基于全卷积神经网络的焊缝特征提取  下载: 1619次

下载: 1619次

1 引言

随着制造行业自动化进程的迅速发展,金属焊接成为生产过程中必不可少的环节。为满足自动化焊接生产的要求,需要实时获得焊接过程中焊缝的宽度、中心线等位置信息。基于激光视觉的焊缝跟踪已成为自动焊接领域的研究热点[1-3]。激光视觉传感技术是将激光投射在焊缝表面,形成包含焊缝轮廓信息的焊缝条纹图像,然后进行特征分析。在焊接过程中,因为受到强烈弧光、飞溅、烟尘等的干扰,采集到的图像受噪声污染比较严重,难以准确定位,从而直接影响到了焊接的质量。因此,在自动焊接过程中,准确获得焊缝位置信息变得尤为重要。

应用于焊缝激光线特征提取的方法很多,有按照目标和背景不同级灰度值分割的阈值法和灰度重心法,有提取目标边缘的边缘法和提取图像中心的几何中心法[4],以及利用Steger算法求光条纹的像素位置等[5]。南方等[6]利用自适应阈值法提取条纹区域,通过随机霍夫变换与法线计算出光条纹区域的宽度,根据不同的宽度值分别设定参数进行Steger算法提取。霍平等[7]先对滤波后的焊缝图像进行阈值分割,去除图像噪声,再用二值形态学进行边缘检测,通过对检测边缘的上下边界取平均值来提取光条纹的中心线。袁攀等[8]针对V型焊接坡口的采集图片进行预处理,提出了一种两步式组合滤波的方法,并采用该方法去噪,对二值化后的图像进行卷积,再通过一种面积统计法去除剩余噪声。刘习文等[9]通过对图像进行Radon变换来消除飞溅及弧光噪声,采用最大类间方差法(Ostu)提取除噪后的激光条纹。雷正龙等[10]提出了一种基于自动阈值的自适应中值滤波方法,该方法保护了条纹数据特征,减小了识别难度。工业现场复杂焊接过程引起的焊缝图像特征变化以及弧光等噪声对焊缝特征提取算法提出了更高的要求,使得焊缝特征提取算法研究从传统的单一的或特定的几何特征提取算法向具有广泛学习能力的多层次特征提取的智能学习算法方向发展,以提高焊缝特征提取的自适应性以及抗干扰能力。近年来,基于深度学习的目标提取方法开始应用于焊缝检测。邹焱彪等[11]利用深度卷积神经网络特征的学习能力与表达能力,对含有焊缝信息的激光条纹进行提取,用相应的卷积核获得特征图,并采用非极大值抑制策略进行最终定位。该方法具有很强的畸变容忍能力,能够有效地提取焊缝位置。

本文提出了一种基于全卷积神经网络(FCN)[12]的焊缝激光线特征提取方法,该方法将通过视觉传感器采集的投射到焊缝上的线激光图像作为训练集,去训练一个能够达到像素级分类的全卷积神经网络模型;用训练好的模型预测焊缝图片中每一个像素的所属类别,将焊缝特征提取出来,再采用反卷积策略恢复图像尺寸,从而实现了在受噪声污染严重的图片中准确地得到焊缝位置信息。该方法大大提升了抗干扰能力,保证了焊接质量。

2 全卷积神经网络

以传统卷积神经网络为基础提出的全卷积神经网络能够做到每一个像素与它对应位置的像素点端对端的训练,实现像素级分类。受其启发,将其引入到焊缝的提取中,从大量样本中学习焊缝的激光线特征信息,实现焊缝像素级别的提取。

卷积神经网络的数据层一般是一个

式中:

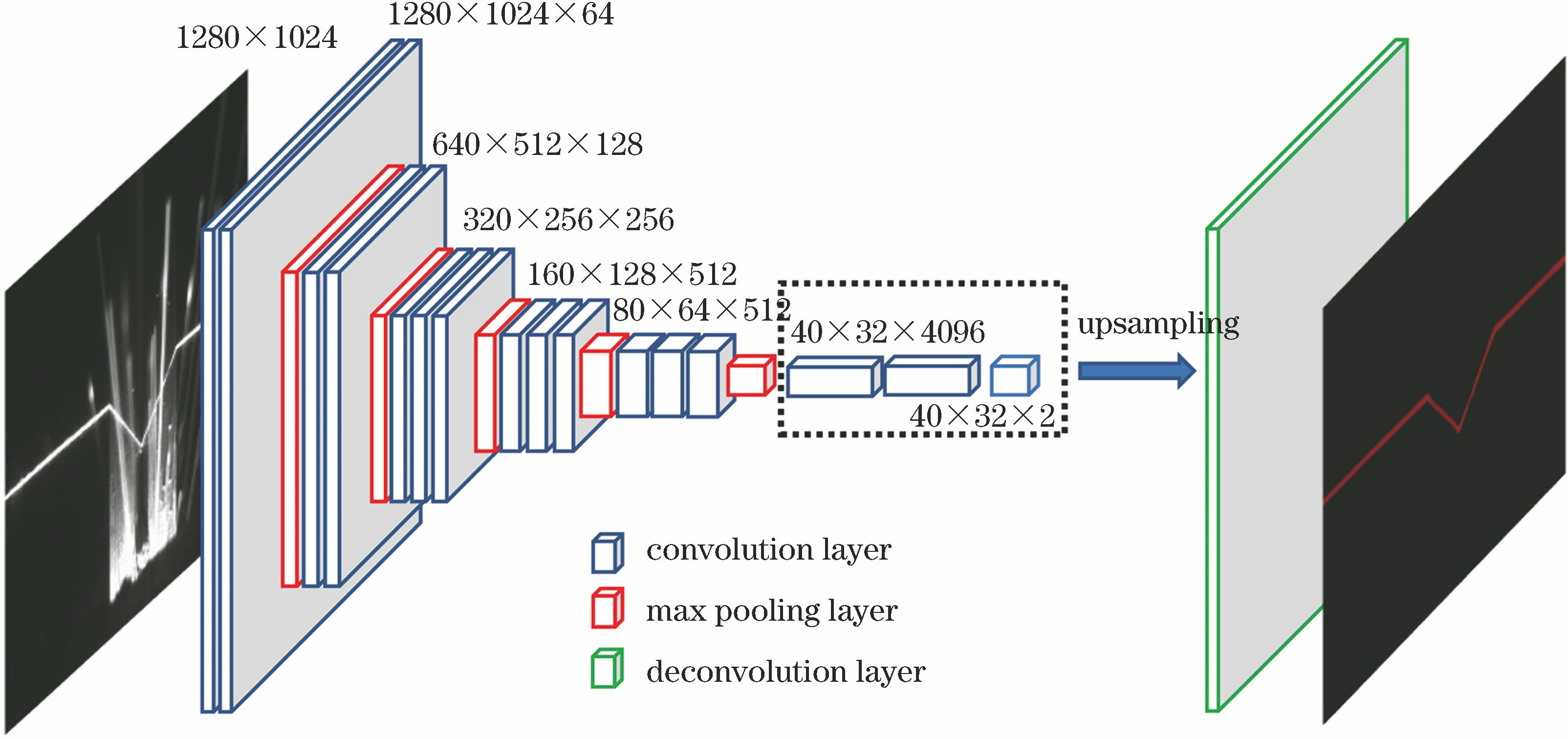

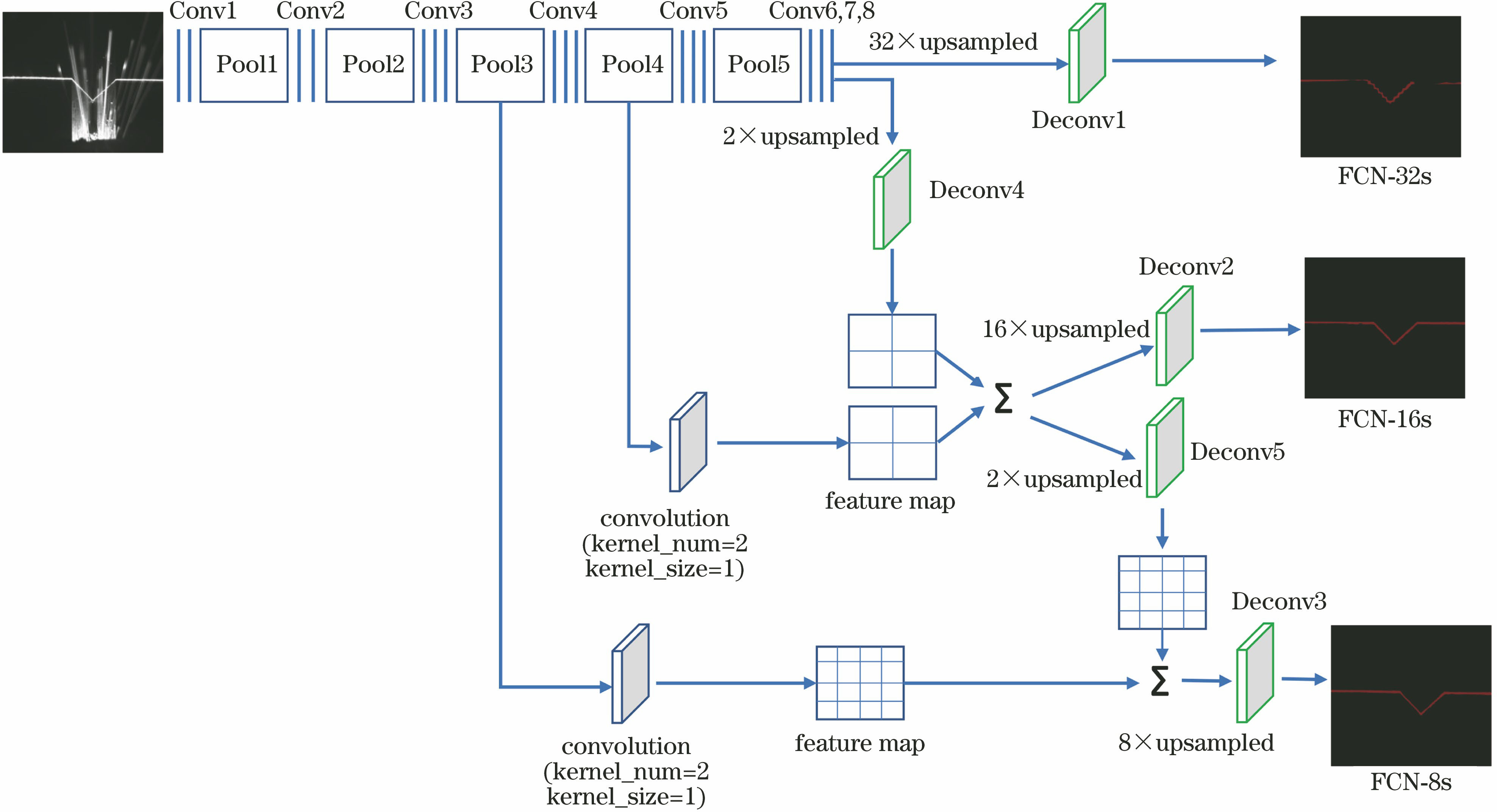

上采样可通过插值的方法进行,如双线性插值法[14],本研究是通过反卷积层实现的。反卷积操作为卷积的逆过程,同样包括卷积核与步长等。图像经过5组卷积和池化以后,它的大小依次缩小为原来的1/2、1/4、1/8、1/16、1/32。对于最后一层的输出图像,需要进行32倍上采样的反卷积操作恢复到原来的大小,由此得到的图像称为FCN-32s。在不断的卷积池化过程中,图像的特征信息会丢失很多,如边缘信息、目标位置等。焊缝特征提取要求能够提供准确的位置信息以及激光线的边缘特征,FCN-32s的图像精度不能够满足需要。为得到更加精细的结果,利用卷积神经网络低层的感知也能够提供目标的更多具体细节这一特点,结合低层与高层输出进行了相加的特征融合。于是,在池化层Pool4后添加卷积核为1×1的卷积层来产生额外预测(为了使低层输出与高层特征映射维度保持一致),与卷积层Conv8的特征映射

3 基于全卷积神经网络的焊缝提取

3.1 数据集准备

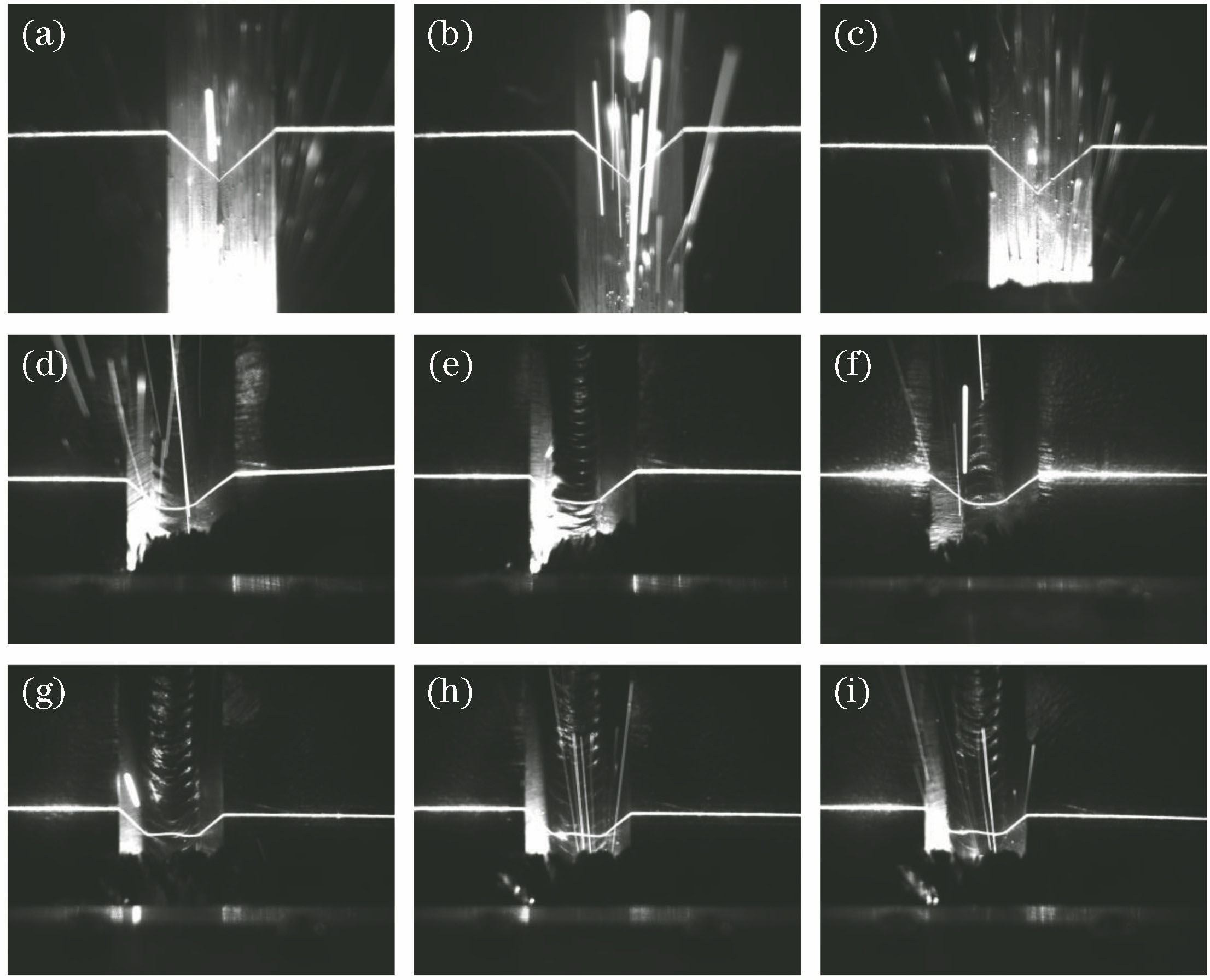

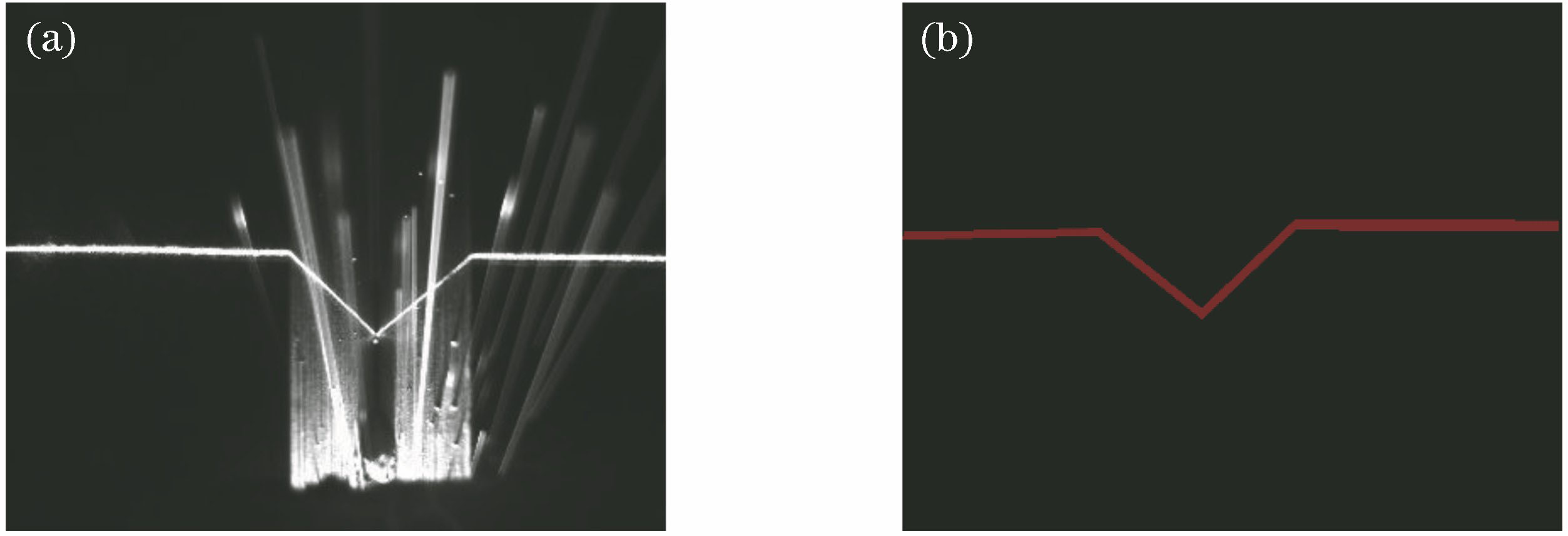

全卷积神经网络和传统卷积神经网络一样,是一个监督学习的过程,需要大量的训练样本,使用视觉传感器采集的原图与人工进行标注的分割图片对模型进行训练。数据集的获取是进行网络训练的前提。在大量的采集图像中选择具有代表性的图片进行训练,使网络模型能够提取不同的特征,具有更好的泛化能力。单一类型的图像训练出来的网络模型不能准确地从复杂图像中分割出焊缝位置。本研究针对的是V型坡口钢材,坡口顶端最宽为25 mm,深度为15 mm。焊接工艺为钨极惰性气体保护焊,传感器内置650 nm线激光器,采集相机为acA1280-60gm相机,采集了200张焊缝图片(1280 pixel×1024 pixel),并在保证不影响原图焊缝特征的情况下,通过对图像进行翻转变换、平移变换等操作将数据扩充到1000张,涵盖了提取过程中焊缝的基本特征。采集的部分图像数据集如

采集好图片后,另一个重要的环节是对采集的图片进行人工标注。这些图片本身没有标签,必须进行人工标注后才能用于监督训练。在获取的图片中,需要标注的类别只有两类,焊缝对应的颜色为红色,背景对应的为黑色。原图与对应的标注图如

3.2 全卷积神经网络模型参数

本研究所使用的全卷积神经网络如

3.3 全卷积神经网络模型的训练

本研究中基于全卷积神经网络的焊缝特征提取是在Caffe[15]深度学习框架上实现的。Caffe深度学习框架提供了Python接口,所提算法通过Python编程实现。本研究所使用的环境配置为Ubuntu 16.04操作系统,内存为32 GB DDR4,显卡为GPU TITAN XP,CPU E5-2640V4。

训练时,采集的原图和对应的人工分割图片采用有监督的学习方式进行训练。本次实验将1000张数据集分为750张训练数据集和250张测试数据集。为加快模型的收敛速度,采用预训练的策略进行参数微调。将在大规模含标签数据集ImageNet[16]中训练好的VGG16网络模型作为预训练模型,结合焊缝图像训练数据集训练好FCN-32s模型,保存模型参数。用该参数作为FCN-16s的预训练模型和焊缝图像训练数据集再次训练FCN-16s模型,依次递进,得到FCN-8s模型,以此加快收敛速度,减少训练时间,得到最终效果较好、精度较高的模型。本实验所有训练过程的训练参数如下:训练次数为10000次,权重衰减系数为0.0005,确定的权值参数的学习率为10-12,使用随机梯度下降法更新权值。训练结束后,将训练好的权值参数保存在caffemodel文件中。为更好地衡量分割结果,采用文献[

12]中的评价标准,用像素准确率(PACC)、平均准确率(MACC)和平均重叠率(MIU)三个指标来判定模型的分割精度。记

定义平均准确率为

定义平均重叠率为

表 1. 网络结构参数

Table 1. Parameters of network structure

|

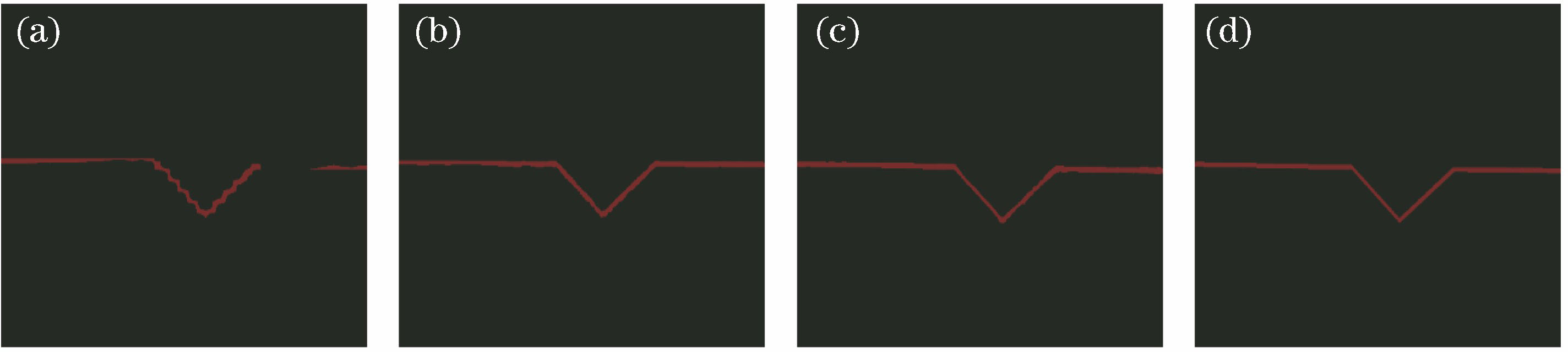

在前面的模型介绍中有三种不同的上采样方式,分别是FCN-32s、FCN-16s、FCN-8s。三种不同上采样结构的训练结果如

表 2. 三种上采样结构的训练结果

Table 2. Training results of three upsampling structures

|

由

图 5. 三种上采样结构的结果图与标注图。(a) FCN-32s;(b) FCN-16s;(c) FCN-8s;(d)标注图

Fig. 5. Results of three upsampling structures and label image. (a) FCN-32s; (b) FCN-16s; (c) FCN-8s; (d) label image

4 实验与分析

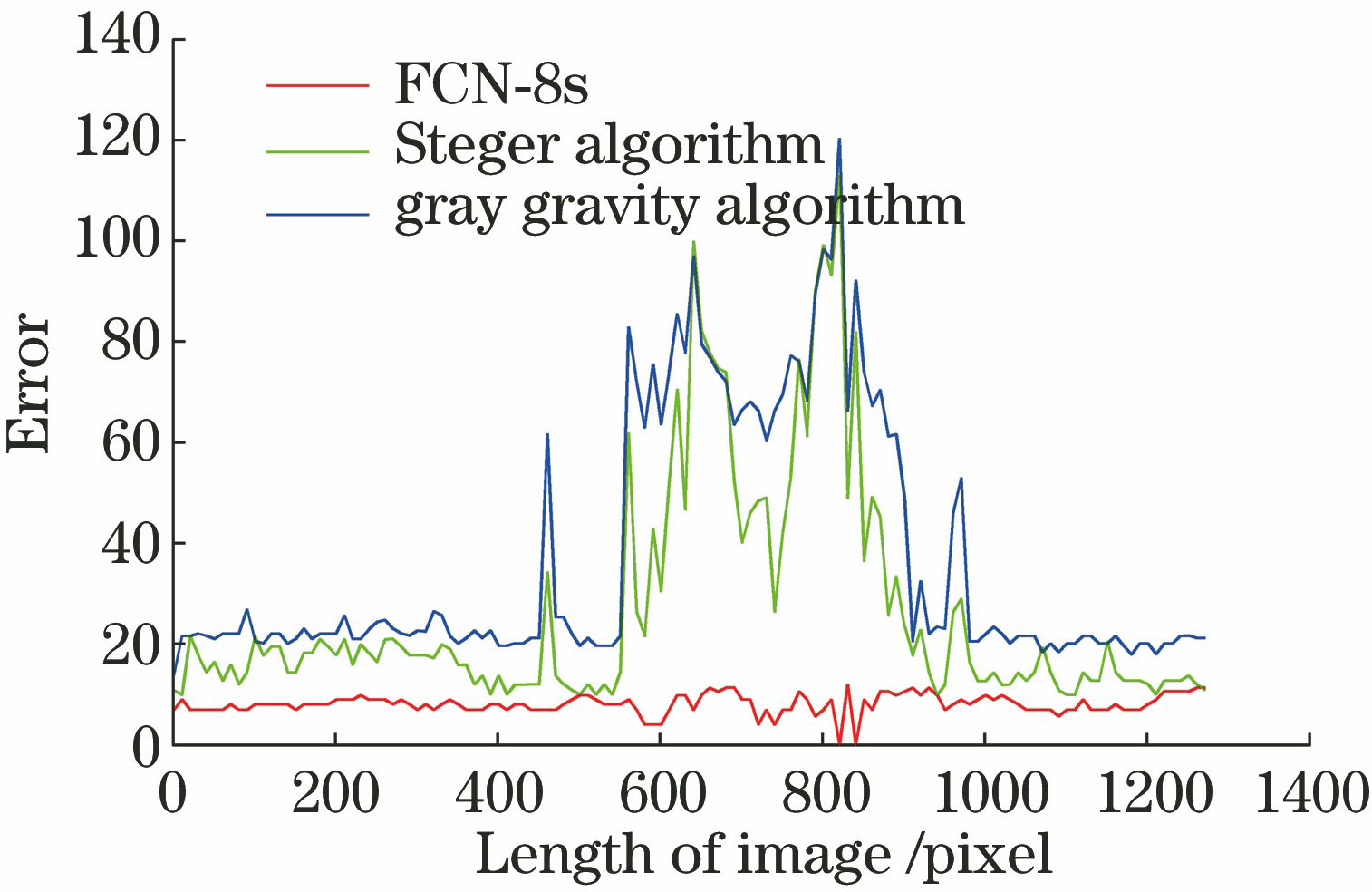

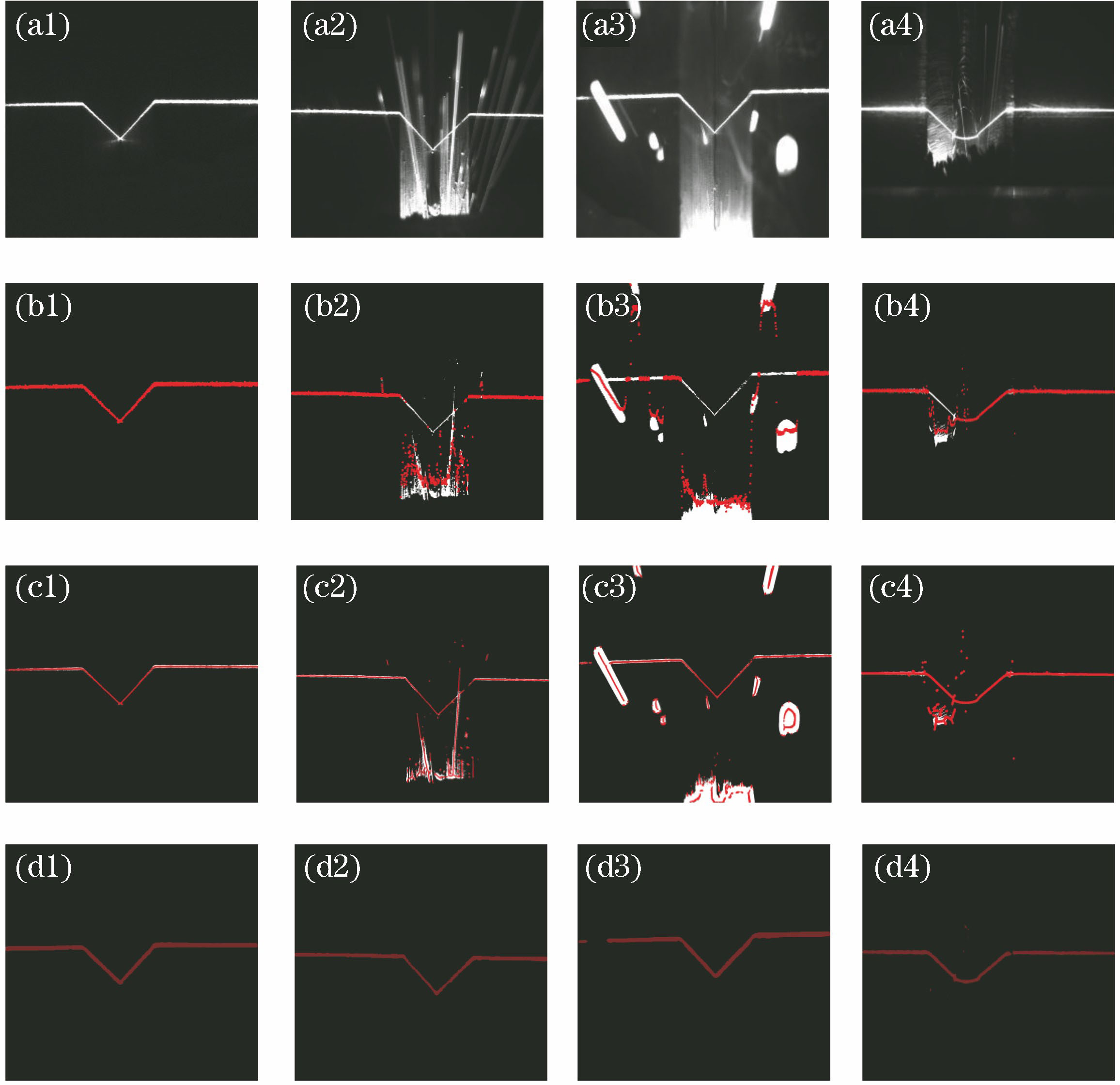

本实验采用FCN-8s网络模型进行测试,读取采集的焊缝图像,并输入到已训练好的全卷积神经网络中,只通过前向传递方式输出提取结果。为了能更好地体现出采用卷积神经网络进行焊缝提取具有更好的切割效果,本次实验同时采用传统提取光条中心的方法(灰度重心法[4]和Steger算法)进行焊缝提取,并将提取效果进行对比。不同的焊缝提取方法的定性比较结果如

提取结果显示:FCN-8s能更好地从受弧光干扰的图像中提取焊缝特征;对于不受噪声干扰的图像,如

图 6. 三种算法的提取结果。(a1)~(a4)焊缝原图;(b1)~(b4)灰度重心法提取的焊缝;(c1)~(c4) Steger算法提取的焊缝;(d1)~(d4) FCN-8s提取的焊缝

Fig. 6. Extraction results obtained with three different algorithms. (a1)-(a4) Weld original images; (b1)-(b4) welds extracted with gray gravity algorithm; (c1)-(c4) welds extracted with Steger algorithm; (d1)-(d4) welds extracted with FCN-8s

为了准确对比各个算法的提取结果,以人工标注图作为标准图,计算各算法提取的焊缝位置与标注图焊缝位置之间的均方根误差(RMSE),用RMSE来定量分析提取的效果,结果如

从

从

表 3. 结果图与标注图在焊缝位置的RMSE

Table 3. RMSE of weld position between results and label images pixel

|

5 结论

针对现阶段自动焊接系统易受环境因素干扰,焊接出现偏移的问题,结合深度学习技术,将深度卷积神经网络应用于焊缝的提取过程,研究了基于全卷积神经网络的焊缝特征提取方法,该方法解决了复杂噪声环境中焊缝定位不准确的问题,能够在强烈弧光、飞溅和烟尘等噪声情况下,准确地找到焊缝位置,提高了自动焊接系统的自适应能力。

另外,通过与传统激光线特征提取方法对比后可知,全卷积神经网络具有良好的抗干扰能力,焊缝提取精度较高,未来的研究工作将从数据集和网络结构方面继续优化模型,以进一步改善提取效果。

[1] 平津, 曾毅. 一种快速有效的基于激光视觉的焊缝跟踪实时图像处理方式[J]. 应用激光, 2010, 30(3): 232-235.

[2] 郭吉昌, 朱志明, 于英飞, 等. 焊接领域激光结构光视觉传感技术的研究及应用[J]. 中国激光, 2017, 44(12): 1200001.

[3] 赵军, 赵继, 张雷. 焊缝结构光图像处理与特征提取方法[J]. 西安交通大学学报, 2013, 47(1): 114-119.

[4] 李佳璇. 基于结构光成像的焊缝跟踪与检测系统[D]. 太原: 中北大学, 2017: 31- 37.

Li JX. Weld tracking and inspection system based on structured light imaging[D]. Taiyuan: North University of China, 2017: 31- 37.

[5] 胡坤, 周富强, 张广军. 一种快速结构光条纹中心亚像素精度提取方法[J]. 仪器仪表学报, 2006, 27(10): 1326-1329.

[6] 南方, 李大华, 高强, 等. 改进Steger算法的自适应光条纹中心提取[J]. 激光杂志, 2018, 39(1): 85-88.

[7] 霍平, 李军萌, 曾翰林, 等. 一种基于结构光的V型焊缝实时图像处理方法[J]. 电焊机, 2014, 44(12): 144-148.

[8] 袁攀, 孔建益, 仄士春, 等. V型焊接坡口图像处理方法的研究[J]. 机械设计与制造, 2017( 6): 64- 66.

YuanP, Kong JY, Ze SC, et al. The research on image processing method of V-shaped welding groove[J]. Machinery Design & Manufacture, 2017( 6): 64- 66.

[9] 刘习文, 洪波, 戴铁峰. 激光视觉焊缝跟踪图像处理与坡口识别[J]. 激光与红外, 2011, 41(7): 804-807.

[10] 雷正龙, 沈健雄, 黎炳蔚, 等. 基于自动阈值的窄间隙端接焊缝识别技术[J]. 光学学报, 2018, 38(8): 0815011.

[11] 邹焱飚, 周卫林, 陈向志. 基于深度分层特征的激光视觉焊缝检测与跟踪系统研究[J]. 中国激光, 2017, 44(4): 0402009.

[12] LongJ, ShelhamerE, DarrellT. Fully convolutional networks for semantic segmentation[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2015: 3431- 3440.

[13] SimonyanK, ZissermanA. Very deep convolutional networks for large-scale image recognition[J]. Computer Science, 2015( v6): 1409.

[14] HariharanB, ArbeláezP, GirshickR, et al. Hypercolumns for object segmentation and fine-grained localization[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2015: 447- 456.

[15] Jia YQ, ShelhamerE, DonahueJ, et al. Caffe: convolutional architecture for fast feature embedding[C]. ACM International Conference on Multimedia, 2014: 675- 678.

[16] DengJ, DongW, SocherR, et al. ImageNet: a large-scale hierarchical image database[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2009: 248- 255.

张永帅, 杨国威, 王琦琦, 马雷, 王以忠. 基于全卷积神经网络的焊缝特征提取[J]. 中国激光, 2019, 46(3): 0302002. Yongshuai Zhang, Guowei Yang, Qiqi Wang, Lei Ma, Yizhong Wang. Weld Feature Extraction Based on Fully Convolutional Networks[J]. Chinese Journal of Lasers, 2019, 46(3): 0302002.