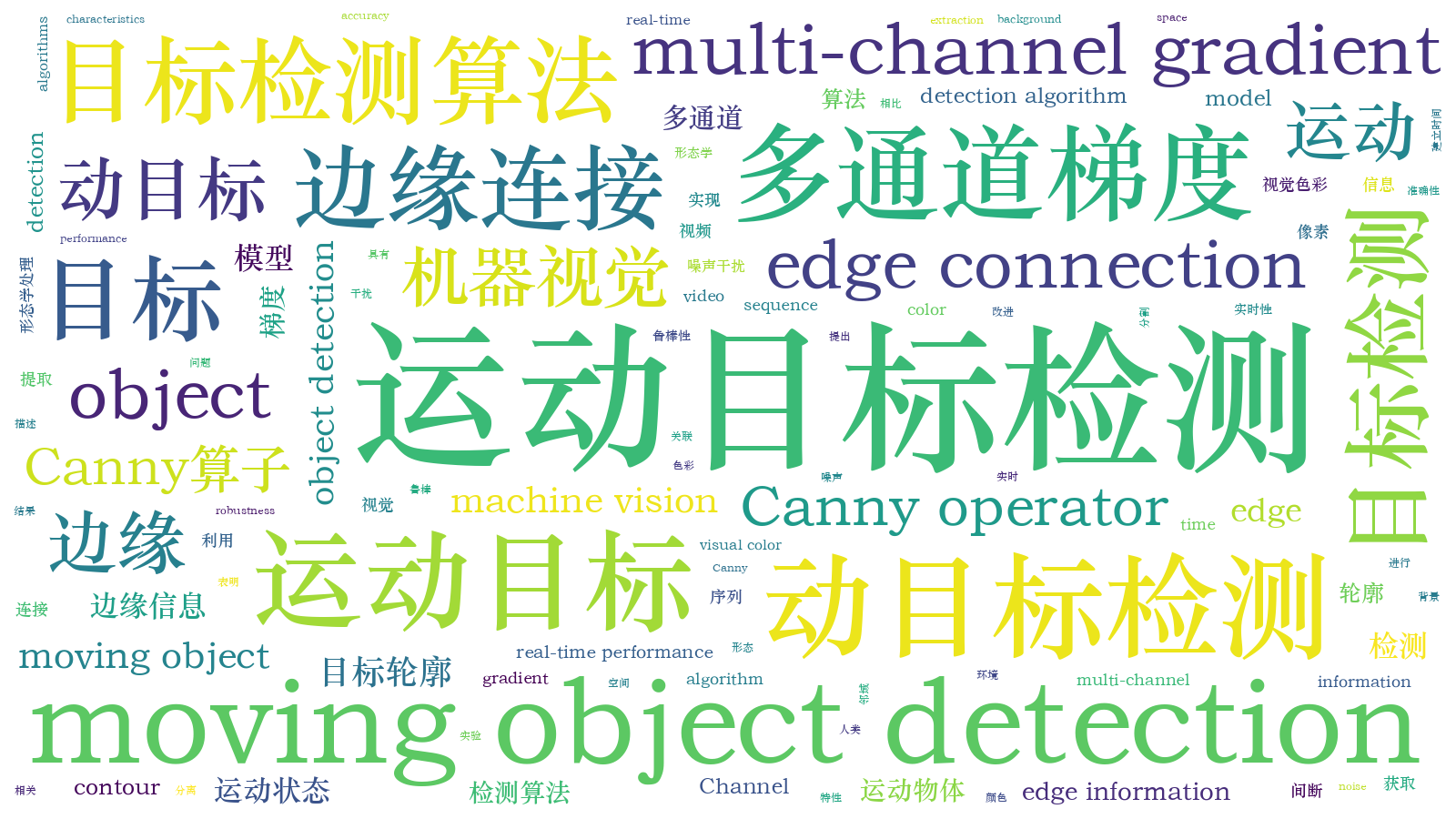

基于边缘多通道梯度模型的多运动目标检测  下载: 857次

下载: 857次

1 引言

目标检测作为机器视觉领域的研究热点,在智能监控、智能交通、无人驾驶等方面具有极其重要的应用和发展前景。如何在目标检测过程中克服光照、异物、遮挡等环境噪声,提高检测效率,提取完整运动目标的轮廓,也成为这类问题的研究重点[1-2]。

目前,主流的目标检测算法可分为基于经典模型和基于学习模型的检测算法,混合高斯法与视觉背景提取算法是基于经典模型的检测算法。Chen等[3]提出了一种在混合高斯改进模型中,利用码本和区间估计提高检测准确性的方法,一定程度上解决了前景像素移动缓慢造成的像素扰动和检测误判问题。但在光照、背景变化等噪声干扰情况下的鲁棒性较差,目标轮廓提取不完整,且无法满足实时性的要求。王旭等[4-6]提出了多种针对目标检测问题的视觉背景提取算法,改进后的算法可以有效抑制视觉背景提取算法的鬼影现象,提升算法的实时性。但这些算法依赖背景模型的更新,受环境噪声干扰较大,无法获取准确的目标轮廓。

YOLO(You only look once)网络是目前比较热门的一种基于学习模型的目标检测算法[7],相比区域卷积神经网络(RCNN)[8]、Fast-RCNN[9]算法在速度上得到了极大的提升,但对微小目标、尺度变化的目标,YOLO网络的检测率和泛化能力都较弱。针对该问题,Liu等[10]提出了一种基于YOLO网络改进的多尺度单步多框检测(SSD)网络,大幅提升了对小目标的检测性能。基于YOLO网络,人们还提出了YOLOv2[11]和YOLOv3[12]网络算法,在确保算法准确性的同时改进了算法整体的运算速度。近年来,生物视觉特性与机器视觉结合的目标检测算法逐渐受到了人们的关注。如受人类视觉感知系统启发的RFBNet(Receptive field block net)[13]算法利用Inception与空洞卷积模拟人类视觉的感受野,并将SSD网络与感受野相结合,相比YOLOv3网络算法,该算法的检测精度和运行效率均有较大提升。基于学习模型的目标检测算法虽然在检测性能方面有较大优势,但算法的网络泛化和实用性依赖大量训练数据集,且耗时耗力。

针对上述问题,本文在文献[ 14]中的多通道梯度模型(McGM)基础上,结合生物视觉特性,提出了一种边缘McGM(E-McGM),并将该模型用于多运动目标检测。针对多运动目标检测过程中出现的目标轮廓提取不完整问题,利用E-McGM设计一种运动目标间断边缘的连接方法。实验结果表明,相比其他算法,本算法在3个序列中的平均查全率、平均查准率和平均F-Measure均得到了一定的提高。

2 基于E-McGM的运动目标检测算法

文献[ 14]中的模型没有对图像信息进行筛选,算法需要计算大量的冗余信息,时间效率低且空间复杂度高。针对该问题,选取图像中具有代表性的边缘信息,并参考文献[ 14]中的模型,提出了一种基于E-McGM的多运动目标检测算法。

2.1 E-McGM的建立

生物学认为物体在人眼中的成像是该物体反射光能量在视觉单元中二维信号的反映。不同波长的反射光对应不同光谱能量值,通过光谱能量值可得到物体在视觉系统中对应的颜色信息[15]。由文献[ 15]中的视觉光学理论及图像学知识,得到图像边缘在图像I中各颜色通道的描述为

式中,λ为波长,Ω为可见光波长的范围,用均值为λ0、标准差为σ的高斯函数G(λ,λ0,σ)表示视觉传感器灵敏度,γ为G(λ,λ0,σ)的求导阶数。令λ0=520 nm,σ=55 nm,依据文献[ 16]提出的人类视觉彩色拮抗理论,将G(λ,λ0,σ)最高求导至二阶,用G0(λ,λ0,σ),G1(λ,λ0,σ)和G2(λ,λ0,σ)分别表示人类视觉的亮度、黄-蓝和红-绿拮抗通道的加权函数,S0,S1和S2分别为对应物体边缘的亮度、黄-蓝和红-绿拮抗通道的光谱响应。物体表面反射光的能量分布E(λ)可表示为

式中,e(λ)为入射光的能量分布,R(λ)为物体表面光的反射系数。当物体运动时,R(λ)不发生变化,e(λ)变化比较缓慢,可认为短时间内的E(λ)为不变量。因此,Sγ(λ0)具有色彩恒常性,即对光照变化的鲁棒性较强。

将S0(λ0)在λ0邻域做二阶泰勒展开,得到图像I中物体边缘的光谱描述为

式中,s为波长λ的偏移量,O(s3) 为泰勒公式的余项。将(3)式的光谱信息与图像I的物体边缘空间、时间信息结合,再次进行泰勒展开,可得到视觉皮层图像信息的E-McGM描述,即图像边缘像素P(x,y,t,λ)对应的E-McGM为

式中,x、y 分别为图像横轴、纵轴的坐标,Et为由Canny算子得到的第t帧边缘图像,(p,q,r,s)为(x,y,t,λ)的偏移参数,e,f,g,h为关于图像边缘像素P(x,y,t,λ)在泰勒展开中的最高阶数,实验取e=3,f=2,g=2,h=2。

2.2 基于E-McGM的运动目标边缘检测

合并(4)式中偏导阶数相同的项,构成向量k(x,y,t,λ),k在空间xy-时间t-光谱λ上的差分可反映边缘像素点P的运动变化趋势。视觉皮层对运动物体的感知过程可看作单帧图像中每个像素点在空间梯度上的变化,可表示为

式中,D为差分算子,X,Y,T,λ分别为向量k对x,y,t,λ的差分值。物体运动过程中的描述参数为

生物学认为初级视觉皮层大部分的细胞具有方向选择性,即表征初级视觉皮层细胞会在m个运动方向θ中选择梯度变化最强响应作为物体的运动方向[17]。图像边缘点P(x,y,t,λ)在视频序列三维空间中的正交方向速度v(vx,vy)可表示为

将(7)式作为初速度建立速度基坐标系,通过旋转速度基坐标系可获得m个不同方向θ的速度响应,令图像边缘点的正速度为

像素点P的速率为

像素点P的运动方向Θ可表示为

由(9)式和(10)式可得到像素点P的速度描述,从而提取出第t帧视频图像的运动物体边缘

2.3 基于E-McGM的间断运动边缘连接

2.2小节获得的运动目标边缘图

1) 设动态像素点的标记w为1,静态像素点的标记w为0。初始化当前第t帧

2) 在集合Pt中按顺序选取第n个动态边缘点

3) 对于数组

式中,

4) 更新M(

将

图 1. 目标检测的结果。 (a)形态学处理的结果; (b)目标块

Fig. 1. Result of object detection. (a) Result of morphological processing; (b) object block

3 实验结果分析与算法评估

本算法的实现与验证环境:操作系统为64位Ubuntu16.04、CPU处理器为Intel Core Xeon E5-2603、内存为16 GB的个人电脑,编程语言为C++和OpenCV库。

实验挑选CDnet2014数据集的blizzard和PETS2006视频序列以及visual tracker benchmark的David序列对本算法进行有效性验证。三个视频序列对应的参数如

表 1. 视频序列参数

Table 1. Parameter of the video sequence

|

3.1 实验结果

首先在人流密集、天气恶劣、光照变化等场景下对不同算法进行多场景性能验证。视频序列1为室内地铁站人员流动场景,测试环境复杂,运动目标较多;视频序列2为室外下雪场景,在该恶劣天气下进行运动目标检测,会受到图像亮度灰暗、背景存在较多噪声和雪花轻微飘动的影响;视频序列3为从昏暗房间向明亮客厅移动的光照变化场景。

![不同算法的检测结果。 (a)原始图像; (b)文献[18]中的算法; (c)文献[19]中的算法; (d)文献[20]中的算法; (e)本算法](/richHtml/lop/2021/58/4/0415002/img_2.jpg)

图 2. 不同算法的检测结果。 (a)原始图像; (b)文献[ 18]中的算法; (c)文献[ 19]中的算法; (d)文献[ 20]中的算法; (e)本算法

Fig. 2. Detection results of different algorithms. (a) Original image; (b) algorithm of Ref. [18]; (c) algorithm of Ref. [19]; (d) algorithm of Ref. [20]; (e) our algorithm

从

3.2 实验结果性能分析

为了进一步量化各算法的检测性能,用查全率(R)、查准率(P)、F-Measure(XF_M)以及检测误差率 (XError_ratio)对检测结果进行量化。前三个指标值越大,表明对应算法的检测结果越好。

式中,XTP为正确检测的前景目标像素点数,XFP为被错误检测为前景目标的背景像素点数,XFN为被错误检测为背景的前景目标像素点数,XGT为前景目标像素总数。本算法与对比算法在视频序列的性能如

表 2. 不同算法的检测性能

Table 2. Detection performance of different algorithms

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

从

3.3 数据优化分析

在目标检测中,图像中许多像素点为无用背景点。而本算法只对目标边缘像素建立模型,大大减少了需要处理的像素点数,从而降低了算法的时间复杂度,提升了算法的运算速度。

表 3. 各阶段计算和存储的数据量

Table 3. Amount of data calculated and store in each stage

|

4 结论

针对视频序列中运动目标检测易受环境噪声干扰、目标轮廓提取困难的问题,在McGM模型基础上提出了E-McGM,并利用所得的运动状态对运动目标轮廓实现完整提取。实验结果表明,相比其他算法,本算法在噪声干扰环境下的目标误检率和漏检率更低。通过结合E-MCGM的运动物体间断边缘连接方法,提升了运动目标检测的准确性和鲁棒性,且具有更优的时间复杂度。本算法虽然可以解决视频序列的缓慢运动目标检测问题,但当背景中运动扰动较大时,检测结果并不理想。因此,在大扰动背景环境中的目标检测问题是未来需要研究的重点。

[1] 方岚, 于凤芹. 去除鬼影及阴影的视觉背景提取运动目标检测算法[J]. 激光与光电子学进展, 2019, 56(13): 131002.

[2] 周兵, 李润鑫, 尚振宏, 等. 基于改进的Faster R-CNN目标检测算法[J]. 激光与光电子学进展, 2020, 57(10): 101009.

[3] Chen X R, Xi C L, Cao J H. Research on moving object detection based on improved mixture Gaussian model[J]. Optik, 2015, 126(20): 2256-2259.

[4] 王旭, 刘毅, 李国燕. 基于改进视觉背景提取算法的运动目标检测方法[J]. 激光与光电子学进展, 2019, 56(1): 011007.

[6] 马永杰, 陈梦利, 刘培培, 等. ViBe算法鬼影抑制方法研究[J]. 激光与光电子学进展, 2020, 57(2): 021007.

[7] RedmonJ, DivvalaS, GirshickR, et al.You only look once: unified, real-time object detection[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE Press, 2016: 779- 788.

[8] Ren S, He K, Girshick R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[9] GirshickR. Fast R-CNN[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile.New York: IEEE Press, 2015: 1440- 1448.

[10] LiuW, AnguelovD, ErhanD, et al. SSD: single shot MultiBox detector[M] ∥Leibe B, Matas J, Sebe N, et al. Computer Vision -ECCV 2016. Lecture Notes in Computer Science. Cham: Springer, 2016, 9905: 21- 37.

[11] RedmonJ, FarhadiA. YOLO9000: better, faster, stronger[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE Press, 2017: 6517- 6525.

[12] RedmonJ, FarhadiA. YOLOv3: an incremental improvement[EB/OL]. [2020-10-25].https:∥arxiv.org/abs/1804. 02767.

[13] Liu ST, HuangD, Wang YH. Receptive field block net for accurate and fast object detection[EB/OL]. [2020-10-25].https:∥arxiv.org/abs/1711. 07767.

[14] Liang X F. McOwan P W, Johnston A. Biologically inspired framework for spatial and spectral velocity estimations[J]. JOSA A, 2011, 28(4): 713-723.

[15] Golland P, Bruckstein A M. Motion from color[J]. Computer Vision and Image Understanding, 1997, 68(3): 346-362.

[17] Johnston A. McOwan P W, Benton C P. Robust velocity computation from a biologically motivated model of motion perception[J]. Proceedings of the Royal Society of London. Series B: Biological Sciences, 1999, 266(1418): 509-518.

[20] Guo Y C, Li Z, Liu Y, et al. Video object extraction based on spatiotemporal consistency saliency detection[J]. IEEE Access, 2018, 6: 35171-35181.

Article Outline

陈婕妤, 奚峥皓, 卢俊鑫. 基于边缘多通道梯度模型的多运动目标检测[J]. 激光与光电子学进展, 2021, 58(4): 0415002. Jieyu Chen, Zhenghao Xi, Junxin Lu. Multi-Moving Object Detection Based on Edge Multi-Channel Gradient Model[J]. Laser & Optoelectronics Progress, 2021, 58(4): 0415002.