一种融合光照和彩色信息的图像匹配算法  下载: 950次

下载: 950次

1 引言

图像匹配算法的好坏直接影响机器视觉的识别结果,广泛地应用于医学影像、计算机视觉、视觉导航、模式识别、图像拼接等领域[1]。传统的SIFT算法等大多是在灰度化图像上进行匹配操作,因此可能会损失图像的颜色信息。光照变化对图像匹配影响较大,在相同场景拍摄的图片会因为光照变化而使图像中颜色直方图对应的像素点不同,导致左视图与右试图误检和漏检特征点现象,使后续图像匹配的难度大大增加[2]。Lowe[3-4]提出的SIFT(scale-invariant feature transform,SIFT)算法具有性能良好的局部特征,在图像匹配中被广泛应用。但是SIFT算法只能在灰度图像上进行匹配,不考虑图像的颜色信息,而且其计算量大、采集的特征点多、实时性较差,因此在实时性要求较高的系统中无法使用。Harris等[5]提出的Harris算法是一种角点检测算法,该算法计算简单、稳定,且不受光照、旋转、噪声等影响,具有良好的检测效果。将Harris算法与SIFT算法结合是目前一种较为理想的方案。

文献[ 6]提出一种能够融合彩色和光照的SIFT算法,该算法相比SIFT算法准确性大大提高,提高了匹配精确度,但由于提取出更多的特征点,使提取匹配时间较长,实时性较低。而许佳佳[7]提出一种多尺度的Harris-SIFT算法,该算法将Harris算法进行改进,在保持配准精度的同时,能够大大减少配准时间。侯小红等[8]提出一种基于Harris-SIFT的LBP(Local Binary Pattern)人脸表情识别算法,具有较好的识别效果。胡海燕等[9]提出用于卫星三线阵的Harris-SIFT图像匹配算法,极大提高了系统实时性。目前Harris-SIFT有2种融合方法,第1种是将Harris算法提升为多尺度,能够在准确率基本不变的情况下极大提高系统的实时性,第2种则将SIFT算法降为单尺度,虽然实时性增强,但会小幅降低系统的匹配准确率[10-12]。

因此,本文提出一种能融合光照和色彩信息的Harris-SIFT算法,首先在灰度化之前计算光照和彩色补偿量,然后迅速提取图像中的角点,角点作为特征点,采用SIFT算法对特征点进行匹配,最后通过特征点特征向量的欧氏距离判定指定图像中特征点的相似性,并采用投票策略对匹配点提纯,实现指定图像的特征点匹配[13-14]。该方法能较好地保留彩色图像中彩色之间的差异性,同时兼顾匹配算法的准确率与实时性。

2 融合光照和彩色信息补偿量算法

2.1 彩色补偿量的提取

文献[

15]提出一种彩色补偿量的方法,很多彩色空间都可以通过2个颜色分量与1个亮度分量代表所有颜色,如CIELUV、CIELAB、YIQ、YCBCR等。CIELAB与GIELUV由1931年制定的 CIE XYZ颜色空间基础上建立,其中字母

RGB颜色空间和YIQ彩色空间的变换关系为

式中,

式中,

式中:

2.2 光照补偿量的提取

当前方法大都采用高斯权重函数调整图像光照强度,因此为保持更多的图像细节和增加对比度,采用的光照补偿量的提取方程式[16]为

式中:

最终的灰度值

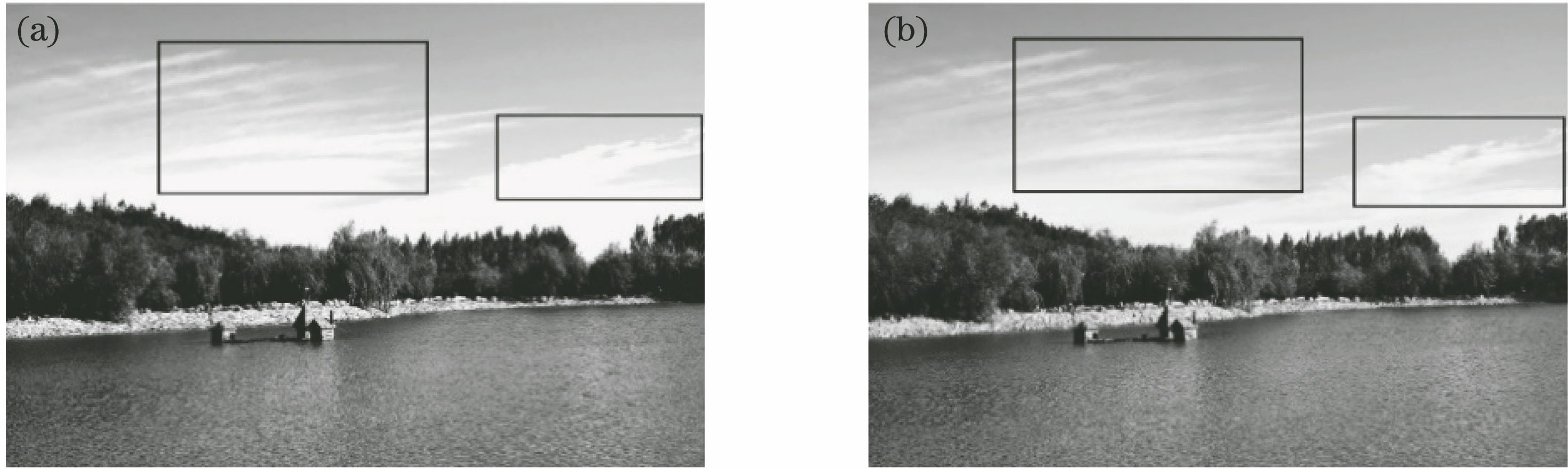

补偿前后的对比图片如

3 图像快速匹配算法

3.1 特征点提取

首先采用Harris算法提取角点,然后对角点的质量进行检查。1)判断其是否为边缘点,2)判断角点所包含的信息是否正确,3)对较差的角点去除,4)对保留下来的特征点进行特征描述来建立特征向量并匹配。

首先,对两幅图像提取角点,公式为

图 1. 灰度图对比。(a)原始灰度图;(b)经过算法补偿后的灰度图

Fig. 1. Grayscale contrast. (a) Original grayscale image; (b) grayscale image after algorithm compensation

式中,

式中,Tr(

然后去除边缘点,可表示为

式中,

最后,将图像中所含信息较低的角点删除,图像携带信息量的多少与图像熵值的大小成正比,具有较大熵值的角点相比具有较小熵值的角点拥有更高的匹配准确率,去掉熵值低的角点,可以大大减少一些不必要的操作,从而提高算法的性能,所用公式为

式中,

对图像

3.2 SIFT特征点匹配

Harris算法所提取的角点仅仅能获得位置信息,而采用SIFT算法进行匹配时需要3方面信息,即尺度信息、位置信息和方向信息。

要获得特征点的方向信息,首先要计算出图像像素点的所有梯度方向和模值,其计算公式为

根据3

3.2.1 特征点的描述

由以上步骤可计算出特征点的位置和方向信息,从而生成需要的特征描述子。在关键的特征点邻域划分一个4×4的子区域,并将该子区域的中心点作为一个种子点,每一个种子点都拥有8个不同的方向,对该种子点取第1组的第1层,即可生成128维的特征描述符。

3.2.2 特征点匹配

特征点的匹配采用特征向量的欧氏距离作为判据,利用欧氏距离判定两个特征向量间的相似性,计算公式为

式中,

4 实验及分析

为验证融合光照和彩色信息的Harris-SIFT算法相比Harris-SIFT算法在匹配准确率上的优势,选取不同的图片进行配准实验。实验采用Intel Corei7-6700, 2.6 GHz CPU,8 G RAM的计算机,Windows10 64位操作系统,Matlab2018b软件实现本算法,实验所用的图像均为实拍图像,其中

图 3. 实验测试图片。(a)(b)书籍匹配图片;(c)(d)不同角度广场图片;(e)(f)不同角度风景建筑图片

Fig. 3. Experimental test images. (a)(b) Book matching images; (c)(d) square images with different angles; (e)(f) scenery building images with different angles

首先,通过实验比较融合光照和彩色信息的Harris-SIFT算法在特征点检测时间与单一Harris-SIFT算法实时性的变化。对融合光照和彩色信息的Harris-SIFT算法及Harris-SIFT算法进行特征点检测对比实验,将两种方法对

表 1. 两种算法特征点检测时间统计

Table 1. Statistic of feature point detection time of two algorithms

| ||||||||||||||||||||||||

表 2. 本文方法的准确率和所用时间

Table 2. Accuracy and cost time of the proposed algorithm

|

表 3. Harris-SIFT算法的准确率和所用时间

Table 3.

|

图 4. 融合光照和彩色信息的Harris-SIFT算法匹配结果。(a)图3中(a)(b)匹配;(b)图3中(c)(d)匹配;(c)图3中(e)(f)匹配

Fig. 4. Image matching results of Harris-SIFT algorithm with exposure and color information. (a) Matching of Figs. 3 (a) and (b); (b) matching of Figs. 3(c) and (d); (c) matching of Figs. 3(e) and (f)

由实验结果可见,融合光照和彩色信息的Harris-SIFT算法成功解决了实时性与匹配准确率这一互相矛盾的问题。

1) 比较Harris-SIFT算法,融合光照和彩色信息的Harris-SIFT算法由于匹配前先采用Harris算法检测出角点,同时去除一些特征表现不好的点,从而为后边SIFT算法减少匹配阶段的计算量,进而提高系统的实时性。所以虽然增加了补偿量的计算,但并没有让系统的实时性变差,而且略有提升。

图 5. Harris-SIFT算法匹配结果。(a)图3中(a)(b)匹配;(b)图3中(c)(d)匹配;(c)图3中(e)(f)匹配

Fig. 5. Image matching results for Harris-SIFT algorithm. (a) Matching of Figs. 3 (a) and (b); (b) matching of Figs. 3(c) and (d); (c) matching of Figs. 3(e) and (f)

2) 融合光照和彩色信息的Harris-SIFT算法,由于在灰度化之前增加了彩色和光照补偿量,解决了灰度化之后对原图像彩色信息表征不明显的问题,能够充分反映原彩色图像的结构,使得特征集合性较为显著,提高了正确匹配率。

5 结论

针对传统的Harris-SIFT图像匹配算法灰度化之后不能很好地表征原彩色图像信息,提出一种融合光照和彩色信息的Harris-SIFT图像快速匹配方法。该方法首先在灰度化过程中加入彩色补偿量和光照补偿量,然后采用改进的Harris-SIFT算法进行特征点匹配,最后对3组图像进行特征点匹配实验,结果表明相较于之前的Harris-SIFT算法,融合光照和彩色信息的Harris-SIFT算法在不影响实时性的情况下,准确率要优于传统的Harris-SIFT图像匹配算法。

[1] 闫利, 王芮, 刘华, 等. 基于改进代价计算和自适应引导滤波的立体匹配[J]. 光学学报, 2018, 38(11): 1115007.

[2] 单宝华, 霍晓洋, 刘洋. 一种极线约束修正数字图像相关匹配的立体视觉测量方法[J]. 中国激光, 2017, 44(8): 0804003.

[4] Lowe[\s]{1}DG.[\s]{1}Object[\s]{1}recognition[\s]{1}from[\s]{1}local[\s]{1}scale-invariant[\s]{1}features[C]//Proceedings[\s]{1}of[\s]{1}the[\s]{1}Seventh[\s]{1}IEEE[\s]{1}International[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision,[\s]{1}September[\s]{1}20-27,[\s]{1}1999,[\s]{1}Kerkyra,[\s]{1}Greece.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}1999,[\s]{1}2:[\s]{1}6365386.[\s]{1}

[5] HarrisC,[\s]{1}StephensM.[\s]{1}A[\s]{1}combined[\s]{1}corner[\s]{1}and[\s]{1}edge[\s]{1}detector[C]//Proceedings[\s]{1}of[\s]{1}the[\s]{1}Alvey[\s]{1}Vision[\s]{1}Conference[\s]{1}1988,[\s]{1}September,[\s]{1}August[\s]{1}31-September[\s]{1}2,[\s]{1}1988,[\s]{1}Manchester,[\s]{1}UK.[\s]{1}[S.l.:[\s]{1}s.n.],[\s]{1}1988:[\s]{1}147-[\s]{1}151.[\s]{1}

[7] 许佳佳. 结合Harris与SIFT算子的图像快速配准算法[J]. 中国光学, 2015, 8(4): 574-581.

[8] 侯小红, 郭敏. 一种基于Harris-SIFT特征点检测的LBP人脸表情识别算法[J]. 西北大学学报(自然科学版), 2017, 47(2): 209-214.

[9] 胡海燕, 赵西安, 侯莉莉, 等. 基于改进Harris-SIFT的ZY-3卫星三线阵影像匹配[J]. 北京建筑大学学报, 2015, 31(4): 51-57.

[10] 尚明姝, 王克朝. 一种改进的Harris与SIFT算子结合的图像配准算法[J]. 微电子学与计算机, 2018, 35(6): 132-134, 140.

[11] 赵钦君, 赵东标, 韦虎. Harris-SIFT算法及其在双目立体视觉中的应用[J]. 电子科技大学学报, 2010, 39(4): 546-550.

[12] 张鑫, 靳雁霞, 薛丹. SICA-SIFT和粒子群优化的图像匹配算法[J]. 激光与光电子学进展, 2017, 54(9): 091002.

[13] 于之靖, 王韶彬. 改进PCA-SIFT算法的立体匹配系统[J]. 激光与光电子学进展, 2016, 53(3): 031501.

[14] 赵立荣, 朱玮, 曹永刚, 等. 改进的加速鲁棒特征算法在特征匹配中的应用[J]. 光学精密工程, 2013, 21(12): 3263-3271.

[16] Zha[\s]{1}ZS,[\s]{1}Tian[\s]{1}QJ,[\s]{1}Wang[\s]{1}JZ,[\s]{1}et[\s]{1}al.[\s]{1}Image[\s]{1}match[\s]{1}using[\s]{1}distribution[\s]{1}of[\s]{1}colorful[\s]{1}SIFT[C]//2010[\s]{1}International[\s]{1}Conference[\s]{1}on[\s]{1}Wavelet[\s]{1}Analysis[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition,[\s]{1}July[\s]{1}11-14,[\s]{1}2010,[\s]{1}Qingdao,[\s]{1}China.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2010:[\s]{1}150-[\s]{1}153.[\s]{1}

[17] 王琰, 丁明明. 基于熵的柱面全景图拼接算法及其鲁棒性分析[J]. 小型微型计算机系统, 2007, 28(1): 148-150.

Article Outline

张庆鹏, 曹宇. 一种融合光照和彩色信息的图像匹配算法[J]. 激光与光电子学进展, 2019, 56(19): 191004. Qingpeng Zhang, Yu Cao. Image Matching Algorithm Based on Exposure and Color Information[J]. Laser & Optoelectronics Progress, 2019, 56(19): 191004.