基于滚动导向滤波和混合多尺度分解的红外与可见光图像融合方法  下载: 936次

下载: 936次

1 引言

通过不同的传感器可以获取不同类型的图像,但是在所获取的单幅图像中并不能提取到所需要的全部有用信息。如红外图像在低光或恶劣的天气条件下可以捕捉到场景目标的热源信息,而这在可见光图像中是不可能得到的;可见光图像则可以提供场景的更多细节信息,得到与人类视觉相一致的图像亮度和对比度信息。由此可见,将同一场景的红外图像与可见光图像整合,可以得到一幅场景细节信息更多、更加完整的图像,故红外与可见光图像融合方法应运而生。红外与可见光图像融合方法已广泛应用于**、目标检测和情报收集等领域。

近年来,学者们先后提出了多种红外与可见光图像融合算法[1-12]。其中,基于像素层红外与可见光图像的融合方法大体上可以分为基于空间域融合方法和基于变换域融合方法。基于空间域融合方法是在空间域对配准的高、低空间分辨率图像进行处理,包含直接融合法、加权融合法等。该类方法在融合处理过程中不对图像进行分解,可能会导致融合图像出现模糊,其相应的对比度较低。目前,使用最多的图像融合方法是基于多尺度变换的融合方法,其是针对变换域而言的,主要包含基于塔形分解的变换方法[1]、基于小波变换的方法[2-3]、基于Curvelet变换的方法[4]、基于Contourlet变换的方法[5]、基于双树复小波变换的方法(DTCWT)[6-7]等。基于塔形分解的变换方法包括基于拉普拉斯金字塔变换[8]、基于梯度金字塔变换[9],以及基于低通比率金字塔(ROLP)变换[10]等。然而上述方法均不具有平移不变性,在融合结果中表现出较明显的伪Gibbs现象。为了解决此类问题,学者们提出了NSCT(non-subsampled contourlet transform)法与NSST(non-subsampled contourlet transform)法[11-12],这些方法具有较好的方向选择性和平移不变性。但是,其在融合的过程中没有充分考虑空间一致性,导致图像可能会出现亮度和颜色失真的现象。

为了克服上述缺陷,将基于边缘保留滤波的方法引入到图像融合中。这主要是因为边缘保留滤波具有平移不变性和好的边缘保留性能,且计算效率相对较高。基于边缘保留滤波的方法在应用中直接将原始图像分解到细节层和基本层,从而达到平滑纹理、保留边缘信息的目的。大部分边缘保留滤波是根据对比度平滑细节信息,而双边滤波[13]和导向滤波[14]等少数滤波方法则根据空间尺度对图像进行分解。因此,为了更好地根据图像的尺度信息保留边缘,平滑图像的结构,Zhang等[15]提出了基于滚动导向滤波(RGF)的方法,其不仅可以更好地平滑图像纹理信息,还可以在实现过程中通过迭代来保留图像的边缘信息。因此可以很好地应用到图像处理中。常规的多尺度分解方法仅从单一通道对图像的信息进行分解,不能对图像信息进行精确分类,而混合多尺度分解方法可以弥补此缺陷,得到不同类型的图像信息。如Zhou等[13]提出将高斯滤波与双边滤波相结合的混合多尺度分解方法,其主要优点有:1)在融合过程中尽可能多地把红外光谱信息融入到可见光图像中;2)保留了可见光图像的场景和细节信息。因此,结合滚动导向滤波和混合多尺度分解方法,可以充分地提取图像的纹理、细节信息,同时保留图像的边缘信息。

此外,在图像融合过程中,选择合适的融合规则同样至关重要。脉冲耦合神经网络(PCNN)因其具有全局耦合性和脉冲同步性,目前已广泛应用于图像处理中。然而,常规的PCNN模型不能同时处理两幅图像,且经常选用单一像素值作为外部刺激,选用常量作为链接强度,降低了对图像细节信息处理的准确性。为了解决上述问题,Cheng等 [16]提出了一种改进的双通道自适应脉冲耦合神经网络模型(DAPCNN),并将其用于处理高频子带图像信息,利用局部图像信息充分提取图像的细节信息,使DAPCNN更加适用于图像融合,且产生较好的融合效果。

基于上述分析,本文综合滚动导向滤波和混合多尺度分解方法的优势,提出了一种新的红外与可见光图像融合方法。混合多尺度分解可以保留原始图像的细节信息,滚动导向滤波具有空间一致性,可以更好地平滑图像纹理信息,保留图像边缘信息。因此,通过结合两者的优势,所提分解方法可以充分提取图像同一层包含的不同类型信息,进而根据不同的信息类型选择不同的融合规则,避免处理过程中信息的丢失。本文还选用改进的DAPCNN模型对图像的大尺度层信息进行处理,进一步提高对图像细节信息的处理能力。同时,为了充分保留输入图像的能量信息,采用区域能量加权方法处理基本层信息。实验结果表明,相比于其他方法,本文所提方法无论是在主观评价还是客观评价都表现出很明显的优势。

2 RGF和DAPCNN理论

2.1 滚动导向滤波

滚动导向滤波是Zhang等 [15]提出的一种新的边缘保留滤波。与其他边缘保留滤波的不同之处在于,滚动导向滤波将迭代运用到实现过程中,可以很好地实现快速收敛。此滤波的实现过程简单、快速,在空间重叠特征中实现了尺度的分离,所得结果没有出现人工效应。

2.1.1 滚动导向滤波实现过程

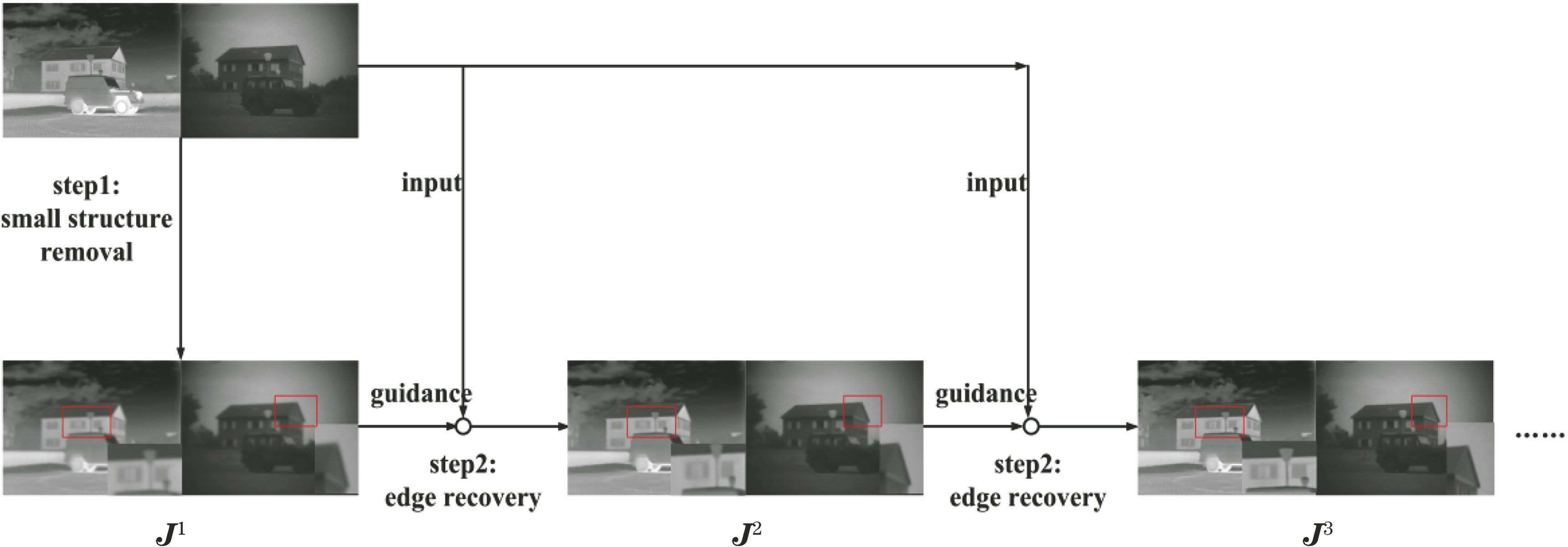

滚动导向滤波包括小结构消除和边缘恢复两个过程,如

1) 小结构消除过程。通过使用高斯滤波实现这个过程。小结构信息通常为细节信息,具体包括纹理、噪声以及小目标等信息。将

式中:

2) 边缘恢复过程。此过程的实现方式包括两步:迭代以及联合滤波。选取导向滤波作为联合滤波,这是因为导向滤波不仅有高的计算效率,还有好的边缘保留性能。将

式中:

2.1.2 参数分析

为了更好地设计基于RGF的图像分解方法,需要对RGF的参数进行分析,并探讨RGF参数的选取对融合效果造成的影响。经查阅,对RGF参数系统分析的文献甚少,故需在此对其进行较为详细的分析。由RGF的构造可知,在小结构消除过程中,参数

选择可见光图像(

客观分析过程如下:

1)固定

2)根据

3)选用确定的参数

图 2. 不同σr值所对应的RGF平滑后的结果

Fig. 2. Smooth results of RGF corresponding to different σr values

4)选用标准差(STD)、空间频率(SF)和边缘强度(EI),对所得的每一幅滤波图像进行客观评价,计算同一幅图像在不同的

经过实验分析发现,当

为了更直观地证明上述结果,计算

参数

表 1. 不同σr值对应的可见光图像的客观评价指标

Table 1. Objective evaluation indicators of visible image corresponding to different σr values

|

2.2 双通道自适应脉冲耦合神经网络

DAPCNN是以PCNN为基础的一种新的脉冲耦合神经网络。PCNN是一种反馈型网络,模拟了哺乳动物大脑视觉皮层中神经元的同步行为现象,是一种二维人工神经网络模型,具有全局耦合性和脉冲同步性。但是,PCNN有两个缺陷:1) 用单一像素值作为外部输入;2) 采用固定值作为链接强度。因此,PCNN不具有自适应性。而DAPCNN改变了外部输入与链接强度的设置,同时考虑了两幅图像之间的联系,用于避免信息的遗失,弥补了PCNN不具有自适应性的不足,可以更有效地处理图像信息。DAPCNN的实现过程包括接收域、调制域和产生域3个部分。

1) 接收域的实现过程可表示为

式中:

2) 调制域的实现过程可表示为

式中:

3) 产生域的实现过程可表示为

式中:

由于梯度可以反映图像细节信息,需要引入Sobel算子来自适应选取链接强度。对图像的任意一点使用Sobel算子,都会得到该点的梯度矢量或法矢量。图像

式中:

3 图像融合的基本过程

3.1 基于滚动导向滤波的混合多尺度分解框架的构造

滚动导向滤波可以通过调控所含参数达到保留图像边缘、平滑纹理的目的。因此,通过设置不同的参数值对图像的边缘、纹理信息进行处理,以期得到含有不同信息的滤波图像。此外,常规的多尺度分解方法是通过直接处理相邻层的滤波图像得到图像的细节层信息,但不能更深入地提取图像的不同类型信息。而混合多尺度分解方法,相当于对不同通道的滤波图像进行处理,根据不同滤波图像包含信息量的多少设计具体的分解框架,以此更充分地提取图像所包含的不同类型的细节信息,从而可以更精确地为不同类型的信息选择不同的融合方法,加强了后期图像的融合效果。结合上述两种方法的优势,提出了一种基于滚动导向滤波的混合多尺度分解方法,该方法不仅可以利用滚动导向滤波的优势提取出图像的细节信息,还可以利用混合多尺度分解方法对细节信息进行分类,得到细节信息对应的纹理信息和边缘信息,具体框架如

1) 使用一系列的滚动导向滤波去平滑输入图像

需要说明的是,这一步主要考虑的是平滑处理图像的纹理信息,因此设置

2) 使用一系列与1)不同参数的滚动导向滤波来平滑纹理细节信息,保留图像的边缘信息,即

此时,

3)将文献[

13]中所提到的混合多尺度分解方法与滚动导向滤波相结合,用于获得图像的纹理信息和边缘细节信息。经上述分析可知,所取

式中:

3.2 融合规则的选择

通过混合多尺度分解,将红外与可见光图像分解到小尺度层、大尺度层和基本层3个不同的尺度层上,并在不同尺度层上选择不同的融合规则来融合各层信息。

3.2.1 小尺度层的融合规则

小尺度层是图像分解的第一层,即

1) 对实验中所需要的参数进行初始化,选用Sobel算子作为像素点的链接强度,即利用(10)式计算链接强度

2) 计算小尺度所对应系数的边缘能量,并将其作为DAPCNN的外部输入。

式中:

式中:

3) 计算

式中:

3.2.2 大尺度层的融合规则

大尺度层包括从

1)根据小尺度层的方法计算第

2)通过使用最小化成本函数得到第

式中:

式中:

因为

式中:

3.2.3 基本层的融合规则

基本层

1) 计算像素能量

式中:

2) 计算总体能量

式中:

通过总体能量去选择最终的融合系数,可表示为

式中:

3) 为避免某些像素点的最终融合系数与其邻域内大部分相邻像素的融合系数来源于不同的图像,利用一致性检验对所得的融合系数进行处理,并利用基本图与另外两个尺度图相加得到最后的融合图像,即

3.3 融合算法

经过上述分析,所提的融合算法步骤如下:

1) 利用3.1节分别对红外与可见光图像进行混合多尺度分解,得到小尺度层

2) 利用3.2.1节的融合规则融合小尺度层

3) 利用3.2.2节的融合规则融合大尺度层

4) 利用3.2.3节的融合规则融合基本层

5) 利用(24)式对

4 实验结果与比较

为了说明所提方法的有效性,本文使用主观评价与客观评价相结合的方法,对不同融合方法所产生的融合结果进行比较分析。与所设计算法作比较的融合方法分别为DWT[19]、CVT[20]、DTCWT[21]、NSCT-DAPCNN[22]、NSDTST[23]、LATLRR[24]、GTF[25]和MSVD[26]。其中NSCT-DAPCNN方法将传统的NSCT模型与DAPCNN相结合。混合多尺度分解的分解层为4,即

4.1 融合结果的视觉评价

为了评估所提融合方法的有效性,在实验中选取了5对红外与可见光图像,见

图 4. 测试中所用到的5 组红外与可见光图像。(a) Un camp;(b) Octec;(c) Steamboat;(d) Kayak;(e) Infrared4-Visible4

Fig. 4. Five sets of infrared and visible images used in test. (a) Un camp; (b) Octec; (c) Steamboat; (d) Kayak; (e) Infrared4-Visible4

图 5. “Un camp”图像在不同融合方法下获得的融合结果

Fig. 5. Fusion results obtained by different fusion methods applied in “Un camp” image

图 6. “Octec”图像在不同融合方法下获得的融合结果

Fig. 6. Fusion results obtained by different fusion methods applied in “Octec” image

图 7. “Steamboat”图像在不同融合方法下获得的融合结果

Fig. 7. Fusion results obtained by different fusion methods applied in “Steamboat” image

图 8. “Kayak”图像对在不同融合方法下获得的融合结果

Fig. 8. Fusion results obtained by different fusion methods applied in “Kayak” image

图 9. “Infrared4-Visible4”图像对在不同融合方法下获得的融合结果

Fig. 9. Fusion results obtained by different fusion methods applied in “Infrared4-Visible4” image

4.2 融合图像的客观评价

本文选用互信息(MI)[27]、信息熵(IE)[28]、标准差 [29]、非线性相关信息熵(

表 2. 不同融合方法的客观评价指标

Table 2. Objective evaluation indicators of different fusion methods

|

为了更直观地分析本文方法在客观评价指标上的优越性,使用统计折线图(

图 10. 不同客观评价指标的统计折线图

Fig. 10. Statistical polygonal images of different objective evaluation indicators

上述分析基于客观评价指标分析所提融合方法的优势。除此之外,本文选择2幅测试图像,并将其原始红外与可见光图像以及融合图像的三维数据图作比较,以此来进一步说明所提方法对图像信息融合的效果,如

图 12. “Infrared4-Visible4”的三维数据图

Fig. 12. Three-dimensional data images of “Infrared4-Visible4”

4.3 运行时间比较

表 3. 所提方法与其他8中方法的运行时间

Table 3. Running-time of eight other methods and proposed method

|

5 结论

提出了一种基于滚动导向滤波的混合多尺度图像融合算法,使用文中所提出的基于滚动导向滤波的混合多尺度分解方法将红外图像与可见光图像分解到不同的尺度层, 再选用不同的融合规则对不同尺度层进行融合, 最后使用逆混合多尺度分解方法得到最终的融合图像。实验结果表明,无论是在主观分析还是在客观分析,所提方法相比于其他方法均能够得到更好的融合效果, 且融合结果更符合人类的视觉感知。

[1] Xu H, Wang Y, Wu Y J, et al. Infrared and multi-type images fusion algorithm based on contrast pyramid transform[J]. Infrared Physics & Technology, 2016, 78: 133-146.

[2] Daubechies I. The wavelet transform, time-frequency localization and signal analysis[J]. IEEE Transactions on Information Theory, 1990, 36(5): 961-1005.

[3] Li H, Manjunath B S, Mitra S K. Multisensor image fusion using the wavelet transform[J]. Graphical Models and Image Processing, 1995, 57(3): 235-245.

[4] 武治国, 王延杰. 一种基于边缘的曲波变换图像融合方法[J]. 光学技术, 2009, 35(5): 682-685, 690.

Wu Z G, Wang Y J. Image fusion algorithm using curvelet transform based on the edge detection[J]. Optical Technique, 2009, 35(5): 682-685, 690.

[5] CaiW, LiM, Li XY. Infrared and visible image fusion scheme based on contourlet transform[C]∥2009 Fifth International Conference on Image and Graphics, September 20-23, 2009, Xi'an, Shaanxi, China. New York: IEEE, 2009: 516- 520.

[6] Aishwarya N, Bennila Thangammal C. Visible and infrared image fusion using DTCWT and adaptive combined clustered dictionary[J]. Infrared Physics & Technology, 2018, 93: 300-309.

[7] Lewis J J. O'Callaghan R J, Nikolov S G, et al. Pixel- and region-based image fusion with complex wavelets[J]. Information Fusion, 2007, 8(2): 119-130.

[8] Burt P J, Adelson E H. The Laplacian pyramid as a compact image code[J]. IEEE Transactions on Communications, 1983, 31(4): 532-540.

[9] Petrovic V S, Xydeas C S. Gradient-based multiresolution image fusion[J]. IEEE Transactions on Image Processing, 2004, 13(2): 228-237.

[10] Toet A. Image fusion by a ratio of low-pass pyramid[J]. Pattern Recognition Letters, 1989, 9(4): 245-253.

[11] Adu J H, Gan J H, Wang Y, et al. Image fusion based on nonsubsampled contourlet transform for infrared and visible light image[J]. Infrared Physics & Technology, 2013, 61: 94-100.

[12] 吴一全, 陶飞翔. 改进投影梯度NMF的NSST域多光谱与全色图像融合[J]. 光学学报, 2015, 35(4): 0410005.

[13] Zhou Z Q, Wang B, Li S, et al. Perceptual fusion of infrared and visible images through a hybrid multi-scale decomposition with Gaussian and bilateral filters[J]. Information Fusion, 2016, 30: 15-26.

[14] 江泽涛, 吴辉, 周哓玲. 基于改进引导滤波和双通道脉冲发放皮层模型的红外与可见光图像融合算法[J]. 光学学报, 2018, 38(2): 0210002.

[15] ZhangQ, Shen XY, XuL, et al. Rolling guidance filter[M] ∥Zhang Q, Shen X Y, Xu L, et al. Computer vision-ECCV 2014. Lecture notes in computer science. Cham: Springer, 2014, 8691: 815- 830.

[16] Cheng B Y, Jin L X, Li G N. Adaptive fusion framework of infrared and visual image using saliency detection and improved dual-channel PCNN in the LNSST domain[J]. Infrared Physics & Technology, 2018, 92: 30-43.

[17] Wang J J, Li Q, Jia Z H, et al. A novel multi-focus image fusion method using PCNN in nonsubsampled contourlet transform domain[J]. Optik, 2015, 126(20): 2508-2511.

[18] Ma J L, Zhou Z Q, Wang B, et al. Infrared and visible image fusion based on visual saliency map and weighted least square optimization[J]. Infrared Physics & Technology, 2017, 82: 8-17.

[20] Nencini F, Garzelli A, Baronti S, et al. Remote sensing image fusion using the curvelet transform[J]. Information Fusion, 2007, 8(2): 143-156.

[21] SruthyS, ParameswaranL, Sasi AP. Image fusion technique using DT-CWT[C]∥2013 International Mutli-Conference on Automation, Computing, Communication, Control and Compressed Sensing (IMac4s), March 22-23, 2013, Kottayam, India. New York: IEEE, 2013: 160- 164.

[23] Yin M, Duan P H, Liu W, et al. A novel infrared and visible image fusion algorithm based on shift-invariant dual-tree complex shearlet transform and sparse representation[J]. Neurocomputing, 2017, 226: 182-191.

[24] ( 2018-12-18)[2018-12-24].https:∥arxiv.org/abs/1804.08992?context=cs.

LiH, Wu XJ. Infrared and visible image fusion using latent low-rank representation[EB/OL].

[25] Ma J Y, Chen C, Li C, et al. Infrared and visible image fusion via gradient transfer and total variation minimization[J]. Information Fusion, 2016, 31: 100-109.

[26] Naidu V P S. Image fusion technique using multi-resolution singular value decomposition[J]. Defence Science Journal, 2011, 61(5): 479-484.

[27] Qu G H, Zhang D L, Yan P F. Information measure for performance of image fusion[J]. Electronics Letters, 2002, 38(7): 313-315.

[28] 冯欣, 曾周末, 封皓, 等. 基于小波信息熵的分布式振动传感系统的扰动评价方法[J]. 光学学报, 2013, 33(11): 1106005.

[29] Balasubramaniam P, Ananthi V P. Image fusion using intuitionistic fuzzy sets[J]. Information Fusion, 2014, 20: 21-30.

[30] Wang H D, Yao X. Objective reduction based on nonlinear correlation information entropy[J]. Soft Computing, 2016, 20(6): 2393-2407.

[31] Chen H, Varshney P K. A human perception inspired quality metric for image fusion based on regional information[J]. Information Fusion, 2007, 8(2): 193-207.

Article Outline

赵程, 黄永东. 基于滚动导向滤波和混合多尺度分解的红外与可见光图像融合方法[J]. 激光与光电子学进展, 2019, 56(14): 141007. Cheng Zhao, Yongdong Huang. Infrared and Visible Image Fusion via Rolling Guidance Filtering and Hybrid Multi-Scale Decomposition[J]. Laser & Optoelectronics Progress, 2019, 56(14): 141007.