基于注意力机制与迁移学习的乳腺钼靶肿块分类  下载: 1300次

下载: 1300次

1 引言

乳腺癌是女性中最常见的癌症,据世界卫生组织(WHO)统计,2018年全世界范围乳腺癌相关死亡人数超过627000例[1]。近年来,全球每个地区女性乳腺癌的发病率和死亡率均呈上升趋势,尽管在全球范围内中国的乳腺癌发病率相对较低,但是中国女性乳腺癌的疾病负担依然不容小觑[2-3]。乳腺癌时刻威胁着女性生命健康,通过研发科学有效的乳腺癌早期筛查方法,能对乳腺癌进行有效防治。乳腺钼靶检查作为乳腺癌病灶可视化及乳腺组织早期病变筛查的主要影像学检查方法,能为后续治疗提供有效可靠的临床依据,是乳腺癌早期筛查的一种常用方法,已被广泛应用于多个国家[4]。然而,大量乳腺影像的阅片诊断需耗费医师大量时间,且十分依赖医师的专业性,即使对于训练有素的放射线医师而言,乳腺钼靶影像的阅片诊断也具有挑战性,且乳腺钼靶影像病变区域形态各异,易导致漏诊误诊率增加。其中,乳腺肿块作为早期病变特征,良恶性肿块差异性小,且容易与乳腺组织混淆,肉眼难以辨别,极易导致误判,为此,依赖人工智能技术,实现基于深度学习的乳腺肿块自动分类技术能够在一定程度上减少成本,降低由人类视觉感知引起的误判率[5-6]。

人工智能凭借其广泛的应用领域,能为医学影像提供低成本且有效可靠的初始解释。深度学习的快速发展持续推动着医学图像分析的发展[7-10]。近年来,研究学者对于乳腺癌的自动分类开展了广泛的研究。Falconi等[11]针对从CBIS-DDSM数据集采样得到的肿块切片,分别依据ResNet50和MobileNet网络模型进行迁移学习,实现了肿块良恶性分类,两种模型的分类准确率分别为78.4%和74.3%。孙利雷等[12]设计了双路径计算卷积深度学习网络,依据两条计算路径进行不同尺度卷积核的卷积计算,对乳腺钼靶肿块良恶性进行分类,利用DDSM数据集上提取的肿块数据进行测试,从测试结果可知AUC(Area Under Receiver Operating Characteristics Curve)值达到了0.7129。杨洁等[13]通过构建带有残差结构的“人型”卷积神经网络模型,对完整的乳腺钼靶影像图片进行分类研究,准确率达到了74.54%。Khan等[14]提出了基于卷积神经网络的多视图特征融合乳腺钼靶分类模型,在CBIS-DDSM数据集的4种不同乳腺钼靶影像视图中提取病变切片作为多视图网络的输入进行特征提取,最后融合多路特征进行分类。该模型在乳腺肿块切片良恶性分类上获得了AUC值为0.757的分类效果。Li等[15]设计了一个深层双路径网络,并将其用于CBIS-DDSM数据集中提取的肿块切片图像的良恶性分类,网络中一路使用带残差结构的卷积层提取特征,一路使用U-Net对肿块图片进行语义分割,生成切片肿块掩码,进一步改进分类结果,两条学习路径互为补充,提高了分类性能,在肿块切片良恶性分类上AUC值达到0.85。前人的工作证明深度学习以及卷积神经网络在乳腺钼靶影像分类上具有很大的潜力,然而目前对提取切片的分类精度不足以满足临床的实际应用,若直接对完整图片进行分类,很可能会因病变区域小而未提取到正确的病变特征。

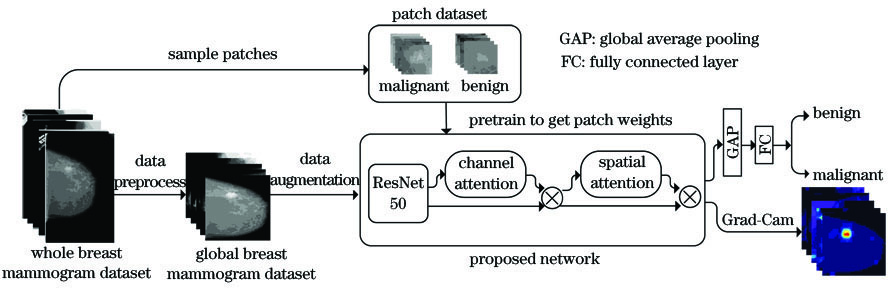

本文针对以上问题,提出了一种乳腺钼靶影像良恶性肿块的分类方法,该方法提升了局部乳腺肿块切片图像及全局乳腺钼靶图像的肿块良恶性分类性能。1)提出了将残差网络ResNet50[16]与注意力机制CBAM(Convolutional Block Attention Module)[17]结合的网络模型,并将其用于病变特征提取。CBAM作为一种注意力机制,能提高网络对关键特征的注意力,能自适应细化提取特征,提升了分类性能。2)以乳腺肿块切片数据集为源域的迁移学习方法替代传统上用ImageNet[18]为源域的迁移学习方法。由于自然图像与医学影像存在较大差异,用ImageNet作为迁移学习源域并不适用于乳腺钼靶影像图片肿块分类,而用提取的肿块切片数据集预训练网络模型,能使网络在初始化权重中获得识别肿块病变特征的能力。

2 材料与方法

首先对完整乳腺钼靶图片分别进行采样切片和数据预处理,得到局部肿块切片图像数据集P和全局乳腺钼靶图像数据集G;然后用切片数据集P初始化所设计的网络模型,得到初始化权重;最后将全局乳腺图像经过数据增强后送入网络,以切片数据集训练得到的权重初始化网络,进一步训练全局乳腺图片,得到最终的分类结果与病变可视化定位。所提方法的流程如

2.1 原始数据集概述

选取的CBIS-DDSM(Curated Breast Imaging Subset of DDSM)[19]数据集,是乳腺钼靶筛查数字数据库DDSM的更新和标准化版本,其中所有的图像都由原始的LJPEG格式转换为标准DICOM格式,该数据集包含分别来自1249位女患者的乳腺钼靶图像。其中包含1590张肿块图片(良性肿块845张,恶性肿块745张),图片对应病变区域含有像素级标注。患者的左右乳房通常会从两个不同角度拍摄,整个数据集中共包含4种乳腺视图,分别是左乳腺侧斜位(L-MLO)、左乳腺头足位(L-CC)、右乳腺侧斜位(R-MLO)、右乳腺头足位(R-CC),如

图 2. CBIS-DDSM数据集中不同视图(L-CC, L-MLO, R-CC和R-MLO)下的乳腺钼靶图片和像素级病变标签

Fig. 2. Mammograms and the pixel-level lesion labels of different views (L-CC, L-MLO, R-CC and R-MLO) from CBIS-DDSM dataset

2.2 数据集的制作

CBIS-DDSM数据集中完整的乳腺钼靶图像大小一般为4000 pixel×3000 pixel,如

本文用作迁移学习源域的样本来自于对病变区域进行采样得到的乳腺肿块切片。由于CBIS-DDSM数据集包含对肿块病变区域的像素级标签及其经过病理确认的标签:良性或恶性。根据像素级标签,可以得到完整乳腺钼靶图片上对应的肿块位置信息,并将其用于采样切片图像。具体制作方法如下:首先确定肿块目标框的坐标点x、y、w、h,其中(x, y)为肿块的中心点坐标,w、h为肿块的宽度和高度,在肿块目标框内随机生成8个坐标点为采样中心点,截取包含肿块及部分上下文特征的切片,并将切片图像大小统一为224 pixel×224 pixel,然后将采样得到的病变肿块切片整理成一个切片数据集P,数据集中图片如

图 3. 不同数据集图片。(a)来自数据集P中的局部乳腺肿块切片图像;(b)来自CBIS-DDSM数据集中的完整乳腺钼靶图像;(c)来自数据集G中的全局乳腺钼靶图像

Fig. 3. Images from different datasets. (a)Local breast mass patch image from dataset P; (b)whole breast mammogram from CBIS-DDSM dataset;(c)global breast mammogram from dataset G

考虑到内存问题,图片输入特征提取网络前一般会进行放缩,这可能会因病变区域放缩过小而丢失重要信息,大面积的背景区域会导致计算资源浪费,伪影的存在也会干扰网络对肿块特征的提取。因此本研究对原始乳腺钼靶图片进行了数据预处理,去除了与分类目标无关的背景、伪影区域,并统一尺寸为512 pixel×512 pixel,得到全局乳腺图像数据集G,如

2.3 数据增强

基于深度学习的医学图像视觉任务成就不仅依赖于卷积神经网络(CNN)模型,而且还依赖于图像的样本数量。样本数量不足将会导致模型训练时出现过拟合、模型的泛化能力差等问题。并且,由于种种原因,如病人隐私、拍摄设备不同、病人体质差异,以及样本需要权威专家人工标注等,公共化大规模带有标注的乳腺钼靶图像数据库难以得到。因此,本研究通过对现有图像样本进行数据增强,依次对数据进行水平翻转、垂直翻转、0°~20°随机旋转、变形缩放,来增大数据量,以使神经网络学习到对分类任务有用的特征,增加网络的泛化能力和鲁棒性,避免网络训练过程中出现过拟合现象。

2.4 网络模型设计

本文将ResNet50与CBAM相结合的卷积神经网络模型,用于实现乳腺钼靶影像图像肿块的良恶性分类,将ResNet50的特征提取层作为主干网络,其后加入CBAM,得到所提特征提取网络模型。残差网络结构可以通过堆叠多层卷积实现对乳腺肿块特征的提取。CBAM用于提高对关键特征的敏感度,使网络在进行特征提取时,注意力集中在有用的关键信息上,抑制无用的信息。CBAM模块的加入,使得网络可以捕捉恶性肿块和良性肿块的细微差异,对类间差异较小的分类任务性能有一定的提升作用。

2.4.1 残差网络ResNet50

卷积层具有强大的特征提取能力,深度卷积网络通过多个堆叠的卷积层整合高低层特征,进一步丰富了特征表达,然而简单地堆叠卷积层易造成网络层冗余,导致梯度消失、梯度爆炸以及网络性能退化问题。残差网络利用残差学习,通过跳跃连接起到恒等映射(Identity Mapping)的作用,解决了在较深网络训练过程中梯度弥散及网络退化等问题。ResNet50中残差块结构可由

假设给定残差块的输入为x,x经过残差块后得到的输出为H(x)=F(x)+x,则残差学习部分为F(x)=H(x)-x,若此时卷积层变成了冗余层,那么最理想的输出特征是H(x)=x,则残差学习F(x)=0,此时残差块只做了恒等映射,至少网络性能没有下降,事实上残差学习不会为0,这也使得卷积层学习到新的特征,从而拥有更好的性能。而ResNet50使用了1×1+3×3+1×1叠加卷积层的瓶颈结构,首端和末端的1×1卷积用来降维和恢复维度,中间3×3卷积用来加深网络,该网络能更好地提取非线性特征。

2.4.2 注意力机制CBAM

注意力机制主要是通过模拟人眼视觉感知,关注突出特征,以便更好地捕捉图片中的重点信息。注意力机制的加入能更好地提升分类网络的性能。

CBAM主要由串联的通道注意力(Channel Attention)和空间注意力(Spatial Attention)组成,通过通道注意力模块学习到关键特征“是什么”,再通过空间注意模块学习到关键特征“在哪里”,以便对特征进行更好的自适应细化。

通道注意力通过提取不同通道特征对关键信息的重要程度,优化特征分类效果。由于高层特征的通道图可以视为对不同语义特征的响应,且语义特征的响应相互联系,故通道注意力可以用于挖掘通道图之间的依赖关系,获得每个特征通道的重要程度,并依照重要程度有选择性地关注权重值大的信息,提高判别性语义的特征表示。通道注意力模块结构可由

给定通道注意力模块输入特征为F∈RH×W×C,利用平均池化层(Average Pooling)和最大池化层(Max Pooling),在空间维度上分别对输入特征进行压缩得到特征Favg∈R1×1×C和Fmax∈R1×1×C,再通过包含一个隐层的多层感知机(MLP)进行特征的降维、升维操作。其中:H为特征图的高度,W为特征图的宽度,C为特征图的通道数。多层感知机中,隐层神经元个数为 C/r,输出层神经元个数为 C,且参数是共享的,其中r为一个超参数,被称为降低率。然后将输出的两个特征图逐元素求和,利用Sigmoid函数对求和得到的特征图进行激活得到通道注意力权重系数MC(F)∈R1×1×C,将权重系数MC与输入特征F进行逐元素相乘,得到经过通道注意力细化后的输出特征F',通道注意力模块权重系数MC(F)可表示为[18]

其中,W0∈RC/r×C和W1∈RC×C/r分别表示多层感知机隐层和输出层权重矩阵,AvgPool(·)和MaxPool(·)表示平均池化操作和最大化池化操作,MLP(·)表示多层感知机对特征的降维和升维操作。

空间注意力模块将注意力聚焦在关键特征的空间位置信息,通过对特征的位置信息赋予不同权重,使网络根据权重分配学习到对分类任务有用的特征信息。由于上下文信息对特征分类有重要的作用,空间注意模块通过在局部特征上构建丰富的上下文关系,增强了对判别性特征的表达能力。空间注意力模块结构如

以通道注意力块输出的特征F'作为空间注意力块的输入,在通道维度上分别经过一个平均池化层和最大池化层压缩得到一维通道特征图F'avg∈RH×W×1和F'max∈RH×W×1,并将其在通道维度上拼接成一个通道数为2的特征图。再用一个卷积核大小为7的卷积层对其进行通道维度上的压缩,此时特征图的大小被压缩为H×W×1,用 Sigmoid对其激活,得到空间注意力权重系数MS(F')∈RH×W×1,与输入特征F'进行对应元素相乘,得到经过空间注意力细化后的特征图F″∈RH×W×1,从而达到对输入特征位置信息的强调作用。空间注意力块权重MS(F')可表示为

其中,f7×7 表示卷积核大小为7的卷积层。

CBAM的整个流程可概括为:输入特征图F∈RH×W×C,先经过通道注意模块得到通道权重系数MC并与输入特征图F相乘,得到包含更多通道维度上的关键特征的特征图F',再将F'作为空间注意模块的输入特征,得到空间权重系数MS并与F'相乘,得到包含更多空间位置关键信息的特征图F″,整个流程可表示为

式中:⊗表示卷积运算。

2.5 迁移学习

迁移学习通过将从相关任务中学习到的知识应用于新任务中来改进新任务的学习效果,已在图像处理领域广泛使用。一般来说,当源域与目标域相似度较高时,得到的迁移学习效果相对较好。通常是使用由自然图像组成的ImageNet预训练网络模型得到初始化权重,然而,由于自然图像与医学影像尤其是乳腺钼靶图像相差甚远,因此本研究中不使用ImageNet作为迁移学习的源域。

本文设计了以肿块切片图像为源域的迁移学习方法。首先,将采样得到的局部乳腺肿块切片数据集P中的图片分为两类,分别是良性肿块、恶性肿块。将切片数据集以80∶10∶10的比例随机划分为独立的训练集、验证集、测试集,且每个集合正负样本的比例保持一致。将训练集输入网络模型进行特征提取,训练使网络学习到关于病变区域的良恶性肿块细微的病理特征差异。本研究使用以下参数训练局部乳腺肿块分类网络模型[14,20]:优化器采用Adam,损失函数为交叉熵损失(Cross Entropy Loss)。设置初始学习率为10-3,如果验证集的准确率在10个时期内没上升,则学习率衰减因子为0.2。受显存限制,将批处理大小设为32。网络训练迭代批次设为150,并设置了早停(early stopping)机制,在这种早停的设置中,当网络性能连续20个批次没有改善或完成了最大150个批次的循环时,训练过程终止,并保存训练得到的权重。此时在肿块切片数据集P上训练得到的权重已经包含了提取肿块良恶性病变特征的能力,后续将被用来初始化全局乳腺钼靶数据集分类网络。然后,将全局乳腺钼靶图片数据集G按照60∶20∶20的比例随机划分为独立的训练集、验证集和测试集,并将训练集输入网络模型进行特征提取,以切片数据集得到的权重为网络初始化权重进行迁移学习,训练模型使其具有在全局乳腺图像上定位并分类良恶性肿块的能力。在全局乳腺肿块分类网络训练过程中,使用交叉熵损失函数,优化器使用随机梯度下降(Stochastic gradient descent),动量设置为0.9。网络初始学习率设为10-2,当验证集准确率连续10个批次没有提高时,设置学习率衰减因子为0.2。受显存限制,批处理大小设为4,训练迭代批次设为200,同样设置了早停机制,当连续20个批次网络性能没有提升时,训练终止,并保存权重。

本文中所提出的迁移学习方法把乳腺切片作为迁移学习的源域,把全局乳腺图片作为迁移学习的目标域,由于两者之间具有相近的语义特征,所以本文方法能得到较好的迁移效果。

3 分析与讨论

3.1 方法优异性验证

为了更好地评估不同方法的分类性能,使用准确率(Accuracy,XAcc)、敏感性(Sensitivity,XSen)、特异性(Specificity,XSpe)、AUC值作为模型评估指标。敏感性和特异性在医学统计中,是最基本的诊断指标,敏感性表明了模型对恶性肿块的识别准确度,特异性则表示模型对良性肿块的识别精度,而AUC是评价分类模型的重要指标。准确率、敏感性、特异性的表达式为

式中:XTP为真阳性,即阳性被预测为阳性的样本个数;XFN为假阴性,即阳性被预测为阴性的样本个数;XTN为真阴性,即阴性被预测为阴性的样本个数;XFP为假阳性,即阴性被预测为阳性的样本个数。

为了进一步证实所提网络模型的有效性,本文中以同样的方式设计了将VGG16[21]与CBAM结合的网络模型(VGG16+CBAM)以及将InceptionV3[22]与CBAM结合的网络模型(Inception V3+CBAM),并将所提出的网络模型与VGG16、VGG16+CBAM 、InceptionV3、Inception V3+CBAM 、ResNet50等网络模型在乳腺肿块切片数据集P与全局乳腺钼靶数据集G上的分类效果进行对比,见

表 1. 不同网络模型在切片数据集P上的分类效果对比

Table 1. Comparison of classification performance of different network models on patch dataset P

|

表 2. 不同网络模型与迁移学习方法在全局乳腺数据集G上的分类效果对比

Table 2. Comparison of classification performance of different network models and different transfer learning methods on global breast dataset G

|

3.2 Grad-CAM可视化

为了直观地得到特征提取网络所关注的重点信息,引入Grad-CAM[23],对肿块病变区域进行可视化,并通过热力图的方式显示出来,直截了当地表明了卷积神经网络对关键特征的提取能力。通过对热力图的观察,可以更好地了解模型决策时所强调的特征信息,良好的可视化也可以用于临床,辅助医师更快地找到病变区域定位。如

图 7. 来自数据集G中的乳腺钼靶图像及对应的Grad-CAM热力图。(a)样片1(良性);(b)样片2(良性);(c)样片3(恶性);(d)样片4(恶性);(e)样片5(恶性)

Fig. 7. Mammogram from dataset G and heat maps of the corresponding Grad-CAM. (a)Sample 1(benign); (b)sample 2(benign);(c)sample 3(malignant);(d)sample 4(malignant);(e)sample 5(malignant)

4 结论

在ResNet50的基础上,提出一种结合注意力机制CBAM与残差网络ResNet50的神经网络模型。通过引入注意力机制CBAM,加强对关键特征的辨别,增强了网络模型对局部细节特征的提取能力,实现了较高精度的乳腺钼靶图像肿块良恶性分类。此外,提出了以病变切片数据集作为迁移学习源域的研究方法,使得全局乳腺钼靶影像在语义相似的切片图像上进行了领域自适应迁移学习,达到了优于ImageNet的迁移学习效果,进一步改善了模型的分类表现。同时,利用对比实验证明了本文方法能够提高乳腺钼靶图像良恶性肿块的分类性能,并且借助Grad-CAM对病变区域进行了可视化,具有潜在的实际应用前景。

[1] World HealthOrganization. Breast cancer [EB/OL]. [2020-06-03].https:∥www.who.int/cancer/prevention/diagnosisscreening/breast-cancer/en/.

[2] Yin J H, Zhang Y, Lai J G, et al. Global burden of disease cancer collaboration[J]. JAMA Oncology, 2015, 1(4): 505-527.

[3] 师金, 梁迪, 李道娟, 等. 全球女性乳腺癌流行情况研究[J]. 中国肿瘤, 2017, 26(9): 683-690.

[6] Kooi T. Litjens G, van Ginneken B, et al. Large scale deep learning for computer aided detection of mammographic lesions[J]. Medical Image Analysis, 2017, 35: 303-312.

[7] 黄泳嘉, 史再峰, 王仲琦, 等. 一种基于混合损失函数的改进型U-Net网络的肝部医学影像分割方法[J]. 激光与光电子学进展, 2020, 57(22): 221003.

[8] 郑斌, 杨晨, 马小萍, 等. 基于循环卷积神经网络的甲状腺恶性结节检测[J]. 激光与光电子学进展, 2019, 56(24): 241003.

[9] 艾玲梅, 石康珍. 基于条件生成对抗网络的低级胶质瘤MR图像分割[J]. 激光与光电子学展, 2020, 57(22): 221004.

[11] Falconí LG, PérezM, Aguilar WG. Transfer learning in breast mammogram abnormalities classification with mobilenet and nasnet[C]∥2019 International Conference on Systems, Signals and Image Processing (IWSSIP), June 5-7, 2019, Osijek, Croatia.New York: IEEE Press, 2019: 109- 114.

[12] 孙利雷, 徐勇. 基于深度学习的乳腺X射线影像分类方法研究[J]. 计算机工程与应用, 2018, 54(21): 13-19.

Sun L L, Xu Y. Research on classification method of mammography based on deep learning[J]. Computer Engineering and Applications, 2018, 54(21): 13-19.

[13] 杨洁, 胡明娣, 李立, 等. 人型网络乳腺钼靶影像分类方法研究[J/OL]. 计算机工程与应用: 1-8[2020-06-04].http:∥kns.cnki.net/kcms/detail/11.2127. TP. 20191205.1030.002.html.

YangJ, Hu MD, LiL, et al. and Applications: 1-8 [2020-06-04].http:∥kns.cnki.net/kcms/detail/11. 2127. TP. 20191205.1030.002.html.

[15] Li HY, Chen DD, Nailon WH, et al.A deep dual-path network for improved mammogram image processing[C]∥2019 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), May 12-17, 2019, Brighton, United Kingdom.New York: IEEE Press, 2019: 1224- 1228.

[16] He KM, Zhang XY, Ren SQ, et al.Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA.New York: IEEE Press, 2016: 770- 778.

[17] WooS, ParkJ, Lee JY, et al.CBAM: convolutional block attention module[M] ∥Computer Vision (ECCV 2018). Cham: Springer International Publishing, 2018: 3- 19.

[18] DengJ, DongW, SocherR, et al.ImageNet: a large-scale hierarchical image database[C]∥2009 IEEE Conference on Computer Vision and Pattern Recognition, June 20-25, 2009, Miami, FL, USA. New York: IEEE Press, 2009: 248- 255.

[21] SimonyanK, Zisserman A. Very deep convolutional networks for large-scale image recognition[EB/OL].( 2014-09-04)[2020-06-04]. https:∥arxiv.org/abs/1409. 1556.

[22] SzegedyC, VanhouckeV, IoffeS, et al.Rethinking the inception architecture for computer vision[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA.New York: IEEE Press, 2016: 2818- 2826.

[23] Selvaraju R R, Cogswell M, Das A, et al. Grad-CAM: visual explanations from deep networks via gradient-based localization[J]. International Journal of Computer Vision, 2020, 128(2): 336-359.

Article Outline

许文慧, 裴以建, 郜冬林, 朱久德, 刘云凯. 基于注意力机制与迁移学习的乳腺钼靶肿块分类[J]. 激光与光电子学进展, 2021, 58(4): 0410007. Wenhui Xu, Yijian Pei, Donglin Gao, Jiude Zhu, Yunkai Liu. Mass Classification of Breast Mammogram Based on Attention Mechanism and Transfer Learning[J]. Laser & Optoelectronics Progress, 2021, 58(4): 0410007.