基于正交迭代的参考点不确定相机位姿估计  下载: 1373次

下载: 1373次

1 引言

相机的位姿估计是相机参数估计中的外参数估计,是计算机视觉、摄影测量学、计算机图形学等学科所要研究的关键问题,在目标识别与跟踪[1]、相机标定[2-3]、移动机器人导航和定位[4]、增强现实[5]等领域都有重要应用。其中,基于空间参考点的单目视觉位姿估计,也称为透视

P

当空间参考点的数目大于5时,一般采用迭代方法,利用优化理论最小化物方或像方目标函数求得相机的位姿[15-16]。常用的非线性算法有最大似然估计(ML)[21]、比例正交投影迭代变换(POSIT)[22]及正交迭代算法[23]等。针对迭代算法存在的局部收敛及收敛速度慢的问题,许多学者提出了改进方法。Haralick等[24]提出了一种基于点特征的相机位姿迭代求解算法,引入空间参考点的景深变量使算法全局收敛,但是收敛速度较慢。Lu等[25]利用单目视觉中的逆投影思想,通过最小化物体空间共线性误差得到相机位姿,算法的迭代次数较少,但是求解过程容易受到误差的影响,导致估计精度降低。李鑫等[26]提出了一种加速正交迭代算法,在正交迭代算法的基础上对迭代计算过程中的平移量、投影点以及目标函数进行规整,降低了计算的复杂度,提高了相机位姿估计的实时性。周润等[27]提出了加权正交迭代方法,根据像面重投影误差确定物方残差函数中参考点的权重系数,算法的精度较高,对测量误差具有抑制作用。

目前,正交迭代算法是性能最优的相机位姿估计算法之一,与其他的算法相比,具有迭代次数少、计算速度快的优点[28]。但是当图像点受均匀的高斯噪声影响时,正交迭代算法的全局收敛过程会产生偏差,尤其是当参考点远离相机中心时,物体空间共线性误差增大,这种偏差也会增大。

本文针对空间参考点不确定的相机位姿求解,提出了一种结合空间参考点不确定性的位姿估计算法,其关键思想是在正交迭代的基础上,考虑摄像头的畸变,通过初值得到参考点的位置信息,以此确定像点在物方残差函数中的权值,对于深度较小的参考点赋予较大的权值,对深度较大的参考点赋予较小的权值,同时对离摄像头光心较近的参考点赋予较大的权值,对离摄像头光心较远的参考点赋予较小的权值,使得优化过程中每个参考点都能对物方残差具有接近同等的贡献。根据文献[ 25]提出的加速正交迭代算法,对迭代过程中的重复计算进行规整,该方法在降低迭代过程复杂度的同时,提高了算法的稳健性与抗噪能力,提高了相机位姿的计算精度。

2 基于空间参考点不确定性的正交迭代算法

2.1 正交迭代算法

正交迭代算法是一种非线性迭代算法,通过最小化物方残差函数进行迭代优化,从而获得相机的位姿。

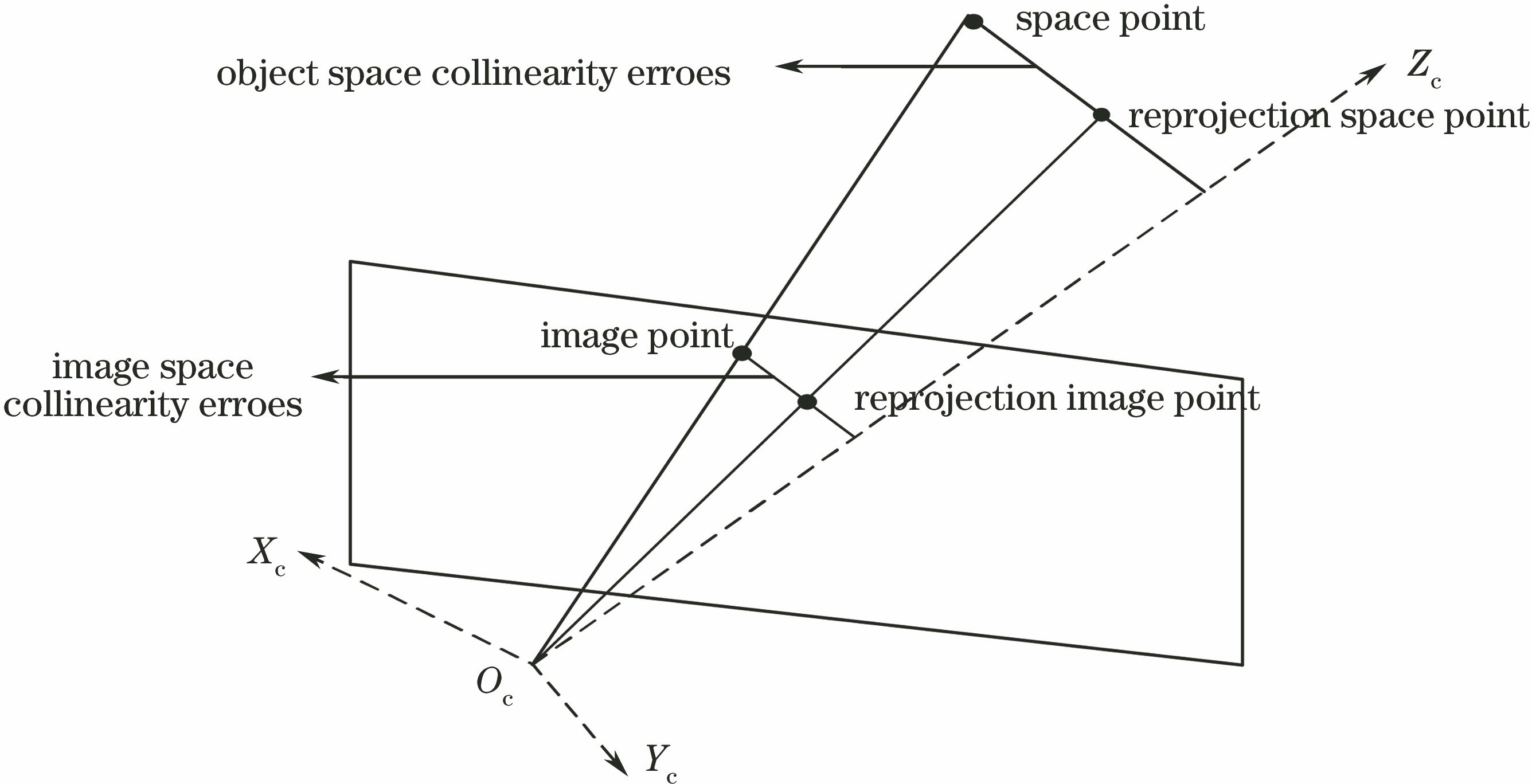

根据理想的小孔成像模型,物体的空间点、归一化图像平面点及投影中心存在线性关系,图像空间共线性方程和物体空间共线性方程定义为

式中

通过最小化所有参考点的空间共线性误差之和,可以得到相机的位姿,因此,物方残差函数定义为

图 1. 相机位姿估计物方残差和像方残差的几何意义

Fig. 1. Geometric meaning of object residuals and image residuals in camera pose estimation

式中

物方残差的约束最小二乘问题可以通过四元数或者奇异值分解(SVD)求得闭合解[21]。正交迭代算法使用SVD的绝对定向问题最优解不断迭代更新

2.2 基于参考点位置信息的正交迭代算法

利用文献[ 26]提出的加速正交迭代思想,在考虑镜头畸变的情况下,首先将相机获取图像中的参考点坐标转换为去畸变归一化的图像平面齐次坐标,即

式中(

式中(

归一化的图像平面坐标与畸变后点的坐标满足

式中(

对参考点坐标

式中

引入矩阵计算公式,

式中vec(

由初始值

式中

再根据

得到参考点在相机坐标系下的参考坐标

由物方残差函数(3)式,对深度较小的参考点赋予较大的权值,对深度较大的参考点赋予较小的权值,同时对离摄像头光心较近的参考点赋予较大的权值,对离摄像头光心较远的参考点赋予较小的权值,使得优化过程中每个参考点都能对物方残差具有接近同等的贡献。

加权后的物方残差函数为

式中

式中

对矩阵

根据更新的旋转矩阵

式中矩阵

当物方残差小于设置的目标函数下界或者收敛容差小于设置的阈值时,迭代终止,由于开始时对参考点的坐标进行了零均值化,所以输出的平移向量为

综上所述,基于参考点位置信息的正交迭代算法的具体步骤为,根据旋转矩阵的初始值及归一化的像点,得到平移向量的初始值,从而计算出空间参考点在相机坐标系下的参考位置。根据参考点在相机坐标系下的深度以及距离摄像头光心的距离得到加权物方残差目标函数,进行迭代运算。在迭代开始前,计算

3 实验

实验分为模拟数据实验和真实图像实验。实验平台为Inter(R)Core(TM)i5-6500 CPU,主频为3.2 GHz,内存大小为8.00 GB;软件平台为Win10 64位操作系统,Matlab R2016a。实验使用旋转矩阵误差

3.1 模拟数据实验

在模拟数据实验中,假定摄像头的内参矩阵为

镜头的径向畸变系数为

为了验证改进的正交迭代算法的有效性,比较下列算法的计算时间与计算精度:1) EP

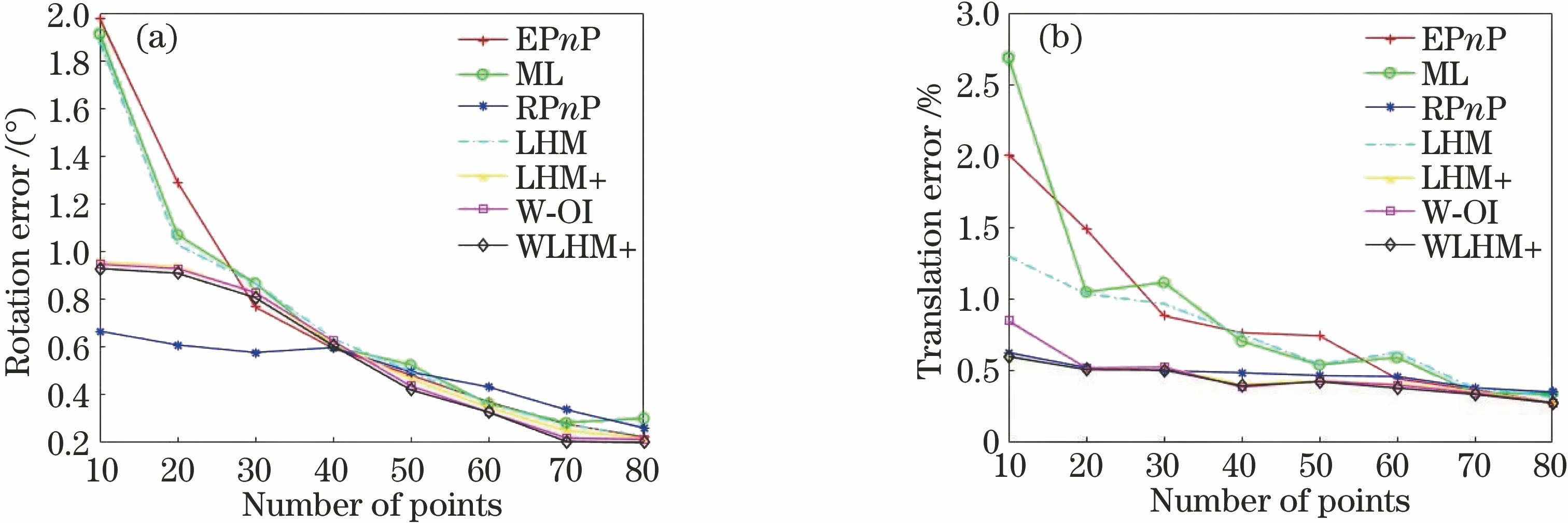

3.1.1 参考点数目实验

随机产生平移向量

图 2. 参考点数目变化时,不同算法的(a)旋转矩阵误差及(b)平移向量误差

Fig. 2. (a) Rotation matrix error and (b) translation vector error with different numbers of reference points

图 3. 参考点数目变化时不同算法的计算时间

Fig. 3. Calculation time of different algorithms with different number of reference points

由

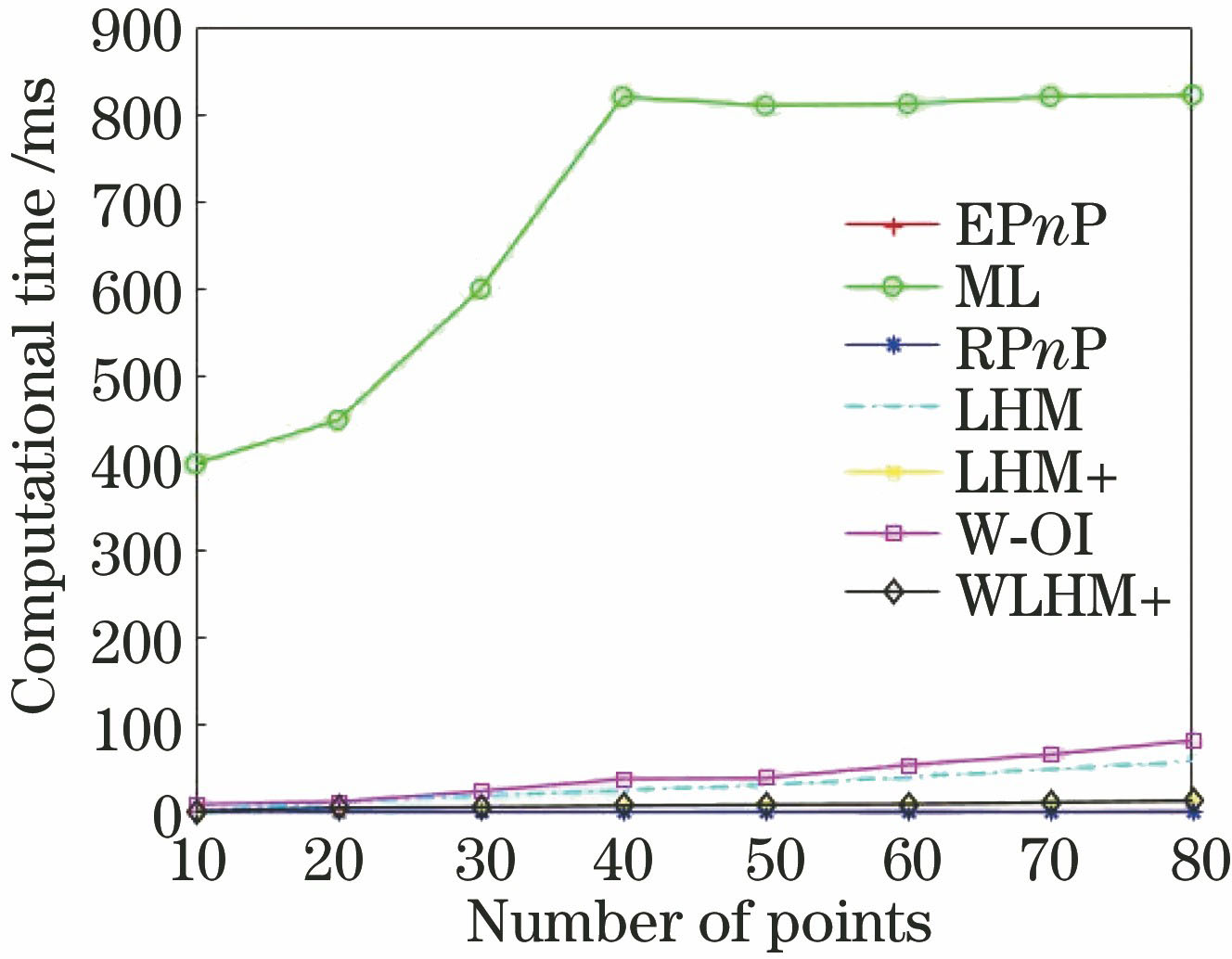

3.1.2 空间参考点中心与相机距离实验

参考点数目为50,相机光轴与空间参考点中心在同一视线上,空间参考点中心与相机距离变换范围为[10,80],变化步长为10,每个参考点数目进行1000次独立实验,对计算误差求取平均值。

由

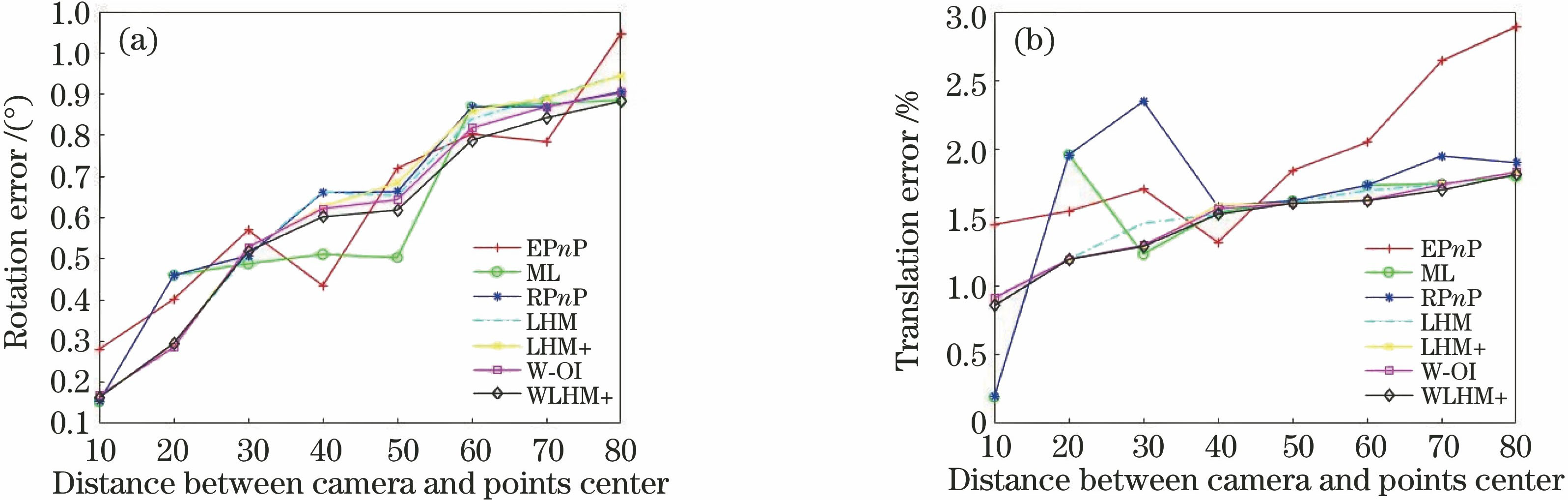

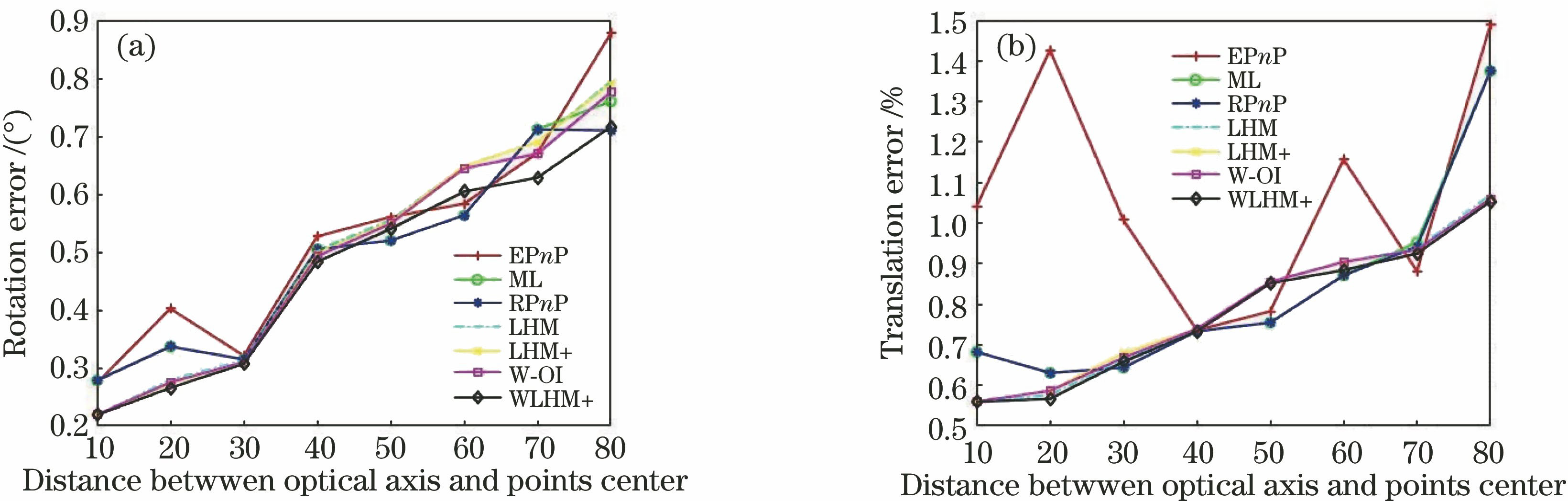

3.1.3 空间参考点中心与相机光轴距离实验

参考点数目为50,空间参考点中心与相机距离为40,相机光轴与空间参考点中心在相机坐标系的

图 4. 空间参考点中心与相机不同距离时的(a)旋转矩阵误差和 (b)平移向量误差

Fig. 4. (a) Rotation matrix error and (b) translation vector error of different distance between space reference point center and camera

图 5. 空间参考点中心与相机光轴不同距离时的(a)旋转矩阵误差和 (b)平移向量误差

Fig. 5. (a) Rotation matrix error and (b) translation vector error of different distance between space reference point center and camera optical axis

由

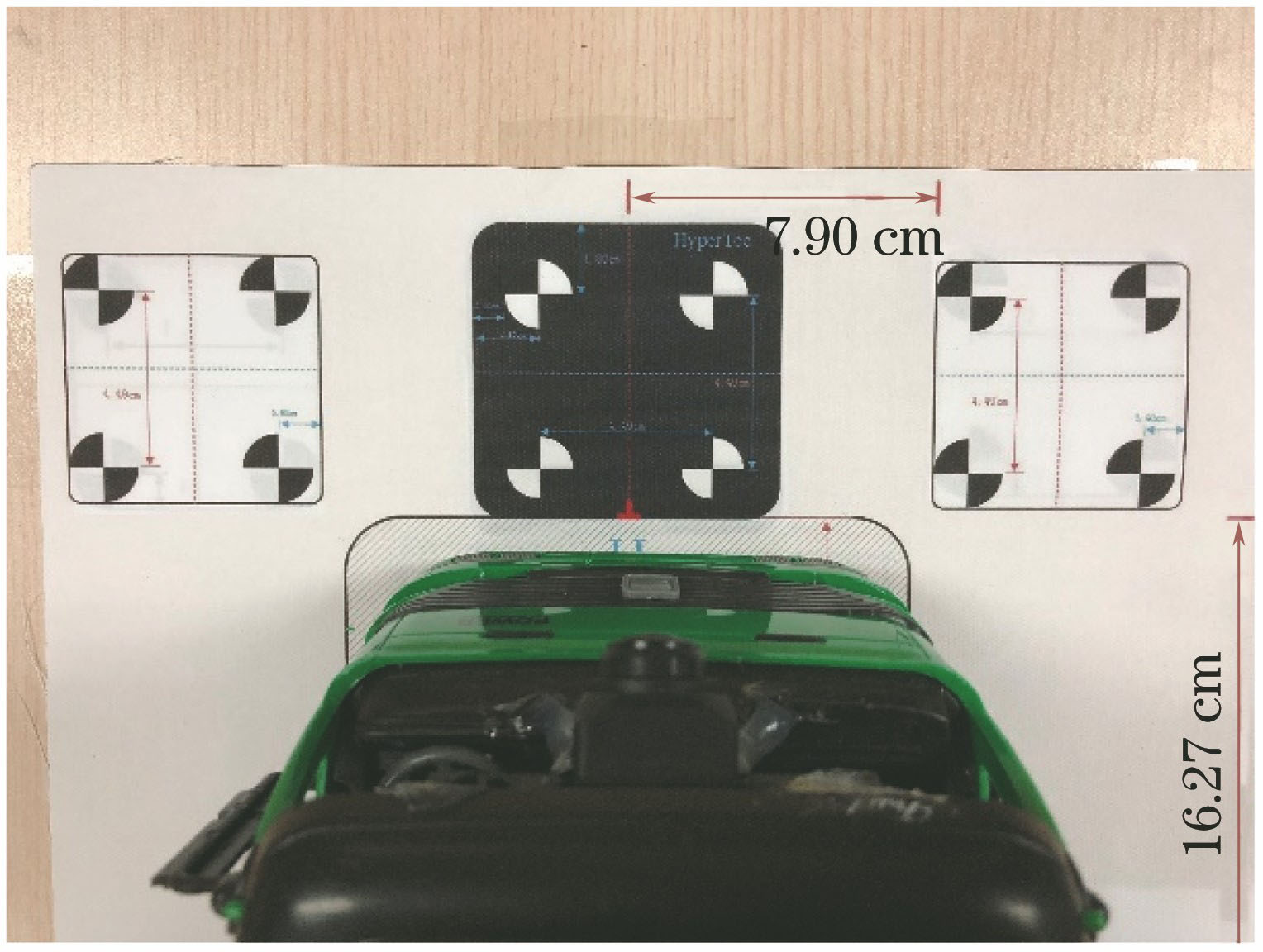

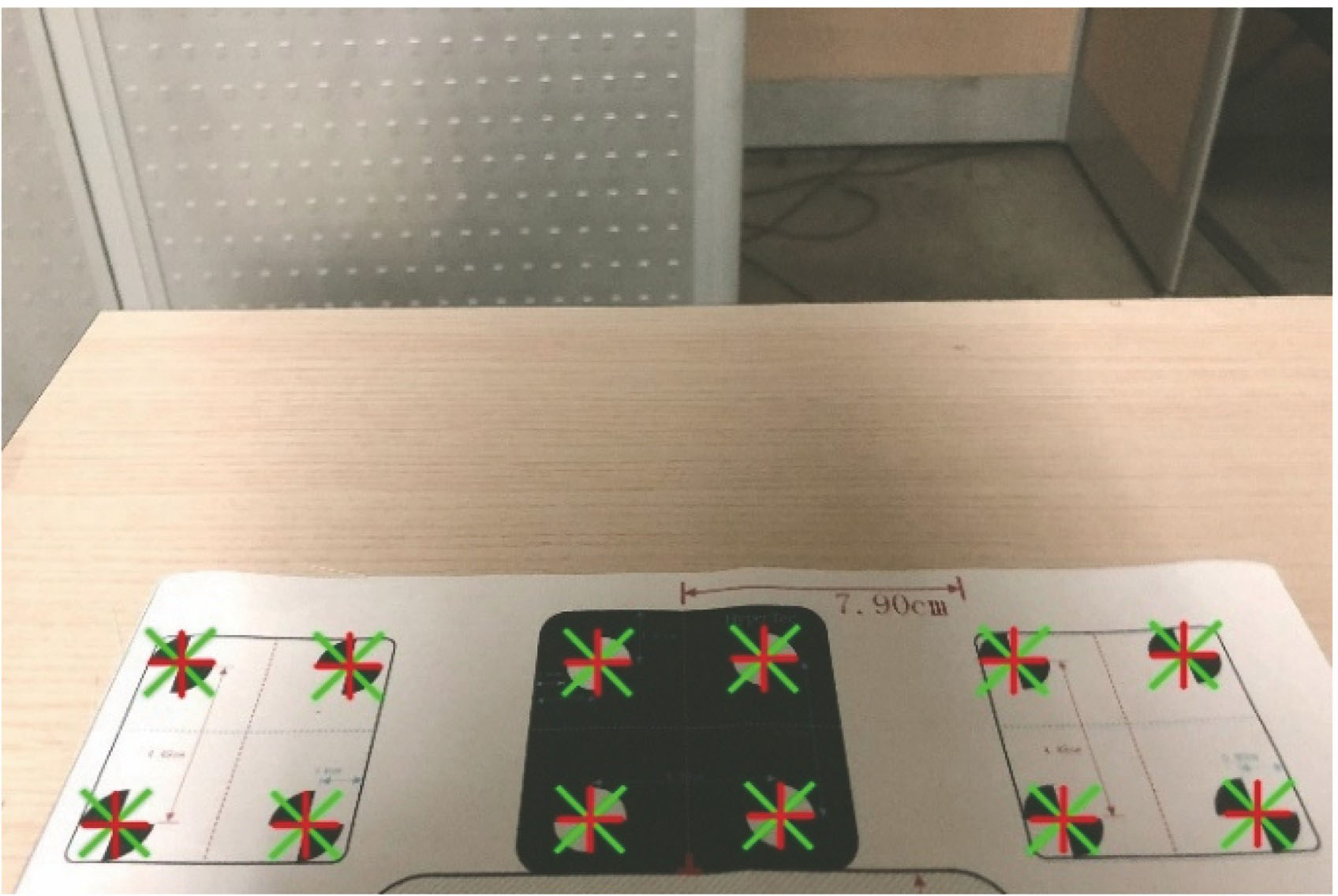

3.2 真实图像实验

在真实实验中,固定摄像头在模型车上的位置,采用基于二维平面靶标的张正友相机标定方法对摄像头进行标定,得到摄像头的内参,包括摄像头的内参矩阵、畸变系数。在布上均匀分布12个空间参考点,将布摆放在模型车底面所在平面,以模型车底面中心构建世界坐标系,得到参考点的世界坐标。具体结构如

表 1. 空间参考点像面重投影结果与真实像点距离之差

Table 1. Difference between re-projection result of spatial reference point on image plane and real image point

|

本文算法及其他算法结果进行像面重投影所得像点坐标之差。可以看出,W-OI、WLHM+算法得到的像面重投影结果与真实像点距离之差低于LHM、LHM+算法。W-OI算法对参考点进行像面重投影计算相机位姿,因此得到的重投影结果接近测量值。WLHM+算法考虑了参考点在相机坐标系下的位置信息,得到的重投影结果与像点的测量值较为吻合。

对4种非线性迭代方法的迭代次数、计算时间、像方残差及物方残差进行了对比,分析结果如

表 2. 真实图像实验结果

Table 2. Results of real image experiment

|

4 结论

针对相机位姿估计中的正交迭代算法存在稳定性差、易受噪声干扰等问题,结合空间参考点的不确定性,提出了一种改进算法。根据空间参考点的位置特征确定其对物方残差目标函数的贡献,最优化约束最小二乘物方残差函数,使物方残差近似于重投影的像方残差。利用加速的思想,提前计算迭代过程中的常量,改进算法的时间复杂度和精度均优于正交迭代算法,在达到同等精度的条件下,其时间复杂度明显低于加权正交迭代算法,较加速正交迭代算法在时间复杂度上略有增加,但是相机位姿估计的精度更高,具有更强的抗噪能力。

由于正交迭代法利用正交投影替代相机的透视投影获得位姿的数值解,因此旋转矩阵不满足单位正交约束,由此导致基于连续视频图像的相机位姿跟踪中会出现较大的累积误差,后续拟解决该问题。

[2] KeT, Roumeliotis SI. An efficient algebraic solution to the perspective-three-point problem[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2017: 4618- 4626.

[3] 吴凡路, 刘建军, 任鑫, 等. 基于圆形标志点的深空探测全景相机标定方法[J]. 光学学报, 2013, 33(11): 1115002.

[4] TahriO, ChaumetteF. Complex objects pose estimation based on image moment invariants[C]∥Proceedings of the 2005 IEEE International Conference on Robotics and Automation, 2005: 436- 441.

[8] KneipL, ScaramuzzaD, SiegwartR. A novel parametrization of the perspective-three-point problem for a direct computation of absolute camera position and orientation[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2011: 2969- 2976.

[9] KukelovaZ, BujnakM, PajdlaT. Closed-form solutions to minimal absolute pose problems with known vertical direction[C]∥Asian Conference on Computer Vision, 2010: 216- 229.

[11] 王鹏, 孙长库, 张子淼. 单目视觉位姿测量的线性求解[J]. 仪器仪表学报, 2011, 32(5): 1126-1131.

[12] 吴福朝, 胡占义. 关于P5P问题的研究[J]. 软件学报, 2001, 12(5): 768-775.

Wu F C, Hu Z Y. A study on the P5P problem[J]. Journal of Software, 2001, 12(5): 768-775.

[16] Hesch JA, Roumeliotis SI. A direct least-squares (DLS) method for PnP[C]∥International Conference on Computer Vision, 2011: 383- 390.

[17] Zheng YQ, Kuang YB, SugimotoS, et al. Revisiting the PnP problem: a fast, general and optimal solution[C]∥IEEE International Conference on Computer Vision, 2013: 2344- 2351.

[18] FerrazL, BinefaX, Moreno-NoguerF. Very fast solution to the PnP problem with algebraic outlier rejection[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2014: 501- 508.

[19] 杨森, 吴福朝. 摄像机位姿的加权线性算法[J]. 软件学报, 2011, 22(10): 2476-2487.

[21] HartleyR, ZissermanA. Multipleview geometry in computer vision[M]. Cambridge: Cambridge University Press, 2003: 1865- 1872.

[26] 李鑫, 龙古灿, 刘进博, 等. 相机位姿估计的加速正交迭代算法[J]. 光学学报, 2015, 35(1): 0115004.

[27] 周润, 张征宇, 黄叙辉. 相机位姿估计的加权正交迭代算法[J]. 光学学报, 2018, 38(5): 0515002.

[28] 岳晓奎, 武媛媛, 吴侃之. 基于视觉信息的航天器位姿估计迭代算法[J]. 西北工业大学学报, 2011, 29(4): 559-563.

李丽媛, 李文韬, 许海燕, 张卓, 谢迎娟, 张学武. 基于正交迭代的参考点不确定相机位姿估计[J]. 激光与光电子学进展, 2019, 56(1): 011503. Liyuan Li, Wentao Li, Haiyan Xu, Zhuo Zhang, Yingjuan Xie, Xuewu Zhang. Camera Pose Estimation with Uncertain Reference Point Based on Orthogonal Iterative[J]. Laser & Optoelectronics Progress, 2019, 56(1): 011503.