基于认知模型的遥感图像有效飞机检测系统  下载: 839次

下载: 839次

1 引言

传统的飞机检测[1-4]旨在准确全面地检测飞机目标,但检测过程中会产生很多冗余的信息。对于无人机侦察,其检测飞机目标主要是为了获取和分析情报,而很多检测到的飞机目标是仅供展览或作为地标的飞机模型,并不具有实际情报价值,因此全面检测会浪费计算资源且耗时过长。构建一种合理的检测系统,有助于提升工作效率,是人工智能的核心要求之一。相比于传统的特征检测方法[5]和新型的机器学习算法[6-7],对飞机目标的检测是一个综合的认知过程,蕴含逻辑分析和推理。为了保证有效飞机目标检测的准确性,检测系统需要剔除飞机模型信息。

2 构建认知模型

认知模型[8]是人类认知真实世界过程的一种计算机模型。建立认知模型的技术常称为认知建模,目的是为了探索和研究人的思维机制,特别是人的信息处理机制,可为人工智能系统的设计提供一种新的体系结构和技术方法[9]。

2.1 对有效飞机的认知

检测有效飞机目标需经过以下流程:1)发现机场;2)找到跑道、停机坪、飞机掩体等典型地物;3)在附近相邻位置搜索飞机目标。这个认知模型是通过对人的观察习惯和思维过程进行分析研究总结出来的。在大幅遥感影像中,受限于人的视觉范围和分辨率,只有大型地物目标能被发现。飞机目标的**和民用价值都只有在机场范围内才能体现,因此应首先进行机场目标确定。机场是功能性的建筑集群,特点较明显突出:1)以机场跑道为核心的呈网络状的道路是机场的主要架构,道路材质多为混凝土,在可见光图像中其灰度和形状特征明显;2)宽阔的集体停机坪和成簇状聚集的个体停机坪、飞机掩体通过拖机道与跑道相连;3)机库、飞机修理厂在停机坪一侧或通过道路与跑道相连。在人的逻辑思维中,机场和飞机是存在包含关系的,从目标属性来看,它们属于不同级别的目标:机场属于大目标,飞机属于小目标。将飞机目标的位置与机场结构相联系,形成位置关系,如:飞机停放在集体或个体停机坪上、飞机掩体中、飞机维修厂附近或在跑道、拖机道上滑行,这进一步缩小了飞机目标检测的地域范围。根据先验知识,机场上具有辨识性的显著子目标是机场道路,在灰度和形状上都具有区别于其他地物的特点,与飞机相关的子目标都是通过拖机道或滑行道与跑道相连,这些道路像机场的骨骼一样连接各主要功能区。基于这一认知,根据飞机特征知识检测飞机目标,完成整体的检测过程。

2.2 基于认知模型的深度学习检测系统构建

深度学习[10-12]是人工神经网络发展的衍生物,其基于生物大脑结构和功能的模拟,是一种信息处理系统。深度学习的网络权重训练过程模拟了神经元提取目标特征的过程,利用卷积参数来刻画目标的特征,形成视觉知识[13]。

按照深度学习网络的训练过程进行机场目标检测的训练,从大范围遥感影像中提取出机场目标,再在机场目标的范围内进行飞机目标检测训练。飞机目标的检测分为完整飞机目标的直接检测和有遮挡飞机目标的检测。根据不同采集样本,可以通过单次多选框检测算法(SSD)网络[14]直接进行检测训练,利用深度学习全卷积网络[15]分割机场,提取道路和停机坪位置,排除机场内的飞机模型。

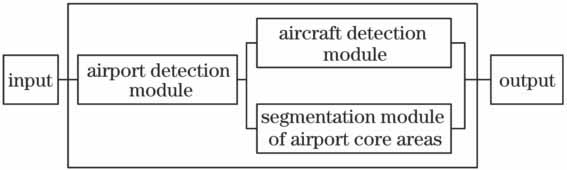

根据人的认知模型,构建基于深度学习的检测系统模型,该模型包括机场检测模块、飞机检测模块和机场核心位置分割模块,可分为机场外和机场内飞机模型。

机场作为有效飞机目标的主要承载体,是检测有效飞机目标的基础。机场检测模块在大范围遥感影像中提取机场区域,排除机场外的飞机模型。模块的输入数据为多分辨率大尺寸遥感影像。

飞机检测模块是检测系统的核心模块。飞机目标的检测效率和准确率直接影响整个系统的工作效率。飞机目标检测采用基于深度学习的目标检测算法,该算法不仅考虑了目标的全局特征,还考虑了部分遮挡的飞机目标与相关遮挡物间的位置关系。该模块的输入数据为机场检测结果图中包含机场区域的局部遥感影像。

机场核心位置分割模块可筛选去除机场范围内的模型飞机,根据模型中的认知关系,对机场的主要道路特征进行提取。该模块的构建依据为有效飞机目标在机场中所处的位置都与以跑道为核心的机场道路体系相关联,因此,通过该模块排除机场内的飞机模型,能进一步准确检测有效飞机。以全卷积的深度学习分割网络作为主体,结合实际需求改进算法并将其作为模块工具。该模块的输入数据为机场检测结果图中包含机场区域的局部遥感影像。系统工作流程框图如

3 模块功能算法的设计与实现

3.1 机场与飞机检测模块算法

检测模块的主要算法是基于深度学习目标的检测算法。SSD网络是基于深度学习目标检测的最佳算法之一,检测速度快且检测准确率高。

SSD网络基于16层视觉几何组网络(VGGNet)[13]改进的全卷积网络,是基于回归思想的检测网络,其结构图如

3.2 机场核心位置的分割模块算法

分割模块的基础算法是一种基于全卷积网络的图像分割算法[15],其根据图像的多特征,可自主学习进行图像分割,在监督学习过程中通过反馈不断提升对复杂图像的分割效果。该算法在卷积神经网络VGGNet上进行了改进,用网络用卷积层代替全连接层,整个网络为全连接网络;另外,通过反卷积的方式保证处理的图像与原始图像大小一致,并利用多尺度融合增加分割细节的信息。

移除全连接层的方法包括:1)对于从卷积层到全连接层的连接方式,用与特征图大小一致的卷积核对一整张特征图进行卷积操作;2)对于全连接层之间的连接方式,将图像看作1 pixel×1 pixel大小的卷积核进行卷积运算。经过改变网络结构,全卷积网络可以适应任意大小的图像输入。

为了滤除机场内的飞机模型,保留有效飞机目标,对归一化的机场分割图与飞机检测结果图进行卷积,完成筛选操作;得到的图像与检测图像叠加求平均,最终得到筛选后的飞机目标检测图,即最终检测结果。检测网络的输出包括目标位置和类别信息,归一化处理后的分割图相当于含有位置信息的筛选条件,只有满足飞机、机场跑道及停机坪的位置关系的检测结果才是有效的飞机目标。通过图像与[0 1]二维矩阵的卷积,仅保留检测到有效目标的区域。对原始图像矩阵、检测结果图像矩阵和分割结果图像矩阵进行矩阵运算,生成最终检测结果。设原始图像为

式中conv代表卷积操作。

基于各模块的算法原理,明确了各部分的功能,其中输入与输出数据、完整检测过程及各步骤结果如

4 系统仿真

系统仿真过程包括各个模块的功能实现以及最终系统的有效性检验。模块功能仿真过程分为基于卷积神经网络的检测、分割算法的网络训练以及结合传统图像处理算法的筛选。深度学习算法仿真过程主要包括样本采集、网络训练和结果分析三个步骤。

4.1 深度学习算法仿真

样本采集是深度学习算法训练的第一步,样本的全面性与标准性直接影响网络性能。目标检测网络的样本主要分为机场目标和飞机目标样本,均由专业判读人员进行判读筛选得到。

遥感影像来自谷歌地球的影像数据集,图像分辨率范围为0.8~6 m,尺寸约为8000 pixel×8000 pixel,图像包含机场、城市建筑物、道路、河流等多样地物。经专业判读人员判断确定机场目标区域。检测图像的格式参照公开目标检测数据集VOC2007的标准格式,要求像素宽高比在0.7~4之间。网络性能对图像大小没有明显约束作用,图像大小仅受硬件计算能力的约束。

制作机场目标样本需要利用遥感影像中机场目标的明显特征,同时综合考虑位置及周围地物。机场多处于城市的边缘区域,远离建筑物,虽然其跑道的特征明显,但在荒漠等地形中的特征不明显,且与高速公路存在很大的相似相性,因此需要结合机场组成综合鉴别,如集体停机坪等。遥感图像中停机坪通过滑行道与跑道相连,是平坦广阔的区域,经多条拖机道与机库掩体等相连,与跑道距离不确定。机场检测网络训练的样本数为464。

飞机样本的采集包括两个方面。一方面是完整飞机目标的采集,包括运输机、直升机、预警机、战斗机等不同机型。

另一方面是针对有遮挡的不完整飞机目标的采集,需要采集目标局部和遮挡物的综合样本图像,主要利用飞机与机库、掩体等的位置关系来进行检测。不完整飞机目标的样本数目为237,部分样本示意图如

分割网络的训练样本主要来自多环境背景、多材质、多时间段的机场遥感图像。现有的公开图像分割数据集主要为日常生活图像,没有针对遥感影像机场目标分割的通用样本。同时,飞机与其他机场目标的位置关系复杂,因此需要在甄别机场目标伪装的前提下,保证机场核心位置的精准分割,全面覆盖飞机目标的位置。例如,与停

机坪相邻的修理厂、机库和拖机道末端的掩体均应包括在机场核心设施的范围内,因此对样本采集制作提出了很高的要求。分割网络要求输入图像的宽高比在0.75~1.4之间,图像尺寸不超过硬件计算能力,训练样本的总数为278。分割样本包括人工分割的图像和对分割样本的说明文本文件。

在分割区域确定后,需要进行类别设置和颜色设定,这两个过程通过MATLAB程序实现。根据研究需要,对机场核心位置的分割主要是二类分割,机场核心位置的类别为core(255,255,255),背景类别为background(0,0,0)。使用Python语言的skimage库进行颜色填充,经过颜色设置生成真实的分割图,结果如

图 10. 人工分割图(a)与原始图像(b)的对比

Fig. 10. Contrast between (a) artificial segmentation image and (b) original image

人工标记虽然耗费时间和人力,但是准确性高,对网络训练反馈具有重要意义。

在训练样本的同时需要采集一部分测试图像样本,用于测试检测、分割网络的性能。测试样本分为机场检测的测试样本和飞机检测的测试样本,测试样本数均为100。分割网络的测试样本数为200,包括200张测试图像本身和利用Labelme软件生成的200张分割图。

4.2 网络训练

实验环境为64位Ubuntu系统。实验平台为caffe平台[16],主要对检测网络和分割网络进行训练。SSD检测网络用于检测机场目标和飞机目标,分割网络用于分割机场道路和停机坪。

除了监督训练需要人工采集处理的样本外,其他SSD目标检测网络的训练都是利用caffe封装好的模块通过端到端完成的。大致流程可以总结为以下三个步骤:1)在原始图像数据源的遥感影像中,提取机场、飞机的分类样本,对SSD检测网络的基础网络VGGNet进行目标分类的训练,确定网络卷积层的权重参数;2)将训练得到的分类网络的caffe模型作为预训练模型,训练整个检测网络;3)存储训练日志文件,实际测试SSD网络的检测性能。

实际训练中可以通过改变迭代次数、批处理训练图像的数量来加速网络训练,并通过调整学习率使网络快速收敛于局部最优,节约训练时间。

网络训练对遥感图像进行机场道路、停机坪和机场其他设施与环境背景的二分割,将网络结构的输出类别参数设置为2。全卷积分割网络的基础网络为VGGNet,为了提升分割的准确性,以用于机场分类的VGGNet网络作为基础网络。

因为分类、检测、分割的样本采集制作难度高,样本数目严重不足。深度学习的网络结构具有比传统模型更强的表达能力,因此在训练样本少的情况下容易出现过拟合。为了解决过拟合的问题,一方面采用在ImageNet大型数据集上得到的充分训练的VGGNet网络进行微调网络权重的训练;另一方面进行随机变换的数据提升,增大样本数量;同时,在网络结构中加入L1和L2正则化以及dropout选择层,有效提升模型的泛化能力。

检测和分割的网络性能需要通过评价参数进行分析评估。检测性能通过识别精度、识别效率和定位准确性衡量。识别精度由平均正确率(

式中

精确率

式中

无论是基于区域提取的方法还是边框回归过程,都需要将候选目标框与真实目标框进行比较,从而计算损失,找到最优值。集合交叉值(

根据

式中

检测速度与精度同等重要,以检测一张图像所用的时间作为衡量标准。

通过

式中

4.3 实验结果分析

根据分类网络训练的日志文件,绘制训练样本准确率和损失参数的变化情况,如

在训练得到的VGGNet的基础上,进行机场和飞机的检测训练。通过训练得到SSD检测网络,利用不同于训练图像数据的测试图像进行网络检测性能的测试。按照评价标准,统一评价机场与飞机目标的检测性能,结果见

表 1. 检测结果

Table 1. Detection results

|

机场的范围大且组成复杂,故检测时间较长。同时,在样本数量有限的情况下,检测定位的准确性较低,但在遥感影像中机场目标能被准确地检测到,可突出核心组成的位置,满足后续实验的需要。

图 12. VGGNet分类训练过程中(a)训练准确率和(b)损失随迭代次数的变化

Fig. 12. (a) Training accuracy and (b) loss parameter versus iteration number in classification training process on VGGNet

无遮挡飞机目标检测的准确率高且速度快[19],相比于部分遮挡的飞机目标的检测具有更好的应用价

值;且二者均为小目标,故检测耗时少,这也是深度学习算法检测的优势[20-21]。在对遮挡飞机目标的检测中,由于存在多样的遮挡情况,样本训练并没有获取完整的知识,在复杂的遮挡情况下存在漏检问题,而且定位的准确性较低。随着遮挡程度的增大,检测的准确性与定位的准确性均明显下降。检测网络的输出结果如

分割网络的训练是端到端的训练方式,训练得到的分割网络是系统功能实现的重要基础。在测试样本上测试时,机场核心区域分割结果的平均

对200张分割网络的测试图像进行筛选功能的统计分析,分析结果如

通过深度学习的网络训练并结合图像运算,完成了各模块的仿真实验,验证了模块算法原理的有效性,实现了各模块的功能,为系统设计奠定了坚实基础。为了验证基于认知模型系统的有效性,将其与基于深度学习的飞机检测算法和传统基于形变部件模型(DPM)的检测算法[22-23]进行对比,对比结果见

表 2. 不同检测算法检测性能对比

Table 2. Performance contrast among different detection algorithms

|

由

5 结论

针对传统飞机目标的检测算法和现有机器学习的检测算法中存在的问题,提出了一种有效飞机检测的概念,并针对传统检测方法存在的检测冗余及有遮挡目标检测率低下的问题进行了研究,设计了基于认知模型的一种检测系统并进行了仿真,构建了一种有效飞机目标检测的认知模型。根据认知模型,使用基于深度学习的全卷积检测和分割网络,设计了遥感影像中飞机目标的检测系统和各模块的功能并进行了实验。从检测结果可知,该系统可以准确检测出飞机整体目标,检测效率高,并且对有遮挡飞机目标的检测率也很高,具有实际应用价值。该系统为开展更多目标的智能检测提供了一种全新的思路和方法。

[1] 徐大琦, 倪国强, 许廷发. 中高分辨力遥感图像中飞机目标自动识别算法研究[J]. 光学技术, 2006, 32(6): 855-862.

徐大琦, 倪国强, 许廷发. 中高分辨力遥感图像中飞机目标自动识别算法研究[J]. 光学技术, 2006, 32(6): 855-862.

徐大琦, 倪国强, 许廷发. 中高分辨力遥感图像中飞机目标自动识别算法研究[J]. 光学技术, 2006, 32(6): 855-862.

[2] 岳伍军. 基于光学遥感图像的飞机目标检测算法研究[D]. 成都: 西南交通大学, 2014.

岳伍军. 基于光学遥感图像的飞机目标检测算法研究[D]. 成都: 西南交通大学, 2014.

岳伍军. 基于光学遥感图像的飞机目标检测算法研究[D]. 成都: 西南交通大学, 2014.

Yue WJ. Research of aircraft target detection algorithm based on optical remote sensing image[D]. Chengdu: Southwest Jiaotong University, 2014.

Yue WJ. Research of aircraft target detection algorithm based on optical remote sensing image[D]. Chengdu: Southwest Jiaotong University, 2014.

Yue WJ. Research of aircraft target detection algorithm based on optical remote sensing image[D]. Chengdu: Southwest Jiaotong University, 2014.

[3] 韩现伟. 大幅面可见光遥感图像典型目标识别关键技术研究[D]. 哈尔滨: 哈尔滨工业大学, 2013.

韩现伟. 大幅面可见光遥感图像典型目标识别关键技术研究[D]. 哈尔滨: 哈尔滨工业大学, 2013.

韩现伟. 大幅面可见光遥感图像典型目标识别关键技术研究[D]. 哈尔滨: 哈尔滨工业大学, 2013.

Han XW. The research on key technologies of large range visible light remote sensing image typical object recognition[D]. Harbin: Harbin Institute of Technology, 2013.

Han XW. The research on key technologies of large range visible light remote sensing image typical object recognition[D]. Harbin: Harbin Institute of Technology, 2013.

Han XW. The research on key technologies of large range visible light remote sensing image typical object recognition[D]. Harbin: Harbin Institute of Technology, 2013.

[4] 姬晓飞, 秦宁丽. 基于光学遥感图像的目标检测与分类识别方法[J]. 沈阳航空航天大学学报, 2015, 32(1): 23-31.

姬晓飞, 秦宁丽. 基于光学遥感图像的目标检测与分类识别方法[J]. 沈阳航空航天大学学报, 2015, 32(1): 23-31.

姬晓飞, 秦宁丽. 基于光学遥感图像的目标检测与分类识别方法[J]. 沈阳航空航天大学学报, 2015, 32(1): 23-31.

Ji X F, Qin N L. Target detection and classification method based on optical remote sensing image[J]. Journal of Shenyang Institute of Aeronautical Engineering, 2015, 32(1): 23-31.

[5] 刘扬, 付征叶, 郑逢斌. 高分辨率遥感影像目标分类与识别研究进展[J]. 地球信息科学学报, 2015, 17(9): 1080-1091.

刘扬, 付征叶, 郑逢斌. 高分辨率遥感影像目标分类与识别研究进展[J]. 地球信息科学学报, 2015, 17(9): 1080-1091.

刘扬, 付征叶, 郑逢斌. 高分辨率遥感影像目标分类与识别研究进展[J]. 地球信息科学学报, 2015, 17(9): 1080-1091.

Liu Y, Fu Z Y, Zheng F B. Research progress of target classification and recognition in high resolution remote sensing images[J]. Journal of Earth Information Science, 2015, 17(9): 1080-1091.

[6] 张义德, 胡长雨, 胡春育. 基于卷积神经网络的遥感图像飞机检测[J]. 光电子技术, 2017( 1): 66- 71.

张义德, 胡长雨, 胡春育. 基于卷积神经网络的遥感图像飞机检测[J]. 光电子技术, 2017( 1): 66- 71.

张义德, 胡长雨, 胡春育. 基于卷积神经网络的遥感图像飞机检测[J]. 光电子技术, 2017( 1): 66- 71.

Zhang YD, Hu CY, Hu CY. Aircraft detection of remote sensing images based on convolutional neural network[J]. Optoelectronic Technology, 2017( 1): 66- 71.

Zhang YD, Hu CY, Hu CY. Aircraft detection of remote sensing images based on convolutional neural network[J]. Optoelectronic Technology, 2017( 1): 66- 71.

Zhang YD, Hu CY, Hu CY. Aircraft detection of remote sensing images based on convolutional neural network[J]. Optoelectronic Technology, 2017( 1): 66- 71.

[7] 惠国保. 基于深层神经网络的军事目标图像分类技术[J]. 现代导航, 2016( 6): 430- 436.

惠国保. 基于深层神经网络的军事目标图像分类技术[J]. 现代导航, 2016( 6): 430- 436.

惠国保. 基于深层神经网络的军事目标图像分类技术[J]. 现代导航, 2016( 6): 430- 436.

Hui GB. Military target image classification technique based on deep layer neural network[J]. Modern Navigation, 2016( 6): 430- 436.

Hui GB. Military target image classification technique based on deep layer neural network[J]. Modern Navigation, 2016( 6): 430- 436.

Hui GB. Military target image classification technique based on deep layer neural network[J]. Modern Navigation, 2016( 6): 430- 436.

[8] 龚怡宏. 人工智能是否终将超越人类智能——基于机器学习与人脑认知基本原理的探讨[J]. 人民论坛·学术前沿, 2016( 7): 12- 21.

龚怡宏. 人工智能是否终将超越人类智能——基于机器学习与人脑认知基本原理的探讨[J]. 人民论坛·学术前沿, 2016( 7): 12- 21.

龚怡宏. 人工智能是否终将超越人类智能——基于机器学习与人脑认知基本原理的探讨[J]. 人民论坛·学术前沿, 2016( 7): 12- 21.

Gong YH. Whether artificial intelligence will eventually surpass human intelligence——based on the basic principles of machine learning and human brain cognition[J]. People's Forum: Academic Front, 2016( 7): 12- 21.

Gong YH. Whether artificial intelligence will eventually surpass human intelligence——based on the basic principles of machine learning and human brain cognition[J]. People's Forum: Academic Front, 2016( 7): 12- 21.

Gong YH. Whether artificial intelligence will eventually surpass human intelligence——based on the basic principles of machine learning and human brain cognition[J]. People's Forum: Academic Front, 2016( 7): 12- 21.

[9] 乔石. 基于人脑学习与记忆的多源信息融合算法研究[D]. 天津: 河北工业大学, 2015.

乔石. 基于人脑学习与记忆的多源信息融合算法研究[D]. 天津: 河北工业大学, 2015.

乔石. 基于人脑学习与记忆的多源信息融合算法研究[D]. 天津: 河北工业大学, 2015.

QiaoS. The research on multi-source information fusion algorithm based on human brain learning and memory[D]. Tianjin: Hebei University of Technology, 2015.

QiaoS. The research on multi-source information fusion algorithm based on human brain learning and memory[D]. Tianjin: Hebei University of Technology, 2015.

QiaoS. The research on multi-source information fusion algorithm based on human brain learning and memory[D]. Tianjin: Hebei University of Technology, 2015.

[10] 高常鑫, 桑农. 基于深度学习的高分辨率遥感影像目标检测[J]. 测绘通报, 2014( S1): 108- 111.

高常鑫, 桑农. 基于深度学习的高分辨率遥感影像目标检测[J]. 测绘通报, 2014( S1): 108- 111.

高常鑫, 桑农. 基于深度学习的高分辨率遥感影像目标检测[J]. 测绘通报, 2014( S1): 108- 111.

Gao CX, SangN. High resolution remote sensing image target detection based on deep learning[J]. Survey and Mapping:2014( S1): 108- 111.

Gao CX, SangN. High resolution remote sensing image target detection based on deep learning[J]. Survey and Mapping:2014( S1): 108- 111.

Gao CX, SangN. High resolution remote sensing image target detection based on deep learning[J]. Survey and Mapping:2014( S1): 108- 111.

[11] LuoP, TianY, WangX, et al. Switchable deep network for pedestrian detection[C]. Computer Vision & Pattern Recognition, 2014.

LuoP, TianY, WangX, et al. Switchable deep network for pedestrian detection[C]. Computer Vision & Pattern Recognition, 2014.

LuoP, TianY, WangX, et al. Switchable deep network for pedestrian detection[C]. Computer Vision & Pattern Recognition, 2014.

[12] LiH, ZhaoR, Wang X. Highly efficient forward and backward propagation of convolutional neural networks for pixelwise classification[EB/OL]. ( 2014-12-16)[2017-01-15]. https:∥arxiv.org/abs/1412. 4526.

LiH, ZhaoR, Wang X. Highly efficient forward and backward propagation of convolutional neural networks for pixelwise classification[EB/OL]. ( 2014-12-16)[2017-01-15]. https:∥arxiv.org/abs/1412. 4526.

LiH, ZhaoR, Wang X. Highly efficient forward and backward propagation of convolutional neural networks for pixelwise classification[EB/OL]. ( 2014-12-16)[2017-01-15]. https:∥arxiv.org/abs/1412. 4526.

[13] SimonyanK, Zisserman A. Very deep convolutional networks for large-scale image recognition[EB/OL]. ( 2015-04-10)[2017-01-15]. https:∥arxiv.org/abs/1409.1556v6.

SimonyanK, Zisserman A. Very deep convolutional networks for large-scale image recognition[EB/OL]. ( 2015-04-10)[2017-01-15]. https:∥arxiv.org/abs/1409.1556v6.

SimonyanK, Zisserman A. Very deep convolutional networks for large-scale image recognition[EB/OL]. ( 2015-04-10)[2017-01-15]. https:∥arxiv.org/abs/1409.1556v6.

[14] LiuW, AnguelovD, ErhanD, et al. SSD: single shot multibox detector[C]. European Conference on Computer Vision, 2016: 21- 37.

LiuW, AnguelovD, ErhanD, et al. SSD: single shot multibox detector[C]. European Conference on Computer Vision, 2016: 21- 37.

LiuW, AnguelovD, ErhanD, et al. SSD: single shot multibox detector[C]. European Conference on Computer Vision, 2016: 21- 37.

[15] Shelhamer E, Long J, Darrell T. Fully convolutional networks for semantic segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2014, 39(4): 640-651.

Shelhamer E, Long J, Darrell T. Fully convolutional networks for semantic segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2014, 39(4): 640-651.

Shelhamer E, Long J, Darrell T. Fully convolutional networks for semantic segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2014, 39(4): 640-651.

[16] Chen LC, PapandreouG, KokkinosI, et al. Semantic image segmentation with deep convolutional nets, atrousconvolution, fully connected CRFs[J]. IEEE Transactions on Pattern Analysis and MachineIntelligence, 2014, PP( 99): 1.

Chen LC, PapandreouG, KokkinosI, et al. Semantic image segmentation with deep convolutional nets, atrousconvolution, fully connected CRFs[J]. IEEE Transactions on Pattern Analysis and MachineIntelligence, 2014, PP( 99): 1.

Chen LC, PapandreouG, KokkinosI, et al. Semantic image segmentation with deep convolutional nets, atrousconvolution, fully connected CRFs[J]. IEEE Transactions on Pattern Analysis and MachineIntelligence, 2014, PP( 99): 1.

[18] RedmonJ, DivvalaS, GirshickR, et al. You only look once: unified, real-time object detection[C]. 2016 IEEE Conference on Computer Vision and Pattern Recognition, 2016.

RedmonJ, DivvalaS, GirshickR, et al. You only look once: unified, real-time object detection[C]. 2016 IEEE Conference on Computer Vision and Pattern Recognition, 2016.

RedmonJ, DivvalaS, GirshickR, et al. You only look once: unified, real-time object detection[C]. 2016 IEEE Conference on Computer Vision and Pattern Recognition, 2016.

[19] 袁渊. 面向安防监控视频树叶遮挡检测研究[D]. 武汉: 武汉科技大学, 2015.

袁渊. 面向安防监控视频树叶遮挡检测研究[D]. 武汉: 武汉科技大学, 2015.

袁渊. 面向安防监控视频树叶遮挡检测研究[D]. 武汉: 武汉科技大学, 2015.

YuanY. The research for security monitoring video leaves shade detection[D]. Wuhan: Wuhan University of Science and Technology, 2015.

YuanY. The research for security monitoring video leaves shade detection[D]. Wuhan: Wuhan University of Science and Technology, 2015.

YuanY. The research for security monitoring video leaves shade detection[D]. Wuhan: Wuhan University of Science and Technology, 2015.

[21] LiH, ZhaoR, Wang X. Highly efficient forward and backward propagation of convolutional neural networks for pixelwise classification[EB/OL]. ( 2014-12-16)[2017-01-15]. https:∥arxiv.org/abs/1412. 4526.

LiH, ZhaoR, Wang X. Highly efficient forward and backward propagation of convolutional neural networks for pixelwise classification[EB/OL]. ( 2014-12-16)[2017-01-15]. https:∥arxiv.org/abs/1412. 4526.

LiH, ZhaoR, Wang X. Highly efficient forward and backward propagation of convolutional neural networks for pixelwise classification[EB/OL]. ( 2014-12-16)[2017-01-15]. https:∥arxiv.org/abs/1412. 4526.

[22] 刘大伟, 韩玲, 韩晓勇. 基于深度学习的高分辨率遥感影像分类研究[J]. 光学学报, 2016, 36(4): 0428001.

刘大伟, 韩玲, 韩晓勇. 基于深度学习的高分辨率遥感影像分类研究[J]. 光学学报, 2016, 36(4): 0428001.

刘大伟, 韩玲, 韩晓勇. 基于深度学习的高分辨率遥感影像分类研究[J]. 光学学报, 2016, 36(4): 0428001.

[23] 韦皓瀚, 曹国, 金挺, 等. 改进星型级联可形变部件模型的行人检测[J]. 中国图象图形学报, 2017, 22(2): 170-178.

韦皓瀚, 曹国, 金挺, 等. 改进星型级联可形变部件模型的行人检测[J]. 中国图象图形学报, 2017, 22(2): 170-178.

韦皓瀚, 曹国, 金挺, 等. 改进星型级联可形变部件模型的行人检测[J]. 中国图象图形学报, 2017, 22(2): 170-178.

Wei H H, Cao G, Jin T, et al. Pedestrian detection based on improved star cascaded deformable component model[J]. Journal of Image and Graphics, 2017, 22(2): 170-178.

Article Outline

侯宇青阳, 全吉成, 魏湧明. 基于认知模型的遥感图像有效飞机检测系统[J]. 光学学报, 2018, 38(1): 0111005. Yuqingyang Hou, Jicheng Quan, Yongming Wei. Valid Aircraft Detection System for Remote Sensing Images Based on Cognitive Models[J]. Acta Optica Sinica, 2018, 38(1): 0111005.