基于多层深度卷积特征的抗遮挡实时跟踪算法  下载: 1184次

下载: 1184次

1 引言

视觉目标跟踪是一个综合视觉特征提取、视觉信息分析、目标运动信息检测和识别等的交叉课题,是机器视觉领域一个重要的研究方向。随着目标跟踪理论研究的深入和计算机软硬件的发展,目标跟踪算法在商业和**领域中的应用日益广泛。然而在实际应用中,设计一个可以处理好各种复杂多变场景的稳健算法依然具有很大的挑战。

近年来,源自信号处理理论的相关滤波视觉跟踪算法以优异的跟踪速度成为研究的热点方向。Bolme 等[1] 将相关理论引入目标跟踪领域,设计了一个最小输出平方误差和(MOSSE)滤波器,在跟踪过程中通过提取图像灰度特征寻找目标最大响应值,实现了速度的飞跃。Henriques 等[2]提出的核循环结构算法(CSK)将训练阶段的密集采样问题转化为特征矩阵的循环移位运算。Danelljan 等[3]提出的颜色特征算法(CN)通过提取灰度特征与降维的颜色特征提升跟踪效果。 Henriques等[4] 提出的核相关滤波算法(KCF)在CSK基础上,通过方向梯度直方图特征(HOG)将适用范围从灰度图扩大到多通道有色图,其跟踪速度达到172 frame/s。Danelljan等[5] 针对KCF中利用循环矩阵求解损失函数时出现的边界效应问题,提出空间正则化算法(SRDCF),通过在损失函数中引入惩罚项,抑制离中心较远的特征对跟踪算法的影响,进一步提高了跟踪精度。此外,国内一些研究人员在相关滤波框架上对多尺度适应问题进行了探索[6-9]。

随着深度学习方法在图像分类、目标检测等领域取得突破性进展,基于深度学习的跟踪算法也引起了广泛关注。Wang等[10] 提出的深度学习算法(DLT),在大规模数据集上通过栈式降噪自编码器进行离线预训练得到通用物体表征能力,引用粒子滤波框架,对输入跟踪数据集的第1帧带标注的样本进行在线微调。Wang等[11]又在DLT基础上改进,提出了结构化输出深度学习算法(SO-DLT),跟踪时利用当前目标的有限样本信息对预训练卷积网络模型进行微调。Ma 等[12-13] 将预训练深度网络中不同卷积层提取的特征与相关滤波的框架结合,提出分层卷积特征算法(HCFT),经过优化更新得到稳健的分层卷积特征算法(HCFTstar)。Wang 等[14] 提出全卷积网络算法(FCNT),设计出特征筛选网络和互补的预测网络,提升了跟踪精度。Nam 等[15] 使用大规模具有标注框的视频序列训练卷积网络得到通用的目标表观模型,提出多域网络(MDNet)结构,包括共享层及多分支的全连接层,解决了跟踪训练数据不足的问题。Bertinetto等[16] 引入基于对比性损失函数的孪生(Siamese)体系结构,训练一个完全端到端的跟踪模型,同时输入示例样本和候选样本,通过离线训练模型评估二者的相似程度,决策层选择适合的匹配算法计算相似度,匹配程度最高的候选样本作为目标当前最优区域。作者又在此基础上改进,得到了端到端相关滤波算法(CFNet)[17]。Tao等[18]提出了一个基于Siamese的实例搜索算法(SINT),通过学习匹配函数,对第1帧的初始块与当前帧候选样本进行相似度计算,返回最相似的候选样本作为目标当前状态,不再进行遮挡检测,无需更新模型,取得不错的跟踪效果。

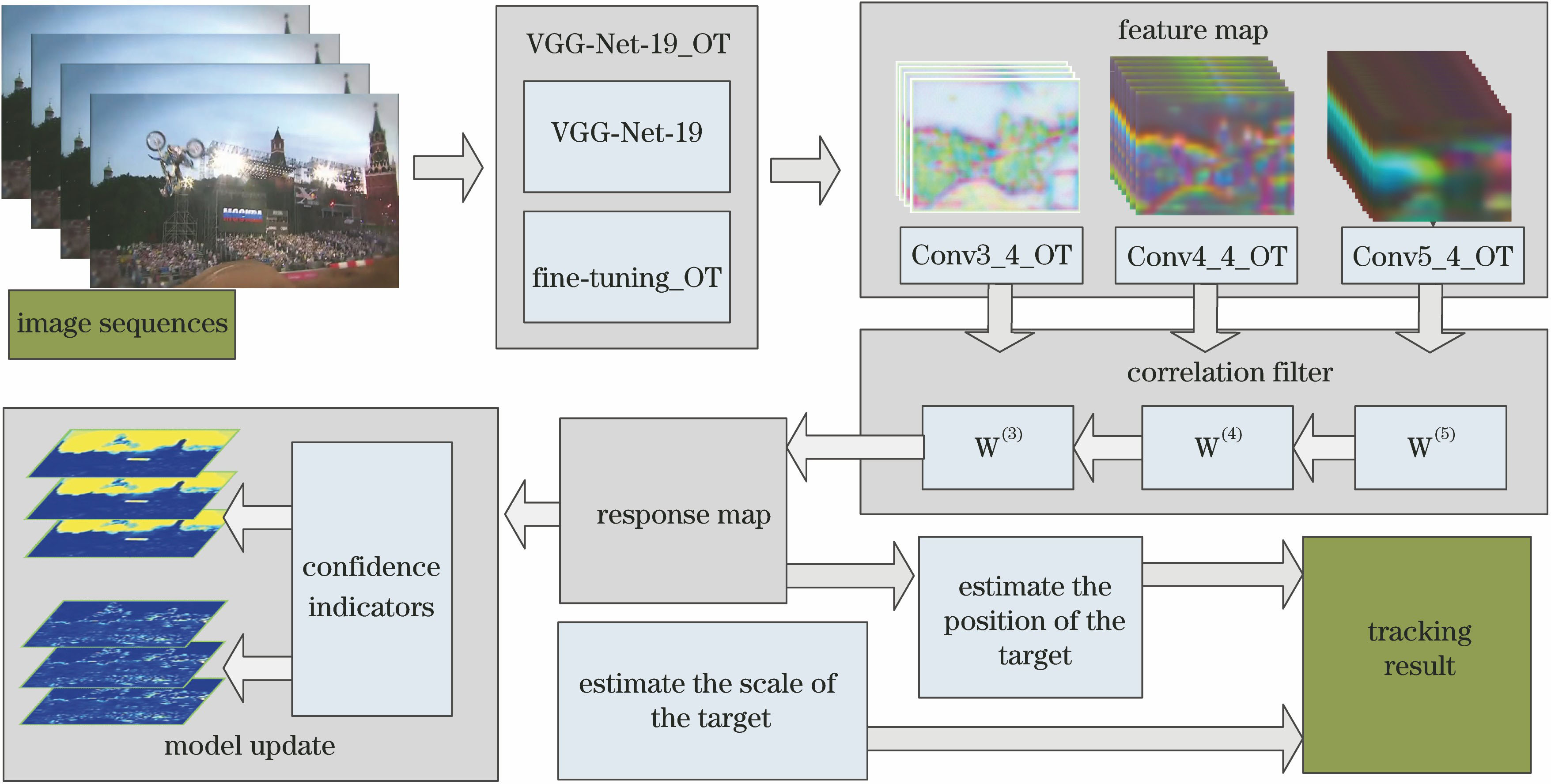

综上,基于相关滤波框架的跟踪算法速度较快,但由于使用HOG、CN等单一特征,对遮挡问题没有做特别处理,对背景有强边缘、目标形变的场景表现不稳健。另外,基于卷积神经网络的跟踪算法精度较高,但难以预先获得大量样本进行训练,而且由于网络结构庞大而复杂,计算量大,直接影响跟踪算法的实时性。因此针对复杂场景下的快速稳健跟踪问题,本文提出一种利用深度卷积模型提取特征的抗遮挡实时目标跟踪算法。一方面,在针对目标任务改进的深度卷积模型上提取多层卷积特征,另一方面基于相关滤波框架,通过位置相关滤波器和尺度相关滤波器确定当前目标位置和目标尺度。同时,通过置信度指标判断目标当前遮挡状态,选择适宜的模型更新策略。本文算法在复杂环境下不但能够取得良好的跟踪精度,而且能够达到较快的跟踪速度,同时解决了跟踪过程中目标遮挡等问题。

2 算法概述

算法的整体框图如

3 基于多层深度卷积特征的目标跟踪算法

3.1 深度卷积特征

目标的特征表达是影响跟踪性能的重要因素,适用于目标跟踪任务的特征表达需要具备较高的区分性,能够对背景和非目标物体保持较好的判别性,还需要具备较强的泛化能力,能够适应各种遮挡、外观变化等不确定因素。同时,为达到跟踪的实时要求,特征表达的参数计算量需要尽可能地少。传统的目标特征提取如HOG 特征、CN特征等浅层特征,带有一定的先验知识,特征提取速度快,对于某些特定场景具有很好的表达能力和区分性,但在快速运动、遮挡、光照变化等复杂环境情况下稳健性较差。随着深度学习方法特别是卷积神经网络(CNNs)[19] 在图像分类领域取得巨大的成功,出现了诸多性能优秀的网络模型,越来越多的研究者开始将其应用到目标跟踪领域。

3.1.1 卷积神经网络VGG-Net

VGG-Net[20]是牛津大学计算机视觉组和DeepMind公司共同研发的深度卷积网络,探索了卷积神经网络的深度与性能之间的关系,通过反复堆叠3×3的小型卷积核和2×2的最大池化层,构筑了16~19层的卷积神经网络,证明小型卷积核可以通过增加网络的深度模仿较大卷积核,实现对图像的局部感知,减少网络训练参数,有效提升模型效果,影响网络最终的性能。卷积模型主要由 5 段卷积、2个全连接特征层和1个全连接分类层组成。卷积核专注于扩大通道数,池化着重于缩小特征图的宽和高,逐渐忽略局部信息。网络结构复杂,参数占用空间与计算量大,以VGG-Net-19[20]为例,各层参数量如

表 1. VGG-Net-19的各层参数

Table 1. Parameters of VGG-Net-19

|

VGG-Net以物体分类作为回归训练标准,在层数递增时,仅对训练图片的判别性特征进行提取,对分类任务无贡献的背景等冗余信息将逐渐消失。目标跟踪与分类的目的不同,需要在跟踪时将目标从背景中区分出来,然而在实际场景中,背景包含同类型物体的可能性也存在。因此,VGG-Net提取的深度特征并不完全适合直接用于目标跟踪任务。

3.1.2 目标跟踪的微调网络模型VGG-Net-19_OT

深度卷积模型的优势来自于对大量标注训练数据的有效学习,而目标跟踪仅仅提供第1帧的边框作为训练数据。为了更好地在深度卷积模型中提取特征应用于目标跟踪任务,需要对VGG-Net的结构进行微调,微调过程的本质是针对特定数据集对卷积核进行微调,每个卷积核对应一个通道,提取一种更契合数据集的判别性特征。具有冗余的卷积层中,各通道的特征提取有很大重叠。减少特征提取能力差的卷积核,保留学习良好的卷积核作为微调初始值,以迭代删减的方式修剪冗余的网络,在保持网络精度前提下,有效减少存储空间、提升网络速度。调整后的网络VGG-Net-19_OT如

3.1.3 网络训练策略

首先对VGG-Net-19 网络模型初始化,保持其结构固定不变。为适应目标在跟踪过程中表观模型的变化,将目标跟踪数据集中的图像筛选部分输入网络中进行训练。

采用SSD[22]的方式设定损失函数

式中,

式中:

第

式中: {

由于深度卷积网络中不同卷积核存在不同的稀疏度,部分卷积核的权重参数过于稀疏,对模型性能提升效果不高。为了更有针对性地提取目标特征,减少卷积核冗余,可以设定稀疏度阈值进行过滤。将小于阈值的卷积核权重设置为0,逐层反复训练、微调,直至无法检测到冗余的卷积核,训练得到收敛的VGG-Net-19_OT网络。在应用场景中有同类背景干扰的情况下,当目标与背景是同一类物体时,调整后的网络训练出的特征也能进行区分,达到很好的跟踪效果。

3.1.4 深度卷积特征提取

预训练的深度卷积网络在不同卷积层提取到不同的特征,充分利用各个层次的特征可以提升目标跟踪的性能。底层特征具有较高的空间分辨率,包含丰富的空间特征和纹理信息,作为类内分类器时,可以剔除表观相似的干扰背景,同时易于捕捉位置的变化,进行精确定位。高层特征包含更多的语义信息,忽略物体的细节差异,难以识别或定位较小目标,作为类间分类器时,进行粗略定位,对于目标发生形变、遮挡等表观变化表现比较稳健[12]。

将视频图像目标候选区域输入改进后的预训练网络VGG-Net-19_OT,并提取出适用于跟踪序列的多层深度卷积特征图,随着层数加深,特征图尺寸逐渐变小,空间分辨率逐步降低。对不同层级的特征图利用双线性插值进行上采样,获得一系列相同尺寸不同层级的深度特征图,进而层次化地构造目标外观模型,设

3.2 相关滤波框架

目标跟踪领域有很多主流的算法,如KCF,都是基于核相关滤波框架。此滤波框架利用目标周围区域的循环矩阵采集正负样本,通过岭回归训练目标分类器,以循环矩阵在傅里叶空间可对角化的性质,将矩阵的运算转化为向量的Hadamard积,降低了运算量,提高了运算速度。本文算法在此相关滤波理论基础上进行构建。

3.2.1 训练阶段

选定跟踪目标,在给定的目标位置提取训练样本,将目标跟踪序列第1帧输入改进后的深度卷积网络模型VGG-Net-19_OT,提取第

式中,

式中,

3.2.2 检测阶段

将待检测样本提取出的第

式中,F-1为傅里叶逆变换。首先计算位置(

再逐层向下搜索位置(

3.2.3 尺度估计

基于相关滤波框架的目标跟踪算法大都局限于对目标位置的预测,并未考虑针对运动目标的尺度变化进行估计。本文算法加入尺度相关滤波器,主要预测流程包括以下几步:首先,位置相关滤波器定位到目标后,在其周围采集不同尺度的图像,构成训练样本;接着,由于深度卷积特征计算量大,为保证算法的高效性,只提取HOG特征;然后,为保留目标的关键信息及平滑图像的边界效应,对提取到的特征进行加窗处理;最后,使用多尺度图像的特征训练核函数最小二乘分类器,得到尺度相关滤波器,寻找最大响应,其对应的尺度就是目标的新尺度。采用可变窗口大小的高斯窗函数代替余弦窗,通过

3.3 模型更新策略

为防止在跟踪过程中,由于目标表观模型的形变或外部条件的干扰,而造成漂移现象,需要对其进行模型更新。令第

式中,学习速率

对于相关滤波类跟踪算法,当目标被遮挡时,如果持续进行模型更新,会产生累积误差,导致模型污染,造成跟踪漂移,当遮挡逐步消除后,则很容易误判目标。因此模型更新策略需要重点解决局部遮挡判断问题。

本文算法采用高置信度的遮挡判断恢复机制,通过最大响应值

3.4 算法总体流程

结合上述对本文算法中关键部分的描述,给出算法的主要步骤,如

4 实验

4.1 实验平台及参数配置

实验平台硬件配置为CPU:Intel(R) Core(TM) i7-6700,3.4 GHz,16 GB内存;GPU:NVIDIA GeForce GTX-1080。软件配置为 MATLAB 2016b 和 C++在 Matconvnet 深度学习库混合编程。算法的正则化参数

4.2 评价标准

为评估算法的性能,在 OTB-2015[23]与UAV123[24] 数据集上进行测试。OTB-2015有100组完全标注的视频,涵盖11个属性。UAV123有123组完全标注的视频,涵盖12个属性。各属性包括视频序列个数分别如

表 2. OTB-2015视频属性

Table 2. Video attributes of OTB-2015

|

表 3. UAV123视频属性

Table 3. Video attributes of UAV123

|

选择一次通过评估(OPE)方法,绘制精确度图(Precision plot)和成功率图(Success plot)。采用4种常见的评估指标[25] :中心位置误差(CLE)、距离精度(DP)、重叠精度(OP)以及平均跟踪帧率(FPS)。

将OTB-2015代码库中自带的ALSA[26] 等算法,以及近几年主流跟踪算法CFNet[17] 、CNN-SVM[27] 、DSST[28] 、HCFT[12] 、HCFTstar[13] 、KCF[4] 、LCTDeep[29] 、SRDCF[5] 等进行定性定量分析。针对OTB-2015数据集,将排名前10的跟踪算法在精确度图和成功率图上显示。针对UAV123数据集,仅选择HCFTstar[13] 、KCF[4] 与本文算法共3种算法在精确度图和成功率图上比较。

4.3 定性分析

基于OTB-2015数据集测试中排名前10的算法的部分跟踪结果如

4.3.1 背景复杂

以“Ironman 1”视频序列为例,如

4.3.2 光照变化

如

4.3.3 尺度变化

在“Doll”中,如

4.3.4 目标旋转

参考

4.3.5 快速运动

4.3.6 目标分辨率低

以视频“Skiing”为例,如

图 4. 10个跟踪算法在不同视频序列上的定性结果显示。(a) Ironman 1; (b) Ironman 2; (c) Doll; (d) MotorRolling; (e) Bolt2; (f) Skiing

Fig. 4. Qualitative results of the 10 tracking algorithms on different video sequences. (a) Ironman 1; (b) Ironman 2; (c) Doll; (d) MotorRolling; (e) Bolt2; (f) Skiing

4.3.7 目标遮挡

选取4组典型的序列“Jogging-1”、“Walking2”、“Coke”和“Soccer”,目标在跟踪过程中受到部分或全部遮挡,如

4.4 定量分析

为进一步全面评估所提算法的性能,对OTB-2015与UAV123的测试视频序列的综合性能进行定量分析。

4.4.1 算法综合性能的定量分析

图 5. 10个跟踪算法在部分遮挡视频序列上的定性结果显示。(a) Jogging-1; (b) Walking2; (c) Coke; (d) Soccer

Fig. 5. Qualitative results of the 10 tracking algorithms on different occluded video sequences. (a) Jogging-1; (b) Walking2; (c) Coke; (d) Soccer

图 6. 基于OTB-2015评估基准OPE的跟踪算法。(a)精度曲线图;(b)成功率曲线图

Fig. 6. Algorithm of OPE on OTB-2015. (a) Precision plot; (b) overlap success plot

4.4.2 基于OTB-2015的不同视频属性的定量分析

面对不同挑战,平均精度和平均成功率结果分别如

图 7. 基于UAV123评估基准OPE的跟踪算法。(a)精度曲线图;(b)成功率曲线图

Fig. 7. Algorithm of OPE on UAV123. (a) Precision plot; (b) overlap success plot

图 8. OTB-2015 11种不同属性视频序列跟踪精度曲线

Fig. 8. Precision plots on 11 different attributes video sequences of OTB-2015

本文算法在 11 种不同属性的跟踪挑战中,跟踪精度始终取得最优或次优的成绩。跟踪成功率在LR、OV属性排名第三,在SV属性处于次优,其余属性均排名第一。由此表明,本文算法可以较好地适应于复杂场景下的目标跟踪任务。

4.4.3 基于UAV123的不同视频属性的定量分析

如

表 4. UAV123 12种不同属性视频序列跟踪精度与跟踪成功率

Table 4. Precision values and success rates on 12 different attributes video sequences of UAV123

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

4.5 算法跟踪速率

跟踪算法对实时性的要求比较高,任何冗余计算都会影响算法的实用性。由于高维卷积特征需要进行复杂的计算,这导致VGG-Net提取目标特征用时较多,本文算法在其模型结构基础上增加目标跟踪分支,优化筛选更适用于目标跟踪任务的卷积核,将小于阈值的卷积核权重设置为0,移除,逐层训练,得到VGG-Net-19_OT深度卷积网络模型,各层有效卷积核的个数约降低为VGG-Net-19的1/9。目标特征提取层参数的减少直接减少了跟踪过程的计算量,提升了跟踪的速度。本文算法在OTB-2015的100组视频的测试中,CPU模式下平均速度为16.3 frame/s,GPU加速条件下,平均跟踪速率为29.6 frame/s,达到实时跟踪要求。

表 5. 跟踪速率

Table 5. Tracking speedsframe /s

|

表 6. 基于深度学习的跟踪算法的平均跟踪速率对比

Table 6. Average tracking speed comparison for the deep learning-based tracking algorithmframe /s

|

综上分析,本文算法在跟踪过程中,遇到背景干扰、光照变化、遮挡、尺度变化、快速运动等变化时,均表现出良好的跟踪性能,且速度优于其他深度学习类算法。

5 结论

本文提出一种结合深度卷积特征和相关滤波框架的抗遮挡实时算法。对卷积网络模型VGG-Net-19结构进行调整,加入针对目标跟踪任务训练的卷积层,优化冗余卷积核,减轻高维卷积特征结构复杂度。通过微调后的深度卷积模型提取目标表观特征,在维持跟踪精度的同时,降低了特征提取的计算量,从而加快了算法运行速度。同时本文算法引入阶段式模型更新恢复机制,解决了相关滤波跟踪误差随时间积累导致模型污染的问题。实验结果表明,与近年来的主流算法相比,本文算法不仅得到较高的跟踪精度,在目标遮挡、外观变化、背景干扰等复杂场景下也有稳健的表现,而且平均跟踪速度可达到29.6 frame/s,满足实际应用的要求。

[1] Bolme DS, Beveridge JR, Draper BA, et al. Visual object tracking using adaptive correlation filters[C]∥2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, June 13-18, 2010, San Francisco, CA, USA. New York: IEEE, 2010: 2544- 2550.

[2] Henriques JF, CaseiroR, MartinsP, et al. Exploiting the circulant structure of tracking-by-detection with kernels[M] ∥Fitzgibbon A, Lazebnik S, Perona P, et al. Lecture notes in computer science. Berlin, Heidelberg: Springer, 2012, 7575: 702- 715.

[3] DanelljanM, Khan FS, FelsbergM, et al. Adaptive color attributes for real-time visual tracking[C]∥2014 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 23-28, 2014, Columbus, OH, USA. New York: IEEE, 2014: 1090- 1097.

[5] DanelljanM, HägerG, Khan FS, et al. Learning spatially regularized correlation filters for visual tracking[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 4310- 4318.

[6] 王鑫, 侯志强, 余旺盛, 等. 基于多层卷积特征融合的目标尺度自适应稳健跟踪[J]. 光学学报, 2017, 37(11): 1115005.

[7] 蔡玉柱, 杨德东, 毛宁, 等. 基于自适应卷积特征的目标跟踪算法[J]. 光学学报, 2017, 37(3): 0315002.

[8] 李聪, 鹿存跃, 赵珣, 等. 特征融合的尺度自适应相关滤波跟踪算法[J]. 光学学报, 2018, 38(5): 0515001.

[9] 王红雨, 汪梁, 尹午荣, 等. 结合目标检测的多尺度相关滤波视觉跟踪算法[J]. 光学学报, 2019, 39(1): 0115004.

[10] Wang NY, Yeung DY. Learning a deep compact image representation for visual tracking[C]∥Proceedings of the 26th International Conference on Neural Information Processing Systems, December 5-10, 2013, Lake Tahoe, Nevada. USA: Curran Associates Inc., 2013, 1: 809- 817.

[11] WangN, LiS, GuptaA, et al. Transferring rich feature hierarchies for robust visual tracking[EB/OL]. ( 2015-04-23)[2019-01-06]. https:∥arxiv.org/abs/1501. 04587.

[12] MaC, Huang JB, Yang XK, et al. Hierarchical convolutional features for visual tracking[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 3074- 3082.

[13] MaC, Huang JB, Yang XK, et al. Robust visual tracking via hierarchical convolutional features[J]. IEEE Transactions on Pattern Analysis and MachineIntelligence ( EarlyAccess), ( 2018-08-13) [2019-01-06]. DOI: 10.1109/TPAMI.2018.2865311.

[14] Wang LJ, Ouyang WL, Wang XG, et al. Visual tracking with fully convolutional networks[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 3119- 3127.

[15] NamH, HanB. Learning multi-domain convolutional neural networks for visual tracking[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 4293- 4302.

[16] BertinettoL, ValmadreJ, Henriques JF, et al. Fully-convolutional Siamese networks for object tracking[M] ∥Hua G, Jégou H. Lecture notes in computer science. Cham: Springer, 2016, 9914: 850- 865.

[17] ValmadreJ, BertinettoL, HenriquesJ, et al. End-to-end representation learning for correlation filter based tracking[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 5000- 5008.

[18] TaoR, GavvesE, Smeulders A W M. Siamese instance search for tracking[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 1420- 1429.

[19] LeCun Y, Bengio Y, Hinton G. Deep learning[J]. Nature, 2015, 521(7553): 436-444.

[20] SimonyanK, Zisserman A. Very deep convolutional networks for large-scale image recognition[EB/OL]. ( 2015-04-10)[2019-01-06]. https:∥arxiv.org/abs/1409. 1556.

[21] DengJ, DongW, SocherR, et al. ImageNet: a large-scale hierarchical image database[C]∥2009 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 20-25, 2009, Miami, FL, USA. New York: IEEE, 2009: 248- 255.

[22] LiuW, AnguelovD, ErhanD, et al. SSD: single shot multibox detector[C]∥Leibe B, Matas J, Sebe N, et al. Lecture notes in computer science. Cham: Springer, 2016, 9905: 21- 37.

[23] Wu Y, Lim J, Yang M H. Object tracking benchmark[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1834-1848.

[24] MuellerM, SmithN, GhanemB. A benchmark and simulator for UAV tracking[M] ∥Leibe B, Matas J, Sebe N, et al. Lecture notes in computer science. Cham: Springer, 2016, 9905: 445- 461.

[25] WuY, LimJ, Yang MH. Online object tracking: a benchmark[C]∥2013 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 23-28, 2013, Portland, OR, USA. New York: IEEE, 2013: 2411- 2418.

[26] JiaX, Lu HC, Yang MH. Visual tracking via adaptive structural local sparse appearance model[C]∥2012 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 16-21, 2012, Providence, RI, USA. New York: IEEE, 2012: 1822- 1829.

[27] HongS, YouT, KwakS, et al. Online tracking by learning discriminative saliency map with convolutional neural network[C]∥Proceedings of the 32nd international Conference on Machine Learning, July 6-11, 2015, Lille, France. Massachusetts: JMLR. org, 2015, 37: 597- 606.

[28] DanelljanM, HägerG, Khan FS, et al.Accurate scale estimation for robust visual tracking[C]∥Proceedings of the British Machine Vision Conference 2014, September 1-5, 2014, Nottingham. Durham, England,UK: BMVA Press, 2014: 1- 11.

Article Outline

崔洲涓, 安军社, 崔天舒. 基于多层深度卷积特征的抗遮挡实时跟踪算法[J]. 光学学报, 2019, 39(7): 0715002. Zhoujuan Cui, Junshe An, Tianshu Cui. Real-Time and Anti-Occlusion Visual Tracking Algorithm Based on Multi-Layer Deep Convolutional Features[J]. Acta Optica Sinica, 2019, 39(7): 0715002.