基于多特征融合和混合卷积网络的高光谱图像分类  下载: 977次

下载: 977次

1 引言

成像光谱仪能在数十至数百个窄波段内获取目标地物丰富的光谱信息,高光谱图像的像素级分类结果,在遥感测绘、地质勘察、精准农业、环境监测和灾害评估等领域得到了广泛应用[1]。近年来,以卷积神经网络(CNN)为代表的深度学习方法被成功用于高光谱图像的分类研究,相比传统分类方法,深度学习方法在分类精度方面有很大提升[2]。高光谱数据中带标签的样本数量较少,因此,在训练样本有限条件下取得理想的分类效果具有一定的挑战性[3]。

高光谱图像具有的高维性、高非线性和小样本等特点,要求分类器具有提取和处理深度抽象特征的能力[4-5]。传统的机器学习分类器,如支持向量机(SVM)、随机森林(RF)、多元逻辑回归(MLR),在缺少深层特征的支持下,难以取得理想的分类效果[6-7]。近年来,以CNN为代表的深度学习模型为高光谱图像分类的特征提取提供了解决方案[8-9]。CNN用三维(3D)数据块作为输入,可直接学习待分类像素的光谱特征及其一定大小邻域内的空间特征,对高光谱图像的分类精度较高[10]。

基于CNN的高光谱图像分类主要用二维CNN(2D-CNN)或3D-CNN提取空谱特征。2D-CNN用降维后的高光谱数据作为输入,保留的主成分数量和邻域窗口尺寸区别较大[11-12]。因此,Chen等[13]和Li等[14]分别构建了3D-CNN,直接对原始高光谱数据进行特征提取,其中,文献[ 13]使用的邻域尺寸为27×27,卷积核尺寸为5×5×32;文献[ 14]使用的邻域尺寸和卷积核尺寸相对较小。实验结果表明,相比2D-CNN,3D-CNN的分类精度有所提高,原因是3D-CNN可以更好地探索高光谱图像中丰富的光谱信息。在3D-CNN的基础上进行网络优化设计,是基于CNN模型进行高光谱图像分类研究的主要方向之一。此外,由于高光谱数据的标记工作费时费力,因此小样本高光谱图像的分类近年来受到了广泛关注[15]。与浅层神经网络相比,深层神经网络可确保提取特征的鲁棒性和判别力,减轻了过拟合现象对分类精度的影响[16]。为了提高高光谱图像的分类精度,人们通过残差网络(ResNet)[17]的残差连接加深网络深度和优化模型的拓扑结构。Lee等[18]在2D-CNN中引入残差连接,构建了较深的2D-CNN(Res-2D-CNN),提升了高光谱图像的分类精度。刘冰等[6]结合3D-CNN和残差连接,成功训练了一个12层的3D-CNN(Res-3D-CNN),进一步提升了高光谱图像的分类精度。Zhong等[19]通过改进残差连接作用的位置构建了光谱空间残差网络(SSRN),通过分离空间特征学习和光谱特征学习进一步改善了提取特征的判别力。魏祥坡等[21]借鉴稠密连接网络(DenseNet)[20]中的密集单元,通过特征图逐像素相加和连接实现了多层特征重用,并加强了网络中的信息传递。颜铭靖等[22]提出了一种空洞卷积残差网络,通过在深层残差网络中引入空洞卷积增大卷积核的感受野,在不增加网络参数量的情况下增强了网络提取空谱特征的能力。Roy等[23]提出了一种三维二维混合卷积网络(HybridSN),在连续的三维卷积层后使用二维卷积层进一步处理提取的空谱特征,并通过实验验证了混合卷积网络在高光谱图像分类中的应用潜力。Feng等[24]在HybirdSN的基础上引入非恒等残差连接和深度可分离卷积,构建了R-HybridSN(Residual HybridSN),减少了网络参数,增加了学习特征的路径,增强了光谱信息在网络中的流动性,进一步提升了小样本高光谱图像的分类精度。但R-HybridSN特征融合方式单一,且对浅层特征的利用不足,存在较大的改进空间。

为了进一步提升小样本高光谱图像的分类精度,本文提出了一种多特征融合HybridSN(M-HybridSN),通过特征图连接和逐像素相加两种方式进行多特征融合,使网络能更高效地学习高光谱数据中的复杂特征。通过与HybirdSN、R-HybirdSN等模型在Indian Pines(IP)、Salinas(SA)、University of Pavia(PU)三个公开数据集上的对比实验验证了本模型的有效性。

2 实验方法

2.1 三维二维混合卷积网络

本模型属于混合卷积网络,基本单元包括三维卷积层和二维深度可分离卷积层。三维卷积层在高光谱数据的空间维和光谱维同时进行运算,单个三维卷积核对三维高光谱数据块的运算结果是三维张量,多个三维卷积核提取的特征图可看作四维张量,因此三维卷积层能更好地探索高光谱数据的空谱联合特征。深度可分离卷积本质上是二维卷积,将卷积过程分为空间卷积和通道卷积两步[25]。相比传统的二维卷积,深度可分离卷积一方面可以降低网络的参数量,另一方面更适合高光谱图像特殊的数据结构[24]。

在HybridSN中,首先用三维卷积进行空谱联合特征学习,然后用二维深度可分离卷积进行空间信息增强。为了使数据维度满足二维卷积层的要求,将最后一层三维卷积层输出的特征图在光谱维和通道维连接,即将维度为W×H×B×C的四维张量重组(reshape)成维度为W×H×(BC)的三维张量,其中,W和H为特征图的宽和长,B为波段数,C为通道数。特征图送入全连接层前,要展平(flatten)成一维向量。本模型在混合网络的基础上,引入残差连接进行多特征融合,在加强网络中信息传递的同时强化网络学习多尺度特征和多抽象层次特征的能力。

2.2 基于残差连接的两种特征融合方式

基于残差连接实现的特征融合是构建深层CNN的核心。目前,CNN中的特征融合方式主要有特征图逐像素相加和特征图连接两种。其中,逐像素相加常用于融合某两层输出的特征图,可加强网络中的信息传递;特征图连接往往用于连接多层输出的特征图,可实现特征重用。设某CNN第k层的输出为Xk,若第k层使用逐像素相加的方式融合本层输入和输出的特征图,则

式中,Hk(·)为第k层对输入的非线性变换函数,Gk(·)为残差连接中包含对输入处理的函数。若为恒等残差连接,则Gk(Xk-1)=Xk-1。若第k层的输入为前l层特征图连接的结果,则

式中,[·]为特征图的连接操作,且l≤k。

特征图逐像素相加为特征学习构建了额外的路径,但这种方式改变了特征图中像素的取值,对单个特征图输出的信息利用不够充分。连接的方式完整保留了前若干层特征图的信息,为网络中浅层特征的重用提供了解决方案。但相比逐像素相加,连接的方式增加了特征图的通道数,可能会造成冗余。因此在构建高光谱图像分类模型时,需要精心设计残差连接的位置和特征图融合的方式,保证增强网络学习特征能力的同时不过多地增加网络参数。

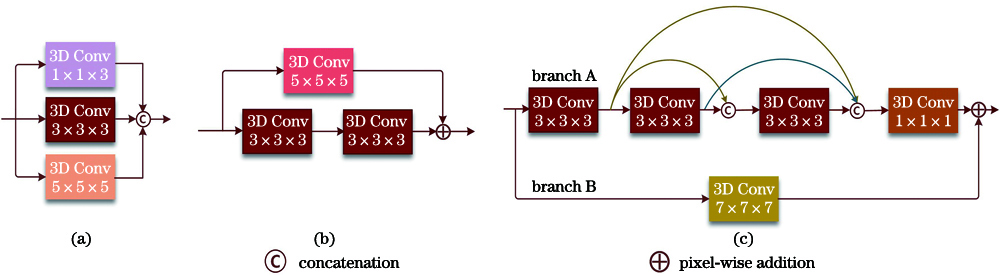

2.3 多特征融合

由待分类像素及其邻域像素的光谱向量构成的三维数据块包含丰富的光谱信息和空间信息,为了取得良好的分类效果,网络必须具有提取深层次抽象特征的能力;且对于不同分辨率、不同地物分布特点的高光谱图像,不同尺度、不同抽象级别的特征都对分类有重要影响。为了更有效地融合不同尺度、不同抽象级别的特征,提出了一种多特征融合模块,该模块与R-HybridSN中三维卷积层的布局对比示意图如

图 1. R-HybridSN和M-HybridSN模块的对比。(a) R-HybridSN第一层的多尺度卷积层;(b) R-HybridSN的非恒等残差连接;(c) M-HybridSN的多特征融合模块

Fig. 1. Comparison of R-HybridSN and M-HybridSN modules. (a) Multi-scale convolutional layer of the first layer of R-HybridSN; (b) non-identical residual connection of the R-HybridSN; (c) multi-feature fusion module of the M-HybridSN

连续卷积层学习的特征有两个特点:1)特征的抽象程度越来越高;2)特征图中单个像素在原始图像中映射的区域(感受野)越来越大。因此,在多特征融合模块分支A中,最终连接的特征图既有多尺度特点,又有多抽象级别的特点。相比R-HybridSN仅在网络开始使用的多尺度卷积层,本模型的多特征融合更彻底。在多特征融合模块分支A中,若不存在特征图连接,则最后输出特征图的感受野为7×7×7。由于重用了主路径上的浅层特征,实际的感受野小于7×7×7。因此,在分支B使用卷积核尺寸为7×7×7的卷积层对输入进行处理后,再进行特征融合,可进一步强化网络对空谱特征的学习能力。

2.4 M-HybridSN的结构

M-HybridSN是包含三维卷积和二维卷积的混合网络,其输入为经主成分分析(PCA)降维后的高光谱图像块。取待分类像素及其邻域若干像素的光谱向量组成图像块,记为PM×M×D,其中,M为选定的邻域尺寸,D为降维后的波段数。通过权衡空间特征学习的需要和模型复杂度,取M=15,D=16。M-HybridSN包含13个卷积层(11个三维卷积层,2个二维卷积层),卷积层的类型、卷积核尺寸、卷积核个数如

3 实验结果与分析

3.1 实验数据

为了验证本模型的有效性,用三个公开的高光谱数据集进行分类实验,包括数据集IP、SA和PU。数据集IP中的图像尺寸为145 pixel×145 pixel,空间分辨率为20 m,主要包括农作物、树林和其他多年生植物等16类,标记样本总数为10249个。数据集SA中的图像尺寸为512 pixel×217 pixel,空间分辨率为3.7 m,主要包括植被、裸土和葡萄园等16类,总标记样本数为54129个。数据集PU中的图像尺寸为610 pixel×340 pixel,空间分辨率为1.3 m,标记样本被分为9类,大部分为城镇的地物,如金属板、屋顶、混凝土路面,标记样本总数为42776个。三个数据集的标记样本被随机划分为训练集、验证集和测试集,实验主要关注小样本高光谱图像的分类,因此需尽可能降低训练样本的数量。其中,数据集IP的训练集、验证集和测试集样本数占标记样本总数的比例分别为5%、5%、90%。数据集SA和PU的训练集、验证集和测试集样本数占标记样本总数的比例分别为1%、1%、98%。对于数据集IP,在训练样本占标记样本总数5%的比例下,部分地物仅包含1到2个训练样本,且不同地物之间训练样本的数量极不平衡,因此实验研究的小样本具有一定代表性。三个数据集训练、验证、测试样本的详细分布如

表 1. 数据集IP的分布情况

Table 1. Distribution situation of the data set IP

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

表 2. 数据集SA的分布情况

Table 2. Distribution situation of the data set SA

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

表 3. 数据集PU的分布情况

Table 3. Distribution situation of the data set PU

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

3.2 对比模型和实验设置

为了验证本模型的有效性,用Res-2D-CNN[18]、Res-3D-CNN[6]、HybridSN[23]、R-HybridSN[24]作为对比模型。不同模型的参数量、输入数据规模(M×M×D)如

表 4. 不同模型的参数量和输入数据规模

Table 4. Parameter number and input data scale of different models

|

为了观察模型结构对分类精度的影响,排除其他因素,统一使用Adam作为模型优化器,学习率固定为0.001。为了保证所有模型均能够充分训练,参考相应文献的设定,将Res-2D-CNN、Res-3D-CNN、HybridSN、R-HybridSN和M-HybridSN的训练轮数分别设置为200、200、200、100、100。训练时监控验证集的分类精度,在指定的训练轮数内保存验证集精度最高的模型。

3.3 实验结果

用总体精度(OA)、平均精度(AA)和Kappa系数定量衡量模型的分类效果,不同模型在三个数据集上的分类结果如

表 5. 不同模型对数据集IP的分类结果

Table 5. Classification results of the data set IP by different models unit: %

|

表 6. 不同模型对数据集SA的分类结果

Table 6. Classification results of the data set SA by different models unit: %

|

表 7. 不同模型对数据集PA的分类结果

Table 7. Classification results of the data set PA by different models unit: %

|

综上所述,M-HybridSN的综合表现最好,在数据集IP、SA、PU上的OA分别比R-HybridSN高0.35、0.64、0.05个百分点。从

3.4 非恒等残差连接分析

相比HybridSN、R-HybridSN模型,M-HybridSN模型的特点是用多特征融合模块连接了不同层的特征图,同时用大尺寸的非恒等残差连接进行进一步特征融合。为了探索多特征融合模块中非恒等残差连接对分类精度的影响,去掉多特征融合模块中的两个非恒等残差连接,并将非恒等残差连接卷积核尺寸依次设置为1×1×1、3×3×3、5×5×5和9×9×9,20次实验的平均值如

图 6. 非恒等残差连接不同条件下的对比实验结果

Fig. 6. Comparative experiment results under different conditions of the non-identical residual connection

4 结论

针对高光谱图像小样本的特点,提出一种M-HybridSN模型。首先,用三维卷积层提取深层空谱联合特征;然后,用深度可分离卷积加强空间特征,经全连接层对特征进一步进行抽象重组;最后,由输出层完成分类。为了加强模型对浅层特征的重用,M-HybridSN模型在主路径用三维卷积连接不同层的特征图,同时引入大尺寸卷积核的非恒等残差连接构建次要路径,加强网络中的信息传递。用数据集IP、SA、PU中极少的标记样本训练模型进行分类实验,结果表明,相比其他模型,M-HybridSN模型在网络结构上具有一定先进性,在小样本高光谱图像的分类中表现较好。为了降低模型的计算复杂度和用较大邻域尺寸提取空间特征,用PCA对高光谱数据进行降维处理,但该过程会造成光谱信息的损失。因此,还需进一步研究如何在空间信息、光谱信息和计算复杂度三者之间达到平衡,同时在结构确定的情况下提高网络对不同数据集的适应能力。

[1] 李盛阳, 刘志文, 刘康, 等. 航天高光谱遥感应用研究进展(特邀)[J]. 红外与激光工程, 2019, 48(3): 0303001.

[5] 毕晓君, 周泽宇. 基于双通道GAN的高光谱图像分类算法[J]. 光学学报, 2019, 39(10): 1028002.

[6] 刘冰, 余旭初, 张鹏强, 等. 联合空-谱信息的高光谱影像深度三维卷积网络分类[J]. 测绘学报, 2019, 48(1): 53-63.

[8] 张号逵, 李映, 姜晔楠. 深度学习在高光谱图像分类领域的研究现状与展望[J]. 自动化学报, 2018, 44(6): 961-977.

[9] 刘玉珍, 蒋政权, 马飞, 等. 基于超图和卷积神经网络的高光谱图像分类[J]. 激光与光电子学进展, 2019, 56(11): 111007.

[11] MakantasisK, KarantzalosK, DoulamisA, et al.Deep supervised learning for hyperspectral data classification through convolutional neural networks[C] //2015 IEEE International Geoscience and Remote Sensing Symposium (IGARSS), July 26-31, 2015, Milan, Italy.New York: IEEE Press, 2015: 4959- 4962.

[15] 杜培军, 夏俊士, 薛朝辉, 等. 高光谱遥感影像分类研究进展[J]. 遥感学报, 2016, 20(2): 236-256.

Du P J, Xia J S, Xue Z H, et al. Review of hyperspectral remote sensing image classification[J]. Journal of Remote Sensing, 2016, 20(2): 236-256.

[17] He KM, Zhang XY, Ren SQ, et al.Deep residual learning for image recognition[C] //2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA.New York: IEEE Press, 2016: 770- 778.

[18] Lee H, Kwon H. Going deeper with contextual CNN for hyperspectral image classification[J]. IEEE Transactions on Image Processing, 2017, 26(10): 4843-4855.

[19] Zhong Z L, Li J, Luo Z M, et al. Spectral-spatial residual network for hyperspectral image classification: a 3-D deep learning framework[J]. IEEE Transactions on Geoscience and Remote Sensing, 2018, 56(2): 847-858.

[20] HuangG, LiuZ, van der MaatenL, et al. Densely connected convolutional networks[C] //2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA.New York: IEEE Press, 2017: 2261- 2269.

[21] 魏祥坡, 余旭初, 谭熊, 等. 利用残差密集网络的高光谱图像分类[J]. 激光与光电子学进展, 2019, 56(15): 151006.

[22] 颜铭靖, 苏喜友. 基于三维空洞卷积残差神经网络的高光谱影像分类方法[J]. 光学学报, 2020, 40(16): 1628002.

[23] Roy S K, Krishna G, Dubey S R, et al. HybridSN:exploring 3-D-2-D CNN feature hierarchy for hyperspectral image classification[J]. IEEE Geoscience and Remote Sensing Letters, 2020, 17(2): 277-281.

[25] CholletF. Xception:deep learning with depthwise separable convolutions[C] //2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE Press, 2017: 1800- 1807.

Article Outline

冯凡, 王双亭, 张津, 王春阳. 基于多特征融合和混合卷积网络的高光谱图像分类[J]. 激光与光电子学进展, 2021, 58(8): 0810010. Fan Feng, Shuangting Wang, Jin Zhang, Chunyang Wang. Hyperspectral Images Classification Based on Multi-Feature Fusion and Hybrid Convolutional Neural Networks[J]. Laser & Optoelectronics Progress, 2021, 58(8): 0810010.