贝叶斯融合多核学习的图像显著性检测  下载: 944次

下载: 944次

1 引言

近年来,图像显著性检测算法的研究越来越得到人们的关注,在场景中找到信息最丰富的区域,成为解决信息问题的有效方式。显著性检测被应用于诸多领域,如目标识别[1]、视觉跟踪[2]、图像压缩[3]等。一般地,显著性检测算法通过自底向上[4]或者自顶向下[5]的算法进行分类。自底向上的算法利用的是低层次的图像信息,如对比颜色、纹理和边界的特征。Harel等[6]构造马尔可夫链,快速提取图像显著性区域的GBVS( Graph-Based Visual Saliency)算法,应用心理学特征,但计算复杂,显著图分辨率很低;Margolin等[7]用主成分分析的方法(PCA)计算图像数据,利用内部结构计算得到最后的显著性图,但计算复杂,检测效果不理想;Yang等[8]对传统的中心先验进行改良,提出粗略估计显著目标位置的HC(Histogram Contrast )算法,该算法存在边界模糊问题;Tong等[9]提出了基于多尺度超像素的SD-MS(Saliency Detection with Multi-Scale Superpixels )显著性检测算法,并在2015年通过增强学习[10](BL)获得准确性更高的显著结果,但运行时间较长,实验结果也受到影响。而自顶向下的算法分析任务驱动的视觉时,需要大量的训练样本对其进行监督学习。如Cheng等[11]提取三通道颜色特征差异计算显著性值,由于只通过颜色特征来分析,故只能粗略检测出显著图,该算法称为Global Contrast Based Salient Region Detection,简称GR算法,对背景抑制能力较弱;Jiang等[12]考虑突出的外观和空间分布,利用马尔可夫链吸收节点AMC(Absorb Markov Chain)的时间来计算显著性值,计算复杂,运算效率较低,并且实验效果并不理想;Li等[13]采用稀疏稠密传播重建误差,并对高斯算法进行改进以获取显著值,该算法称为Dense and Sparse Reconstruction,简称DSR算法,算法效率低。

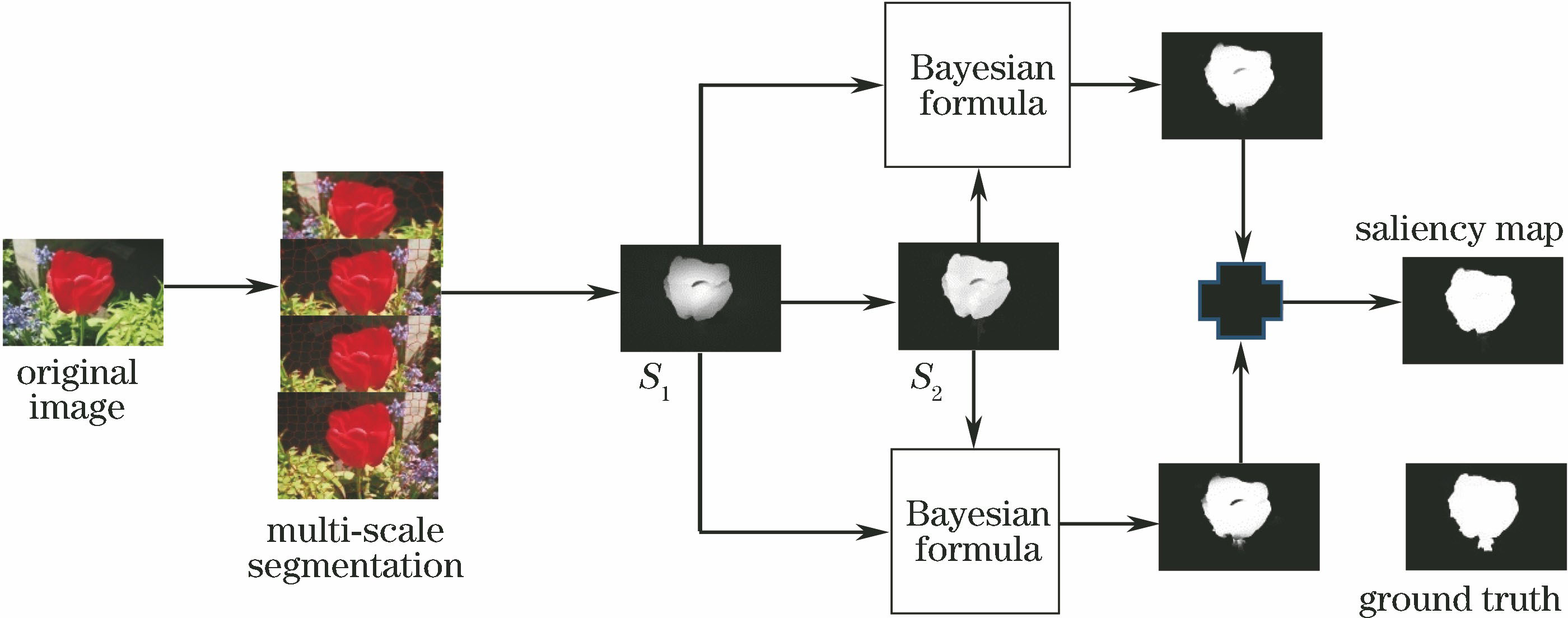

针对图像显著性检测算法存在的检测不准确和边缘不清晰问题,利用贝叶斯公式算法将通过compactness先验得到的初级显著性图和通过多核学习得到的次级显著性图融合,同时运用多尺度分割,得到最终的显著性图。本文结合两种检测算法的优势,提取空间特征,训练学习样本,同时运用贝叶斯公式融合,可以大幅提高检测结果的精确性。

2 算法整体框架

底层特征的传统显著性检测方式常通过提取场景的低级特征来突出目标,故对于复杂背景的抑制与目标内部纹理的均匀性检测效果欠佳,检测结果边缘模糊,目标边界附近像素归类容易产生误差。为解决以上问题,提出了一种基于多核学习与贝叶斯公式融合的显著性检测算法。基于多核学习方式能有效突出显著性目标,基于compactness先验对比能够紧密地区分显著目标的位置,将两种显著图以贝叶斯公式融合,优势互补。整体框架如

3 初级和次级显著图

3.1 初级显著图

在基于底层线索的全局或局部的显著性检测算法中,无论是背景还是目标的颜色纹理等细微变化,都可以在显著性结果中呈现出来,因此引入误差的概率较大。图像的显著性检测目标一般都对应真实存在的物体,他们通过互相连接的区域组合起来,所以,相比于背景区域,显著性目标具有更加紧凑的空间分布特性,因此引入了compactness先验[14]的算法从空间紧凑度的角度来提高算法的性能。

从场景角度分析,图像的前景目标物体通常被背景区域紧紧包围,这就意味着空间域的颜色分布在背景区域较为分散,故任一超像素的颜色空间差异越大就越可能是背景区域。首先将输入图像分割成

式中:

根据摄影学原理,物体大多被安排在图像靠近中央的位置,这使得图像更加美观,同时也更容易在看到图像的同时能够捕捉到图像的焦点,即显著目标。故任一超像素到图像中心的空间距离

式中:

式中:Norm(·)为归一化函数,表示将函数参数归一化。

3.2 次级显著图

次级显著性检测算法采用多核学习[10]的方法,多核学习是结合多个支持向量机(SVM)分类器的方式,每个SVM可以提取不同的信息特征,由于具有各个核提取不同特征的特点,可解决特征选择和协调特征的缺陷问题。对图像进行训练,将训练与测试放在同一张图像中,给定样本集合{

式中:

式中:

式中:

式中:

(8)式得到的强分类器用于图像样本,经过

3.3 构建多尺度显著图

由于所使用的数据集内容丰富,且图像内目标物体的大小不一样,任意图片的显著物体目标的尺度不同,超像素分割在单一尺度下也未必准确,分割情况会影响显著性检测的效果,因此需采用多尺度[12]解决分割问题。设立不同的超像素个数,

同理,

4 贝叶斯公式融合

贝叶斯公式用条件概率表达各个信息要素之间的相关关系,它能够有效地进行多元信息的表达和融合,在某些情况下,类似于自顶向下的机制,通过寻找先验概率、似然概率和后验概率三者之间的相互关系求得结果,以提高显著性检测的精确性。基于此特点,提出了一种用贝叶斯公式[13]得到的后验概率图,并使用一定的比例将后验概率图进行融合的算法,使得最终结果可以更好地突显出目标。

本文采用将显著图作为贝叶斯公式计算概率的方式,有效解决了因先验概率计算而引入的噪声问题。利用不同显著图的有效信息,分别作为贝叶斯公式中的先验概率和似然概率,得到后验概率显著图,首先

式中:

同样地,以

式中:

贝叶斯公式融合是将这两种显著图的不同信息充分利用,有效地突出图像中的目标,因为次级显著图受到初级显著图的影响,最终融合时初级显著图作为先验概率得到的后验概率所占比例高一些,经过多次实验证实,

5 实验结果及分析

本文中所有实验结果均是在同一个环境下运行得出,使用Matlab R2014b进行实验分析,运行环境基于Windows8.1操作系统平台,内存4.00 GB,处理器为Intel Core i5 CPU,主频参数为1.60 。实验使用的两个数据集(MSRA-10K[14]和ECSSD[15])为公开数据集,数据集从互联网的共享信息中获得。

为验证本文算法的有效性,对比分析本文算法与8种经典算法(GBVS[6]、HC[8]、PCA[7]、DSR[13]、AMC[12]、GR[11]、SD-MS[9]、BL[10])的实验结果。

5.1 实验分析

在MRSA-10K[14]和ECSSD[15]数据集上进行测试,并通过精确度召回率曲线(

图 2. ECSSD和MRSA-10K数据集上显著性检测结果

Fig. 2. Saliency test results on ECSSD and MRSA-10K datasets

5.2 评测指标

在大多数现有的算法中,采用精确率、召回率和

式中:

图 3. MSRA-10K数据集上P-R曲线。(a)整体曲线;(b)局部曲线

Fig. 3. P-R curves on MSRA-10K dataset. (a) Whole curves; (b) partial curves

图 4. MSRA-10K数据集上F-measure曲线。(a)整体曲线;(b)局部曲线

Fig. 4. F-measure curves on MSRA-10K dataset. (a) Whole curves; (b) partial curves

图 5. ECSSD 数据集上P-R曲线。(a)整体曲线;(b)局部曲线

Fig. 5. P-R curves on ECSSD dataset. (a) Whole curves; (b) partial curves

图 6. ECSSD数据集上F-measure曲线。(a)整体曲线;(b)局部曲线

Fig. 6. F-measure curves on ECSSD dataset. (a) Whole curves; (b) partial curves

为便于观察数据,列出9种算法中最优

表 1. 多种算法运行环境及时间对比

Table 1. Running environments and time of various algorithms

|

6 结论

针对显著性检测算法存在的检测不准确和边缘不清晰的问题,采用贝叶斯公式将由compactness先验的空间紧密性所产生的初级显著性图和经多核学习得到的次级显著图以不同权重进行融合,这样的结合方式使得最终的显著性检测图像更加精确,在多核学习获得次级显著图的过程中,将训练学习限制在一个图像的多尺度内,既增强了检测效率,又减少了计算资源。经对比经典算法,可以看出本文算法性能优于其他算法,可以更加精确地检测出图像显著目标,在运行时间上也略优于部分算法。

[1] 毕立恒, 刘云潺. 基于改进神经网络算法的植物叶片图像识别研究[J]. 激光与光电子学进展, 2017, 54(12): 121102.

[2] 李敬轩, 宗群. 基于多特征和局部联合稀疏表示的目标跟踪[J]. 激光与光电子学进展, 2017, 54(10): 101502.

[3] 李非燕, 霍宏涛, 白杰, 等. 基于稀疏表示和自适应模型的高光谱目标检测[J]. 光学学报, 2018, 38(12): 1228004.

[4] 汪丽华, 涂铮铮, 王泽梁. 基于流形正则化随机游走的图像显著性检测[J]. 激光与光电子学进展, 2018, 55(12): 121005.

[5] 鲁圆圆, 强静仁, 汪朝. 基于区域信息主动轮廓模型的图像分割[J]. 计算机工程与应用, 2018, 54(10): 208-212.

Lu Y Y, Qiang J R, Wang Z. Image segmentation based on active contours with local information[J]. Computer Engineering and Applications, 2018, 54(10): 208-212.

[6] HarelJ, KochC, PeronaP. Graph-based visual saliency[C]∥19th International Conference on Neural Information Processing Systems, December 4-7, 2006, Canada.Cambridge: MIT Press, 2006: 545- 552.

[7] MargolinR, TalA, Zelnik-ManorL. What makes a patch distinct?[C]∥2013 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 23-28, 2013, Portland, OR, USA. New York: IEEE, 2013: 1139- 1146.

[8] Yang C, Zhang L H, Lu H C. Graph-regularized saliency detection with convex-hull-based center prior[J]. IEEE Signal Processing Letters, 2013, 20(7): 637-640.

[10] TongN, Lu HC, RuanX, et al. Salient object detection via bootstrap learning[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 1884- 1892.

[11] Cheng M M, Mitra N J, Huang X L, et al. Global contrast based salient region detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 569-582.

[12] Jiang BW, Zhang LH, Lu HC, et al. Saliency detection via absorbing Markov chain[C]∥2013 IEEE International Conference on Computer Vision, December 1-8, 2013, Sydney, NSW, Australia. New York: IEEE, 2013: 1665- 1672.

[13] Li XH, Lu HC, Zhang LH, et al. Saliency detection via dense and sparse reconstruction[C]∥2013 IEEE International Conference on Computer Vision, December 1-8, 2013, Sydney, NSW, Australia. New York: IEEE, 2013: 2976- 2983.

[14] 黄子超. 先验融合和特征指导的显著目标检测方法研究[D]. 合肥: 安徽大学, 2017: 32- 33.

Huang ZC. Research of salient object detection based on prior integration and feature guidance[D]. Hefei: Anhui University, 2017: 32- 33.

[15] 刘坤, 张晓怿, 陈宁纪, 等. 融合深度信息的雾霾情况下显著性目标提取[J]. 河北工业大学学报, 2015, 44(2): 10-15.

Liu K, Zhang X Y, Chen N J, et al. Salient object detection fusing depth information under foggy weather[J]. Journal of Hebei University of Technology, 2015, 44(2): 10-15.

[16] 毕威, 黄伟国, 张永萍, 等. 基于图像显著轮廓的目标检测[J]. 电子学报, 2017, 45(8): 1902-1910.

Bi W, Huang W G, Zhang Y P, et al. Object detection based on salient contour of image[J]. Acta Electronica Sinica, 2017, 45(8): 1902-1910.

Article Outline

陈雪敏, 唐红梅, 韩力英, 高振斌. 贝叶斯融合多核学习的图像显著性检测[J]. 激光与光电子学进展, 2019, 56(16): 161010. Xuemin Chen, Hongmei Tang, Liying Han, Zhenbin Gao. Image Saliency Detection of Bayesian Integration Multi-Kernel Learning[J]. Laser & Optoelectronics Progress, 2019, 56(16): 161010.