一种改进的Capsule及其在SAR图像目标识别中的应用

0 引 言

作为深度学习网络模型,卷积神经网络在图像分类、计算机视觉等领域取得了长足的进展[1]。但是,卷积神经网络缺乏对目标的相对位置和空间关系的处理能力。因此,为了识别不同视角的目标,需要更多的训练样本或者更多的网络结构[2-3]。针对经典卷积神经网络存在的问题,一种新的深度学习网络Capsule[4-5]被提出。Capsule网络包含很多Capsule单元,而Capsule单元是由多种特征组合而成的多维向量,代表一个物体的整体或者一部分。Capsule输出既有本身的激活概率也有描述它们属性的实例化参数,其中属性包括姿态、形变、方向和纹理等[6]。在传输过程中,耦合过滤原则被用来激活更高层的Capsules和在Capsules之间建立局部与整体的空间关系。Capsule网络通过动态路由机制[4-5]调整局部与整体的空间关系,这种空间关系的建立使得Capsule网络能更好地处理目标的相对位置关系和空间关系问题。但是,由于Capsule网络需要消耗大量的计算和存储资源,因此处理图片大小一般不超过32×32。这给Capsule网络在**领域的应用带来了极大的限制,如在SAR-ATR应用中,合成孔径雷达(SAR)图像的目标切片大小一般大于128×128,可见光和红外图像具有更大的图像尺寸,采用Capsule网络进行目标识别,对计算和存储资源的需求成为了一个挑战。

文中基于脑机制提出了一种针对Capsule网络的改进算法,大大减小了计算量和参数数量。在SAR-ATR上,与Capsule网络、SVM[7]、AdaBoost[7]、IGT[7]、DCNN[8-9]、CGM[10]和2-VDCNN[11]识别算法相比,准确率也得到明显的提升。这为深度学习技术的发展借鉴生物脑机制提供了有力的证据。

1 相关工作

Capsule概念的提出借鉴了初级大脑视觉皮层中具有相同功能的神经元以柱状的形式组织的机制[12],以多个神经元组合表征实体的局部或整体。在初级大脑视觉皮层中,神经元以层级结构组织,而每一层中具有相同或相似功能的神经元又以柱状的形式被组织在一起,比如处理颜色属性和处理纹理属性的神经元分别组成处理颜色属性的柱状结构和处理纹理属性的柱状结构。

1.1 Capsule单元

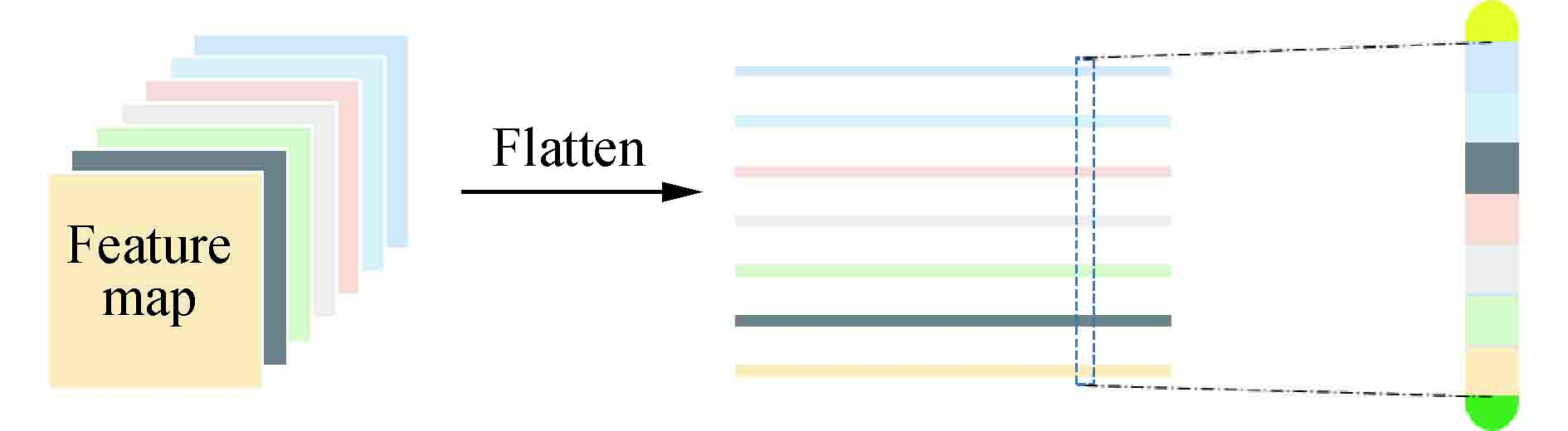

一个Capsule单元是一个多维向量,它的长度代表了一个实体存在的可能性。向量的每个维度代表了实体的属性,包括位置、方向、色度、纹理等。Capsule单元的结构如

1.2 Capsule网络结构

Capsule网络包含两个卷积层,卷积核的大小都是9×9像素,输出通道皆为256通道。以Capsule网络处理手写数据集图像为例,手写数据集的图像大小为28×28。在PrimaryCaps层中,经过第二次卷积,得到256个像素大小为6×6的特征图;然后进行矩阵维度变换,将256个特征图分成32组,每一组包含8个特征图,形成1 152个向量维度为8的Capsule单元。最后一层为DigitCaps层,包含10个向量维度为16的Capsule,表示10个实体类别。除了这些基本的结构外,原论文中还添加了重构层,将识别出来的目标还原成图片,用来计算重构损失以及可视化目标识别类别。重构层中包含3个全连接层,每一层神经元的数量分别为512、1 024和784。

Capsule网络用向量的长度表征实体存在的可能性。通过非线性变换,将向量映射到(0,1)之间。映射函数为非线性函数,定义如下:

式中:

实例化向量

式中:如果数字类别

1.3 Capsule网络的动态路由机制

Capsule网络通过动态路由机制[4-5]调整输出层的输出。输出层中的一个Capsule单元的总输入

式中:

式中:

Procedure 1 Routing algorithm.

1: procedure Routing

2: for all Capsule

3: for

4: for all Capsule

5: for all Capsule

6: for all Capsule

7: for all Capsule

8: return

1.4 Capsule网络的重构

Capsule网络使用重构损失作为总损失的一部分,促使输出Capsules编码输入图像的实例化参数。重构结构如

式中:

1.5 Capsule网络的优势

(1)提取的特征具有局部与整体空间关系的不变性。这一特性有助于识别或分割较小的目标。

(2)路由机制代替池化操作。这一机制保全了目标的信息,在识别邻近或重叠目标方面具有更好的优势。

(3)以向量输出代替标量输出。向量包含了目标的各个属性,实例化目标,能更好地解译目标。

(4)在相同识别效果下,与经典卷积神经网络相比,需要更少的训练数据、更少的层和参数。

2 改进的Capsule网络

文中基于脑机制提出了完全实例化的思想,并对原Capsule网络进行了改进,不仅保留了原网络的优势,而且减少了计算量和参数数量,同时也提升了训练的速度及识别的准确率。

初级大脑视觉皮层是以层级结构以及柱状组织的形式处理信息,并且随着层级的加深,提取的特征也更加抽象[12]。在初级视觉皮层中,获取到的视觉信号被逐级的处理,高层信息特征是对低层信息特征的整合[12]。基于此,文中对原Capsule网络结构进行了改进。一是特征提取结构的改进:原Capsule网络仅采用两层卷积层,而且卷积核的数量固定且较多,没能更好地体现初级大脑视觉皮层以层级处理信息的机制,以及提取的特征没有更加趋于抽象化,如

图 3. 原Capsule网络结构与改进的Capsule 网络结构

Fig. 3. Structure of original Capsule network and improved Capsule network

改进的Capsule网络卷积层的卷积核数量依次为16,32和64,卷积核大小都是9×9像素,如

表 1. 改进的Capsule网络与Capsule网络性能对比

Table 1. Performance comparison of improved Capsule network and Capsule network

|

表 3. 原Capsule网络10类目标识别结果的混淆矩阵(识别率:98.48%)

Table 3. Confusion matrix of 10-class target recognition results of Capsule network(recognition rate: 98.48%)

|

表 4. 改进的Capsule网络10类目标识别结果的混淆矩阵(识别率:98.85%)

Table 4. Confusion matrix of 10-class recognition results of improved Capsule network (recognition rate: 98.85%)

|

3 实验与分析

文中采用了标准工作条件(SOC)下采集的10类军用车辆的SAR图像数据集进行训练和测试,并与Capsule网络在SAR图像数据集上的识别结果进行对比。对比算法除了原Capsule网络之外,还有其他7种算法,主要分为传统SAR目标识别算法和基于经典卷积神经网络的SAR目标识别算法。

3.1 数据描述

获取该数据集的传感器为高分辨率的聚束式合成孔径雷达,该雷达的分辨率为0.3 m×0.3 m。MSTAR数据集的采集条件分为两类,分别为标准工作条件(SOC)和扩展工作条件(EOC)。文中主要采用标准工作条件(SOC)下采集的数据集进行实验。

图 4. (a)和(b)分别为BMP2、BTR70、T72、BTR60和2S1的光学图像和相对应的SAR图像;(c)和(d)分别为BRDM2、D7、T62、ZIL131和ZSU23/4的光学图像和相对应得SAR图像

Fig. 4. Optical images and their corresponding MSTAR SAR images for (a) and (b) BMP2, BTR70, T72, BTR60, and 2S1; (c) and (d) BRDM2, D7, T62, ZIL131, and ZSU23/4

表 2. 用于训练和测试实验的原始SAR数据集

Table 2. Raw SAR dataset for training and testing in experiment

|

3.2 实验结果

实验中采用图像重构作为正则化方法,并将重构损失计算到总损失之中,改进的Capsule网络训练过程中图像的重构结果如

图 5. 改进的Capsule网络的重构结果。(a)原始图像,(b)目标图像,(c)重构图像

Fig. 5. Reconstruction result of improved Capsule. (a) Original image,(b) Target image and (c) Reconstruction image

图 6. 改进的Capsule网络训练中重构错误曲线和训练损失曲线。(a)重构错误曲线,(b)训练损失曲线

Fig. 6. Reconstruction error curve and training loss curve of improved Capsule network. (a) Reconstruction error curve and (b) training loss curve

3.3 识别效果对比

在标准工作条件(SOC)下,除与原Capsule网络进行了对比外,还与基于经典卷积神经网络的目标识别算法和传统目标识别算法进行了对比。它们分别是SVM[13]、AdaBoost[14]、CGM[10]、IGT[7]、DCNNs[8-9]和2-VDCNN[11]。DCNNs和2-VDCNN都是经典卷积神经网络模型,其中2-VDCNN是多视角目标识别算法,相较于单一视角目标识别较容易取得好的识别效果。对比结果如

表 5. 不同方法的识别效果

Table 5. Recognition performance of different methods

| ||||||||||||||||||||||||||||||||

从

4 结 论

文中首先分析了Capsule网络的结构、原理及特性,并结合脑机制对原Capsule网络存在的不足进行了改进。然后,将原Capsule网络和改进后的Capsule网络应用于SAR图像目标识别,并与其他SAR图像目标识别算法进行了对比。实验结果表明,在性能上,改进的Capsule网络较原Capsule网络的参数数量和计算量分别降低了1.6倍和31倍,训练速度提高了一倍;在SAR-ATR上,改进的Capsule网络的识别率较原Capsule网络和多视角2-VDCNN分别提高了0.37和1.04个百分点。与其他6种算法相比,在训练样本分别减小62.5%和49.9%的条件下,改进的Capsule网络的识别率分别提高了1.96~8.96个百分点。从而验证了基于脑机制改进的Capsule网络较原Capsule网络在性能上有较大的提升,并且在SAR-ATR上具有更好的识别效果。尽管改进的Capsule网络在一定程度上减少了计算量和参数数量,但是针对更大图片的处理仍然存在计算消耗和存储需求较大的问题。因此,在后续的工作中,将考虑去除没有或包含较少信息量的特征,进一步减少Capsule单元的维度,从而使得对计算资源和存储空间的需求降低。

[2] Cohen T, Welling M. Group equivariant convolutional wks[C] International Conference on Machine Learning. 2016: 29902999.

[3] Cohen T S, Geiger M, Köhler J, et al. Spherical cnns[J]. arXiv preprint arXiv: 1801.10130, 2018.

[4] Sabour S, Frosst N, Hinton G E. Dynamic routing between Capsules[J]. Computer Vision and Pattern Recognition, 2017, arXiv: 1710.09829: 1-11.

[5] Sabour S, Frosst N, Hinton G. Matrix capsules with EM routing[C]6th International Conference on Learning Representations, ICLR. 2018: 115.

[6] Hinton G E, Krizhevsky A, Wang S D. Transfming autoencoders[C]International Conference on Artificial Neural wks. Berlin, Heidelberg: Springer, 2011: 4451.

[8] Ding J, Chen B, Liu H. Convolutional neural network with data augmentation for SAR target recognition[J]. IEEE Geoscience and Remote Sensing Letters, 2016133: 364-368.

[9] Mgan D A E. Deep convolutional neural wks f ATR from SAR imagery[C]Algithms f Synthetic Aperture Radar Imagery XXII. International Society f Optics Photonics, 2015, 9475: 94750F.

[12] Eric R K, James H S, Thomas M J, et al. Principles of Neural Science [M]. 5th ed. Beijing: China Machine Press, 2013.

[14] Sun Y, Liu Z, Todorovic S. Adaptive boosting for SAR automatic target recognition[J]. IEEE Transactions on Aerospace & Electronic Systems, 2007, 43(1): 112-125.

Article Outline

张盼盼, 罗海波, 鞠默然, 惠斌, 常铮. 一种改进的Capsule及其在SAR图像目标识别中的应用[J]. 红外与激光工程, 2020, 49(5): 20201010. Zhang Panpan, Luo Haibo, Ju Moran, Hui Bin, Chang Zheng. An improved Capsule and its application in target recognition of SAR images[J]. Infrared and Laser Engineering, 2020, 49(5): 20201010.