基于双流卷积神经网络的RGB-D图像联合检测  下载: 1328次

下载: 1328次

1 引言

红绿黄彩色图像和深度(RGB-D)图像是当前计算机视觉领域新的研究热点[1],主要由深度相机获得,包括红绿黄彩色(RGB)图像和对应的深度图像。RGB图像包含所拍摄物体的表面颜色和纹理等信息,而深度图像包含物体的空间形状等信息。两种图像对彼此都是一个很好的补充。因此,有效利用RGB信息和深度信息能显著提高场景中物体识别检测的准确率。当前,RGB-D图像的联合检测方法有基于人工设计特征的提取表达法和自动特征学习法[2]两种。

基于人工设计特征的提取表达法是指根据先验知识设计特定的特征,如尺度不变特征变换(SIFT)、加速稳健特性(SURF)、方向梯度直方图(HOG)等。首先采用词袋模型、空间金字塔匹配和稀疏编码等方法进行特征表达,然后对彩色图像和深度图像特征描述进行融合,最后使用分类算法,如支持向量机(SVM)、贝叶斯分类器等,进行图像识别检测。该方法的主要缺点是需要很强的先验知识才能设计好区分性强的特征与融合规则,不具有普适性。

自动特征学习法可以克服人工设计特征通用性不强的缺点,它采用特定的神经网络结构,通过无监督或有监督的训练,自动地学习源图像中的低层或高层特征,并采用一定的方式进行融合。基于卷积神经网络(CNN)的深度学习模型是当前这一领域的优秀代表。该学习模型使用卷积核将相邻像素之间的共同特性较好地提取表达出来,并在卷积核之间进行权值共享,大幅减少了神经网络训练过程中的参数数量,具有识别精度高、训练参数少的优势。Couprie等[3]将四通道的RGB-D图像同时输入到卷积网络中,得到了高于单一RGB或深度图像的识别精度。Gupta等[4]采用多方向梯度算子提取RGB-D图像的边缘特征,将提取到的边缘特征融合后送入到卷积神经网络中进行特征学习,在特定物体的识别方面取得了比原始RGB-D图像更好的分类效果。Eitel等[5]将不同模态的数据输入到独立的卷积神经网络中进行训练,经过五层卷积和下采样操作,再经过两个全连接层,最后将RGB信息和深度信息融合输入到输出层,得到了比四通道RGB-D信息同时输入更优的识别效果。

2 卷积神经网络

2.1 卷积神经网络模型结构

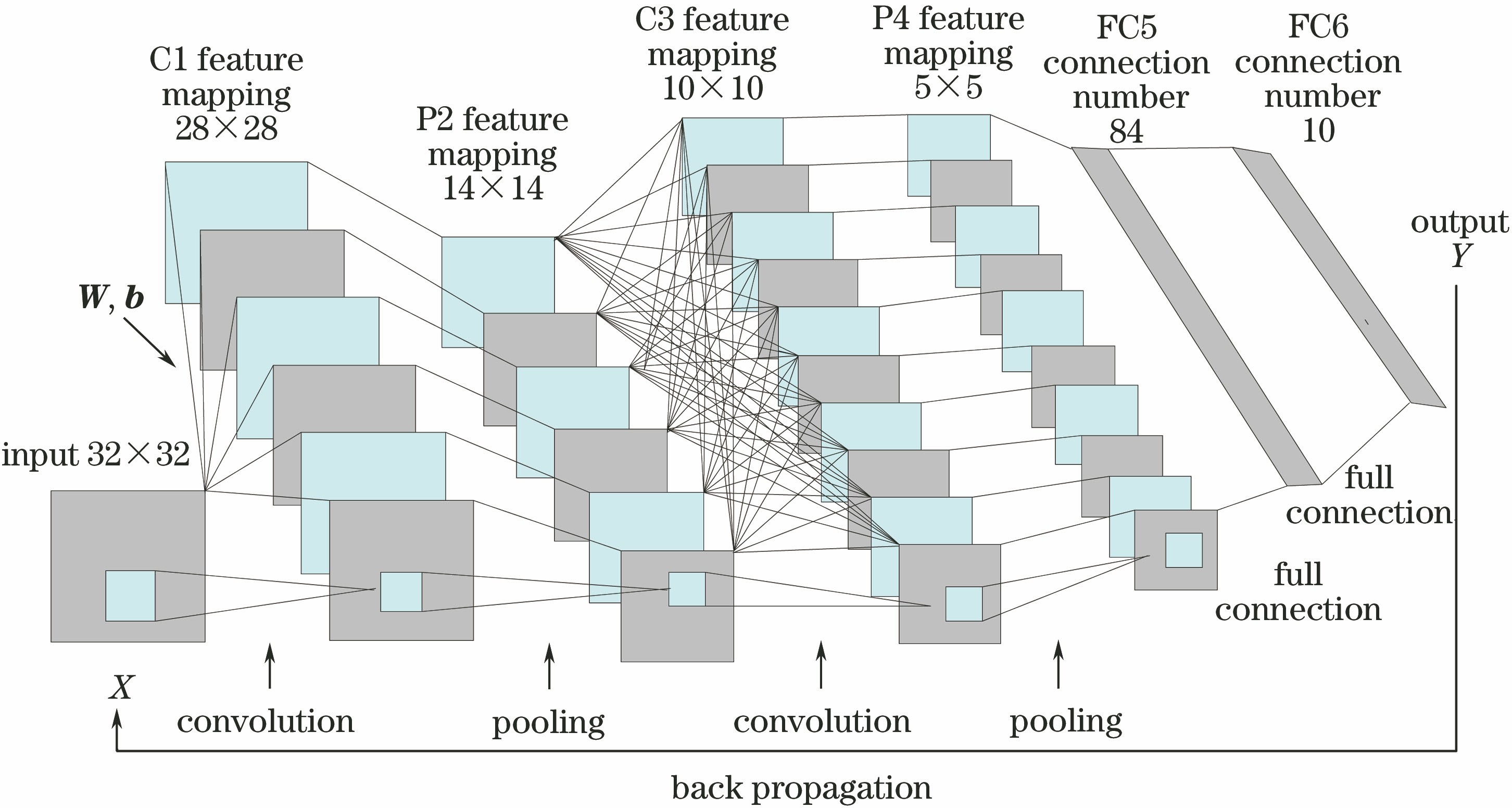

卷积神经网络是图像识别检测领域优秀的深度学习模型[6-7],与传统的后向传播(BP)神经网络相比增加了可以进行特征提取的卷积层和保证位移不变的池化层。卷积层能将相邻像素之间的共同特性较好地提取出来,池化层用来对图像信息进行降采样。为了降低运算的复杂度,卷积神经网络每层内的神经元权值实行共享,使用不同的卷积核进行卷积可提取前一层特征图的不同特征。这些代表不同特征的特征图共同作为下一层网络的输入数据,其结构如

如

2.2 卷积神经网络前向传播过程

卷积神经网络的训练过程可分为前向传播和后向传播两个阶段。在前向传播阶段,信息从输入层开始向前逐层传播,经过各个卷积层和全连接层直至输出层,神经元的基本模型如

设卷积网络的第

式中

当第

式中

当第

式中

2.3 卷积神经网络后向传播过程

卷积网络的训练目标是最小化网络的损失函数

卷积神经网络后向传播的实质是根据损失函数

式中

与传统识别算法相比,基于卷积神经网络的深度学习模型具有权值共享、模型复杂度低、权值数量少等优点,可避免复杂的手动特征提取和数据重建过程,也可实现自动特征学习,具有较高的研究价值与实用价值。

3 基于双流卷积神经网络的RGB-D信息融合

3.1 早期融合和后期融合策略

为了对RGB-D图像进行联合检测,可以通过卷积神经网络对RGB和深度图像的信息进行融合。当前基于卷积神经网络的主要的RGB-D信息融合模式为早期融合和后期融合[9-10],其结构分别如

式中“+”指对卷积得到的RGB特征图和深度特征图进行加法运算,本质是矩阵的加法运算。所有的RGB-D信息在第一个卷积层即完成了融合,其融合权值都为0.5,之后对融合后的RGB-D信息进行完整的卷积网络映射,这种方式偏向于对初始图像信息进行融合。

在输出层对两种图像进行融合之前,两个独立的卷积神经网络分别对两种图像进行运算,其卷积、池化、全连接运算过程分别如(1)、(3)、(5)式所示。RGB网络通道中最后一层全连接层中得到的神经元为

式中

3.2 全连接层融合和卷积层融合策略

3.1节中的两种网络结构都对RGB-D图像特征进行了一定的融合,但是早期融合结构偏重考虑RGB-D图像之间的相关性,对RGB和深度图像的独立特性考虑得不够充分,后期融合结构则偏重考虑RGB-D图像的独立性。为了更有效地融合RGB-D信息,本课题组提出了全连接层融合和卷积层融合的策略,其结构分别如

RGB网络通道中最后一层得到的神经元为

式中

该网络改进的关键点在于为了保证RGB和深度信息的独立性,并没有在最开始时将两种模态的信息输入到同一卷积层中,而是分别在两个卷积通道中进行训练。同时为了保持两种模态信息的联系,在两个卷积网络之间进行权值共享,这样也减少了训练参数,提升了训练和检测速度。经过数层卷积运算挖掘提取图像的内在特征后,为了得到RGB信息和深度信息的关联性,再通过相同的卷积核将两种模态信息融合。

对于融合系数

经网络对RGB图像和深度图像分别进行训练,得到对应的检测准确度之后,按照(10)式计算RGB图像和深度图像融合的最优权重。其中,

式中

4 实验实现及结果分析

4.1 实验平台和数据集选取

选取Tensorflow[11-12]作为实验平台,因其在搭建深度学习模型方面具有独特优势。它可提供Python和C++编程接口,通过把节点分配给多个图像处理器(GPU)可便捷地实现并行计算,加快运算效率。

实验数据库选用华盛顿大学采集构建的RGB-D数据库[13],该数据库利用Kinect传感器同步拍摄物体的RGB和深度信息,是一个大规模、多层次、多视角的物体和场景数据库。数据集分为两大部分:300个家用物体构成的51个类别数据集以及8个办公室和厨房视频RGB-D场景数据集。本实验从8个视频RGB-D场景数据集中抽取部分数据作为训练样本。

4.2 评价指标

使用中心位置误差、准确率和成功率[14]对识别检测结果进行评价。中心位置误差

式中(

准确率

式中

成功率

式中

4.3 网络参数设置

选用均方误差函数作为网络的损失函数[15]:

式中

采用随机梯度下降法求取损失函数下降最大的方向。学习率设置为0.01,激活函数选用Sigmoid函数,其形式如下

式中

损失函数和测试中心位置误差随训练步数的变化情况如

图 10. 测试中心位置误差和训练损失函数随训练步数的变化曲线

Fig. 10. Change curves of center position error and training loss function with the training steps

由构建的卷积网络结构分别对RGB图像和深度图像进行训练,得到几类不同物体分别在RGB和深度图像下的检测精度,然后由(10)式计算出RGB和深度图像的融合权重,结果如

表 1. 不同检测物体的融合权重

Table 1. Fusion weight of different detection objects

|

4.4 实验结果分析

使用

图 11. 不同算法下的检测结果。(a)基于RGB图像的检测;(b)基于后期融合的RGB-D联合检测;(c)基于卷积层融合的RGB-D联合检测

Fig. 11. Detection results at different algorithms. (a) Detection based on RGB images; (b) joint detection of RGB-D based on late fusion; (c) joint detection of RGB-D based on convolution layer fusion

在

表 2. 不同方法的检测结果

Table 2. Detection results by different methods

|

由得到的检测结果可以看出,无论采用哪种融合方式,基于RGB-D图像的联合检测均可显著提高检测精度。RGB信息的全连接层融合比早期融合、后期融合具有更高的检测准确率和成功率,而且由于双流卷积网络之间的权值共享,检测时间比后期融合方式也有一定缩短。卷积层的融合方式充分考虑了RGB图像和深度图像的独立性和关联性,进一步提高了联合检测的效率,其识别准确率和成功率相比于之前最好的融合方法分别提高了4.1%和3.5%。

5 结论

针对RGB-D图像联合检测效率不高的问题提出了一种新的双流卷积神经网络结构。该网络结构有效地融合了RGB图像和深度图像的互补信息,提高了识别检测精度和成功率,为RGB-D图像的联合检测提供了一条新途径。

将RGB-D图像分别输入到两个结构相同、权值共享的卷积网络中进行特征学习训练,之后根据一定的权值在卷积层中进行融合,对融合后的特征进行二次卷积训练,有效地提升了RGB-D信息的融合利用程度。提出了一种最优融合权值算法,根据各类识别目标在单一模态信息下的识别准确率确定融合时所占的权重,确保得到最高效的融合结果。相比于已有的融合方法,所提RGB-D信息融合策略更好地挖掘了RGB图像和深度图像之间的内在联系,提高了互补信息的融合效率,其识别准确率和成功率分别提高了4.1%和3.5%。

[1] 崔波. 基于RGB-D信息的显著物体检测[D]. 天津: 天津大学, 2014: 17- 26.

CuiB. Significant object detection based on RGB-D information[D]. Tianjin: Tianjin University, 2014: 17- 26.

[2] GuptaS, GirshickR, ArbeláezP, et al. Learning rich features from RGB-D images for object detection and segmentation[C]. European Conference on Computer Vision, 2014, 8695: 345- 360.

[3] CouprieC, FarabetC, NajmanL, et al. Indoor semantic segmentation using depth information [J]. arXiv: 1301. 3572v2.

[4] GuptaS, ArbelaezP, MalikJ. Perceptual organization and recognition of indoor scenes from RGB-D images[C]. IEEE Computer Vision and Pattern Recognition, 2013: 564- 571.

[5] EitelA, Springenberg JT, SpinelloL, et al. Multimodal deep learning for robust RGB-D object recognition[C]. IEEE/RSJ International Conference on Intelligent Robots and Systems, 2015: 681- 687.

[6] 芮挺, 费建超, 周遊, 等. 基于深度卷积神经网络的行人检测[J]. 计算机工程与应用, 2016, 52(13): 163-168.

Rui T, Fei J C, Zhou Y, et al. Pedestrian detection based on deep convolutional neural network[J]. Computer Engineering and Application, 2016, 52(13): 163-168.

[7] 卢宏涛, 张秦川. 深度卷积神经网络在计算机视觉中的应用研究综述[J]. 数据采集与处理, 2016, 31(1): 1-17.

Lu H T, Zhang Q C. Overview of application of depth convolutional neural network in computer vision[J]. Data Acquisition and Processing, 2016, 31(1): 1-17.

[8] SongS, Xiao JX. Deep sliding shapes for amodal 3D object detection in RGB-D images[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2016: 808- 816.

[9] 涂淑琴, 薛月菊, 梁云, 等. RGB-D图像分类方法研究综述[J]. 激光与光电子学进展, 2016, 53(6): 060003.

[10] 卢良锋, 谢志军, 叶宏武. 基于RGB-D特征与深度特征融合的物体识别算法[J]. 计算机工程, 2015, 42(5): 187-192.

Lu L F, Xie Z J, Ye H W. Object recognition algorithm based on RGB-D feature and depth feature fusion[J]. Computer Engineering, 2015, 42(5): 187-192.

[11] 张俊, 李鑫. TensorFlow平台下的手写字符识别[J]. 电脑知识, 2016, 12(16): 199-201.

Zhang J, Li X. Handwritten character recognition based on TensorFlow platform[J]. Computer Knowledge, 2016, 12(16): 199-201.

[12] 张炜. 基于机器学习的智能家居系统设计与实现[D]. 吉林: 吉林大学, 2016: 25- 37.

ZhangW. Design and implementation of intelligent home system based on machinelearning[D]. Jilin: Jilin University, 2016: 25- 37.

[13] LaiK, BoL, RenX, et al. A large-scale hierarchical multi-view RGB-D object dataset[C]. IEEE International Conference on Robotics and Automation, 2011: 1817- 1824.

[14] 毛宁, 杨德东, 杨福才, 等. 基于分层卷积特征的自适应目标跟踪[J]. 激光与光电子学进展, 2016, 53(12): 121501.

[15] JiaY, ShelhamerE, DonahueJ, et al. Caffe: Convolutional architecture for fast feature embedding[C]. ACM International Conference on Multimedia, 2014: 675- 678.

[16] 蔡强, 魏立伟, 李海生, 等. 基于ANNet网络的 RGB-D 图像的目标检测[J]. 系统仿真学报, 2016, 28(9): 2260-2266.

Cai Q, Wei L W, Li H S, et al. Target detection of RGB-D images based on ANNet networks[J]. Journal of Systems Simulation, 2016, 28(9): 2260-2266.

Article Outline

刘帆, 刘鹏远, 张峻宁, 徐彬彬. 基于双流卷积神经网络的RGB-D图像联合检测[J]. 激光与光电子学进展, 2018, 55(2): 021503. fan Liu, Pengyuan Liu, Junning Zhang, Binbin Xu. Joint Detection of RGB-D Images Based on Double Flow Convolutional Neural Network[J]. Laser & Optoelectronics Progress, 2018, 55(2): 021503.