基于改进神经网络的交通标志识别  下载: 1106次

下载: 1106次

1 引言

交通标志是道路上的重要安全设施,在规范交通行为、保障道路安全、引导车辆和行人顺利通行等方面起到重要作用。作为智能化的一部分,交通标志的检测对高级辅助驾驶系统、交通标志维修和自动驾驶等应用具有重要意义。从80年代中期起,交通标志检测与识别的方法不断被拓展,在过去十年的时间里,该研究引起了各国学者的广泛重视,在理论研究和实际应用方面均取得了一定的成就[1-4]。

目前,深度学习理论被广泛应用于图像识别和目标检测领域,这使得目标检测更加快速准确。卷积神经网络(CNN)可以在不进行预处理的情况下从大量样本中学习特征,不仅避免了手工制作特征的设计难度,而且可以训练更多的特征。因此,基于深度学习的交通标志检测与分类方法具有检测速度快、识别精度高和成本低等优势,是机器视觉领域的重点研究方向。但是,自然道路下的交通标志识别算法依旧存在检测速率慢、漏检错检率高和识别精度低等问题。在现有的方法中,YOLOv2(You Only Look Once version2)算法的检测效果最好[1]。该模型能够通过单个神经网络在一次训练过程中进行预测和分类任务。然而 YOLOv2也有不足之处,例如,YOLOv2不擅长检测小目标。所以,本文将针对这个问题展开研究。

本文提出一种新的网络NYOLOv2 (New You Only Look Once version2),为了提高YOLOv2对小目标检测的性能,提出新的损失函数定义。使用边界框宽度和高度差的归一化策略取代直接使用目标宽度和高度的方法,目的是有效减小小交通标志检测的误差。在YOLOv2结构的第一层和第二层之间插入1个1×1×64的卷积层,以便获得平滑变化的提取特征。用初始模块替换掉YOLOv2的第三层和第四层,以进一步拓宽网络结构,减少参数数量。

为了评估交通标志检测的相关方法,采用现有的被广泛使用的公共数据集:德国交通标志检测基准(GTSDB)和德国交通标志识别基准(GTSRB)。GTSDB将交通标志分为三大类,包含指示标志(蓝色和圆形)、警告标志(红色和三角形)和禁止标志(红色和圆形)。在GTSDB中有900张大小为1360 pixel×800 pixel的图像(600个用于培训,300个用于测试)。GTSRB数据集包含39209张训练图像和12630张测试图像。这些标志同样被分为三类,其中包括德国交通标志的43个小类,大小从15 pixel×15 pixel到250 pixel×250 pixel。本文选用GTSDB进行训练,选用GTSRB进行测试,并与其他方法的结果进行比较。实验结果显示改进后的YOLOv2模型比原始模型以及其他解决方案具有更好的检测性能。

2 相关工作

交通标志检测方法大致可分为两大类。一类是基于传统的目标检测算法,该方法结合了交通标志的特征。另一类是基于深度学习的方法,具有自我学习不同特征的能力。传统的检测方法主要依赖于颜色和形状的特征提取算法。关于颜色特征,文献[ 5]中提出了基于Ohta空间的颜色概率模型,用于计算交通标志的每种颜色的概率。关于形状特征,交通标志通常是圆形、三角形、矩形或多边形。文献[ 6]中提出了一种新的椭圆检测方法,用于检测由外力或拍摄角度而变形的圆形交通标志。文献[ 7]为每个类别的交通标志设计了一组形状匹配模板。文献[ 8]采用了定向梯度直方图(HOG)特征和支持向量机分类器来检测交通标志并取得了很好的成绩。文献[ 9]结合了布尔卷积神经网络和HOG特征来检测GTSDB上的交通标志,证明特征提取算法在线性特征上比在非线性特征上更有效。然而,当出现如背光、标志破损和褪色等极端情况时,基于颜色特征提取的交通标志识别方法会出现不稳定的现象,导致漏检或错检。基于形状特征的交通标志识别方法可以用于处理图像中的遮挡问题,但是对于图像倾斜扭曲等问题不能得出高质量的识别效果。

基于深度学习的方法按照其区域提取策略的不同被分为两类。一类是基于区域选择的目标检测算法。基于区域的卷积神经网络(R-CNN)明显提高了平均检测精度[10]。R-CNN首先通过选择性搜索方法生成2

基于区域方法的交通标志识别方法在识别精度和定位精度方面具有优势。但是,其计算效率低,并且该过程需要大量计算资源。而YOLOv2算法相对简单,且检测效果好。YOLOv2算法只需要进行一轮预备和分类工作,并且每个图像只需要检测一次,因此,它能够以45 frame/s的速度运行检测,同时保证极高的准确性[19]。

3 本文方法

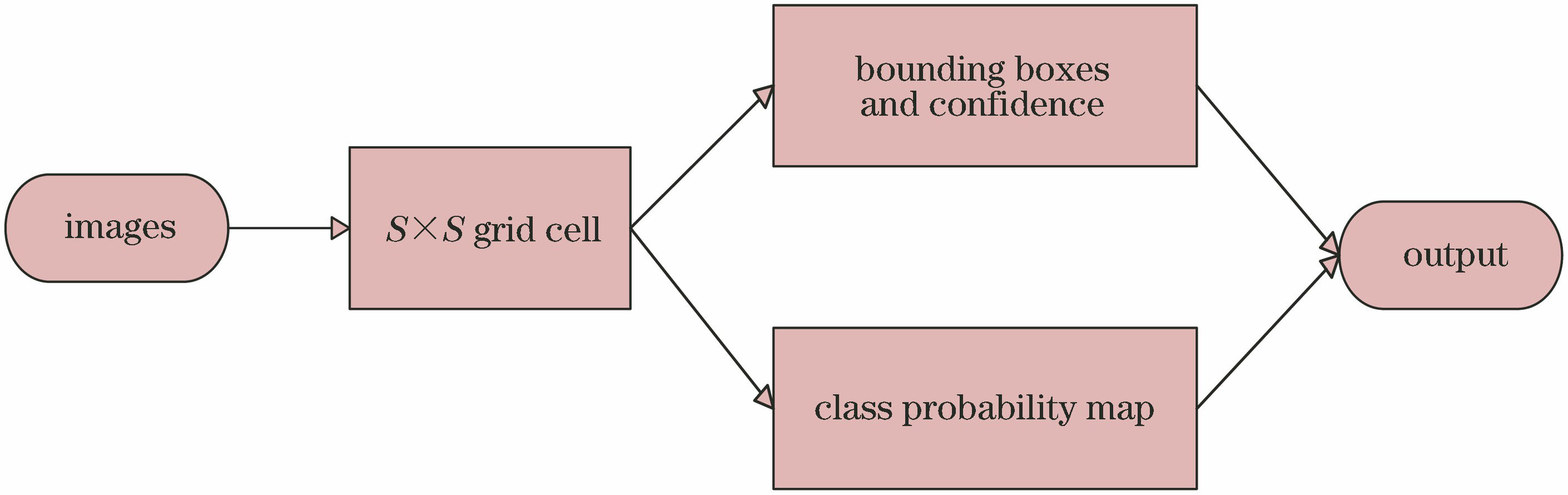

由于R-CNN系列算法均需要生成建议框,故在建议框上进行分类与回归,但建议框之间有重叠,这会带来很多重复工作。YOLOv2算法改进了R-CNN系列候选区域检测框架,把物体检测问题处理成回归问题,用一个卷积神经网络结构实现端到端的目标检测。

如

然而,YOLOv2算法存在以下两个不足点:1)在尺度上的泛化能力较差。由于网格单元是固定的正方形,当同一类物体出现新的、不常见的长宽比时,预测的框线对尺度的变化比较敏感[20]。 2)小尺寸目标难以识别。由于实际中大尺寸和小尺寸的损失值不同,YOLOv2的损失函数对小尺寸的检测和大尺寸的检测并未分开计算,小尺寸物体损失的一部分检测精度可能会导致检测失败。针对这两个不足点,本文提出两个改进措施:1)在YOLOv2结构中加入1个1×1×64卷积层,以便获得所提取特征的平滑变化。 并且加入两个初始模块,以进一步拓宽网络结构,减少参数数量,以此增加网络的泛化能力,使之能够进行多尺度图像训练。2)改进原网络的损失函数,使网络适用于小目标检测。

3.1 网络设计

初始模块是由GoogleNet首先引入的,研究人员发现其密集组件是逼近和覆盖卷积网络的关键,且他们注意到初始模块非常适用于目标定位和检测[13],所以,本文开发了两种初始模型,如

3.2 损失函数的优化

原始损失函数表示为

式中:

在原始损失函数中,YOLOv2算法利用平方差(

当对象的宽度与高度的比例很小时,边界框宽度的重要性很容易被低估。归一化是消除不同尺寸物体之间竞争的有效方法,而且在检测任务中发挥着积极作用。通过使用归一化,可以更有效地捕捉到边界框[15]。 改进后的损失函数定义为

4 仿真设置及结果分析

将不同的模型使用同一数据集[12]进行训练和测试,并使用YOLOv2软件包来训练本文的模型,数据集中标志的三个分类如

图 5. 交通标志的三个超分类示例。(a)指示;(b)禁止;(c)警告

Fig. 5. Three super classification examples of traffic signs. (a) Mandatory; (b) prohibitory; (c) danger

4.1 训练过程

使用YOLOv2模型及GTSDB数据集预训练本文的检测网络,预训练模型可以明显缩短训练时间。考虑到YOLO算法所需输入的大小固定,本文将不同尺度的图像调整为608 pixel×608 pixel的均匀尺寸。在损失函数中,GTSDB有三个标记类,所以

表 1. 不同时间阈值下的精确度和召回率数值

Table 1. Precisions and recall rate values at different time thresholds

|

4.2 构架分析

为了进一步了解初始模块的效用,对提出的方法进行计算能力的评估。除非另有说明,否则严格遵循先前的参数设置。本文方法在数据集上联合训练有初始模型和没有初始模型的YOLOv2模型(网络的其余部分是一致的),利用平均精度均值(mAP)和每秒帧数(FPS)进行定量和定性评估,这些指标被广泛应用于计算机视觉领域,以评估算法的优异程度。

表 2. 不同构架性能比较

Table 2. Comparison of different architecture performances

|

4.3 损失函数结果分析

本文的目标是找出改进后的损失函数和YOLOv2的损失函数产生的结果之间的差异。本文的方法训练了具有改进后的损失函数的模型和具有原始YOLOv2损失函数的模型(网络的其余部分一致)。然后使用相同的训练数据集来训练两个模型并对其进行测试。如

4.4 评估结果对比分析

为了分析测试结果,设置了识别时间阈值

表 3. 三种方法分类结果比较

Table 3. Comparison of classification results of three methods

| |||||||||||||||||||||||||||||||||||||||

图 9. 三个超分类的PR曲线图。(a) 指示;(b)禁止;(c)警告

Fig. 9. PR curves of three super categories. (a) Mandatory; (b) prohibitory; (c) danger

从

表 4. 不同方法的处理时间及性能对比

Table 4. Comparison of processing time and performance of different methods

|

表 5. 不同方法的AUC值和处理时间

Table 5. AUC values and processing time for different methods

|

5 结论

本文提出了YOLOv2的扩展网络模型,以提高交通标志检测的性能。为了更有效地检测小目标,改进了YOLOv2的原始损失函数,并使用了标准化的边界框宽度和高度。在网络体系结构,使用初始模块来替换YOLOv2中的某些卷积层,并在第一层和第二层之间添加1×1×64的卷积层。在测试数据集上测试了所提出的模型,仿真结果表明,该模型优于其他预测检测算法,包括R-CNN、Fast R-CNN和YOLOv2。但是,所提算法仍有一些改进空间,该算法可实现精确实时的交通标志检测与识别,但没有采用跟踪算法,合适有效的跟踪算法能够有效减少系统的运行时间。接下来计划引入跟踪算法进行识别。并且,该方法仅限于德国交通标志识别研究,而国内交通标志与欧洲交通标志的特征存在明显差异,今后计划针对国内交通标志进行研究。

[1] RedmonJ,[\s]{1}DivvalaS,[\s]{1}GirshickR,[\s]{1}et[\s]{1}al.[\s]{1}You[\s]{1}only[\s]{1}look[\s]{1}once:[\s]{1}unified,[\s]{1}real-time[\s]{1}object[\s]{1}detection[C]∥2016[\s]{1}IEEE[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition(CVPR),[\s]{1}June[\s]{1}27-30,[\s]{1}2016,[\s]{1}Las[\s]{1}Vegas.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2015:[\s]{1}779-[\s]{1}788.[\s]{1}

[2] 刘华平, 李建民, 胡晓林, 等. 动态场景下的交通标识检测与识别研究进展[J]. 中国图象图形学报, 2013, 18(5): 493-503.

Liu H P, Li J M, Hu X L, et al. Recent progress in detection and recognition of the traffic signs in dynamic scenes[J]. Journal of Image and Graphics, 2013, 18(5): 493-503.

[3] 高东东, 徐晓婷, 李博. 红外/白光混合补光系统在智能交通中的应用研究[J]. 红外与激光工程, 2018, 47(9): 0918006.

[4] 徐岩, 韦镇余. 一种改进的交通标志图像识别算法[J]. 激光与光电子学进展, 2017, 54(2): 021001.

[5] YangY,[\s]{1}Wu[\s]{1}FC.[\s]{1}Real-time[\s]{1}traffic[\s]{1}sign[\s]{1}detection[\s]{1}via[\s]{1}color[\s]{1}probability[\s]{1}model[\s]{1}and[\s]{1}integral[\s]{1}channel[\s]{1}features[M][\s]{1}∥Li[\s]{1}S,[\s]{1}Liu[\s]{1}C,[\s]{1}Wang[\s]{1}Y.[\s]{1}Pattern[\s]{1}recognition.[\s]{1}CCPR[\s]{1}2014.[\s]{1}Communications[\s]{1}in[\s]{1}computer[\s]{1}and[\s]{1}information[\s]{1}science.[\s]{1}Berlin,[\s]{1}Heidelberg:[\s]{1}Springer,[\s]{1}2014,[\s]{1}484:[\s]{1}545-[\s]{1}554.[\s]{1}

[6] Wang G Y, Ren G H, Wu Z L, et al. A fast and robust ellipse-detection method based on sorted merging[J]. The Scientific World Journal, 2014, 2014: 481312.

[7] LiangM,[\s]{1}Yuan[\s]{1}MY,[\s]{1}Hu[\s]{1}XL,[\s]{1}et[\s]{1}al.[\s]{1}Traffic[\s]{1}sign[\s]{1}detection[\s]{1}by[\s]{1}ROI[\s]{1}extraction[\s]{1}and[\s]{1}histogram[\s]{1}features-based[\s]{1}recognition[C]∥The[\s]{1}2013[\s]{1}International[\s]{1}Joint[\s]{1}Conference[\s]{1}on[\s]{1}Neural[\s]{1}Networks[\s]{1}(IJCNN),[\s]{1}August[\s]{1}4-9,[\s]{1}2013,[\s]{1}Dallas,[\s]{1}TX,[\s]{1}USA.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2013:[\s]{1}6706810.[\s]{1}

[8] Wang[\s]{1}GY,[\s]{1}Ren[\s]{1}GH,[\s]{1}Wu[\s]{1}ZL,[\s]{1}et[\s]{1}al.[\s]{1}A[\s]{1}hierarchical[\s]{1}method[\s]{1}for[\s]{1}traffic[\s]{1}sign[\s]{1}classification[\s]{1}with[\s]{1}support[\s]{1}vector[\s]{1}machines[C]∥The[\s]{1}2013[\s]{1}International[\s]{1}Joint[\s]{1}Conference[\s]{1}on[\s]{1}Neural[\s]{1}Networks[\s]{1}(IJCNN),[\s]{1}August[\s]{1}4-9,[\s]{1}2013,[\s]{1}Dallas,[\s]{1}TX,[\s]{1}USA.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2013:[\s]{1}6706803.[\s]{1}

[9] Xiao[\s]{1}ZT,[\s]{1}Yang[\s]{1}ZJ,[\s]{1}GengL,[\s]{1}et[\s]{1}al.[\s]{1}Traffic[\s]{1}sign[\s]{1}detection[\s]{1}based[\s]{1}on[\s]{1}histograms[\s]{1}of[\s]{1}oriented[\s]{1}gradients[\s]{1}and[\s]{1}boolean[\s]{1}convolutional[\s]{1}neural[\s]{1}networks[C]∥2017[\s]{1}International[\s]{1}Conference[\s]{1}on[\s]{1}Machine[\s]{1}Vision[\s]{1}and[\s]{1}Information[\s]{1}Technology[\s]{1}(CMVIT),[\s]{1}February[\s]{1}17-19,[\s]{1}2017,[\s]{1}Singapore.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2017:[\s]{1}111-[\s]{1}115.[\s]{1}

[10] GirshickR,[\s]{1}DonahueJ,[\s]{1}DarrellT,[\s]{1}et[\s]{1}al.[\s]{1}Rich[\s]{1}feature[\s]{1}hierarchies[\s]{1}for[\s]{1}accurate[\s]{1}object[\s]{1}detection[\s]{1}and[\s]{1}semantic[\s]{1}segmentation[C]∥2014[\s]{1}IEEE[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition,[\s]{1}June[\s]{1}23-28,[\s]{1}2014,[\s]{1}Columbus,[\s]{1}OH,[\s]{1}USA.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2014:[\s]{1}580-[\s]{1}587.[\s]{1}

[12] GirshickR.[\s]{1}Fast[\s]{1}R-CNN[C]∥2015[\s]{1}IEEE[\s]{1}International[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}(ICCV),[\s]{1}December[\s]{1}7-13,[\s]{1}2015,[\s]{1}Santiago,[\s]{1}Chile.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2015:[\s]{1}1440-[\s]{1}1448.[\s]{1}

[13] Ren S Q, He K M, Girshick R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[14] RedmonJ,[\s]{1}FarhadiA.[\s]{1}YOLO9000:[\s]{1}better,[\s]{1}faster,[\s]{1}stronger[C]∥2017[\s]{1}IEEE[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition[\s]{1}(CVPR),[\s]{1}July[\s]{1}21-26,[\s]{1}2017,[\s]{1}Honolulu,[\s]{1}HI,[\s]{1}USA.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2017:[\s]{1}17355115.[\s]{1}

[15] LiuW,[\s]{1}AnguelovD,[\s]{1}ErhanD,[\s]{1}et[\s]{1}al.[\s]{1}SSD:[\s]{1}single[\s]{1}shot[\s]{1}MultiBox[\s]{1}detector[M][\s]{1}∥Leibe[\s]{1}B,[\s]{1}Matas[\s]{1}J,[\s]{1}Sebe[\s]{1}N,[\s]{1}et[\s]{1}al.[\s]{1}Computer[\s]{1}vision-ECCV[\s]{1}2016.[\s]{1}Lecture[\s]{1}notes[\s]{1}in[\s]{1}computer[\s]{1}science.[\s]{1}Cham:[\s]{1}Springer,[\s]{1}2016,[\s]{1}9905:[\s]{1}21-[\s]{1}37.[\s]{1}

[16] Chang X J, Ma Z G, Yang Y, et al. Bi-level semantic representation analysis for multimedia event detection[J]. IEEE Transactions on Cybernetics, 2017, 47(5): 1180-1197.

[17] Chang X J, Yu Y L, Yang Y, et al. Semantic pooling for complex event analysis in untrimmed videos[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(8): 1617-1632.

[18] Chang X J, Yang Y. Semisupervised feature analysis by mining correlations among multiple tasks[J]. IEEE Transactions on Neural Networks and Learning Systems, 2017, 28(10): 2294-2305.

[19] Kuang P, Ma T S, Li F, et al. Real-time pedestrian detection using convolutional neural networks[J]. International Journal of Pattern Recognition and Artificial Intelligence, 2018, 32(11): 1856014.

[20] 谢一德.[\s]{1}基于深度卷积神经网络和图像传感器的道路多目标检测研究[D].[\s]{1}北京:[\s]{1}北京交通大学,[\s]{1}2018:[\s]{1}72-[\s]{1}85.[\s]{1}

Xie[\s]{1}YD.[\s]{1}Study[\s]{1}on[\s]{1}multi-target[\s]{1}detection[\s]{1}based[\s]{1}on[\s]{1}deep[\s]{1}convolution[\s]{1}neural[\s]{1}network[\s]{1}and[\s]{1}image[\s]{1}sensor[D].[\s]{1}Beijing:[\s]{1}Beijing[\s]{1}Jiaotong[\s]{1}University,[\s]{1}2018:[\s]{1}72-[\s]{1}85

[21] 张淑芳, 朱彤. 一种基于HDR技术的交通标志牌检测和识别方法[J]. 激光与光电子学进展, 2018, 55(9): 091006.

[22] 马永杰, 李雪燕, 宋晓凤. 基于改进深度卷积神经网络的交通标志识别[J]. 激光与光电子学进展, 2018, 55(12): 121009.

Article Outline

童英, 杨会成. 基于改进神经网络的交通标志识别[J]. 激光与光电子学进展, 2019, 56(19): 191002. Ying Tong, Huicheng Yang. Traffic Sign Recognition Based on Improved Neural Networks[J]. Laser & Optoelectronics Progress, 2019, 56(19): 191002.