对数域中基于实例学习的光照估计  下载: 995次

下载: 995次

1 引言

颜色恒常性是人类在任意光照下感知物体颜色的自适应能力[1]。在计算机视觉领域,颜色恒常性计算通常是对场景进行光照估计,并通过色适应将目标颜色校准到标准光照下,从而获得光照相关度较低的准确的颜色表达[2]。颜色恒常性计算和光照估计已被广泛应用于机器视觉和图像处理领域,如色彩合成[3]、图像增强[4]、图像校正[5]、目标识别与跟踪[6],以及特征匹配[7]等。

现有光照估计方法可以分为两种:基于统计的方法[8-12]和基于学习的方法[13-22]。前者主要是基于图像的统计属性或者物理属性估计场景光照,预先确定参数配置,无需训练,包括基于图像灰度的一系列方法,如Grey-World[8]、White-Patch[9]、Shades-of-Grey[10]、Grey-Edge[11]方法,以及针对目标表面反射特性进行建模的Zeta-Image方法[12]等。但该类方法均基于唯一确定的场景光照假设,适用范围小且在处理场景内容复杂的图像时误差较大。基于学习的方法是利用学习训练集图像建立模型,实现相似场景的光照估计。例如Gamut Mapping方法[13]假设给定光照下场景中的颜色数量,学习得到规范色域,以此估计光照。一些常见的机器学习方法也被引入,如贝叶斯推理[14]、支持向量回归[15]等,通过对图像像素的亮度和色度分布等关键特征建立模型,实现光照估计。近年来,随着深度学习技术的发展,卷积神经网络也被应用于光照估计。Lou等[16]在光照数据集上对AlexNet网络进行微调,得到光照估计模型。Deep-CC方法[17]构建了一个小型的卷积神经网络,分析了卷积核大小、层数,以及全连接层等网络结构与光照估计误差的关系,给出了最优参数选择。Oh等[18]等将光照估计这一回归问题转换为分类问题,并在AlexNet网络的基础上实现问题求解。Weighted Grey-Edge方法[19]和Multi-Cue方法[20-21]分析现有光照估计方法的适用场景或语义层次,训练模型灵活选取合适的单个或多个光照估计方法,综合其结果完成最终的光照估计。与基于统计的方法相比,基于学习的方法适用范围更广,且精度更高。但上述方法假设场景均为均匀光照,实际场景为非均匀光照,导致这些方法失效。

综上所述,目前光照估计算法主要存在两个问题:1)对于均匀光照场景,模型过于复杂,算法适用范围有限。根据Lambertian反射理论,图像中每个像素的颜色均可对应无数种光照和物体表面反射的组合,因此获得一种普适性的光照估计函数是极其困难的。2)难以处理非均匀光照和多光照场景。

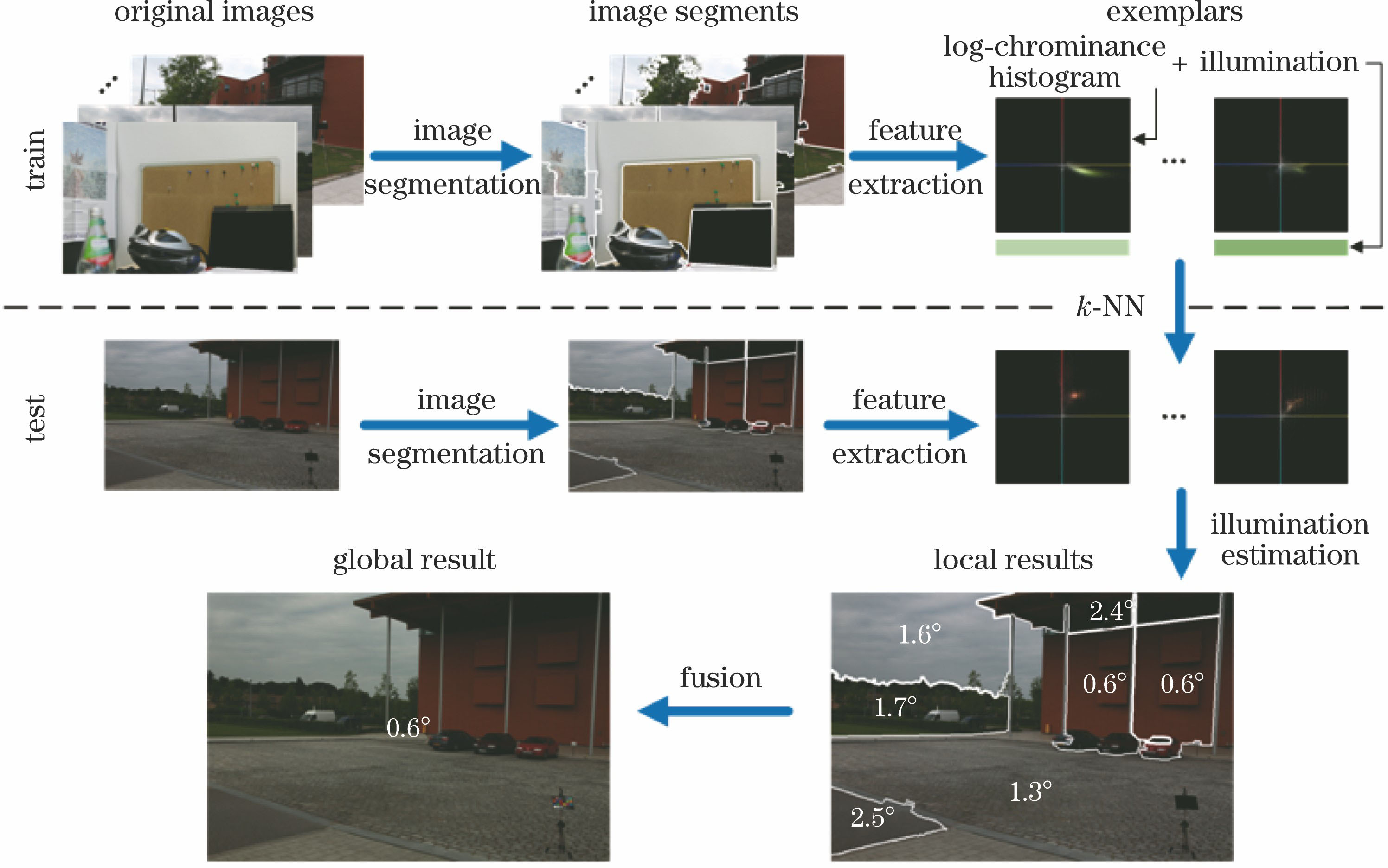

Exemplar-Based方法[22]采用图像分割技术处理复杂和多光照场景,同时借鉴实例学习思想[23],采用纹理和颜色直方图作为实例特征,分别估计各分割表面的光照,有效提高了光照估计精度和算法适用范围。在此基础上,本文提出了一种在对数域中基于实例学习的光照估计方法。该方法在对数域中提取色度直方图作为光照一致性特征(相似特征的场景光照也相似),与纹理和颜色直方图特征相比,具有更高的光照相关性和更低的训练集相关性,同时受图像分割结果的影响较小,提高了算法精度和稳健性。此外,Exemplar-Based方法[22]需要引入White-Patch方法[9]对原始图像进行初步的光照校正处理,本文方法的特征直接反映光照色度,无需进行校正,降低了算法复杂度。该方法是在对数域中提取色度直方图作为实例特征,基于

2 本文的光照估计方法

本文方法首先将原始图像映射到LUV色彩空间(CIELUV),利用均值漂移方法[24]分割图像,获取光照相对均匀的分割区域表面,并计算对数色度直方图作为区域表面特征。由此可以根据已知光照的训练集计算得到实例集。光照估计首先采用

2.1 对数色度直方图计算

光照估计可以定义为如下问题:对于一幅图像

根据

可以得到:

因此图像的二维对数色度直方图[26]可定义为

式中

对

两个场景在3组不同光照下的对数色度直方图如

图 2. 两个场景在三组不同光照下的图像和对数色度直方图。场景1在(a)白光光照,(b)蓝光光照,(c)绿光光照下的图像和对数色度直方图;场景2在(d)白光光照,(e)蓝光光照,(f)绿光光照下的图像和对数色度直方图

Fig. 2. Images and log-chrominance histograms of two scenes with three different illuminations. Scene 1 images and log-chrominance histograms under (a) white light, (b) blue light, (c) green light; scene 2 images and log-chrominance histograms under (d) white light, (e) blue light, (f) green light

表 1. 图2中对数色度直方图χ2距离

Table 1. χ2 distance of log-chrominance histograms in Fig. 2

|

影响较小,作为特征应用可以有效区分不同光照的场景。由(5)式可知,对数色度直方图作为一种图像的统计量,具有较强的光照色度相关性和较低的光照强度相关性,因此可以作为一种有效的光照一致性特征,对数色度直方图越相似的场景,其光照也越相似。

2.2 基于实例学习的光照估计

实例学习框架基于

已知光照实例集基于训练集图像分割得到,待测实例由待测图像分割得到,分别计算各分割表面的对数色度直方图作为实例特征。针对待测图像每个分割表面,依据最近邻方法从已知光照实例集中选取与其特征相似度最高的

测试图像分割表面

式中

式中

对于单光照场景的图像,本文以其所有分割表面光照估计值的中值作为整幅图像的光照估计值,其光照估计流程如

在多光照场景下,获得各分割表面的光照估计后,需要结合整个图像的光照数量等先验信息进行数据融合,完成最终的光照估计。对于光照数量为

式中

3 实验结果及分析

为了验证本文方法的有效性,分别在3组单光照数据集和一组多光照数据集上进行实验,给出光照估计误差和色彩校正结果,并与主流光照估计算法进行对比。

3.1 数据集

ColorChecker数据集[14,27]由568幅图像组成,包含室内和室外场景,由Canon 1D和Canon 5D拍摄,采用自动白平衡设置,特点是图像分辨率较高。该数据集的光照真实值由设置在各场景中的Macbeth ColorChecker计算得到(在实际使用时须将该部分遮住)。本文还选用了Shi等[27]重处理后的ColorChecker数据集,是Shi等[27]在ColorChecker数据集RAW图像的基础上进行线性化处理,所得到的另一组数据集和对应的光照真实值。

SFU Grey-ball数据集[28]是由视频序列帧组成,共11346幅图像,包含室内和室外场景,其特点在于场景和光照的变化较大,且图像分辨率较低,为360 pixel×240 pixel。该数据集的光照真实值是根据场景中设置的一个灰度球计算得到。

多光照数据集[29]包括实验室图像和室外图像,仅室外图像为多光照场景,本文选用室外图像集。室外图像均包含两个光照区别较大的场景,其光照真实值根据场景中分别在不同位置设置的多个灰度球计算得到。

3.2 评价指标

本文计算光照估计误差的均值、中位数、三均值和最大值。均值衡量算法的总体性能,中位数和三均值则旨在消除离散值的影响,最大值用于度量算法的最差性能,其值越小说明稳健性较好。

对于单一光照问题,图像的光照估计值

多光照图像中每个像素点都有独立的光照估计值,通常以所有像素点角度误差的均值作为图像的光照估计误差,即:

式中图像分辨率为

3.3 与其他方法对比

本文用于对比的算法包括基于统计的方法如Grey-World[8]、White-Patch[9]、Shades-of-Grey[10]、Grey-Edge[11]和Zeta-Image[12]方法,以及基于学习的方法如Gamut Mapping[13]、Bayesian[14]、Weighted Grey-Edge[19]、Multi-Cue[21]、Deep-CC[17]和Exemplar-Based[22]方法。

3.3.1 ColorChecker数据集

本文方法与几种主流光照估计方法的对比及在原始Color Checker数据集[14]和经重处理后的数据集[27]上的角度误差分别如

表 2. 不同光照估计方法在原始ColorChecker数据集上的角度误差对比

Table 2. Angular errors for original ColorChecker dataset for different illumination estimation algorithms(°)

|

表 3. 不同光照估计方法在重处理的ColorChecker数据集上的角度误差对比

Table 3. Angular errors for re-processing of ColorChecker dataset for different illumination estimation algorithms(°)

|

实验结果表明,本文方法实例匹配的准确性更高,结果优于采用纹理和颜色特征的Exemplar-Based方法[22],在所有方法中精度最高。基于统计的方法均采用唯一确定的场景光照假设,精度最差。基于学习的方法以相似的场景光照估计未知场景,能够处理复杂场景问题,精度普遍优于基于统计的方法,其中Deep-CC方法[17]的精度仅次于本文方法。所有方法在线性化图像集上的误差均有大幅降低,是因为该线性化图像集直接对应相机传感器输出,没有改变图像的色彩和亮度,能够获得更准确的光照估计。

3.3.2 SFU Grey-ball数据集

本文方法在SFU Grey-ball数据集[28]上与几种主流光照估计方法的角度误差对比结果如

表 4. 不同光照估计方法在SFU Grey-ball数据集上的角度误差对比

Table 4. Angular errors for SFU Grey-ball dataset for different illumination estimation algorithms(°)

|

3.3.3 多光照数据集

在多光照数据集[29]上,本文方法与几种光照估计方法的角度误差中位数对比结果如

表 5. 不同光照估计方法在多光照数据集上的角度误差中位数对比

Table 5. Median angular errors for multiple light sources dataset for different illumination estimation algorithms(°)

| |||||||||||||||||||||||||||||||

误差的均值作为图像的光照估计误差。实验结果表明,无论是否指定光照数量,本文方法均优于其他方法。其中Exemplar-Based方法[22]使用纹理和颜色特征受图像分割结果影响显著,在指定光照数量不同时误差波动较大,本文采用对数色度直方图作为实例特征,与图像纹理和内容相关性小而与光照色度相关性高,对图像分割的适应性更好,误差较小且稳定,能够更有效地处理多光照场景。本文方法设置光照数分别为1、2和不确定时,在多光照数据集上的部分光照估计结果如

图 4. 多光照图像的光照估计。(a)原始图像;(b)光照真实值;(c)单光照假设的估计结果;(d)双光照假设的估计结果;(e)多光照假设的估计结果

Fig. 4. Illumination estimation of multi-illuminant images. (a) Original images; (b) ground-truth values; (c) single illuminant estimation results; (d) double illuminant estimation results; (e) multi-illuminant estimation results

3.4 算法分析

本文算法将图像分割为多个不同区域,并对每个局部区域进行光照估计,进而估计全局光照。为了验证其有效性,去除图像分割并保持其余模块不变,直接对整幅图像进行全局光照估计,二者的光照估计误差和时间性能对比如

表 6. 本文方法在无分割和有分割设置下的角度误差对比

Table 6. Angular errors for the proposed method with and without segmentation(°)

| |||||||||||||||||||||||||||||||||||||||||||||||||

表 7. 本文方法在无分割和有分割设置下的平均消耗时间对比

Table 7. Average consuming time for the proposed method with and without segmentations

| |||||||||||||||||||

实验结果表明,完整算法引入分割并对每个局部区域进行处理能够显著减少最终的光照估计误差,但也增加了计算时间,考虑到平均每幅图像包含超过10个分割块(SFU Grey-ball数据集[28]为超过5个分割块),所提完整算法中局部区域光照估计可以并行处理(

3.5 颜色校准

根据图像的光照估计值,利用对角模型[30]对其进行颜色校准。本文方法与其他方法的对比及在SFU Grey-ball数据集[28]上的部分颜色校准结果及角度误差如

图 5. 不同光照估计方法在SFU Grey-ball数据集上的颜色校准结果。(a)原始图像;(b) Grey-World方法;(c) White-Patch方法;(d) Shades-of-Grey方法;(e) Grey-Edge方法;(f) Gamut Mapping方法;(g) Exemplar-Based方法;(h)本文方法

Fig. 5. Color correction results using different illumination estimation algorithms on SFU Grey-ball dataset. (a) Original images (b) Grey-World; (c) White-Patch; (d) Shades-of-Grey; (e) Grey-Edge; (f) Gamut Mapping; (g) Exemplar-Based; (h) proposed method

4 结论

针对目前复杂场景和多光照场景中的光照估计问题,提出了一种对数域中基于实例学习的光照估计方法。基于实例学习框架设计算法,选取特征相似的已知实例估计未知场景光照,能够有效处理光照差异极大的场景。在对数域中提取色度直方图作为光照一致性特征,具有较强的光照色度相关性和较低的光照强度相关性,能够增强实例匹配的准确性,提高光照估计精度。将图像分割为若干内容相近的表面,并以每个分割表面为实例,一方面扩大了实例的数量,满足了实例集的多样性,另一方面降低了图像光照不均匀对光照估计结果的影响,并实现对多光照场景进行光照估计。实验结果表明,相较于其他文献中的方法,本文方法在不同数据集上的光照估计误差中位数降低了5%~14%,在复杂场景的光照估计上,本文方法的精度更高,稳健性更优。在多光照场景的估计上,本文方法有效降低了图像分割结果对最终光照估计结果的影响,精度高且适应性好。但本文方法对光照的估计仅考虑了低层像素信息,下一步的工作将引入高层语义知识,提高由局部到全局光照融合的准确性,从而进一步提高光照估计精度和稳健性。

[1] Krantz JH. Experiencing sensation and perception[M]. New York: Pearson Education, 2012.

Krantz JH. Experiencing sensation and perception[M]. New York: Pearson Education, 2012.

[2] Qian YL, ChenK, Kamarainen JK,et al. Deep structured-output regression learning for computational color constancy[EB/OL]. [2017-06-21]. http: ∥arxiv.org/abs/1607.03856v1.2016. 9.

Qian YL, ChenK, Kamarainen JK,et al. Deep structured-output regression learning for computational color constancy[EB/OL]. [2017-06-21]. http: ∥arxiv.org/abs/1607.03856v1.2016. 9.

[3] 项金蓉, 任建伟, 刘洪兴, 等. 基于光谱可调积分球光源的多光谱相机颜色校正研究[J]. 激光与光电子学进展, 2015, 52(1): 013301.

项金蓉, 任建伟, 刘洪兴, 等. 基于光谱可调积分球光源的多光谱相机颜色校正研究[J]. 激光与光电子学进展, 2015, 52(1): 013301.

[4] Liu QS, BaiJ, Yu FH. An adaptive weight value-based multi-scale Retinex algorithm for color image enhancement[C]. 5th International Conference on Computer Sciences and Automation Engineering, 2015: 609- 612.

Liu QS, BaiJ, Yu FH. An adaptive weight value-based multi-scale Retinex algorithm for color image enhancement[C]. 5th International Conference on Computer Sciences and Automation Engineering, 2015: 609- 612.

[5] 张林, 冯华君, 徐之海, 等. 基于物体颜色信息的图像紫边矫正方法[J]. 光学学报, 2016, 36(12): 1233001.

张林, 冯华君, 徐之海, 等. 基于物体颜色信息的图像紫边矫正方法[J]. 光学学报, 2016, 36(12): 1233001.

[6] 李双双, 赵高鹏, 王建宇. 基于特征融合和尺度自适应的干扰感知目标跟踪[J]. 光学学报, 2017, 37(5): 0515005.

李双双, 赵高鹏, 王建宇. 基于特征融合和尺度自适应的干扰感知目标跟踪[J]. 光学学报, 2017, 37(5): 0515005.

[7] Mirzaei H, Funt B. Gaussian-based hue descriptors[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(12): 2441-2450.

Mirzaei H, Funt B. Gaussian-based hue descriptors[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(12): 2441-2450.

[9] Land E H. The Retinex theory of color vision[J]. Scientific America, 1977, 237(6): 108-128.

Land E H. The Retinex theory of color vision[J]. Scientific America, 1977, 237(6): 108-128.

[10] Finlayson GD, TrezziE. Shades of gray and colour constancy[C]. Color and Imaging Conference, 2004: 37- 41.

Finlayson GD, TrezziE. Shades of gray and colour constancy[C]. Color and Imaging Conference, 2004: 37- 41.

[11] van de Weijer J, Gevers T, Gijsenij A. Edge-based color constancy[J]. IEEE Transactions on Image Processing, 2007, 16(9): 2207-2214.

van de Weijer J, Gevers T, Gijsenij A. Edge-based color constancy[J]. IEEE Transactions on Image Processing, 2007, 16(9): 2207-2214.

[12] Drew MS, Joze H R V, Finlayson G D. Specularity, the Zeta-Image, and information-theoretic illuminant estimation[C]. International Conference on Computer Vision, 2012: 411- 420.

Drew MS, Joze H R V, Finlayson G D. Specularity, the Zeta-Image, and information-theoretic illuminant estimation[C]. International Conference on Computer Vision, 2012: 411- 420.

[13] Gijsenij A. Gevers T, van de Weijer J. Generalized Gamut Mapping using image derivative structures for color constancy[J]. International Journal of Computer Vision, 2010, 86(2/3): 127-139.

Gijsenij A. Gevers T, van de Weijer J. Generalized Gamut Mapping using image derivative structures for color constancy[J]. International Journal of Computer Vision, 2010, 86(2/3): 127-139.

[14] Gehler PV, RotherC, BlakeA, et al. Bayesian color constancy revisited[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2008: 1- 8.

Gehler PV, RotherC, BlakeA, et al. Bayesian color constancy revisited[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2008: 1- 8.

[15] Funt B V, Xiong W H. Estimating illumination chromaticity via support vector regression[J]. Journal of Imaging Science and Technology, 2006, 50(4): 341-348.

Funt B V, Xiong W H. Estimating illumination chromaticity via support vector regression[J]. Journal of Imaging Science and Technology, 2006, 50(4): 341-348.

[16] Lou ZY, GeversT, Hu NH, et al. Color constancy by deep learning[C]. British Machine Vision Conference, 2015: 76.

Lou ZY, GeversT, Hu NH, et al. Color constancy by deep learning[C]. British Machine Vision Conference, 2015: 76.

[17] BiancoS, CusanoC, SchettiniR. Color constancy using CNNs[C]. IEEE Conference on Computer Vision and Pattern Recognition Workshops, 2015: 81- 89.

BiancoS, CusanoC, SchettiniR. Color constancy using CNNs[C]. IEEE Conference on Computer Vision and Pattern Recognition Workshops, 2015: 81- 89.

[23] Mitchell TM. Machine Learning[M]. New York: McGraw-Hill Education, 1997: 231- 233.

Mitchell TM. Machine Learning[M]. New York: McGraw-Hill Education, 1997: 231- 233.

[24] Comaniciu D, Meer P. Mean shift: a robust approach toward feature space analysis[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2002, 24(5): 603-619.

Comaniciu D, Meer P. Mean shift: a robust approach toward feature space analysis[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2002, 24(5): 603-619.

[25] Von Kries J. Die Gesichtsempfindungen.Handbuch der physiologie des menschen[M]. Behring: Nabu Press, 2012.

Von Kries J. Die Gesichtsempfindungen.Handbuch der physiologie des menschen[M]. Behring: Nabu Press, 2012.

[26] Barron JT. Convolutional color constancy[C]. IEEE International Conference on Computer Vision, 2015: 379- 387.

Barron JT. Convolutional color constancy[C]. IEEE International Conference on Computer Vision, 2015: 379- 387.

[27] ShiL, FuntB. Re-processed version of the Gehler color constancy dataset of 568 images[EB/OL]. [2017-06-21].http: ∥www.cs.sfu.ca/~colour/data.

ShiL, FuntB. Re-processed version of the Gehler color constancy dataset of 568 images[EB/OL]. [2017-06-21].http: ∥www.cs.sfu.ca/~colour/data.

[28] CiureaF, FuntB. A large image database for color constancy research[C]. Color and Imaging Conference, 2003: 160- 164.

CiureaF, FuntB. A large image database for color constancy research[C]. Color and Imaging Conference, 2003: 160- 164.

Article Outline

崔帅, 张骏, 高隽. 对数域中基于实例学习的光照估计[J]. 光学学报, 2018, 38(2): 0233001. Shuai Cui, Jun Zhang, Jun Gao. Illumination Estimation Based on Exemplar Learning in Logarithm Domain[J]. Acta Optica Sinica, 2018, 38(2): 0233001.