基于卷积神经网络判定方法的激光微透镜阵列微米级加工工艺

1 引 言

Mini/Micro-LED作为以阵列方式排布的可穿戴、超大尺寸显示器与AR/VR设备的重要基础部件[1],具有极大的商业价值。Mini/Micro-LED的加工工艺流程中,曝光是其中最重要的工艺,很大程度上决定了Mini/Micro-LED的效率与性能[2]。常用的投影式光刻工艺中由于其需要掩模版来辅助加工,就导致其定位困难并且加工成本增加,而无掩模曝光现在凭借其成本低与灵活性高具有远大的发展前景[3]。微透镜阵列(Microlens Array,MLA)曝光是一种高效无掩膜曝光工艺,MLA能够将一束激光分裂成数千束激光,在成本低与灵活性高的前提下具有很高的加工效率[4]。在MLA曝光中,由于入射激光光斑呈高斯分布,再加上台面的轻微倾斜还有光刻胶厚度不均匀,众多曝光点的加工状态会产生差异。其中,能显影出图案并且线宽在指定范围内的曝光点,可作为合格点;不能显影出图案的曝光点,即为欠曝点;曝光线宽大于指定范围的曝光点,即为过曝点。合格点数量占总数量的比重就直接决定MLA曝光工艺成品率的上限,因此提高合格点的占比,即MLA曝光加工良率,对于制造阵列化微结构特征的功能器件具有重要的工程意义。

MLA曝光加工中,曝光点的数量通常不少于数千个,在这样的数量级下,通过高倍率显微镜进行人工目检来判定曝光点的类型是非常耗时耗力的。虽然针对各种应用场景的目标检测模型不胜枚举,且很多目标检测模型具有较好的性能,可以作为阵列式微结构良率检测的基础。目前,MLA曝光工艺依然采用人工检测的方法来判别良率,其人工成本与时间成本较高。为提高MLA曝光工艺的自动化水平、减轻MLA曝光工艺中人类的操作强度,本文将目标检测模型引入MLA曝光工艺中。机器学习中,基于卷积神经网络(Convolutional Neural Network,CNN)[5-6]的目标检测模型[7]快速发展,并在光刻等众多领域得到了广泛的应用,已经可以代替人类完成一些机械性的判定工作[8-12]。在光刻领域中,基于CNN的目标检测模型可以用来辅助平台对焦[13],还可以用来检测光刻热点的位置[14-15],但是却未用于MLA曝光加工图案的检测。为了实现对曝光点类型的高效识别和判定,本文设计了一种用于曝光点类型判定的图案,利用CNN中的目标检测算法模型,根据显影出图案的特征,将曝光点分为欠曝点、过曝点与合格点3种。在MLA曝光中,影响曝光质量的因素有许多种,如基底表面状态、旋涂与曝光时光刻胶表面的气流、光刻胶的种类以及厚度与激光的种类以及曝光量等。其中,基底表面状态与旋涂、曝光时光刻胶表面的气流、光刻胶与激光的种类主要受实验材料与环境的影响,不是本研究主要优化的目标因素。这里主要研究光刻胶厚度以及光刻胶曝光量对于MLA曝光加工良率的影响,为适应不同的后续工艺,探究不同光刻胶厚度下,MLA曝光合格率与激光功率、平台移动速度等因素之间的关系。

2 检测原理

2.1 MLA曝光设备与主要材料参数

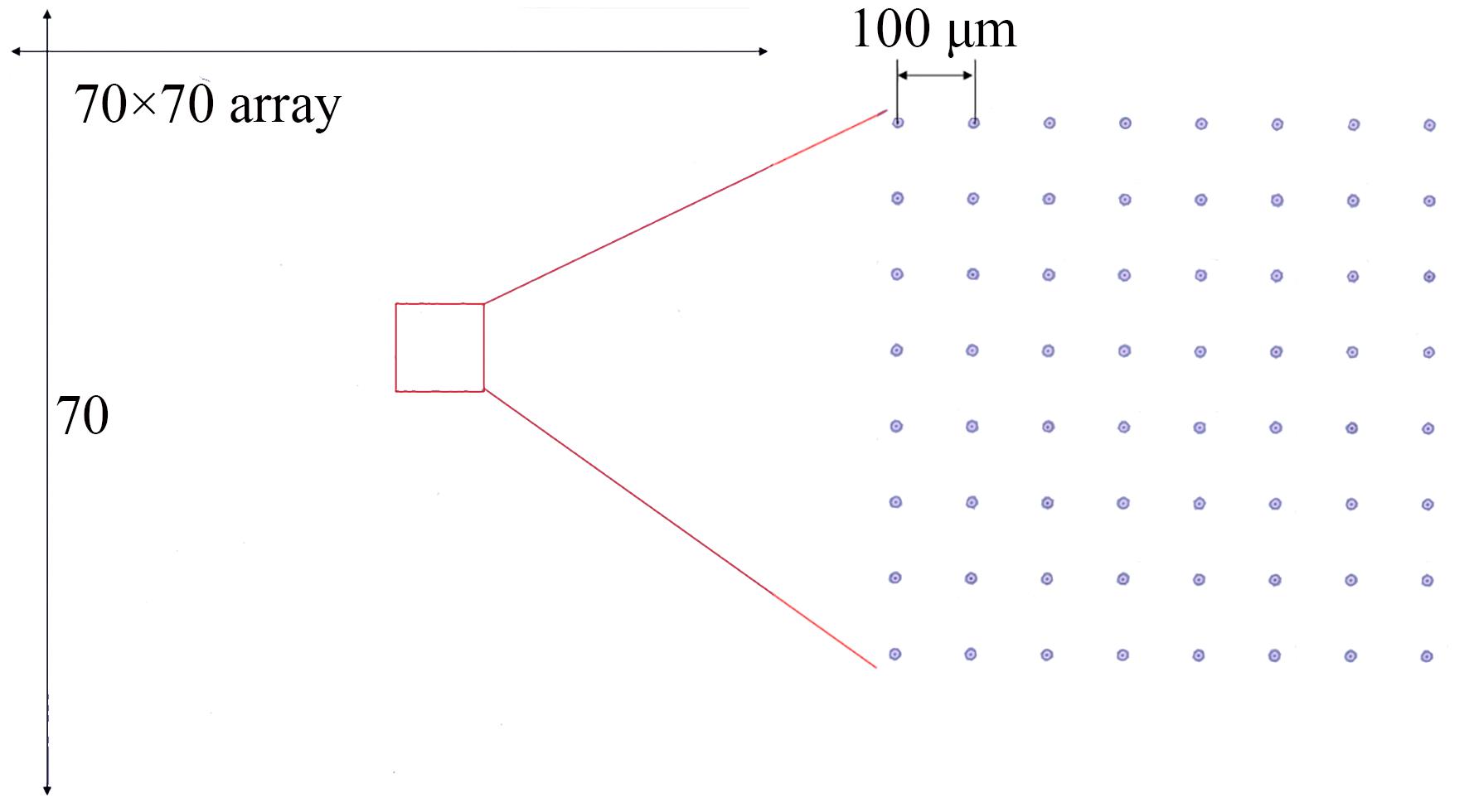

实验设备与材料主要如下:光源采用高稳定性蓝紫光激光器(型号为MDL-III-405),其最大功率为500 mW,能够提供中心波长为(405±5)nm的高斯光束。XY轴运动平台负责驱动激光按照设定路线移动,在光刻胶绘制相应的曝光图案,其行程为400 mm×150 mm,重复定位精度小于±300 nm,定位精度小于±1 μm,最大负载为5 kg,最大速度为300 mm/s。光刻胶(AZ Electronic Materials,型号为AZ 5214E)对激光的吸收率约为0.018。高倍率显微镜拍摄的单次微透镜阵列曝光结果如图1所示,含有70×70共4 900个曝光点,相邻两个曝光点的距离为100 μm。在这样的数量级下,通过高倍率显微镜进行人工目检来判定曝光点的类型量是非常耗时耗力的。

2.2 曝光点判定标准

这里定义能显影出图案并且线宽在指定范围内的曝光点为合格点。识别图案是否欠曝比较容易,欠曝图案的主要特征在于图案的曝光部分在显影后的整体或局部有残留的光刻胶,其特征在图像中的表现为图案曝光部分的透明度低,存在明显的杂质,目标检测模型对此特征的识别有着较强的能力。然而,过曝图案的识别比较困难,本实验中设定合格点的线宽为6~8 μm,过曝点的线宽在8 μm以上,合格点和过曝点在线宽上的区分不显著,曝光图案尺寸又偏小,所以对于目标检测模型来讲,想要直接精准辨别过曝点的难度极高。为了更好地区分合格点与过曝点,需要建立两者的显著特征,本文设计了一种圆环形曝光图案,即激光曝光光斑按照设定半径R走过一周曝光出的图案,R为合格线宽阈值的一半。当前点为合格点时,线宽一半会小于圆环半径R,曝光图案中心存在未曝光的部分,如图2(a)所示;当前图案为过曝点时,线宽的一半会大于圆环半径R,曝光图案中心不存在未被曝光部分,如图2(b)所示。这种图案便于计算机通过目标检测模型判别曝光点的类型。合格线宽的阈值设置要根据最终加工目标与自身设备的实际情况来选择,根据当前实验设备的性能,曝光合格线宽阈值为8 μm,因此R设定为4 μm。

2.3 目标检测基础模型

目标检测模型主要分为两步法与一步法两种,两步法以SPPNet[16]与Faster RCNN[17-19]系列算法为代表,一步法以SSD[20]与YOLO[21-23]系列算法为代表。其中,YOLO系列算法以其快速、准确的优势,在目标检测领域处于领先地位。因此,这里选择YOLOv5为基本模型,其网络架构如图3所示。

YOLOv5模型主要由以下4个部分组成:输入端(Input),负责输入图像;主干网络(Backbone),负责提取网络中的特征,既提取图像中的信息;连接网络(Neck),负责连接输出端与bone,整合主干网络提取得到的特征,使得输出端能够更好地利用特征;输出端(Output),负责输出内容,利用提取整合出来的特征进行预测。

Backbone中采用归一化模块(Conventional Batch Normalization SiLU,CBS),其结构如图4(a)所示。其中,归一化层(Batch Normalization,BN)[24]能够将获取到的数据统一到设定的区间,加快训练速度,避免梯度消失与梯度爆炸。此外,采用Cross Stage Partial(CSP1)模块,借鉴CSPNet[25]网络结构,将图像数据经过归一化所得到的特征分割成两部分:一部分通过归一化层与残差块[26],另一部分仅通过归一化层后合并,在保证准确率的前提下可以减少计算量。在连接网络部分中也采用同类型模块CSP2,其结构与CSP1相似,如图4(b)所示,区别在于CSP2中没有残差块,取而代之的是归一化模块,这样可以加强网络特征的融合能力。

2.4 微透镜阵列曝光加工良率的卷积神经网络判定

为了实现MLA曝光加工良率的判定,需要制作CNN训练所需的数据集。数据集要包括所有曝光图案,制作时要尽可能地扩大参数的选择范围,该范围主要参照所使用激光器的参数。实验中激光功率为80~290 mW,间隔30 mW进行采样,速度为5~65 μm/s,间隔10 μm/s进行采样,采用上述参数使用微透镜阵列绘制半径为8 μm的圆环,共得到56张曝光图像,图像尺寸极大约为18 000×18 000个像素点。而YOLOv5模型的输入图像尺寸为640×640个像素点,因此,为了避免图像被压缩,需要将拍摄图像拆分为30×30份,每张图像中包含4~9个曝光点。56×900张图像中人工抽取150张包含所有类型的图像制作成数据集,手动进行标注,并导出标签。将数据集以7∶3的比例拆分训练集与测试集,训练集105张图像,测试集45张图像。搭载NVIDIA GTX 1650的显卡和Intel i5-10200H的CPU的电脑作为硬件平台,选用pytorch作为深度学习框架,对目标检测模型进行训练。

将剩余曝光图输入模型中进行测试,并将30×30个测试结果进行统合,得到每个曝光参数所对应曝光图像中合格点、过曝点以及欠曝点的数量。最后,通过计算得出不同曝光参数下的加工良率。通过上述方法仅需要在测试阶段使用人工目检的方法标注150张图像,对模型进行训练与测试,其余图像都可以通过模型得到各个类型曝光点的数量。人工通过显微镜观察检测一次曝光下的曝光质量大约需要5~10 min,但是通过CNN判定方法仅耗时10 s左右,可以大幅减少人的工作量以及检测时间。

3 结果与讨论

3.1 模型优化方案与识别结果

YOLOv5作为目标检测任务的基础模型。由于合格点检测中待检测点的尺寸很小,并且由于拍摄图像尺寸过大,样品表面轻微的不平整即会造成部分图像发生离焦,局部成像模糊,并且图像上除了曝光图案以外还存在杂质,这会导致检测模型误判,从而影响YOLOv5基础检测模型的识别精度。因此,这里对YOLOv5模型进行局部优化。针对待检测目标尺过小的问题,将YOLOv5模型中的CSP2模块替换为Transformer encoder模块[27],其结构如图5(a)所示。与CSP模块相比,Transformer encoder模块能够获得更加丰富的图像信息,虽然增加了一定的计算量,但是整体的识别精度有显著的提升。针对图像模糊且包含杂质的问题,引入了卷积模块注意力机制(Convolutional Block Attention Module,CBAM)模块[28],在每个卷积层后都添加CBAM模块,其结构如图5(b)所示。这是一个结合了空间与通道的注意力机制模块,不仅结构简单,还能帮助模型排除杂质的干扰,提高识别效果。

显影后若曝光部位仍有残留光刻胶则判定为非合格点,即欠曝点,如图6(a)所示。显影后图案为实心圆,则说明当前曝光点线宽大于设定阈值,判定为非合格点,即过曝点,如图6(b)所示。显影后图案为同心圆环,则判定为合格点,如图6(c)所示。

在识别过程中,模型会对每一个待检测点输出3种曝光图案种类的置信度,其值在0~1之间,作为判定各类型点的概率。模型将各点曝光类型的置信度进行比较,若其最大值大于所设定的置信度值,则判定为置信度最大值所对应的类型,其值越接近1,判定越准确。若设定置信度值偏小,模型会将一些置信度比较低的杂质点判定为曝光点,使精确率下降;若设定置信度偏大,则有些曝光点会被排除,使召回率下降。在测试集上进行测试,置信度为0.45,0.65,0.85时的识别结果如表1所示。当置信度取0.65时,识别效果最佳。相比改进前,YOLOv5算法模型的召回率与精确率都有一定的提升。在上述设置下完整判断一组曝光参数下每个曝光点的类型需要12.64 s,相比通过高倍率显微镜进行人工目检来判定曝光点的方式,耗时大幅缩短。

表 1. 识别效果比较

Table 1. Comparison of recognition effect

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

3.2 光刻胶厚度、激光曝光功率与平台移动速度对MLA曝光加工质量的影响

MLA曝光工艺中,加工质量主要受光刻胶旋涂速度、激光曝光功率与平台移动速度的影响。不同旋涂速度所旋涂的光刻胶厚度不一样,不同厚度的光刻胶被曝透所需的激光曝光功率与平台移动速度也不相同。一定厚度的光刻胶能否被曝透主要取决于其所接收到的曝光剂量,曝光剂量即为单位面积光刻胶在曝光期间所接收的总体曝光能量,它与激光曝光功率与平台移动速度直接相关。当曝光剂量不足时,激光不能使照射到的光刻胶发生质变,会出现欠曝的情况。当曝光量过大时,临近曝光区域的光刻胶也会发生质变,导致曝光线宽变大,会出现过曝情况。光刻胶厚度主要由匀胶机旋涂光刻胶速度决定,实验中旋涂速度取2 000,3 000与4 000 r/min,对应的光刻胶厚度为2.2,1.8与1.5 μm。

为了更好地体现光刻胶曝光剂量与MLA曝光参数之间的关系,本文引用线能量密度的概念。由于曝光线宽D变化不明显,因此采用线能量密度来衡量曝光量。线能量密度为:

其中:P为激光功率,v为平台移动速度,E2为能量密度,D为曝光线宽。

激光功率设置为80~260 mW,间隔30 mW进行采样,平台移动速度为10~50 μm/s,间隔5 μm/s进行采样,在此参数下进行曝光实验,将所得曝光图像通过CNN目标检测模型进行检测,将识别出各类型曝光点数量占比与线能量密度进行拟合,结果如图7所示。

图 7. 线能量密度与各类型点占比的拟合曲线

Fig. 7. Fitting curves between level of energy density during laser scanning and qualification rate

从图7(c)可以看出,在光刻胶厚度一定的前提下,随着线能量密度的增加,欠曝率在一定线能量密度下陡直下降至0%后区域稳定。这是由于线能量密度在升高的过程中,每一个单元面积的光刻胶所接收的曝光量也随之升高,而激光与光刻胶发生反应的条件即为接收到足够的曝光量,所以在线能量密度高与特定值时欠曝率为0%。从图7(b)中可以看出,过曝率在一定能量下陡直上升至100%后趋于稳定。这是由于激光器发射的激光光斑呈高斯正态分布,在线能量密度升高的过程中,其光强等高线也随之扩散,导致激光光斑变大,曝光线宽也随之变大。当线宽大于阈值时,曝光点属于过曝点,因此一定线能量密度之上的曝光点都属于过曝点。从图7(a)可以看出,合格率在一定范围内先增加后减小,增加与减小的拐点与过曝率与欠曝率的突变界限有着一定的关系,这说明光刻胶厚度一致的前提下,其曝光所需要的线能量密度是一个特定区间。随着不同光刻胶旋涂转速的增加,即厚度的减小,欠曝率与过曝率的突变节点前移,因此,合格率较好时对应的线能量密度范围也前移。这说明不同厚度的光刻胶所需要的最佳能量密度不同,越厚的光刻胶曝光需要的能量密度越大。当光刻胶厚度为1.5 μm时,合格率在80%以上的线能量密度区间为6.5~8.5 kJ/m;光刻胶厚度为1.8 μm时,合格率在80%以上的线能量密度区间为6.5~10.5 kJ/m;光刻胶厚度为2.2 μm时,合格率在80%以上的线能量密度区间为9~13 kJ/m。

此外,光刻胶的剖面倾角会影响光刻关键尺寸(Critical Dimension,CD)的精确性与稳定性[29],所以加工质量的评价还要考虑曝光后微结构的剖面倾角。剖面倾角如图8(a)所示,从切面可得到相应曲线,显影侧壁之间的夹角即为光刻胶剖面倾角,它会影响曝光点的加工质量。光刻胶剖面倾角过大,在后续工艺中线宽会与实际测得的曝光线宽不一致,因此,确定的合格点不能完全达到工艺要求。为了更好地确定胶厚与曝光参数之间的关系,在不同参数(见表2)下进行曝光实验,结果如图8(b)所示。从中可以看出,在3种光刻胶厚度线能量密度区间内,光刻胶的剖面倾角偏低,都在3°以内,高于行业标准[30]。

表 2. 最佳线能量密度区域内多种参数组合的加工良率统计

Table 2. Statistics of qualified rate of multiple parameter combinations in optimal level of energy density region during laser scanning

|

3.3 相同线能量密度下最佳激光加工参数组合

在得到不同光刻胶厚度情况下最佳的线能量密度后,本文分析了曝光效果与最佳激光功率、平台移动速度之间的关系。当匀胶机旋涂速度为3 000 r/min,光刻胶厚度为1.8 μm时,最佳线能量密度在6.5~10.5 kJ/m。选取多组曝光参数进行实验,平台移动速度在10~40 μm/s,间隔10 μm/s取样。通过上述方法对合格率进行检测,结果如表2所示。

由表2可知,在最佳区域内能够取得较好的加工效果。曝光结果显示,随着平台移动速度的增大,即使显影结果中各曝光点中光刻胶被曝透且大部分曝光点线宽在设定值之下,符合本文对合格点的定义,但是图形存在明显的失真。这是由于运动平台位置的反馈存在延迟,速度过快的情况下,平台还未稳定在指定位置就要向下个目标点前进,此时若当前平台的运动方向与下一时刻的运动方向不共线,则当前方向的曝光线条不稳定,从而导致曝光图案失真。鉴于上述原因,MLA曝光机在绘制直线时曝光图案不会失真。这里通过曝光圆形图案来探究图案不发生失真时平台的最大移动速度。

本文使用圆度作为失真的衡量标准,这是由于在绘制圆形过程中运动方向不断改变,只要MLA曝光机在一定速度下能够绘制出较为完整的圆,此速度下也能绘制其他图形。圆度越低,图像失真越严重。圆度计算公式如下:

其中:C为圆度;F为区域面积;Dmax为区域中心到轮廓点的最大距离。

图9为10~50 μm/s的平台速度下,线能量密度一致时所绘制圆形的圆度测试结果。随着平台移动速度的增加,圆度逐渐下降,曝光图案的失真程度逐渐升高。在30~40 μm/s内曝光图案圆度的下降幅度达到35%,在10~20 μm/s之间为5%,20~30 μm/s为10%,因此,综合加工效率与图案失真情况,平台移动速度选为30 μm/s。

图 9. 不同平台移动速度下圆形曝光图案的圆度

Fig. 9. Different platform moving speeds correspond to circularity of circle pattern

4 结 论

本文引入深度学习目标检测模型来检测MLA曝光图案的良率,设计了圆环形曝光图案,便于目标检测模型来辨别曝光点的类型。通过引入Transformer encoder模块与CBAM模块对YOLOv5模型进行局部优化,在置信度设定为0.65的前提下进行测试,合格点的检测精确率可达97%,召回率可达100%;过曝点与欠曝点的精确率分别为98%和100%,召回率分别为79%和90%。在激光器功率为80~260 mW,平台移动速度为10~50 μm/s与旋涂转速为2 000~4 000 r/min的条件下,使用训练好的模型对曝光图像进行识别,并对识别结果进行拟合,得到光刻胶旋涂速度2 000~4 000 r/min下的最佳线能量密度为[6.5 kJ/m,8.5 kJ/m],[6.5 kJ/m,10.5 kJ/m]与[9 kJ/m,13 kJ/m],在线能量密度区间得到的光刻胶剖面倾角都在3°以内。在相同线能量密度内,基于圆度评价曝光图案的失真程度,得到最佳平台移动速度为30 μm/s。

[3]

[4] TANG M, CHEN Z C, HUANG Z Q, et al. Maskless multiple-beam laser lithography for large-area nanostructure/microstructure fabrication[J]. Applied Optics, 2011, 50(35): 6536-6542.

[5] LECUN Y, BOTTOU L, BENGIO Y, et al. Gradient-based learning applied to document recognition[J]. Proceedings of the IEEE, 1998, 86(11): 2278-2324.

[8] YOON J H, INGALE S L, KIM J S, et al. Effects of dietary supplementation of synthetic antimicrobial peptide-A3 and P5 on growth performance, apparent total tract digestibility of nutrients, fecal and intestinal microflora and intestinal morphology in weanling pigs[J]. Livestock Science, 2014, 159: 53-60.

[10] LUO H, HE M, HUI B, et al. Pedestrian detection algorithm based on dual-model fused fully convolutional networks(Invited)[J]. Infrared and Laser Engineering, 2018, 47: 203001.

[13]

[16] HE K M, ZHANG X Y, REN S Q, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1904-1916.

[17]

[18] REN S Q, HE K M, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[23]

[24] IOFFE S, SZEGEDY C. Batch normalization: accelerating deep network training by reducing internal covariate shift[J]. CoRR, 2015.

Article Outline

姚宇超, 周锐, 严星, 王振忠, 高娜. 基于卷积神经网络判定方法的激光微透镜阵列微米级加工工艺[J]. 光学 精密工程, 2024, 32(1): 43. Yuchao YAO, Rui ZHOU, Xing YAN, Zhenzhong WANG, Na GAO. Micron-level processing technology of microlens array (MLA) photolithography based on convolutional neural network[J]. Optics and Precision Engineering, 2024, 32(1): 43.