基于图像分割和局部亮度调整的微光图像颜色传递算法  下载: 612次

下载: 612次

1 引言

微光夜视图像的彩色显示技术,可以使得夜视系统获取高质量的图像,提高其分辨目标的能力,增大作用范围[1-2]。彩色夜视技术能提高夜间的观察能力且抗干扰能力强,因此不论在理论还是实际应用上,彩色夜视技术的发展均得到人们的广泛关注[3-4]。Reinhard在2001年基于Ruderman的

本文提出了一种基于图像分割和局部亮度调整的颜色传递算法:通过采用简单线性迭代聚类法[12-14]和K-means均值聚类法[15-16]对微光夜视图像进行聚类分割,结合参考图像,将分割后的目标图像用亮度值重映射的方法进行色度传递,再根据纹理沟壑调整亮度值,对目标图像进行彩色传递。

1 相关理论

1.1 图像纹理特征

微光图像为弱纹理图像,纹理细节不清,灰度共生矩阵定义为像素对的联合分布概率,是一个对称矩阵,它不仅反映图像灰度在相邻方向、相邻间隔、变化幅度的综合信息[17],也反映了相同灰度级像素之间的位置分布特征,是计算纹理特征的基础。用条件概率计算图像相邻像素灰度的空间相关特性,得到共生矩阵,在已有共生矩阵的基础上计算14种灰度共生矩阵的纹理特征向量[18]。将图像的灰度级量化成16级,计算距离d=1;角度取0°、45°、90°、135°四个方向的灰度共生矩阵[19]。计算其灰度共生矩阵的4个相关性较低且描述能力强的参数[20]:

1) 对比度(

2) 能量(

3) 相关(

4) 熵(

式中:

1.2 多参数亮度重映射算法

用图像中每一点像素的邻域亮度均值和标准差对比灰度图像和彩色图像之间的像素来实现多参数亮度重映射算法。选取与目标图像有相似特征的参考图像,两幅图片从RGB颜色空间转至YCbCr颜色空间,将彩色图像的亮度值按照目标图像的亮度结合统计特征做线性变换,使其亮度值动态范围一致。在亮度通道上对每个像素进行匹配,匹配到与彩色图像上相近的像素点时将色彩信息(通道)传递给目标图像对应的像素点,保留目标图像本身的亮度信息,进行颜色空间逆变换得到结果图。参考图像进行亮度对比传递的公式如下:

式中:L为变换后新的彩色参考图像中像素点亮度值;

2 本文算法

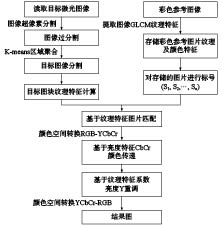

本文算法包含以下要点:1) 分割后的子目标图像纹理特征与参考图纹理特征值在相同范围内;2) 按照每一像素点子目标图像的亮度值与参考值匹配,将亮度一致的像素点颜色进行传递;3) 微光图像大多细节不清,为保证色彩传递后纹理细节不消失,将微光图像的亮度用灰度共生矩阵的对比度的值重新调整系数,最终得到一幅具有真实场景的颜色与纹理的彩色图片。算法思路框图如

2.1 图像分割

利用简单线性迭代聚类(SLIC)算法进行分割预处理,分割原理是将一幅图像以K个初始聚类中心为核心,根据距离产生大小近似相等的超像素小图块,图块中心的间隔近似为

改进K-means均值聚类算法,基于灰度图像的亮度均值、方差与对比梯度将超像素图块作为一个整体对其进行超像素合并。亮度均值表明在某一处的图像的平均灰度,同一物体在同一条件(光照、时间、场景相同)下亮度变化不大,所以拍摄的微光图像中同样的景物亮度均值相似。方差表示超像素图块中每一个像素点与均值的差,其中方差越大,其差越大,在超像素图块中灰度变化越大,场景变化也就越明显。对比梯度指一个像素点四连通邻域内的点的变化幅度,其值越大,周围明暗对比越明显。对已经分割成超像素的图片进行K-means聚类,依照其每一超像素图块的均值

式中:

1) 读取预分割微光图片;

2) 选取超像素的个数K,在图像内均匀分配聚类中心;

3) 在每个聚类中心的邻域2S×2S范围内,利用距离为每个像素点聚类,得到超像素尺寸大小近似为S×S,图像分为K个超像素的图像;

4) 把每一个超像素图块看做是一个整体,再根据图像重新定义聚类中心,依照其每一超像素部分的均值、方差及对比梯度,对已经分割成超像素的图片重新进行全局K-means聚类;

5) 通过不断迭代收敛,至每个超像素聚类中心不再发生变化为止,图像根据景物特点分割出不同场景;

6) 将不连续的超像素、尺寸过小的超像素重新分配给最邻近的聚类中心,遍历所有的像素点分配给相应的聚类中心,直到遍历完毕为止。

2.2 参考图像纹理统计信息

在全局算法的理论基础之上,基于已分割好的图像块,对不同景物特征的图像块分别进行颜色传递,提出局部区域的颜色传递。文中的参考图像按照灰度共生矩阵纹理特征及常见场景色彩给彩色图像分类标记。

选择常见场景目标(包括天空、建筑、树木、草地、道路)进行图片切割,切割成互不重叠

2.3 色彩传递

本文面向自然场景,树木本身纹理沟壑深,其对比度大,但在微光图像中视觉效果不明显,为使其清晰,用上文灰度共生矩阵中对比度参数的均值及均方差调整图像亮度系数,让原本不容易赋上色彩的纹理沟壑深度部分更易上色。反之,文中天空和陆地本身色彩信息比较单一,但亮度相对较高一些,灰度共生矩阵的对比度小,沟纹浅,易赋色,则不再凸显出亮度信息。具体算法如下:

1) 目标微光图像

2) 选择目标图像

3) 将图像

4) 用(12)式调整图片亮度,其中

式中系数由灰度共生矩阵中对比度的均值和均方差求得,即2.2小节中

5) 将二次颜色传递后的图像再进行颜色空间转换,由YCbCr颜色空间空间转至RGB空间;

式中:

6) 重复2)~5),直至所有的目标场景都被传递上相应的最佳彩色。

3 实验研究

本实验采用Andor公司的EMCCD相机,该相机的分辨率为130像素,每秒可采集60帧图像;采用AZURE公司的M2518 MPW2镜头,焦距为25 mm。本实验时间为2019年夏季7月底,凌晨01:00~03:00。地点:室外。温度:24 ℃。能见度:14 km。相对湿度:在60%~70%之间。光照度:

3.1 图像处理结果

3.2 结果评价

选取空间频率、平均梯度、峰值信噪比(PSNR)这3个指标对

4 结论

在分析现有算法的基础上,提出了一种基于分割的局部图像亮度调整颜色传递方法。颜色传递过程中,纹理细节不丢失,目标图像超像素预分割后再进行超像素之间的聚合,让图像中不同场景实现准确分割。颜色传递过程中利用不同的子区域分别进行颜色传递,目标图像与相应的参考图像亮度值对应,让每一部分颜色都尽可能地与自然真实场景颜色接近。利用灰度共生矩阵的对比度特性,根据不同场景子区域的纹理沟壑程度调整亮度,得到微光图像的局部颜色传递的图像符合人眼观察特性的彩色图片。文中颜色传递算法得到图像的平均梯度值最高4.928 5,最低3.157 1,比其他算法平均提高1.98;峰值信噪比的值本文算法最高13.287 1 dB,最低11.312 5 dB,比其他算法平均提高2.72 dB;空间频率的值本文算法最高11.934 5,最低6.538 9,比其他算法平均提高4.63。

[1] FLEA L, FLEA C, IONU C.Avoiding the deconvolution: framewk iented col transfer f enhancing lowlight images[C]2016 IEEE Conference on Computer Vision Pattern Recognition Wkshops (CVPRW). USA: IEEE Computer Society, 2016: 2735.

[5] REINHARD, E, ADHIKHMIN M, GOOCH B. Color transfer between images[J]. IEEE Computer Graphics and Application, 2001, 21(2): 34-41.

[9] 仲红玉, ZHONG Hongyu, YIN Liju, 尹丽菊, 高明亮, GAO Mingliang. Color transfer method of luminance remapping with multi-parameters[J]. Infrared and Laser Engineering, 2018, 47(5): 159-166.

[10] ARBELOT B, VERGNE R, HURTUT T. Local texture-based color transfer and colorization[J]. Computers & Graphics, 2017, 62: 15-27.

[13] 罗学刚, LUO Xuegang, LYU Junrui, 吕俊瑞, 彭真明, PENG Zhenming. Recent research progress of superpixel segmentation and evaluation[J]. Laser & Optoelectronics Progress, 2019, 56(9): 45-55.

[14] ZHANG Liang, LI Huan, SHEN Peiyi, et al. improving semantic image segmentation with a probabilistic superpixelbased dense conditional rom field[C]USA: IEEE Access, 2018: 1529715310.

[15] TANIR D, NURIYEVA F. On ing the initial cluster centers in the Kmeans algithm[C]2017 IEEE 11th International Conference on Application of Infmation Communication Technologies. USA: IEEE, 2017: 15.

[20] HAMAM T, DDEK Y, COHEN D. Singleb infrared texturebased image colization[J]. IEEE, 2012, 27: 46734681.

Article Outline

辛浪, 刘钧, 袁渊. 基于图像分割和局部亮度调整的微光图像颜色传递算法[J]. 应用光学, 2020, 41(2): 309. Lang XIN, Jun LIU, Yuan YUAN. Low-light image color transfer algorithm based on image segmentation and local brightness adjustment[J]. Journal of Applied Optics, 2020, 41(2): 309.