基于前景感知的时空相关滤波跟踪算法  下载: 939次

下载: 939次

1 引言

目标跟踪是计算机视觉中具有挑战性的任务之一。它是一个首先给定视频序列初始帧目标的位置和大小,并在随后的视频序列中估计出目标状态的过程[1]。近年来,该领域的研究取得了重大进展,但是受到目标外观形态、尺度变化,光照变化和遮挡等问题的影响,目标跟踪任务仍然不能通过任意一个单一跟踪算法处理所有场景。根据目标外观模型的表达策略划分,可将跟踪算法分为生成式模型[2-3]和判别式模型[4-8]。生成式模型利用一个模式表达目标的外观形态,然后在搜索图像区域中找到与模型最相似的区域作为目标。判别式模型则是利用已知的样本进行训练,进而学习到一个分类器,从而建立一个将目标从背景区域分离出来的判别方法。而基于相关滤波器的跟踪算法,是判别式模型中的一种,近些年来在各个数据集和目标跟踪的比赛中获得了优秀的效果。

Henriques等[9]提出高速核相关滤波算法(KCF),它利用循环密集采样,对目标和目标周围的环境构造出大量训练样本,以提高分类器的分类能力,再利用循环矩阵对角化的性质和快速傅里叶变换,将空域内的计算转换到频域,能降低计算复杂度,实现在线跟踪。Danelljan等[10]提出精确尺度估计的稳健跟踪算法(DSST),其利用多尺度相应策略,能够有效地解决尺度变化的问题。后来,Danelljan等[11]提出空间正则化相关滤波跟踪算法(SRDCF),通过引入空间正则化权重来抑制相关响应中背景部分引起的杂波,能降低相关滤波算法中的边界效应,显著提高了相关滤波的跟踪准确性。以SRDCF为基础改进的连续空间卷积跟踪器(CCOT)[12]和高效时空卷积跟踪器(ECO)[13]也均在公用数据集上表现出卓越的性能。

SRDCF结合深度神经网络提取的特征,能很好地解决目标外观形态、尺度和光照变化等问题,但是缺乏对跟踪序列中上下文关系的分析,会导致跟踪漂移,尤其是对背景混杂、遮挡、目标移出视野再移回的情况解决不佳。此外,SRDCF在传统特征的表达下,计算速度仅为6 frame /s,远不能达到实时跟踪的目的。为解决这些问题,本文在SRDCF的基础上提出一个考虑时间上下文信息的跟踪方法,它利用一个保有历史信息的正则项,使各帧学习到的滤波器始终保持在一个低维流形上,能避免滤波器模板向量突变。在时间正则项的约束中,设计一个具有前景感知功能的滤波方法,其能够利用真实样本训练相关滤波器,避免了循环移位产生的边界效应问题,并能有效区分前景和背景。本文利用交替方向乘子法(ADMM)求解,在几次迭代后即可实现收敛,从而达到快速求解的目的,以实现跟踪的实时性。此外,本文还提出基于目标候选区域的重检测方法,能够有效解决目标发生遮挡、目标移出视野的问题。利用OTB-2013、OTB-2015、VOT2016数据集,将本文算法与基准算法SRDCF及一些流行的目标跟踪算法进行对比,证明了本文算法的可靠性。

2 空间正则化相关滤波跟踪算法

SRDCF是一种在频域利用稀疏的正则化矩阵学习得到空间正则化相关滤波器的方法,其有效地减轻了多通道相关滤波器的边界效应,也在各评估基准中证明具有很好的跟踪性能。

在相关滤波的学习过程中,SRDCF利用空间正则化权重函数

式中,

3 基于前景感知的时空相关滤波跟踪算法

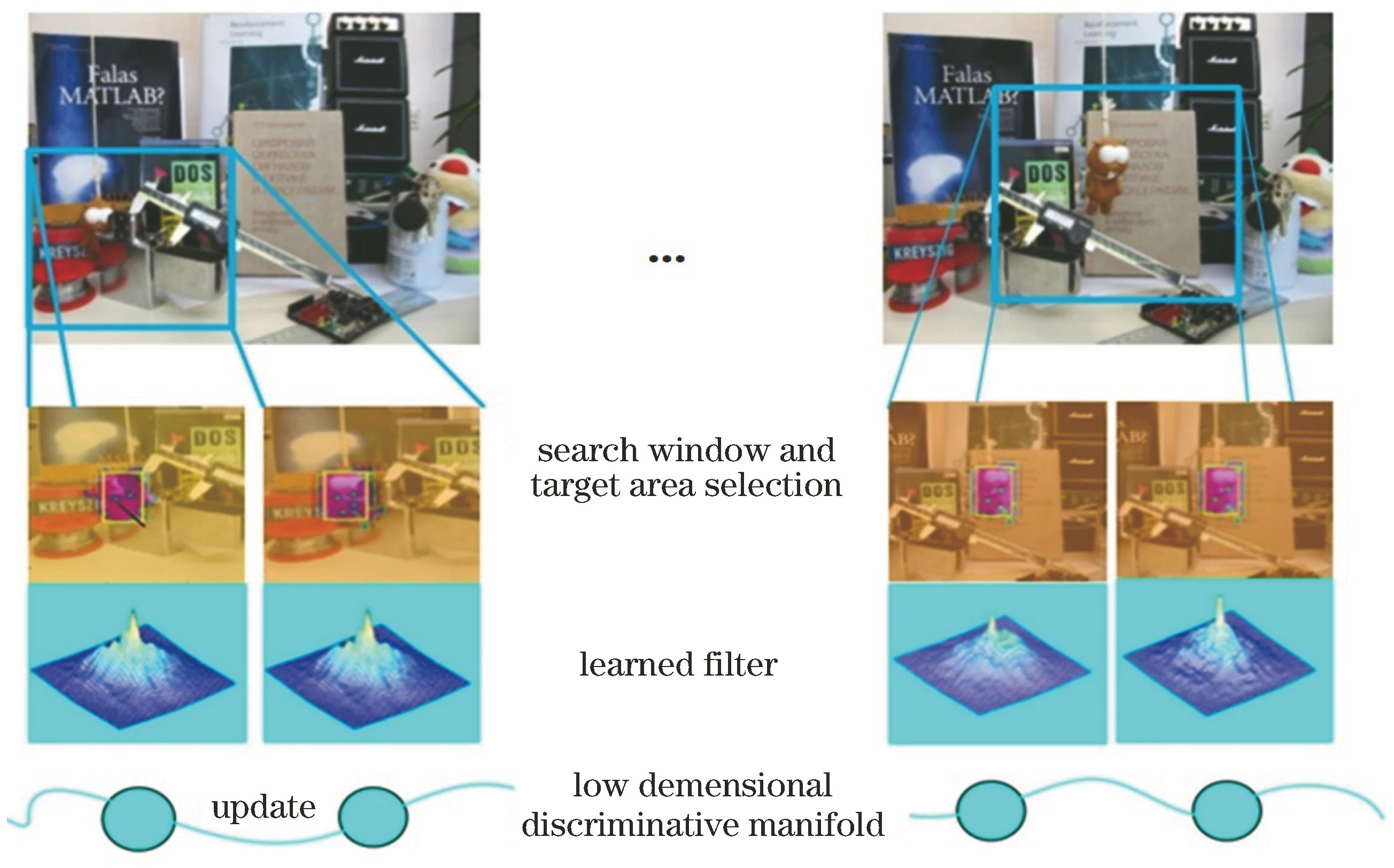

3.1 基于前景感知的时间一致性模型

为表达跟踪过程中时间信息的一致性,假设构成连续视频帧的滤波器模板的向量位于一个低维流形上,前后帧变化被限定在一个

式中,

图 1. 用序列Tiger说明具有目标区域选择功能的时间一致性约束

Fig. 1. Temporal consistency constraints with object area selection function explained by sequence Tiger

3.2 前景感知滤波器模板的学习

这节给出前景感知功能的滤波器模板

![以一维向量为例。假设目标大小D=3。左侧是一个L=5的一维信号xi,xi[Δτj]图像是所有循环移位所得的结果,它通过左乘掩模矩阵P,可以得到5个长度为3的一维向量,其中前3行是与目标大小一致的真实的正样本](/richHtml/lop/2019/56/22/221503/img_2.jpg)

图 2. 以一维向量为例。假设目标大小D=3。左侧是一个L=5的一维信号xi,xi[Δτj]图像是所有循环移位所得的结果,它通过左乘掩模矩阵P,可以得到5个长度为3的一维向量,其中前3行是与目标大小一致的真实的正样本

Fig. 2. Take one-dimensional vector as example, assuming length of target is D=3. Left side is one-dimensional signal xi with L=5. xi[Δτj] image is result of all cyclic shifts. Five one-dimensional vectors with length of 3 can be obtained by multiplying mask matrix P on this image, where first 3 rows are real positive samples with same size of object

传统的相关滤波器在频域内求解,岭回归方程在空域内可以表示为

式中,

定义多个

式中,

和传统相关滤波器的求解方法一样,将(5)式转换到频域进行分析。由帕塞瓦尔定理,可得

式中,

3.3 优化方法

SRDCF采用高斯-赛德尔迭代法求解,高斯-赛德尔迭代法是数值代数中的一种迭代法,用于求解线性方程组,但其收敛速度慢,无法满足跟踪过程的实时性。在这里,采用ADMM求解,可以保证在传统特征表达上的跟踪具有实时性。

图 3. 传统相关滤波器和本文方法训练样本对比。(a)传统相关滤波器的循环移位训练样本;(b)前景感知相关滤波器的训练样本

Fig. 3. Comparison of training samples between traditional correlation filters and proposed method. (a) Cyclic-shift training samples of traditional correlation filter; (b) training samples of foreground-aware correlation filter

第1帧的滤波器模型通过3.2小节求得,为求解(4)式,引入松弛变量

式中,

利用ALM,将(7)式约束转换为标准函数,则目标函数可以转换为拉格朗日函数的最小值,即

式中,L(·)为拉格朗日函数,

由于(8)式无闭环解,通过ADMM优化求解可得两个优化子问题。

子问题

式中,

式中,

子问题

更新拉格朗日系数为

更新惩罚系数

式中,

由3.1小节的最优函数可以看出,带有时空正则项的最优函数为凸函数,且ADMM的每一个子问题均在空域或频域有闭环解,因此可以收敛到全局最优。

对复杂度分析,由于(9)式的求解在每个像素位置上是相互独立的,因此关于子问题

3.4 重检测

3.4.1 目标重检测

目前任何跟踪算法都不能始终保证跟踪的正确性。基于相关滤波的跟踪器一旦发生跟踪错误,那么所训练到的分类器通常是由前一帧或者前几帧的错误样本取得,那么模板会发生漂移,从而导致跟踪失败。目前常用的办法是用相关响应的峰值旁瓣(PSR)来确定相关峰振荡的剧烈程度,由此来决定跟踪器是否发生跟踪错误。然而,仅仅改变模型跟新策略无法重捕已丢失的目标。

受目标检测算法的启发,本文采用候选区域和相关滤波结合的方法设计了一个重检测器。文献[

14]的候选区域方法为EdgeBoxes,其利用图像中纹理、边缘、颜色等信息,可以保证在选取较少窗口(几千甚至几百个)的情况下,保持较高的召回率。对于重检测器,本文通过上文方法,获得两个相关滤波器模板。一个与传统相关滤波跟踪方法相同,采用帧帧更新的策略,用于正常跟踪状态;另外一个通过保守的更新率来获得长时跟踪所需的具有记忆效应的滤波器模板,一旦发生目标丢失的现象,能激活重检测器。在重检测时,用EdgeBoxes候选区域方法获得目标可能出现的位置,并计算所有候选框目标与具有记忆效应滤波器的相关输出,定义为

式中,

3.4.2 重检测阈值确定

为不与后续实验数据集重合而产生偶然性,用独立的数据集来验证阈值选取的可靠性。MEEM[15]跟踪算法提供了10个带有不同属性的视频序列,如遮挡、光照变化、低分辨率和目标非刚性形变等。VIVID数据集提供航拍的移动车辆数据,其中包括红外图像和可见光视频序列,其中车辆经常发生互相遮挡、障碍物遮挡和尺度变换等情况,共计上万帧视频序列。为测试重检测器的激活阈值,首先用无重检测功能的跟踪方法,以便获得跟踪失败的序列。以MEEM数据集中的2个视频序列为例,

图 4. 无重检测器的carRace和ball序列的IoU值和响应得分曲线关系。(a) carRace的IoU值和响应得分曲线关系;(b) carRace第502帧跟踪结果;(c) carRace第510帧跟踪结果;(d) ball的IoU值和响应得分曲线关系;(e) ball第209帧跟踪结果;(f) ball第211帧跟踪结果

Fig. 4. Relationship between IoU value and tracking confidence score for carRace and ball sequences without re-detector. (a) Relationship between IoU value of carRace and tracking confidence score; (b) 502nd-frame tracking result of carRace; (c) 510th-frame tracking result of carRace; (d) relationship between IoU of ball and tracking confidence score; (e) 209th-frame tracking result of ball; (f) 211st-frame tracking result of ball

实验发现,当目标被严重遮挡时,如序列carRace的510 帧和ball的210 帧,相关响应值小于0.2,会导致跟踪失败(IoU值小于0.5),因此将重检测器的阈值

3.5 算法流程

目标在第

和传统的相关滤波跟踪器一样,本文采用在线更新策略来提高算法的稳健性,防止过拟合。第t帧的滤波器模板以一个固定的学习速率更新,

4 实验结果与分析

利用文献[ 16-17]提供的公开数据集和方法定性、定量分析测试本文算法。在特征表达上用传统特征、基于神经网络提取特征的方法分别进行实验。对本文算法与一些具有代表性的高性能算法进行对比,其中包括CCOT[12]、 ECO[13]、 DSST[10]、分层卷积特征跟踪器CF2[18]、端到端的相关滤波器跟踪CFNet[19]、SRDCF[11]、KCF[9]、长时跟踪器LCT[4]、多专家模型MEEM[15]、孪生全连接网络SiamFC[20]、互补学习跟踪方法 Staple[21]、背景感知跟踪器BACF[22]、多域卷积神经网络MDNet[23]、多尺度相关滤波跟踪器SAMF[24]及未配备重建测功能的CF2跟踪器CF2camera。最后在文献[ 15]所提供的数据集中选出序列。在实验数据对比中,本文方法基于传统特征的用Ours表示,基于深度特征的用Oursdeep表示。实验的测试平台为Matlab2017a,实验使用的计算机CPU为主频3.40 GHz的I7-6700,内存为8 GB,通过英伟达GeForce GTX 1080ti GPU基于MatConvNet工具箱提取前向特征。

和SRDCF一致,本文在4倍于目标长、宽的搜索区域进行查找,然后分别提取方向梯度直方图(HOG)、颜色名称和卷积特征,然后通过余弦窗处理来降低边界效应。对于ADMM,将(8)式中的超参数

4.1 定量分析

4.1.1 在OTB-2013数据集上的评估

利用文献[

14]中提供的2种评判标准来评价算法:1)精确度,定义为目标中心误差小于指定阈值的帧数占总帧数的百分比,其中阈值取20 pixel,并把这个值定义为中心距离准确率(DP);2)成功率,定义为

首先把本文算法和一些其他基于传统特征的先进方法进行对比,

表 1. 基于传统特征的跟踪算法在OTB-2013上的成功率、精确度和跟踪速度

Table 1. Success rate, precision, and tracking speed of tracking algorithm based on traditional features on OTB-2013 dataset

|

图 5. 基于传统特征的跟踪器在OTB-2013数据集上的OPE曲线和成功率曲线。(a) OPE曲线;(b)成功率曲线

Fig. 5. Plots of OPE and success rate of trackers with traditional features on OTB-2013 dataset. (a) Plots of OPE; (b) plots of success rate

本文还基于OTB-2013数据集对视频序列中的11个属性进行了测试。如

为更好地表征目标物体的模式,本文跟踪器也结合深度特征并与其他基于深度学习的方法进行比较。在这里,对跟踪器组合VGG-M中conv1和conv5的网络输出,结合传统特征作为特征表达,同样采用成功率,精确度和跟踪速度作为衡量标准。

4.1.2 在VOT2016上的评估

参与比较的算法有VOT2015和VOT2016上的冠军算法MDNet和CCOT,由

表 2. 各跟踪器在OTB-2013上的属性评估

Table 2. Performance evaluation of each tracker on OTB-2013 dataset

|

表 3. 基于卷积特征的跟踪算法在OTB-2013上的准确率、精确度和跟踪速度

Table 3. Success rate, precision, and tracking speed of tracking algorithm based on convolutional features on OTB-2013 dataset

|

图 6. 基于卷积特征的跟踪器在OTB-2013数据集上的OPE曲线和成功率曲线。(a) OPE曲线;(b)成功率曲线

Fig. 6. Plots of OPE and success rate of trackers with convolutional features on OTB-2013 dataset. (a) Plots of OPE; (b) plots of success rate

4.2 定性分析

表 4. VOT2016数据集上各算法的EAO,精确度和稳健性评估

Table 4. Evaluations of EAO, precision, and robustness of algorithms on VOT2016 dataset

|

图 7. 本文算法和SiamFC,CCOT,DSST,KCF,ECO,CF2在OTB-2015上的8个序列的效果对比。从上到下依次为singer2,girl2,tiger,bird1,dragonbaby,motorrolling,skiing,soccer

Fig. 7. Comparison of tracking results of SiamFC, CCOT, DSST, KCF, ECO, CF2, and proposed algorithm on 8 challenging sequences from OTB-2015 dataset. From top to bottom: singer2, girl2, tiger, bird1, dragonbaby, motorrolling, skiing, and soccer

有效抑制背景与目标的混杂,且正则项可以阻止帧与帧之间滤波器模板因突变而产生的漂移。此外,重检测块能够抵抗遮挡影响。这种时间一致性的约束和重检测器甚至可以在目标发生完全遮挡,移出视野并移回的序列中起到效果(bird1)。从4.1小节的属性性能比较中可以看出,本文算法对平面内旋转和平面外旋转场景的处理效果很好(dragonbaby),因为其延续了SRDCF空间正则化方法的优点,总是能在较大范围的搜索框中很好地区分目标区域和周围环境区域。

5 结论

空间正则化相关滤波算法SRDCF在目标超出视野、严重遮挡和复杂背景的情况下容易跟踪失败。基于SRDCF,引入时间一致性约束,使相关滤波跟踪同时具有时间空间正则化功能。令跟踪模型能够考虑历史信息,在时间正则项中,引入具有前景感知功能的滤波器作为约束,并消除边界效应的影响。在跟踪整体框架上使用ADMM,能够改变SRDCF运算速度慢的缺陷,从而实现在线跟踪。此外,通过设计基于候选区域方法的重检测器,探究重检测器激活的条件,使跟踪器能有效对抗遮挡和移出视野。利用OTB-2013,OTB-2015和VOT2016数据集,对本文算法和时下最先进的算法进行对比。结果显示,在OTB-2013上,本文算法的传统和卷积特征两个版本的跟踪成功率比SRDCF均有提高,且与参与比较的算法相比,在跟踪成功率排名上均为第一。通过基于数据集的定性和定量分析,本文算法能够应对多种复杂场景,与现有先进算法相比较,有很好的稳定性。

[1] 高美凤, 张晓玄. 尺度自适应核相关滤波目标跟踪[J]. 激光与光电子学进展, 2018, 55(4): 041501.

[3] KwonJ, Lee KM. Visual tracking decomposition[C]∥2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, June 13-18, 2010,San Francisco, CA, USA. New York: IEEE, 2010: 1269- 1276.

[4] 茅正冲, 陈海东. 基于核相关滤波的长期目标跟踪算法[J]. 激光与光电子学进展, 2019, 56(1): 010702.

[5] 蔡玉柱, 杨德东, 毛宁, 等. 基于自适应卷积特征的目标跟踪算法[J]. 光学学报, 2017, 37(3): 0315002.

[6] HareS, SaffariA, Torr P H S. Struck: structured output tracking with kernels[C]∥2011 International Conference on Computer Vision,November 6-13, 2011, Barcelona, Spain. New York: IEEE, 2011: 263- 270.

[7] GaoJ, Ling HB, Hu WM, et al. Transfer learning based visual tracking with Gaussian processes regression[M] ∥Fleet D, Pajdla T, Schiele B, et al. Computer vision-ECCV 2014. Lecture notes in computer science. Cham: Springer, 2014, 8691: 188- 203.

[8] 廖秀峰, 侯志强, 余旺盛, 等. 基于核相关的尺度自适应视觉跟踪[J]. 光学学报, 2018, 38(7): 0715002.

[10] Danelljan M, Hager G, Khan F S, et al. Discriminative scale space tracking[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(8): 1561-1575.

[11] DanelljanM, HagerG, Khan FS,et al. Learning spatially regularized correlation filters for visual tracking[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 4310- 4318.

[12] DanelljanM, RobinsonA, Shahbaz KhanF, et al. Beyond correlation filters: learning continuous convolution operators for visual tracking[M] ∥Leibe B, Matas J, Sebe N, et al. Computer vision-ECCV 2016. Lecture notes in computer science. Cham: Springer, 2016, 9909: 472- 488.

[13] DanelljanM, BhatG, Khan FS, et al. ECO: efficient convolution operators for tracking[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 6931- 6939.

[14] WuY, LimJ, Yang MH. Online object tracking: a benchmark[C]∥2013 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2013, Portland, OR, USA. New York: IEEE, 2013: 2411- 2418.

[15] Wu Y, Lim J, Yang M H. Object tracking benchmark[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1834-1848.

[16] KristanM, PflugfelderR, LeonardisA, et al. The visual object tracking vot2016 challenge results[C]∥European Conference on Computer Vision Workshops (ECCVW), October 8-10, 2016, Amsterdam, The Netherlands. New York: IEEE, 2016: 777- 823.

[17] ZhuG, PorikliF, Li HD. Beyond local search: tracking objects everywhere with instance-specific proposals[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 943- 951.

[18] MaC, Huang JB, Yang XK, et al. Hierarchical convolutional features for visual tracking[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 3074- 3082.

[19] ValmadreJ, BertinettoL, HenriquesJ, et al. End-to-end representation learning for correlation filter based tracking[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 5000- 5008.

[20] Zhang JM, Ma SG, SclaroffS. MEEM: robust tracking via multiple experts using entropy minimization[M] ∥Fleet D, Pajdla T, Schiele B, et al. Computer vision-ECCV 2014. Lecture notes in computer science. Cham: Springer, 2014, 8694: 188- 203.

[21] BertinettoL, ValmadreJ, Henriques JF, et al. Fully-convolutional Siamese networks for object tracking[C]∥Hua G, Jégou H. Computer vision-ECCV 2016 Workshops. Lecture notes in computer science. Cham: Springer, 2016, 9914: 850- 865.

[22] BertinettoL, ValmadreJ, GolodetzS, et al. Staple: complementary learners for real-time tracking[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 1401- 1409.

[23] Galoogahi HK, FaggA, LuceyS. Learning background-aware correlation filters for visual tracking[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy. New York: IEEE, 2017: 1144- 1152.

[24] NamH, HanB. Learning multi-domain convolutional neural networks for visual tracking[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 4293- 4302.

Article Outline

虞跃洋, 史泽林, 刘云鹏. 基于前景感知的时空相关滤波跟踪算法[J]. 激光与光电子学进展, 2019, 56(22): 221503. Yueyang Yu, Zelin Shi, Yunpeng Liu. Foreground-Aware Based Spatiotemporal Correlation Filter Tracking Algorithm[J]. Laser & Optoelectronics Progress, 2019, 56(22): 221503.