基于卷积特征和贝叶斯决策的双波段场景分类  下载: 710次

下载: 710次

1 引言

随着深度学习技术的广泛研究,凭借海量标注样本的优势,面向可见光波段的图像分类、目标检测等计算机视觉任务取得了突飞猛进的发展,产生了一些经典的卷积神经网络(CNN)模型,如应用于图像分类的AlexNet[1]、视觉几何组网络(VGGNet)[2]、GoogLeNet[3]、深度残差网络(ResNet)[4]模型。红外图像可为同一场景可见光图像提供补充信息,因此,融合可见光和红外信息的双波段图像比单一波段图像的优势更大。近年来,双波段图像结合深度学习技术,逐渐成为图像分类[5]、目标识别[6]、行人检测[7]、目标检测[8]及目标跟踪[9]等领域的研究热点。

场景分类是计算机视觉领域长期研究的一个主题[10]。目前,基于可见光RGB(Red,Green,Blue)和近红外(NIR)双波段图像的场景分类方法主要包括基于传统特征的方法和基于CNN的方法。基于传统特征的方法主要利用尺度不变特征变换(SIFT)等人工设计特征,如Brown等[11]提出了一种基于多光谱SIFT(MSIFT)的场景分类方法,该方法对双波段图像进行去相关处理,提取每个通道的SIFT特征进行级联融合,并用主成分分析(PCA)方法降低融合特征维度。Salamati等[12]利用Fisher Vector方法融合SIFT特征和颜色信息,Xiao等[13]使用直方图统计变换方法对多光谱的梯度信息和颜色信息进行联合编码。张秋实等[14]提取双波段图像的密集SIFT(DSIFT)特征,采用无字典模型(CLM)进行特征变换,然后基于混合核的支持向量机(SVM)进行分类。

基于CNN的方法通常采取预训练或微调的经典网络模型提取卷积特征,通过设计双波段图像的特征级联融合网络,学习训练共同的特征表示。Ševo等[15]通过组合基于GoogLeNet模型的两个子网络和三个分类器,设计了一种双CNN(Dual CNN)体系架构,两个子网络分别以RGB图像和NIR+RGB组合通道图像作为输入。Peng等[16]通过微调预训练GoogLeNet模型提取双波段图像的卷积特征,并采用基于核函数的主成分分析(KPCA)和典型相关分析(CCA)方法进行特征降维和特征融合。江泽涛等[17]使用预训练ResNet-50模型提取图像特征,进行级联融合后送入全连接层,然后进行训练和分类。Jiang等[5]利用全连接层融合基于简单CNN的RGB和NIR两路输出特征,构建并训练双路特征融合模型,取得了较好的分类性能。此外,由于双波段图像缺乏大量的标注样本,数据增强、Dropout等正则化技术是这类方法训练中常用的技巧,可避免模型出现过拟合问题。

基于传统特征的方法通过词袋模型、Fisher Vector、直方图统计变换等方法对多通道自然场景的结构、纹理、颜色等视觉信息进行联合编码。而CNN通过自动学习,将低级特征由底层到高层逐步抽象为高级语义特征[18],相比传统方法在图像表示上有明显优势。双波段图像的卷积特征不仅包含互补信息,还包括大量冗余信息,导致级联融合的特征质量不高,而学习共同的判别性特征表示仍是目前基于双波段图像计算机视觉任务的一个难点。在双波段图像标注样本匮乏的情况下,基于CNN的方法克服了人工设计特征表示能力不足的问题,但模型训练易出现过拟合、级联融合质量低以及共同特征表示学习难等问题。

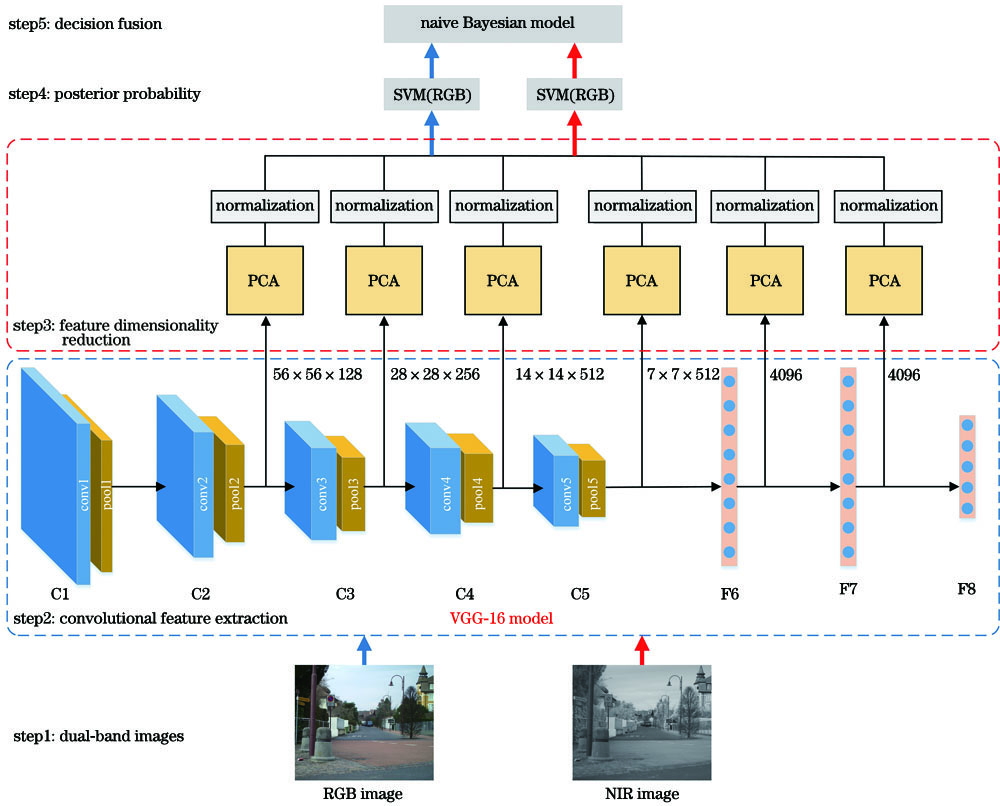

近年来,单一波段多分类器融合[19-20]的决策级融合在双波段图像目标识别[21]、目标检测[22]领域中得到广泛的应用。为解决双波段图像场景分类中存在的问题,本文利用决策级融合简单快速的优势,提出了一种基于预训练网络模型卷积特征和朴素贝叶斯模型(Naive Bayes model)决策融合的双波段图像场景分类方法,为双波段图像场景分类提供了一种新的融合思路。

2 融合模型

本方法首先利用基于ImageNet数据集预训练的CNN模型(以VGG-16为例)分别提取双波段图像的卷积特征,避免因标注数据集匮乏引起的深度网络模型训练过拟合问题。其次,采用PCA方法进行特征选择,并降低卷积特征维度,避免高维度卷积特征占用存储和计算资源多的问题。然后,基于SVM分类器计算每个波段图像分类的后验概率。最后,通过朴素贝叶斯模型融合后验概率,输出双波段图像的分类识别标签。算法的总体框架如

2.1 卷积特征提取

深度学习区别于传统机器学习方法的最主要特点在于表示学习部分具有分布式表示特性[23]。此外,AlexNet、VGGNet等深度CNN通过增加网络层数,将底层的视觉特征逐步抽象为高层的语义特征。因此,整个网络体系架构由下自上呈现出特征表示的层次性[24]。采用基于ImageNet数据集预训练的VGGNet和ResNet模型,并根据网络结构特征表示的层次性,依次提取RGB和NIR双波段图像的低级、中级和高级卷积特征,如

表 1. VGGNet和ResNet的网络层及特征维度

Table 1. Layers and feature dimension of the VGGNet and ResNet

| |||||||||||||||||||||||||||

2.2 特征降维与归一化设计

提取的高维度卷积特征消耗的计算资源较多,且含有一定的噪声和较多的冗余信息,因此,通过PCA将卷积特征从高维空间投影到低维空间。PCA是机器学习中最常用的降维方法,主要思想是通过对高维特征的协方差矩阵进行特征值分解,保留前几个最大特征值对应的特征向量,从而构成低维特征空间。PCA可以通过设置固定维度和设置重构阈值[25]两种方法获取低维特征空间的维度,其中,设置重构阈值的数学理论是方差最大化理论。在信号处理中,通常认为信号的方差较大,噪声的方差较小,信噪比就是信号与噪声的方差比,即信噪比越大越好。PCA也可看成逐一选取方差最大方向,即通过PCA投影后,保留方差较大的前几个特征向量,该做法与保留前几个最大特征值得到的特征向量等价。重构阈值的实质是低维空间方差和与高维空间方差和的百分比。在协方差矩阵中,方差可经奇异值或特征值解释,因此,重构阈值可表示为

式中,λd为高维特征协方差矩阵的第d个特征值,dhigh=r2K为高维空间的维数,dlow为低维空间的维数,t为重构阈值。可以发现,t越大,dlow也越大。

实验主要研究双波段场景图像数据集,不同波段具有不同的成像特性,且提取的特征为预训练深度CNN模型不同层的卷积特征。此外,数据集的样本数远小于卷积特征的维数,因此,从特征重构的角度出发,通过设置重构阈值计算低维特征空间的维度。重构阈值的大小直接影响了特征重构的质量,进而影响后续SVM的分类精度。

利用SVM计算后验概率前,采用L2范数归一化处理低维特征空间的每个样本,有利于计算两个样本之间的距离相似度。L2范数归一化方法首先计算每个样本的L2范数,然后将该样本中的元素除以该范数,归一化处理的目的是使每个样本的L2范数为1。令f'i=(f'1,f'2,…,f'

2.3 贝叶斯决策融合模型构建

SVM分类器通常产生模式识别中的类别标签,通过拟合Sigmoid模型的方法,可将SVM的无阈值输出转换为后验概率输出[26]。本方法采用基于线性核的SVM分别计算双波段图像中每个样本的后验概率,并通过朴素贝叶斯模型进行融合分类,得到双波段图像共同的分类标签。朴素贝叶斯模型是一种基于贝叶斯理论和条件独立性假设的分类方法。本方法将SVM分类器输出的后验概率作为先验概率,通过计算条件概率获得融合分类的后验概率,从而构建朴素贝叶斯决策融合模型,其后验概率的计算与分类过程如下。

假设ωk(k=1,2,…,c)为双波段图像数据集的样本类别,S={s1,s2},s1和s2为双波段图像对应的两个相互独立的SVM分类器,P(sm)为第m个SVM分类器将样本x标记为所有类别的后验概率。依据条件独立性假设,得到条件概率P(S⃓ωk)为

通过先验概率P(ωk)和条件概率P(S⃓ωk)计算用决策融合模型标记样本x的后验概率P(ωk⃓S),可表示为

式中,P(S)为s1和s2的联合概率,与ωk无关,可以忽略。则样本x对类别ωk的支持μk(x)可表示为

式中,∝为正比符号,样本x的最终类别为μ=(μ1,μ2,…,μc)中最大值对应的类别。贝叶斯决策融合方法在样本数为N的数据集上的具体实现:两个波段的分类器s1和s2通过测试样本集计算,分别获得一个c×c的混淆矩阵C1和C2。每个C的第(k,s)个元素

根据μ=(μ1,μ2,…,μc)的最大值规则,将样本x标记为类别ωk。

3 实验与分析

3.1 数据集与实验平台

实验采用的验证数据集是唯一公开的RGB-NIR双波段自然场景基准数据集[11],该数据集包含477对RGB-NIR图像,包括乡村(52)、田野(51)、森林(53)、室内(56)、山峰(55)、古老建筑(51)、街道(50)、城市(58)、水域(51)9类,括号中为每类样本的数量。虽然数据集的图像数量有限,但包含相互干扰、具有挑战性的类别,如乡村与田野、街道与城市。

仿真验证的硬件平台:处理器为2.8 GHz英特尔Core i7-7700HQ,内存为16 GB,显卡为NVIDIA GeForce 940MX。软件环境:系统为Windows10,集成开发环境为PyCharm 2.4,PCA和线性SVM算法的实现采用基于Python语言sklearn库集成PCA模块和SVM模块中核函数为“linear”的SVC模块,PCA和SVM的关键参数分别为维度因子ncom和惩罚因子C,其中,ncom的取值为(0,1),C=1为SVC模块的默认参数。贝叶斯决策融合模型中,C1和C2通过基于Python语言sklearn库集成confusion_matrix模块计算获得。深度学习框架采用前端Keras和后端TensorFlow平台,深度CNN模型为基于ImageNet预训练的VGG-16、VGG-19和ResNet-50模型。

3.2 实验结果与分析

1) PCA降维算法的性能评估

线性核SVM算法的时间复杂度与输入样本的特征维度成线性关系,因此降低输入样本的特征维度可加快分类速度。以重构阈值t为0.99的PCA方法对CNN特征进行降维,通过对比CNN原始特征和PCA降维特征的大小与分类精度,评估PCA降维方法的性能。

图 3. 两种特征的分类精度。(a)RGB图像;(b)NIR图像;(c)RGB-NIR图像

Fig. 3. Classification accuracies of the two features. (a) RGB image; (b) NIR image; (c) RGB-NIR image

表 2. VGG-16模型不同特征的维度

Table 2. Dimensions of different features of the VGG-16 model

|

2) 不同重构阈值的分类性能

为了分析不同重构阈值t对算法分类性能的影响,将基于1组重构阈值的PCA方法作用于VGG-16模型的各层卷积特征,分析基于单波段和双波段的场景分类精度。

图 4. 不同阈值对模型分类精度的影响。(a)C5层;(b)F6层;(c)F7层

Fig. 4. Influence of the different threshold value on model classification accuracy. (a) C5 layer; (b) F6 layer; (c) F7 layer

3) 基于不同CNN模型的分类性能

图 5. 不同CNN模型的分类精度。(a)VGG-16模型;(b)VGG-19模型;(c)ResNet-50模型

Fig. 5. Classification accuracies of different CNN models. (a) VGG-16 model; (b) VGG-19 model; (c) ResNet-50 model

表 3. 不同CNN模型在不同t时的分类精度

Table 3. Classification accuracies of different CNN models at different t unit: %

| |||||||||||||||||||||||||||||||||||||||||||||||||

4) 与其他方法的对比

实验选用PCA重构阈值t为0.99、ResNet-50模型G6层的融合方法与现有八种算法进行对比,包括四种基于传统特征的方法和四种基于CNN的方法。基于传统特征的方法包括基于多光谱SIFT的方法(MSIFT)[11]、基于Fisher Vector的方法(Fisher Vector)[12]、基于直方图统计变换的方法(mCENTRIST)[13]、基于密集SIFT和无字典模型的方法(DSIFT_CLM)[14];基于CNN的方法包括基于双CNN的方法(Dual CNN)[15]、基于核函数主成分分析和典型相关分析的方法(CNN_KPCA_CCA)[16]、基于多路CNN的方法(MCNN)[17]和基于双通道CNN的方法(DC_ CNN)[5],不同方法的双波段场景分类精度如

表 4. 不同方法在RGB-NIR数据集上的分类精度比较

Table 4. Classification accuracy comparison of different methods

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

图 6. 本方法的分类精度混淆矩阵。(a)20组中最好的分类精度(98.0%);(b)20组中最差的分类精度(88.9%)

Fig. 6. Classification accuracy confusion matrix of our method. (a) Best classification accuracy in the 20 groups (98.0%); (b) worst classification accuracy in the 20 groups (88.9%)

4 结论

在双波段图像缺少标注样本和特征级联融合分类精度不高的情况下,利用预训练的经典CNN模型提取卷积特征,通过PCA方法降维和SVM计算后验概率;采用朴素贝叶斯决策融合分类,避免了网络模型训练出现过拟合以及特征融合共同表示学习难的问题。实验结果表明,在场景分类中,双波段图像决策级融合分类性能明显优于单一波段分类和级联特征融合分类的性能。本方法在VGG-16模型第2个全连接层、ResNet-50模型全局平均池化层取得了最佳融合效果,与其他方法相比,具有分类精度高、处理速度快的优势,可适用于特殊领域数据样本少的计算机视觉任务。

[1] Krizhevsky A, Sutskever I, Hinton G E. ImageNet classification with deep convolutional neural networks[J]. Communications of the ACM, 2017, 60(6): 84-90.

[2] SimonyanK, ZissermanA. Very deep convolutional networks for large-scale image recognition[EB/OL]. [2020-06-15].http:∥arxiv.org/abs/1409. 1556.

[3] SzegedyC, VanhouckeV, IoffeS, et al.Rethinking the inception architecture for computer vision[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA.New York: IEEE Press, 2016: 2818- 2826.

[4] He KM, Zhang XY, Ren SQ, et al.Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA.New York: IEEE Press, 2016: 770- 778.

[5] Jiang J H, Feng X A, Liu F, et al. Multi-spectral RGB-NIR image classification using double-channel CNN[J]. IEEE Access, 2019, 7: 20607-20613.

[6] 刘峰, 沈同圣, 马新星. 特征融合的卷积神经网络多波段舰船目标识别[J]. 光学学报, 2017, 37(10): 1015002.

[7] Ding L, Wang Y, Laganière R, et al. Convolutional neural networks for multispectral pedestrian detection[J]. Signal Processing: Image Communication, 2020, 82: 115764.

[8] Zhang Q, Huang N C, Yao L, et al. RGB-T salient object detection via fusing multi-level CNN features[J]. IEEE Transactions on Image Processing, 2020, 29: 3321-3335.

[9] Zhang X C, Ye P, Peng S Y, et al. DSiamMFT: an RGB-T fusion tracking method via dynamic Siamese networks using multi-layer feature fusion[J]. Signal Processing: Image Communication, 2020, 84: 115756.

[10] Xie L, Lee F, Liu L, et al. Scene recognition: a comprehensive survey[J]. Pattern Recognition, 2020, 102: 107205.

[11] BrownM, SüsstrunkS. Multi-spectral SIFT for scene category recognition[C]∥CVPR 2011, June 20-25, 2011, Providence, RI, USA.New York: IEEE Press, 2011: 177- 184.

[12] SalamatiN, LarlusD, CsurkaG. Combining visible and near-infrared cues for image categorisation[C]∥22nd British Machine Vision Conference (BMVC 2011), August 30-September 1, 2011, Dundee, Scotland.UK: BMVA Press, 2011: 1- 11.

[13] Xiao Y, Wu J X. Yuan J S. mCENTRIST: a multi-channel feature generation mechanism for scene categorization[J]. IEEE Transactions on Image Processing, 2014, 23(2): 823-836.

[14] 张秋实, 李伟, 李禄, 等. 基于无字典模型的红外与可见光图像融合分类[J]. 北京化工大学学报(自然科学版), 2018, 45(2): 71-76.

Zhang Q S, Li W, Li L, et al. Infrared and visible image fusion classification based on a codebookless model(CLM)[J]. Journal of Beijing University of Chemical Technology (Natural Science Edition), 2018, 45(2): 71-76.

[15] ŠevoI, AvramovićA. Multispectral scene recognition based on dual convolutional neural networks[C]∥Proceedings of the 10th International Symposium on Image and Signal Processing and Analysis, September 18-20, 2017, Ljubljana, Slovenia.New York: IEEE Press, 2017: 126- 130.

[16] Peng X S, Li Y X, Wei X, et al. RGB-NIR image categorization with prior knowledge transfer[J]. EURASIP Journal on Image and Video Processing, 2018, 2018(1): 1-11.

[17] 江泽涛, 秦嘉奇, 胡硕. 基于多路卷积神经网络的多光谱场景识别方法[J]. 计算机科学, 2019, 46(9): 265-270.

Jiang Z T, Qin J Q, Hu S. Multi-spectral scene recognition method based on multi-way convolution neural network[J]. Computer Science, 2019, 46(9): 265-270.

[18] YosinskiJ, CluneJ, BengioY, et al. How transferable are features in deep neural networks? [EB/OL]. [2020-06-13].https:∥arxiv. org/abs/1411. 1792v1.

[19] Zhao H H, Liu H. Multiple classifiers fusion and CNN feature extraction for handwritten digits recognition[J]. Granular Computing, 2020, 5(3): 411-418.

[20] Woźniak M, Graña M, Corchado E. A survey of multiple classifier systems as hybrid systems[J]. Information Fusion, 2014, 16: 3-17.

[21] Zeng H, Yang B, Wang X Q, et al. RGB-D object recognition using multi-modal deep neural network and DS evidence theory[J]. Sensors, 2019, 19(3): 529.

[22] 唐聪, 凌永顺, 杨华, 等. 基于深度学习的红外与可见光决策级融合检测[J]. 红外与激光工程, 2019, 48(6): 456-470.

Tang C, Ling Y S, Yang H, et al. Decision-level fusion detection for infrared and visible spectra based on deep learning[J]. Infrared and Laser Engineering, 2019, 48(6): 456-470.

[23] Bengio Y, Courville A, Vincent P. Representation learning: a review and new perspectives[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 35(8): 1798-1828.

[24] Zeiler MD, FergusR. Visualizing and understanding convolutional networks[EB/OL]. [2020-06-15].https:∥arxiv.org/abs/1311. 2901.

[25] 周志华. 机器学习[M]. 北京: 清华大学出版社, 2016: 229- 232.

Zhou ZH. Machine learning[M]. Beijing: Tsinghua University Press, 2016: 229- 232.

[26] Lin H T, Lin C J, Weng R C. A note on Platt's probabilistic outputs for support vector machines[J]. Machine Learning, 2007, 68(3): 267-276.

邱晓华, 李敏, 张丽琼, 董琳. 基于卷积特征和贝叶斯决策的双波段场景分类[J]. 激光与光电子学进展, 2021, 58(4): 0415006. Xiaohua Qiu, Min Li, Liqiong Zhang, Lin Dong. Dual-Band Scene Classification Based on Convolutional Features and Bayesian Decision[J]. Laser & Optoelectronics Progress, 2021, 58(4): 0415006.