基于区域先验信息的去遮挡立体匹配算法  下载: 1271次

下载: 1271次

1 引言

双目立体视觉是一种系统简洁、非主动的三维成像测量方式,广泛用于交互式机器人导航、自动驾驶、三维重建等众多领域[1-2]。在双目立体视觉中,通过在极线上搜索相同图像元素实现视差信息测量的过程被称为立体匹配[3],其测量精度直接决定着双目立体视觉系统的性能,因此受到了国内外科研工作者的广泛关注。

立体匹配作为计算机视觉领域的基础性问题之一,经历了多年的发展,还存在许多问题亟待解决,如:光学失真、噪声干扰、弱纹理、重复纹理、透视失真、遮挡等[4]。其中遮挡问题是指相机成像时,空间上一个物体表面被另一物体遮挡,导致物体被遮挡区域只能被单个相机成像,而在另一相机中搜索不到对应的图像信息。遮挡像素没有严格意义的匹配点,使得无法准确获得理论意义上的视差信息,进而可能严重降低双目立体视觉系统测量精度。为解决遮挡问题带来的负面影响,Bobick等[5]提出了加入顺序约束条件的动态规划算法,但该方法受限于物体的大小,无法有效处理孔状和窄物体区域。此外,该方法需要对遮挡区域进行代价惩罚,修改后的代价函数对正确匹配像素的敏感性变低。Egnal等[6]基于唯一性约束条件提出了交叉验证算法,该方法受限于唯一性约束,无法用于水平倾斜表面。Kolmogorov等[7]使用基于马尔可夫随机场(MRF)的代价函数来惩罚遮挡像素,该算法对遮挡像素的惩罚依赖于唯一性约束。Ho等[8]使用扭曲约束和左右一致性检验,在不变空间置信度传播(CSBP)算法的基础上处理遮挡问题。该方法速度快,但因受到CSBP算法的限制,误匹配率高。Liu等[9]采用两步局部法处理遮挡问题,该方法首先依据对比度直方图计算初始匹配代价,然后使用基于分割的自适应支持权重法进行代价聚合。该方法需要准确检测出被遮挡的区域,而如何得到准确的区域信息是当前研究的一大难点。Oh等[10]提出了一种基于图和曲面模型处理遮挡问题的方法,该方法利用顺序约束和分割约束建立图模型检测遮挡区域,使用曲面模型估计倾斜面遮挡视差。Jang等[11]提出了一种检测和细化遮挡区域的方法,采用曲面模型、交叉验证和亮度差约束条件共同优化代价函数,该方法具有优异的遮挡检测效果,但是时间复杂度较高。

本文以视差的局部平滑特性作为约束条件,提出了一种基于区域先验信息的去遮挡立体匹配算法。相较于现有的方法,本文提出的算法通过在代价计算中引入区域信息,使得代价函数保留了对非遮挡区域的高敏感性,同时对遮挡区域表现出低敏感性,从而有效降低遮挡区域的误匹配率。

2 基于区域先验信息的去遮挡立体匹配算法

本文方法整体流程分为以下几个步骤:1)聚类同质区域;2)以区域信息修正代价函数;3)使用区域一致性检测修正遮挡和误匹配像素,获得精确视差图。本节将详细介绍引入区域先验信息的代价函数和区域一致性检测法。

为聚类同质区域,利用Canny算子[12]提取获得的边缘信息作为区域生长[13]的停止条件。本文方法通过随机初始化种子点实现区域生长,当区域生长的边界与Canny算子得到的边缘重合,且重合边缘的八邻域不包含Canny边缘点时,停止生长,即可获得原始图像各个同质区域。为避免Canny算子获得的边缘无法形成闭合曲线,区域生长法的原始停止条件仍保留使用。记原始图像全图区域为

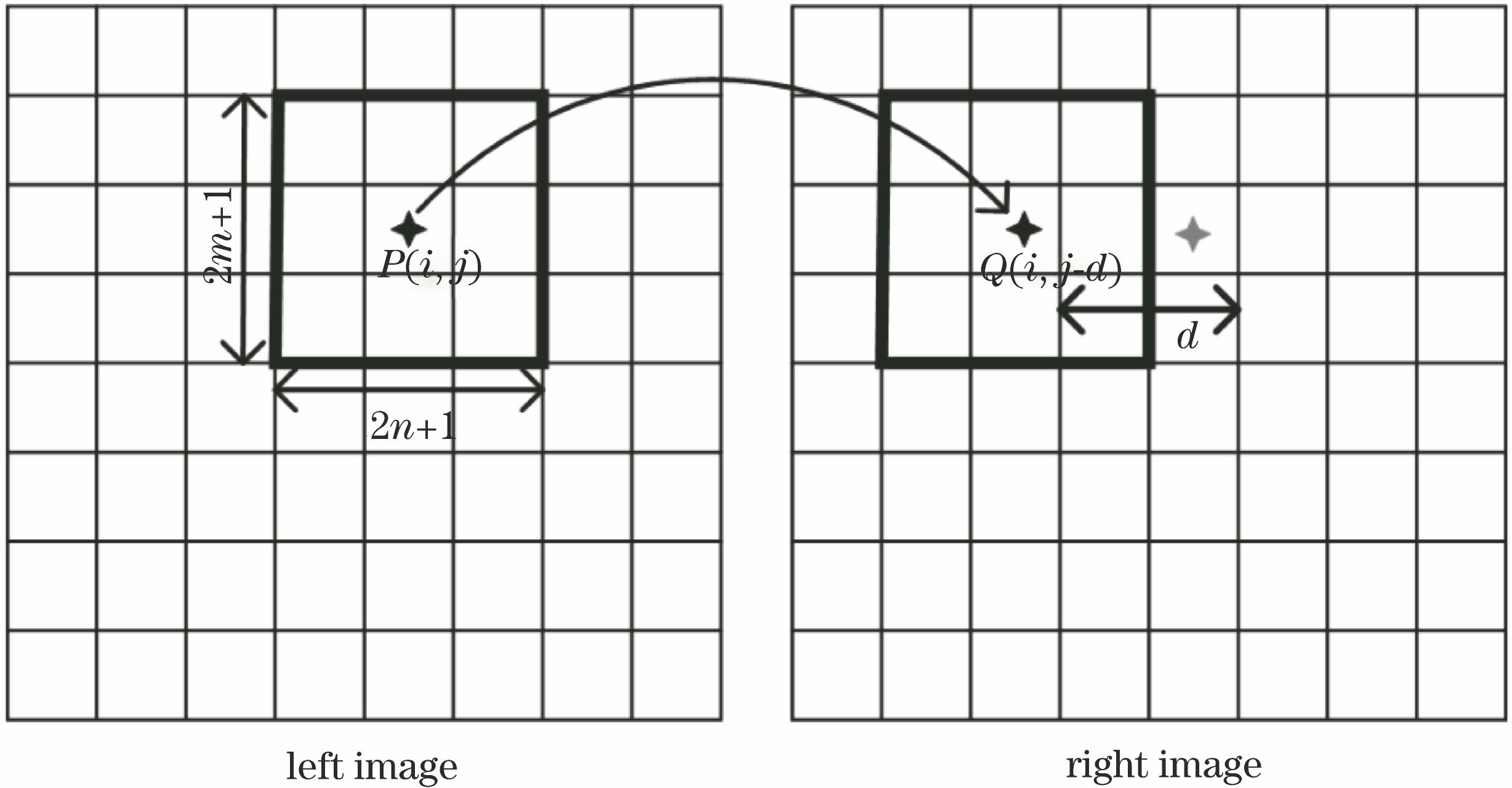

2.1 匹配代价计算

代价函数被用来度量同一场景不同视场的两幅图像中对应像素之间的相似性。代价函数的流程如

式中:

式中:

由于单个像素的匹配代价区分度不强,且易受噪声影响,故需要对获得的代价进行代价聚合[14]。基于局部视差平滑性假设,代价聚合利用相邻像素信息进行滤波,提高了视差区分度。引导滤波[15-16]通过引入引导图像,在滤除噪声的同时保留丰富的边缘细节信息。采用引导滤波进行代价聚合,记输入灰度图像为

式中:

式中:|

在代价聚合之后,使用WTA(winner take all)进行视差选取,获得初始视差图

2.2 视差精化

通过上述方法获得的初始视差图在遮挡区域和边缘位置区域依然存在着大量的误匹配像素。如

图 2. 视差精化示意图 (a)左右一致性检测;(b)区域一致性检测

Fig. 2. Disparity refinement diagrams. (a) Left-right consistency check; (b) regional consistency check

3 实验结果及分析

基于Matlab平台,采用Middlebury公开数据集进行评测。为减小计算量,首先对原始图像进行2倍下采样。实验中,归一化互相关(NCC)算法的窗口大小为9×9,区域一致性检测的像素差为3,Canny边缘检测的阈值为0.2,权重系数

遮挡的出现常伴随空间深度的变化,当空间物体的深度信息发生跳变时,形成遮挡的概率更大。同时基于几何光学原理,当左右两相机固定时,空间物体的深度信息突变越大,形成的遮挡区域越大。

图 3. 遮挡距离解释图。(a)参考图; (b)目标图

Fig. 3. Occlusion distance interpretation diagrams. (a) Reference image; (b) target image

图 4. 仿真展示图。(a)左图;(b)真值图;(c) NCC残差图;(d)本文算法残差图

Fig. 4. Simulation results. (a) Left images; (b) ground truths; (c) residual figures of NCC; (d) residual figures of proposed algorithm

表 1. 左右图存在大量遮挡的误匹配率

Table 1. Mismatching rates of left and right figures with large occlusion%

|

此外,本文算法是一种加性算法,可以方便地用于现有立体匹配算法中,以改善原始算法的匹配效果。通过将本文算法融合到NCC、绝对误差和算法(SAD)[18]、误差平方和算法(SSD)[19]中进行实验检验,并使用Middlebury的数据进行测试,结果如

表 2. 左右图存在较少遮挡的误匹配率

Table 2. Mismatching rates of left and right figures with less occlusion%

|

表 3. 原始算法与引入本文算法后的误匹配率

Table 3. Mismatching rates of original algorithm and proposed algorithm%

|

4 结论

提出一种基于区域先验信息的立体匹配算法,该方法同时具有对非遮挡区域的高敏感度和对遮挡区域的低敏感度。实验表明,本文方法通过在代价计算和视差精化中引入区域先验信息,能有效降低遮挡区域的误匹配率。此外,本文算法作为一种加性算法,可以方便地融入到其他立体匹配算法中,从而改善原始算法在遮挡区域的匹配效果,降低原始算法在遮挡区域的误匹配率。

[1] 许金鑫, 李庆武, 刘艳, 等. 基于色彩权值和树形动态规划的立体匹配算[J]. 光学学报, 2017, 37(12): 1215007.

[2] 卢迪, 林雪. 多种相似性测度结合的局部立体匹配算法[J]. 机器人, 2016, 38(1): 1-7.

Lu D, Lin X. A local stereo matching algorithm based on the combination of multiple similarity measures[J]. Robot, 2016, 38(1): 1-7.

[3] BleyerM,[\s]{1}BreitenederC.[\s]{1}Stereo[\s]{1}matching-state-of-the-art[\s]{1}and[\s]{1}research[\s]{1}challenges[M][\s]{1}∥[\s]{1}Farinella[\s]{1}G,[\s]{1}Battiato[\s]{1}S,[\s]{1}Cipolla[\s]{1}R.[\s]{1}Advanced[\s]{1}topics[\s]{1}in[\s]{1}computer[\s]{1}vision.[\s]{1}London:[\s]{1}Springer,[\s]{1}2013:[\s]{1}143-[\s]{1}179.[\s]{1}

[4] 隋婧, 金伟其. 双目立体视觉技术的实现及其进展[J]. 电子技术应用, 2004, 30(10): 4-6, 12.

Sui J, Jin W Q. Implementation and development of binocular stereo vision technology[J]. Application of Electronic Technique, 2004, 30(10): 4-6, 12.

[5] Bobick A F, Intille S S. Large occlusion stereo[J]. International Journal of Computer Vision, 1999, 33(3): 181-200.

[6] EgnalG,[\s]{1}Wildes[\s]{1}RP.[\s]{1}Detecting[\s]{1}binocular[\s]{1}half-occlusions:[\s]{1}empirical[\s]{1}comparisons[\s]{1}of[\s]{1}four[\s]{1}approaches[C]∥2000[\s]{1}IEEE[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition,[\s]{1}June[\s]{1}15-15,[\s]{1}2000,[\s]{1}Hilton[\s]{1}Head[\s]{1}Island,[\s]{1}USA.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2002:[\s]{1}466-[\s]{1}473.[\s]{1}

[7] Kolmogorov V, Zabih R. Computing visual correspondence with occlusions using graph cuts[J]. Phd Thesis Stanford Univ, 2013, 2: 508-515.

[8] Ho[\s]{1}YS,[\s]{1}Jang[\s]{1}WS.[\s]{1}Occlusion[\s]{1}detection[\s]{1}using[\s]{1}warping[\s]{1}and[\s]{1}cross-checking[\s]{1}constraints[\s]{1}for[\s]{1}stereo[\s]{1}matching[M][\s]{1}∥Jin[\s]{1}J[\s]{1}S,[\s]{1}Xu[\s]{1}C[\s]{1}S,[\s]{1}Xu[\s]{1}M.[\s]{1}The[\s]{1}era[\s]{1}of[\s]{1}interactive[\s]{1}media.[\s]{1}New[\s]{1}York:[\s]{1}Springer,[\s]{1}2013:[\s]{1}363-[\s]{1}372.[\s]{1}

[9] Liu[\s]{1}TL,[\s]{1}Zhang[\s]{1}PZ,[\s]{1}Luo[\s]{1}LM.[\s]{1}Dense[\s]{1}stereo[\s]{1}correspondence[\s]{1}with[\s]{1}contrast[\s]{1}context[\s]{1}histogram,[\s]{1}segmentation-based[\s]{1}two-pass[\s]{1}aggregation[\s]{1}and[\s]{1}occlusion[\s]{1}handling[M][\s]{1}∥Wada[\s]{1}T,[\s]{1}Huang[\s]{1}F,[\s]{1}Lin[\s]{1}S.[\s]{1}Advances[\s]{1}in[\s]{1}image[\s]{1}and[\s]{1}video[\s]{1}technology.[\s]{1}Berlin,[\s]{1}Heidelberg:[\s]{1}Springer,[\s]{1}2009:[\s]{1}449-[\s]{1}461.[\s]{1}

[10] Oh J D. Kuo C C J. Robust stereo matching with improved graph and surface models and occlusion handling[J]. Journal of Visual Communication and Image Representation, 2010, 21(5/6): 404-415.

[12] CannyJ.[\s]{1}A[\s]{1}computational[\s]{1}approach[\s]{1}to[\s]{1}edge[\s]{1}detection[M][\s]{1}∥Fischler[\s]{1}M[\s]{1}A,[\s]{1}Firschein[\s]{1}O.[\s]{1}Readings[\s]{1}in[\s]{1}computer[\s]{1}vision.[\s]{1}San[\s]{1}Francisco:[\s]{1}Morgan[\s]{1}Kaufmann,[\s]{1}1987:[\s]{1}184-[\s]{1}203.[\s]{1}

[13] 李仁忠, 刘阳阳, 杨曼, 等. 基于改进的区域生长三维点云分割[J]. 激光与光电子学进展, 2018, 55(5): 051502.

[14] 闫利, 王芮, 刘华, 等. 基于改进代价计算和自适应引导滤波的立体匹配[J]. 光学学报, 2018, 38(11): 1115007.

[16] 刘杰, 张建勋, 代煜, 等. 基于跨尺度引导图像滤波的稠密立体匹配[J]. 光学学报, 2018, 38(1): 0115004.

[17] Zhang Z Y, Deriche R, Faugeras O, et al. A robust technique for matching two uncalibrated images through the recovery of the unknown epipolar geometry[J]. Artificial Intelligence, 1995, 78(1/2): 87-119.

[19] Scharstein D, Szeliski R, Zabih R. A taxonomy and evaluation of dense two-frame stereo correspondence algorithms[J]. International Journal of Computer Vision, 2002, 47(1/2/3): 7-42.

Article Outline

陈先锋, 郭正华, 伍俊龙, 马帅, 杨平, 许冰. 基于区域先验信息的去遮挡立体匹配算法[J]. 激光与光电子学进展, 2019, 56(19): 191001. Xianfeng Chen, Zhenghua Guo, Junlong Wu, Shuai Ma, Ping Yang, Bing Xu. De-Occlusion Stereo Matching Algorithm Based on Regional Prior Information[J]. Laser & Optoelectronics Progress, 2019, 56(19): 191001.