基于多特征描述子自适应权重的文物碎片分类  下载: 739次

下载: 739次

1 引言

文物是古代留下来的具有历史、艺术与科学价值的文化遗产,从不同的侧面反映了当时人类社会的发展情况。进行文物的保护与管理,对认识历史、揭示人类社会发展规律、认识并促进当代社会发展都具有重要的意义。在文物碎片的发掘与开采过程中,对大量的碎片进行手工分类与拼接费时费力,因此,使用计算机图形学、三维点云处理算法与深度学习的方法对文物碎片进行分类具有重要的意义。

点云模型分类问题主要包括特征提取与描述、特征相似度度量及分类。针对点云模型的特征提取,国内外学者已经开展了大量的研究。现有的三维特征描述子主要分为两类:基于全局特征的描述子和基于局部特征的描述子。在特征提取方面,王飘等[1]提取了文物表面纹理特征,对文物进行特征描述,由于仅提取了单一特征,所以对部分表面光滑的碎片分类效果不佳。Salti等[2]提出的SHOT局部描述子使用局部参考坐标系(LRF)描述特征点的局部曲面,采用局部直方图形式进行编码,并描述了特征的分布情况,有较强的区分性与鲁棒性,但特征维度较高会导致匹配效率降低。Yang等[3]提出的TOLDI描述子建立LRF,从三个正交视图平面投影捕获局部深度图像,连成一维直方图来进行特征描述,取得了很好的效果。刘剑等[4]提出了一种全新的FPFH描述子与Delaunay三角剖分相结合,用于三维点云的配准。Kleppe等[5]提出了一种基于形状因子选择关键点的方法,用来识别由点云表示对象的不同特征点,然后通过描述拟合平面的局部曲率计算出每个关键点的描述符。但使用的描述子核心是计算特征点拟合平面的局部曲率,计算量相对较大且易受噪声影响。Beksi等[6]提出了一种基于拓扑的三维点云描述子STPP,通过计算点云模型的第0同调群和第1同调群的拓扑不变量构造STPP描述子。不需要预处理,仅使用单个调优参数就能完成特征描述。这是一种全局特征描述子,对于整体形状差异较大的点云模型有较好的分类与识别效果,但不适用于文物碎片。

针对提取的各种特征,目前多是使用深度学习方法进行分类。何志超等[7]提出了一种多分辨率特征融合的卷积神经网络,利用两个相互独立且深度不同的通道对图片进行特征提取,使卷积神经网络自主学习同一图像下不同分辨率的特征。刘峰等[8]提出了一种基于VGG-16网络的显著性检验方法。在全局模型中通过对VGG-16网络设计额外的卷积层进行训练,生成初始显著图,达到从图像整体角度预测每一个候选区域显著性的目的。杨军等[9]使用深度体素卷积神经网络,提取体素深层特征对三维模型进行分类。白静等[10]提出了一种基于卷积神经网络(CNN)和投票机制的三维模型检索算法,将三维模型转化为二维视图,基于深度学习模型CaffeNet完成分类。Charles等提出了点云神经网络PointNet[11]与PointNet++[12]。点云神经网络PointNet通过训练大量带标签数据进行分类,可直接输入点云数据,在ModelNet40公用数据集上取得较好的分类效果。但由于文物碎片数据的特殊性,无法获取大量带标签碎片数据进行训练,且经过测试发现分类准确率较低。

传统的分类方法大多通过提取单一全局几何特征或局部特征进行匹配并分类,但文物碎片由于年代久远,且在开采出土之后大多存在残缺现象。使用全局特征作为分类判别特征会忽略文物碎片局部的几何特征,而单一描述子都具有一定的局限性,分类效果较差。

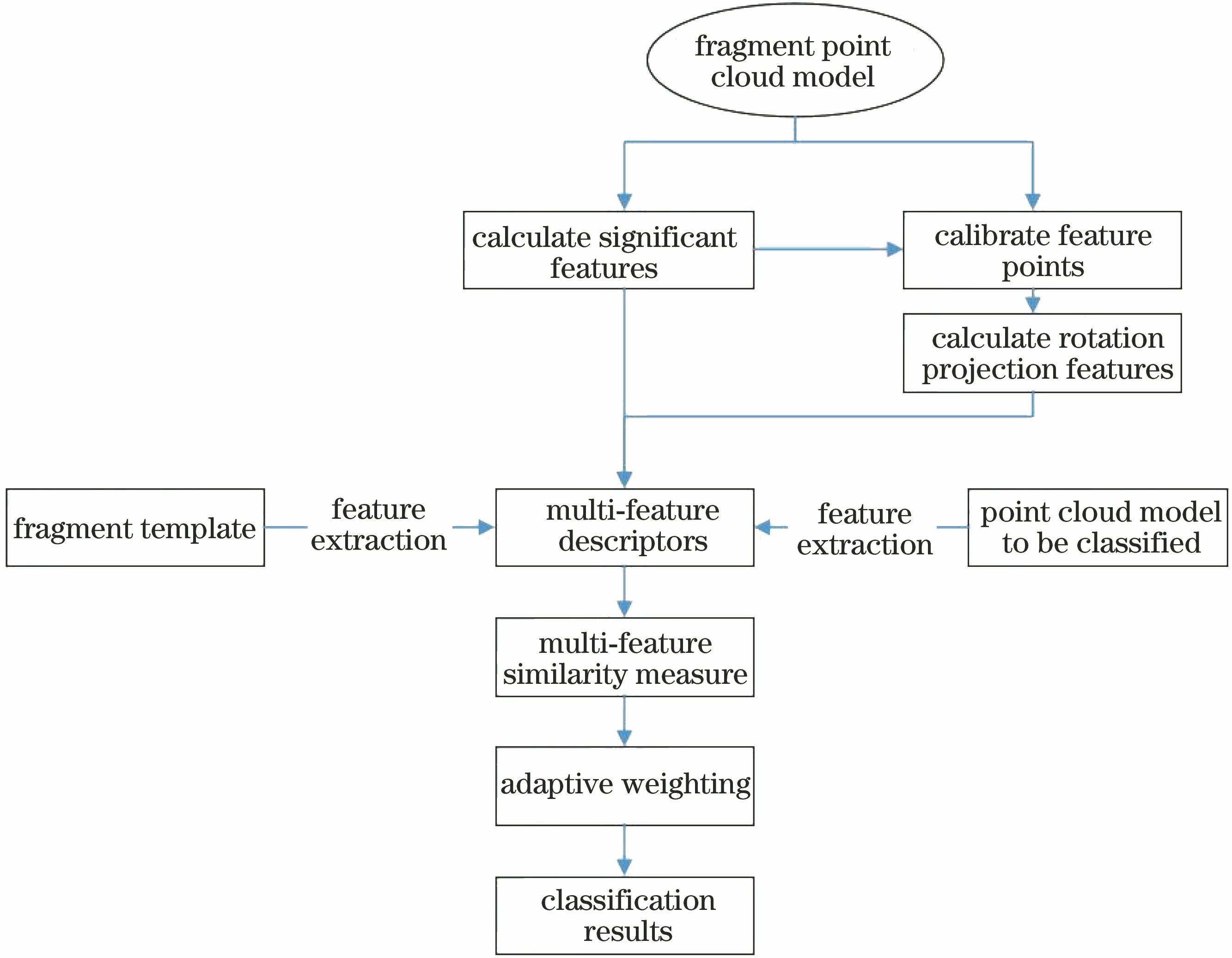

针对上述问题,提出一种多特征描述方法,用局部点云信息与显著性多特征描述子对兵马俑碎片进行特征描述,并提出了一种针对两种特征的自适应权值相似度度量算法,最后建立各部位特征模板库并进行了分类测试。实验对象为在K9901号百戏俑坑与兵马俑2号坑实地采集的兵马俑碎片点云数据,经实验验证分类效果良好。

2 特征描述子生成

局部表面特征描述子可以描述当前特征点的局部表面,选定合适的分类特征是分类的关键。文物碎片的特点是形状不一、大小不一,大部分存在破损情况,且不同位置的特点各不相同。如手、脚有明显的几何特征,而躯体部分则多是光滑的碎片。文物碎片部分属于薄壁文物,如古字画、壁画;部分属于非薄壁文物,如兵马俑铠甲碎片。现有的三维描述子很难完整地描述文物碎片特征。因此,首先提取文物碎片表面的局部显著特征,然后结合局部显著特征标定特征点,同时提取特征点局部曲面的旋转投影特征,用来描述文物碎片的局部特征,可以弥补单一描述子信息量不足的缺陷,同时提高算法的匹配度和分类的准确性,算法步骤流程图如

2.1 旋转投影特征

旋转投影特征[13-15]是一种常用的局部特征,核心思想是通过建立特征点的局部参考坐标系,对点云的局部曲面进行旋转并投影,将三维点云转换为一系列具有深度信息的二维图像,然后提取其特征,形成相对应的特征编码。旋转投影特征具有良好的旋转平移不变性,同时可以获取点云的深度与局部曲面点云的密度信息。

2.1.1 建立LRF局部参考坐标系

首先提取点云中的特征点p,并构建相对应LRF。选取特征点p及其相对应的描述半径r,可以构成一个局部表面Q={qi| || p -qi||≤r,1≤i≤N},其中Q为当前点云的局部表面,N为当前的点云局部表面中点云中点的总数,qi为当前特征点p在局部表面中的第i个邻域点。协方差矩阵C由局部表面Q中的所有点计算

式中wi为影响局部参考坐标系稳定的权值,实验中选择较为稳定的线性加权方式。

式中‖p-qi‖为点p到qi的欧氏距离。通过点云局部表面的协方差矩阵,可直接计算出当前协方差矩阵的三个特征向量n1,n2,n3,分别构成当前LRF的三个坐标轴。

2.1.2 旋转投影

选定特征点p,将特征点的邻域点qi绕建立好的局部参考坐标系的第j个轴旋转n次,j为LRF各坐标轴的标号,n为旋转的总次数,每次旋转角度为θ,n与θ满足0≤nθ≤90°。将每次旋转后的对应点云投影到平面l上,其中l∈{yz,xy,xz},旋转投影结束。此时绕每个坐标轴投影3×n次,共投影3×3×n次,得到3×3×n个带有深度信息的图像。

将投影得到的二维图像块离散化为M×M的网格,记作Gcjl

式中,XGrid[]为对二维图像块进行离散化网格操作,X为投影得到的二维图像,c为当前投影图像旋转的次数,j为当前投影图像旋转所绕的坐标轴,l为当前投影图像所投影到的平面。投影落入网格Gcjl(m,n)内的局部旋转点云Qθj的子集为

式中m,n为离散化之后的网格中对应的小网格坐标,1≤m,n≤M。

式中,D(m,n)为局部旋转点云投影Qθj落入各个网格的点云数量,XCou[]为计算得到各个网格中点云点的数量,此处为点云的密度信息图像块。

定义点云的深度信息图像块I(m,n)的每个像素值为离视点距离最近的两点深度的平均值,即

式中,di=XDep(qi),di≤dj,i≤j|qi∈Qcjl(m,n)为投影点云落入对应的小网格内的点云子集的深度集合,XDep[]为当前点到点云视点的欧氏距离,r为所选取的特征半径。

将得到的二维图像块进行归一化处理,然后使用CS-LBP[16]方法对每个特征点的每个图像块用编码并连在一起进行二进制描述,文中将CS-LBP搜索半径固定为2。编码得到144位的二进制串,包含特征点局部表面的点云深度与局部曲面点的密度信息。

2.2 局部显著特征

部分文物碎片,例如兵马俑头部碎片(

Mérigot等[17]使用卷积协方差矩阵计算出点云模型表面的曲率、方向,可提取表面尖锐显著特征。曲率可以很好地描述曲面的梯度,在处理多尺度图像时具有旋转平移不变性,但容易受到噪声扰动,不适用于形状大小不一且噪声较多的文物碎片。因此提出一种基于积分不变量值生成连通点集并计算其显著程度的方法,用来描述碎片的局部显著特征并进行匹配。

2.2.1 显著特征定义

式中,Bd(p)为在特征点p处建立半径值为d的球体,若以特征点p为球心的球体上的某一点在D以内,χD取1,否则取0。

设特征点p处的凹凸度XBul(p)为

式中,Vr(p)为以p为球心半径为r的球体在点云区域D内的体积与球体体积的比值,当平面完全光滑时,这个值无限趋近于0.5。积分不变量包含了当前特征点局部曲面的曲率信息,故XBul(p)能直观反映出当前特征点p的凹凸程度,从而判断显著程度。值越大表示越凸,值越小表示越凹。

2.2.2 显著特征提取

计算点云上每个点的凹凸度,用XBul(pi)表示当前点云上每个点pi的凹凸程度。不同碎片点云的特征点数量不同,得到的特征向量的维度也不相同,且点云中点的数量过多会造成计算效率低下,故需要对提取到的局部显著特征进行处理。

首先将每个点云的特征向量XBul={XBul(p1),XBul(p2),…,XBul(pn)}按照凹凸程度递减排序。对得到的特征向量,使用K-means聚类方法进行聚类,计算出k个局部显著特征,即碎片点云表面上最凸的点和最凹的点会被分开并聚类在一起。

在K-means聚类方法中,聚类中心数量k的选择非常关键,不同的k值会影响聚类的结果与算法的稳定性,文中使用轮廓系数法对k值的选择进行优化。

将某个样本点轮廓系数定义为

式中,Xnearlen(i)为当前特征向量中XBul(pi)与最近的聚类簇中所有样本的平均距离,表示样本的分离度。Xavglen(i)为XBul(pi)与同簇中其他样本的平均距离,表示样本的凝聚度。最近簇定义为

式中,XBul(pk)为某个簇Ck的样本,用XBul(pi)到某个簇所有样本的平均距离衡量该点到该簇的距离,选择距离XBul(pi)最近的一个簇作为最近簇。

指定2≤k≤int(

3 碎片相似度度量

提取碎片的旋转投影特征与局部显著特征,共同作为局部点云信息与显著性多特征描述子的匹配判别特征。

3.1 旋转投影特征相似度

旋转投影特征的相似度可以使用Hamming距离进行判断,即比较两个等长的二进制串,以及对应位置值不同的个数,进行相似性度量,实验中用于旋转投影特征的匹配。在结果中统计1出现的次数,以此衡量两个二进制串的相似度,出现的次数越多表示相似程度越低。两个碎片点云的相似度度量流程:

1) 获取两个点云的特征点,为保证用较少的特征点进行特征描述,结合局部显著特征的计算结果和均匀采样法进行选点,一部分选取XBul(pi)={XBul(p1),XBul(p2),…,XBul(pn)}集合中前20%与后20%的XBul(pi)对应的点pi,因为实验发现这些点包含点云中大部分的表面几何信息;另一部分则采用均匀采样法选择数量相等的点,共采样n个特征点。

2) 计算两个点云所有特征点的旋转投影特征,按先后顺序将编码完成的二进制串存储起来。

3) 使用暴力搜索的方法并结合交叉验证方法,计算两个点云之间每个点对的Hamming距离,选择相距距离最小的作为匹配点,匹配完成后使用随机采样一致性(RANSAC)的方法筛选出错误匹配点并去除。

在暴力搜索完成之后计算得到两个点云的相似度为

式中,Q1、Q2分别为正在比较的两个点云,pi、pj分别为点云的当前特征点。

3.2 局部显著特征相似度

对于局部显著特征的相似度,聚类后不具有连通性,不同部位的凹凸度近似的点会被聚类到一个簇,如果直接进行匹配会造成很大程度的误匹配。实验数据显示,在聚类完成后,计算结果中显著点集区间的范围为前20%与后20%的簇中的点,包含了大部分当前点云的表面几何信息。算法步骤包括:

1) 在聚类完成的聚类结果集合{C1,C2,…,Ck}中,首先选择前20%的簇{C1,…,Ci},i=int(

2) 依次访问起始点的邻接点,将其存储在动态数组vec中。若其邻接点未被访问过且存在于hash表中,则删除该点,并将该点作为下一个起始点,递归执行步骤2)进行扩张搜索。

3) 上述步骤递归运行完毕后,vec中的点构成一个连通的局部显著特征点集{p1,p2,…,pn},保存当前点集并将vec置空。继续在hash表中选择下一个点进行步骤2),直至hash表为空,得到当前点云的所有连通局部显著特征点集。

4) 每个点集所构成的曲面表示一部分连通的表面局部显著特征,当前点集的显著程度L表示为

式中,D(p)为当前点集的方差,C(p)为当前点集中最大与最小积分不变量的数量。计算每个点集的显著程度L,递减排序之后标号并存储,得到当前点云的特征向量{L1,L2,…,Ln}。

5) 相似度度量是通过计算其显著程度特征向量之间的欧氏距离得到的。若两个点云Q1,Q2的特征向量维度不同,则对维数较多的那个进行归一化操作后再进行相似度度量。计算出欧氏距离dim(Q1,Q2)后,使用dim(Q1,Q2)作为相似度度量的标准,数值越大表示两个点云的相似程度越低。将待分类碎片与模板库中每个碎片匹配完成之后,对匹配结果进行归一化处理并作为相似度标准。

3.3 自适应权值计算

在两个特征都描述完成之后,与模板库中的碎片进行匹配。匹配完成之后,需要计算出一个值把两个度量结果结合起来用于描述整体的相似程度。实验过程中,度量结果的数值区间相差很大,不能用常量进行加权计算。因此提出一种自适应加权的方法对相似度计算结果进行加权。

1) 当待分类碎片与模板库中各碎片完成相似度度量之后,把每个特征相似度度量的结果按列排好,计算出其中心值。

2) 求出每列的每个特征值距其特征中心值的距离和W1与W2,对其距离和进行归一化操作得到每列属性值的权重,分别为

根据上述方法,每次有新的待分类碎片需要与模板特征库中的特征进行匹配时,可以根据相似度度量结果,得到对应的自适应权值。提高了相似度度量效率的同时还具有良好的扩展性,在提取的特征种类增多时仍然适用。

4 实验及结果分析

实验工具采用Matlab与Visual Studio 2013,Visual Studio配置了开源点云库PCL(Point Cloud Library),使用C++实现算法,PC配置:CPU为Intel Core2 Quad Q9400,内存为4 G。实验数据为兵马俑碎片点云模型,所有兵马俑碎片点云数据均利用Artec3D扫描仪在K9901号百戏俑俑坑与兵马俑2号坑扫描获得。

根据已标定好的部位数据集,将兵马俑碎片分为5类,分别为头部、手部、腿部与脚部、下身部、上身部。下身部主要包括兵马俑的裙摆,上身部主要包括兵马俑的铠甲。每个部位选定30块相对完整且特征显著的碎片作为部位模板库,提取其局部显著特征与旋转投影特征。

图 4. 特征计算。(a) G10-19-15(38)原始碎片;(b) G10-19-15(38)局部显著特征

Fig. 4. Feature computation. (a) G10-19-15(38) original fragment; (b) G10-19-15(38) local significant feature

表 4. 特征描述子对比数据

Table 4. Feature descriptor comparison

|

表 1. 碎片连通性计算结果

Table 1. Fragment connectivity calculation result

|

从

表 3. 分类准确率

Table 3. Classification accuracy

|

表 2. 分类结果

Table 2. Classification result

|

表 5. FPFH分类准确率

Table 5. FPFH classification accuracy

|

将计算出的凹凸性显著的特征点与均匀采样的结果作为特征点计算出旋转投影特征的编码结果并保存。其中旋转投影特征的计算参数中旋转次数设为1次,特征描述半径为30 mr,RANSAC阈值为10 mr,最大迭代次数为30000,CS-LBP编码固定搜索半径为2。旋转投影特征虽然采用的是暴力搜索,在选点时过程中耗时较长,但匹配时采用Hamming距离大大提高了算法的效率。旋转投影特征的编码完成后得到144位二进制串,将其存储于对应模板的特征库中。

在已分类并标注的模板库中随机选择各部位碎片作为测试集,因碎片数据较少,所以采用多倍交叉验证的方法进行测试。测试集包括两部分:第一部分是经过考古学专家鉴定并分类完毕的文物碎片数据集,大多为秦俑上身部与下身部的零散碎片点云,肉眼难以辨认其所属分类,是碎片模板库中未使用过的部分;第二部分是未经过分类和标注但通过肉眼可判断部位的点云数据,例如较为明显的五官。

实验中依次提取待测试碎片局部显著特征与旋转投影特征,与模板库中的碎片进行匹配后采用自适应权值策略进行加权。选定判定匹配阈值为0.3,相似度度量加权求和后结果小于阈值0.3则认为匹配当前类别。若有多个符合阈值的结果,则在所有符合的结果中进行投票表决,选择得票最多的类别作为当前待分类碎片的分类结果。

实验结果表明,旋转投影特征的相似度度量结果区间为0.127~0.653,其中同部位碎片相互匹配时相似度接近0.13,下身部碎片区分度最低,上身部碎片区分度最高。局部显著特征的相似度度量结果区间为0.151~0.840,因采用欧氏距离作为度量算法,故相似度整体区间上下限差距较大。其中下身部碎片区分度最低,头部碎片区分度最高。

对比分类结果发现,其中头部碎片的分类效果最佳,实验中采用的头部碎片共41片,正确分类的数量为33片。头部碎片表面局部特征较为集中且明显,且大部分碎片都包括有凸起的五官与发饰,在标定特征点阶段,积分不变量的计算值会集中于五官部分,所以旋转投影特征能很好地描述特征点局部的深度与密度信息。上身部碎片的分类结果也较为良好,实验中采用的上身部碎片共50片,正确分类的数量为39片。上身部碎片的特点为整体形状不规则、大小不一、外表面存在大量较为分散的显著铠甲甲钉。且模板库中选择的上身部碎片都包含数个甲钉,在匹配局部显著特征时,上身部的碎片同部位的相似度能达到0.1~0.2,匹配程度极高,确保了分类的准确性。实验中采用的手部碎片共41片,正确分类的数量为31片。手部碎片的实验分为两部分,有包含手指的部分碎片与不包含手指的手掌至袖口部分碎片。包含手指的部分分类结果较好,同部位匹配时,在旋转投影特征匹配过程中,手指部分的特征点局部的深度信息具有较高的匹配程度。不包含手指的部分表面相对光滑,且普遍较小。这一部分碎片的断裂面包含了较多的局部显著特征,在分类过程中,同部位匹配结果超过相似度阈值的结果集中在手部碎片不包含手指的部分与下身部碎片部分。匹配结果有较好的区分度,但易造成误匹配。

下身部碎片中存在最多的误匹配,实验中采用的下身部碎片共57片,正确分类的数量为39片。下身部碎片大多属于兵马俑模型的裙摆区域,模板库中的碎片大小不一、表面平滑、形状不规则、局部显著特征分布不均匀,所以在计算旋转投影特征时,标定特征点的策略近似于均匀采样法标定,故旋转投影特征的区分度不高,较为依赖局部显著特征的匹配结果。腿部与脚部碎片的误匹配率仅次于下身部碎片,实验中采用的腿部与脚部碎片共42片,正确分类的碎片数量为30片。部分腿部与脚部碎片和下身部的连接部分包含了一部分下身部碎片,且腿部与脚部碎片的部分显著特征与头部碎片相似,所以在分类过程中易发生误匹配。各部位分类结果见

实验中采用的算法对各部位的平均分类准确率为74.78%,对于不同类别的兵马俑碎片都具有较高的区分度。各部位分类准确率如

在已有的点云特征描述方法中,FPFH描述子具有较强的压缩特性与区分性,而SHOT描述子通过邻域点的空间位置信息和几何特征统计信息结合起来描述特征点,取得了较好的描述效果。实验中使用FPFH描述子与SHOT描述子相结合的方式对碎片点云进行描述,采取均匀采样法标定点云特征点,FPFH描述子对于每个特征点描述得到33维浮点型特征向量,SHOT经过描述得到352维浮点型特征向量。特征描述完成之后依次与模板库中碎片的特征向量进行暴力搜索匹配与相似度度量,采用欧氏距离作为度量标准,均采用开源点云库PCL中的默认参数。

可以发现,实验选用的描述子结合了FPFH和SHOT描述子两种方法,平均描述时长低于FPFH描述子,略高于SHOT描述子。这是由于结合了描述效率较高的旋转投影特征与维度较低的局部显著特征,且不需要进行FPFH与SHOT描述子在特征描述前需要检测并估计点云法向量的操作。但在标定特征点过程中需要进行额外的步骤,标点效率相对较低。在模板匹配过程中,FPFH描述子采用PCL点云库中封装好的OpenMP开发模式,特征维度只有33维,匹配效率最高。而SHOT描述子特征维度为352维,且采用计算欧氏距离的匹配方法,故匹配效率最低。实验所使用的描述子中,旋转投影特征采用Hamming距离进行相似度度量,计算效率很高,局部显著特征虽采用欧氏距离进行相似度度量,但经扩张搜索之后特征维度与FPFH描述子相近,匹配效率与FPFH描述子接近,但高于SHOT描述子。

将相似度度量结果作为判断分类的标准,随机选取100块已标记的碎片作为测试数据,使用FPFH方法的分类结果如

可以看出,FPFH描述子得到的平均准确率为58.84%,低于本文提出的分类方法。且在进行描述时使用了法向量信息,受点云噪声影响较大,导致度量结果区分度低。对于兵马俑碎片点云数据,单一特征描述子具有一定的局限性,FPFH描述子特征描述依赖于特征点与其k近邻点之间的法向夹角。而部分碎片(如

5 结论

提出一种适用于文物碎片分类的局部描述子,提取碎片表面的旋转投影特征与局部显著特征,并给出了相对应的相似度度量匹配方法,结合多特征对文物碎片进行模板匹配并判断分类。实验结果表明该方法具有较高的准确率,可以在类似文物的分类中加以应用。但由于实验中兵马俑数据的特殊性与不规则性,之后可进一步研究提取其他特征并加以实验。

[1] 王飘, 耿国华, 杨稳, 等. 结合表面纹理与断裂轮廓的碎片拼接方法[J]. 计算机工程, 2019, 45(2): 315-320.

Wang P, Geng G H, Yang W, et al. Fragment splicing method combined with surface texture and fracture contour[J]. Computer Engineering, 2019, 45(2): 315-320.

[2] Salti S, Tombari F, Di Stefano L. SHOT: unique signatures of histograms for surface and texture description[J]. Computer Vision and Image Understanding, 2014, 125: 251-264.

[3] Yang J Q, Zhang Q, Xiao Y, et al. TOLDI: an effective and robust approach for 3D local shape description[J]. Pattern Recognition, 2017, 65: 175-187.

[4] 刘剑, 白迪. 基于特征匹配的三维点云配准算法[J]. 光学学报, 2018, 38(12): 1215005.

[5] Kleppe A L, Egeland O. A curvature-based descriptor for point cloud alignment using conformal geometric algebra[J]. Advances in Applied Clifford Algebras, 2018, 28(2): 50.

[6] Beksi W J, Papanikolopoulos N. A topology-based descriptor for 3D point cloud modeling: theory and experiments[J]. Image and Vision Computing, 2019, 88: 84-95.

[7] 何志超, 赵龙章, 陈闯. 用于人脸表情识别的多分辨率特征融合卷积神经网络[J]. 激光与光电子学进展, 2018, 55(7): 071503.

[8] 刘峰, 沈同圣, 娄树理, 等. 全局模型和局部优化的深度网络显著性检测[J]. 光学学报, 2017, 37(12): 1215005.

[9] 杨军, 王顺, 周鹏. 基于深度体素卷积神经网络的三维模型识别分类[J]. 光学学报, 2019, 39(4): 0415007.

[10] 白静, 司庆龙, 秦飞巍. 基于卷积神经网络和投票机制的三维模型分类与检索[J]. 计算机辅助设计与图形学学报, 2019, 31(2): 303-314.

Bai J, Si Q L, Qin F W. 3D model classification and retrieval based on CNN and voting scheme[J]. Journal of Computer-Aided Design & Computer Graphics, 2019, 31(2): 303-314.

[11] Qi CR, SuH, Mo KC, et al. Pointnet: deep learning on point sets for 3D classification and segmentation[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, July 21-26, 2017, Honolulu, Hawaii. New York: IEEE, 2017: 652- 660.

[12] Qi CR, YiL, SuH, et al. Pointnet++: deep hierarchical feature learning on point sets in a metric space[C]//Advances in Neural Information Processing Systems, December 4-9, 2017, Long Beach, CA, USA. Canada: NIPS, 2017: 5099- 5108.

[13] Zou Y, Wang X Q, Zhang T, et al. BRoPH: an efficient and compact binary descriptor for 3D point clouds[J]. Pattern Recognition, 2018, 76: 522-536.

[16] Heikkilä M, Pietikäinen M, Schmid C. Description of interest regions with local binary patterns[J]. Pattern Recognition, 2009, 42(3): 425-436.

Article Outline

陆正杰, 李纯辉, 耿国华, 周蓬勃, 李岩, 刘洋. 基于多特征描述子自适应权重的文物碎片分类[J]. 激光与光电子学进展, 2020, 57(4): 041511. Zhengjie Lu, Chunhui Li, Guohua Geng, PengBo Zhou, Yan Li, Yang Liu. Classification of Cultural Fragments Based on Adaptive Weights of Multi-Feature Descriptions[J]. Laser & Optoelectronics Progress, 2020, 57(4): 041511.