基于YOLO v3的红外末制导典型目标检测  下载: 1376次

下载: 1376次

1 引言

随着人工智能的迅猛发展,大量先进技术广泛应用在制导**系统中。红外成像凭借其抗干扰能力强、空间分辨率高、昼夜工作等特点成为精确制导中重要的研究领域。作为导弹**的“眼睛”,准确并及时发现目标对提高导弹的命中率具有重要意义[1]。

由于目标的快速性和机动性日益增强,“人在回路中”的方式已经无法满足探测高时敏性和高覆盖率的要求[2],这就要求制导系统具备自动目标识别的能力。深度学习方法能够自主学习目标特征,不断完善网络模型,真正实现自动目标识别定位。

任何温度高于0 K的物体都向外界发出热辐射,通过描述不同物体热辐射的差异可以得到红外图像。凭借不受光照影响、可昼夜工作的优势,红外图像广泛应用于**侦察领域。由于舍弃了物体的颜色、局部纹理等特征,红外图像的对比度和信噪比低,较为模糊[3]。传统方法中,获取红外图像的质量对目标的检测效果有着十分重要的影响,因此易翔等[4]提出一种结合帧间时空域特征的红外检测算法,实现了红外图像的增强,检测精度较高,但是较为突出的问题是检测时间长;熊斌等[5]则针对红外场景中的小目标,提出一种自适应参数目标图像恢复算法,具有较低误检率,其本质也是对红外图像进行增强。传统方法虽然能够较好地完成红外图像的目标检测,但大多是在特征提取和图像增强方面进行改进,对检测目标具有一定的局限性。

深度学习方法和传统方法相比,最大的优势在于其强大的自学习和泛化能力。通过学习,深度模型不仅可以自动提取目标的形状、轮廓等表象特征,还可以挖掘出肉眼不可见的深层特征,从而弱化传统方法中对红外图像的增强操作,将研究的重点转移到网络模型的改进。2012年,Krizhevsky等[6]提出的AlexNet以绝对的优势获得了ImageNet图片分类竞赛的冠军,自此引发了将深度学习应用于目标检测的热潮。Sermanet等[7]提出的OverFeat是最早应用于目标检测的卷积神经网络方法之一,检测效果较传统算法有显著改进,但错误率依旧较高。Ren等[8]提出的Faster R-CNN在VOC2012数据集上的平均准确率(mAP)达到75.9%,但检测速度只有5 frame/s,无法满足导弹高速飞行时实时检测目标的要求。2016年,Redmon等[9]提出的YOLO算法真正实现了对目标的实时检测,检测速度达到45 frame/s。在YOLO的基础之上,又相继改进提出YOLO v2[10]和YOLO v3[11]算法,大幅提高了检测速度和精度以及对小目标的检测效果。

本文将深度学习方法应用于红外图像目标检测,大大减少人为特征提取和处理的过程,借助于深度学习强大的性能,使红外目标的检测效率和精度得到大幅提高。为了在红外末制导背景下实现对目标又快又准的检测,针对红外图像的特点对YOLO v3网络结构进行改进,并从损失函数和训练模式入手,使模型能够较好地实现对红外图像的目标检测。以特种车辆、舰船、飞行器三类典型目标作为末制导研究对象,为解决红外目标数据集稀缺的问题,采取自行拍摄、标注的方式,制备数据集。同时,从边界框损失、置信度损失和分类损失三方面入手,优化损失函数权重系数,实验证明该方法能小幅提高模型的检测精度,并降低检测虚警率。为了深层挖掘红外图像特征,结合动量法和Adam算法的特点设计联合训练方法,利用自适应算法Adam使网络快速收敛,再通过动量法对网络进行进一步优化和精修。Adam算法加快网络收敛速度,有益于动量法初始学习率的设定,改善网络检测效果。

2 YOLO v3原理及改进

2.1 YOLO v3原理

YOLO采用单个神经网络直接将整张图像作为输入进行训练,省去生成候选区域的中间步骤,能够快速区分背景区域和目标,从而实现对目标物体的实时监测。

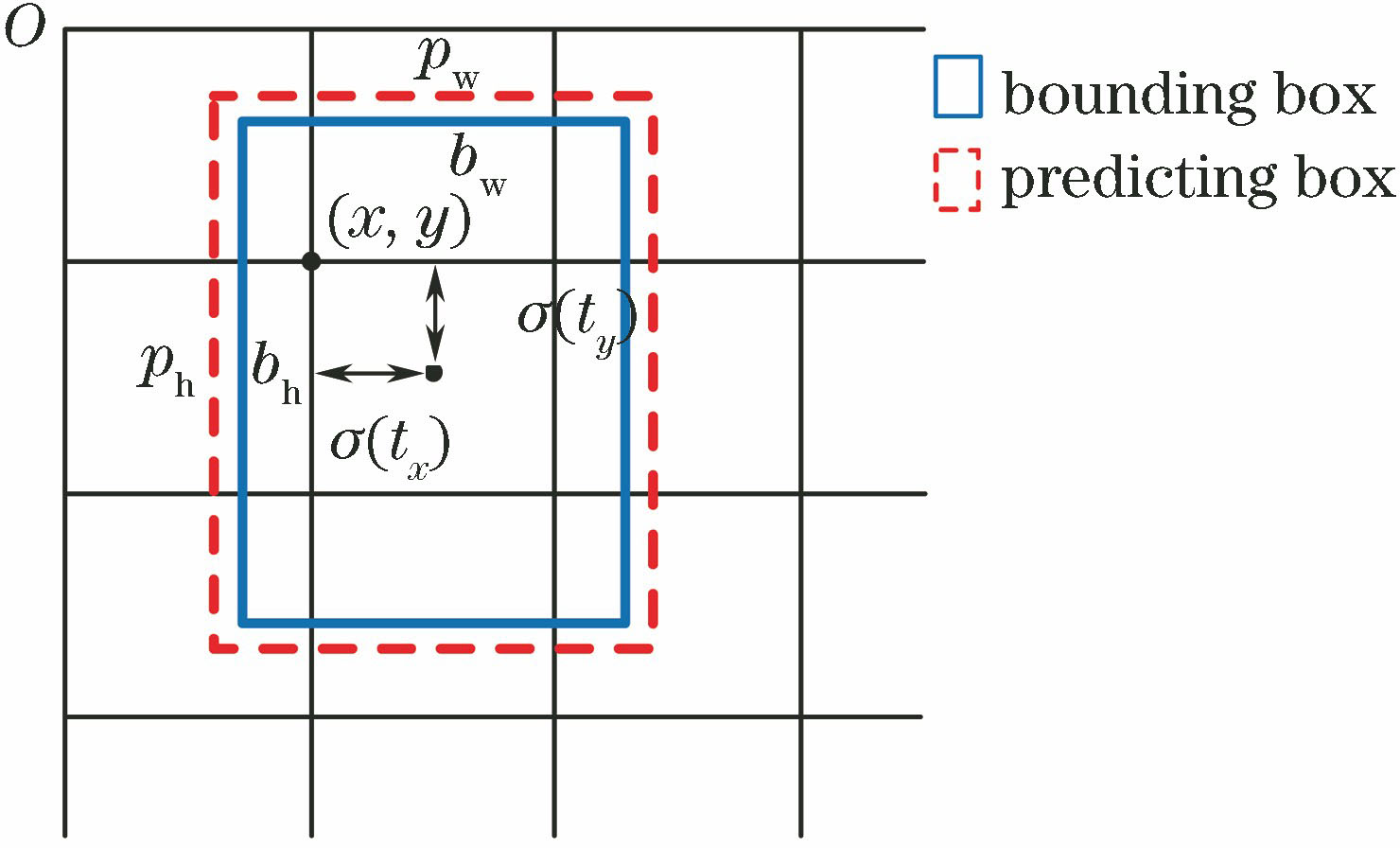

YOLO v3的检测过程是:首先将输入图像缩放至416 pixel×416 pixel,接着将图像划分成

式中:(

通常情况下,红外图像是以单通道的灰度图像形式存储,

YOLO v3原本的网络结构适用于可见光图像,即输入的图像大小为416 pixel×416 pixel×3,一种解决方案是将红外单通道图像转换成三通道格式输入。虽然这种方案可以满足网络的输入格式,但只是将单通道进行简单的复制获得三通道图像,并没有增加颜色、纹理等特征,对最终的检测结果没有实质性的提高。

因此,从网络结构入手,将网络的输入调整为416 pixel×416 pixel×1,这样做的好处在于输入单通道图像,使网络参数的计算更加集中,减少参数冗余。

2.2 损失函数加权

假设每个单元格的预测值为

边界框损失由中心坐标的误差和边界框宽与高的误差构成,可以描述为

式中:(

置信度损失和分类损失的计算公式可以分别描述为

式中:

如果直接使用(2)式计算损失,那么三类损失的权重均为1,可以理解为三种损失的重要程度相当,这显然与实际不符,故对损失函数进行改进加权,以提高末制导过程中目标的定位精准度和识别准确度。加权后的损失函数(

式中:

为了提高边界框损失的地位,可以适当提高边界框损失的权重。同时,要想在红外末制导中精准瞄准目标,必须首先提高预测目标中心坐标精度,其次才是目标的形状,故需要增大权重

综合考虑各类损失因素对红外末制导目标检测的重要程度,可以得到权重之间的关系为

2.3 随机梯度下降联合训练

梯度下降是应用最广泛、效果最好的优化算法之一,并且也是目前为止优化神经网络最常用的方法[12]。按照能否自动调节学习率分类,梯度下降方法可以分为自适应方法和非自适应法。其中,常用的自适应方法有AdaGrad、RMSProp和Adam等,非自适应方法有随机梯度下降(SGD)、SGD with Momentum和Nesterov Momentum等。

2.3.1 动量法

SGD算法容易进入陡谷,陡谷指当前维度的曲率远大于邻近维度,故难以出来,从而陷入局部最优。动量法(SGD with Momentum)能帮助SGD算法在相关方向上加速并抑制振荡,具有一定摆脱局部最优的能力[13],如

顾名思义,动量法借鉴物理中的动量概念,将上一时刻的绝大部分更新向量添加到当前更新向量中,可以描述为

式中:

这样的好处在于:当前梯度点的方向与前一时刻保持的方向一致时,可以增大动量项并加速,当方向发生改变时,动量项会减小,故而能起到加快收敛和减小振荡的作用。

2.3.2 Adam自适应算法

Adam算法作为一种学习率自适应调整的一阶梯度优化方法,具有实现简单、计算量小、运算速度快等优点,和其他自适应学习算法相比更具优势[14]。和动量法类似,Adam算法不断累积存储历史梯度信息,可以描述为

式中:

Adam算法不直接使用梯度的累加,而改用一阶矩和二阶矩,为不同参数设计独立的自适应学习率,能够在改变方向时起到平滑的作用。当

因此,Adam算法能够实现自适应调整学习率,更新的步长能够限制在一定范围内,能够较好地实现不稳定函数的优化。

2.3.3 基于Adam和SGD with Momentum的联合训练方法

由于红外图像的特性,神经网络需要花费更多的时间去挖掘图像中的目标特征。对于动量法而言,虽然能够学习红外图像的深层特征,但需要的学习率很小,这给训练过程中学习率的初始值和中间值的设定造成一定的难度。学习率设定过小,网络收敛较慢,设置过大则会阻碍收敛,甚至引发发散[15]。对于Adam自适应算法而言,尽管没有考虑学习率的问题,但训练容易“点到为止”,即收敛能力有限,这会导致对红外图像的深层特征学习不够深入,仍不是最佳的选择。同时,由于Adam算法时刻调整学习率,会导致网络权重产生波动,所以训练时误差曲线不太稳定。

针对红外图像的特点,将Adam算法的自适应能力和动量法的稳定高效相结合,并借助于“预训练”思想,提出一种基于Adam和SGD with Momentum的联合训练方法。使用Adam优化算法对YOLO v3进行预训练,在没有指定学习率的情况下,Adam算法通过迭代迅速调整神经网络权重,使损失函数迅速收敛,前期YOLO网络便能对数据集进行较好的学习。对初步训练的网络权重使用动量法继续训练,由于神经网络已经初步收敛,因此易于设定合适的学习率使已初步收敛的网络逐步趋于稳定,减少损失函数的振荡,最终使网络达到最佳状态。

图 5. 基于改进YOLO v3的红外末制导目标检测方法示意图

Fig. 5. Diagram of infrared homing guidance target detection method based on improved YOLO v3

综上,可以得到基于改进YOLO v3的红外末制导目标检测方法示意图,如

3 实验验证

3.1 实验数据及配置环境

将特种车辆、舰船和飞行器作为典型目标进行研究,由于真实红外数据采集较为困难,故拍摄

实验配置环境为:Windows 10系统,CPU为Intel Core i7-7820X,主频3.6 GHz,GPU为NVIDIA GeForce GTX 1080 Ti,内存32 GB,在Python 3.5环境下使用Keras框架,并安装cuda 8.0加速计算,YOLO v3网络框架为DarkNet 53。

3.2 实验测试及结果分析

随机选取6773张图片进行训练,676张图片进行测试,其余作为交叉验证图片。

1)聚类优化候选框。使用

式中:

画出平均交并比与锚点框的关系,如

2)损失函数加权和联合训练法对比实验。控制6组对比实验训练总次数为200 epoch,选取最优实验结果,实验参数如

文献[

12]中指出,作为自适应算法,在训练时使用Adam优化器,选用文献默认参数即可达到较好效果。在固定学习率情况下,过大或过小的学习率都不利于训练,故本文中动量法学习率的设置由离散指数衰减方法得到,使学习率在一定步长范围内保持恒定,且总体呈指数减小。动量法学习率初始值的选取需要通过观察训练损失曲线进行人工调节,设定原则是损失函数能在规定次数内收敛的情况下尽可能大,动量法学习率(

式中:

由

表 1. 对比实验参数表

Table 1. Parameters for contrastive experiments

|

3)测试及分析。通过设置不同条件进行对比实验,测试结果如

表 2. 不同方法测试结果对比

Table 2. Comparison of different testing methods

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

4 结论

针对红外末制导背景中红外图像局部信息缺失,给传统方法带来极大困难的问题,提出基于改进YOLO v3的红外末制导目标检测方法,结合Adam算法和动量法的优势,设计联合训练方法,加快网络收敛速度,充分挖掘图像深层信息,同时对YOLO v3损失函数模型进行优化加权。通过设置不同条件对比实验进行验证,改进后三类典型目标检测的mAP值能够达到77.89%,虚警率和漏检率都得到降低,改进效果明显。检测速度能够达到25 frame/s,能较好地满足实时性要求。未来,将从网络模型入手,重点提高检测速度。

[1] 姜锦锋. 红外图像的目标检测、识别与跟踪技术研究[D]. 西安: 西北工业大学, 2004.

Jiang JF. Research on target detection, recognition and tracking technology of infrared image [D]. Xi'an:Northwestern Polytechnical University, 2004.

[2] 张天序, 王岳环, 钟胜. 飞行器光学寻的制导信息处理技术[M]. 北京: 国防工业出版社, 2014.

Zhang TX, Wang YH, ZhongS. Guidance information processing methods in aircraft optical imaging seeker[M]. Beijing: National Defense Industry Press, 2014.

[3] 姚广顺, 孙韶媛, 方建安, 等. 基于红外与雷达的夜间无人车场景深度估计[J]. 激光与光电子学进展, 2017, 54(12): 121003.

[4] 易翔, 王炳健. 基于多特征的快速红外弱小目标检测算法[J]. 光子学报, 2017, 46(6): 0610002.

[5] 熊斌, 黄心汉, 王敏. 基于自适应目标图像恢复的红外弱小目标检测[J]. 华中科技大学学报(自然科学版), 2017, 45(10): 25-30.

Xiong B, Huang X H, Wang M. Infrared dim small target detection based on adaptive target image recovery[J]. Journal of Huazhong University of Science and Technology(Natural Science Edition), 2017, 45(10): 25-30.

[6] Krizhevsky A, Sutskever I, Hinton G E. ImageNet classification with deep convolutional neural networks[J]. Communications of the ACM, 2017, 60(6): 84-90.

[7] SermanetP, EigenD, ZhangX, et al. OverFeat: integrated recognition, localization and detection using convolutionalnetworks[J/OL].( 2014-02-24)[2019-01-06]. https:∥arxiv.org/abs/1312. 6229.

[8] Ren S Q, He K M, Girshick R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[9] RedmonJ, DivvalaS, GirshickR, et al. You only look once: unified, real-time object detection[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 779- 788.

[10] RedmonJ, FarhadiA. YOLO9000: better, faster, stronger[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 6517- 6525.

[11] RedmonJ, Farhadi A. YOLOv3: an incremental improvement[J/OL].( 2018-04-08)[2019-01-09]. https:∥arxiv.org/abs/1804. 02767.

[12] 魏湧明, 全吉成, 侯宇青阳. 基于YOLO v2的无人机航拍图像定位研究[J]. 激光与光电子学进展, 2017, 54(11): 111002.

[13] Ruder S. An overview of gradient descent optimization algorithms[J/OL].( 2017-06-15)[2019-01-05]. https:∥arxiv.org/abs/1609. 04747.

[14] KingmaD, Ba J J C S. Adam: a method for stochastic optimization[J/OL].( 2017-01-30)[2019-01-06]. https:∥arxiv.org/abs/1412. 6980.

[15] 张晋晶. 基于随机梯度下降的神经网络权重优化算法[D]. 重庆: 西南大学, 2018.

Zhang JJ. Optimization algorithms of neural networks weights based on stochastic gradient descent[D]. Chongqing: Southwest University, 2018.

Article Outline

陈铁明, 付光远, 李诗怡, 李源. 基于YOLO v3的红外末制导典型目标检测[J]. 激光与光电子学进展, 2019, 56(16): 161502. Tieming Chen, Guangyuan Fu, Shiyi Li, Yuan Li. Typical Target Detection for Infrared Homing Guidance Based on YOLO v3[J]. Laser & Optoelectronics Progress, 2019, 56(16): 161502.