面向无人机的轻量级Siamese注意力网络目标跟踪  下载: 1612次

下载: 1612次

1 引言

凭借灵敏的反应速度、平稳的悬停能力、轻巧的身型等优点,无人机开始广泛应用于民用、商业、**领域。随着计算机视觉、人工智能领域的蓬勃发展,在高性能计算技术的推动下,面向无人机应用的目标跟踪算法展现了巨大的应用前景。在无人机跟踪任务中,由于平台的运动,导致拍摄的视频图像序列视野角度多变、目标尺寸变化大、分辨率低、遮挡等情况更为频繁。因此,构建一个面向无人机应用的高效稳健目标跟踪算法具有重要的研究意义及应用价值。

以核循环结构(CSK)[1] 算法、核相关滤波(KCF)[2] 算法为代表的传统相关滤波类算法以优异的跟踪速度广泛应用于无人机跟踪任务中。然而方向梯度直方图(HOG)等手工设计的浅层特征需要有针对性地构造旋转不变性、尺度不变性、光照不变性等特性,在面对无人机跟踪的多变场景中表现不够稳健。近年来,深度学习方法在图像分类等计算机视觉任务中展现了巨大的潜力,深度卷积网络以其强大的泛化能力与迁移能力逐步被引入目标跟踪任务中,涌现出一批精度高、稳健性好的算法,诸如多层卷积特征相关滤波(HCFT)[3] 算法、多域卷积网络(MDNet)[4] 算法、连续卷积相关滤波(C-COT)[5] 算法、高效卷积相关滤波(ECO)[6] 算法等。利用离线预训练的深度网络进行特征提取,提升了目标的特征表达能力,进而大幅提升了跟踪精度。但是预训练网络结构通常较为庞大,特征维度的升高直接影响了算法的跟踪速度,多数算法即使在GPU下也难以达到实时,更无法适应无人机的应用需求。深度学习方法在跟踪领域的融合不单单局限于作为特征提取网络嵌入传统跟踪框架中,更多是直接训练端到端的跟踪网络,比较有代表性的是基于Siamese框架的跟踪算法。从实例搜索(SINT)[7]算法、全卷积孪生网络(SiamFC)[8] 算法开创性地将Siamese网络引入目标跟踪任务,到相关滤波端到端网络(CFNet)[9] 算法在网络中加入相关滤波层,再到区域候选网络SiamRPN[10]算法创造性地将区域候选网络(RPN)引入到跟踪领域,形成Siamese-RPN跟踪框架,将原来的相似度计算问题转化为回归以及分类问题,通过大规模数据集进行端到端的离线训练。越来越多的研究者开始基于Siamese框架进行目标跟踪算法的研究[11-12],相对于基于预训练深度网络的目标跟踪算法,在提升跟踪精度的同时,速度也得到了质的飞跃。

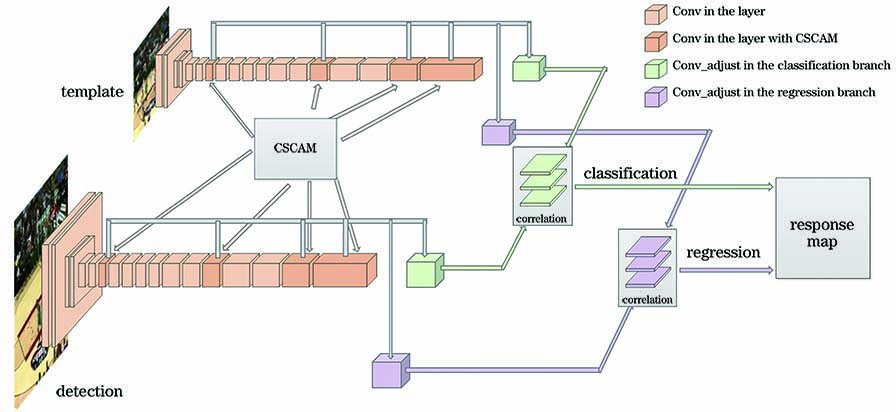

由于无人机跟踪任务中更容易受到尺度变化、遮挡等因素的干扰,这对算法的稳健性提出了更高的要求。另外,无人机平台计算资源相对有限,这为算法的实时性增加了难度。为了更好地满足无人机跟踪任务的需求,本文提出一种基于Siamese-RPN跟踪框架的无人机跟踪算法,主要包括以下三方面的工作:1)构建以轻量级神经网络MobileNetV2[13]为主干网络的Siamese跟踪框架,针对跟踪任务的特点对网络模型进行改进,使其具有更强的特征表达能力;2)引入多种注意力机制,从通道、空间以及协同三个层面提升关键特征的筛选能力,使离线训练的模型在线跟踪时具有更优越的适应能力以及判别能力;3)融合多层前景背景分类和边界框回归的响应图,调整边界框的筛选策略,以获取更精准的定位。在目标跟踪通用数据集中,进行算法性能的验证,与当前主流算法相比,本文算法能够更好地适应尺度变化、视野角度变化、遮挡等多种无人机跟踪场景,取得良好的跟踪精度。

2 轻量级Siamese网络跟踪算法

算法的整体框架如

图 1. 融合通道空间协同注意力的轻量级Siamese网络

Fig. 1. Framework of Siamese network with channel spatial coordination attention module

2.1 融合通道空间协同注意力的轻量级Siamese网络

2.1.1 基于Siamese网络的目标跟踪

基于Siamese网络的算法将目标跟踪任务转化为相似性度量问题,将视频序列第一帧z、后续帧中的候选区域x分别作为模板分支、检测分支的输入图像,通过权值共享的特征提取网络φ(·)映射到特征空间,学习度量函数f(z,x)来比较模板图像和候选区域搜索图像之间的相似度,返回响应图。分数越高,二者相似度越高。

式中:*代表互相关运算;b·I表示在响应图中每个位置的取值。

2.1.2 轻量级网络MobileNet

深度学习网络模型在视觉跟踪任务中应用的效果越来越好,伴随而来的是神经网络结构逐渐复杂,体积逐渐增大,对硬件资源的需求也逐渐增多。神经网络大都是在具有强大的浮点运算能力、性能优越的服务器上运行,普通PC难以承担如此繁重的计算压力,资源受限的移动平台更是难以部署。因此,深度学习领域的研究者们也开始致力于在保证模型准确率的同时,促使神经网络向小型化、高速化发展。一个研究方向是对训练好的复杂模型进行压缩得到小模型;另一个研究方向是直接设计训练小模型,近年来出现的许多具有代表性的轻量级网络模型,如SqueezeNet、ShuffleNet、NasNet、MnasNet和MobileNet等,加速了神经网络模型在移动终端、嵌入式设备的应用。

MobileNetV1[14]是谷歌提出的轻量级CNN网络,设计了深度可分离卷积,将标准卷积的运算过程分离为深度(DW)卷积与点(PW)卷积。DW卷积为输入特征图的每个通道分配一个单独的卷积核进行卷积运算;PW卷积使用1×1卷积对DW卷积的运算结果进行标准卷积运算。深度可分离卷积通过分解将总计算量降低至标准卷积的1/N+1/

MobileNetV2相对于MobileNetV1引入了倒残差和线性瓶颈,卷积模块如

为了便于后续注意力模块的设计与分析,从输入输出协同工作角度,将模块的卷积过程从通道和空间两个层面进行抽象可视化,如

在神经网络中,诸如ReLU等非线性激活层通过引入非线性在高维空间有效增加特征的非线性表达,使模型具有更强的拟合能力。但ReLU的引入同时会带来低维数据坍塌问题,这导致了MobileNetV1训练后一些DW卷积核容易置空。原空间的低维特征通过变换T映射至嵌入空间后,加入ReLU进行处理,若再通过T的逆变换,将处理后的特征映射至原空间,信息会损失一部分。嵌入空间的维度越高,则信息损失越小;维度越低,则信息损失越大。因此MobileNetV2在倒残差结构中,第一层PW、中间层DW使用ReLU,最后一层PW卷积后使用线性激活函数替换ReLU,称之为线性瓶颈。

相对于主流的神经网络模型,MobileNetV2拥有更小的体积、更少的计算量、更高的精度,易于部署在诸如FPGA、DSP等无人机图像处理平台。而在目标跟踪任务中,特征提取网络的选择直接影响跟踪速度与性能。因此,本文选取MobileNetV2作为Siamese网络中的特征提取主干网络。同时考虑到后续互相关以及响应图的融合等操作,对其进行修改,以检测分支为例,具体网络结构如

表 1. 基于MobieleNetV2的Siamese网络结构

Table 1. Architecture of Siamese network based on MobieleNetV2

|

从

1) 原始的MobileNetV2总步长为32,为了适应网络应用于跟踪的精确定位,将网络的总步长限制为8,保持后四段Layer4~Layer7中的尺寸不变,缩小了网络模型的总步长;后四个卷积模块的分辨率保持变化一致。

2) 为了提升网络的性能,在Layer3、Layer5、Layer6、Layer7后融入了注意力模块CSCAM,但并未改变特征图尺寸;

3) 为了便于后续分类分支与回归分支的互相关计算以及响应图的融合,在CSCAM的输出后,均增加一层1×1的卷积层Conv_adjust,用于调节通道数。

2.1.3 通道空间协同注意力模块

相对于相关滤波类的跟踪算法,基于Siamese网络的跟踪算法为了提升速度,采取了离线训练的网络,摒弃了在线训练的环节,这就需要网络一方面需要对各种场景变化表现稳定,可以将目标代表性、本质性的特征抽象提取出来;另一方面又需要对不同目标的差异表现敏感,能够对目标的细节有所提炼。即网络需要具备强大的特征提取能力,自带判别作用。然而:1)从特征提取的层面。MobieleNetV2等基于大规模分类数据集离线训练的通用网络,对图像的每个位置有较为平均的关注度,而跟踪任务需要根据不同的目标关注不同的特征,因此离线训练的网络并不能完全适应在线跟踪。2)从相似度判别层面。由(1)式可以看出,在互相关计算的整个过程中,不同通道、不同位置对于相似度计算的贡献是平均的,这极大限制了网络的特征提取能力与判别能力,因此需要在相似度计算中进行加权突出或筛选目标的重要信息,抑制无关的细节信息,提升网络的判别能力。

为了使离线训练的网络具有更强的特征提取能力、适应能力以及判别能力,受到人类视觉系统中注意力机制的启发,将其引入提升网络的性能。人类视觉系统的一个重要特性是不试图同时处理整个场景。相反,为了更好地捕捉视觉结构,人类利用一系列的局部关注,有选择地聚焦于显著的部分。类似地,在深度网络模型中加入注意力模块能够有效突出感兴趣的区域,为了便于直观地体现注意力模块的作用,利用类激活热力图[15](Grad-CAM)对网络进行可视化,如

图 4. Grad-CAM网络可视化结果。(a)无注意力模块;(b)有注意力模块

Fig. 4. Grad-CAM network visualization results. (a) No attention module; (b) with attention module

为了对不同跟踪目标特征图中不同通道、不同空间的重要性区别性地突出,同时为了更好地利用模板图像以及搜索图像的背景信息,根据Siamese网络的结构特点,设计通道空间协同注意力模块,如

通道注意力通过对通道之间的依赖性进行建模,从语义层面学习特征之间的关联,对特征进行优化,激活与目标更相关的通道特征,去除冗余特征,使特征表达更加凝练、精确度更高。设经过MobileNetV2网络模板分支、检测分支提取到的特征图φ(z)∈

在Siamese网络中,模板分支与检测分支通常都是独立操作,在此设计协同注意力模块,将各自分支编码融入另外的分支,使背景信息得到充分利用。为了便于和特征进行矩阵乘法,需要对其进行整形和调整维度,输出协同注意力权重AI{φ(x)}、AI{φ(z)}。经由通道注意力、协同注意力模块后,两个分支的权重进行融合,得到φ'(z)、φ'(x)。

空间注意力更集中于位置的描述,能够构建特征图中不同位置的相互关系,对位置进行加权融合,对通道注意力进行补充。将特征图φ'(·)沿着通道维度压缩,分别得到通道最大池化、通道平均池化,拼接后再进行卷积操作,经由激活函数,输出空间注意力权重AS(·)。与输入特征φ'(·)进行元素级乘法,得到最终注意力特征图 。

2.2 多层区域建议网络

区域建议网络包括分类分支与回归分支。Siamese网络中模板分支、检测分支输出的各层特征图通过调整层的卷积操作调整为分辨率统一、通道数相同的特征图,再分别输入区域建议网络的分类分支以及回归分支中。设分类分支输入的第q层调整后的特征图为[φ(q)(z)]cls 、[φ(q)(x)]cls;回归分支输入的第q层调整后的特征图为[φ(q)(z)]reg、[φ(q)(x)]reg,分别进行逐通道相关操作,减少计算成本和冗余参数。最后,再将多层特征图经由区域建议网络得到的输出进行加权融合。

在对每个候选区域进行前景或背景分类时,由于同一目标可能同时存在于多个重叠的矩形框内,因此通常采用非极大值抑制(NMS)进行剔除,得到更为精准的位置信息。设置分类得分较高的矩形框为抑制窗口,在筛选过程中,以矩形框交并比(IoU)为指标来判断当前矩形框与抑制窗口是否重叠,超过设定IoU阈值时,则当前矩形框被剔除,否则被保留。

式中:bi为第i个矩形框;si为第i个矩形框对应的得分,是设定的IoU阈值。

然而这个策略存在的问题是:分类得分高的矩形框未必是所有矩形框中最优的,如果其他的矩形框因为与抑制窗口重叠率高而被剔除,则很有可能造成跟踪漂移,因此对其进行改进,

当前矩形框与抑制窗口IoU超过阈值时,得分会线性衰减,而不是直接置0,从而达到保留矩形框的问题。重叠面积越大,得分衰减越大,重叠面积未超过阈值时,得分并无影响。在不增加额外计算量的同时使结果更为精准。

3 实验与分析

3.1 实验平台及参数配置

本文算法实验平台硬件配置为:CPU Intel(R) CoreTM i7-9700,基础频率3.0 GHz,睿频加速频率4.7 GHz,内存16 G;GPU NVIDIA GeForce RTX-2060,内存6 G。

训练数据选自ImageNet VID[17]和Youtube-BB[18],分别覆盖了大约4000个逐帧注释的视频和超过10万个每30帧注释的视频,通过特定的比例组合,前者包含更多的细粒度信息而后者包含粗粒度信息。从相同的视频序列中随机选取两帧,并将它们组合成一对模板图像和检测图像,作为Siamese网络的输入,学习如何测量用于视觉跟踪的一般对象之间的相似性的一般概念。使用MobileNetV2预训练模型初始化卷积层,采用随机梯度下降(SGD),训练时学习率为10-4~10-6。整个训练过程包含100多个阶段,每个阶段由6000对样本组成。每次计算8对样本的平均损失值。

3.2 轻量级注意力模块有效性对比实验

为了验证注意力模块的功能性,在OTB-2015[19]上进行了对比实验。为了直观地分析注意力模块对算法性能的改进,将11种不同属性下的跟踪精度与绘图成功率汇总以图表形式呈现,分别如

图 6. 不同注意力模块组合在OTB-2015中成功率对比图

Fig. 6. Success rate comparison of different attention module combinations on OTB-2015

图 7. 不同注意力模块组合在OTB-2015中跟踪精度对比图

Fig. 7. Precision comparison of different attention module combinations on OTB-2015

3.3 基于UAV123的实验

将具有代表性的9种算法(本文算法、ECO[6]、SiamRPN[10]、SRDCF[20]、ASLA[21]、SAMF[22]、DSST[23]、DCF[2]、KCF[2]),在囊括123组视频序列、覆盖12种属性的高分辨率无人机跟踪数据集(UAV123)[24]上评估算法的性能。UAV123数据集包括3个子集,其中子集1包含103个用专业级无人机拍摄的不同物体的序列,跟踪高度在5~25 m之间,视频序列的帧速率在30~96 frame/s之间,分辨率在1280×720~4096×2160 之间;子集2包含12个从安装在小型低成本无人机(UAV)上的摄像头捕获的序列,由于视频传输带宽有限,这些序列的质量和分辨率较低,并且包含合理数量的噪声;子集3包含8个合成序列,由UAV模拟器捕获[24]。以一次通过评估OPE(One Pass Evaluation)[19]作为跟踪算法准确性能的评价标准。

3.3.1 定性分析

选取九种算法在部分视频序列上的表现进行定性分析,跟踪效果如

图 8. 九种跟踪算法在不同视频序列上的定性结果显示。(a) car6_5;(b) car17;(c) person9;(d) person1_s;(e) uav4;(f) wakeboard6

Fig. 8. Qualitative results of the nine tracking algorithms on different video sequences. (a) car6_5; (b) car17; (c) person9; (d) person1_s; (e) uav4; (f) wakeboard6

也存在个别问题序列,如

3.3.2 定量分析

跟踪算法的评估指标主要包括中心位置误差和覆盖率。前者是指跟踪结果与真实目标的中心位置之间的欧氏距离;后者是指跟踪结果与真实目标的重叠率,分别体现在精度图以及成功率图中,通过设定一定阈值对跟踪结果进行判定。

1) 九种算法在UAV123上的成功率曲线以及精度曲线如

图 10. 跟踪算法基于OTB-2015的结果。(a)成功率曲线图;(b)跟踪精度曲线图

Fig. 10. Results of the tracking algorithms on OTB-2015. (a) Success plot; (b) precision plot

2) 针对不同的视频属性类别,九种算法的跟踪成功率定量分析结果如

图 11. 不同属性视频跟踪成功率曲线图。(a)尺度变化;(b)宽高比变化;(c)低分辨率;(d)快速运动;(e)完全遮挡;(f)部分遮挡;(g)超出视野;(h)背景干扰;(i)光照变化;(j)视角变化;(k)相机移动;(l)相似物体

Fig. 11. Tracking success plots of different attributes videos. (a) Scale variation; (b) aspect ratio change; (c) low resolution; (d) fast motion; (e) full occlusion; (f) partial occlusion; (g) out-of-view; (h) background clutter; (i) illumination variation; (j) viewpoint change; (k) camera motion; (l) similar object

3) 针对不同的视频属性类别,九种算法的跟踪精度定量分析结果如

图 12. 不同属性视频跟踪精度曲线图。(a)尺度变化;(b)宽高比变化;(c)低分辨率;(d)快速运动;(e)完全遮挡;(f)部分遮挡;(g)超出视野;(h)背景干扰;(i)光照变化;(j)视角变化;(k)相机移动;(l)相似物体

Fig. 12. Tracking precision plots of different attributes videos. (a) Scale variation; (b) aspect ratio change; (c) low resolution; (d) fast motion; (e) full occlusion; (f) partial occlusion; (g) out-of-view; (h) background clutter; (i) illumination variation; (j) viewpoint change; (k) camera motion; (l) similar object

4) 在UAV123中,尺度变化与宽高比变化两种属性的视频占比最高,分别占89%、55%,也恰好是面向无人机的目标跟踪中面临最多的挑战场景,因此以car6_5、wakeboard6为例进行进一步地分析。如

图 13. 部分视频序列的定量分析。(a)尺度变化与宽高比变化;(b)中心位置误差

Fig. 13. Quantitative analysis of some video sequences. (a) Scale variation and aspect ratio change; (b) CLE

5) 相较于ECO算法,本文算法跟踪精度在背景干扰场景仍有一点差距。然而基于深度网络特征的ECO算法在GPU上的速度为8 frame/s[3],本文算法的平均速度达到60 frame/s,在跟踪速度上有了大幅提升。

综上,本文算法在UAV123的12种属性的视频序列中表现稳定,通过设计通道空间协同注意力模块,以及多层响应图融合取得了良好的跟踪效果,在提高跟踪精度与稳健性的同时,保证了实时的跟踪速度,可以更好地适应尺度变化、视野角度变化、遮挡等无人机跟踪场景。

4 结论

本文提出一种嵌入轻量级网络MobileNetV2作为特征提取主干网络,融合通道空间协同注意力模块,结合区域建议网络的端到端跟踪算法,并通过实验对算法进行了验证。实验表明:1)通道空间协同注意力模块的融入,显著了提升网络模型的特征提取能力、适应能力与判别能力。基于OTB-2015的对比实验表明,由于从通道、空间、协同三个层面进行了注意力调整,使得网络性能在不同属性的视频中有了显著的提升,特别是在背景复杂、运动模糊、形变、低分辨率、遮挡、相似物干扰等情况下,网络学习到更具代表性的特征,区分性更强。2)在无人机目标跟踪数据集UAV123上的实验表明,与当前主流算法相比,本文算法成功率为0.604,跟踪精度达到0.803,在目标外观变化、相似物干扰、目标遮挡等无人机常见的复杂场景下,表现更为稳健。3)在NVIDIA RTX 2060 GPU下的平均跟踪速度可达到60 frame/s 。

[2] Henriques J F, Caseiro R, Martins P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 583-596.

[3] MaC, Huang JB, Yang XK, et al.Hierarchical convolutional features for visual tracking[C]//2015 IEEE International Conference on Computer Vision (ICCV). December 7-13, 2015, Santiago, Chile.New York: IEEE Press, 2015: 3074- 3082.

[4] NamH, HanB. Learning multi-domain convolutional neural networks for visual tracking[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). June 27-30, 2016, Las Vegas, NV, USA.New York: IEEE Press, 2016: 4293- 4302.

[5] Danelljan M, Robinson A, Shahbaz Khan F, et al. Beyond correlation filters: learning continuous convolution operators for visual tracking[J]. Computer Vision-ECCV, 2016, 2016: 472-488.

[6] DanelljanM, BhatG, Khan FS, et al.ECO: efficient convolution operators for tracking[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). July 21-26, 2017, Honolulu, HI, USA. New York: IEEE Press, 2017: 6931- 6939.

[7] TaoR, GavvesE, Smeulders A W M. Siamese instance search for tracking[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). June 27-30, 2016, Las Vegas, NV, USA.New York: IEEE Press, 2016: 1420- 1429.

[8] BertinettoL, ValmadreJ, Henriques JF, et al.Fully-convolutional Siamese networks for object tracking[M] //Lecture Notes in Computer Science. Cham: Springer International Publishing, 2016: 850- 865.

[9] ValmadreJ, BertinettoL, HenriquesJ, et al.End-to-end representation learning for correlation filter based tracking[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). July 21-26, 2017, Honolulu, HI, USA.New York: IEEE Press, 2017: 5000- 5008.

[10] LiB, Yan JJ, WuW, et al. High performance visual tracking with Siamese region proposal network[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR), Salt Lake City, USA, 2018: 8971- 8980.

[11] 仇祝令, 查宇飞, 朱鹏, 等. 基于孪生神经网络在线判别特征的视觉跟踪算法[J]. 光学学报, 2019, 39(9): 0915003.

[12] 陈志旺, 张忠新, 宋娟, 等. 基于目标感知特征筛选的孪生网络跟踪算法[J]. 光学学报, 2020, 40(9): 0915003.

[14] Howard AG, Zhu ML, ChenB, et al.( 2017-04-17)[2020-05-13]. org/abs/1704. 04861. https://arxiv.

[15] Selvaraju R R, Cogswell M, Das A, et al. Grad-CAM: visual explanations from deep networks via gradient-based localization[J]. International Journal of Computer Vision, 2020, 128(2): 336-359.

[16] WooS, ParkJ, Lee JY, et al. CBAM: convolutional block attention module[C]//European Conference on Computer Vision, 2018: 3- 19.

[17] Krizhevsky A, Sutskever I, Hinton G E. ImageNet classification with deep convolutional neural networks[J]. Communications of the ACM, 2017, 60(6): 84-90.

[18] RealE, ShlensJ, MazzocchiS, et al.YouTube-BoundingBoxes: a large high-precision human-annotated data set for object detection in video[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). July 21-26, 2017, Honolulu, HI, USA. New York: IEEE Press, 2017: 7464- 7473.

[19] Wu Y, Lim J, Yang M H. Object tracking benchmark[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1834-1848.

[20] DanelljanM, HägerG, Khan FS, et al.Learning spatially regularized correlation filters for visual tracking[C]//2015 IEEE International Conference on Computer Vision (ICCV). December 7-13, 2015, Santiago, Chile.New York: IEEE Press, 2015: 4310- 4318.

[21] JiaX, Lu HC, Yang MH. Visual tracking via adaptive structural local sparse appearance model[C]//2012 IEEE Conference on Computer Vision and Pattern Recognition. June 16-21, 2012, Providence, RI, USA.New York: IEEE Press, 2012: 1822- 1829.

[22] Li Y, Zhu J K. A scale adaptive kernel correlation filter tracker with feature integration[J]. Computer Vision-ECCV 2014 Workshops, 2015: 254-265.

[23] DanelljanM, HägerG, Shahbaz KhanF, et al. Accurate scale estimation for robust visual tracking[C]//Proceedings of the British Machine Vision Conference 2014. Nottingham. British Machine Vision Association, 2014: 1- 11.

[24] MuellerM, SmithN, GhanemB. A benchmark and simulator for UAV tracking[M] //Computer Vision-ECCV 2016. Cham: Springer International Publishing, 2016: 445- 461.

Article Outline

崔洲涓, 安军社, 张羽丰, 崔天舒. 面向无人机的轻量级Siamese注意力网络目标跟踪[J]. 光学学报, 2020, 40(19): 1915001. Zhoujuan Cui, Junshe An, Yufeng Zhang, Tianshu Cui. Light-Weight Siamese Attention Network Object Tracking for Unmanned Aerial Vehicle[J]. Acta Optica Sinica, 2020, 40(19): 1915001.

![MobileNetV2[13]卷积模块框图](/richHtml/gxxb/2020/40/19/1915001/img_2.jpg)