结合稠密轨迹与视频显著性特征的人体动作识别  下载: 1003次

下载: 1003次

1 引言

人体动作识别是指通过机器视觉技术对摄像机采集到的视频图像数据进行有关的处理和分析,检测出图像序列中的行为动作,并通过相邻帧之间时空特征的关联性对其表征,最后对提取的特征进行学习并理解其中的行为动作。近年来随着人工智能相关技术的蓬勃发展,基于视频图像序列的人体动作识别已成为计算机视觉领域研究的热点问题,在视频检索、智能视频监控、人机交互、自动驾驶等领域得到了广泛的应用。

动作识别过程中如何提取有效且稳健的动作特征以及如何选取性能优良的分类器来对动作类别进行预测分类,对识别性能起着至关重要的作用[1]。由于人体动作在图像表观上类内以及类间变化差异较大,对于真实场景下的视频,动态背景的分析与处理是研究人员亟待解决的问题。背景运动一般由背景目标运动或者拍摄过程中相机运动引起,在整个视频中占据较大的范围甚至会覆盖人体动作,通常以相似的方式存在于视频中,这意味着背景运动一般在每个单独的帧中呈现统一的模式,背景运动的表示具有较大的相关性。相比之下,动作相关区域的运动是行为和背景运动的混合,在空间域中表现出不规则的特性。传统的动作特征表示方法中,基于全局特征[2]和局部特征[3-4]的动作特征表示已经日渐完善。Wang等[5]提出了基于稠密轨迹(DT)的动作识别算法,该算法在诸多真实场景下的动作识别数据集上都取得了较好的识别结果。然而对于具有动态背景的视频,采样点落在了与动作无关的背景区域,产生了过多的背景轨迹,稠密轨迹算法在每一帧所有区域内的密集采样,并无区分动作区域和背景区域,在动作表征时若对动作相关轨迹和背景轨迹等同处理,必然会降低识别性能。为解决此类问题,Wang等[6]利用前后帧图像存在的单应性关系,通过投影变换矩阵估计相机运动,消除了背景中由相机运动产生的干扰性轨迹,改进后的稠密轨迹算法(IDT)在鲁棒性和识别效果上取得了较大的提升。受人类视觉感知系统的启发,视觉显著性特征在静态图像和视频图像领域取得了较大的成功与广泛的应用[7-11]。Wang 等[12]针对视频中的特征表示,利用显著图来进行特征选择,进而稀疏提取信息丰富的兴趣点。Yi等[13]首先计算原始稠密轨迹的表观显著性和运动显著性,然后对二者的显著性值利用线性组合的方式得到轨迹的联合显著性,去除了冗余轨迹,保留了与动作相关区域的轨迹。Somasundaram等[14]在柯式复杂性和信息论的基础上,利用稀疏编码的残差确定显著的时空区域,并假设残差越大,时空块越显著。Li等[15]通过运动显著性分析来提纯轨迹,并根据运动显著性的强度分布来优化词袋模型,用于从复杂视频的上下文中学习识别特征。Yi等[16]利用显著性区域提取动作特征,降低了计算和存储的成本。本文受到视频显著性检测相关工作[17-18] 上角标的启发,旨在真实场景的视频中获取与动作相关的区域,并在此区域中提取动作轨迹来表征人体动作。其中最关键的问题是在视频中找到动作相关区域,由于动作相关区域一般都具有较强的表观显著性和运动显著性,故可以将此任务简化为视频中行为显著区域的检测。

2 理论与方法

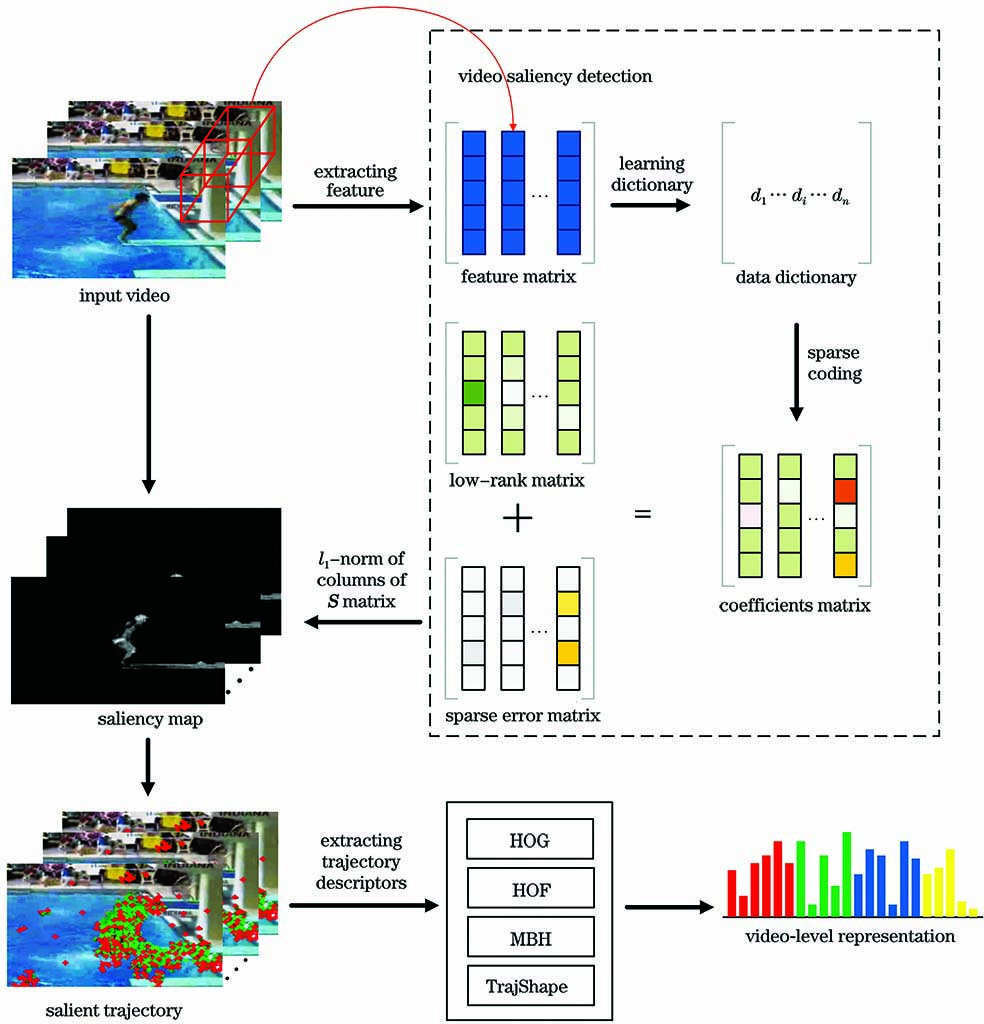

本文方法的框架如

2.1 显著性区域检测

本研究的重点是检测与动作相关的显著性区域,结合在视频图像领域中视觉显著性研究的相关工作[7-11], 将动作视频分解为稀疏表示的显著部分和均匀规则的非显著部分。假设视频Vi=[I1,I2,…,It,…,IT],t∈[1,T],It表示第t帧,将视频分割成不重叠的时空块,大小为s×s×t,空域大小为s×s,时域长度为t,以视频Vi为例,利用低秩分解的方法对其显著性展开论述。设F表示特征矩阵,并将F分解为低秩矩阵L和稀疏误差矩阵S,即

其中满足

式中,rank(L)是低秩矩阵L的秩,λ是平衡低秩和稀疏性的权重因子。

由于(2)式是一个NP-hard问题,利用松弛凸优化方案,用l1范数替代l0范数,核范数替代L的秩,故(2)式可重新改写为

在低秩分解前首先要找到一个合适的特征矩阵来作为低秩分解的输入,利用之前已划分视频Vi的时空块构造特征矩阵,即

其中,Xi是构成时空块i的特征向量,m是向量的维数,n是向量的个数。对得到的特征矩阵进行字典学习,设字典D=[d1,d2,…,dk]∈Rm×k,则时空块的特征向量可以表示为

其中,dj是字典原子,βji是相对应的系数,ε是高斯噪声组成的m维向量。将(5)式改写为

因此,把Xi表示为稀疏编码βi=[β1i,β2i,…,βki]∈Rk×1,也就是说每个特征向量都可以表示为字典中原子的稀疏线性组合。学习特征向量的稀疏表示可表示为

其中,β是特征点稀疏表示的系数矩阵,λ*是平衡稀疏性的正则化参数。在得到特征的稀疏表示后,使用增广拉格朗日乘子(ALM)法通过优化(3)式来求解得到低秩矩阵和稀疏误差矩阵。求解稀疏误差矩阵S序列的

2.2 稠密轨迹

基于轨迹的动作特征表示已经被证明是一种有效的特征表示方法。Wang等[5]提出了更为有效的稠密轨迹来对动作进行描述,其算法原理如

对于视频的每一帧,在w个像素为间隔的网格上采样特征点并在不同的空间尺度下分别追踪采样点。在t帧的特征点Pt=(xt,yt)通过在密集光流场ωt=(ut,vt)的中值滤波操作,可以在t+1帧追踪得到,其位置定义为

其中M是3×3的中值滤波核,ut和vt分别为光流的垂直分量和水平分量。后续帧的特征点连接起来形成轨迹

然后将位移向量的大小求和,对轨迹的形状进行正则化表示,表达式为

最终,将S'作为轨迹的唯一描述符。

2.3 基于显著性的轨迹

将显著图融入到密集跟踪的过程中,以提取视频中与动作相关的稠密轨迹,形成的轨迹中既具有重要的几何特性又具有较强的视觉显著性。在得到视频显著图后,假定动作区域内特征点的显著性强度值大于给定阈值Ts,对任意的一条轨迹Ti,计算它的每一个轨迹点P(t,i)的显著性值S(Pt,i),然后与给定阈值Ts比较,如果该点的显著性强度大于Ts,则认为该点为有效的轨迹点,否则,在该点处终止轨迹Ti的追踪。重新定义显著性轨迹,表达式为

其中,T是稠密轨迹的集合。如果隶属于原始轨迹集合中任意特征点的显著性值大于给定的显著性阈值Ts,则将该点归属于集合Tsalient。将Tsalient中的点代入(8)~(11)式重新确定轨迹的形状和位移向量。在整个与动作相关的显著性区域内重复以上过程,实现了仅保留与行为有关的轨迹、去除由背景运动导致的冗余轨迹。

2.4 动作分类

对于每一条显著性轨迹,计算4种类型的行为描述符:方向梯度直方图、光流直方图、运动边界直方图和轨迹形状(TrajShape),然后使用Fisher向量对这4种描述符进行统一编码,得到最终的视频表示,并将其输入到支持向量机(SVM)中预测动作类别。选取χ2核函数的非线性支持向量机对动作进行分类:

其中Hp和Hq为两个视频的直方图,D(Hp,Hq)是两个直方图的χ2距离,Z为所有训练样本直方图χ2距离的平均值。

3 分析与讨论

3.1 实验数据集和实验环境

为了验证本文动作识别方法的有效性,在UCF Sports和YouTube两个公开的动作数据集上进行实验测试。

UCF Sports数据集[19]总共有150个行为视频,分辨率为720 pixel ×480 pixel,包含10种不同类的动作:跳水、打高尔夫、踢足球、举重、骑马、跑步、滑板、鞍马、单双杠和步行。该数据集具有场景大、视角广的特征,包含了大量的相机运动。

YouTube数据集[20]中的视频来源于YouTube视频网站,是一个更具有挑战性的数据集。数据集总共有1168个视频序列,包含11个动作类:投篮、骑自行车、跳水、打高尔夫球、骑马、颠足球、荡秋千、打网球、蹦床、打排球和遛狗。YouTube数据集包含运动相机和固定相机的混合、目标的尺度变化、视角和光线的变化、分辨率低、复杂背景和背景目标运动等干扰性因素。

图 3. 动作样本帧实例(UCF Sports/YouTube)。(a)UCF Sports数据集;(b)YouTube数据集

Fig. 3. Sample frames from UCF Sports and YouTube. (a) UCF Sports; (b) YouTube

本文方法以Linux操作系统为实验平台,采用opencv2.4.9作为开发环境。算法实现的环境如

表 1. 实验环境

Table 1. Experimental environment

|

3.2 实验参数优化

为了降低计算代价,将数据集中的视频大小调整为原始视频的四分之一,用于显著性区域的检测。本研究中将视频分割为不重叠的时空块,构造特征矩阵,进一步将其作为显著性区域检测过程中低秩分解的输入,通过与给定阈值Ts比较得到视频显著图。

在两个数据集上测试显著性阈值Ts对整体识别性能的影响,每次增加相同的步长,见

3.3 实验结果

由于传统稠密轨迹算法只考虑了特征的几何特性,未考虑显著性,所以并不能很好地区分动作区域和背景运动区域。如

图 5. 本文方法与稠密轨迹方法的可视化比较。(a)UCF Sports数据集;(b)YouTube数据集

Fig. 5. Comparison of the DT and our method. (a) UCF Sports; (b) YouTube

图 6. 本文方法与稠密轨迹方法对每个动作类识别率的比较。(a)UCF Sports数据集;(b)YouTube数据集

Fig. 6. Accuracy comparison of each class by DT and our method. (a) UCF Sports; (b) YouTube

表 2. 本文方法与传统稠密轨迹方法平均识别准确率的比较

Table 2. Comparison of mean accuracy by DT and our method unit: %

|

表 3. 本文方法与当前先进算法实验结果的对比

Table 3. Results comparison of our method and the state-of-the-art method unit: %

| ||||||||||||||||||||||||||||||||

4 结论

为了有效地处理传统稠密轨迹表示冗余性的问题,提出了一种新的稠密轨迹采样策略(S-Traj),基于低秩分解的思想,利用时空信息将视频分解为存在背景运动的低秩矩阵和与动作相关的稀疏误差矩阵,使用得到的稀疏矩阵计算视频显著图并根据显著图指示的区域提取轨迹。实验结果表明,对视频中背景运动带来的干扰进行了较好的处理,节省了内存的开销。在两个公开的数据集上本文的方法取得了较好的识别性能,与传统的稠密轨迹算法相比,识别准确率取得了一定程度的提升。本文方法虽然对传统的稠密轨迹做出了更有效的表示,但是由于对显著性区域的分析,增加了算法的时间复杂度,未来的研究将主要降低算法复杂度、提高算法普适性。

[1] 罗会兰, 王婵娟, 卢飞. 视频行为识别综述[J]. 通信学报, 2018, 39(6): 169-180.

Luo H L, Wang C J, Lu F. Survey of video behavior recognition[J]. Journal on Communications, 2018, 39(6): 169-180.

[2] Bobick A F, Davis J W. The recognition of human movement using temporal templates[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2001, 23(3): 257-267.

[3] Laptev I. On space-time interest points[J]. International Journal of Computer Vision, 2005, 64(2/3): 107-123.

[4] DollarP, RabaudV, CottrellG, et al.Behavior recognition via sparse spatio-temporal features[C]∥2005 IEEE International Workshop on Visual Surveillance and Performance Evaluation of Tracking and Surveillance, October 15-16, 2005, Beijing, China.New York: IEEE Press, 2005: 65- 72.

[6] WangH, SchmidC. Action recognition with improved trajectories[C]∥2013 IEEE International Conference on Computer Vision, December 1-8, 2013, Sydney, NSW, Australia.New York: IEEE Press, 2013: 3551- 3558.

[7] Liu X, Zhao G Y, Yao J W, et al. Background subtraction based on low-rank and structured sparse decomposition[J]. IEEE Transactions on Image Processing, 2015, 24(8): 2502-2514.

[9] 李艳荻, 徐熙平. 基于超像素时空特征的视频显著性检测方法[J]. 光学学报, 2019, 39(1): 0110001.

[10] Duan L J, Xi T, Cui S, et al. A spatiotemporal weighted dissimilarity-based method for video saliency detection[J]. Signal Processing: Image Communication, 2015, 38: 45-56.

[11] 李庆武, 周亚琴, 马云鹏, 等. 基于双目视觉的显著性目标检测方法[J]. 光学学报, 2018, 38(3): 0315002.

[12] WangL, Zhao DB. Recognizing actions using salient features[C]∥2011 IEEE 13th International Workshop on Multimedia Signal Processing, October 17-19, 2011, Hangzhou, China.New York: IEEE Press, 2011: 1- 6.

[13] Yi Y, Lin Y K. Human action recognition with salient trajectories[J]. Signal Processing, 2013, 93(11): 2932-2941.

[14] Somasundaram G, Cherian A, Morellas V, et al. Action recognition using global spatio-temporal features derived from sparse representations[J]. Computer Vision and Image Understanding, 2014, 123: 1-13.

[15] Li Q, Cheng H, Zhou Y, et al. Human action recognition using improved salient dense trajectories[J]. Computational Intelligence and Neuroscience, 2016, 2016: 6750459.

[16] Yi Y, Zheng Z X, Lin M Q. Realistic action recognition with salient foreground trajectories[J]. Expert Systems With Applications, 2017, 75: 44-55.

[17] Wang X F, Qi C. Saliency-based dense trajectories for action recognition using low-rank matrix decomposition[J]. Journal of Visual Communication and Image Representation, 2016, 41: 361-374.

[18] Wang X F, Qi C, Lin F. Combined trajectories for action recognition based on saliency detection and motion boundary[J]. Signal Processing: Image Communication, 2017, 57: 91-102.

[19] Rodriguez MD, AhmedJ, ShahM. Action MACH a spatio-temporal Maximum Average Correlation Height filter for action recognition[C]∥2008 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2008, Anchorage, AK, USA.New York: IEEE Press, 2008: 1- 8.

[20] Liu JG, Luo JB, ShahM. Recognizing realistic actions from videos “in the wild”[C]∥2009 IEEE Conference on Computer Vision and Pattern Recognition, June 20-25, 2009, Miami, FL, USA.New York: IEEE Press, 2009: 1996- 2003.

[21] Cho J, Lee M, Chang H J, et al. Robust action recognition using local motion and group sparsity[J]. Pattern Recognition, 2014, 47(5): 1813-1825.

[22] Yang XD, Tian YL. Action recognition using super sparse coding vector with spatio-temporal awareness[C]∥ Fleet D, Pajdla T, Schiele B, et al. Computer Vision-ECCV 2014. Cham: Springer, 2014: 727- 741.

[24] Guo YN, MaW, Duan LJ, et al.Human action recognition based on discriminative supervoxels[C]∥2016 International Joint Conference on Neural Networks (IJCNN), July 24-29, 2016, Vancouver, BC, Canada.New York: IEEE Press, 2016: 3863- 3869.

[25] 段立娟, 郭亚楠, 乔元华, 等. 基于判别性区域提取的视频人体动作识别方法[J]. 北京工业大学学报, 2017, 43(10): 1480-1487.

Duan L J, Guo Y N, Qiao Y H, et al. Human action recognition based on extracted discriminative regions[J]. Journal of Beijing University of Technology, 2017, 43(10): 1480-1487.

[26] Wang LM, QiaoY, Tang XO. Action recognition with trajectory-pooled deep-convolutional descriptors[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA.New York: IEEE Press, 2015: 4305- 4314.

[27] 李庆辉, 李艾华, 王涛, 等. 结合有序光流图和双流卷积网络的行为识别[J]. 光学学报, 2018, 38(6): 0615002.

Article Outline

高德勇, 康自兵, 王松, 王阳萍. 结合稠密轨迹与视频显著性特征的人体动作识别[J]. 激光与光电子学进展, 2020, 57(24): 241003. Deyong Gao, Zibing Kang, Song Wang, Yangping Wang. Human-Body Action Recognition Based on Dense Trajectories and Video Saliency[J]. Laser & Optoelectronics Progress, 2020, 57(24): 241003.