基于改进Frustum PointNet的3D目标检测  下载: 908次

下载: 908次

1 引言

随着自动驾驶技术的发展,3D目标检测变得越来越重要。3D目标检测是在自动驾驶环境中感知动态障碍物,如车辆、行人和自行车[1],实现难度大。基于图像的3D目标检测,其准确率较低,近年来In0.53Ga0.47As(InGaAs)单光子探测阵列的深入研究推动了激光雷达的发展[2],因此基于激光雷达以及基于图像与激光雷达融合的方案越来越多且准确率较高。融合的方案能够结合图像与激光雷达的优势,有效提高3D目标检测的准确率,但是如何融合才能减少较少的信息损失且同时剔除大量的冗余信息,这是提高3D目标检测效果的关键。

基于RGB(Red,Green,Blue)图像和激光点云融合数据的3D目标检测方法主要有多视图融合检测框架和PointNet融合检测框架[3]。Chen等[4]提出的MV3D(Multi-View 3D)检测网络是典型的多视图融合检测结构,使用激光点云数据的前视图和鸟瞰图来表示三维点云信息,并与RGB图像融合以预测定向3D边界框,但是该网络使用的是转换成视图的点云数据,不是原始点云数据,这会造成信息损失。Qi等[5]提出的F-PointNet(Frustum PointNet)是典型的PointNet融合检测结构,通过Mask R-CNN(Region Convolutional Neural Networks)[6]结合深度信息以得到视锥目标区域,然后使用PointNet++[7]对得到的视锥区域进行目标的3D边界框回归估计,该网络是在原始点云上进行特征提取的,但是边界框预测直接使用了掩模结果,这依旧会存在信息损失的问题。万鹏[8]在F-PointNet的基础上修改参数初始化的方式、增加正则化以及减少T-Net(Transform Network)卷积核数,有效提升了检测精度,但是并未解决原始网络信息损失的问题。

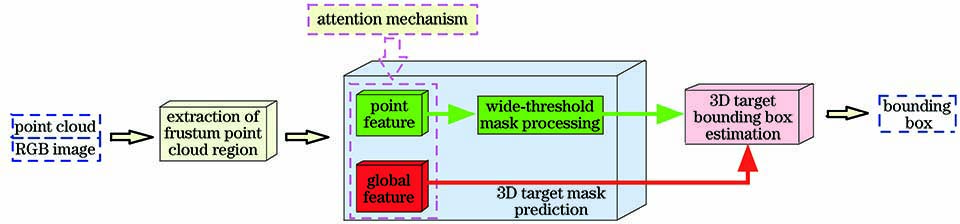

经过掩模预测后,发现大部分非目标点的预测概率接近0,剩余部分目标点的预测概率既有大于0.5,也有小于0.5。因此本文对F-PointNet中掩模预测部分的网络结构进行改进,使用宽阈值掩模处理放宽掩模判定的边界,解决原始网络在该处损失信息的问题。同时增加注意力机制[9]并提取全局特征以进一步增加目标信息,并且更换损失函数为适合目标点较少、背景点较多的Focal Loss[10],通过多个对比实验,证明改进的F-PointNet可以提高3D目标检测的效果。

2 基本原理

2.1 整体网络框架

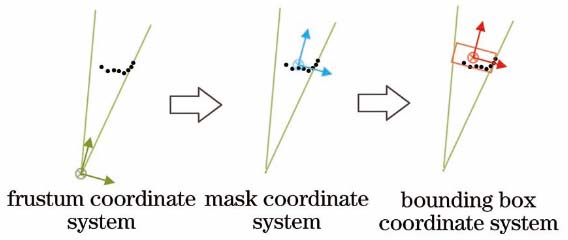

原有F-PointNet的基础架构由锥形点云候选区域提取部分、3D目标掩模预测部分以及3D目标边界框预测部分组成,对3D目标掩模预测部分的网络结构进行改进,改进的F-PointNet如

2.2 锥形点云候选区域的提取

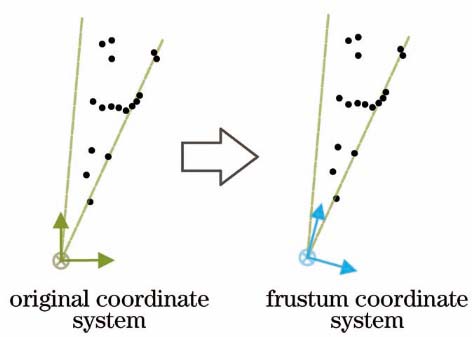

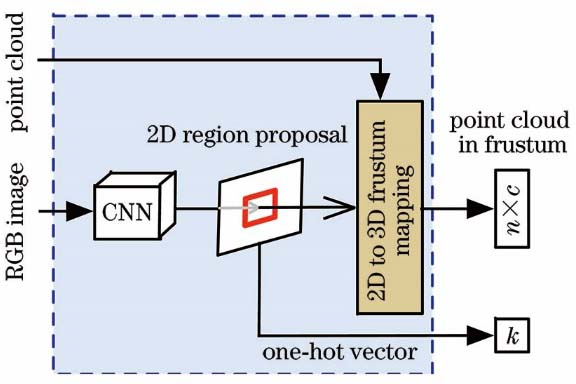

锥形点云候选区域提取部分的整体网络结构如

图 2. 锥形点云候选区域提取的网络结构

Fig. 2. Network structure for extracting candidate regions of frustum point cloud

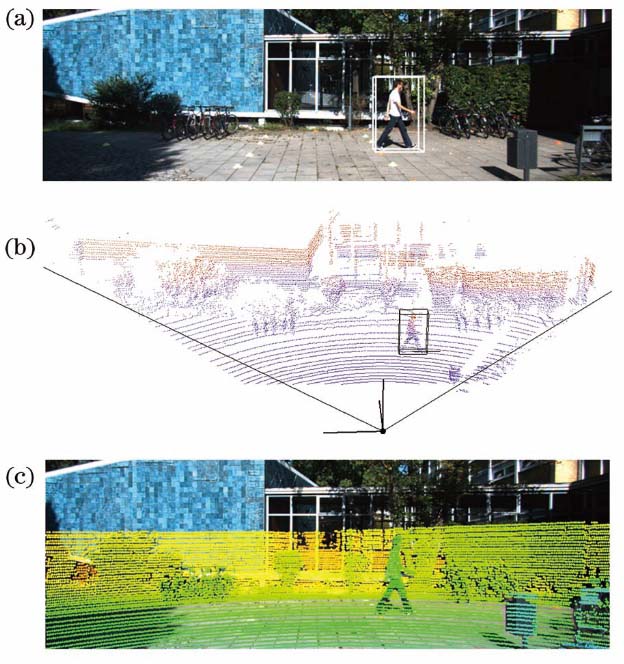

图 3. 2D图像与3D点云的配准结果。(a) RGB图像;(b)3D点云数据;(c)图(a)与图(b)的配准效果

Fig. 3. Registration results of 2D images and 3D point clouds. (a) RGB image; (b) 3D point cloud data; (c) registration effect of Fig. (a) and Fig. (b)

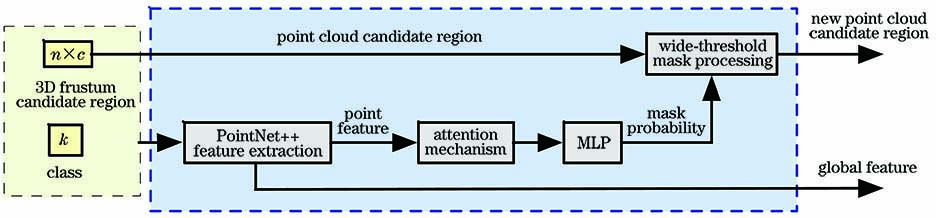

2.3 3D目标掩模预测

3D目标掩模预测部分是将候选区域的点云数据(每个候选区域只包含一个感兴趣目标)输入到3D目标掩模预测网络中,以预测候选点云区域中每个点的概率得分,进而得到该候选区域的目标掩模预测结果,最后根据预测的掩模结果,在3D目标视锥候选区域点云中提取目标实例点云。3D目标掩模预测网络如

当预测3D目标边界框时,需要利用掩模结果来提取目标实例点云,这可能会出现由于目标掩模预测结果不准确而缺失有用信息的情况。因此采用宽阈值掩模处理放宽判定目标掩模的边界,从原来大于1/2为掩模,放宽为大于(1-xmargin)/2,其中xmargin为原阈值被放宽的程度,取值范围为0~1。该处理过程不仅能够将大部分预测概率接近于0的非目标点剔除,而且能够有效保留预测概率小于0.5的目标点。通过多次实验,实验选取最佳的xmargin=0.2,既减少在3D目标边界框预测输入的冗余信息,又增加有用信息,有利于获得更好的检测结果。

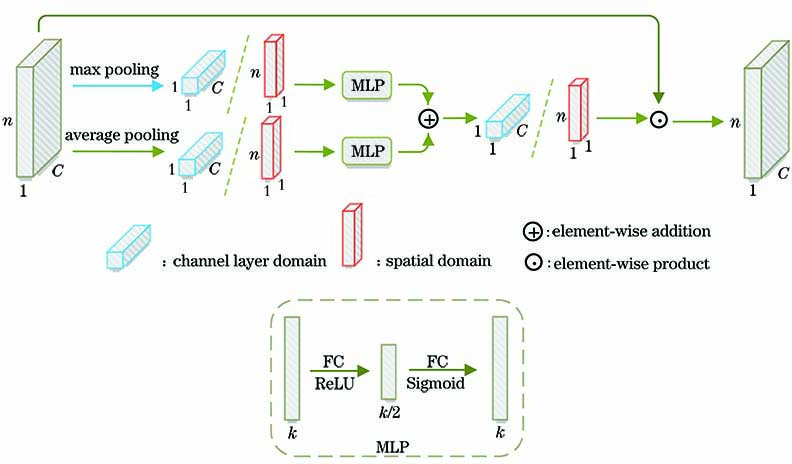

受到基于二维图像的混合域软注意力机制的启发,实验对3D点云数据的注意力机制分为空间域和通道域。空间域注意力机制能够找到3D点云数据中需要关注的点,通道域能够找到特征图中需要关注的通道层,实现方式均采用基础的注意力模型。

原始掩模预测网络使用的是普通的交叉熵损失函数,但是由于点云数据中目标前景点与背景点的数量比例十分不平衡,拥有大量的背景无关点。普通的交叉熵损失函数无法挖掘前景点的重要性,因此实验中使用Focal Loss损失函数,其能够降低大量背景点在训练中所占的权重,使得训练更关注前景点即目标物体,掩模预测损失计算公式为

式中:p为预测概率;α为权重因子,能够平衡正负样本的重要性;γ为调制因子,能够调节样本权重降低的速率;y为真值的类别,对于y=1,预测概率为p。实验过程中,α取0.25,γ取2。

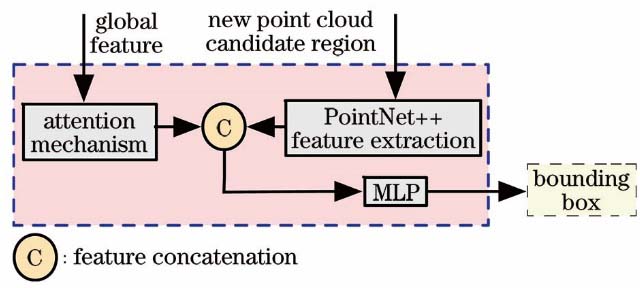

2.4 3D目标边界框预测

3D目标边界框预测部分是对2.3节得到的目标实例点云和全局特征进行3D目标检测,网络结构如

2.5 损失函数

改进的F-PointNet使用与原始网络一样的多任务损失函数Lmulti-task,其包含3D目标掩模预测损失函数Lmask和3D目标边界框预测损失函数Lbbox。3D目标边界框预测损失函数与原始网络相同,包含T-Net产生的损失函数Lc1-reg、目标边界框中心预测的损失函数Lc2-reg、目标方位角的分类损失函数Lh-cls和回归损失函数Lh-reg、目标边界框大小的分类损失函数Ls-cls和回归损失函数Ls-reg、目标边界框中8个顶点的损失函数Lcorner。但是3D目标掩模预测损失函数与原始网络不同,使用2.3节(1)式的Focal Loss。Lmulti-task计算公式为

Lh-cls和Ls-cls使用Softmax交叉熵损失函数,Lmask使用Focal Loss,Lc1-reg、Lc2-reg、Lh-reg和Ls-reg使用L1范数损失函数损失,λ和γ沿用原始网络中的设置,Lcorner是指预测的边界框与真值之间对应8个顶点的距离之和。

3 分析与讨论

3.1 实验配置与数据

所提网络使用TensorFlow框架来实现,数据使用公开的KITTI数据集[13],实验配置如

表 1. 实验配置

Table 1. Experimental configuration

|

3.2 实验步骤

首先在ImageNet分类和COCO目标检测数据集上对2D目标检测模型的权重进行预训练,在KITTI 2D目标检测数据集上对预训练后的数据集进行微调。然后使用训练好的2D目标检测器得到2D目标,再提取KITTI数据集中的3D点云候选数据并进行存储。最后,使用存储的候选区域点云数据进行3D目标掩模预测和3D目标边界框预测的联合训练。模型训练过程中,先进行宽阈值掩模实验,实验时设定多个阈值并从中选择平均准确率(AP)最高的阈值,然后在该阈值下对各处理部分进行对比,最后将最终改进模型的结果与其他模型进行比较。学习率选择0.001,其随训练衰减,优化器选择Adam算法,Batch大小为12,训练执行100轮。

3.3 实验结果及分析

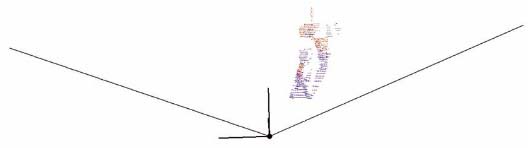

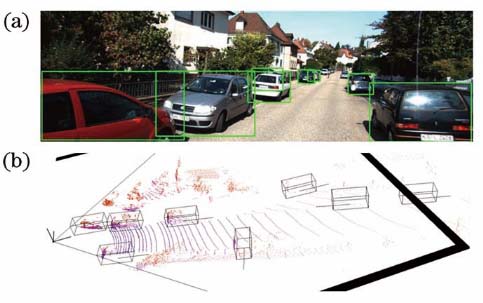

可视化的候选区域提取结果如

表 2. 各阈值下3D目标检测的AP值

Table 2. AP values of 3D target detection under each threshold unit: %

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

图 10. 可视化的3D目标边界框预测结果。(a) 2D目标检测结果;(b) 3D目标检测结果

Fig. 10. Visual 3D target bounding box prediction results. (a) 2D target detection result; (b) 3D target detection result

为了验证各个处理部分对原始网络的影响程度,仅对汽车类别进行对比实验,结果如

表 3. 各处理部分对AP值的影响

Table 3. Influence of each processing part on AP values

| ||||||||||||||||||||||||||||||||||||||||||

表 4. 不同模型的AP值对比

Table 4. Comparison of AP values of different models

| |||||||||||||||||||||||||||

4 结论

为了提高3D目标检测的准确率,对F-PointNet的掩模预测部分进行改进,使用宽阈值掩模处理,增加注意力机制并更换损失函数为Focal Loss。实验结果表明,宽阈值掩模处理在减少点云冗余信息的同时,能够充分利用其有用信息,最终与基于其他网络的3D目标检测相比,基于改进的F-PointNet的3D目标检测可以获得较优的结果。但针对无人驾驶领域的3D目标检测研究,准确率还有提升的空间,后续的研究将进一步在网络结构设计及目标检测过程的机理上深入挖掘。

[1] 张银, 任国全, 程子阳, 等. 三维激光雷达在无人车环境感知中的应用研究[J]. 激光与光电子学进展, 2019, 56(13): 130001.

[2] 刘凯宝, 杨晓红, 何婷婷, 等. InP基近红外单光子雪崩光电探测器阵列[J]. 激光与光电子学进展, 2019, 56(22): 220001.

[3] 季一木, 陈治宇, 田鹏浩, 等. 无人驾驶中3D目标检测方法研究综述[J]. 南京邮电大学学报(自然科学版), 2019, 39(4): 72-79.

[4] Chen XZ, Ma HM, WanJ, et al. Multi-view 3D object detection network for autonomous driving[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 6526- 6534.

[5] Qi CR, LiuW, Wu CX, et al. Frustum PointNets for 3D object detection from RGB-D data[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 918- 927.

[6] He K M, Gkioxari G, Dollar P, et al. Mask R-CNN[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 42(2): 386-397.

[7] Qi CR, YiL, SuH, et al. ( 2017-07-07)[2019-12-23]. https:∥arxiv.org/abs/1706. 02413.

[8] 万鹏. 基于F-PointNet的3D点云数据目标检测[J]. 山东大学学报(工学版), 2019, 49(5): 98-104.

Wan P. Object detection of 3D point clouds based on F-PointNet[J]. Journal of Shandong University (Engineering Science), 2019, 49(5): 98-104.

[9] WooS, ParkJ, Lee JY, et al. CBAM: convolutional block attention module[M] ∥Ferrari V, Hebert M, Sminchisescu C, et al. Computer vision-ECCV 2018. Lecture notes in computer science. Cham: Springer, 2018, 11211: 3- 19.

[10] Lin T Y, Goyal P, Girshick R, et al. Focal loss for dense object detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 42(2): 318-327.

[11] Lin TY, DollárP, GirshickR, et al. Feature pyramid networks for object detection[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 936- 944.

[12] JaderbergM, SimonyanK, ZissermanA, et al. ( 2016-02-04)[2019-12-23]. https:∥arxiv.org/abs/1506. 02025.

[13] GeigerA, LenzP, UrtasunR. Are we ready for autonomous driving? The KITTI vision benchmark suite[C]∥2012 IEEE Conference on Computer Vision and Pattern Recognition, June 16-21, 2012, Providence, RI, USA. New York: IEEE, 2012: 3354- 3361.

[14] LiangM, YangB, Wang SL, et al. Deep continuous fusion for multi-sensor 3D object detection[M] ∥Ferrari V, Hebert M, Sminchisescu C, et al. Computer vision-ECCV 2018. Lecture notes in computer science. Cham: Springer, 2018, 11220: 663- 678.

[15] DengJ, CzarneckiK. MLOD: a multi-view 3D object detection based on robust feature fusion method[C]∥2019 IEEE Intelligent Transportation Systems Conference (ITSC), October 27-30, 2019, Auckland, New Zealand. New York: IEEE, 2019: 279- 284.

刘训华, 孙韶媛, 顾立鹏, 李想. 基于改进Frustum PointNet的3D目标检测[J]. 激光与光电子学进展, 2020, 57(20): 201508. Xunhua Liu, Shaoyuan Sun, Lipeng Gu, Xiang Li. 3D Object Detection Based on Improved Frustum PointNet[J]. Laser & Optoelectronics Progress, 2020, 57(20): 201508.