融合光谱信息的机载LiDAR点云三维深度学习分类方法  下载: 1397次

下载: 1397次

ing at the problem that the traditional 2D deep learning method can not realize the 3D point cloud classification, this study proposes a novel classification method for airborne LiDAR point clouds based on 3D deep learning. First, airborne LiDAR point clouds and multi-spectral imagery are fused to expand the spectral information of point clouds. Then, 3D point clouds are placed on grids to make the LiDAR data suitable for the 3D deep learning. Subsequently, the local and global features in different scales are extracted by multi-layer perceptron. Finally, airborne LiDAR point clouds are classified into semantic objects using the 3D deep learning algorithm. The data sets provided by the International Society of Photogrammetry and Remote Sensing (ISPRS) are used to validate the proposed method, and the experimental results show that the classification accuracy can be increased by 13.39% by fusing the LiDAR point clouds and multi-spectral images. Compared with some of the methods submitted to ISPRS, the proposed method achieves better performance by simplifying the process of feature extraction.

1 引言

现代城市正在由数字城市向智慧城市转变[1],传统的二维数据已经不能满足人们对真实三维空间认知的需求。机载激光雷达(LiDAR)能够直接获取各种地物的三维空间信息,在测绘、林业、电力等行业得到了广泛应用。然而,从离散、不规则分布且包含有噪声的机载LiDAR点云数据中,准确且自动地分类和解译出各种典型地物目标仍有较大的难度,成为近些年来的研究热点之一。

目前,针对点云数据进行分类的主要方法是传统的机器学习方法,该方法首先提取分类对象的特征,然后基于特征向量构建相应的判别模型,最后基于判别模型进行分类。如Zhang等[2]使用支持向量机(SVM)对LiDAR数据进行分类,何曼芸等[3]使用随机森林(RF)对城区LiDAR数据进行分类,而Niemeyer等[4]则采用一种基于条件随机场(CRF)的上下文分类方法实现LiDAR点云分类。上述方法需要人工提取点云数据的各种特征,对于数据量较大的机载LiDAR数据提取,存在计算时间较长和特征表达受限的问题。为了解决上述问题,学者们开始研究基于深度学习的点云分类方法。该方法通过级联神经网络逐层抽象得到特征,不需要人工提取特征,可以在提高运算效率的同时,取得比传统机器学习方法更好的效果[5]。早期基于深度学习的方法侧重于将点云处理成非点云的形式进行训练,例如:Yi等[6-7]从三维物体的不同视角生成二维图片,然后利用卷积神经网络进行三维点云分类;Maturana等[8-9]对三维点云进行体素化,再通过神经网络训练完成分类。这种分类方法会造成原始数据特征损失,同时产生一定程度的数据冗余。近些年来,基于点云数据的三维深度学习方法开始出现并受到了一定程度的关注,例如斯坦福大学的Charles等[10]提出了PointNet框架。PointNet是一个可以直接对三维点云进行训练的深度学习框架,它可以充分利用点云的数据特性,降低网络计算的复杂度[11]。赵中阳等[12]研究了基于PointNet的机载LiDAR点云数据分类方法,但是由于点云数据分布具有稀疏性和不规则性,且缺少其他辅助信息的有效支持,分类结果的精度仍有待提高。

针对上述问题,本文提出一种融合光谱信息的机载LiDAR点云三维深度学习分类方法。该方法首先利用多光谱航空影像来扩充点云的光谱信息,然后采用多层感知机提取出多尺度的点特征和全局特征,最后基于PointNet三维深度学习框架实现机载LiDAR点云的准确分类。

2 三维深度学习分类算法

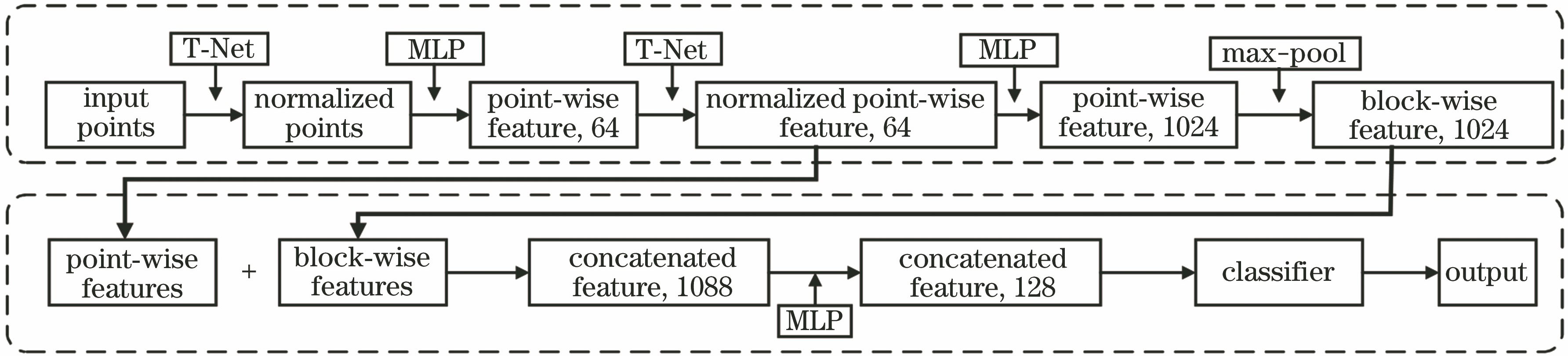

为将传统深度学习方法应用于三维点云分类,多数学者通常将点云处理成二维图像或者进行体素化用于训练和分类。在此过程中,将三维数据投影为二维数据时会出现原始数据特征丢失,点云体素化则会造成一定的数据冗余。为了解决这些问题,Charles等[10]提出了一种直接对三维点云进行训练和分类的深度学习框架PointNet,并采用如下策略来保证PointNet框架能够直接对三维点云进行分类:1)使用规范化操作保证点云旋转不变性;2)使用最大池化操作来避免点云无序性;3)使用点特征和全局特征串联的方式进行信息聚合,以增加点云的空间关系描述。

点云旋转不变性是指点云数据发生旋转或平移时,其分类输出结果保持不变。PointNet从输入数据中学习与特征空间维度一致的变换矩阵,然后将变换矩阵与原始数据相乘,实现对输入特征空间的规范化(T-Net)操作。PointNet通过两次T-Net变换操作来保证点云数据旋转不变性:第一次T-Net操作是对原始输入点云进行规范化操作;第二次T-Net操作则是对64维点特征进行规范化操作。

点云数据是一组无序的坐标向量集合,对于N个点会有N!种输入组合,该特点即为点云的无序性。点云的无序性会导致无法直接对点云进行训练。PointNet解决点云无序性的策略是最大池化操作,其基本思想就是将集合内所有成员进行比较,选取最大值。无论点云的输入组合如何变化,其集合最大值是唯一的,最大池化操作可保证点云输入的不变性,其表达式为

式中:x表示点云;h表示多层感知机(MLP)特征提取层;g表示最大池化的对称方法;f表示相机的焦距。

PointNet采用多层感知机首先提取每个点的64维特征,然后通过特征增维和最大池化操作提取出1024维全局特征(块特征),最大池化操作是对一个块内所有点的1024维特征进行每一个维度的最大特征值提取,从而构成一个1024维的全局特征(块特征)。最后将点特征以及全局特征联合,形成既有点特征又有全局特征的组合,以此为基础完成三维点云的精确分类。

基于PointNet的点云分类流程如

图 1. 基于PointNet的三维点云分类流程

Fig. 1. Classification flow of 3D point clouds based on PointNet

3 融合光谱信息的机载LiDAR点云三维深度学习分类

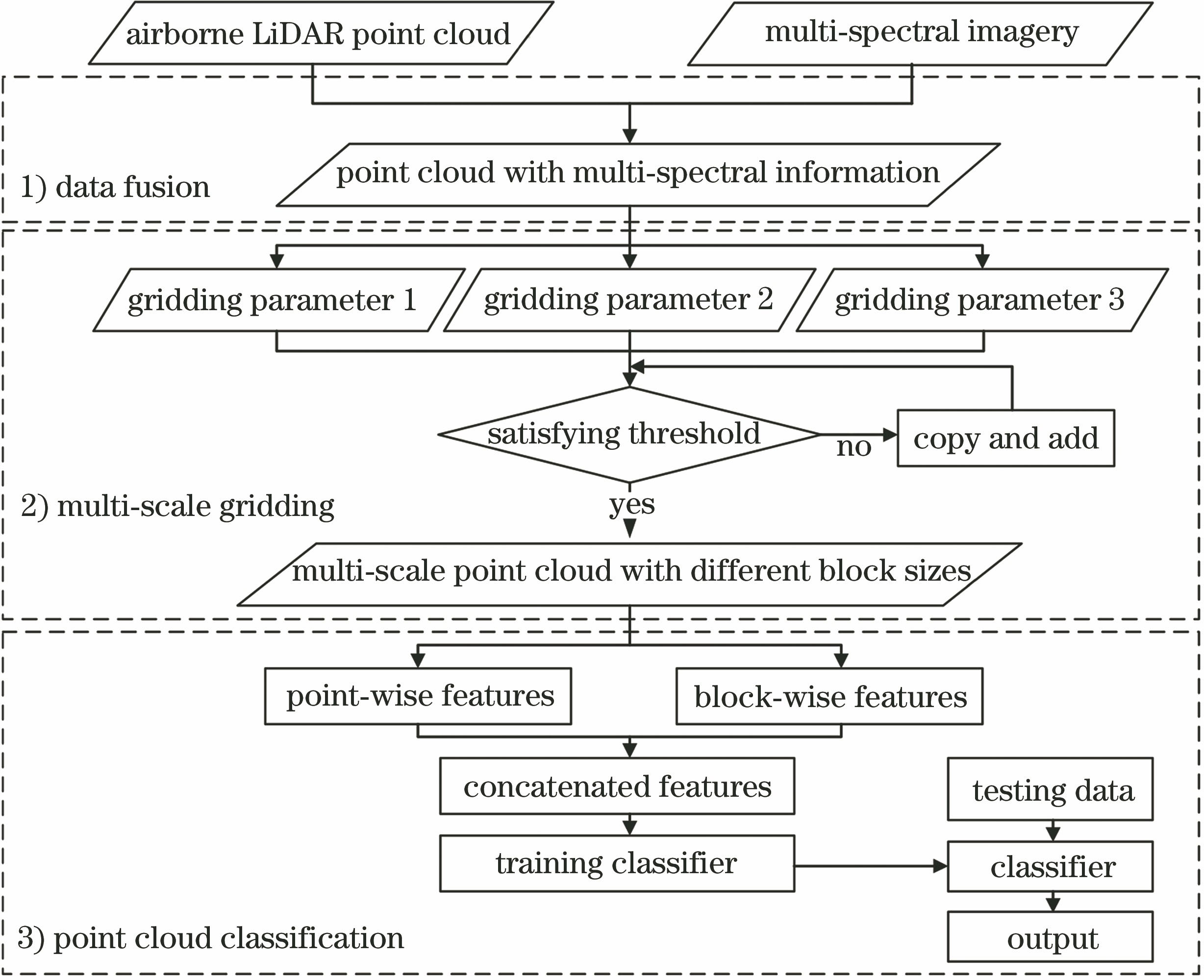

为了提高机载LiDAR点云的分类精度,将多光谱影像与机载LiDAR点云数据进行融合,并采用三维深度学习算法进行点云分类:1)将机载LiDAR点云与航空多光谱影像数据融合;2)对融合数据进行多尺度分块处理;3)点云分类。融合多光谱信息的机载LiDAR点云分类流程如

图 2. 融合多光谱信息的机载LiDAR点云分类流程

Fig. 2. Flow chart of classification for airborne LiDAR point clouds fusing multi-spectral imagery

3.1 机载LiDAR点云光谱信息融合

将机载LiDAR点云与多光谱航空影像融合,生成具有光谱信息的点云数据,以实现点云数据的光谱信息补充。在已知航摄像片内外方位元素的情况下,将LiDAR点云的三维坐标代入共线条件方程[13],可计算得到对应三维点在影像上的像素位置,进而通过重采样获取近红外(NIR)、红色(R)以及绿色(G)通道的灰度值。共线条件方程可表示为

式中:(X,Y,Z)为地面点的三维坐标;(Xs,Ys,Zs)是外方位元素的三个线元素;(a1,b1,c1,a2,b2,c2,a3,b3,c3)是由外方位元素中三个角元素计算得到的旋转矩阵参数。

计算出每个激光脚点对应的光谱信息(NIR、R、G三通道灰度值)后,将点云三维坐标、光谱信息以及点云强度信息组合得到增强的点云数据,作为后续点云分类的输入数据。

3.2 融合点云数据多尺度分块

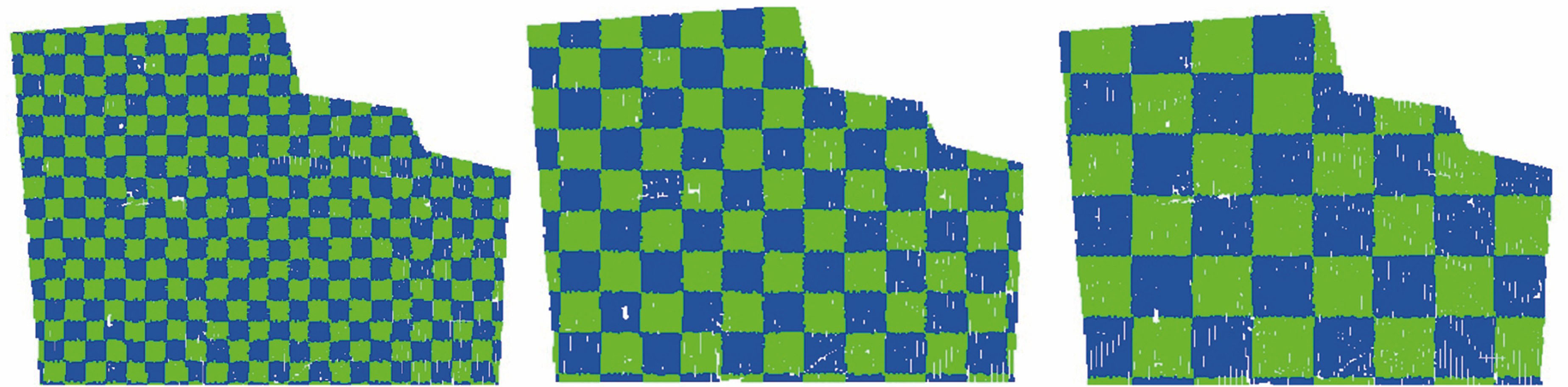

采用三维深度学习算法进行机载LiDAR点云分类时,需要对点云数据进行分块处理并保证每个块内的点数量保持一致。为减小地物尺寸对分类结果的影响,使提取的全局特征具有多尺度特性,当数据被分割成不同尺寸的块时,训练样本的数量明显增加,通过增强训练数据,可以进一步提高对噪声和方向的鲁棒性[14]。故本研究采用不同尺寸的格网进行机载LiDAR点云数据的分块处理(

3.3 基于PointNet的机载LiDAR点云分类

基于PointNet进行点云分类,其采用多层感知机自动提取点特征,在此过程中,需要定义相应的激活函数。本研究采用ReLU函数作为网络的激活函数[15],其可在一定程度上避免反向传播过程中的梯度爆炸和梯度消失问题。ReLU函数的具体形式为

提取出每个点的64维特征之后,采用多层感知机和最大池化操作可获取每个点的1024维全局特征,将上述计算得到的点特征和全局特征串联可得到1088维联合特征。以此特征向量作为输入,通过训练分类器可得到相应的网络参数,最终将测试数据输入训练好的分类器来实现机载LiDAR点云的分类。

网络训练过程中,由于机载LiDAR点云的稀疏性和不均匀性,使用相同的学习率,网络将不能适应所有的参数更新,从而影响分类结果。因此,本研究采用Adam优化方法[16]进行网络参数的更新,该方法可以基于训练数据迭代更新神经网络权重,从而解决参数更新过程中存在的问题。

4 实验与分析

4.1 数据集描述

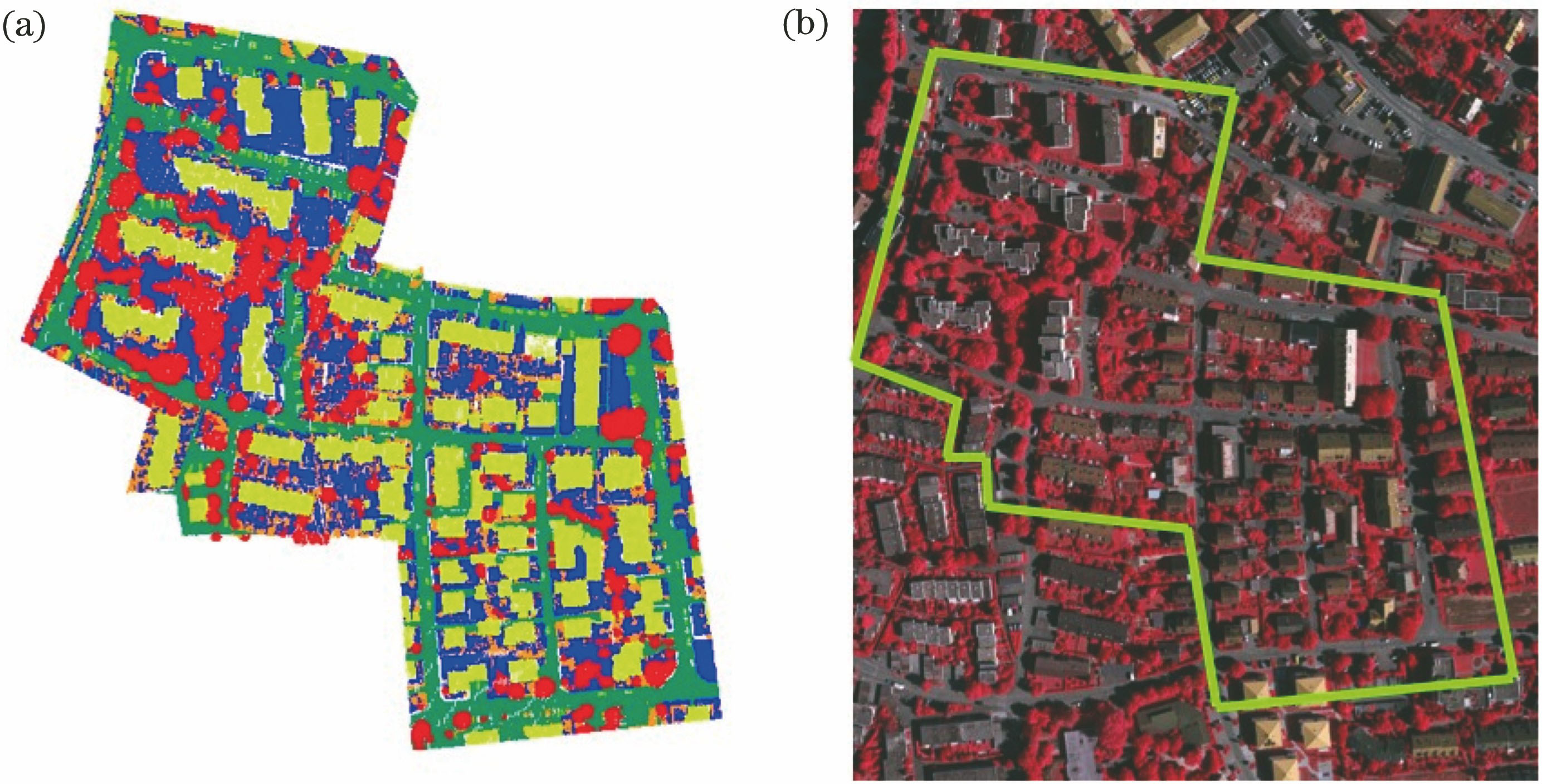

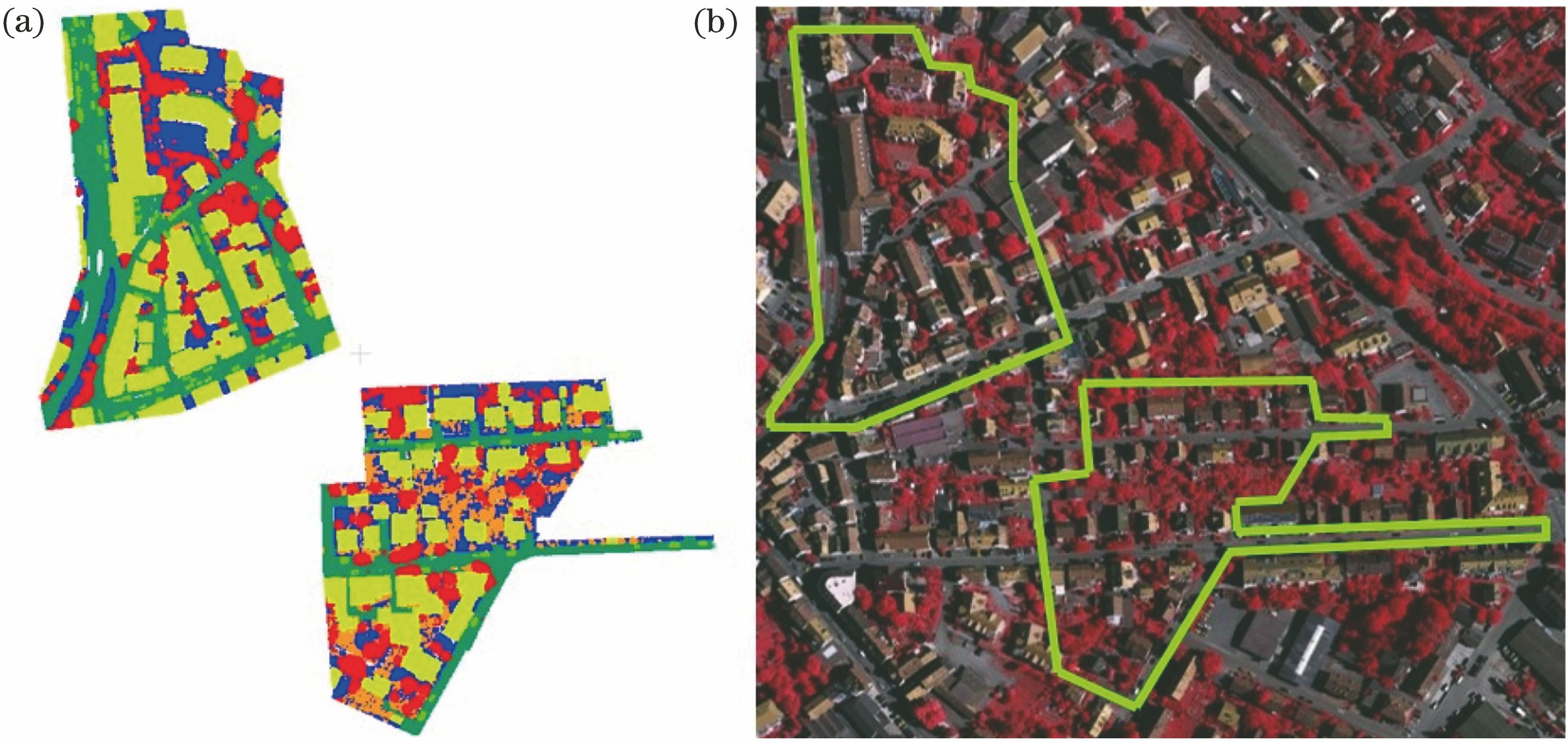

采用国际摄影测量与遥感协会(ISPRS)提供的德国Vaihingen地区测试数据集[17]进行所提方法的验证。实验数据集包括机载LiDAR点云数据及其相应的多光谱航空影像。其中,机载LiDAR点云数据由徕卡ALS50系统获取,点密度约为4 m-2,每个激光脚点包含三维坐标、反射强度和回波次数等信息;多光谱航空影像的地面分辨率为8 cm,每张影像的尺寸为7680 pixel×13824 pixel,并且提供了影像的内、外方位元素。为了对分类精度进行评定,本研究同时提供了上述数据集的参考数据,并给出了每个激光脚点对应的地物类别。该数据集包括训练数据集和测试数据集,如

4.2 实验结果及分析

采用PointNet进行点云分类时,需要将点云进行多尺度格网化处理。为确定格网化的最佳尺度,根据实验区的地物尺寸,选取不同的尺度进行格网划分,并针对单个尺度以及多尺度分块的分类总体精度(OA)以及Kappa系数进行对比,结果如

图 4. 训练数据集及其对应区域的多光谱影像。(a)训练数据集;(b)多光谱影像

Fig. 4. Training set and the corresponding multi-spectral imagery. (a) Training set; (b) multi-spectral imagery

图 5. 测试数据集及其对应区域的多光谱影像。(a)测试数据集;(b)多光谱影像

Fig. 5. Test set and the corresponding multi-spectral imagery. (a) Test set; (b) multi-spectral imagery

表 1. 不同尺度下点云分类精度对比

Table 1. Comparison of classification accuracy under different scales

|

从

为验证所提方法的可行性和有效性,采用如下两种方案对分类结果进行分析和评价:1)对融合光谱数据前后的机载LiDAR点云分类结果进行评价;2)将所提分类方法与其他方法的分类结果进行对比。

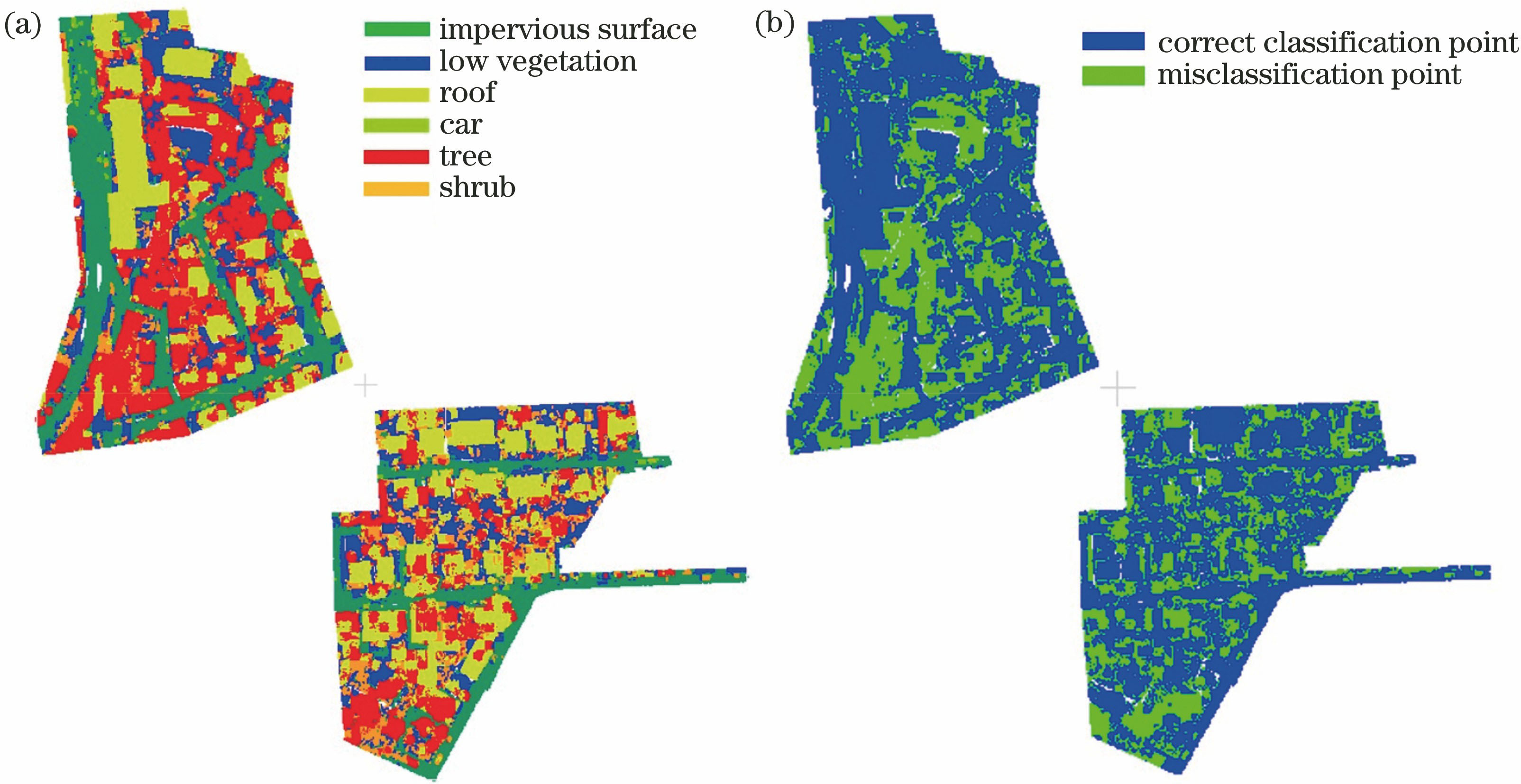

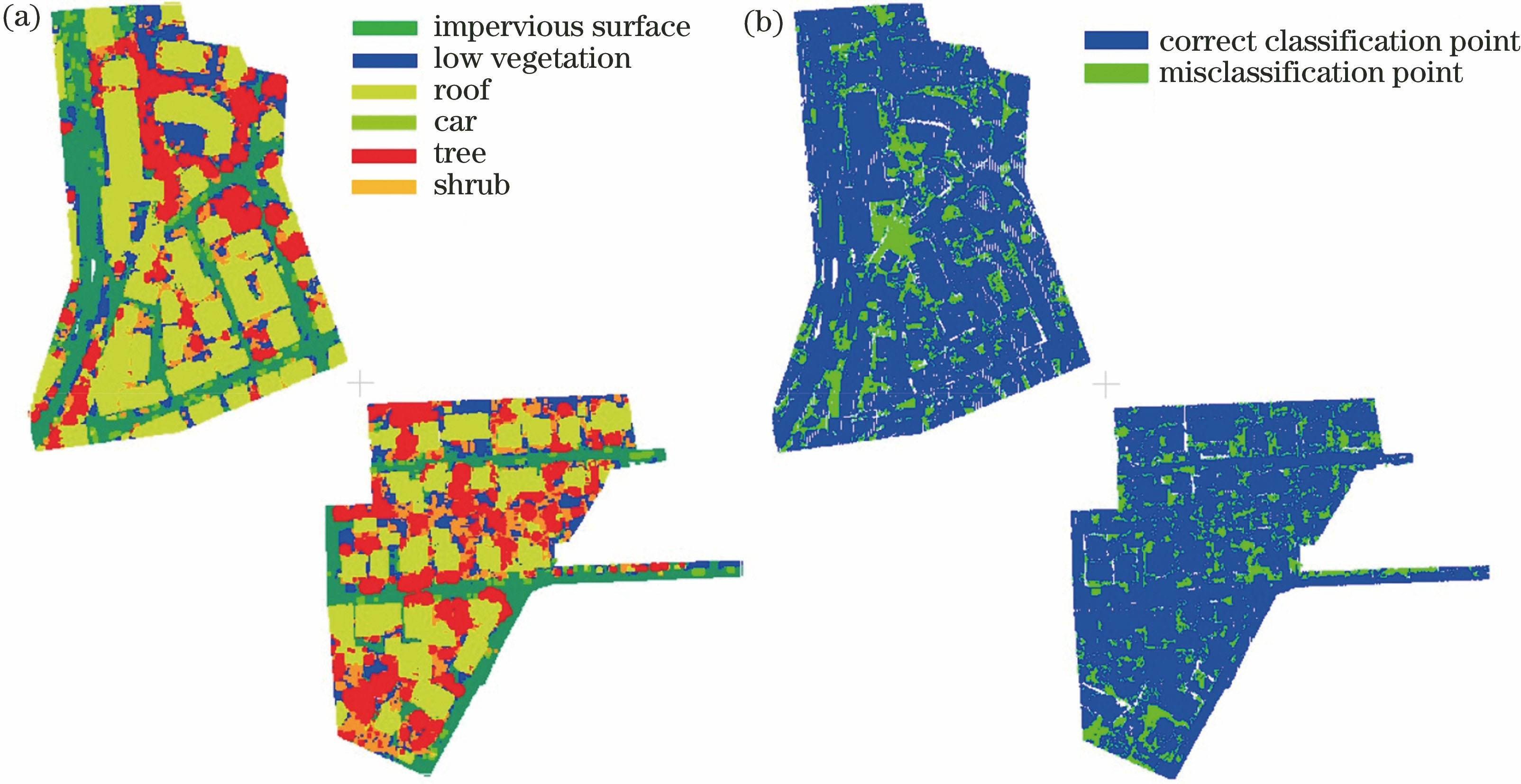

1)融合光谱数据前后的机载LiDAR点云分类结果

融合光谱信息前、后的点云分类结果分别如

图 6. 未融合光谱信息的点云分类结果。(a)不同地物的分类结果;(b)错误分类结果

Fig. 6. Classification results of original LiDAR point clouds. (a) Classification results of different objects; (b) misclassification results

图 7. 融合多光谱信息的点云分类结果。(a)不同地物的分类结果;(b)错误分类结果

Fig. 7. Classification results of multi-spectral point clouds. (a) Classification results of different objects; (b) misclassification results

为了对分类结果进行更加客观的评价,采用总体精度、Kappa系数以及综合评价指标F1分数对分类结果进行定量分析。F1分数计算公式为

式中:F1为综合考虑查准率和查全率的一种评价指标;Pprecision为查准率;Rrecall为查全率。融合光谱信息前、后的点云分类结果如

表 2. 融合多光谱信息前、后的点云分类结果

Table 2. Point cloud classification results of unfused and fused spectral information

| |||||||||||||||||||||||||||||||||||

从定量化的评价结果来看,融合光谱信息后,所有地物的点云分类精度都有较大提升。其中,总体精度提高了13.39个百分点,Kappa系数提高0.1689,且每类地物的综合评价指标F1分数均有不同程度的提高,屋顶、树木和车辆的F1分数提升效果尤为明显,分别提高了25.02个百分点、27.61个百分点和18.15个百分点。由此可见,融合光谱特征后,点云的属性信息可以得到有效增强,从而实现了对各种地物目标更加准确的分类。

2)与其他研究方法的结果对比

为了对不同的研究方法进行对比,ISPRS网站提供了不同方法的实验结果。本研究将所提方法的精度测量结果与部分提交结果(http://www2.isprs.org/commissions/comm2/wg4/vaihingen-3d-semantic-labeling.html,2019年9月24日)进行了对比,结果如

表 3. 不同分类方法的精度对比

Table 3. Accuracy comparison of different classification methods

| |||||||||||||||||||||||||||||||||||||||||

从

5 结论

提出一种融合光谱信息的机载LiDAR点云三维深度学习分类方法。该方法首先将机载LiDAR点云与多光谱影像进行融合,以扩充输入端的点云属性信息,进而采用点云网格化操作和数据增强处理来解决点云的稀疏性和不均匀性问题,最后采用多层感知机提取出点特征和全局特征,并基于PointNet实现了机载LiDAR点云的准确分类。实验结果表明,所提出的点云分类方法可以在不进行人工提取特征的前提下,保证分类精度,同时提高了运算效率。此外,将三维点云与光谱信息融合,可有效解决点云属性数据不足而导致的无法准确分类问题,特别是对树木和建筑物的分类精度提升较为显著。然而在实验中发现,当描述电力线、栅栏以及建筑物立面等点数较少的地物特征时,分块处理方法具有一定的局限性,分类精度不高,但本研究未进行上述三类地物的分类,接下来将考虑加入点云局部特征描述,以实现点云的精细化分类。

[1] 李德仁, 邵振峰, 杨小敏. 从数字城市到智慧城市的理论与实践[J]. 地理空间信息, 2011, 9(6): 1-5.

Li D R, Shao Z F, Yang X M. Theory and practice from digital city to smart city[J]. Geospatial Information, 2011, 9(6): 1-5.

[2] Zhang J X, Lin X G, Ning X G. SVM-based classification of segmented airborne LiDAR point clouds in urban areas[J]. Remote Sensing, 2013, 5(8): 3749-3775.

[3] 何曼芸, 程英蕾, 廖湘江, 等. 融合光谱特征和几何特征的建筑物提取算法[J]. 激光与光电子学进展, 2018, 55(4): 042803.

[4] NiemeyerJ, RottensteinerF, Soergel U. Conditional random fields for lidar point cloud classification in complex urban areas[J]. ISPRS Annals of Photogrammetry, RemoteSensing and Spatial InformationSciences, 2012, I-3: 263- 268.

[5] 魏书法. 基于三维点云与二维图像的场景理解[D]. 北京: 中国科学院大学, 2016.

Wei SF. Scene understanding based on point clouds and 2D images[D]. Beijing: University of Chinese Academy of Sciences, 2016.

[6] YiL, SuH, Guo XW, et al. SyncSpecCNN: synchronized spectral CNN for 3D shape segmentation[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI. New York: IEEE, 2017: 17355428.

[7] BaiS, BaiX, Zhou ZC, et al. GIFT: a real-time and scalable 3D shape search engine[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 5023- 5032.

[8] MaturanaD, SchererS. VoxNet: a 3D convolutional neural network for real-time object recognition[C]∥2015 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), September 28-October 2, 2015, Hamburg, Germany. New York: IEEE, 2015: 922- 928.

[9] Wang L, Huang Y C, Shan J, et al. MSNet: multi-scale convolutional network for point cloud classification[J]. Remote Sensing, 2018, 10(4): 612.

[10] Charles RQ, HaoS, Mo KC, et al. PointNet: deep learning on point sets for 3D classification and segmentation[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI. New York:IEEE, 2017: 17355473.

[11] 张佳颖, 赵晓丽, 陈正. 基于深度学习的点云语义分割综述[J]. 激光与光电子学进展, 2020, 57(4): 040001.

[12] 赵中阳, 程英蕾, 释小松, 等. 基于多尺度特征和PointNet的LiDAR点云地物分类方法[J]. 激光与光电子学进展, 2019, 56(5): 052804.

[13] 张剑清, 潘励, 王树根. 数字摄影测量[M]. 2版. 武汉: 武汉大学出版社, 2009: 26- 30.

Zhang JQ, PanL, Wang SG. Digital photogrammetry [M]. 2nd ed. Wuhan: Wuhan University Press, 2009: 26- 30.

[14] Yousefhussien M, Kelbe D J, Ientilucci E J, et al. A multi-scale fully convolutional network for semantic labeling of 3D point clouds[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2018, 143: 191-204.

[15] Shang WL, SohnK, AlmeidaD, et al. Understanding and improving convolutional neural networks via concatenated rectified linear units[EB/OL]. [2019-09-01].https: ∥arxiv.org/abs/1603. 05201.

[16] Kingma DP, BaJ. Adam: a method for stochastic optimization[EB/OL]. [2019-09-10].https: ∥arxiv.org/abs/1412. 6980.

[17] Niemeyer J, Rottensteiner F, Soergel U. Contextual classification of lidar data and building object detection in urban areas[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2014, 87: 152-165.

[18] Ramiya A M, Nidamanuri R R, Ramakrishnan K. A supervoxel-based spectro-spatial approach for 3D urban point cloud labelling[J]. International Journal of Remote Sensing, 2016, 37(17): 4172-4200.

[19] Zhao R B, Pang M Y, Wang J D. Classifying airborne LiDAR point clouds via deep features learned by a multi-scale convolutional neural network[J]. International Journal of Geographical Information Science, 2018, 32(5): 960-979.

Article Outline

王宏涛, 雷相达, 赵宗泽. 融合光谱信息的机载LiDAR点云三维深度学习分类方法[J]. 激光与光电子学进展, 2020, 57(12): 122802. Hongtao Wang, Xiangda Lei, Zongze Zhao. 3D Deep Learning Classification Method for Airborne LiDAR Point Clouds Fusing Spectral Information[J]. Laser & Optoelectronics Progress, 2020, 57(12): 122802.