基于背景抑制和前景更新的显著性检测  下载: 878次

下载: 878次

1 引言

显著性检测能够从复杂的场景中提取出引起人类更多集中注意力的前景区域、忽略引起人类很少集中注意力的背景区域。该方法广泛应用于目标识别[1-2]、图像检索[3-4]、图像融合[5]、图像匹配[6]等计算机视觉领域中的各项任务。近年来,与深度学习相关的显著性检测方法[7-9]大大地吸引了人们的关注,但该类算法的计算成本高,且对硬件设备要求高。

显著性检测的目的是抑制背景区域、突出前景区域,因而背景先验或前景先验被广泛应用到显著性检测方法中。Wei等[10]提出的GS(Geodesic Saliency)算法,利用边界连通先验更多地关注背景区域,获得的显著图在简单背景下能够准确突出前景区域,但不适应于复杂背景。Li等[11]提出的HFT(Hypercomplex Fourier Transform)算法,以频域的角度分析问题,利用非显著性的概念来实现显著性的目标,获得的显著图能够较好地抑制部分背景区域,但其仅能突出前景区域的大体轮廓。Yang等[12]提出的MR算法,利用背景查询节点和前景查询节点的相似性来提取更多有意义的前景区域,获得的显著图能够高亮前景区域,但对于边界处的背景区域抑制效果较差。Zhang等[13]提出的LRR(Low Rank Matrix Regularization)算法,利用多重正则化与矩阵因式分解相结合的方式进行优化处理,获得的显著图能够突出前景区域,且能显示出更多的细节信息,但对背景区域的抑制效果不明显。Li等[14]提出的DSR(Dense and Sparse Reconstruction)算法,利用贝叶斯框架融合稠密重构误差与稀疏重构误差,获得的显著图能够提取出可靠性高的前景区域,但对于背景区域与前景区域对比度相接近的图像处理效果一般。Zhu等[15]提出的RBD(Robust Background Dtection)算法,利用独特的优化框架整合多个低级线索以达到最优的效果,获得的显著图能够突出前景区域更多的信息,但对于亮度较低的图像,在处理背景区域时仍有待改进。Wang等[16]提出的BFS(Background and Foreground Seed)算法,同时集成背景显著性与前景显著性,获得的显著图能够平滑准确地显示前景区域,但其整体分辨率较低,且背景区域处理效果不好。Wang等[17]提出的基于背景驱动的显著性检测方法,利用背景显著性估计前景区域的显著性值,获得的显著图背景抑制效果好,但对于复杂背景的图像,在处理背景区域时仍需完善。金一康等[18]提出的基于背景连续性先验的显著性检测方法,利用最短路径获得的前景权重优化了显著性检测结果,获得的显著图的前景区域分辨率高,但对于背景区域与前景区域不存在相似属性的复杂图像,该方法完全失效。

针对以上提及的显著性检测方法普遍存在背景抑制效果差或前景分辨率低的问题,本文提出一种基于背景抑制和前景更新的显著性检测方法,该方法在贝叶斯框架下,充分发挥抑制背景区域和突出前景区域的优势,获得了可靠性更强、检测效果更好的显著图。

2 本文框架

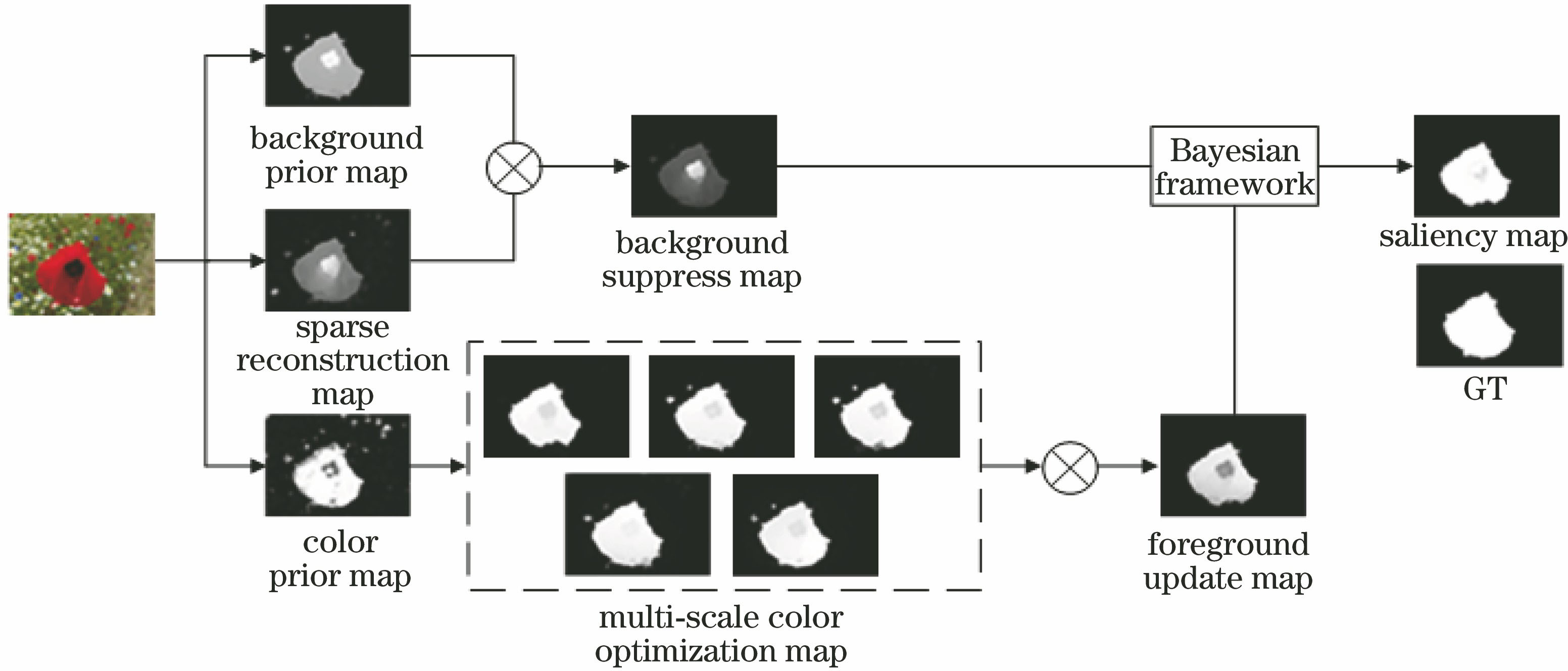

为更好地解决现有显著性检测方法存在背景抑制效果差、前景分辨率低的问题,提出一种基于背景抑制和前景更新的显著性检测方法。该方法能够将图像的基本特征有机结合,本文框图如

1) 利用MR算法得到背景先验图(即background prior map),同时借助超像素分割算法提取原图像的像素点特征,把边缘超像素作为背景模板,计算稀疏重构图(即sparse reconstruction map),接着将背景先验图与稀疏重构图执行点乘运算,从而获得高质量的背景抑制图(即background suppress map);

2) 利用高斯混合模型得到颜色先验图(即color prior map),在多尺度条件下,借助CA(Cellular Automata) 模型计算颜色优化图(即multi-scale color optimization map),将多尺度的颜色优化图执行点乘运算,从而获得高精度的前景更新图(即foreground update map);

3)在贝叶斯框架下,将背景抑制图与前景更新图进行融合优化,从而获得背景抑制效果好、前景分辨率高的显著图(即saliency map),进而与人工标注图(Ground truth,即GT)进行对比评估。

3 基于背景抑制和前景更新的显著性检测方法

3.1 背景抑制

对图像进行显著性检测时,背景区域通常占据图像的更多空间,这些背景区域会影响显著图的检测结果,从而导致准确率下降,因此去除背景区域尤为重要。本文获得背景抑制图的具体实现流程如下。

1)计算背景先验图

利用算法MR[12]获得背景先验图。首先给定一个包含已标记数据和未标记数据的数据集X={x1,x2,…,xn},令y=[y1,y2,…,yn]T作为数据集的标记情况,若xi是已标记数据,则yi=1,否则yi=0。将f∶X→Rn作为排序函数,即为每个xi分配与其对应的排序值fi。在数据集X上,定义一个图G=(V,E),其中V表示节点,E表示由关联矩阵W=[wij]n×n加权获取的边界(wij表示边界权重)。将D=diag{d11,d22,…,dnn}作为图G的度矩阵,即连接到每个节点的权重总和。则已标记数据排序结果的表达式为

式中:λ表示衡量平滑约束和拟合约束函数的平衡参数。利用非标准化的拉普拉斯矩阵计算已标记数据的优化排序结果,从而获得背景先验图。

式中:μ与λ相关,即μ=1/(1+λ),通常μ=0.99。

2)计算稀疏重构图

利用稀疏重构误差获得稀疏重构图[14]。首先借助超像素分割方法将原图像转化为包含颜色信息和位置信息的5维向量,通过对该向量进行局部聚类来获得原图像的像素点特征sF=[sF1,sF2,…,sFM],其中M表示超像素总数,如

式中:δ为影响因子,通常δ=0.01。

图 2. 稀疏重构各阶段结果。(a)原图;(b)像素点特征;(c)背景模板

Fig. 2. Each-stage results of sparse reconstruction. (a) Original image; (b) pixel feature; (c) background template

3)计算背景抑制图

将背景先验图与稀疏重构图执行点乘运算可获得背景抑制效果良好的,且质量更加可靠的背景抑制图,即

式中:β是由(4)式中βi组成的矩阵。

3.2 前景更新

颜色在人脑中是早期被处理过的视觉特征,可引导视觉搜索[19],故利用颜色特征对前景区域进行检测。然而单一尺度下的颜色特征图不能够对前景区域做到精细检测,因此本文在多尺度条件下,通过优化颜色先验图的方式计算前景更新图,具体步骤如下。

1)计算颜色先验图

利用高斯混合模型(该模型中包含若干个高斯分布)计算颜色先验图的表达式为

式中:c表示第c个高斯分布;p(c|Ix)表示每个像素被分配颜色的可能性;C(c)表示第c个高斯分布的总方差;SW(c)表示第c个高斯分布空间分配的权重。

2)计算多尺度颜色优化图

CA模型的应用领域广泛[20-22]。本文利用CA的优化模型,即SCA(Single Cellular Automata)[20],在多尺度条件下,计算颜色优化图。首先利用超像素块表示元胞,则元胞之间的影响因子矩阵可表示为IFM=[

为降低局部环境的影响,更有利地促进所有元胞的同步更新,每个元胞需要根据自身当前时刻的置信度cOi计算置信度矩阵

式中:a和b用来控制cOi的取值范围,通常a=0.6,b=0.2。

在多尺度条件下,根据

式中:t+1表示下一时刻;k表示不同的尺度,取值分别为100、200、300、400和500;t表示当前时刻。

3)计算前景更新图

将各个尺度下的颜色优化图执行点乘运算获得保留更多细节信息的、精度更加准确的前景更新图,即

3.3 贝叶斯融合

贝叶斯框架[23-25]可以充分发挥各方法的优势,能抑制更多背景区域的同时显示更完整的前景区域。本文利用该框架将背景抑制图和前景更新图进行有效融合,从而获得显著特征完整的最终显著图。

式中:p(S|x)表示后验概率;p(S)表示像素x属于前景区域的先验概率;p(

利用背景抑制图Sb的平均显著值分割Sb得到Sb的背景区域Sbb和前景区域Sbq,利用前景更新图Sq的平均显著值分割Sq得到Sq的背景区域Sqb和前景区域Sqq。本文计算的后验概率分为2种情况:第1种情况,根据先验概率p(Sb)和似然概率p(Sq|Sqq)计算后验概率p(Sqq|Sq);第2种情况,根据先验概率p(Sq)和似然概率p(Sb|Sbq)计算后验概率p(Sbq|Sb)。表达式分别为

显著性检测方法中,可以通过直接相乘或直接相加的方式进行融合。本文通过后验概率采用直接相乘和直接相加的方式获得显著图

原图、GT图、

4 实验结果分析

本文方法测试的实验平台是64位的Windows7操作系统,内存是4 GB,处理器是Intel(R) Core(TM)i5-4210U,主频是2.1 GHz,软件版本是Matlab R2017a。在ASD和ECSSD数据集上分别选取200幅具有背景复杂、背景区域与显著区域的对比度或亮度接近、显著目标较小等特征的图片作为实验测试的数据。其中,ASD 数据集共包括1000张图片和与其对应的GT图,该数据集中的图片大多数以单目标作为显著目标。ECSSD数据集共包括1000幅图片和与其对应的GT图,该数据集中的图片大多数以多目标作为显著目标,与自然场景更为接近,这些特点使得实验的开展极具挑战性,同时也提高了本次实验的说服力。为验证本文方法的准确性和可靠性,将本文方法与8种包含开源代码的显著性检测方法GS[10]、HFT[11]、MR[12]、LRR[13]、DSR[14]、RBD[15]、BFS[16]和BSCA[20]进行主观对比与客观对比。

4.1 主观对比

在ASD和ECSSD数据集上,本文方法与8种显著性检测方法进行主观对比的部分实验结果如

图 4. ASD和ECSSD数据集上的主观对比结果

Fig. 4. Subjective comparison results on ASD and ECSSD datasets

4.2 客观对比

在ASD和ECSSD数据集上,本文方法与8种显著性检测方法利用准确率-召回率曲线(Precision-Recall曲线)、受试者操作特征曲线(ROC曲线)、准确率与召回率的综合评价指标(F-measure)和平均绝对误差(MAE)4种评价指标进行客观对比。

为更好地计算上述评价指标,则需计算4个状态值,即:NTP表示目标区域属于显著性区域的数量,NFP表示背景区域属于显著区域的数量,NFN表示目标区域属于非显著性区域的数量,NTN表示背景区域属于非显著性区域的数量。

Precision-Recall曲线是以Precision为纵轴、Recall为横轴,则Precision和Recall的表达式为

在ASD和ECSSD数据集上的Precision-Recall曲线如

ROC曲线是以真正例率(TPR)为纵轴、假正例率(FPR)为横轴,则TPR和FPR的表达式为

图 5. ASD和ECSSD数据集上的Precision-Recall曲线。(a) ASD数据集;(b) ECSSD数据集

Fig. 5. Precision-Recall curves on ASD and ECSSD datasets. (a) ASD dataset; (b) ECSSD dataset

在ASD和ECSSD数据集上的ROC曲线如

Precision与Recall是一组矛盾的评价指标,一般来讲,Precision高时,Recall较低;Precision低时,Recall较高。此时,可以利用F-measure更好地表述Precision与Recall的整体性能,其表达式为

式中:γ表示衡量Precision和Recall影响程度的参数,γ越小,表明Precision的影响程度越大,通常γ2=0.3。在ASD和ECSSD数据集上的F-measure如

图 6. ASD和ECSSD数据集上的ROC曲线。(a) ASD数据集;(b) ECSSD数据集

Fig. 6. ROC curves on ASD and ECSSD datasets. (a) ASD dataset; (b) ECSSD dataset

图 7. ASD和ECSSD数据集上的F-measure。(a) ASD数据集;(b) ECSSD数据集

Fig. 7. F-measure on ASD and ECSSD datasets. (a) ASD dataset; (b) ECSSD dataset

MAE能够充分考虑图像中的背景显著性,从而更好地评估显著性检测结果的好坏,其表达式为

式中:w表示图像的宽度,h表示图像的高度;S(x,y)表示点(x,y)处显著图的值;TGT(x,y)表示点(x,y)处GT图的值。在ASD和ECSSD数据集上的MAE见

表 1. ASD和ECSSD数据集上的MAE

Table 1. MAE on ASD and ECSSD datasets

|

5 结论

提出基于背景抑制和前景更新的显著性检测方法。针对现有显著性检测方法存在背景抑制效果较差、前景分辨率低的问题,利用稀疏重构图修正背景先验图的方式获得可靠的背景抑制图;在多尺度条件下,借助CA模型优化颜色先验图获得颜色优化图,点乘运算获得精细的前景更新图;贝叶斯算法融合背景抑制图和前景更新图,获得背景抑制效果良好、前景区域分辨率高的显著图。在两个公开的数据集上,将本文方法与8种流行的显著性检测方法进行主观对比和客观对比,实验结果表明,本文方法不仅主观评价结果突出,而且在准确率、综合评价指标、平均绝对误差等评价指标方面也有显著提高,计算出的显著图与人工标注图最为接近,更具稳健性和可靠性。

[1] LuoP, Tian YL, Wang XG, et al. Switchable deep network for pedestrian detection[C]∥2014 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2014, Columbus, OH, USA. New York: IEEE, 2014: 899- 906.

[3] Jian M W, Dong Y, Ma J. Image retrieval using wavelet-based salient regions[J]. The Imaging Science Journal, 2011, 59(4): 219-231.

[4] Cheng M M, Mitra N J, Huang X L, et al. Salientshape: group saliency in image collections[J]. The Visual Computer, 2014, 30(4): 443-453.

[5] 张立保, 章珏. 基于显著性分析的自适应遥感图像融合[J]. 中国激光, 2015, 42(1): 0114001.

[6] 李杰, 刘怡光, 都双丽, 等. 基于层次化及最小二乘的精确图像配准[J]. 控制理论与应用, 2017, 34(6): 811-819.

Li J, Liu Y G, Du S L, et al. Precise image matching via multi-resolution analysis and least square optimization[J]. Control Theory & Applications, 2017, 34(6): 811-819.

[7] Li G B, Yu Y Z. Visual saliency detection based on multiscale deep CNN features[J]. IEEE Transactions on Image Processing, 2016, 25(11): 5012-5024.

[8] 冯小雨, 梅卫, 胡大帅. 基于改进Faster R-CNN的空中目标检测[J]. 光学学报, 2018, 38(6): 0615004.

[9] 纪超, 黄新波, 曹雯, 等. 基于深度学习的图像显著区域检测[J]. 激光与光电子学进展, 2019, 56(9): 091007.

[10] Wei YC, WenF, Zhu WJ, et al. Geodesic saliency using background priors[M] ∥Fitzgibbon A, Lazebnik S, Perona P, et al. Computer vision-ECCV 2012. Lecture notes in computer science. Berlin, Heidelberg: Springer, 2012, 7574: 29- 42.

[12] YangC, Zhang LH, Lu HC, et al. Saliency detection via graph-based manifold ranking[C]∥2013 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2013, Portland, OR, USA. New York: IEEE, 2013: 3166- 3173.

[14] Li XH, Lu HC, Zhang LH, et al. Saliency detection via dense and sparse reconstruction[C]∥2013 IEEE International Conference on Computer Vision, December 1-8, 2013, Sydney, Australia. New York: IEEE, 2013: 2976- 2983.

[15] Zhu WJ, LiangS, Wei YC, et al. Saliency optimization from robust background detection[C]∥2014 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2014, Columbus, OH, USA. New York: IEEE, 2014: 2814- 2821.

[16] Wang J P, Lu H C, Li X H, et al. Saliency detection via background and foreground seed selection[J]. Neurocomputing, 2015, 152: 359-368.

[17] Wang Z L, Xiang D, Hou S H, et al. Background-driven salient object detection[J]. IEEE Transactions on Multimedia, 2017, 19(4): 750-762.

[18] 金一康, 于凤芹. 基于背景连续性先验知识的显著性检测[J]. 激光与光电子学进展, 2019, 56(12): 121006.

[19] Wolfe J M, Horowitz T S. What attributes guide the deployment of visual attention and how do they do it?[J]. Nature Reviews Neuroscience, 2004, 5(6): 495-501.

[20] QinY, Lu HC, Xu YQ, et al. Saliency detection via cellular automata[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 110- 119.

[21] 陆牧, 朱明, 高扬, 等. 基于元胞自动机的动态背景运动目标检测[J]. 光学精密工程, 2017, 25(7): 1934-1940.

[22] Liu M Y, Shi J. A cellular automata traffic flow model combined with a BP neural network based microscopic lane changing decision model[J]. Journal of Intelligent Transportation Systems, 2019, 23(4): 309-318.

[23] Zhou L, Fu K R, Li Y J, et al. Bayesian salient object detection based on saliency driven clustering[J]. Signal Processing: Image Communication, 2014, 29(3): 434-447.

[24] Wang ST, ZhouZ, Qu HB, et al. RGB-D saliency detection under Bayesian framework[C]∥2016 23rd International Conference on Pattern Recognition (ICPR), December 4-8, 2016, Cancun, Mexico. New York: IEEE, 2016: 1881- 1886.

[25] 赵宏伟, 何劲松. 基于贝叶斯框架融合深度信息的显著性检测[J]. 光电工程, 2018, 45(2): 13-20.

Zhao H W, He J S. Saliency detection method fused depth information based on Bayesian framework[J]. Opto-Electronic Engineering, 2018, 45(2): 13-20.

崔丽群, 陈晶晶, 齐博华, 叶晋. 基于背景抑制和前景更新的显著性检测[J]. 激光与光电子学进展, 2020, 57(2): 021002. Cui Liqun, Chen jingjing, Qi Bohua, Ye Jin. Saliency Detection Based on Background Suppressing and Foreground Updating[J]. Laser & Optoelectronics Progress, 2020, 57(2): 021002.