基于机器视觉方法的诊断设备自动瞄准技术

激光驱动惯性约束聚变(ICF)需要在巨型激光装置上使用上百束激光驱动实现,整个动作过程处于极端复杂的物理状态,需要使用不同学科门类的数十台(套)诊断设备从多个方位对ICF瞬态过程进行高时间、空间和能谱分辨的测量,实现对若干关键物理过程的精密表征和物理参数的精密诊断[1-4]。ICF实验较多诊断设备需要工作距离处于厘米到米的不同空间位置,诊断设备从数十个方位对特定靶标进行瞄准,瞄准精度通常需要达到50 μm水平[5]。激光聚变装置靶室直径随着激光装置能量增大而迅速增加,美国NIF装置靶室内径达到10 m,实验需要使用的诊断数量快速增加,诊断设备需要在更长的搭载运动行程下实现相同的瞄准精度,对诊断精密瞄准方法提出了更高的要求,并且需要在实验前的较短时间内实现数十套设备的快速瞄准,对诊断设备的自动化水平也提出了挑战。NIF瞄准精度最高的方法称为对穿法兰远距离辅助瞄准(OPAS)[6-9],该方法通过在诊断设备正对的法兰室外架设一套较大调焦行程的长焦卡塞格林望远镜来辅助针对设备的同轴瞄准,其焦深超过5 m,变焦行程超过1 m,精度最高能达到40 μm,由于其卡塞格林式调焦望远镜是一项非常复杂的工程,尚未实现自动瞄准;2017年,美国NIF装置通过实验发次提升计划发展了一种激光跟踪仪辅助瞄准方法(ATLAS)[8],即通过靶室壁安装的激光跟踪仪对诊断设备上定位球进行坐标系重建并实现对靶点瞄准,诊断瞄准时间从2 h降低至20 min以内,但该方法的瞄准精度仅100 μm。法国兆焦耳装置的双光束瞄准方法[10-11],瞄准精度100 μm,并且实现了自动瞄准。我国激光聚变装置上发展了一种双目视觉瞄准方法,在靶室良好照明条件下,瞄准精度可以达到50 μm,目前只能依赖人眼判读方式进行靶标识别,通过手动操作诊断设备调节姿态进行瞄准[12-15]。但激光靶室内通常处于照明不佳的状态,对瞄准视觉图像的靶标判读造成很大影响,不同方位诊断设备的瞄准视线还与靶标存在夹角,对图像靶标识别精度造成影响。本文发展了一种基于机器视觉的靶标图像识别算法和反馈控制瞄准方法,可实现弱光环境下对图像靶标的自动判读,并标定了靶标图像与靶点坐标的相关系数,提出了基于双目瞄准图像靶标自动识别和反馈控制运动的高精度自动瞄准方法,初步验证了基于机器视觉图像的指向瞄准和径向瞄准精度,对大型激光装置上实现诊断设备的高精度自动瞄准和自动化运行具有一定的基础参考价值。

1 双目视觉瞄准原理

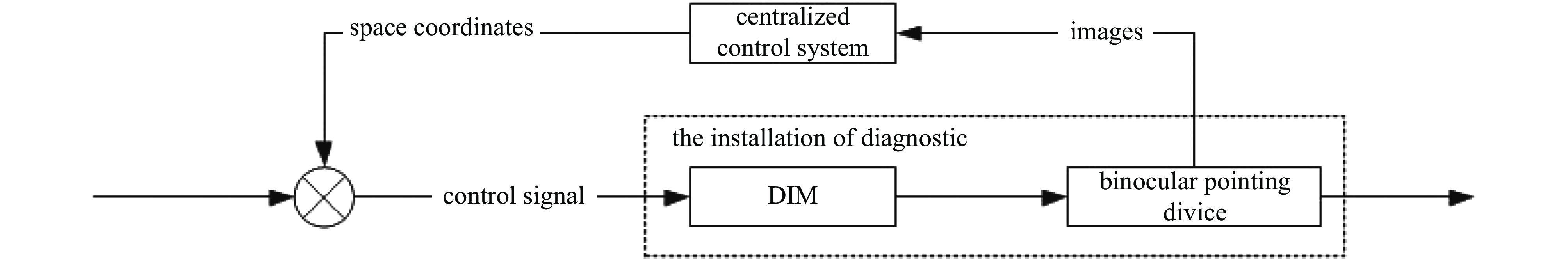

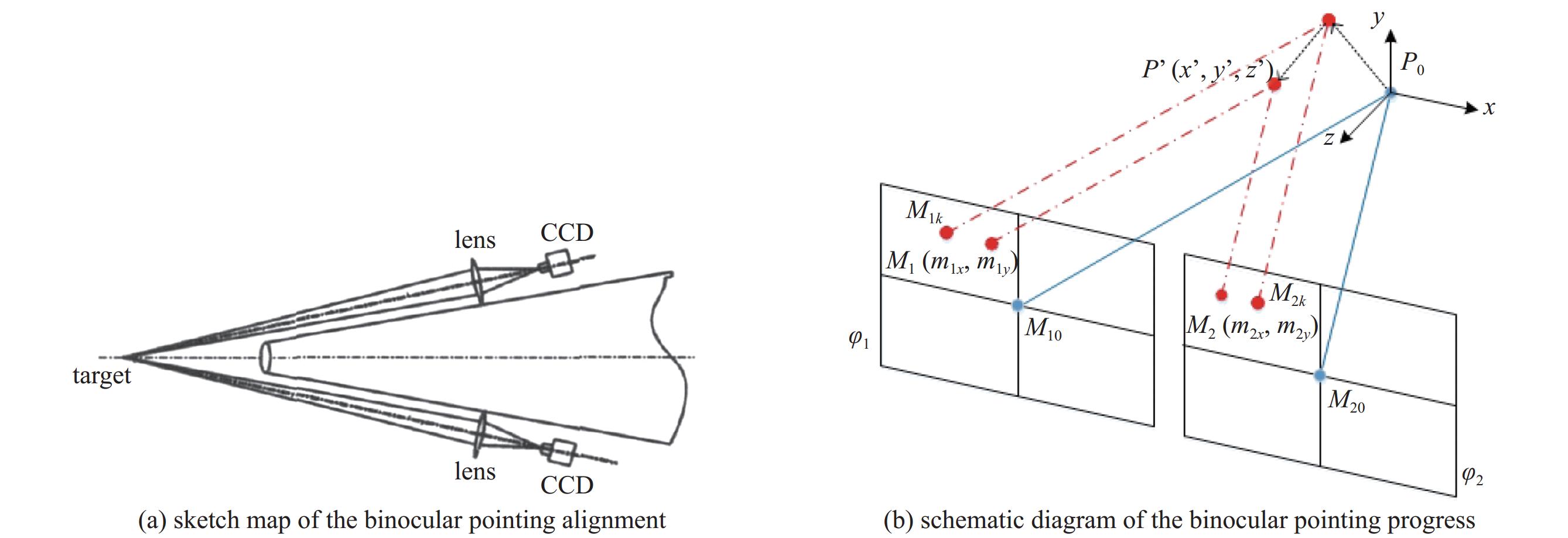

基于双目视觉图像识别的诊断瞄准操作流程如图1所示,当诊断搭载平台将诊断设备运送至靶室内预定工作区域后,通过诊断设备头部的双目瞄准机构对目标靶进行成像,通过识别靶标图像并判断靶标点与诊断设备预先瞄准点的坐标偏差,反馈控制诊断搭载平台进行指向和径向运动,直至靶标点与诊断设备预先瞄准点重合。在瞄准的整个动作过程中,双目瞄准机构的靶标识别精度和反馈控制能力是实现高瞄准精度和自动化流程的关键单元。对于关键单元,本文基于双目瞄准机构采集的图像采用算法实现高精度瞄准点定位,通过像素坐标到空间坐标的映射关系实现空间坐标定位。

双目瞄准机构的结构示意图如图2(a)所示[16],主要包括了诊断设备头部两侧的一组高清视频成像镜头,其成像视场达到1~3 mm,物面分辨率达到1~3 μm。两支成像镜头形成交叉视线,如同人眼视线一样,只有当靶标处于视线交叉点时,利用靶标在左右两个图像面上的成像点视差获得景物的空间坐标信息。双目瞄准方法的原理如图2(b)所示,由两个内部参数一致的成像镜头组成。正式实验之前,诊断设备需要在实验室内预先完成离线瞄准标定,即采用其他辅助措施将一个模拟靶标放置于诊断设备瞄准点P0处,调整双目瞄准镜组姿态使靶标图像位于左右视觉图像的中心(M10和M20),然后锁紧瞄准镜组姿态,实现诊断设备瞄准点空间坐标到视觉图像像素坐标的传递。实验期间带有双目瞄准机构的诊断设备被搭载传送至靶点附近,双目视觉图像将识别到靶标P′偏离瞄准点P0。在线瞄准过程主要分为两步,第一步是识别出左右视觉图像中靶标M1和M2相对于离线瞄准点M10和M20的像素偏差,第二步则是根据离线标定的视觉图像像素偏差与靶点几何坐标偏差的关系曲线,计算得到P′相对于P0的坐标偏移量(包括指向偏差和径向偏差),将该数据反馈至集成控制系统,即可修正诊断设备姿态,实现对靶标的自动瞄准。

图 2. 双目视觉瞄准方法示意图及视觉图形与坐标偏移的坐标系

Fig. 2. Sketch map of the binocular pointing alignment and the coordinate system between the vision graph and the shift in the coordinate

视觉图像的像素偏差与瞄准点的坐标偏移之间的关系,可以描述为靶标点在指向与径向两个维度上与预先瞄准点的坐标偏移量,导致的视觉图像上靶标像素相对瞄准标记点的线性近似偏移量。如图2(b)所示:

2 基于机器视觉的靶标图像自动识别算法

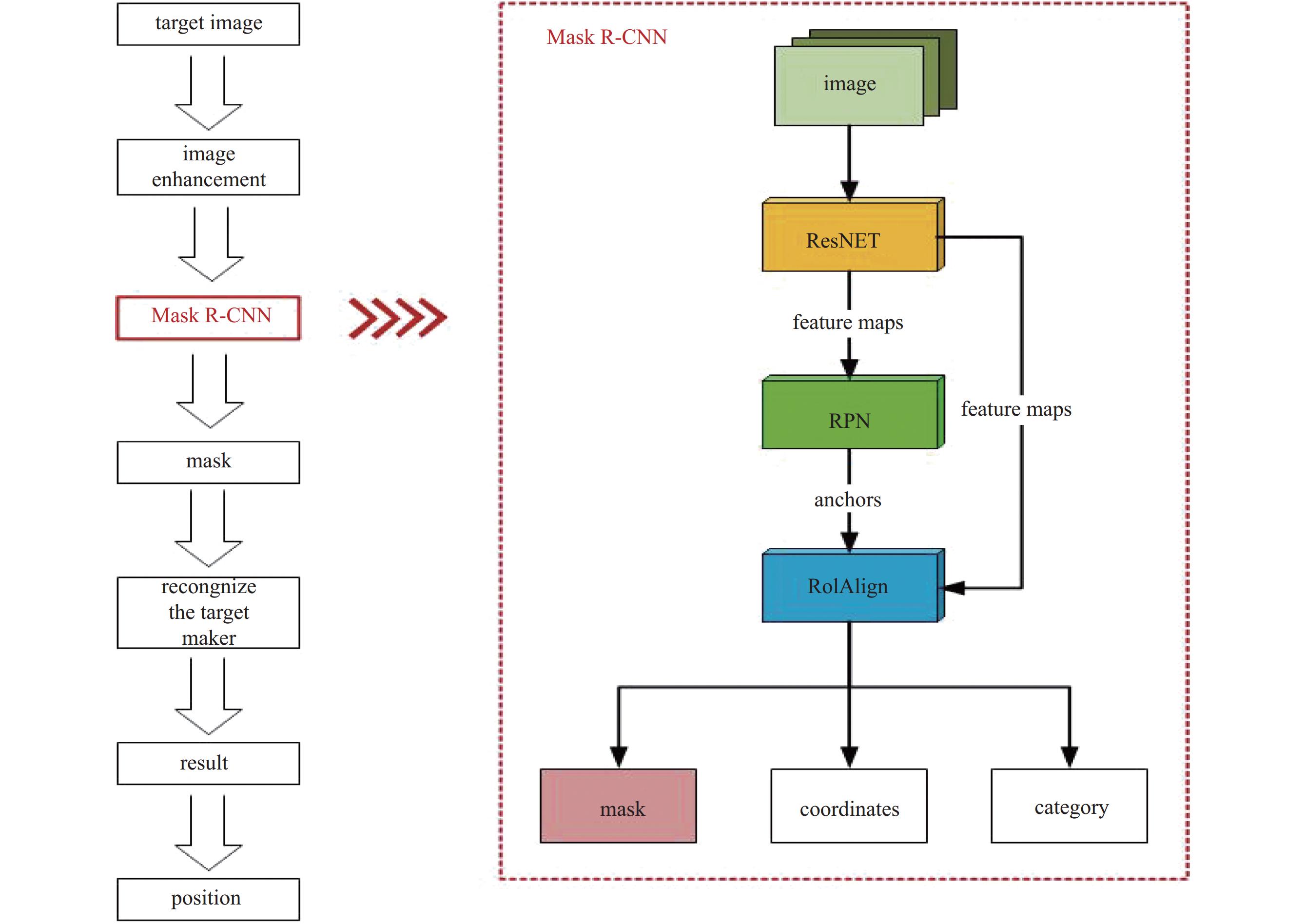

双目视觉瞄准需要对视觉图像中靶标像素坐标进行高精度识别,当面临诊断设备的瞄准视线与靶标点存在倾斜角度或者靶标照明条件不佳等情况时,人眼对靶标识别方法的精度迅速下降,部分情况下还需要依赖专业操作人员的经验指导。采用机器视觉的方法Mask R-CNN算法[17-18],通过预先在实验室完成瞄准图像的靶结构特征点识别的算法训练,可以有效提升靶标图像的识别精度。靶标识别的算法流程如图3所示,首先,通过模拟数据软件获得3D模拟图像,结合图像增噪技术(主要采用高斯噪声、泊松噪声和椒盐噪声)可获得大量的有效的训练样本,然后,采用Mask R-CNN算法实现对图像靶标识别关键区域的分割后计算得出目标靶点的位置。

作为目标靶点识别的关键算法,Mask R-CNN首先是找出区域生成网络(Region Proposal Network),即RPN,然后对RPN找到的每个RoI进行分类、定位、并找到二分类Mask。模型有三种输出[18]:(1)语义分割,对图片的每一个像素进行分类,输出Mask,不需要区分Object Instances;(2)目标分类,正确的分类图片中的目标,并定位各目标的包围框;(3)目标检测,能正确地检测图片中的所有目标,并精确地分类每一个物体。

本文主要应用Mask,对瞄靶区域进行语义分割,作为识别靶点的输入,Mask R-CNN训练损失函数描述为[18]

式中:L({pi}、{ti})为训练RPN的损失函数,Lcls、Lbox和Lmask为输出的三个任务(分类、目标检测以及像素分割)对应的损失函数[19]。

L({pi},{ti})可表示为[17]

式中:

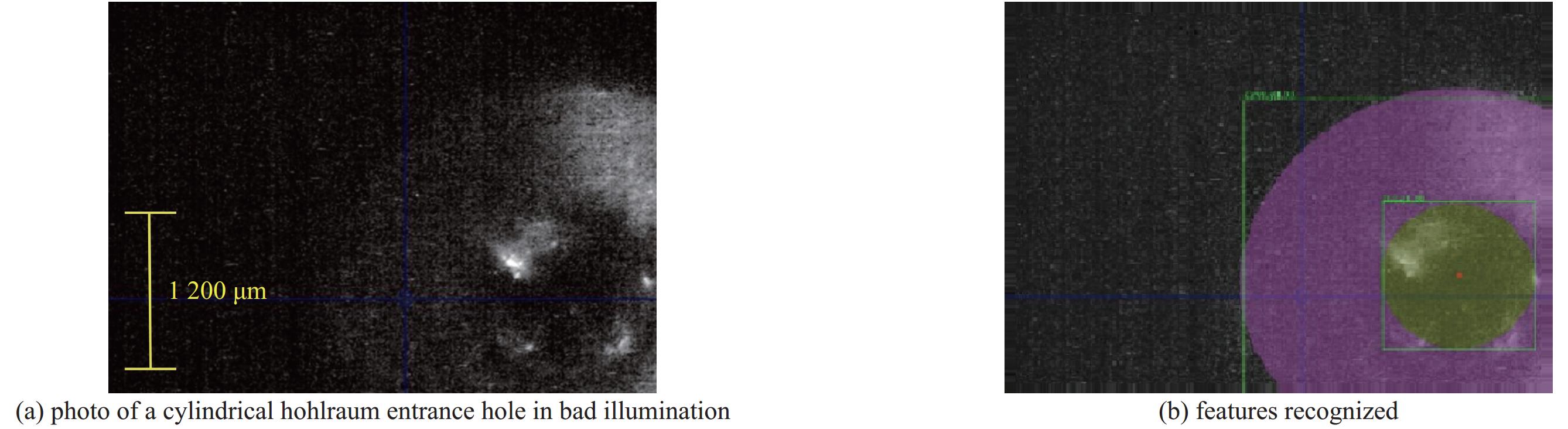

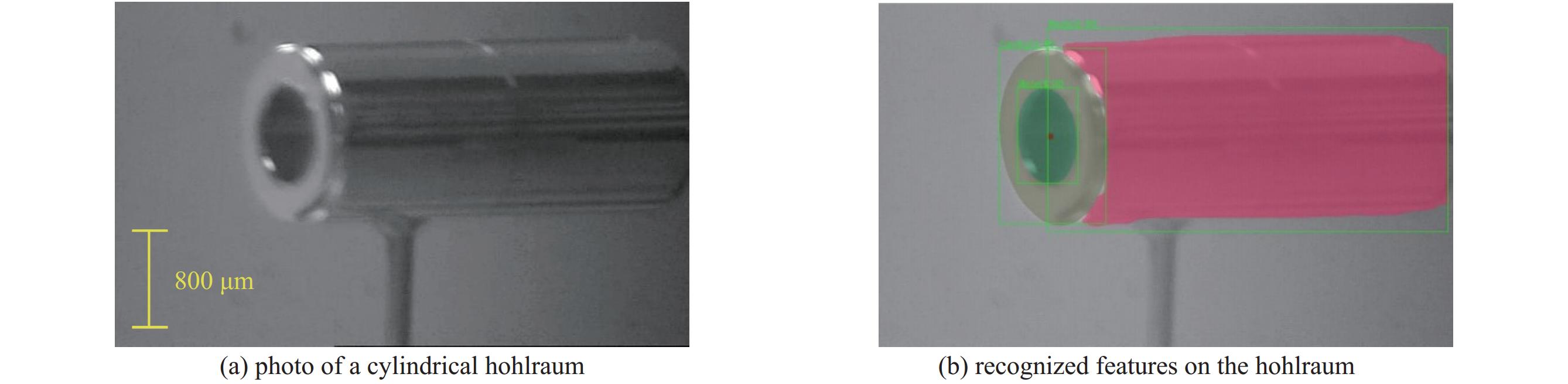

本文采用模拟数据软件获得500张不同视角的模拟靶图照片,再进行图像增噪处理,得到2 000张带标注的训练集,然后对算法进行训练,得到目标靶关键区域识别的二值掩膜,针对实验采用的柱形靶,对腔面和注入孔进行椭圆拟合之后,计算二值掩膜的中点,建立柱腔靶结构的视觉识别数学模型,基于训练得到靶识别算法模型,在靶室装置环境下开展了靶标识别精度的测试。首先,开展了诊断设备瞄准视线与靶标轴线存在夹角情况下的测试,如图4所示,瞄准视线与柱腔靶轴线存在105°夹角,识别程序成功重建出柱腔激光注入孔平面斜视图模型,并计算得到了柱腔注入孔中心的标志点坐标,对多次测试在不同角度场景下的识别结果进行统计,得到识别精度在8个像素点(约20 μm)以内的图像达到92%。紧接着开展了靶室光照不佳条件下的靶标图像识别测试,在靶室内部无环境照明的条件下,仅依靠瞄准节前端微弱照明拍摄的柱腔靶注入孔照片如图5(a)所示,注入孔中心标志点非常模糊,并且靶照片还存在视场拍摄不完整的情况,传统人工判读方式基本无法完成靶标点的准确判读,采用本文发展识别算法,重构获得了黑腔注入孔端面的结构图,并清晰分辨出注入孔轮廓,计算得到了注入孔中心标志点做坐标。

图 4. 瞄准视线夹角为105°条件下的靶标识别图

Fig. 4. Recognition of the center of the laser entrance hole with an angle of 105° between the sightline and the hohlraum

3 靶标视觉图像与瞄准点空间坐标的关联分析

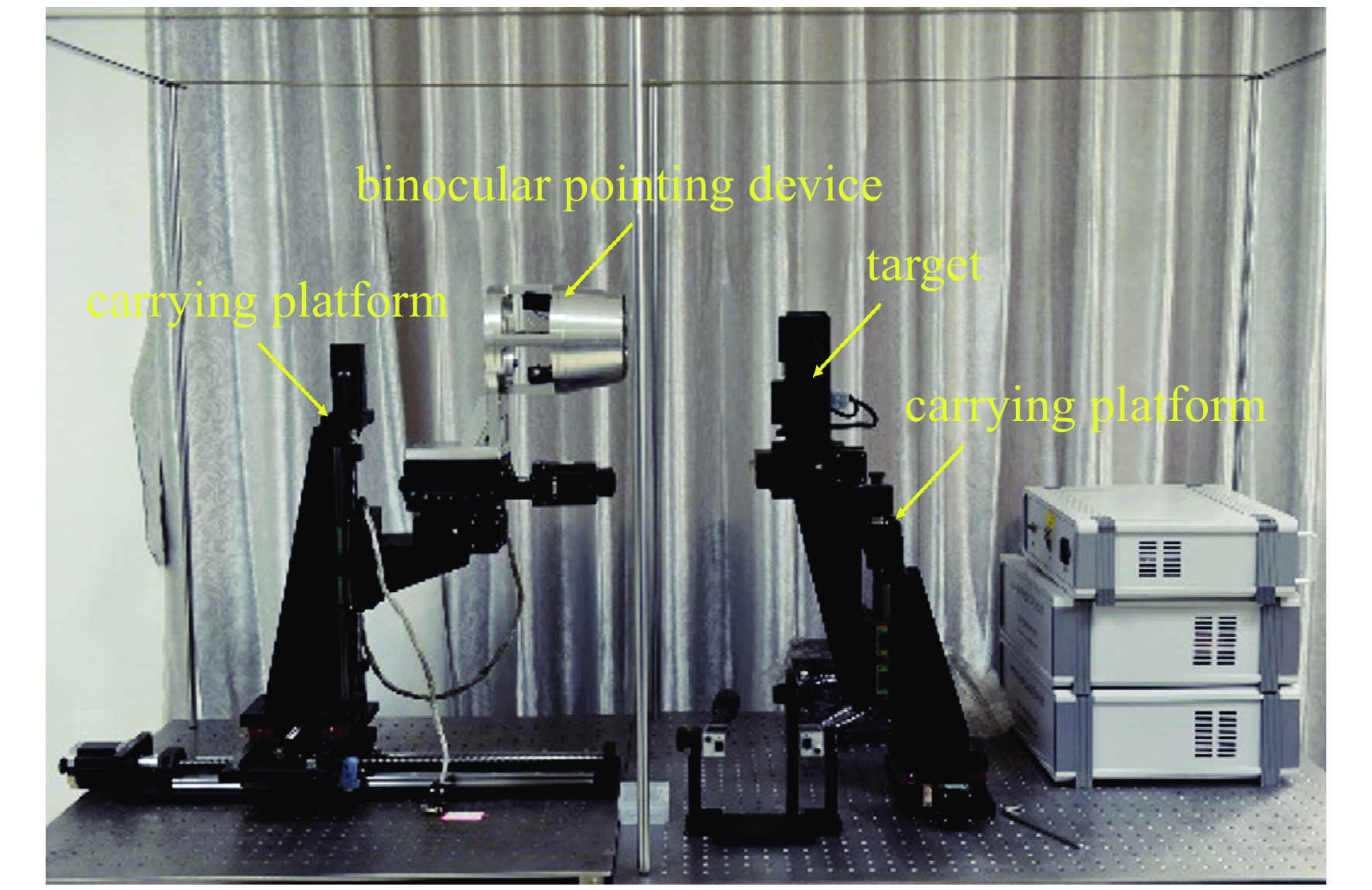

在进行验证前,需要对双目瞄准机构进行离线标定,确保双目瞄准中心轴与径向运动方向平行,同时实现对瞄准点进行标定,建立三维空间坐标系,左右透视平面投影坐标系。根据瞄准机构的左右两支镜头视觉图像,可以分别得到双目视觉图像的靶标点像素偏移值,按照式(1)~(3)可以快速计算出当前诊断设备瞄准点与靶标点的空间坐标偏差情况,进而反馈给集成控制系统引导诊断搭载平台运动。本文在实验室搭建了一套诊断瞄准精度测试平台,如图6所示,测试平台采用与实验场景同种型号的双目瞄准机构,其中传动装置包括:五自由度瞄靶装置,通过三方位平移、俯仰和旋转,模拟靶场不同法兰口诊断设备的瞄准方位;五自由度置靶装置,通过三方位旋转,两方位平移,模拟靶体不同角度姿态。

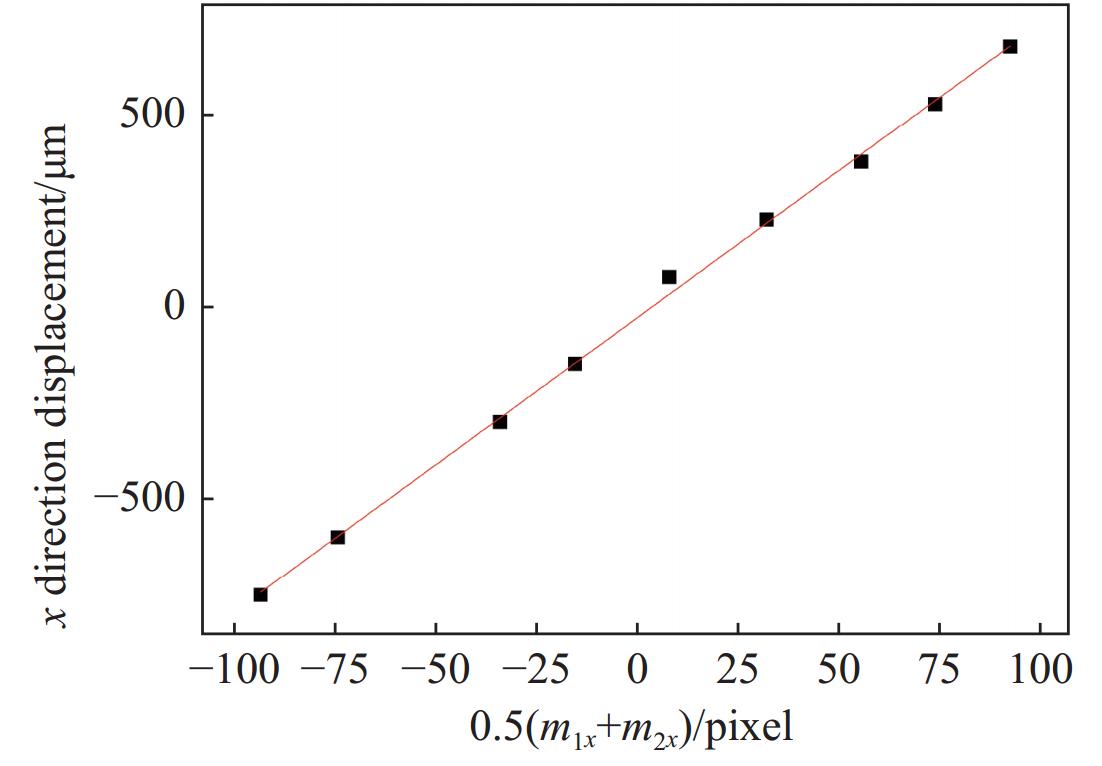

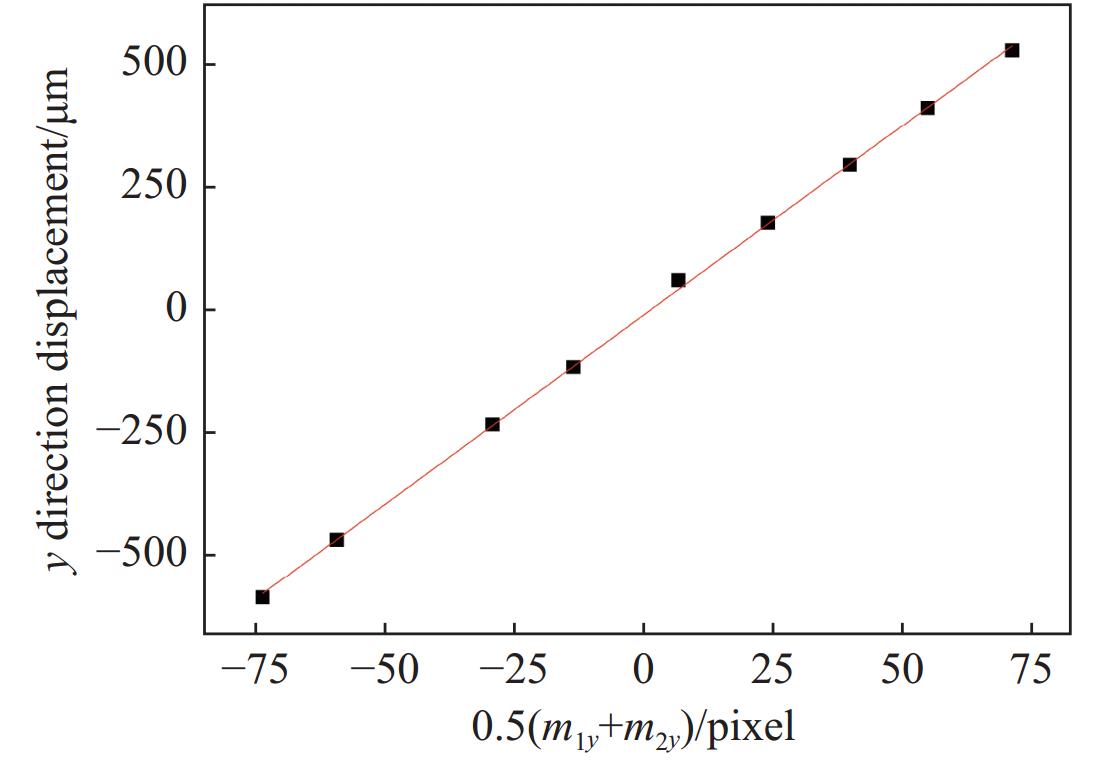

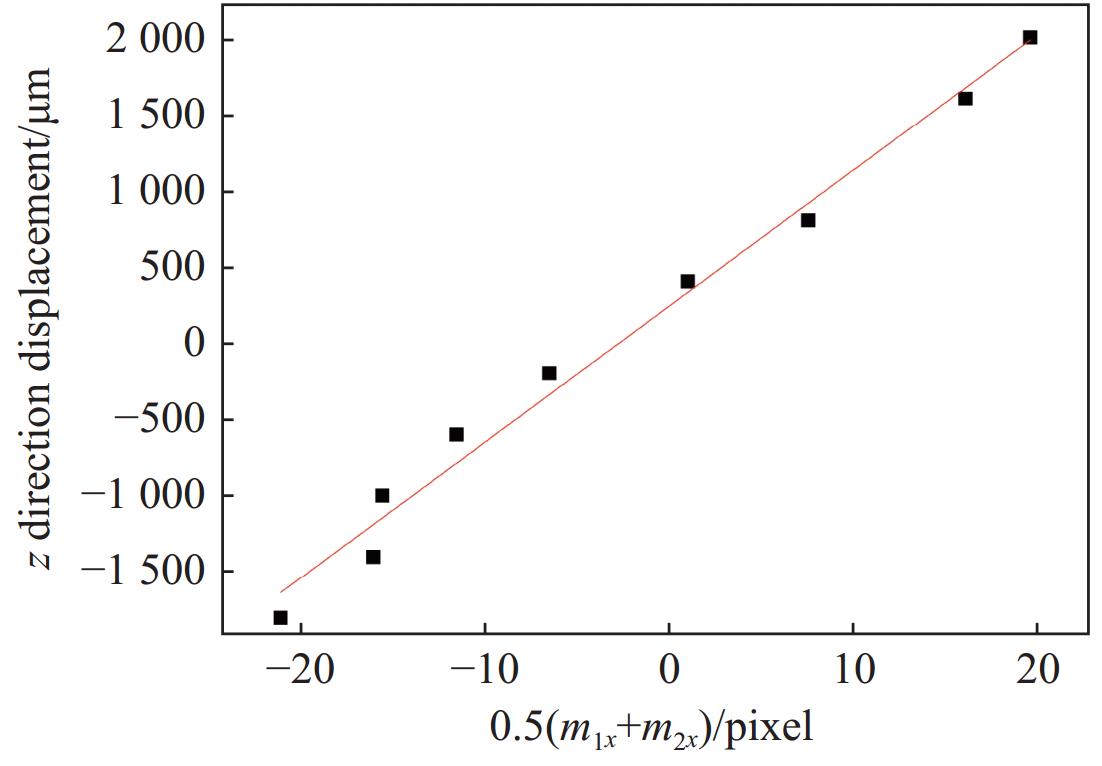

利用瞄准精度测试平台,本文完成了式(1)~(3)中的像素-坐标关联系数标定。针对指向运动维度,分别移动x轴和y轴以一组确定的坐标偏移量,采集双目视觉图像,并计算不同坐标偏移量下的视觉图像中靶标点像素坐标移动量,通过拟合得到

随后,根据拟合得到的式(1)~(3)像素-坐标关联系数,开展了基于机器视觉方法的诊断瞄准精度测试。在指向瞄准精度测试中,控制电动台分别在x方向移动450 μm和y方向移动350 μm,采用机器视觉方法分析得到的算法的瞄准偏移量为437 μm和354 μm,瞄准偏差为23 μm和4 μm。在径向瞄准精度测试中,利用电动台移动z方向位移量600 μm,采用机器视觉方法分析得到的算法的瞄准偏移量为558 μm,瞄准偏差为42 μm。

4 结 论

大型激光装置上诊断设备的双目视觉瞄准方法可以实现较高瞄准精度,目前主要依赖人工视觉方式进行靶标识别和瞄准操作。本文发展了一种基于Mask R-CNN算法并以大量模拟瞄准图作为训练集进行靶标识别训练,实现了双目视觉靶标瞄准图像的识别,误差控制在8个像素点以内,并且在靶室照明不佳或者瞄准视线与靶标存在夹角等特殊情况下,依然能实现视觉图像中靶标的有效识别。本文在实验室条件下对双目瞄准视觉图像像素坐标与瞄准点空间坐标关系进行了精密标定,分别在指向和径向维度开展了基于视觉图像靶标像素偏移的瞄准点坐标偏移量计算和精度分析,测试结果显示指向瞄准精度预估优于30 μm、径向瞄准精度预估优于50 μm,后续将机器视觉图像识别算法及反馈控制瞄准方法部署至集成控制系统,即可实现诊断设备的高精度自动瞄准。

[1] 郑志坚, 丁永坤, 丁耀南, 等. 激光-惯性约束聚变综合诊断系统[J]. 强激光与粒子束, 2003, 15(11):1073-1078

Zheng Zhijian, Ding Yongkun, Ding Yaonan, et al. Recent progress and application of diagnostic technique in laser fusion[J]. High Power Laser and Particle Beams, 2003, 15(11): 1073-1078

[5] 汪威, 史铁林, 来五星, 等. ICF诊断设备搭载平台结构设计与误差分析[J]. 强激光与粒子束, 2010, 22(6):1259-1264

[6] Manuel A M, McCarville T J, Seppala L G, et al. Opposed pt alignment system (OPAS): a commercial astronomical telescope modified f viewing the interi of the NIF target chamber[C]Proceedings of SPIE 8491, Optical System Alignment, Tolerancing, Verification VI. 2012: 84910E.

[7] Ayers S. Target & diagnostic alignment basics[R]. Liverme: Lawrence Liverme National Security, 2016.

[8] Brunton G, Abed Y, Fedov M, et al. Status of the National Ignition Facility (NIF) integrated computer control infmation systems[C]Proceedings of the 16th International Conference on Accelerat Large Experimental Control Systems. 2017: 1418.

[9] Shingleton N, Kalantar D, Wood R, et al. Alignment of an Xray imager line of sight in the National Ignition Facility (NIF) target chamber using a diagnostic instrument manipulat (DIM) opposed pt alignment system (OPAS)[C]Proceedings of SPIE8505, Target Diagnostics Physics Engineering f Inertial Confinement Fusion. 2012: 7281.

[12] 杨正华, 刘慎业, 曹柱荣, 等. 神光Ⅲ主机通用诊断搭载平台的研制[J]. 强激光与粒子束, 2011, 23(1):115-120

[13] 齐文博, 张琦, 何俊华, 等. 激光核聚变诊断设备双光束交汇瞄准技术研究[J]. 应用光学, 2009, 30(6):1032-1035

[14] 李颖洁, 陈铭, 陈黎, 等. 激光聚变实验中诊断设备反馈控制瞄准技术[J]. 控制理论与应用, 2020, 37(10):2147-2154

Li Yingjie, Chen Ming, Chen Li, et al. A feedback control aiming technique of the diagnostic equipments in the inertial confinement fusion experiments[J]. Control Theory & Applications, 2020, 37(10): 2147-2154

[15] 夏立琼, 陈伯伦, 王鹏, 等. 深度神经网络在自动瞄靶技术中的应用研究[J]. 核聚变与等离子体物理, 2022, 42(S1):125-130

Xia Liqiong, Chen Bolun, Wang Peng, et al. Research on the application of deep neural network in automatic targeting technology[J]. Nuclear Fusion and Plasma Physics, 2022, 42(S1): 125-130

[16] 卢卫涛, 闫亚东, 张敏, 等. 公共诊断搭载平台双CCD交汇瞄准系统[J]. 应用光学, 2011, 32(4):630-635

[18] He Kaiming, Gkioxari G, Dollár P, Girshick R. Mask RCNN[C]Proceedings of2017 IEEE International Conference on Computer Vision (ICCV). 2017: 29802988.

[19] Girshick R. Fast RCNN[C]Proceedings of 2015IEEE International Conference on Computer Vision (ICCV). 2015: 14401448.

Article Outline

夏立琼, 陈铭, 王鹏, 陈伯伦, 张兴, 魏惠月, 杨品, 李颖洁. 基于机器视觉方法的诊断设备自动瞄准技术[J]. 强激光与粒子束, 2023, 35(11): 112002. Liqiong Xia, Ming Chen, Peng Wang, Bolun Chen, Xing Zhang, Huiyue Wei, Pin Yang, Yingjie Li. Machine vision aided method for the autonomic diagnostic alignments[J]. High Power Laser and Particle Beams, 2023, 35(11): 112002.