基于双分支多尺度融合网络的毫米波SAR图像多目标语义分割方法

1 引言

随着毫米波技术的发展,毫米波安检方案越来越成熟[1-2],与传统的安检技术相比,如X射线安检、红外线安检、金属探测仪安检等,毫米波安检成像不仅可以检测出织物下隐匿的金属物,还可以检测出塑料枪支、陶瓷刀具、炸药等危险品,最重要的是,毫米波具有非电离性,对人体不会造成伤害[3-5]。毫米波安检能获得清晰的图像信息,可大大降低虚警率,因而毫米波成像设备在人体安检场合得以广泛应用。

近几年,随着人工智能的发展,深度卷积神经网络在图像分类[6-7]、目标检测[8-9]、图像分割[10-15]等领域都获得取得重大突破。因此,许多高效的深度学习算法被应用到毫米波图像的隐藏目标检测中。然而,这些算法一般检测的目标都是RGB图像与高分辨率图像,这与毫米波图像存在着较大的差异。毫米波图像普遍为灰度图像,且分辨率较低,同时由于毫米波探测器性能以及成像算法的影响,毫米波图像的信噪比远低于光学图像,图像对比度低,物体成像不完整。现有的研究已经证明,这些问题严重干扰了隐藏目标的识别与定位,降低了毫米波图像的检测性能[16]。因此,一些针对SAR (millimetre-wave synthetic aperture radar)成像特性的毫米波图像检测的深度学习方法被陆续提出。Liu等人 [17] 将毫米波图像与额外的空间深度图结合,并设计了一个新的损失函数,提高了对违禁品的检测率,但检测类别只有一个。Sun等人[18] 设计了具有两种不同注意力机制的多源聚合Transformer,能有效提升隐藏目标的检测性能。然而,上述研究只能检测出违禁品在人体表面的位置,无法对违禁品的种类进行识别,这导致安检人员需要进行二次检查,确定违禁品种类,以对违规人员进行处置。如果能直接对违禁物品进行识别,将会大大提升安检效率。Pang等人[19] 使用了YOLO v3算法,对被动毫米波图像的人体隐蔽金属**进行实时检测。他们主要针对手枪和人进行识别,两个目标形状差异明显,便于深度学习网络识别,但识别种类较少,识别精度和误报率仍有进一步改进的空间。

上述方法都是基于锚框的目标检测方法。锚框中不仅包含检测目标,还有背景噪声,这会影响目标的识别。同时,由于毫米波图像的可读性差,只用锚框框出检测目标,不利于安检人员的查看。 语义分割方法则可以解决此类问题,它不同于目标检测和识别,语义分割可以实现图像像素级的分类。“语义”指具有人们可用语言探讨的意义,“分割”指图像分割。语义分割能够将整张图的每个部分分割开,使每个部分都有一定类别意义。与目标检测不同的是,目标检测只需要找到图片中目标,打上框然后分出类别。语义分割是将图像中的所有像素点分类,然后以描边的形式,将整张图不留缝隙地分割成各个区域。每个区域是一个类别,没有类别的默认为背景(background),这大大避免了背景噪声的干扰,可以将整个违禁品分割出来进行种类划分,同时上色,即便在可读性差的毫米波图像中,安检人员也可轻易地看出物体的形状,快速获取因违禁品的信息,以便后续的处理。Wang等人[20] 通过扩展卷积来提高感受野,以用来提高检测性能,并且在实验用取得良好的结果。Liang等人[21] 通过选定连接U-net网络结合生成对抗网络,实现在人体中分割出违禁物品。然而,目前SAR图像检测的研究重心主要是目标成像问题和背景干扰问题,但SAR图像检测还存在多目标间的相互干扰、小目标如何检测等问题。因此,要实现SAR图像中隐藏目标的精确识别与定位还存在着一些挑战。针对以上难点,本文主要贡献有:1) 提出双分支特征提取网络(DBPFEN, dual-branch parallel feature extraction network),该网络为双分支并行输出的结构,两个分支之间建立双边连接,进行重复的信息融合,能够大大减小模型复杂度,同时提高模型对成像不完整的目标、相互阻挡的目标和小目标的识别能力;2) 提出一个多尺度融合模块(MSFM, multi-scale fusion module)。该模块能够将多个不同层的高分辨率特征图融入低分辨率特征图中,从而去获得更多的位置细节信息以增加对目标的检测能力。

2 基本原理

2.1 双分支多尺度融合网络(DBMFnet)

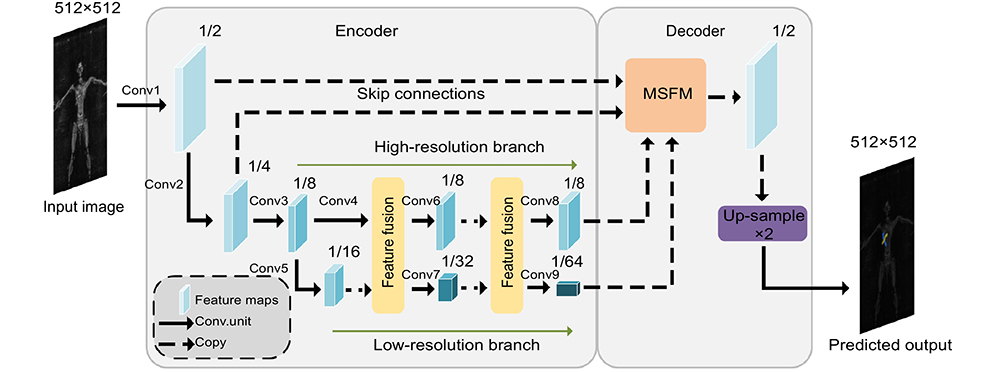

在本文中,我们提出了DBMFnet语义分割模型来识别SAR图像中的违禁品,该网络为Encoder-Decoder结构。在Encoder阶段,我们采用双分支并行特征提取网络(DBFEN),在特征提取的过程中一个分支保持高分辨率不变,另一个分支通过多次下采样操作提取丰富的语义信息,两个分支之间建立双边连接,进行重复的特征融合。在Decoder阶段,为了增加对目标的检测能力,低分辨率分支特征图、高分辨率分支特征图以及通过Skip连接层获得的更高分辨率的特征图同时引入多尺度融合模块(MSFM),实现多个不同分辨率特征图之间的相互融合。之后通过上采样二倍恢复原图大小后输出预测图。其网络结构如

双分支并行特征提取网络具体实现流程如

表 1. 双分支特征提取网络结构

Table 1. Architectures of DBFEN

|

2.2 多尺度融合模块(MSFM)

语义分割的解码器阶段需要将低分辨率的特征图逐步恢复到原始图像的分辨率。常见的操作是在恢复的过程中通过skip connections融合下采样过程中的特征图,U-net和DeeplabV3+使用拼接(FCM)的方式融合特征图,如

图 3. 不同的特征融合方式。(a) FCM; (b) FDM; (c) MSFM;

Fig. 3. Different feature fusion methods. (a) FCM; (b) FDM; (c) MSFM

其中:upsample(.)为双线性插值上采样,cat(.)代表拼接操作,conv(.)代表3×3的卷积层。在获得偏移场后,低分辨率特征图将被扭曲(warp)为高分辨率特征图,偏移场的每个点

其中:

其中:

在MSFM中,引入低分辨率分支、高分辨率分支与通过skip connections获得的输入分辨率1/4的特征图,分别为

3 实验与分析

3.1 数据集

基于实验室的MIMO-SAR架构的主动式毫米波人体安检成像系统,构建了毫米波SAR人体安检图像数据集,命名为HM-SAR,数据集共1100张图片,其中90%的图片用于训练,10%的图片用于测试。该系统为平扫系统,工作频率为35 GHz,天线阵列放置于X轴,系统沿Y轴上下扫描,可同时对人体正面和背面进行扫描,成像效果如

图 4. HM-SAR安检图片。(a) 背面扫描的人体图片;(b) 正面扫描的人体图片

Fig. 4. HM-SAR security images. (a) Back scanning image of the human body; (b) Frontal scanning image of the human body

3.2 评价指标

为了进行定量评估,测试网络性能参数主要为平均像素准确率(MPA)、平均交并比(mIoU)、F1。

上述式中,k表示像素类总数,pii表示原本为i类被预测为i类的像素点数量,pij表示原本为i类被预测为j类的像素点数量,pji表示原本为j类被预测为i类的像素点数量。MPA表示对所有类别的CPA的平均值。mIoU表示对所有类别的IoU的平均值。mIoU的值越高,表示模型的预测值和真实值的重合度更好,说明模型的分割性能越好。

3.3 热力图分析

为了进一步了解DBMFnet模型网络结构中各个步骤特征图变化情况,我们对整个网络进行热力图分析,我们将网络中各个步骤输出的特征图提取出来,并进行可视化展示,展示结果如

3.4 有效性评估

为了评估DBMFnet模型的有效性,选择U-net、Pspnet、FCN-8s、Deeplabv3+和HRnet-v2作为模型性能的对比对象,这些都是语义分割领域的经典模型,且都有很大的影响力。根据

表 2. 各模型在HM-SAR数据集中的分割性能比较

Table 2. Comparisons of the segmentation performance of each model in the HM-SAR dataset

|

表 3. 各模型在HM-SAR数据集中的目标分割性能比较

Table 3. Comparisons of the objects segmentation performance of each model in the HM-SAR dataset

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

我们选取五张图像的分割结果来更直观地说明各个模型的分割效果。

图 6. 各模型测试结果,每一行代表相同图片测试的结果,每一列代表同一模型的测试结果。黑色像素表示背景,红色像素 表示锤头,绿色像素表示扳手,黄色像素表示手枪,蓝色像素表示小刀

Fig. 6. Test results of each model. Each row represents the test results of the same picture, and each column represents the test results of the same model. Black denotes the background, green denotes the wrench, yellow denotes the pistol, red denotes the hammer, and blue denotes the knife

除了测试模型精度外,我们还对模型复杂性和推理速度进行测试,如

表 4. 各个模型的计算复杂度和推理速度

Table 4. Calculation complexity and inference speed of each model

|

3.5 消融实验

在本文中,双分支特征提取网络用于编码器来提高特征提取性能;多尺度融合模块用于解码器来提高分割精确度。为了验证所提出的模块有效性,我们分别对其进行了消融实验,所有实验均在数据集HM-SAR上进行。

我们首先评估双分支特征提取网络的性能,我们使用没有解码器的DBMFnet,即双分支特征提取网络作为比较基线(Baseline),将双分支特征提取网络的高分辨率分支输出与低分辨率分支上采样8倍后的结果直接进行拼接,然后再上采样8倍得到预测结果,如

表 5. 使用不同解码器模块的模型性能对比

Table 5. Comparisons of models using different decoder modules

|

4 总结

针对安检系统SAR图像中违禁品的检测,提出一种语义分割方法DBMFnet,该方法能够精确定位和识别SAR图像中多种小目标的违禁品。该方法包括双分支并行特征提取网络和多尺度融合模块。并行输出结构能够在特征提取过程中不断融合交换高分辨率特征和低分辨率特征的信息,减少下采样过程中的特征损失,有利于小目标和相互重叠目标的识别,同时双分支结构大大减少了模型复杂度,降低了部署的硬件成本。使用HM-SAR数据集测试时,我们所提出的模型与现有的表现最好语义分割模型相比mIoU提升了2.54%。 消融实验表明,所提出多尺度融合模块均可有效提升mIoU值。我们的方法可以拓展到其他遥感场景,比如检测船舶、土地分类、水体检测等。在未来的工作中, 我们期望将实例分割应用到SAR图像的检测中,能利用SAR图像中尽可能多的信息,促进SAR图像目标识别的研究。

Overview: With the advancements of millimeter wave technology, millimeter wave security inspection systems have reached a higher level of maturity. Compared with traditional security inspection technologies such as X-ray, infrared, and metal detectors, millimeter wave security imaging not only enables the detection of the metallic objects hidden under fabrics, but also identifies dangerous items such as plastic firearms, knives, explosives, etc. Significantly, it is crucial to note that millimeter waves are non-ionizing and do not cause harm to the human body. The utilization of millimeter wave security inspection enables the acquisition of precise image information and significantly reduces the occurrence of false alarms, making millimeter wave imaging equipment extensively employed in the security inspection of the human body.

There are several major challenges in the detection and identification of contraband in millimetre-wave synthetic aperture radar (SAR) security imaging: the complexities of small target sizes, partially occluded targets and overlap between multiple targets, which are not conducive to the accurate identification of contraband. To address these problems, a contraband detection method based on Dual Branch Multiscale Fusion Network (DBMFnet) is proposed. The overall architecture of the DBMFnet follows the encoder-decoder framework. In the encoder stage, a dual-branch parallel feature extraction network (DBPFEN) is proposed to enhance the feature extraction. In the feature extraction process of DBMFnet, one branch preserves the high resolution while the other branch extracts the rich semantic information through multiple downsampling operations. Bilateral connections are established between high-resolution and low-resolution branches to facilitate repeated feature exchange, ensuring that the high-resolution branch feature maps integrate into the low-rate branch feature maps across different scales, which facilitates the combination of rich semantic information and fine-grained details to improve the detection of small and interfering targets in images. In the decoder stage, a multi-scale fusion module (MSFM) is proposed to enhance the detection ability of the targets. The module consists of the Feature Alignment Module (FAM), which allows multiple low-resolution feature maps to merge into high-resolution maps. The FAM is inspired by the optical flow for the motion alignment between adjacent video frames, where the feature maps Fh, Flof different resolutions are used as the input and changed to the same number of channels by a 1×1 convolutional layer, respectively. Subsequently, the high-resolution feature map Fh is concatenated with the low-resolution feature map Fl by a bilinear interpolation up-sampling layer.

The experimental results show that when tested using the HM-SAR dataset, our proposed model improves mIoU by 2.54% compared to the existing best performing semantic segmentation models. The ablation experiment shows that the proposed MSFM can effectively improve the mIoU value.

[2] Jing H D, Li S Y, Cui X X, et al. Near-field single-frequency millimeter-wave 3-D imaging via multifocus image fusion[J]. IEEE Antennas Wirel Propag Lett, 2021, 20(3): 298-302.

[3] Nozokido T, Noto M, Murai T. Passive millimeter-wave microscopy[J]. IEEE Microw Wirel Compon Lett, 2009, 19(10): 638-640.

[4] Appleby R, Anderton R N. Millimeter-wave and submillimeter-wave imaging for security and surveillance[J]. Proc IEEE, 2007, 95(8): 1683-1690.

[5] Işiker H, Ünal İ, Tekbaş M, et al. An auto‐classification procedure for concealed weapon detection in millimeter‐wave radiometric imaging systems[J]. Microw Opt Technol Lett, 2018, 60(3): 583-594.

[8] RenS Q, HeK M, GirshickR B, et al. Faster R-CNN: towards real-time object detection with region proposal networks[C]//Proceedings of the 28th International Conference on Neural Information Processing Systems, Montreal, 2015.

[11] XieE Z, WangW H, YuZ D, et al. SegFormer: simple and efficient design for semantic segmentation with transformers[C]//Proceedings of the 35th International Conference on Neural Information Processing Systems, 2021.

[15] Pan H H, Hong Y D, Sun W C, et al. Deep dual-resolution networks for real-time and accurate semantic segmentation of traffic scenes[J]. IEEE Trans Intell Transp Syst, 2023, 24(3): 3448-3460.

[16] López-Tapia S, Molina R, de la Blanca N P. Deep CNNs for object detection using passive millimeter sensors[J]. IEEE Trans Circuits Syst Video Technol, 2019, 29(9): 2580-2589.

[17] Liu C Y, Yang M H, Sun X W. Towards robust human millimeter wave imaging inspection system in real time with deep learning[J]. Prog Electromagn Res, 2018, 161: 87-100.

[18] Sun P, Liu T, Chen X T, et al. Multi-source aggregation transformer for concealed object detection in millimeter-wave images[J]. IEEE Trans Circuits Syst Video Technol, 2022, 32(9): 6148-6159.

[19] 王林华, 袁明辉, 黄慧, 等. 太赫兹安检系统人体图像边缘物体识别[J]. 红外与激光工程, 2017, 46(11): 1125002.

Wang L H, Yuan M H, Huang H, et al. Recognition of edge object of human body in THz security inspection system[J]. Infrared Laser Eng, 2017, 46(11): 1125002.

[20] Wang C J, Yang K H, Sun X W. Precise localization of concealed objects in millimeter-wave images via semantic segmentation[J]. IEEE Access, 2020, 8: 121246-121256.

[21] Liang D, Pan J X, Yu Y, et al. Concealed object segmentation in terahertz imaging via adversarial learning[J]. Optik, 2019, 185: 1104-1114.

Article Outline

丁俊华, 袁明辉. 基于双分支多尺度融合网络的毫米波SAR图像多目标语义分割方法[J]. 光电工程, 2024, 50(12): 230242. Junhua Ding, Minghui Yuan. A multi-target semantic segmentation method for millimetre wave SAR images based on a dual-branch multi-scale fusion network[J]. Opto-Electronic Engineering, 2024, 50(12): 230242.