基于图像信息约束的三维激光点云聚类方法

1 引言

三维激光点云聚类识别是移动机器人感知环境的重要方式之一,主要目的是为了获取目标物在三维空间中的语义、位置、尺寸以及姿态等信息。近年来,许多学者不断加大在环境信息提取、分类方面的研究工作,尤其是多传感器信息融合技术的深入研究,能够有效弥补单个传感器获取信息的不足,且有不少的研究成果[1]。利用传感器数据对周边环境进行感知是实现移动机器人在未知环境下自主作业的首要任务,如何快速有效从含有地面点云的复杂环境中提取目标物体信息具有十分重要的研究意义。

在传感器中,相机有较好的环境细节信息提取能力,适用于目标物分类。激光雷达能够探测目标位置、速度等特征,具有分辨率高、抗干扰能力强、点云信息丰富的特点。目前,处理三维激光点云的方法主要分为深度学习方法和传统聚类方法,随着深度学习在图像领域的不断成熟,逐渐发展了不少基于深度学习模型的方法来处理点云分类问题[2],如Su等提出了基于多视图的MVCNN[3]卷积神经网络方法,利用不同姿态下的虚拟相机捕获2D视图,再通过卷积神经网络进行特征提取,从而实现点云的识别。Maturana等提出的Voxnet[4],实现了非结构化的点云体素化为网格数据并应用于3D卷积神经网络。Qi等提出了直接处理激光点云的PointNet[5]、PointNet++[6]网络算法,有效解决了三维空间中点云无序性、旋转不变性等问题,能较好地对点云进行特征提取。基于深度学习方法虽然泛化能力好、分割精度高,但存在前期标注工作量庞大、硬件计算平台成本高等问题[7]。点云在传统聚类方法[8]中主要有基于密度的DBSCAN聚类算法、基于距离的欧氏聚类算法、基于划分的K-means聚类算法等。DBSCAN算法[7]能快速地对任意形状的三维点云进行聚类,但内存资源消耗大。欧氏聚类算法[9]对数据处理有良好的通用性,但受距离阈值参数影响较大,空间中点云存在近密远疏的特性,易出现过欠聚类的情况。K-means算法[10]快速实用有效,但由于存在k值的不确定性以及聚类中心点的随机性,往往会导致聚类效果不佳。K-means++[11]聚类是对K-means算法的改进,对随机产生的初始聚类中心点添加彼此分散的约束,能提高一定的聚类效果。传统聚类算法虽然处理速度快,但对聚类参数的依赖度高,参数设定优劣直接影响该算法能否正确给出点云的语义等信息。

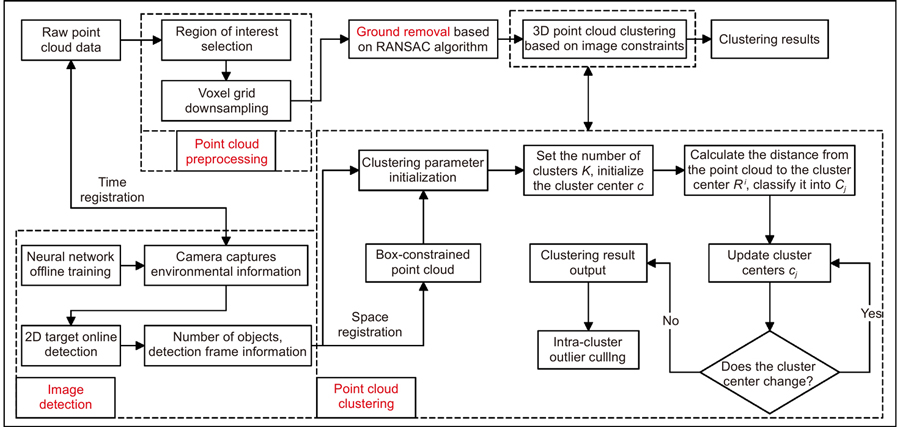

针对上述基于深度学习方法硬件成本高及传统点云聚类方法参数设定依赖度高等问题,为满足三维激光点云快速聚类分割的需求,提出了一种基于图像信息约束的三维激光点云聚类方法。首先考虑到激光点云数据量庞大,采取感兴趣区域选取、体素栅格下采样滤波的点云预处理操作;为防止地面点云被误检为有效数据,结合RANSAC方法进行地面点云分割剔除;其次引入基于卷积神经网络的YOLOv5目标检测算法,在完成传感器时空配准后进行图像和点云的数据层融合,进一步实现点云范围约束及聚类参数初始化,有效解决传统三维点云K-means聚类参数难以选取的问题;聚类结果采用类内异点剔除法进行优化,并采用不同颜色的簇标记加以区分。最后搭建移动机器人硬件平台,在室内环境下对箱体进行测试分析,验证本文方法的有效性。整体算法流程如

图 1. 基于图像信息约束的三维激光点云聚类算法流程图

Fig. 1. Flow chart of 3D laser point cloud clustering algorithm constrained by image information

2 点云预处理与地面分割

2.1 点云数据预处理

激光雷达传感器获取环境信息时,对于庞大的点云数据采取感兴趣区域粗提取、体素栅格下采样操作,实现点云有效数据获取及数据精简。三维目标识别考虑移动机器人正前方的数据区域,因此本文选取的感兴趣区域以激光雷达为起始点框选出三维长方体8 m×4 m×3 m的区域,删掉区域外的点云,初步给定点云处理范围。为加速后续算法处理速度,采用体素栅格化方法,其原理是生成若干个三维立方体,储存在立方体中的点云由重心来替代,保证点云结构不被破坏的情况下,降低点云密度,体素滤波参数根据实际精度与计算速度折中选取,本文体素边长参数设定为0.01 m。考虑到单帧点云数据较为稀疏,对于离群点及噪点未作处理,点云数据预处理结果如

图 2. 点云数据预处理。(a) 处理前;(b) 处理后

Fig. 2. Preprocessing of point cloud data. (a) Before processing; (b) After processing

2.2 基于RANSAC算法的地面分割

激光雷达点云数据经预处理后仍包含地面点云,为排除地面点对目标物聚类的干扰,需对地面点云检测剔除。RANSAC算法[12]利用随机采样的方式对三维点云数据拟合估计出平面数学模型参数,速度快且效果较好。确定好RANSAC算法的点云数目

在当前点云数据

计算空间中任意一点云

对于距离

图 3. 地面分割。(a) 地面点;(b) 非地面点

Fig. 3. Ground segmentation. (a) Groud points; (b) Non-groud points

3 图像信息约束的三维激光点云聚类方法

3.1 传感器数据时空配准

在三维激光点云聚类过程中为添加图像信息约束的条件,实现点云在图像的像素坐标系中完成数据融合,必须完成激光雷达与相机的时空配准。首先构建两个不同传感器的空间映射关系,设

激光雷达坐标系与像素坐标系的空间映射关系为

其中:旋转矩阵

相机内参及畸变系数获取参考张式标定法[13],激光雷达与相机的外参数确定参考无标定板像素级外参自标定方法[14],主要利用空间中存在大量的边缘特征,对图像和点云共有的边缘特征进行检测与匹配,添加优化后的图像及点云中边缘特征约束,构建边缘特征外参计算的残差方程:

其中:

在传感器数据融合时,各个传感器有着不同测量精度和周期,为保证测量结果反映同一状态下的客观世界,必须保证多传感器的时间配准。本文采用时间最近邻匹配方法,以激光雷达时间作为基准,匹配对应时刻下时间间隔最小的图像数据,从而完成激光雷达与相机的时间戳对齐。

3.2 二维图像检测框尺寸优化

二维图像目标检测对于三维目标检测任务而言,缺少深度信息,且单一的纹理信息无法直接确定目标在三维空间中的位置、姿态等信息,但能输出目标物的类别、数量等信息。YOLOv5算法[15]是一种基于卷积神经网络的单阶段目标检测算法,速度快、精度高,相较于YOLO之前系列的检测模型,性能有较大的提升。YOLOv5整体网络结构如

目标检测算法输出的二维检测框信息为三维点云提供约束条件,二维目标检测框的边界范围将直接影响后续的点云分割,过小的检测框会导致提取的目标物点云缺失,过大则会引入干扰点云,因此对检测框作适当扩张处理,避免丢失目标物点云。YOLOv5边框预测公式为

其中:

完成预测框尺寸优化后,对于检测框外的非目标物点云,如

3.3 三维点云K-means聚类改进

K-means 算法[10]属于较为经典的非监督学习的聚类算法之一,以欧几里得距离作为衡量数据相似度的指标,聚类速度快,常用于三维点云的聚类分割。核心思想是在未标记的点云数据中随机选取

给定点云数据集

其中:

将点云

其中:

三维点云K-means聚类存在难以选定最佳聚类个数

对于聚类结果,考虑到图像约束的检测框,深度信息未知,检测框在三维空间中以视锥的方式获取点云,检测框框选的点云数目多于实际目标物点云数目,后方其他物体的点云数据有几率被保留,对聚类结果造成干扰。设定异点判定阈值,判断当前点云与本类簇初始聚类中心

4 实验结果与分析

4.1 实验硬件平台搭建

本文实验所采用的移动机器人硬件平台如

硬件系统中相机图像的输出频率为30 Hz,激光雷达点云的输出频率为10 Hz,以激光雷达点云的时间为基准,完成传感器的时间戳对齐,如

4.2 内外参数标定实验

根据搭建的移动机器人硬件平台,由于激光雷达与相机刚性连接,相对位姿保持不变,本文采用张氏标定法求解相机的内参矩阵

表 1. 内参标定结果

Table 1. Calibration results of internal parameters

|

表 2. 外参标定结果

Table 2. Calibration results of external parameters

|

为了验证标定系数的准确性,将标定前与标定后的三维激光点云分别投影至对应图像信息中,实现RGB信息融合,标定效果如

图 10. 激光雷达与相机标定。(a) 标定前;(b) 标定后

Fig. 10. LiDAR and camera calibration. (a) Before calibration; (b) After calibration

4.3 三维点云聚类实验

为验证本文方法的有效性,在室内环境下,实验设计场景如

目标物分布疏密程度对聚类算法有较大的影响。位置分布紧密的目标物容易被聚类成同一物体,导致误检情况的发生。设置五组目标物不同的分布间距,测试本文算法鲁棒性,以

其中:

考虑到K-means、K-means++算法聚类结果存在随机性,统计完全聚类成功率

其中:

如

表 3. 分布间距对算法影响

Table 3. Affects of distribution spacing on the algorithm

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

图 11. 多种算法聚类结果。(a) DBSCAN;(b) Euclidean Clustering;(c) K-means++;(d) My-method

Fig. 11. Clustering results of multiple algorithms. (a) DBSCAN; (b) Euclidean Clustering; (c) K-means++; (d) My-method

表 4. 多种算法性能对比

Table 4. Performance comparison of multiple algorithms

|

其中:

由

5 结论

本文提出一种基于图像信息约束的三维激光点云聚类方法。经点云预处理、基于RANSAC的地面点云剔除,获得有效点云数据。引入YOLOv5目标检测算法,利用图像二维目标检测框约束三维点云范围,进一步排除其他物体对于目标物的干扰;基于图像检测信息完成聚类参数初始化,有效改善因聚类参数难以设定而导致聚类效果不佳的问题;聚类结果采用类内异点剔除进行优化。本文对箱体进行测试,实验结果表明,本文方法的聚类准确率和聚类时间分别为86.96%和23 ms,对于较为密集的目标物能较好地进行聚类分割。本文提出的移动机器人三维点云聚类识别方法,检测效果好、准确率高且具有良好的鲁棒性,满足移动机器人在未知环境感知过程中对三维点云快速聚类分割的需求,可用于移动机器人导航避障、自主搬运等领域。

实验中发现,单帧点云数据视野有限,实际还会存在物体相互遮挡的情况,无法恢复识别物体的整体结构,下一步将研究基于非重复性扫描激光雷达的高精度三维场景重建(Slam),从而获取更为丰富的物体三维点云信息,进一步提升物体识别的准确率及鲁棒性。

姬长英, 周俊农业机械导航技术发展分析农业机械学报2014459445410.6041/j.issn.1000-1298.2014.09.008

赵佳琦, 周勇, 何欣, 等基于深度学习的点云分割研究进展分析电子与信息学报202244124426444010.11999/JEIT210972

[3] Su H, Maji S, Kalogerakis E, et al. Multi-view convolutional neural networks for 3D shape recognition[C]//2015 IEEE International Conference on Computer Vision, 2015: 945–953. https://doi.org/10.1109/ICCV.2015.114.

[4] Maturana D, Scherer S. VoxNet: a 3D convolutional neural network for real-time object recognition[C]//2015 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), 2015: 922–928. https://doi.org/10.1109/IROS.2015.7353481.

[5] Qi C R, Su H, Mo K C, et al. PointNet: deep learning on point sets for 3D classification and segmentation[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition, 2017: 77–85. https://doi.org/10.1109/CVPR.2017.16.

[6] Qi C R, Yi L, Su H, et al. PointNet++: deep hierarchical feature learning on point sets in a metric space[C]//Proceedings of the 31st International Conference on Neural Information Processing Systems, 2017: 5105–5114.

[7] 金立生, 贺阳, 王欢欢, 等基于自适应阈值DBSCAN的路侧点云分割算法汽车工程202244798799610.19562/j.chinasae.qcgc.2022.07.005

王子洋, 李琼琼, 张子蕴, 等应用于无人驾驶车辆的点云聚类算法研究进展世界科技研究与发展202143327428510.16507/j.issn.1006-6055.2020.12.025.

[9] 魏玉锋, 梁冬泰, 梁丹, 等基于多模态信息的机器人视觉识别与定位研究光电工程201845217065010.12086/oee.2018.170650

杨俊闯, 赵超K-Means聚类算法研究综述计算机工程与应用20195523714,6310.3778/j.issn.1002-8331.1908-0347

李沛婷, 赵庆展, 田文忠, 等结合无人机载LiDAR点云法向量的K-means++聚类精简国土资源遥感202032210311010.6046/gtzyyg.2020.02.14

刘亚坤, 李永强, 刘会云, 等基于改进RANSAC算法的复杂建筑物屋顶点云分割地球信息科学学报20212381497150710.12082/dqxxkx.2021.200742

[13] 潘济宇, 张水强, 苏志龙, 等基于数字图像相关的水下螺旋桨三维变形测量光学学报20214112121200110.3788/AOS202141.1212001

许德刚, 王露, 李凡深度学习的典型目标检测算法研究综述计算机工程与应用2021578102510.3778/j.issn.1002-8331.2012-0449

Article Outline

夏金泽, 孙浩铭, 胡盛辉, 梁冬泰. 基于图像信息约束的三维激光点云聚类方法[J]. 光电工程, 2023, 50(2): 220148. Jinze Xia, Haoming Sun, Shenghui Hu, Dongtai Liang. 3D laser point cloud clustering method based on image information constraints[J]. Opto-Electronic Engineering, 2023, 50(2): 220148.