一种裸眼3D显示中的多视点校正方案  下载: 510次

下载: 510次

1 引言

我们身处在一个三维世界之中,当我们通过双眼观察周围的景物时,不仅会接收到物体表面发出的颜色和光强信息,还可以获取物体的空间深度信息,帮助我们理解物体的大小、远近、位置关系。然而,传统的平面显示设备只能显示三维场景中某个侧面的二维投影图像,丢失了三维场景的深度信息,严重影响了人们对三维空间信息的获取、处理和表达。裸眼三维显示技术可以为观看者再现具有空间深度信息的立体图像,而且观看者无需佩戴任何助视设备。因此,裸眼3D显示技术被认为是未来显示领域的重要发展方向[1-6]。光栅立体显示技术是目前运用较广泛的裸眼3D显示技术之一,能够提供清晰的显示效果和立体感,受到了各国研究人员和企业的广泛关注[25]。

光栅立体显示器的基本原理是将多视点图进行合成编码,并加载到显示器上显示,通过柱透镜光栅的折射在空间中形成不同的视点显示区域,观察者左右眼处在不同视点区域内时,将看到具有立体效果的图像[7-9]。多视点采集为光栅立体显示器提供了显示内容,是光栅立体显示的关键一步。多视点采集的关键在于采集位置要匹配显示器视点分布,否则会出现错误显示。传统多视点采集方案包括真实采集[11]和虚拟采集两种[10],这两种方案均通过搭建均匀相机阵列对场景进行采集。经研究发现,由于柱透镜光栅存在畸变,光栅立体显示器构建的视点实际上呈不均匀分布,这种分布和传统的均匀采集方案发生冲突,显示器空间视点将会被填充错误的视差图像,导致视点图像偏移、透视关系错误等问题,影响最终观看质量。因此,本文提出一种针对裸眼3D中多视点图像的校正方案,使采集视点匹配显示器视点分布,并填充正确视点图像,对提升光栅立体显示器观看效果是尤为必要的。

利用相邻视点生成对应位置的虚拟视点是校正的关键一步。基于深度信息的渲染(DIBR)[12-14]是目前比较主流的虚拟视点生成方法,该算法通过深度和RGB图像、通过3D扭曲(3D warping)生成虚拟视点,有着计算速度快、算法轻便等优势,但生成效果存在空洞、重叠和伪影问题[13],不适用于光栅立体显示的内容生成[10]。神经网络光场(NeRF)[15]使用神经网络表征针对场景的光线采样,以隐函数的方式计算新视图,NeRF可以合成复杂场景的高质量虚拟视点,但存在网络复杂、渲染速度慢、训练时间长等问题,不适用于动态光栅立体显示器的视点合成。光流记录了时变或相邻视点图像中模式运动速度,包含了目标相对运动的信息[16-19],可以通过前后帧的光流经过后向扭曲(Backward warping)预测时序中间帧。光流法在保证计算速度的同时的渲染效果同样可观,被广泛的运用于视频插帧中[19-22],受光流插帧的启发,本文提出了一种基于光流预测的中间视点合成模块,该模块调用RAFT光流预测网络[18]和一个融合校正网络组成,以有效的生成相邻视点间任意位置的高质量中间视点。

针对均匀采集的多视点图像与显示器视点分布不匹配的问题,本文在不改变显示器硬件配置的前提下,提出了一种视点筛选算法和中间视点生成网络,以生成正确位置拍摄的虚拟视点,使之匹配显示器视点分布:输入均匀采集的一组多视点图像阵列和显示器相关参数,利用视点筛选算法计算出正确空间视点位置分布,指导光流预测网络生成双向光流,并经融合校正网络进行光流校正,以提高中间光流生成质量,通过后向扭曲生成对应位置的虚拟视点图像,经合成编码后在光栅立体显示器上显示。实验表明,该校正方案有效地解决了传统采集和显示器视点不匹配的问题,校正后的视点为显示器视点填充了正确的视差图,提升了观看质量。

2 基本原理

2.1 光栅立体显示器和多视点图像采集

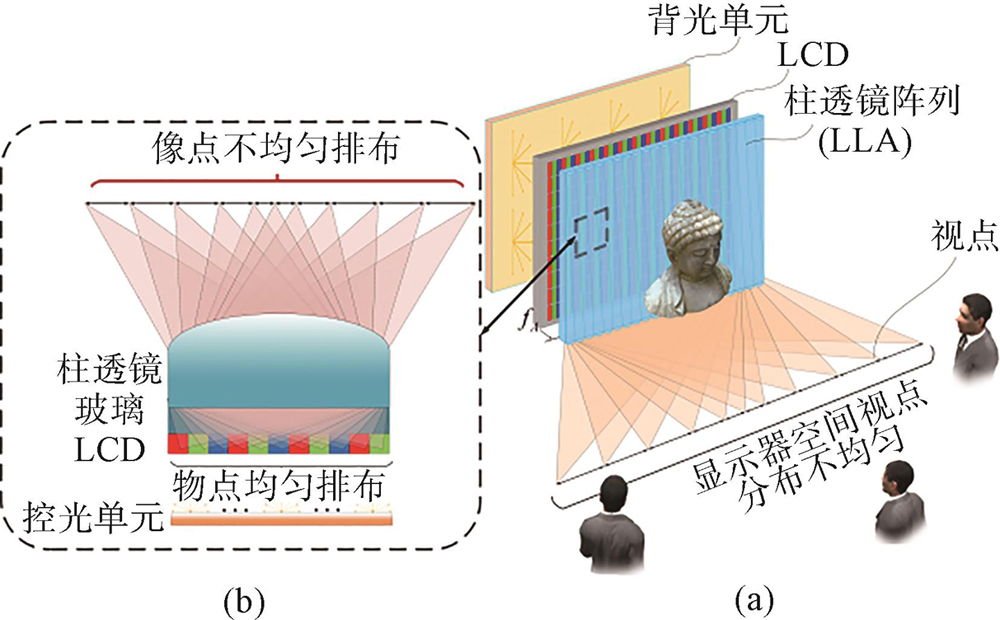

多视点图像采集为光栅立体显示器提供了显示内容,是光栅立体显示的关键一环,相机采集间距、采集距离等参数和光栅立体显示器硬件参数是否匹配直接决定了最后的观看质量[10]。传统多视点采集分为虚拟场景和真实场景采集两种,这两种方案都是通过搭建均匀相机阵列实现采集。在理想条件下,视差图经多视点编码后经过柱透镜光栅被均匀偏折在空间中,所以只要根据显示器参数设置好采集间隔进行均匀采集,采集视点图像

图 1. 均匀采集和空间视点分布示意图。(a)光栅立体显示器的视点采集和显示;(b)真实透镜下的视点分布。

Fig. 1. Schematic diagram of uniform acquisition and spatial viewpoint distribution.(a)Viewpoint acquisition and display of auto stereo display;(b)View distribution under the real lenses.

因此,本文提出一种基于软件实现的多视点图像校正方案:针对均匀采集的多视点图像进行校正,利用视点间相关性预测出对应位置的多视点图像,使之能够正确匹配显示器视点分布,提高观看效果。

多视点采集校正方案如

图 2. 多视点采集校正原理。(a)多视点采集校正方案;(b)基于Zemax的视点分布计算。

Fig. 2. Principle of multi-view acquisition and correction.(a)Multi-view acquisition and correction scheme;(b)Viewpoint distribution calculation based on Zemax.

2.2 基于光流法的虚拟视点生成网络

2.2.1 网络结构分析

给定两个相邻视点

相邻视点间的光流

或者

其中,

为了得到光流

由于缺乏中间视点的监督,和遮挡关系的影响,单纯的使用RAFT网络预测中间视点通常在接近

首先利用RAFT光流预测网络计算出

2.2.2 训练

给定输入图像

其中:光流预测损失函数

其中,

插值损失

最后,我们添加了一个平滑度损失项

设置经验性权重

2.3 多视点筛选算法

根据光栅立体显示器的实际视点分布,我们提出了一种多视点筛选算法,本算法的目的是求得均匀采集视点

m:m表示距离真实采集点最近且小于真实采集点序号的均匀视点序号,真实采集点将位于(m,m+1)之间,i和m的设置可以保证

i:

x:x表示插值系数,

首先利用光学仿真计算针对特定的光栅立体显示器的光学参数在最佳观看距离处仿真出显示器空间视点分布

按照这个方法,可以最终确定

由此,可以得到所有正确位置的多视点校正图像

3 实验结果

3.1 基于光流法的虚拟视点生成测试

为了结合实际应用场景,验证本文提出的利用基于光流法的视点生成的有效性,我们分别选用了若干组真实、虚拟场景多视点图像作为对视点生成模块的测试集,选用两组分辨率为960×540、视差角为6°的视差图送入训练好的网络做插值预测,单视点平均生成时间为34 ms。

3.2 显示效果测试

将均匀采集后的多视点图像阵列编码后分别加载到本实验室的光栅立体显示器上显示,分别在显示器左右15°放置单反相机拍照记录,最终显示效果如

图 7. 显示效果对比图。(a)特定位置采集效果;(b)校正前特定角度显示图像;(c)校正后特定角度显示图像;(d)图6(a)和图6(b)间的差值图;(e)图6(a)和图6(c)间的差值图。

Fig. 7. Display effect comparison diagram.(a)Acquisition effect of specific location;(b)Display image at specific angle before correction;(c)Display image at specific angle after correction;(d)Difference between Fig.6(a)and Fig.6(b);(e)Difference between Fig.6(a)and Fig.6(c).

4 结论

在裸眼3D显示系统中,由于柱透镜存在像差,使显示器空间视点呈不均匀分布,存在空间视点分布和采集视点分布不匹配的现象,导致视点图像错位,透视关系不正确等问题,最终影响观看效果。

本文针对上述问题提出了一种多视点校正方案,旨在将均匀采集的多视点图像校正为符合观看角度的新图像阵列,以提高光栅立体显示效果。该校正方案包括视点筛选算法和中间视点生成模块,通过光学仿真出真实空间视点分布,利用视点筛选算法指导光流法生成正确位置的中间视点阵列,使校正图像匹配真实的空间视点位置。经过实验验证,该方法有效校正了原本存在的空间视点分布和采集分布不匹配的问题,明显地提升了观看效果。

[7] 王琼华.3D显示技术与器件[M].北京: 科学出版社, 2011.10.1002/j.2637-496x.2011.tb00390.x

[10] 邢树军, 曹良才, 桑新柱, 等. 面向超多视点光场的虚拟立体内容生成技术综述[J]. 中国激光, 2021, 48(15): 1509001.

[11] 尧奔.密集视点三维光场视频直播系统实现方法研究[D].北京: 北京邮电大学, 2021.10.30919/es8d549

[23] LIU Z, MAO H Z, WU C Y, et al. A ConvNet for the 2020s[J], 2022, arXiv: 2201.03545.

Article Outline

李宁驰, 于迅博, 高鑫, 颜玢玢, 桑新柱, 温旭东, 徐斌. 一种裸眼3D显示中的多视点校正方案[J]. 液晶与显示, 2022, 37(5): 605. Ning-chi LI, Xun-bo YU, Xin GAO, Bin-bin YAN, Xin-zhu SANG, Xu-dong WEN, Bin XU. Multi-view correction scheme for naked eye 3D display[J]. Chinese Journal of Liquid Crystals and Displays, 2022, 37(5): 605.