时空特征对齐的多目标跟踪算法

1 引言

多目标跟踪是计算机视觉的重要组成部分,广泛应用在监控视频分析和自动驾驶等领域,其目的是定位多个感兴趣的目标,并维持每个目标唯一的身份编号(identification, ID),记录连续运动轨迹[1]。多目标跟踪面临诸多挑战,首先在背景复杂的场景中,目标的运动具有不确定性和随意性,而且目标与目标之间存在相互遮挡以及被物体遮挡现象,导致目标特征发生改变;其次在低分辨率场景中,目标与背景差异较小,分辨出感兴趣目标就十分困难;并且在多目标跟踪过程中目标数目具有不确定性,容易带来误检、漏检以及ID切换等现象。针对上述问题,研究者提出了一系列多目标跟踪方法。最早的多目标跟踪算法主要关注优化检测以及数据关联。随着目标检测和行人重识别的迅速发展,MOT也有了相当大的突破[2-10]。但是这些方法的检测步骤是完全独立于先前的历史帧,一旦目标变得部分或完全被遮挡,检测器就失效了,从而造成轨迹丢失。Zhou等人 [11-12]将成对的帧作为输入,直接输出检测和成对的关联,虽然这些方法提高了跟踪的健壮性,但是它们输入的是成对的帧,不能提取多帧的相关性,只能处理单帧遮挡。最近,随着端到端的目标检测器DETR[13]的提出,开始有学者提出了基于注意力机制的多目标跟踪算法[14-16]。虽然这些算法是端到端的(联合检测和跟踪),但是其中的检测部分也只是将基于卷积的检测器换成了基于Transformer[17]的检测器,仍是独立地对每一帧进行特征提取,没有对目标的时序信息进行直接地建模。

目前主流的多目标跟踪方法大多是单独地提取每一帧的信息,忽略了不同帧之间的关联,虽然近几年也有一些方法开始尝试构建不同帧之间相关性,但是它们都仅停留在相邻帧,没有对视频中存在的时序信息进行显式建模。而在视频目标检测和视频行人重识别领域中,视频时序信息已被证实在处理运动模糊,遮挡和小目标等问题上很有效。受此启发,本文提出了一种时空特征对齐的多目标跟踪方法。本文主要贡献如下:

1) 提出时空特征对齐的多目标跟踪方法,充分利用时空特征以及保证时间一致性,提升多目标跟踪性能;

2) 引入卷积门控递归单元,对视频时空信息进行建模,该结构可以学习整个历史帧序列信息,输入任意长度的视频,构建任意长度视频帧之间的相关性;

3) 设计特征对齐模块,利用前后帧目标的位置对应关系,将历史帧信息与当前帧信息对齐,保证时间一致性,降低误检率;

4) 将设计的方法在公开数据集MOT17和MOT20上进行实验验证,结果表明所提方法较基准方法提升明显且优于目前同类先进方法。特别是在MOT20上,MOTA值达到了67.4,IDF1值达到了70.6。

2 相关工作

本文方法从视频理解相关领域出发,探究多目标跟踪中视频时序信息的有效性,下面为这些领域中与本文方法相关的工作以及本文方法的不同之处。

2.1 多目标跟踪

多目标跟踪方法大致可以分为三类,分别为基于检测[2-3, 18-19],联合检测与重识别[9-10, 20-22]以及联合检测与跟踪[11-12, 14-16, 23]。基于检测的算法将多目标跟踪任务分为四步,分别为目标检测、特征提取、相似度计算和数据关联。由于目标检测和行人重识别的迅速发展,大多数学者的目光聚焦在前两步,而后两步采用传统方法。SORT[2]是最早利用卷积神经网络检测行人的多目标跟踪算法之一,该算法依靠卡尔曼滤波[24]和匈牙利算法[25]来解决目标关联,但是相似度计算只利用了运动信息——检测框和跟踪框的交并比(intersection over union, IOU),对于遮挡问题效果不佳,DeepSORT[3]在SORT的基础上引入行人重识别(re-identification, Re-ID)网络来提取目标的深度表观特征,使得数据关联更准确,还有一些方法利用了更复杂的特征,如Xu等人[8]使用了时空图卷积来提取轨迹深度特征表示。不过复杂特征的提取大大增加了计算量,算法实时性较差。为了提高实时性,JDE[9]提出联合检测与重识别这一跟踪范式,用一个网络来实现目标检测和Re-ID特征提取,平衡了跟踪精度和跟踪速度,而针对JDE方法在单一网络中检测和Re-ID特征存在不公平等问题,一系列算法如 FairMOT[10],CSTrack[20],RelationTrack[21],CorrTrack[22]相继提出。也有研究者尝试为MOT构建端到端的解决方案,也就是联合检测与跟踪,该范式旨在同时输出检测和跟踪结果,Tracktor[11]直接利用检测器的回归模块预测目标下一帧的位置来完成多目标跟踪任务,CenterTrack[12]通过在成对的图像上执行检测,并结合先前帧的目标检测结果来预测当前帧的目标位置偏移,从而将前后帧中相同目标建立起联系,实现多目标跟踪。ChainedTrack[26]使用相邻帧作为输入,并生成代表相同目标的框对,将跨帧关联问题转化成目标检测问题。简单有效的端到端目标检测器DETR[13]的出现给目标检测领域带来革新的同时,也给多目标跟踪带来了新思路,有学者开始构建基于Transformer[17]的端到端的多目标跟踪器,如TransTrack[14],TrackFormer[15],MOTR[16],这些算法主要在DETR解码器的查询输入这块进行一定的改进以适应MOT任务。可以看出,MOT的发展与目标检测和行人重识别的发展是一致的,不过本文从视频目标检测和视频行人重识别出发来研究视频时序信息对MOT的重要性。

2.2 视频行人重识别

在视频行人重识别方面,视频比静止图像包含更丰富的空间和时间信息,基于视频的行人重识别最直接的方法是先把视频拆成一帧一帧的图像,利用深度学习提取每帧图像的帧级别特征,然后通过不同操作如平均池化或最大池化[27],递归循环网络(recurrent neural networks, RNN)[28-29]和时间注意力[30]来聚合多帧特征得到视频级别特征。另一种策略是通过3D卷积同时捕获空间和时间信息[31],不同于基于2D卷积的模型需要诸如循环网络来提取时间信息,3D 卷积自然处理输入视频以输出时空特征。尽管性能良好,但3D卷积通常需要更多的计算和内存资源,因此本文方法没有采用3D卷积模型,而是采用先提取图像单帧级别特征,再聚合多帧特征这一策略。

2.3 视频目标检测

在视频目标检测方面,相比于图像目标检测,视频具有高冗余度的特性,其中包含了大量的时空信息[32]。充分利用好时序上下文关系,可以解决视频中连续帧之间的大量冗余的情况,提高检测速度[33];还可以解决视频相对于图像存在的运动模糊、视频失焦、部分遮挡和奇异姿势等问题。对于高冗余度特性,学者们希望利用运动信息来进行检测,其中最常用的运动信息是光流。DFF[34]只对关键帧进行特征提取,而对于关键帧附近的非关键帧,通过计算光流来聚集关键帧特征,大大减少了计算量。对于时空信息的提取,T-CNN[35]用检测算法学习图像中目标的空间信息,用跟踪算法学习图像中目标的时序信息,D&T[36]利用孪生网络来提取不同帧的相关性也就是时序信息,STMN[37]在单帧检测器上加入时空存储模块来提取时空信息,使其能够处理任意长度的视频。与STMN结构类似,本文在通用特征提取模块后引入了ConvGRU[18]来提取时空信息,并用特征对齐模块来保证了时空一致性。

3 本文方法

本节对本文方法进行详细描述。首先在3.1节对本文方法整体架构进行概述,然后在3.2节、3.3节和3.4节详细介绍各个模块,分别为时空特征提取模块、检测头与Re-ID头和数据关联模块。

3.1 方法整体架构

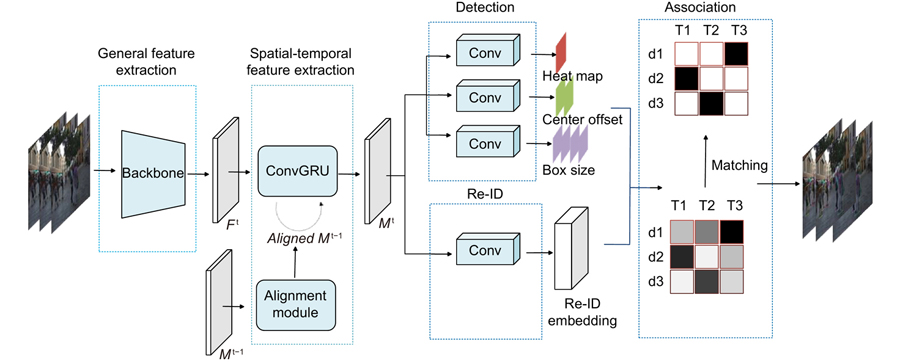

针对目前主流多目标跟踪算法未能有效地提取时序信息这一问题,本文提出时空特征对齐的多目标跟踪方法,结构如

3.2 时空特征提取模块

本文方法使用ConvGRU[18]来学习目标的时空信息,ConvGRU是如

其中

由于视频中目标是运动的,目标在当前帧的空间位置与前一帧的空间位置不同,那么代表历史帧特征的

其中

3.3 检测头和Re-ID头

检测模块主要由三个并行的卷积模块(卷积核大小为3x3,输出通道数为256的卷积+卷积核大小为1x1的卷积)组成,分别输出目标中心点热力图,目标中心点偏移和检测框宽高。热力图分支负责预测目标中心点位置,训练时需要将标签转化为热力图形式来计算损失,假设目标真实框为

其中,参数

其中,

Re-ID模块旨在提取同一类别中可以区分不同身份的细粒度表观特征,主要在时空特征提取模块后应用卷积提取128维的特征图。训练时将Re-ID作为分类任务,将真值处目标特征向量经过一个线性分类层,得到每个ID分类的概率值

其中,

其中,

3.4 数据关联

数据关联策略与FairMOT[10]保持一致。首先基于第一帧中检测到的框初始化轨迹片段。然后在后续的帧中,使用两阶段匹配策略实现检测框与轨迹片段的连接。在第一阶段,通过网络得到输入图像的目标位置信息和Re-ID特征,首先利用卡尔曼滤波和马氏距离排除相距较远的匹配,然后将Re-ID特征余弦距离

4 实验结果与分析

4.1 数据集与模型评价

实验主要在多目标跟踪数据集MOT17和MOT20上进行,并与现有方法进行对比分析。MOT17数据集主要标注目标为移动的行人,包含了不同天气状况、相机静止或运动、多个拍摄角度和光照变化的视频,涵盖了多目标跟踪过程中可能遇到各种挑战的场景。MOT17数据集共14个视频序列,分为7个训练集和7个测试集,视频序列长度平均为800帧,其中训练集包含112297个检测框标注和548个ID标注且提供3种检测器SDP、DPM和Faster R-CNN的检测结果。为了进行公平的对比分析,实验在训练时还使用了与FairMOT[10]相同的额外数据集ETH、CityPerson、CalTech、CUHK-SYSU、PRW、CrowdHuman。CityPerson是行人检测数据集,数据是由车载摄像机在城市中收集,总计25000张图片,350000个标注框;ETH包含5598张图片。不过这两个数据集只提供了目标真实检测框,所以训练时忽略了这些数据集中的 Re-ID损失。CalTech、CUHK-SYSU、PRW、MOT17提供了目标真实检测框和ID,可以用来同时训练检测分支和Re-ID分支。对于消融实验,本文使用上述6个额外数据集和MOT17的前半序列作为训练集,MOT17的后半序列作为验证集。MOT任务中的评价指标主要包括如下:

多目标跟踪准确度 (Multiple object tracking accurary, MOTA):同时考虑误检、漏检和ID切换,能够直接衡量算法检测和跟踪的性能。计算公式如式(12)所示,其中,t表示时间帧的索引,FN表示漏检数,FP表示误检数,IDSW表示ID切换次数,GT表示真实检测框数。

识别F1值(Identification F1 Score,IDF1):用来衡量ID识别准确率与召回率之间的平衡性,评估跟踪器的ID识别性能。计算公式如式(13)所示,其中,IDTP表示真阳性ID,IDFP表示假阳性ID,IDFN表示假阴性ID,与检测指标的TP、FP、FN相对应。

高阶跟踪精度(Higher order tracking accuracy, HOTA):同时考虑了检测精度、关联和定位精度。

误检数(False positive, FP):被预测为正样本的负样本数。

漏检数(False negatives, FN):被预测为负样本的正样本数。

命中轨迹比(Mostly tracked targets, MT):跟踪轨迹占真实轨迹80%以上的轨迹数与轨迹总数之比。

丢失轨迹比(Mostly lost targets, ML):跟踪轨迹占真实轨迹20%以下的轨迹数与轨迹总数之比。

ID切换(Identity switches, IDs):目标ID切换的总数。

4.2 实验环境与训练细节

实验硬件环境为搭载Inter Xeon(R) Platinum 8163 CPU 2.50GHz处理器和4张NVIDIA GeForce RTX 3090(24G 显存)的深度学习服务器。软件环境为Ubuntu 20.04操作系统下的Pytorch1.7深度学习框架。实验按照FairMOT[10]的设置,采用了如随机翻转和随机裁剪等数据增强方法。为了解决不同帧率的问题,本文对视频序列进行了有间隔的随机采样。ConvGRU的卷积核大小设为5×5,特征对齐模块的局部区域大小设为5。训练时输入图片大小为1088×608,首先使用在COCO数据集预训练得到的模型参数来初始化骨干网络模型,然后采用Adam优化器训练30个轮次,batch size设置为12,初始化学习率为1e-4,在第20个轮次更改学习率为1e-5。

4.3 定量分析

为了验证本文提出的时空特征对齐的多目标跟踪方法的效果,在MOT Challenge上与当前一些先进MOT算法进行了指标对比。

表 1. 本文方法与其他先进方法在MOT17数据集上的对比结果

Table 1. The tracking performance comparision between our method and other advanced methods on MOT17 data set

|

表 2. 本文方法与其他先进方法在MOT20数据集上的对比结果

Table 2. The tracking performance comparision between our method and other advanced methods on MOT20 data set

|

4.4 消融实验

本文的消融实验使用上述6个额外数据集和MOT17的前半序列作为训练集,MOT17的后半序列作为验证集。本文探究了ConvGRU和特征对齐模块对整体跟踪性能的影响。从

表 3. 不同模块对跟踪性能的影响

Table 3. The impact of different components on the overall tracking performance

|

本文还设计了消融实验探究视频序列输入长度对跟踪性能的影响,如

表 4. 视频序列输入长度对跟踪性能的影响

Table 4. The impact of video sequence input length on the overall tracking performance

|

4.5 定性分析

除了在基准数据集上进行量化指标的测试,本节也对本文方法与基准方法进行了对比定性分析,通过可视化的结果来分析本文方法在面对多目标跟踪中遮挡、目标形变等问题时表现出的效果。与消融实验一样,将MOT17的前半序列作为训练集,MOT17的后半序列作为验证集,本文在验证集上进行定性分析。

图 4. 本文方法与基准方法在验证集上的可视化结果对比。(a) ID切换;(b) 误检和漏检;(c) 特定的误检

Fig. 4. The visualization results comparison between baseline and our method on validation set. (a) ID switch; (b) FP and FN; (c) special FP

但时空特征提取模块也存在一定的缺陷,会出现基于单帧的方法中不存在的误检现象。比如

5 结论

现有多目标跟踪方法大多是单独提取每一帧的信息,没有对视频中存在的时序信息进行显式建模,这使得方法在运动模糊、遮挡和小目标等场景中的性能显著下降。针对这一问题,本文提出了时空特征对齐的多目标跟踪方法,主要通过ConvGRU提取视频中的时空信息,不过由于前后帧目标的空间位置不同,且实验结果表明时序模型难以忘记过去帧目标所处位置,使得误检增多,因此进一步提出特征对齐模块将前后帧目标信息对齐。实验结果表明,本文方法可以有效提取时序信息,提升多目标跟踪性能,这也体现了多目标跟踪中时序信息的有效性。不过,特征对齐模块中相似度计算的运算量较大以及时序信息的引入会造成一些单帧检测器中不会出现的误检现象,影响检测器的性能,因此,下一步研究工作的重点在于更高效的特征对齐模块和检测模块上,通过改进检测模块来避免因为时序信息引入而出现的特定误检现象。

6 附录

6.1 KITTI数据集上的实验结果与分析

自动驾驶数据集KITTI共50个视频序列,分为21个训练集和29个测试集,包含市区、乡村和高速公路等场景采集的真实图像数据,可用于车辆多目标跟踪。值得注意的是,相比于MOT系列数据集,该数据集帧率较低,只有10 fps。KITTI车辆类测试集的定量结果如

表 5. 本文方法与其他先进方法在KITTI车辆类测试集上的对比结果

Table 5. The tracking performance comparision between our method and other advanced methods on KITTI vehicle class test set

|

KITTI上的定量结果显示了本文方法的一个缺陷,即在本文方法的特征对齐模块中,计算前后帧相似度是在局部区域,假设目标在相邻帧不会有过大的位移,这在目标速度过快或帧率过低时有些不成立。KITTI数据集帧率低且车辆速度快,尽管如此,对于KITTI的大多数场景,本文方法仍有效。从可视化结果可以看出,在相机运动目标静止以及相机静止目标运动这些场景,本文方法跟踪性能良好。对于

图 5. 本文方法在KITTI测试集上的可视化结果。图片左侧为视频号。图片左上角为帧号

Fig. 5. Visualization results of this method on the KITTI test set. The video number is in the left side of the figure. The frame number is in the upper left of the figure

尽管如此,对比同样使用了Re-ID模块的QDTrack,本文方法的HOTA、IDS指标较好,但在同时衡量检测和跟踪的MOTA 指标上较低,表明本文方法跟踪器较好,提取的Re-ID特征较好,而检测器较差,这也可以从FP这个指标可以看出,因为本文方法在会车场景时检测框会漂移,漂移的检测框与真实检测框的IOU可能小于0.5,就被认为是误检。不过使用Re-ID模块的方法对比未使用Re-ID模块的CenterTrack,跟踪性能都较差,表明提取的Re-ID特征不够鲁棒,这可以使用额外的车辆重识别数据弥补。

Overview: Multiple object tracking (MOT) is an important task in computer vision. It is widely used in the fields of surveillance video analysis and automatic driving. MOT is to locate multiple objects of interest, maintain the unique identification number (ID) of each object, and record continuous tracks. The difficulty of multi-target tracking is false positives (FP), false negatives (FN), ID switches (IDs), and the uncertainty of the target number. Most of the MOT methods improve object detection and data association, usually ignoring the correlation between different frames. Although some methods have tried to construct the correlation between different frames in recent years, they only stay in the adjacent frames and do not explicitly model the temporal information in the video. They don’t make good use of the temporal information in the video, which makes the tracking performance significantly degraded in motion blur, occlusion, and small target scenes. In order to solve these problems, this paper proposes a multiple object tracking method with the aligned spatial-temporal feature. First, the convolutional gated recurrent unit (ConvGRU) is introduced to encode the spatial-temporal information of the object in the video; By considering the whole history frame sequence, this structure effectively extracts the spatial-temporal information to enhance the feature representation. However, the target in the video is moving, and the spatial position of the target in the current frame is different from that in the previous frame, and ConvGRU is difficult to forget the spatial position of the target in the historical frame, thus overlaying the misaligned features, resulting in the spatial position of the target in the historical frame on the feature map has a high response, which makes the detector think that the target is still in the spatial position of the previous frame. Then, the feature alignment module is designed to ensure the time consistency between the historical frame information and the current frame information to reduce the false detection rate. Finally, this paper tests MOT17 and MOT20 datasets, and the multiple object tracking accuracy (MOTA) values are 74.2 and 67.4, respectively, which are increased by 0.5 and 5.6 compared with the baseline FairMOT method. Our identification F1 score (IDF1) value is 73.9 and 70.6, respectively, which is increased by 1.6 and 3.3 compared with the baseline FairMOT method. In addition, the qualitative and quantitative experimental results show that the overall tracking performance of this method is better than that of most of the current advanced methods.

[2] Bewley A, Ge Z Y, Ott L, et al. Simple online and realtime tracking[C]//2016 IEEE International Conference on Image Processing (ICIP), 2016: 3464–3468. https://doi.org/10.1109/ICIP.2016.7533003.

[3] Wojke N, Bewley A, Paulus D. Simple online and realtime tracking with a deep association metric[C]//2017 IEEE International Conference on Image Processing, 2018: 3645–3649. https://doi.org/10.1109/ICIP.2017.8296962.

[4] 鄂贵, 王永雄基于R-FCN框架的多候选关联在线多目标跟踪光电工程202047119013610.12086/oee.2020.190136

[5] Berclaz J, Fleuret F, Fua P. Robust people tracking with global trajectory optimization[C]//2006 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR'06), 2006: 744–750. https://doi.org/10.1109/CVPR.2006.258.

[6] Pirsiavash H, Ramanan D, Fowlkes C C. Globally-optimal greedy algorithms for tracking a variable number of objects[C]//CVPR 2011, 2011: 1201–1208. https://doi.org/10.1109/CVPR.2011.5995604.

[7] Brasó G, Leal-Taixé L. Learning a neural solver for multiple object tracking[C]//Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2020: 6246–6256. https://doi.org/10.1109/CVPR42600.2020.00628.

[8] Xu J R, Cao Y, Zhang Z, et al. Spatial-temporal relation networks for multi-object tracking[C]//Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision, 2019: 3987–3997. https://doi.org/10.1109/ICCV.2019.00409.

[9] Wang Z D, Zheng L, Liu Y X, et al. Towards real-time multi-object tracking[C]//Proceedings of the 16th European Conference on Computer Vision, 2020: 107–122. https://doi.org/10.1007/978-3-030-58621-8_7.

[11] Bergmann P, Meinhardt T, Leal-Taixé L. Tracking without bells and whistles[C]//Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision, 2019: 941–951. https://doi.org/10.1109/ICCV.2019.00103.

[12] Zhou X Y, Koltun V, Krähenbühl P. Tracking objects as points[C]//Proceedings of the 16th European Conference on Computer Vision, 2020: 474–490. https://doi.org/10.1007/978-3-030-58548-8_28.

[13] Carion N, Massa F, Synnaeve G, et al. End-to-end object detection with transformers[C]//Proceedings of the 16th European Conference on Computer Vision, 2020: 213–229. https://doi.org/10.1007/978-3-030-58452-8_13.

[14] Sun P Z, Cao J K, Jiang Y, et al. Transtrack: Multiple object tracking with transformer[Z]. arXiv: 2012.15460, 2020. https://arxiv.org/abs/2012.15460.

[15] Meinhardt T, Kirillov A, Leal-Taixé L, et al. TrackFormer: Multi-object tracking with transformers[C]//Proceedings of the 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2022: 8834–8844. https://doi.org/10.1109/CVPR52688.2022.00864.

[16] Zeng F G, Dong B, Zhang Y A, et al. MOTR: End-to-end multiple-object tracking with transformer[C]//Proceedings of the 17th European Conference on Computer Vision, 2022: 659–675. https://doi.org/10.1007/978-3-031-19812-0_38.

[17] Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need[C]//Proceedings of the 31st International Conference on Neural Information Processing Systems, 2017: 6000–6010.

[18] Ballas N, Yao L, Pal C, et al. Delving deeper into convolutional networks for learning video representations[C]//Proceedings of the 4th International Conference on Learning Representations, 2015.

[19] Yu F W, Li W B, Li Q Q, et al. POI: Multiple object tracking with high performance detection and appearance feature[C]//Proceedings of the European Conference on Computer Vision, 2016: 36–42. https://doi.org/10.1007/978-3-319-48881-3_3.

[21] Yu E, Li Z L, Han S D, et al. RelationTrack: Relation-aware multiple object tracking with decoupled representation[J]. IEEE Trans Multimedia, 2022. https://doi.org/10.1109/TMM.2022.3150169.

[22] Wang Q, Zheng Y, Pan P, et al. Multiple object tracking with correlation learning[C]//Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2021: 3875–3885. https://doi.org/10.1109/CVPR46437.2021.00387.

[23] Tokmakov P, Li J, Burgard W, et al. Learning to track with object permanence[C]//Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision, 2021: 10840–10849. https://doi.org/10.1109/ICCV48922.2021.01068

[24] Welch G, Bishop G. An Introduction to the Kalman Filter[M]. Chapel Hill: University of North Carolina at Chapel Hill, 1995.

[25] Kuhn H W. The Hungarian method for the assignment problem[J]. Naval Res Logist Q, 1955,

[26] Peng J L, Wang C A, Wan F B, et al. Chained-tracker: Chaining paired attentive regression results for end-to-end joint multiple-object detection and tracking[C]//Proceedings of the 16th European Conference on Computer Vision, 2020: 145–161. https://doi.org/10.1007/978-3-030-58548-8_9.

[27] Zheng L, Bie Z, Sun Y F, et al. MARS: A video benchmark for large-scale person re-identification[C]//Proceedings of the 14th European Conference on Computer Vision, 2016: 868–884. https://doi.org/10.1007/978-3-319-46466-4_52.

[28] McLaughlin N, Del Rincon J M, Miller P. Recurrent convolutional network for video-based person re-identification[C]//Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition, 2016: 1325–1334. https://doi.org/10.1109/CVPR.2016.148.

[29] Zhou Z, Huang Y, Wang W, et al. See the forest for the trees: Joint spatial and temporal recurrent neural networks for video-based person re-identification[C]//Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition, 2017: 6776–6785. https://doi.org/10.1109/CVPR.2017.717.

[30] Fu Y, Wang X Y, Wei Y C, et al. STA: Spatial-temporal attention for large-scale video-based person re-identification[C]//Proceedings of the 33rd AAAI Conference on Artificial Intelligence, 2019: 8287–8294. https://doi.org/10.1609/aaai.v33i01.33018287.

[31] Li J N, Zhang S L, Huang T J. Multi-scale 3D convolution network for video based person re-identification[C]//Proceedings of the 33rd AAAI Conference on Artificial Intelligence, 2019: 8618–8625. https://doi.org/10.1609/aaai.v33i01.33018618.

王迪聪, 白晨帅, 邬开俊基于深度学习的视频目标检测综述计算机科学与探索20211591563157710.3778/j.issn.1673-9418.2103107

陆康亮, 薛俊, 陶重犇融合空间掩膜预测与点云投影的多目标跟踪光电工程202249922002410.12086/oee.2022.220024

[34] Zhu X Z, Xiong Y W, Dai J F, et al. Deep feature flow for video recognition[C]//Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition, 2017: 4141–4150. https://doi.org/10.1109/CVPR.2017.441.

[35] Kang K, Ouyang W L, Li H S, et al. Object detection from video tubelets with convolutional neural networks[C]//Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition, 2016: 817–825. https://doi.org/10.1109/CVPR.2016.95.

[36] Feichtenhofer C, Pinz A, Zisserman A. Detect to track and track to detect[C]//Proceedings of the 2017 IEEE International Conference on Computer Vision, 2017: 3057–3065. https://doi.org/10.1109/ICCV.2017.330.

[37] Xiao F Y, Lee Y J. Video object detection with an aligned spatial-temporal memory[C]//Proceedings of the 15th European Conference on Computer Vision, 2018: 494–510. https://doi.org/10.1007/978-3-030-01237-3_30.

[38] Yu F, Wang D Q, Shelhamer E, et al. Deep layer aggregation[C]//Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2018: 2403–2412. https://doi.org/10.1109/CVPR.2018.00255.

[39] Pang B, Li Y Z, Zhang Y F, et al. TubeTK: adopting tubes to track multi-object in a one-step training model[C]//Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2020: 6307–6317. https://doi.org/10.1109/CVPR42600.2020.00634.

[40] Wu J J, Cao J L, Song L C, et al. Track to detect and segment: an online multi-object tracker[C]//Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2021: 12347–12356. https://doi.org/10.1109/CVPR46437.2021.01217.

[41] Pang J M, Qiu L L, Li X, et al. Quasi-dense similarity learning for multiple object tracking[C]//Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2021: 164–173. https://doi.org/10.1109/CVPR46437.2021.00023.

Article Outline

程稳, 陈忠碧, 李庆庆, 李美惠, 张建林, 魏宇星. 时空特征对齐的多目标跟踪算法[J]. 光电工程, 2023, 50(6): 230009. Wen Cheng, Zhongbi Chen, Qingqing Li, Meihui Li, Jianlin Zhang, Yuxing Wei. Multiple object tracking with aligned spatial-temporal feature[J]. Opto-Electronic Engineering, 2023, 50(6): 230009.