基于人眼视觉规律的注视点分类及其在图像标注中的应用

1 引言

图像标注广泛应用于计算机视觉领域,如物体检测、识别等[1-4]。传统图像标注通常由标注人员手动绘制目标物体边界框,存在效率低、成本高的问题。据统计,在Mechanical Turk上对ImageNet进行大规模标注时,绘制边界框耗费的时间中位数为25.5 s。此外,还需要对标注人员进行相关培训[5-6]。

生物学研究表明,人类的视觉系统存在选择性注意机制[7]。目前,针对眼动规律与目标识别关系的相关研究结果表明,在任务驱动型眼动过程中,相较于背景,人眼注视点会更多地停留在与任务相关的图像目标中[8-10]。基于上述研究结果,利用人眼在观测标注目标过程中的注视点规律,自动确定目标物体边界框,能有效提高标注效率,降低标注成本[11-12]。DIMITRIOS P等提出的眼动图像标注算法[11]就是此类应用领域的一个经典算法[13]。该方法将目标标注问题建模为一个目标和背景的分类问题。首先提取眼动注视点和背景分别所在的超像素块的相关眼动特征和图像外观[14]、似物性特征[15]等,构建一个支持向量机(Support Vector Machine,SVM)超像素块分类模型,实现标注目标边界框的初定位;然后采用似GrabCut能量模型[14]进行目标边界框精定位。该算法只需使用较少的数据(7%)训练标注模型,标注一幅图片平均仅需2 s。

标定过程中采集的眼动数据中包含标定目标的位置先验线索,利用这些线索能有效提高后续标定精度。但是,首先眼动过程中存在的固有抖动和眨动,使眼动数据中容易引入噪声;另外,眼动图像目标标注这类任务驱动型眼动过程是一个自底向上和自顶而下相互交互的复杂认知过程[11,16]。研究表明,人眼更容易关注动物、人之类的活动目标,也容易停留在显著的非目标对象或背景对象上,因此目前提取和标注任务相关的眼动信息仍然是一个研究难点。目前DIMITRIOS P等提出的眼动图像标注算法利用所有注视点定位标注目标,停留在非目标上的注视点容易引入干扰因素,存在算法精度不高的问题。文献[10,17]采用热力图去除离群点算法提取和识别任务相关的注视点,但是该方法以每一个注视点为中心累加二维高斯函数,通过设置阈值将离群注视点滤除,未能有效地适应注视点通常以线状而非球状呈现这一空间特征,并且高斯函数计算量大、方差难以确定,因此存在运行效率低、阈值设置困难等问题。另外,这些算法主要应用在目标检测领域,文献[10]虽然提到目标标注问题,但是也是以现有图像目标检测结果为基础,辅助眼动数据减少漏标注,与经典的DIMITRIOS P眼动图像标注算法思路不一致。

国内已有针对驾驶过程中的注视序列[18-19]以及人机交互过程中的注视序列[20-21]的研究,但均不能适用于图片标注研究领域。在目标导向、任务驱动的图像标注过程中,人眼视觉由“预注意”和“注意”两个阶段组成[22-23],被称为人眼视觉的“搜索”和“识别”[16],前者的凝视点不在目标上,而后者的凝视点在目标上。准确提取眼动识别阶段的注视点是提高眼动图像标注定位精度的关键。鉴于此,本文拟从探索图像目标标注这一任务驱动下的眼动规律入手,设计注视点分类模型。首先研究图像标注过程中眼动注视点在时间、空间维度上的眼动规律,然后结合眼动规律,提出基于参数自适应的DBSCAN(Density-Based Spatial Clustering of Applications with Noise)[24]算法将人眼注视序列中注视点自动分类为视觉搜索和视觉识别两个类别,旨在将提取的眼动识别阶段注视点作为图像标注算法的输入,提高标注精度。

2 搜索和识别两阶段的眼动规律

为了探究隶属于视觉识别和视觉搜索阶段注视点的规律,本文选取2014 DIMITRIOS P数据集[11,25]当中的包含单目标的图片开展眼动规律实验研究。该数据集选取Pascal VOC2012数据集中的10类目标,共6 270幅图片,其中单目标图片共5 104幅图。这10类目标分别为猫/狗、自行车/摩托车、飞机/船、牛/马以及沙发/餐桌。5位受试者眼动标注过程中的眼动数据采用Eyelink 2 000眼动仪采集,采样频率为1 000 Hz。眼动数据格式用

针对标注目标

针对10类标注目标,从注视点分布占比率、注视持续时间、注视空间聚集度3个角度探索两个视觉阶段的眼动规律。

(1)两阶段注视点分布占比率对比

针对上述10类标注目标,分别计算5位受试者眼动注视点集合

从

(2)两阶段注视点持续时间对比

针对标注目标

从

图 4. 不同标注目标的搜索-识别阶段注视点的持续时间占比

Fig. 4. Proportion of the duration of fixations in the search-recognition of different targets

(3)两阶段注视点空间聚集度对比

针对视觉识别和视觉搜索两个阶段,分别按照

式中:

绘制不同类别目标物体的搜索、识别阶段归一化点密度,如

图 5. 不同标注目标的搜索-识别阶段注视点的归一化点密度

Fig. 5. Normalized point density of fixations in the visual search-recognition of different targets

综合上述实验结果,可分析得出如下眼动规律:

(1)在眼动图像标注这类任务驱动的眼动过程中,眼动注视点会明显落在标注目标上。因此以标注者的眼动注视点位置为线索,能较准确地初步定位标注目标位置。

(2)从眼动注视点的时间维度上看,视觉识别阶段的注视点总的持续时间呈现明显大于视觉搜索阶段的趋势。

(3)从眼动注视点的空间维度上看,视觉识别阶段注视点在目标内部聚集,视觉搜索阶段注视点在标注目标四周稀疏分布。

3 基于眼动规律的眼动注视点分类

实验结果表明:在眼动标注过程中,处于眼动搜索阶段和眼动识别阶段的注视点在空间聚集度和时间持续性两个方面存在明显的差别。因此本文提出基于眼动注视点空间和时间两个维度特征的眼动注视点分类方法。在

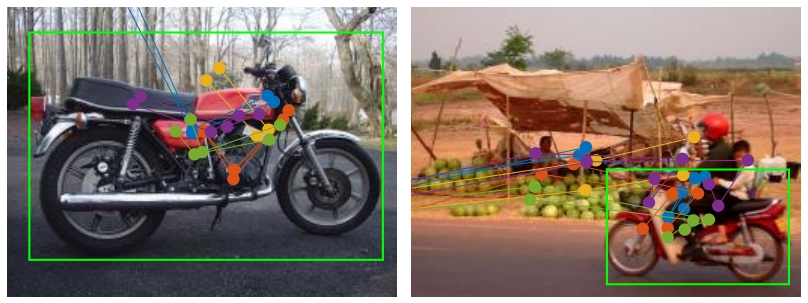

图 6. 视觉搜索-识别注视点划分流程图。(a)注视序列用红点标识,蓝线相连;(b)、(c)聚类簇由绿色和粉红色点标识;(d)视觉搜索阶段使用红点标识,视觉识别阶段使用黄点标识。

Fig. 6. Framework of visual search-recognition fixations classification.(a)Fixation sequence marked with red dots and linked by blue lines;(b),(c)Different clusters marked with green and pink dots individually;(d)Visual search phase and visual recognition phase marked with the red and yellow dots correspondingly.

表 1. 视觉搜索-识别注视点划分算法伪代码

Table 1. Visual search-recognition classification pseudocode

| ||||||||||||||||||||||||||||||||||||||||||||||||

(1)目标标注问题中聚类簇的邻域半径Eps与标注目标的尺寸有较明确的对应关系。观察发现,标注目标尺寸占标注图片总尺寸的比例主要分布在5%~50%左右,因此定义Eps参数取值公式如

式中:

(2)邻域密度阈值MinPts与停留在标注目标上的平均注视点数量有关。统计分析发现,数据集中标注目标上的注视点数目占注视点总数比例分布在12.7%~29.3%之间。基于此,定义MinPts参数取值公式如

其中:N表示当前标注图像I中的注视点总数目,

4 实验与分析

本文针对标注过程中的眼动序列,结合眼动规律提出算法将包含的眼动注视点分类到对应的搜索阶段和识别阶段。本节将首先围绕算法分类性能、算法执行效率两个方面开展对比分析,然后验证本文算法对提高眼动图像标注精度的有效性。

实验数据集:2014 DIMITRIOS P公共眼动数据集(10类目标,目标物体占整幅图片比小于30%,单目标图片共1 962幅),训练集和测试集比例为1∶9。

实验硬件环境:第4代Intel Core i5(3.3 GHz);8GB内存;256 GB SSD;Matlab R2018b;操作系统为Win10 专业版。

4.1 视觉搜索和识别注视点分类相关实验与分析

4.1.1 眼动注视点分类性能评估

本文提出将受试者眼动序列中的注视点分为视觉搜索和识别两个阶段,这个过程可看作一个二分类问题。因此,采用机器学习常用的查准率P、查全率R和

计算热图(Heatmap)算法[17]、基于固定参数的本文算法(DBSCAN)和基于自适应参数的本文算法(Adaptive-DBSCAN)3种方法的查准率P、查全率R和

表 2. 眼动注视点分类结果对比

Table 2. Comparison of the classification results of eye movement fixation points

|

从

图 8. 视觉搜索-识别注视序列划分算法的结果。(a)常规情况;(b)含有显著物体的情况。

Fig. 8. Results of visual search-recognition classification.(a)Normal situation;(b)Situation containing visual attention objects.

4.1.2 算法执行效率对比

从

表 3. 算法的整体运行速度

Table 3. Overall running speed of the algorithm

|

4.2 眼动图像标注精度对比

利用眼动数据标注图像的方法的研究目前还处于初级阶段,DIMITRIOS P等[11]提出的眼动图像标注算法是一个非常经典的算法。因此,为了验证本文算法对提高眼动图像标注精度的可行性和有效性,本实验将以该算法为基础对比以下3种方法的图像标注精度:(1)复现的DIMITRIOS P图像标注算法(DIMITRIOS P);(2)基于热力图过滤离群点的图像标注算法(Heatmap-Annotation);(3)基于本文方法提取眼动识别阶段注视点的图像标注方法(Ours)。为了比较结果的客观性,这3种方法仅在眼动序列输入的选择上采取不同策略,后续的图像标注过程均保持一致。DIMITRIOS P算法未开源,因此复现该算法的初分割部分作为本文标注算法的基线。其中似物性特征使用BING算法[26]构建。

精度评估指标CorLoc[11,27]的计算公式如

式中:n为预测的物体框总数,m为标注结果与目标真值框重叠率大于0.5目标总数。

针对数据集中的10种标注目标,上述3种方法标注结果的CorLoc精度指标计算结果如

表 4. 眼动图像标注精度指标CorLoc结果

Table 4. Eye movement image annotation accuracy index CorLoc results

|

图 9. 眼动图像标注算法的输出结果对比图。(a)~(c)飞机标注图;(d)~(f)自行车标注图;(g)沙发标注图。

Fig. 9. Comparison of the output results of the eye movement image annotation.(a)~(c)Aeroplane;(d)~(f)Bicycle;(g)Sofa.

5 结论

眼动图像标注算法以标注序列中的所有人眼注视点为输入实现目标框标注,然而注视点并非都是等权重的,未落在目标物体上的注视点会为标注算法引入目标定位干扰因素,降低算法性能。

鉴于此,本文结合目标标注任务中的眼动特点,提出将注视点分类为视觉搜索和视觉识别两大类,首先探究了两个阶段注视点在时间维度和空间维度上的眼动规律,然后结合眼动规律提出基于参数自适应的DBSCAN算法的注视点分类方法。实验结果表明,该方法能有效提取和标注目标相关的视觉识别注视点,提高目标标注精度,同时算法运行稳定,执行效率高。

目前我们仅考虑利用眼动规律实现两个阶段注视点的分类,对于标注目标大、停留其中的注视点空间聚集度不明显的注视点,分类还不够准确。另外在多目标聚集的情况下,多标注目标注视点的提取也比较困难。针对上述问题,在本文现有Adaptive-DBSCAN算法聚类特征仅为注视点眼动特征的基础上,如何融合注视点所在超像素块图像特征(如纹理、颜色、边缘等),提高大目标、多目标聚集时的图像目标标注精度将是下一步的研究重点。

[1] 兰旭婷, 郭中华, 李昌昊. 基于注意力与特征融合的光学遥感图像飞机目标检测[J]. 液晶与显示, 2021, 36(11): 1506-1515.

[2] 孔雅洁, 张叶. 引入高斯掩码自注意力模块的YOLOv3目标检测方法[J]. 液晶与显示, 2022, 37(4): 539-548.

[3] 李玲, 宋莹玮, 杨秀华, 等. 应用图学习算法的跨媒体相关模型图像语义标注[J]. 光学 精密工程, 2016, 24(1): 229-235.

[6] SUH, DENGJ, FEI-FEIL. Crowdsourcing annotations for visual object detection [R]. Toronto: AAAI Workshop, 2012: 40-46.

[7] 樊镕. 基于眼动先验的显著性检测 [D]. 天津: 天津大学, 2015.

FANR. Visual saliency detection based on eye tracking prior knowledge [D]. Tianjin: Tianjin University, 2015. (in Chinese)

[9] WOLFE J M. Visual search[J]. Current Biology, 2010, 20(8): R346-R349.

[12] PAPADOPOULOSD P. Efficient human annotation schemes for training object class detectors [D]. Edinburgh: University of Edinburgh, 2018.

[18] 孙文财, 杨志发, 李世武, 等. 面向驾驶员注视区域划分的DBSCAN-MMC方法[J]. 浙江大学学报(工学版), 2015, 49(8): 1455-1461.

[19] 谭婷, 王羽尘, 宗晨宏, 等. 公路隧道群不同区段驾驶人视觉特征差异性研究[J]. 物流科技, 2020, 43(10): 68-72,82.

[20] 贺辉, 黄君浩. 基于眼动跟踪的人机交互应用[J]. 山东大学学报(工学版), 2021, 51(2): 1-8.

HE H, HUANG J H. Eye tracking in human-computer interaction control[J]. Journal of Shandong University (Engineering Science), 2021, 51(2): 1-8.

[21] 陆柳杏, 石宇, 李济远, 等. 人机交互研究中的眼动追踪:主题、作用、动向[J]. 图书情报工作, 2020, 64(1): 113-119.

LU L X, SHI Y, LI J Y, et al. Eye-tracking in human-computer interaction: status quo, roles, and trends[J]. Library and Information Service, 2020, 64(1): 113-119.

[24] ESTERM, KRIEGELH P, SANDERJ, et al. A density-based algorithm for discovering clusters in large spatial databases with noise [C]//Proceedings of the 2nd International Conference on Knowledge Discovery and Data Mining. Portland: AAAI Press, 1996: 226-231.

Article Outline

漆正溢, 方红萍, 万中华, 张瀚源, 伍世虔. 基于人眼视觉规律的注视点分类及其在图像标注中的应用[J]. 液晶与显示, 2023, 38(4): 515. Zheng-yi QI, Hong-ping FANG, Zhong-hua WAN, Han-yuan ZHANG, Shi-qian WU. Visual-pattern-based fixation classification and its application in image annotation[J]. Chinese Journal of Liquid Crystals and Displays, 2023, 38(4): 515.