高鲁棒性Camera-IMU外参在线标定算法

1 引言

在实时定位与建图(Simultaneous localization and mapping,SLAM)技术中[1],相机和惯性测量单元(Inertial measurement unit,IMU)组合是常见的传感器组合,也是当下机器人导航[2]、视觉自动驾驶[3]和测量测绘等领域的主流传感器组合。其中,相机在低速运动时能够稳定成像,且短时间内成像变化不大,因此特征匹配时表现较好;而在高速运动时,相机容易成像模糊,且短时间内图像差异较大,这会导致重叠区域较少进而出现特征误匹配的问题。而IMU输出的是线加速度和角速度,在高速运动时能够输出可靠的测量结果,但在低速运动时测量结果反而不可靠。因此,在低速和高速运动相结合的作业场景下,基于相机和IMU的传感器组合,其在数据的可靠性方面具有互补性。基于相机和IMU融合的定位算法[4-6]已成为近年来研究的热点,特别是将Camera-IMU与实时动态测量(Real-time kinematic,RTK)相融合逐渐成为测绘领域的重点研究方向。然而,由于缺乏视觉尺度的直接观测,单目相机处理信息的算法挑战明显多于双目相机[7],并且现在单目视觉系统[8]的性能严重依赖于初值(速度、姿态、视觉尺度)的精度以及相机和IMU的标定。提高输出定位结果的精度是所有融合定位算法的目标,在此之前,需尽可能地准确标定各个传感器之间的转换关系,即估计相机和IMU之间的旋转和平移变换。在设备长期的使用与晃动过程中,机械构型发生变化,每隔一段时间进行人工测量IMU和相机之间的外参是很难实现的,因此将重点研究如何在算法中实现Camera-IMU传感器组合的在线标定和初始化,并改进标定算法,提高标定精度与鲁棒性。

Camera-IMU的外参标定方法主要有离线标定和在线标定[9],其中离线标定方法需要手持标定板进行一系列操作,费时费力,而在线标定在系统运行过程中即可完成标定,操作简单、实时性高。Dong-Si[10]运用几何方法直接从传感器测量中计算系统的可观测量(姿态、速度、Camera-IMU外参),但没有考虑传感器的噪声和IMU零偏对系统产生的影响。为了以最小的运算量实现快速外参标定,Li[11]提出一种快速的基于扩展卡尔曼滤波(Extended kalman filter,EKF)的视觉惯性里程计(Visual-inertial odometry,VIO)融合定位SLAM技术,在整个SLAM系统中使用扩展卡尔曼滤波实现对Camera-IMU外参的快速估计,因为算法的收敛性依赖于初始化的精度,所以外参标定效果较差。随后,外参离线标定工具Kalibr被提出并应用于Camera-IMU的外参标定,其可以解决多摄像机内外参标定[12]、视觉惯性标定等问题、卷帘相机内参标定、IMU内参标定等问题,该工具可以得到相对可靠的标定结果,但标定过程较为复杂。Yang[13]在Dong-Si的基础上利用线性估计方程优化方法求解外参和初始化参数,但该算法没有考虑IMU零偏,导致算法的精度较低。香港科技大学沈劭劼团队[14]将经典的机器人手眼标定方法应用到外参在线标定中,先对Camera-IMU之间相对旋转量进行标定,在初始化过程中假设IMU的零偏不变,构造线性方程组进行外参线性初始化,标定和初始化完成后进行视觉惯性联合的状态估计,并且把标定量也作为估计的状态放在联合优化中[15-16]。Huang等[17]借鉴了沈劭劼团队的方法,在视觉惯性SLAM的基础上加上相机和IMU的相对位姿进行在线标定,此方法在系统运行之初就能快速得到足够高精度的标定结果,因此没有将外参纳入状态估计的优化变量中,大大节省了计算量。

为了实现影像RTK中Camera-IMU的初始化和在线外参标定,本文提出了一种高精度Camera-IMU在线外参标定算法。首先将Camera-IMU旋转外参线性初始化,假设已经追踪到足够多的特征,使用随机采样一致性算法对异常值进行判别与剔除,提高特征匹配的准确性,通过两帧图像的对极约束和经典的八点算法[18]求得本质矩阵

2 基本原理

2.1 符号说明

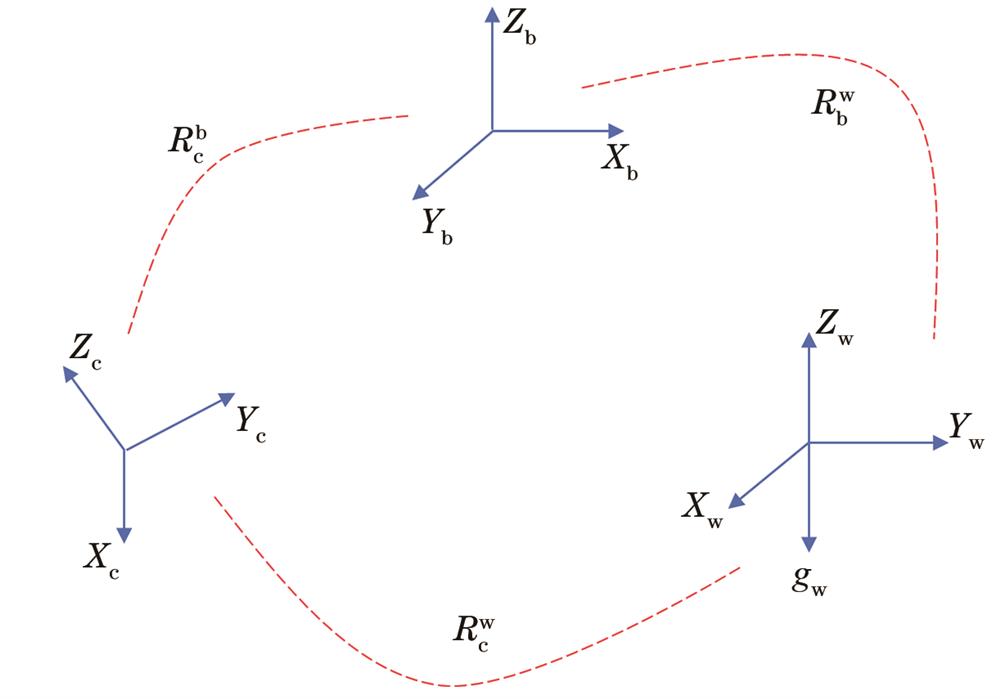

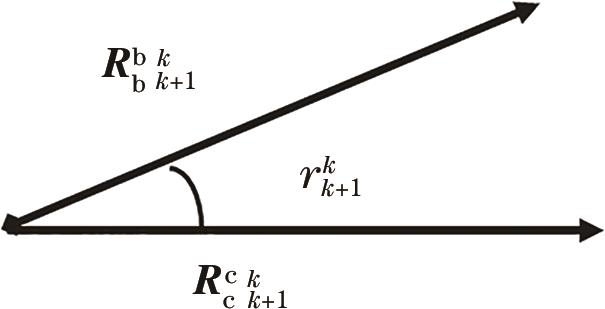

坐标系转换如

2.2 IMU模型和预积分

IMU由加速度计和陀螺仪组成,其以固定的频率在IMU坐标系下采集物体在三维空间的三轴加速度和三轴角速度,这就是最常见的六轴IMU。加速度计和陀螺仪的输出不仅受高斯噪声

预积分最早在文献[20]中被提出,主要是为了解决重复积分问题,而后Forster等[21]将其引进SLAM系统,通过对相机两个关键帧进行IMU预积分,得到两帧的状态增量,这样就避免了在优化过程中姿态发生改变时需要大量的重复积分,从而减小运算量。给定k时刻和k+1时刻两幅图像的IMU测量值,IMU在地球惯性坐标系下的位置和速度传播模型可表示为

式中:

式中:

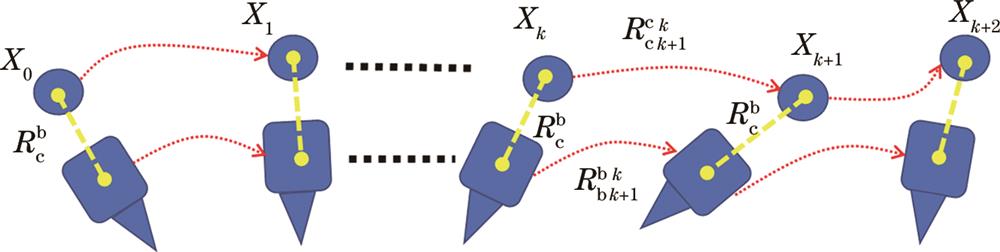

2.3 旋转外参标定

相机和IMU之间的旋转变换为

式中:相机从k到k+1时刻的旋转矩阵

式中:

式中:

式中:

上述公式表示两帧图像之间的旋转,大量图像之间的旋转可以用超定方程

2.4 滑动窗口迭代优化

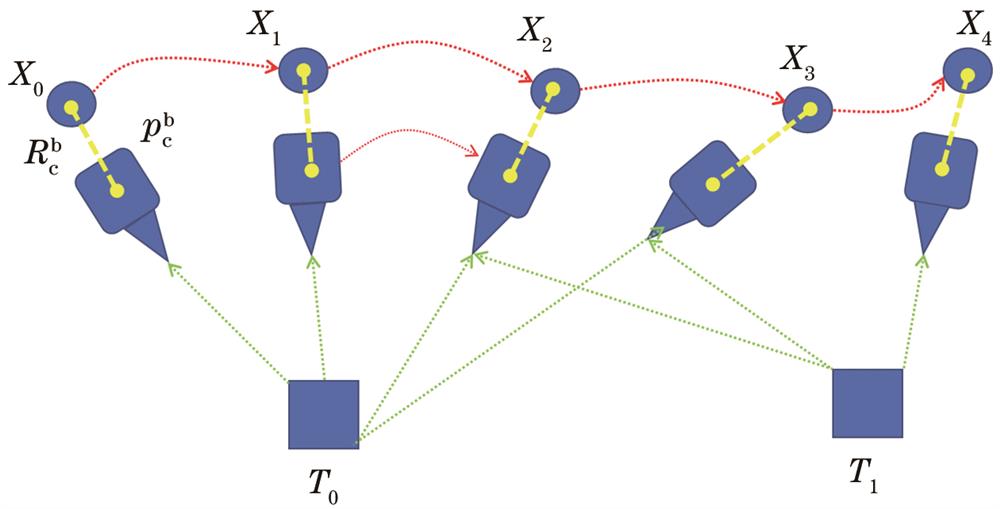

当Camera-IMU之间的旋转外参固定以后,可以估计速度、姿态、视觉尺度、外参平移量。在同时定位与地图构建中,随着时间的增加,关键帧和路标点会不断增多,优化变量也会快速增多,后端优化的效率会逐渐下降。为解决此问题,使用一个紧耦合的滑动窗口,保留距离当前时刻最近的几个关键帧,对之前的部分关键帧进行边缘化处理,使其维持在一定数量内,并且只对窗口内相关变量进行优化,减小了计算量,在计算复杂度不变的情况下融合单目相机和IMU测量值,滑动窗口模型如

当出现新的观测约束时,滑动窗口将会丢弃窗口内最旧的状态,将新的状态纳入窗口。窗口内所有状态量定义为

式中:

式中:

利用

3 外参在线标定实现

3.1 算法框架

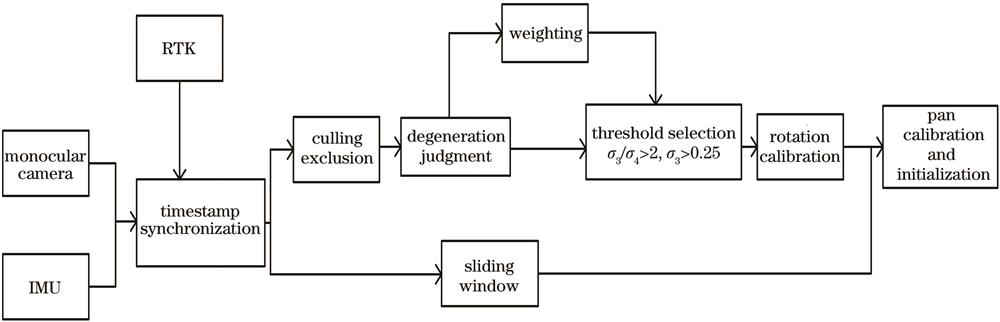

Camera-IMU外参标定和初始化的算法框架如

图 3. Camera-IMU外参标定框架流程图

Fig. 3. Flow chart of Camera-IMU external parameter calibration framework

3.2 剔除外点的标定模型

所提的标定问题可以用相对几何位姿变换来解决,相对变换法是使IMU和相机充分激励得到足够数据,利用不同时刻在同一参照系下的几何位姿差异来求解的一种方法。相机和IMU传感器由机械套件刚性连接,其相对位置不随时间变化而变化,如

相机由k时刻到k+1时刻的旋转变换为

式中:N为图片帧数,由滑动窗口的大小决定;由于相机八点算法得到的旋转增量包含退化运动(如直线运动)下的异常值,为了更好地处理异常值,加入权重

式中:

式中:

先根据

此外,当传感器设备在一定时间内没有旋转运动,只有直线运动时,两个里程计旋转矩阵增量都接近于单位矩阵

3.3 标定模型求解判定条件改进

在旋转运动足够多时,运动得到充分激励,这时对应着唯一解,此时零空间的秩为1,

式中:

则

在奇异值分解中

传统方法[23]判定收敛的终止条件是使用

然而在实验中发现,当设备在某一轴上出现匀速运动时,会产生退化现象,当使用判断条件

4 实验分析

4.1 实验平台与传感器数据预处理

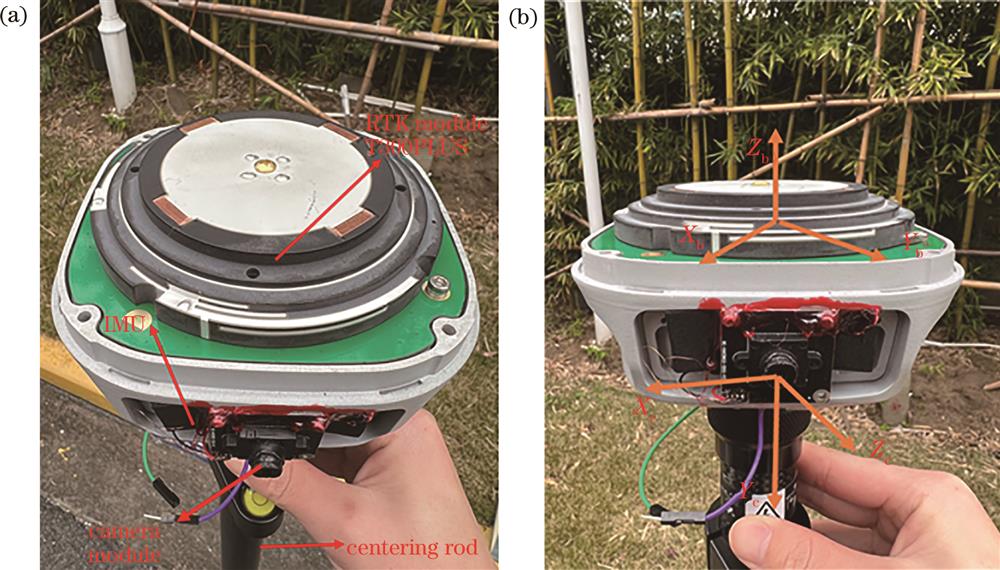

实验平台由司南导航T300PLUS RTK接收机、CMOS图像传感器PS5268和博世SMI130 IMU构成,如

图 6. 影像RTK实验平台。(a)实验平台结构;(b)坐标系示意图

Fig. 6. Image RTK experimental platform. (a) Experimental platform structure; (b) schematic diagram of the coordinate system

传感器预处理步骤如下:

a)充分晃动设备,激励试验平台的运动状态;

b)分批多次采集时长大于1 min的数据,以确保在旋转外参求解过程中有充足的满足条件的IMU数据和相机数据;

c)在获取相机和IMU两个传感器数据以后,将图像的开始时间和IMU时间对齐,丢弃没有IMU数据的图像,然后通过全球导航卫星系统(GNSS)时间使两个传感器数据对齐,制作具有同一时间序列的相机和IMU位姿数据包。

4.2 改进阈值与加权方式对比实验

在求解

表 1. 不同阈值加权方式旋转外参标定误差

Table 1. Rotation external parameter calibration error in different threshold weighting methods

| |||||||||||||||||||||||||||||||||||||||||||||

通过不同阈值和加权方式的组合,获得旋转外参的偏航角、俯仰角、滚转角的结果与真实目标结果的误差,误差均值为旋转外参3个误差量的平均值。由

4.3 外参收敛过程分析

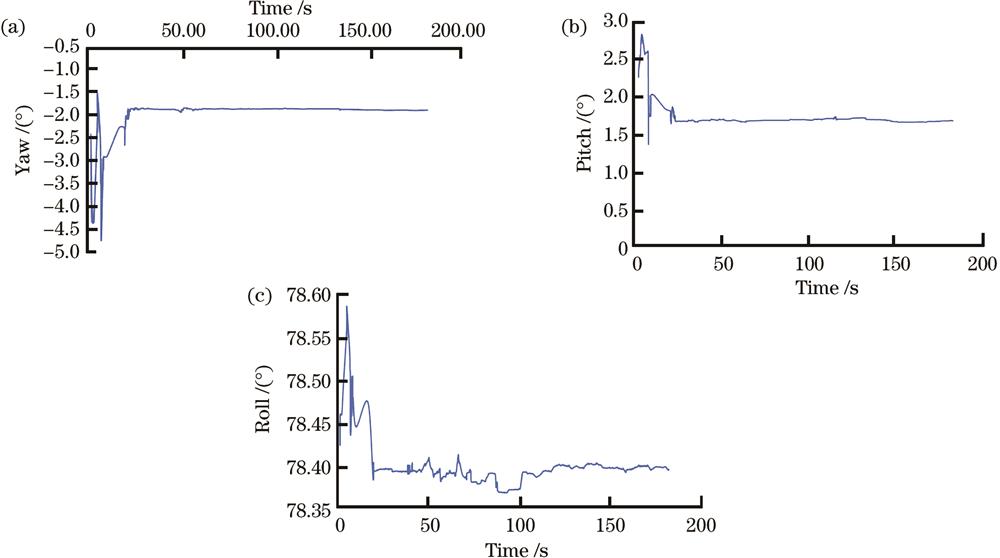

通过带有RTK的相机与IMU实验平台采集数据,通过4.2节的实验结论将阈值确定为2,并以

图 7. 旋转外参收敛过程。(a)偏航角;(b)俯仰角;(c)翻滚角

Fig. 7. Rotation external parameter convergence process. (a) Yaw; (b) pitch; (c) roll

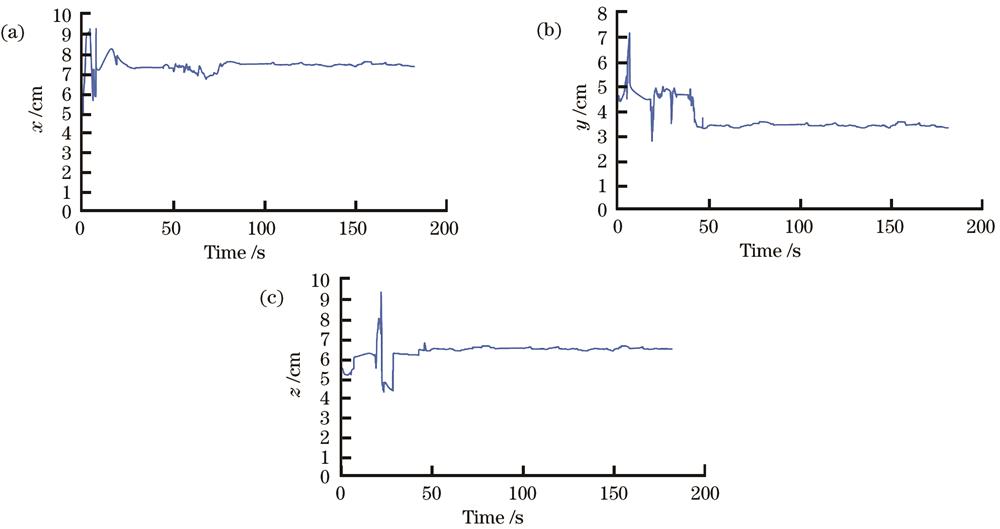

得到旋转外参标定结果以后,将该标定结果作为非线性优化窗口的初值,在紧耦合滑动窗口中进行线性初始化,合并大量IMU和相机测量值,并通过IMU的预积分来完成平移量的标定,平移外参收敛过程如

图 8. 平移外参收敛过程。(a)x轴;(b)y轴;(c)z轴

Fig. 8. Translation external parameter convergence process. (a) x-axis; (b) y-axis; (c) z-axis

为了计算改进算法的精度,通过手动测量和Kalibr多次测量得到相机与IMU的外参真值,由于该值的误差非常小,将该值近似为真值,具体结果如

表 2. 外参测量值与收敛时间

Table 2. External parameter measurement and convergence time

| |||||||||||||||||||||||||||||||||||||||||

由

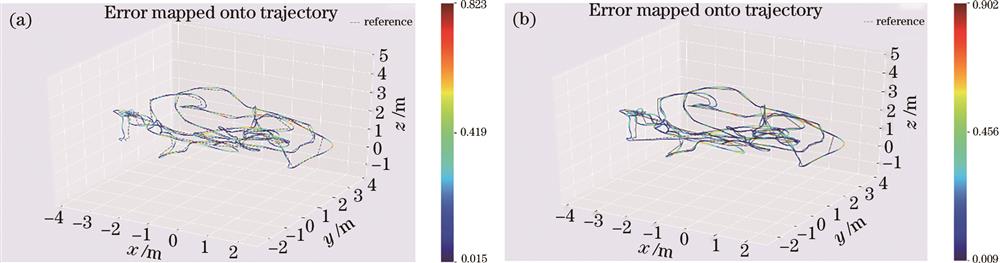

4.4 轨迹可视化对比验证

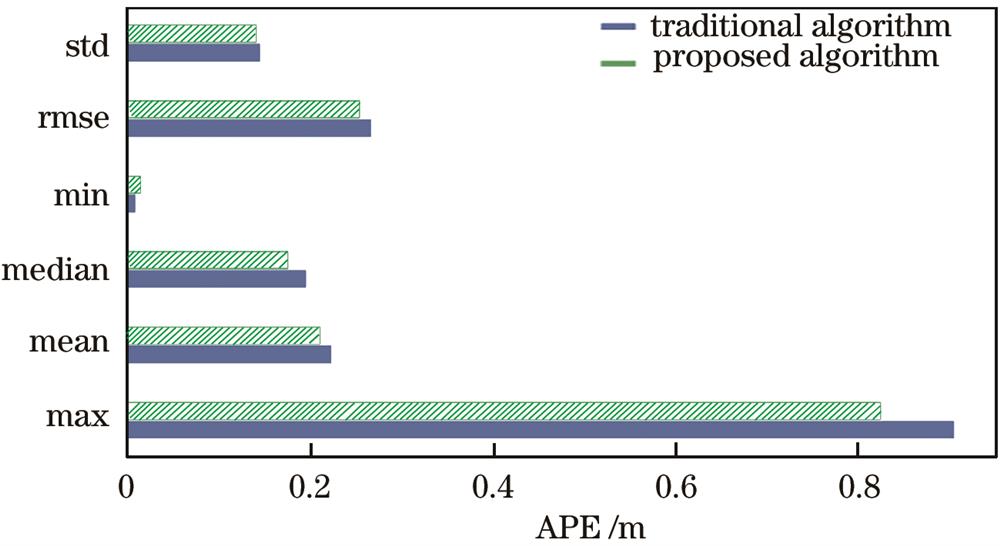

在3.2节已通过实验对改进的在线标定算法的精度和收敛时间进行评估,所提算法除了估计IMU和相机之间的外参,还融合定位构建运动轨迹。为了比较所提算法的准确率,将所提算法与传统算法在同一数据集下进行轨迹可视化对比,通过对比轨迹的定位轨迹精度、绝对位姿误差(APE)等方面来验证改进算法的优越性。所提算法与传统算法分别在数据集中与真实轨迹的重合度如

图 9. 轨迹可视化。(a)所提算法轨迹;(b)传统算法轨迹

Fig. 9. Track visualization. (a) Trajectory of proposed algorithm; (b) trajectory of traditional algorithm

由

由

5 结论

提出一种改进的Camera-IMU外参的标定方法,通过改变判断最小二乘解的最优解条件,利用新的加权方式,实现对旋转外参和平移外参的在线标定,在传统算法基础上改进求解旋转外参过程,提高标定结果的精度。其中,旋转外参的误差为1.7°,平移外参的误差为0.8 cm,所提算法旋转外参和平移外参的标定精度较传统算法分别提高15%和35%。在同一数据集下运行传统算法和所提算法,验证了所提算法在外参在线标定与系统融合定位精度方面的性能。对其轨迹和相对位姿误差进行比较,证明运行轨迹基本与真实轨迹重合,而且所提算法的APE表现较好,具有较高的精度和一致性,这表明所提算法在Camera-IMU外参在线标定过程中具有较好的可靠性。

[1] 徐陈, 周怡君, 罗晨. 动态场景下基于光流和实例分割的视觉SLAM方法[J]. 光学学报, 2022, 42(14): 1415002.

[2] Zhang C, Yang Z, Xu H, et al. RRVPE: a robust and real-time visual-inertial-GNSS pose estimator for aerial robot navigation[J]. Wuhan University Journal of Natural Sciences, 2023, 28(1): 20-28.

[3] BaheriA, KolmanovskyI, GirardA, et al. Vision-based autonomous driving: a model learning approach[C]∥2020 American Control Conference (ACC), July 1-3, 2020, Denver, CO, USA. New York: IEEE Press, 2020: 2520-2525.

[4] 王鑫, 李伟, 梁炜, 等. 单目相机-IMU-机械臂的空间联合标定方法[J]. 仪器仪表学报, 2021, 42(6): 221-231.

Wang X, Li W, Liang W, et al. A space joint calibration method of monocular camera-IMU-manipulator[J]. Chinese Journal of Scientific Instrument, 2021, 42(6): 221-231.

[5] 余哲琳. 基于视觉惯导融合的智能车辆定位技术研究[D]. 成都: 电子科技大学, 2022.

YuZ L. Intelligent vehicle localization technology research based on vision and inertial fusion[D]. Chengdu: University of Electronic Science and Technology of China, 2022.

[6] MishraS, PandeyG, SaripalliS. Target-free extrinsic calibration of a 3D-lidar and an IMU[C]∥2021 IEEE International Conference on Multisensor Fusion and Integration for Intelligent Systems (MFI), September 23-25, 2021, Karlsruhe, Germany. New York: IEEE Press, 2021.

[7] 吕钧澔, 娄群, 校金友, 等. 大倾角靶标的双目相机高精度标定方法[J]. 光学学报, 2022, 42(23): 2312002.

[8] OgataK, TanakaH, MatsumotoY. A robust position and posture measurement system using visual markers and an inertia measurement unit[C]∥2019 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), November 3-8, 2019, Macau, China. New York: IEEE Press, 2020: 7497-7502.

[9] 黄文文, 彭小红, 李丽圆, 等. 相机标定方法及进展研究综述[J]. 激光与光电子学进展, 2023, 60(16): 1-17.

Wen W W, Peng X H, Li L Y, et al. A review of camera calibration methods and research progress[J]. Laser & Optoelectronics Progress, 2023, 60(16): 1-17.

[10] Dong-SiT C, MourikisA I. Estimator initialization in vision-aided inertial navigation with unknown camera-IMU calibration[C]∥2012 IEEE/RSJ International Conference on Intelligent Robots and Systems, October 7-12, 2012, Vilamoura-Algarve, Portugal. New York: IEEE Press, 2012: 1064-1071.

[11] Li M Y, Mourikis A I. High-precision, consistent EKF-based visual-inertial odometry[J]. The International Journal of Robotics Research, 2013, 32(6): 690-711.

[12] 杨昭辉, 朱华炳, 殷玉龙, 等. 基于编码立体靶标的高精度双目相机标定[J]. 中国激光, 2023, 50(6): 0604002.

[13] Yang Z F, Shen S J. Monocular visual-inertial state estimation with online initialization and camera-IMU extrinsic calibration[J]. IEEE Transactions on Automation Science and Engineering, 2017, 14(1): 39-51.

[14] Qin T, Li P L, Shen S J. VINS-mono: a robust and versatile monocular visual-inertial state estimator[J]. IEEE Transactions on Robotics, 2018, 34(4): 1004-1020.

[15] 曹力科, 肖晓晖. 基于卷帘快门RGB-D相机的视觉惯性SLAM方法[J]. 机器人, 2021, 43(2): 193-202.

Cao L K, Xiao X H. A visual-inertial SLAM method based on rolling shutter RGB-D cameras[J]. Robot, 2021, 43(2): 193-202.

[16] 潘林豪, 田福庆, 应文健, 等. 单目相机-IMU外参自动标定与在线估计的视觉-惯导SLAM[J]. 仪器仪表学报, 2019, 40(6): 56-67.

Pan L H, Tian F Q, Ying W J, et al. VI-SLAM algorithm with camera-IMU extrinsic automatic calibration and online estimation[J]. Chinese Journal of Scientific Instrument, 2019, 40(6): 56-67.

[17] HuangW B, LiuH. Online initialization and automatic camera-IMU extrinsic calibration for monocular visual-inertial SLAM[C]∥2018 IEEE International Conference on Robotics and Automation (ICRA), May 21-25, 2018, Brisbane, QLD, Australia. New York: IEEE Press, 2018: 5182-5189.

[18] Hartley R I. In defense of the eight-point algorithm[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1997, 19(6): 580-593.

[19] 黄秀珍, 伍一帆, 李凯涛. 基于李群的无迹卡尔曼滤波视觉SLAM算法[J]. 无线电通信技术, 2022, 48(2): 342-346.

Huang X Z, Wu Y F, Li K T. An unscented Kalman filter visual SLAM algorithm based on lie group[J]. Radio Communications Technology, 2022, 48(2): 342-346.

[20] Lupton T, Sukkarieh S. Visual-inertial-aided navigation for high-dynamic motion in built environments without initial conditions[J]. IEEE Transactions on Robotics, 2012, 28(1): 61-76.

[21] Forster C, Carlone L, Dellaert F, et al. On-manifold preintegration for real-time visual: inertial odometry[J]. IEEE Transactions on Robotics, 2017, 33(1): 1-21.

[22] Lin Y, Gao F, Qin T, et al. Autonomous aerial navigation using monocular visual-inertial fusion[J]. Journal of Field Robotics, 2018, 35(1): 23-51.

[23] Wang K, Cao C, Ma S, et al. An optimization-based multi-sensor fusion approach towards global drift-free motion estimation[J]. IEEE Sensors Journal, 2021, 21(10): 12228-12235.

[24] 林伟文, 甘海云, 朱冰冰, 等. 视觉同步定位与建图中特征点匹配算法优化[J]. 汽车工程师, 2021(12): 13-17.

Lin W W, Gan H Y, Zhu B B, et al. Visual simultaneous localization and mapping feature point matching algorithm optimization[J]. Automotive Engineer, 2021(12): 13-17.

Article Outline

茆子念, 周志峰, 沈亦纯, 王立端. 高鲁棒性Camera-IMU外参在线标定算法[J]. 激光与光电子学进展, 2024, 61(4): 0411005. Zinian Mao, Zhifeng Zhou, Yichun Shen, Liduan Wang. Camera-IMU State Estimation and External Parameter Online Calibration Algorithm[J]. Laser & Optoelectronics Progress, 2024, 61(4): 0411005.