基于改进RoI Transformer的遥感图像多尺度旋转目标检测

1 引言

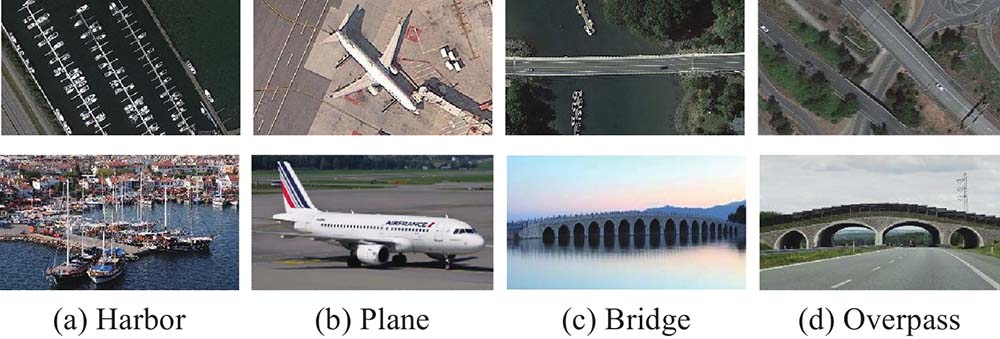

基于深度学习的目标检测技术在遥感领域已广泛应用[1]。不同于前视图像中的目标,俯视的遥感图像中的目标具有方向任意的特点(如

图 1. 遥感图像(第1行)和自然图像(第2行)对比图

Fig. 1. Comparison between remote sensing images (the first row) and natural images (the second row)

近年来,在基于深度学习的通用目标检测基础上发展出了多种旋转目标检测方法。通用目标检测主要回归目标区域的

基于RoI Transformer的旋转目标检测常用于双阶段(two-stage)目标检测,其包含生成目标候选区域和目标检测分类两个步骤。最近有学者提出了一些单阶段(one-stage)旋转目标检测方法,例如R3Det(refined rotation RetinaNet)[11],一种基于RetinaNet的端到端精细化旋转目标检测器,它采用从粗到精的渐进回归形式,首先使用水平anchor以达到更高的召回率,然后在后续精细化阶段使用精细的旋转anchor以获得更精确的定位。SASM (shape-adaptive selection and measurement) reppoints[12]方法提出样本自适应选择和分配策略,根据目标的形状信息和特征分布动态选择样本。Oriented reppoints[13]方法提出一种高效的质量评估和样本分类方法,还引入了一种空间约束来惩罚离群点,以实现鲁棒的自适应学习。其他典型的单阶段方法还包括SSD(single shot multibox detector)、YOLO(you only look once)及其改进方法[14]等。在单阶段目标检测中,一种基于高斯分布的回归损失被提出,用来解决目标表示的角度周期性问题,提高了旋转目标的检测精度,其核心步骤是将旋转边界框转换为二维高斯分布,采用的损失包括GWD(Gaussian Wasserstein distance)[9]、KLD(Kullback -Leibler divergence) [15]和KFIoU(Kalman filtering intersection over union)[16]等。单阶段方法一般可以获得比双阶段方法更高的检测效率,但其检测精度也会受到一定的损失[17]。

针对RoI Transformer对多尺度遥感图像旋转目标检测精度不足的问题,本文提出了HRD-ROI Transformer (HRNet + KLD ROI Transformer)方法。首先,采用原始的RoI Transformer检测框架获取RRoI,用于鲁棒的几何特征提取;其次,使用HRNet[18]作为骨干网络,提升模型对多尺度目标检测的适应能力;最后,借鉴单阶段目标检测的损失函数设计思路,以KLD损失代替RoI Transformer检测框架中的Smooth L1损失,解决旋转目标表示带来的角度周期性问题,进一步提高ROI Transformer框架对旋转目标检测能力。

1 HRD-ROI Transformer

HRD-ROI Transformer使用RoI Transformer作为基本框架。其采用HRNet作为骨干网络,将高分辨率卷积和低分辨率卷积流并行连接,可在保持高分辨率特征提取的前提下提升模型对多尺度目标检测的适应能力。KLD损失用来代替Smooth L1损失,解决度目标表示周期性带来的角度边界不连续性和类正方形问题。

1.1 检测网络整体架构

HRD-ROI Transformer的整体架构如

特征提取模块 采用带有特征金字塔的HRNet提取多层高分辨率特征(见1.2节)。

RPN模块 RPN模块将任意大小的特征图作为输入,生成一系列粗略的HRoIs。

RoI Transformer模块 RoI Transformer模块用于从HRoIs的特征图中生成RRoIs。首先,通过RoI Pooling或RoI Align对不同大小的HRoIs进行RoI提取,得到固定大小(默认为7×7)的RoI特征,然后将每个HRoI特征输入到全连接层中,并对其进行解码,得到相应的粗略RRoIs。

基于KLD损失的RCNN模块 类似于RoI Transformer模块,通过旋转RoI Pooling、旋转RoI warping或旋转RoI Align将不同尺寸的RRoIs进行旋转,RoI提取得到固定尺寸的RoI特征,再输入到全连接层进行分类和更加精细的边界框回归,其中以KLD损失调整边界框回归的结果,最终输出结果。

1.2 高分辨率网络

为了提升检测网络对不同尺度目标的适应性,本文采用高分辨率网络HRNet代替ResNet 作为骨干网络。HRNet的基本结构如

该模型的主要特点是整个过程中特征图始终保持高分辨率,通过在高分辨率特征图主网络中逐渐并行加入低分辨率特征图子网络,不断进行不同网络分支之间的信息交互,同时保持强语义信息和精准位置信息。在RoI Transformer网络的基本结构中,FPN(feature pyramid networks)作为特征提取中重要的一个环节,是将低分辨率强语义的深层特征和高分辨率弱语义的浅层特征通过一种自上而下的方式进行特征融合,使得不同层次的特征增强[19],而HRNet并非是FPN的扩展,它不仅有逐层的特征融合,还有子网络之间多次重复地交换信息,可以持续保持高分辨率的特征。

1.3 基于KLD的参数联合优化

尽管RoI Transformer方法在旋转目标检测中具有良好的效率和精度,但由于其旋转目标表示方式带来的角度周期性,会存在角度边界不连续性(

1.3.1 旋转目标表示的角度周期性

对于类正方形的目标(如

1.3.2 KLD损失

为解决ROI Transformer原有的目标表示方式存在角度周期性问题,本文在RoI Transformer框架中引入KLD损失。首先,将目标表示的旋转框

式中:

属性1:

属性2:

属性3:

根据属性1,旋转目标的OpenCV表示方法造成的长短边的交换问题得以避免。根据属性2和3,旋转目标的长边定义法造成的类正方形问题也可以得到解决。综上,角度周期性因高斯分布的三角函数表示方式得以避免,表现出边界连续性。

预测框和真值对应的高斯分布

显然,

最后,为了保证评估测度和回归损失之间的一致性,采用非线性变换将

式中:

上述分析表明,基于KLD的损失可以保证旋转框参数

2 实验和讨论

2.1 数据集

本文使用带有旋转目标标签的DOTA v1.0[22]和DIOR-R[23]数据集进行方法的测试和比较。DOTAv1.0 数据集的图像大小从800×800像素到20 000×20 000像素不等,包含各类具有各种方向、尺度和外观的目标,是迄今为止最具挑战性的旋转目标检测数据集,共包含2806张图片,将188282个目标实例分为飞机(plane, PL)、船舶(ship)和储罐(storage tank, ST)等15类,其中训练集、验证集和测试集的比例分别为1/2、1/6和1/3,更多有关各个类别的统计数据可以参考文献[22]。DIOR-R数据集是DIOR[24]数据集的扩展,与DIOR数据集共享相同的图像,主要用于旋转目标检测。该数据集中有 23463 张图像和192518个实例,涵盖各类典型场景和 20 个常见目标类。DIOR-R中的目标类别包括飞机(airplane, APL)、机场(airport, APO)、棒球场(baseball field, BF)和篮球场(basketball court, BC)等。

2.2 评估标准

本文的目标检测结果主要采用精度 (precision, P)、召回率(recall, R)、平均精度均值 (mAP)、检测速度作为评价标准。精度及召回率公式如下:

式中:

2.3 实现细节

实验基于i9-10920X 处理器,使用4个NVIDIA GeForce RTX-2080Ti GPU,内存为256 GB,利用mmrotate平台[25],以ImageNet数据集预训练好的模型进行骨干网络参数初始化。采用随机梯度下降算法(stochastic gradient descent,SGD)对模型进行训练,momentum为0.9,权重衰减为0.0001,初始学习率为0.005,共训练12 epochs,在第8和11个epoch时学习率衰减为前一阶段的1/10[26]。

对于DOTAv1.0数据集,本文将所有训练集和验证集的原始图像以824的步长裁剪出1 024×1024像素大小的图像块(其中为避免目标在切割图像时被分割,保留图像重叠度为200)。对于DIOR-R数据集,图像大小保持800 × 800像素的原始大小。

训练集的图像块通过一组图像归一化、随机翻转、随机裁剪等数据增强预处理方式之后,输入到模型中用于训练。在DOTAv1.0数据集的实验中,使用训练集对模型进行训练,使用验证集对模型进行评价。对于DIOR-R数据集,则使用训练验证集进行训练,使用测试集对模型进行评价。

2.4 实验结果分析

表 1. 不同方法在DOTAv1.0数据集上的表现对比

Table 1. Performance comparison of different methods on DOTAv1.0 dataset

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

RoI Transformer[3]由于提取了更为精准RRoI特征,所以达到了比Rotated Faster RCNN[19]更好的性能。如

本文用DIOR-R数据集评估HRD-ROI Transformer模型的适应性。根据DIOR-R数据集的特性,将用于DOTAv1.0数据集模型的的输入图像大小调整为800 × 800像素,检测目标类别调整为20,并使用DIOR-R数据集重新训练和测试模型。结果如

表 2. 不同方法在DIOR-R数据集上的表现对比

Table 2. Performance comparison of different methods on DIOR-R dataset

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

尽管ReDet采用ReResNet提取旋转不变特征,但它的高分辨率特征语义信息很弱,对于小目标的检测效果不佳。而本文方法中使用的HRNet保持了高分辨率表示,保持强语义信息的同时,提高了网络对各种尺度目标的鲁棒性。如

表 3. DOTAv1.0和DIOR-R数据集的小目标检测效果

Table 3. Detection effects of small object on DOTAv1.0 and DIOR-R datasets

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

此外,RoI Transformer对于大长宽比的目标定位不够精准。如

图 8. 检测结果对比(大长宽比目标)

Fig. 8. Comparison of detection results (objects of large aspect ratios)

2.5 消融实验

本文利用消融实验分别测试KLD损失函数和HRNet对模型性能的影响,并对比了GWD、KLD和KFIoU 3种用于旋转目标检测的损失函数的性能。

模型(a)是RoI Transformer框架中仅以KLD损失函数替换Smooth L1损失函数,模型(b)是RoI Transformer框架融合HRNet特征提取网络,模型(c)即为本文提出的HRD-ROI Transformer方法。

表 4. KLD和HRNet在DOTAv1.0上的有效性对比

Table 4. Comparison of effectiveness of KLD and HRNet on DOTAv1.0 dataset

|

在DOTAv1.0数据集上,RoI Transformer的mAP达到68.8%,而仅使用KLD损失的模型(a)达到了70.3%,仅使用HRNet的模型(b)达到了71.7%,相比于RoI Transformer分别提升了1.5%和2.9%。这表明这两个部分对于最终的检测结果都有贡献。结合KLD损失和HRNet的模型(c)的mAP进一步达到了72.5%。上述结果充分验证了基于KLD损失和HRNet的有效性。模型(a)、(b)和(c)在DIOR-R数据集上的mAP分别比原始RoI Transformer高0.8%、3.2%和4%,也验证了本文模型的适应性。

表 5. KLD和HRNet在DIOR-R上的有效性对比

Table 5. Comparison of effectiveness of KLD and HRNet on DIOR-R dataset

|

模型(a)和RoI Transformer的检测结果对比如

GWD、KLD和KFIoU 3种损失函数的性能对比如

表 6. 3种损失函数模型的mAP比较

Table 6. Comparison of mAP for three loss function models

|

2.6 HRD-ROI Transformer误检样本分析

3 结论

本文提出了一种基于RoI Transformer的遥感图像多尺度旋转目标检测方法HRD-ROI Transformer,该方法采用HRNet作为骨干网络,提高了模型对目标尺度变化的适应性,在小目标检测效果上优于现有典型旋转目标检测方法;此外,本文所提方法引入KLD损失,可对旋转边界框参数进行联合优化,提高了模型对旋转目标,特别是大长宽比旋转目标的检测精度。在两个公共数据集的的比较试验证明了HRD-ROI Transformer可以适应目标尺度变化,并解决了角度周期性问题,在旋转目标的检测精度方面优于当前主流的方法。

本文方法对DIOR-R数据集中的机场(APO)和高尔夫球场(GF)检测效果欠佳,后续将根据这类目标的特性做数据增强,并将SAM(segmenting anything model)嵌入检测模型中[27],以SAM分割的高细粒度结果指导目标检测中低细粒度的边界框的生成,提升模型对这类目标的检测能力。针对小目标的检测问题,本文方法的检测精度有所提升,后续还可以通过引入特征层注意力机制[28],增强模型对小目标的关注,或者采用优化的低耦合网络(optimized low coupling network, OLCN)[29]避免小目标的丢失。此外,使用的HRNet包含多个特征融合,可能会造成较大的训练存储成本,因此,网络轻量化也将是未来重要的研究方向。

[1] LIU L, OUYANG W, WANG X G, et al. Deep learning for generic object detection: a survey[J]. International Journal of Computer Vision, 2020, 128(2): 261-318..

[2] 符长虹, 陈锟辉, 鲁昆瀚, 等. 面向边缘智能光学感知的航空紧固件旋转检测[J]. 应用光学, 2022, 43(3): 472-480.

[3] DINGJ, XUEN, LONGY, et al. Learning RoI transformer for oriented object detection in aerial images[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE, 2019: 2849-2858.

[4] QIANW, YANGX, PENGS L, et al. Learning modulated loss for rotated object detection[C]// Proceedings of the AAAI conference on artificial intelligence. [S. l. ]: [s. n. ], 2021: 2458-2466.

[5] MA J Q, SHAO W Y, YE H, et al. Arbitrary-oriented scene text detection via rotation proposals[J]. IEEE Transactions on Multimedia, 2018, 20(11): 3111-3122..

[6] XIEX X, CHENGG, WANGJ B, et al. Oriented r-cnn for object detection[C]// Proceedings of the IEEE/CVF International Conference on Computer Vision. Piscataway: IEEE, 2021: 3520-3529.

[7] HANJ M, DINGJ, XUEN, et al. Redet: a rotation-equivariant detector for aerial object detection[C]// Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2021: 2786-2795.

[8] HEK M, ZHANGX Y, RENS Q, et al. Deep residual learning for image recognition[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE, 2016: 770-778.

[9] YANGX, YANJ C, MINGQ, et al. Rethinking rotated object detection with Gaussian Wasserstein distance loss[C]// International Conference on Machine Learning. [S. l. ]: [s. n. ], 2021: 11830-11841.

[11] YANGX, YANJ C, FENGZ M, et al. R3det: refined single-stage detector with feature refinement for rotating object [C]// Proceedings of the AAAI conference on artificial intelligence. [S. l. ]: [s. n. ], 2021: 3163-3171.

[12] HOUL, LUK, XUEJ, et al. Shape-adaptive selection and measurement for oriented object detection[C]// Proceedings of the AAAI Conference on Artificial Intelligence . [S. l. ]: [s. n. ], 2022: 923-932.

[13] LIW, CHENY, HUK, et al. Oriented reppoints for aerial object detection[C]// Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. New York: IEEE, 2022: 1829-1838.

[14] 吴烈权, 周志峰, 朱志玲, 等. 基于改进YOLO-V4的贴片二极管表面缺陷检测[J]. 应用光学, 2023, 44(3): 621-627.

[15] YANGX, YANGX J, YANGJ R, et al. Learning high-precision bounding box for rotated object detection via kullback leibler divergence[C]//Advances in Neural Information Processing Systems. Cambridge: MIT Press, 2021: 18381-18394.

[18] WANG J D, SUN K, CHENG T S, et al. Deep high-resolution representation learning for visual recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2021, 43(10): 3349-3364..

[19] 曹家乐, 李亚利, 孙汉卿, 等. 基于深度学习的视觉目标检测技术综述[J]. 中国图象图形学报, 2022, 27(6): 1697-1722.

CAO Jiale, LI Yali, SUN Hanqing, et al. A survey on deep learning based visual object detection[J]. Journal of Image and Graphics, 2022, 27(6): 1697-1722.

[20] YANG X, YAN J C, LIAO W L, et al. SCRDet++: detecting small, cluttered and rotated objects via instance-level feature denoising and rotation loss smoothing[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2023, 45(2): 2384-2399..

[21] HAN J, DING J, LI J, et al. Align deep features for oriented object detection[J]. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60: 1-11.

[22] XIAG S, BAIX, DINGJ, et al. Dota: a large-scale dataset for object detection in aerial images[C]// Proceedings of the IEEE conference on computer vision and pattern recognition. New York: IEEE, 2018: 3974-3983.

[23] CHENG G, WANG J B, LI K, et al. Anchor-free oriented proposal generator for object detection[J]. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60: 1-11.

[24] LI K, WAN G, CHENG G, et al. Object detection in optical remote sensing images: a survey and a new benchmark[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2020, 159: 296-307.

[25] ZHOUY, YANGX, ZHANGG F, et al. Mmrotate: a rotated object detection benchmark using pytorch[C]// Proceedings of the 30th ACM International Conference on Multimedia. [S. l. ]: [s. n. ], 2022: 7331-7334.

[28] LIJ, GONGY X, MAZ, et al. Enhancing feature fusion using attention for small object detection[C]// 2022 IEEE 8th International Conference on Computer and Communications. New York: IEEE, 2022: 1859-1863.

[29] YUAN Y, ZhANG Y L. OLCN: an optimized low coupling network for small objects detection[J]. IEEE Geoscience and Remote Sensing Letters, 2021, 19: 1-5.

Article Outline

刘敏豪, 王堃, 金睿蛟, 卢天, 李璋. 基于改进RoI Transformer的遥感图像多尺度旋转目标检测[J]. 应用光学, 2023, 44(5): 1010. Minhao LIU, Kun WANG, Ruijiao JIN, Tian LU, Zhang LI. Multi-scale oriented object detection based on improved RoI Transformer in remote sensing images[J]. Journal of Applied Optics, 2023, 44(5): 1010.

![HRNet结构图[18]](/richHtml/yygx/2023/44/5/1010/3165-3.jpg)