高频信息对齐的多尺度融合去雾网络

1 引言

由于空气中雾霾、气溶胶等媒介因子的存在,户外拍摄的图片总存在对比度降低和颜色失真等质量退化现象,影响后续的计算机视觉任务的执行性能,如遥感、语义分割、目标检测等[1-2]。所以近些年来图像去雾任务引起了研究人员的广泛关注和研究[3-18],其目的是通过给定的有雾图像得到对应的无雾干净图像。

先前的工作如暗通道先验[7]、非局部先验[8]、颜色线先验[9]和颜色衰减先验[10]等都是遵循大气散射模型的假设,估计透射率和大气光值,进而得到对应的无雾图像。上述先验是对大量无雾图像进行观察统计进而人为设计得到的,因此在大多真实场景下并不能保证它们总是成立,间接说明透射率和大气光的不正确估计会直接影响重构出的无雾图像的质量。

随着深度学习的不断发展,大量基于卷积神经网络的方法被用于图像超分辨、图像去噪和图像去雾等图像恢复任务,且被证明是高度有效的,去雾方法包括MSCNN[11]、Dehaze-Net[12]、AOD-Net[13]、cGAN[14]和GFN[15]等。基于学习的去雾方法可进一步分为“间接端到端”和“直接端到端”方法。前者如MSCNN,其目的是为了获取大气散射模型的中间参数,即透射率和大气光,然后通过大气散射模型得到无雾图像,而中间参数的估计会造成重构误差的放大,进一步影响最后的重构结果。后者通过网络学习“有雾图像-无雾图像”的直接映射关系,如AOD-Net、EPDN[16]、MSBDN[17],避免估计中间参数所带来的问题。但大多数此类方法并未使用先验信息,且计算量和参数量过大,对计算机硬件有较高要求。

为将先验信息引入到以数据驱动的深度学习方法中并降低网络对计算机内存和算力的要求,本文提出一个高频信息对齐的多尺度融合去雾网络(Multi-Scale Fusion Dehazing Network for High-Frequency Information Alignment,HFMS-Net),其本质是采用循环模式构建生成对抗网络,贡献如下:(1)对生成器的不同深度卷积层中所嵌入的多尺度特征进行融合学习,利用多尺度特征融合带来的性能优势,通过减少网络通道数与缩减基础构建块数目有效减少了HFMS-Net的计算量与参数量;(2)对判别器的输入特征进行数据处理,以促使后续的对抗学习实现输入图像与重构图像之间的高频信息对齐;(3)与现有算法相比,HFMS-Net不仅在PSNR、SSIM方面有一定提升,在视觉效果方面也有一定的竞争力。

2 研究背景

2.1 大气散射模型

根据大气散射模型,图像雾霾化过程可用

式中第一项表示拍摄目标自身的反射光到达相机传感器的部分,第二项表示大气光经散射和吸收之后到达传感器的部分。其中

其中

2.2 基于先验的方法

传统的基于先验的去雾方法以大气散射模型为基础,主要目标是估计透射率和大气光值,进而通过大气散射模型反向推导出无雾图像。

基于先验的经典方法有暗通道先验、颜色衰减先验、最大化局部对比度方法[18]以及颜色线先验等。暗通道先验基于无雾图像的大多局部块中的像素值至少在一个颜色通道非常小甚至接近于0的假设提出。Zhu[10]等人观察到在有雾图像的局部块中,随着此处饱和度的下降,其亮度值反而会增大,因此会形成一个明显的差异。Tan[18]通过最大化局部对比度来增强图像的视觉效果,达到去雾目的。Fattal[9]发现在RGB颜色空间的局部块中,像素通常呈现一维分布。

上述方法都取得了不错的性能,但先验知识通常是通过统计观察进而人为设计得到的。由于大气光和大气散射系数的多样性,提前设计的先验假设在很多真实情景下并不成立。此外,由于大气散射模型自身的病态性,中间参数的独立估计一般会存在估算误差,直接影响最后的无雾图像质量,发生去雾残留和颜色失真等现象。

2.3 基于学习的方法

随着深度学习不断发展,基于卷积神经网络的方法不断被引入计算机视觉领域[11-17,19-23]。事实证明基于学习的方法对于图像恢复任务非常高效。在图像去雾领域,基于学习的方法大概可分为“间接端到端”和“直接端到端”方法。

“间接端到端”方法是利用神经网络学习大气散射模型的中间参数透射率和大气光,然后利用大气散射模型推导出无雾图像。MSCNN、Dehaze-Net作为此类方法的代表,首先通过网络训练学习估算透射率的能力并通过传统方法得到大气光值,然后基于大气散射模型获取干净无雾图像。MSCNN包括“粗尺度”和“细尺度”两个子网络。“粗尺度”子网络利用图像全局信息学习全局范围内较粗糙的透射率,“细尺度”子网络利用前者的学习结果(即全局透射率)和图像局部信息去细化此透射率。Dehaze-Net通过在网络架构中设计一些特殊的网络层体现先验假设,将现有的先验假设和网络连接起来。上述方法的缺点在于中间参数的独立估计会放大重构误差,影响最后重构图像的质量。

“直接端到端”方法通过网络训练学习有雾图像到无雾图像的直接映射关系,避免了中间参数的估计,近年来提出的去雾网络大部分均采用“直接端到端”设计。AOD-Net通过将透射率和大气光的独立参数估计融合为估计参数

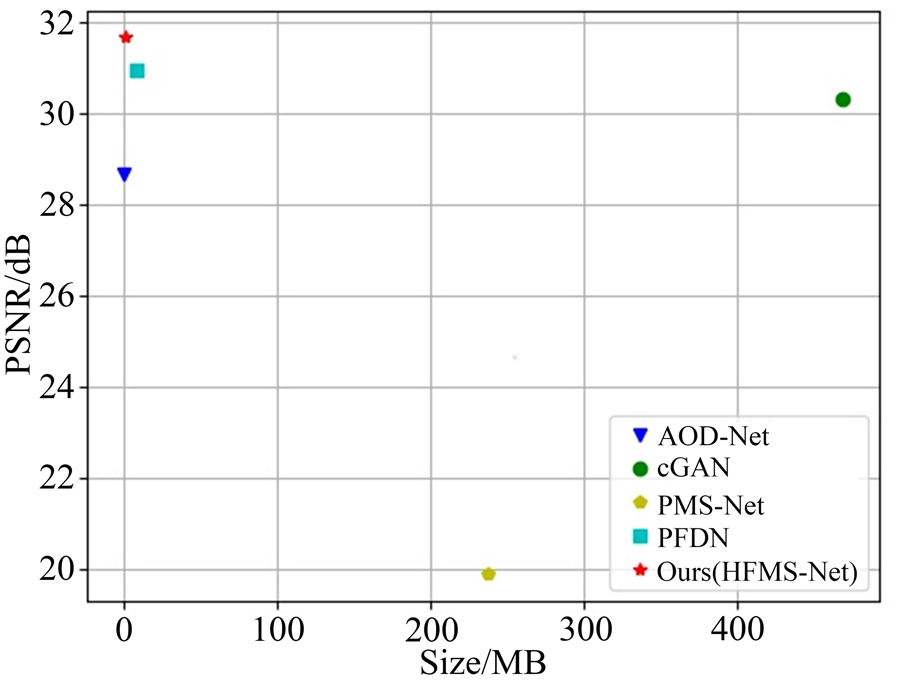

HFMS-Net在生成器中进行多尺度特征融合,充分利用网络的中间层特征,通过减少网络通道数与缩减基础构建块数目有效降低了网络对计算机的算力和内存要求,如

3 高频信息对齐的多尺度融合网络

本文提出一个高频信息对齐的多尺度融合去雾网络(HFMS-Net),基于生成对抗网络的思想构建。受Cycle-GAN[19]启发,HFMS-Net选择类循环模式作为网络主体框架,在普通生成对抗式网络中引入一个逆向生成器去增强网络约束。

HFMS-Net在生成器的不同深度引入多个残差连接以充分利用网络的中间层特征,实现多尺度特征融合,并利用多尺度特征融合带来的性能优势,通过减少网络通道数与缩减基础构建块数目有效减少了HFMS-Net的计算量与参数量。此外,为将图像的先验特征引入网络学习,本网络对判别器的输入特征进行纹理特征提取以促使后续的对抗学习实现输入图像与重构图像之间的高频信息对齐。

HMFS-Net的网络架构如

3.1 生成器

本网络包括两个生成器:正向生成器和逆向生成器。正向生成器的作用是通过有雾图像重构无雾图像,而逆向生成器采用正向生成器的输出作为输入,其目的是通过无雾图像重构有雾图像,以此增强网络的约束性,更大程度地保证网络学习的准确性。

两个生成器结构相同,如

网络采用有雾图像作为输入Inp,经过一次卷积、残差依次得到结果Conv1、Res1;再通过跳跃连接将输入Inp及一次残差结果Res1进行级联得到Concat1作为二次卷积的输入,进而得到二次卷积、残差的结果Conv2、Res2;同样地,将一次级联结果Concat1及二次残差结果Res2进行级联得到Concat2作输出层的输入,最后经Relu激活层得到去雾结果。

其中涉及到的卷积操作其卷积核大小均为3×3,而通道数依次为64,64,128,128,3,且步长设置为1避免了下采样操作带来的信息丢失。每个残差块也由如前所述的两个卷积块组成。

3.2 判别器

判别器通过对输入特征进行判断估计而决定输入是否为“真”,即检验判别器输入是真实无雾图像还是由生成器所得的重构图像,若判别器将输入特征判断为假则输出为0,反之非0。当判别器经过数次迭代训练而对生成器的输出和真实无雾图像无法分辨时,则认为网络学习达到收敛,判别器认为对应的生成器已经有足够的去雾能力。

通过观察,同一场景在不同条件下所获取的图像在纹理结构等高频信息上具有一致性,故在去雾网络的学习过程中过分关注颜色信息等视觉属性而忽略纹理结构信息的一致性会导致重构图像具有一定程度的纹理损失。因此,本网络在判别器的开端引入纹理信息提取操作,并与去雾图像/真实图像进行级联以提供视觉信息,以此对齐输入图像和去雾图像的结构信息。

如

网络采用去雾图像/真实图像作为输入,再将输入的去雾图像或真实图像进行纹理信息提取进而得到单通道特征图,然后与输入的去雾图像/真实图像进行级联得到四通道的特征图,最后将该级联结果作为后续卷积操作的输入得到判别结果。

3.3 损失函数

本网络训练目标与Cycle-GAN相似,定义训练数据集为

(1)对抗损失。对于正向生成器

其中

(2)重构损失。逆向生成器

(3)循环一致损失函数。如

(4)总体损失函数。总体损失函数如

4 实验

本节内容主要分两部分:一是用于展示本文提出的网络与现有去雾网络在合成数据以及真实数据上的定量分析及定性分析结果;二是进行充分的消融实验以凸显本文所引入模块的有效性及对于网络性能提升所带来的影响。

本文在进行对比实验时,依据方法被提出的先后顺序依次为AOD-Net、cGAN、PMS-Net[20]、PFDN[21]、BCDP[22]。为保证对比的公平性,本文所采用的实验结果均为所采用数据集上的复现结果。

4.1 实现细节

(1)超参数设置。在网络训练中,本文采用Adam优化器并设置固定学习率为0.001,指数衰减率

(2)数据集选择。在本网络训练中,随机从RESIDE(REalistic Single Image Dehazing)数据集[23]的OTS子集中分别选取3 500对、880对“有雾-无雾”图像用于训练和测试。

(3)数据处理。考虑到图像过大对于网络训练和硬件设备的要求过高,可能会存在内存不足的问题,本网络将训练集中所有图像大小通过随机裁剪的方式设置为256×256,并将像素值范围归一化到[0,1]。

(4)衡量指标。在类似于图像去雾的图像重构任务中,峰值信噪比(PSNR)和结构相似性(SSIM)两个经典指标常常被用来衡量网络的性能。PSNR和SSIM均越大越好,前者越大表示图像的失真越小而有用信息更多,后者越大表示重构图像和真实图像之间的结构相似性越高。因此本文的所有定量分析过程均采用PSNR和SSIM指标做参考。

(5)实验环境。在Windows10系统下,在单张NVIDIA TITAN Xp的GPU上采用Python3.6、Tensorflow2.4.1框架实现。

4.2 对比实验

4.2.1合成域数据

表 1. 在合成数据上的定量分析结果

Table 1. Quantitative analysis results on synthetic data

|

4.2.2真实域数据

4.3 消融实验

为了表明本文所提网络架构的有效性,设计了以下4组实验并对其进行定量分析以及视觉效果的比较:(1)Model_A:表示网络最初始的状态,包括两个生成器及一个普通的二分类判别器;(2)Model_B:表示在(1)的基础上对其生成器引入两条跳跃连接;(3)Model_C:表示在(2)的基础上对判别器的输入引入纹理信息进行提取操作;(4)Model_D:表示在(3)的基础上将去雾结果/真实图像与纹理提取结果进行级联。

从

表 2. 消融实验定量结果

Table 2. Quantitative results of ablation experiments

|

5 结论

本文提出了一个高频信息对齐的多尺度融合去雾网络(HFMS-Net),其本质是采用循环模式构建生成对抗网络。HFMS-Net对生成器中嵌入的多尺度特征信息进行融合提取以避免信息丢失,并利用多尺度特征融合带来的性能优势通过减少网络通道数与缩减基础构建块数目有效减少了HFMS-Net的计算量与参数量。对于判别器,网络需对其输入进行纹理信息提取,逼近去雾图像和有雾图像之间的高频信息,使基于数据驱动的网络学习更具物理解释性。

整个网络学习没有涉及任何其他的预训练网络,在保证去雾性能的前提下,在一定程度上缩减了模型架构。与现有方法相比,本文算法将图像先验特征引入网络学习,拥有更低的空间复杂度,参数量显著降低,以PFDN所需内存的1/5取得了更优越的性能。HFMS-Net在参数量降至2 MB的同时PSNR至少提升了0.71。实验证明与现有方法相比,本文提出的网络其性能不仅在合成域数据上有着一定的提升,在真实数据上也取得了一定的效果。

[1] 刘涛, 钱锋, 张葆. 遥感图像的MAP超分辨重建[J]. 液晶与显示, 2018, 33(10): 884-892.

[2] 张瑞琰, 姜秀杰, 安军社, 等. 面向光学遥感目标的全局上下文检测模型设计[J]. 中国光学, 2020, 13(6): 1302-1313.

[3] 周文舟, 范晨, 胡小平, 等. 多尺度奇异值分解的偏振图像融合去雾算法与实验[J]. 中国光学, 2021, 14(2): 298-306.

[4] 郭璠, 蔡自兴, 谢斌, 等. 图像去雾技术研究综述与展望[J]. 计算机应用, 2010, 30(9): 2417-2421.

[5] 禹晶, 徐东彬, 廖庆敏. 图像去雾技术研究进展[J]. 中国图象图形学报, 2011, 16(9): 1561-1576.

[6] 李婉, 毕竞舸, 张选德, 等. 基于非局部和先验约束的多尺度图像去雾网络研究[J]. 陕西科技大学学报, 2022, 40(3): 172-178,184.

[9] FATTAL R. Dehazing using color-lines[J]. ACM Transactions on Graphics, 2014, 34(1): 13.

Article Outline

李鹏泽, 李婉, 张选德. 高频信息对齐的多尺度融合去雾网络[J]. 液晶与显示, 2023, 38(2): 216. Peng-ze LI, Wan LI, Xuan-de ZHANG. Multi-scale fusion dehazing network for high-frequency information alignment[J]. Chinese Journal of Liquid Crystals and Displays, 2023, 38(2): 216.