基于卷积与图神经网络的合成孔径雷达与可见光图像配准  下载: 607次

下载: 607次

1 引言

合成孔径雷达(SAR)图像和可见光图像是卫星遥感领域中常见的两类异源图像,两者融合将提供更丰富的信息[1]。不同卫星平台获取的SAR图像和可见光图像间通常存在视角差异,故进行图像融合之前需进行图像配准。SAR图像因存在大量斑点噪声,与可见光图像之间存在显著的非线性辐射畸变(NRD)[2],使得基于同源图像的经典配准算法(如SIFT[3]、ORB[4]等)失效或性能大幅度下降。近年来,遥感异源图像配准问题得到了较为广泛的关注[5],根据是否采用深度学习方法,可分为基于人工设计的配准方法和基于深度学习的配准方法。

在基于人工设计的配准方法中,较早的遥感SAR与可见光图像配准方法包括两类:基于区域的互信息模板匹配方法[5]和基于特征的改进SIFT方法[6],但这两类方法配准效果较差且计算代价高昂。近期研究发现,基于频域的相位一致性(PC)特征[7]对NRD具有更好的鲁棒性,在遥感领域得到了较为广泛的应用:HOPC方法[8]通过拓展PC特征构建区域描述符,采用模板匹配方法进行配准,但只对异源图像间的小范围平移问题有效;辐射不变特征变换(RIFT)[2]直接利用PC特征图进行特征点检测与描述,实现了配准的旋转不变性;后续研究者进一步提高了PC特征的旋转与尺度不变性[9-11],但这类配准算法普遍较慢、不具有实时性。

为了提高配准精度与实时性,近年来出现了一些基于深度学习的SAR与可见光图像配准研究工作,大致可以分为三类:1)基于风格迁移的配准方法[12-13],即采用生成对抗网络(GAN)等模型,将SAR与可见光图像迁移到同一种模态下,降低异源图像之间的差异,再利用同源配准方法进行匹配,这类网络目前泛化能力不强,且容易丢失细节信息;2)基于图像区域的配准方法,Hughes等[14]和Zhang等[15]将SAR与可见光图像块输入到孪生卷积神经网络中,利用特征图的相关性预测图像块之间的平移量,但这类算法在SAR与可见光影像之间存在显著的旋转与尺度差异,难以保证配准的鲁棒性;3)基于深度学习特征的配准方法,这类方法主要利用卷积神经网络同时进行特征点的检测与描述,典型的网络包括SuperPoint[16]与D2Net[17],目前主要用于自然图像配准工作中。其中,D2Net方法实现了昼夜图像的配准,CMM-Net[18]是D2Net的改进方法,用于SAR与可见光图像的配准任务。

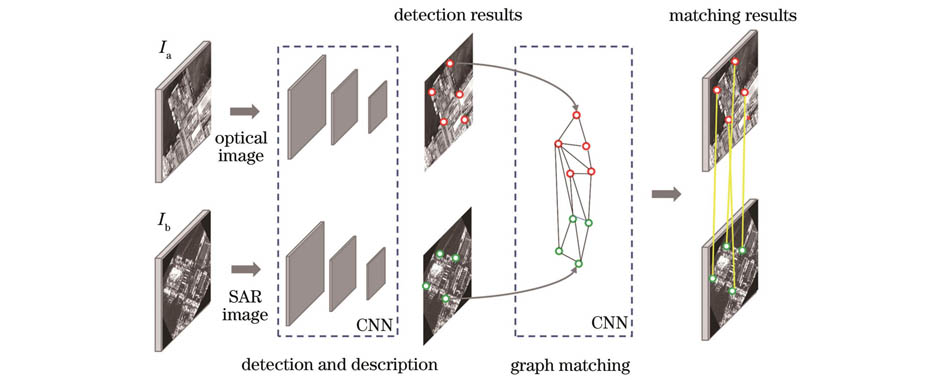

在上述研究工作中,通常只考虑图像区域或局部特征的外观相似性,忽略了特征点在空间位置上的关系,难以解决SAR与可见光图像在显著旋转与尺度变化下的配准问题。本文受基于上下文描述符的ContextDesc算法[19]与SuperGlue算法[20]启发,提出了一种基于卷积与图神经网络(CGNet)的配准方法。CGNet先利用CNN进行局部特征点的检测与描述,再结合特征点的位置信息,通过图神经网络(GNN)聚合描述符的几何上下文信息,最后利用图匹配方法完成特征点匹配,构建了端到端的SAR与可见光配准网络。

2 SAR与可见光图像配准网络架构

本文的SAR与可见光图像配准网络架构如

2.1 特征点检测与描述网络

如

1)特征编码器

该编码器利用类似VGG[21]的结构进行特征提取与降维,由卷积层、池化空间降采样和非线性激活函数三部分构成。编码器共使用了三个最大池化层,即在空间维度上经过了三次两倍下采样,假设输入图像大小为

2)特征检测解码器

编码器输出的张量图通过该解码器的两层卷积模块后,中间张量的维度大小变为

3)特征描述解码器

该解码器包含两个基本卷积层,输出的张量维度为

假设输入图像分别为

2.2 特征点匹配网络

特征点匹配网络由位置信息编码器、GNN、最优传输三部分组成,结构如

1)位置信息编码器

为使得局部描述符具有几何上下文信息,本文将特征点

式中:MLP(·)表示利用多层感知机进行信息编码。

2)GNN

为了使得特征描述符能进一步聚合几何上下文信息,需要采用自注意力层和交叉注意力层进行信息传递,相应表达式为

式中:l为网络层数;ε为自注意力机制模式参数;

网络总共

其中网络每一层的注意力权重

式中:

式中:

利用自注意力层与交叉注意力层重复多次进行特征描述符的几何上下文信息增强,学习潜在的几何变换与特征投影。

3)最优传输

将GNN输出的所有特征向量

3 匹配矩阵与损失函数

CGNet直接采用SuperPoint进行特征点检测与描述,需要训练的部分是特征点匹配网络,目的是弥补现有局部特征描述符的不足,进一步增强描述符的几何上下文信息。

由于存在视角变化的SAR与可见光图像难以通过标注匹配特征点的方式获得训练真值,故本文采用预先配准对齐的SAR与可见光数据集进行训练,通过仿射变换矩阵随机生成几何变换,模拟视角变化,其中主要的空间变换类型包括:平移、旋转、缩放和复合的刚体变换,如

3.1 随机几何变换与匹配矩阵

在训练过程中,对图片

图 5. 匹配矩阵。(a)真值生成;(b)预测与损失计算

Fig. 5. Matching matrix. (a) Ground truth generation; (b) prediction and loss calculation

3.2 损失函数

如

由于SAR与可见光图像差异明显,特征点检测重复率低,同名点数量稀少,故本文需要特别将

4 实验结果与分析

4.1 实验数据与参数设置

实验中的SAR与可见光图像数据集来源于高分三号与资源三号卫星,覆盖包括港口、城市、河流、机场、岛屿和平原共6个场景。图像需要预先进行配准对齐,经过切片后,分辨率为512 pixel×512 pixel,选择其中1497张图片作为训练样本,350张图片用于测试。本文的CGNET方法基于PyTorch框架实现。特征点检测与描述网络SuperPoint的置信度阈值

4.2 特征点检测性能评估

为验证特征点检测器对NRD的鲁棒性,本文在对比实验中采用的方法包括:经典的点特征匹配算法(SIFT[3]、ORB[4])、基于相位一致性特征的异源图像匹配算法(RIFT[2])和基于CNN的深度学习匹配算法(SuperPoint[16]和D2Net[17])。

式中:

图 6. 特征点检测结果。(a)原图;(b)ORB;(c)SIFT;(d)D2Net;(e)RIFT;(f)SuperPoint

Fig. 6. Results of feature point detection. (a) Original image; (b) ORB; (c) SIFT; (d) D2Net; (e) RIFT; (f) SuperPoint

本文使用整个数据集(1847对图片)进行测试评估,计算每个检测器的

表 1. 特征检测器性能评估

Table 1. Performance evaluation of feature detector

|

4.3 特征点匹配性能评估

特征点匹配性能的评价指标包括:匹配成功率

首先验证CGNet的平移不变性,本文根据已有的350幅对齐的测试集图像,利用空间变换矩阵生成具有平移变换的SAR与可见光图像数据集,每组图像在纵横两个方向的相对平移量范围为

图 7. 平移不变性实验匹配结果。(a)OS-SIFT;(b)SuperPoint;(c)D2Net;(d)CMM-Net;(e)RIFT;(f)所提CGNet

Fig. 7. Matching results of shift invariance experiment. (a) OS-SIFT; (b) SuperPoint; (c) D2Net; (d) CMM-Net; (e) RIFT; (f) proposed CGNet

对具有平移变化的350对测试集图片进行定量的评估,计算匹配成功率

表 2. 平移不变性实验中的特征匹配性能

Table 2. Performance of feature matching in shift invariance experiment

|

与平移不变性实验相同,为验证CGNet具有较好的旋转与尺度不变性,利用空间变换矩阵随机生成具有旋转、缩放和刚体变换的测试集,其中旋转变换的角度范围为

表 3. 旋转、缩放和刚体变换实验中的特征匹配性能

Table 3. Performance of feature matching in rotation, scaling and rigid transformation experiments

|

最后,

图 8. 旋转不变性实验的匹配和配准结果。(a)150°旋转的匹配结果;(b)150°旋转的配准结果;(c)210°旋转的匹配结果;(d)210°旋转的配准结果

Fig. 8. Matching and registration results in rotation invariance experiment. (a) Matching result of 150° rotation; (b) registration result of 150° rotation; (c) matching result of 210° rotation; (d) registration result of 210° rotation

图 9. 尺度与刚体变换实验的匹配结果。(a)缩放尺度为0.75;(b)缩放尺度为0.6;(c)随机刚体变换1;(d)随机刚体变换2

Fig. 9. Matching results in scaling and rigid transformation. (a) Scaling scale of 0.75; (b) scaling scale of 0.6; (c) random rigid transformation 1; (d) random rigid transformation 2

4.4 消融实验

为了验证CGNet网络中各部分组件的必要性,进行了消融实验。所有实验设置相同的参数,在相同的训练数据上训练300个epoch后,在平移情况下的配准测试集上进行性能评估,结果如

表 4. 消融实验结果

Table 4. Results of ablation study

|

4.5 正负样本均衡与计算效率

由于特征点

表 5. 不同epoch下的匹配成功率增长量

Table 5. Growth value of matching success rate

|

最后,进行算法运行时间与参数量比较,结果如

表 6. 运行时间与参数量比较

Table 6. Running time and number of parameters comparison

|

5 结论

提出了一种基于卷积与GNN的SAR与可见光图像配准方法CGNet。由于采用了CNN的特征点检测方法,故CGNet在计算速度上显著优于基于相位一致性特征的遥感图像匹配方法。在SAR与可见光配准任务中,通过传统方法和CNN方法构建的局部特征描述符匹配性能不佳,而CGNet利用GNN学习特征点之间的位置关系,丰富了局部描述符的上下文信息,使得描述符具有良好的旋转与尺度不变性,显著提高了匹配性能。同时,针对难以通过标注获得匹配特征点真值的问题,CGNet利用预先对齐的配准数据集设计了一套弱自监督的训练方法,可以端到端直接输出两幅图像的特征点匹配关系,具有很高的计算效率。CGNet可拓展到其他类型的异源图像配准任务中,如红外与可见光图像配准、医学图像配准等。

[1] 谢志华, 刘晶红, 孙辉, 等. 可见光图像与合成孔径雷达图像的快速配准[J]. 激光与光电子学进展, 2020, 57(6): 062803.

[2] Li J Y, Hu Q W, Ai M Y. RIFT: multi-modal image matching based on radiation-variation insensitive feature transform[J]. IEEE Transactions on Image Processing, 2020, 29: 3296-3310.

[3] Lowe D G. Distinctive image features from scale-invariant keypoints[J]. International Journal of Computer Vision, 2004, 60(2): 91-110.

[4] RubleeE, RabaudV, KonoligeK, et al. ORB: an efficient alternative to SIFT or SURF[C]//2011 International Conference on Computer Vision, November 6-13, 2011, Barcelona, Spain. New York: IEEE Press, 2011: 2564-2571.

[5] Suri S, Reinartz P. Mutual-information-based registration of TerraSAR-X and Ikonos imagery in urban areas[J]. IEEE Transactions on Geoscience and Remote Sensing, 2010, 48(2): 939-949.

[6] Xiang Y M, Wang F, You H J. OS-SIFT: a robust SIFT-like algorithm for high-resolution optical-to-SAR image registration in suburban areas[J]. IEEE Transactions on Geoscience and Remote Sensing, 2018, 56(6): 3078-3090.

[7] KovesiP. Phase congruency detects corners and edges[C]//The Australian Pattern Recognition Society Conference, December 10-12, 2003, Sydney. [S.l.: s.n.], 2003: 309-318.

[8] Ye Y X, Shan J, Bruzzone L, et al. Robust registration of multimodal remote sensing images based on structural similarity[J]. IEEE Transactions on Geoscience and Remote Sensing, 2017, 55(5): 2941-2958.

[9] Li Z Y, Zhang H T, Huang Y H. A rotation-invariant optical and SAR image registration algorithm based on deep and Gaussian features[J]. Remote Sensing, 2021, 13(13): 2628.

[10] 孙明超, 马天翔, 宋悦铭, 等. 基于相位特征的可见光和SAR遥感图像自动配准[J]. 光学 精密工程, 2021, 29(3): 616-627.

[11] 李泽一, 赵薇薇, 喻夏琼, 等. 基于最大相位索引图的异源影像配准方法[J]. 中国激光, 2021, 48(15): 1509002.

[12] Zhang J, Ma W P, Wu Y, et al. Multimodal remote sensing image registration based on image transfer and local features[J]. IEEE Geoscience and Remote Sensing Letters, 2019, 16(8): 1210-1214.

[13] ToriyaH, DewanA, KitaharaI. SAR2OPT: image alignment between multi-modal images using generative adversarial networks[C]//IGARSS 2019-2019 IEEE International Geoscience and Remote Sensing Symposium, July 28-August 2, 2019, Yokohama, Japan. New York: IEEE Press, 2019: 923-926.

[14] Hughes L H, Schmitt M, Mou L C, et al. Identifying corresponding patches in SAR and optical images with a pseudo-siamese CNN[J]. IEEE Geoscience and Remote Sensing Letters, 2018, 15(5): 784-788.

[15] Zhang H, Ni W P, Yan W D, et al. Registration of multimodal remote sensing image based on deep fully convolutional neural network[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2019, 12(8): 3028-3042.

[16] DeToneD, MalisiewiczT, RabinovichA. SuperPoint: self-supervised interest point detection and description[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops (CVPRW), June 18-22, 2018, Salt Lake City, UT, USA. New York: IEEE Press, 2018: 337-349.

[17] DusmanuM, RoccoI, PajdlaT, et al. D2-net: a trainable CNN for joint description and detection of local features[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), June 15-20, 2019, Long Beach, CA, USA. New York: IEEE Press, 2019: 8084-8093.

[18] 蓝朝桢, 卢万杰, 于君明, 等. 异源遥感影像特征匹配的深度学习算法[J]. 测绘学报, 2021, 50(2): 189-202.

Lan C Z, Lu W J, Yu J M, et al. Deep learning algorithm for feature matching of cross modality remote sensing images[J]. Acta Geodaetica et Cartographica Sinica, 2021, 50(2): 189-202.

[19] LuoZ X, ShenT W, ZhouL, et al. ContextDesc: local descriptor augmentation with cross-modality context[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), June 15-20, 2019, Long Beach, CA, USA. New York: IEEE Press, 2019: 2522-2531.

[20] SarlinP E, DeToneD, MalisiewiczT, et al. SuperGlue: learning feature matching with graph neural networks[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), June 13-19, 2020, Seattle, WA, USA. New York: IEEE Press, 2020: 4937-4946.

[22] Sinkhorn R, Knopp P. Concerning nonnegative matrices and doubly stochastic matrices[J]. Pacific Journal of Mathematics, 1967, 21(2): 343-348.

[23] WangRZ, YanJC, YangXK. Learning combinatorial embedding networks for deep graph matching[C]//2019 IEEE/CVF International Conference on Computer Vision (ICCV), October 27-November 2, 2019, Seoul, Korea (South). New York: IEEE Press, 2019: 3056-3065.

Article Outline

刘磊, 李元祥, 倪润生, 张宇轩, 王艺霖, 左宗成. 基于卷积与图神经网络的合成孔径雷达与可见光图像配准[J]. 光学学报, 2022, 42(24): 2410002. Lei Liu, Yuanxiang Li, Runsheng Ni, Yuxuan Zhang, Yilin Wang, Zongcheng Zuo. Synthetic Aperture Radar and Optical Images Registration Based on Convolutional and Graph Neural Networks[J]. Acta Optica Sinica, 2022, 42(24): 2410002.