角度差异强化的光场图像超分网络

1 引言

传统相机记录3D空间的2D投影,照片的强度反映了空间光线的能量积分。为了更加充分地记录空间信息,常通过变换相机位置及调整镜头焦距,实现多视角图像及多聚焦图像的获取[1]。与传统相机相比,光场相机的成像效率更高,基于单次曝光捕获的光场原图,通过图像处理即可计算同一场景的多张重聚焦图像及多视角图像[2]。光场相机成像效率的提升得益于相机成像模型的优化[3],核心技术在于通过分光技术实现4D光场的获取,即空间光线位置信息和角度信息的同步获取,但角度信息的获取是以牺牲图像空间分辨率为代价的。为了提高光场图像的空间分辨率,研究有效的光场超分辨率重构技术具有重要意义[4-11]。近年来,各种先进的深度学习网络框架被应用于图像超分辨率重构,同时在光场超分辨率重构中也展示了其优越的性能。悉尼大学Yeung等人提出空间、角度信息可分离的光场超分(light field super-resolution using deep efficient spatial-angular separable convolution, LFSSR)网络,该模型呈沙漏形状,设计了空间-角度可分离卷积来提取空间与角度的联合特征,具有运算速度快的优点[7]。北京交通大学张硕等人提出残差光场超分(residual networks for light field image super-resolution, ResLF)网络,该方法隐式地挖掘多视点图像间的内在对应关系,通过学习子孔径图像阵列中水平、竖直和对角方向上的视差信息,实现了重建图像的高频信息补充[8]。但ResLF算法由于没有用到光场中的全部视角图像,从而导致对遮挡边缘部分的重建结果有些失真。香港城市大学Jin等人提出结合几何嵌入与结构一致性的光场超分网络,首先利用多对一模块学习子孔径图像间的互补信息,得到初级超分图像,再采用正则化模块强化视差结构,得到空间结构一致性增强的高分辨率图像[9]。网络的优点在于充分利用视图之间的互补信息和保留光场视差结构。以宏像素图像阵列为输入,国防科技大学王应谦等人提出空间、角度交互光场超分(spatial-angular interaction for light field image super-resolution, LF-InterNet)网络,提出空间特征提取器与角度特征提取器分别提取光场图像的空间特征与角度特征,将其反复交互融合得到高分辨率光场图像[4]。并且空间角度交互机制是一个通用框架,可以高效地处理光场数据。之后,他们又提出了可变形卷积光场图像超分(light field image super-resolution using deformable convolution, LF-DFnet)网络,设计了角度可变形对准模块来学习侧视图与中心视图的偏移量,并将该偏移量编码到每个视图的特征中提高网络超分性能[5]。可变形卷积光场图像超分网络虽然考虑到了所有视图之间的视差信息,但是在深层特征提取部分却忽略了对自身特征深入学习。国防科技大学梁政宇等人提出角度分辨率灵活变化的光场超分(angular-flexible network for light field image super-resolution, LF-AFnet)网络,将解耦和融合模块以残差的形式连接,实现了任意角度分辨率光场图像的超分辨率重构[10]。其最大的优势在于该网络可以处理由具有任意角度分辨率的不同类型设备捕获的光场数据。国防科技大学莫宇等人提出稠密双注意力网络(dense dual-attention network, DDAN),设计了视图注意力模块和通道注意力模块,实现了跨视点和跨通道有用信息的提取,提高了超分过程中子孔径图像信息的利用率[6]。其优点在于能够以更少的网络参数量达到更好的超分辨率效果。上海交通大学赵圆圆等人提出融合多尺度特征的光场图像超分辨率网络[11],该算法在空洞空间金字塔池化(atrous spatial pyramid pooling, Aspp)模块结构基础上加入了残差式的设计,组成了残差空洞空间金字塔池化(residual atrous spatial pyramid pooling, ResAspp)块的网络子结构,该算法没有充分利用视图的差异特征。

光场超分网络以4D光场重排后的2D图像阵列为输入,大多通过学习光场子孔径图像间的空间特征和角度特征来进行超分得到高分辨率图像。性能优越的LF-DFnet网络在学习过程中引入了不同视图间差异特征的学习,却忽略了视图自身特征的学习,而在传统单幅图像超分辨率重建过程中,通过图像自身特征学习也可得到质量较高的高分辨率图像。基于此,本文搭建了自身特征强化的光场超分辨率重构网络,采用多分支残差块实现浅层特征提取,在深层特征提取时采用优化的角度可变形对准模块来强化中心视图特征和侧视图特征的学习,最后采用简化的残差特征蒸馏模块实现子孔径图像重构。

2 光场超分辨率重构网络搭建

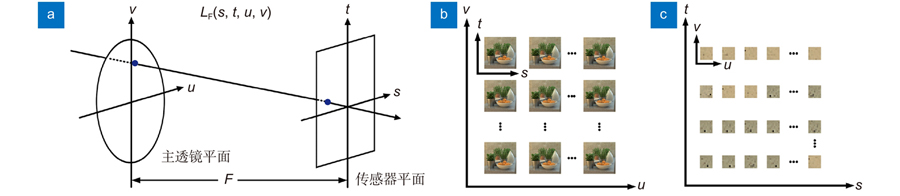

基于光场双平面表示模型如

图 1. 4D 光场获取与重排。(a) 光场双平面表示模型;(b) 子孔径图像阵列;(c) 宏像素阵列

Fig. 1. 4D light field acquisition and rearrangement. (a) Biplanar representation model of light field; (b) Subaperture image array; (c) Macropixel array

考虑到光场相机角度信息的获取是以牺牲图像空间分辨率为代价,本文搭建的光场超分辨率重构网络主要用于光场图像空间分辨率超分,整体网络结构图如

2.1 基于MBR块的浅层特征提取

本文搭建的光场超分辨率重构网络在进行浅层特征提取时,采用1×1卷积和8个MBR块生成浅层特征,所设计的MBR块包括3个支路,其数据处理流程图如

2.2 基于EADA模块的深层特征提取

4D光场数据较传统2D图像,具有丰富的角度信息,故光场超分辨率重构网络在深层特征提取时,有效利用角度信息的相关性可以提高网络超分性能。文献[5]提出的LF-DFnet网络,在深层特征提取部分用到了角度可变形对准(angular deformable alignment, ADA)模块,其结构如

图 4. ADA 模块细节。(a) ADA 模块数据处理流程;(b) 特征收集(collect);(c) 特征收集中偏移 量的获取;(d)中心视图的更新;(e) 特征发散(distribute);(f) 特征发散中偏移量的获取

Fig. 4. ADA module details. (a) ADA module data processing process; (b) Feature collection; (c) Offset acquisition in feature collection; (d) Update the central view; (e) Feature distribution; (f) Offset acquisition in feature distribution

1) 将侧视图特征1与中心视图特征对齐,学习对齐后的侧视图特征1与中心视图特征来得到偏移量特征(如

2) 更新中心视图特征(具体操作如

3) 循环收集所有侧视图的偏移量特征;

4) 所有侧视图特征和更新后的中心视图特征通过1×1卷积进行角度信息合并,得到融合特征。

特征发散部分如

为了充分利用4D光场多视角图像间角度信息的相关性,本文在深层特征提取部分也采用可变形卷积来进行特征收集和特征发散。考虑到ADA模块在深层特征提取中没有充分对视图自身特征进行挖掘,本文对ADA模块进行了改进,提出了强化侧视图自身特征学习的EADA模块,以进一步提高网络性能。EADA模块中特征收集部分的结构如

图 5. EADA 模块细节。(a) EADA 特征收集细节;(b) EADA 特征发散细节

Fig. 5. EADA module details. (a) EADA feature collection details; (b) EADA feature distribution details

其中:

其中:

2.3 基于SRFD模块的数据重构

数据重构一般包括特征融合和特征上采样两部分,这两部分逐步将网络提取的有效信息解码成最终的高清图像。本文在数据重构过程中,借鉴了残差特征蒸馏的思想完成特征融合。残差特征蒸馏(Residual feature distillation, RFD)模块[12]的结构如

图 6. RFD 模块的简化。(a) RFD 模块细节;(b) SRFD 模块细节

Fig. 6. RFD module simplification. (a) RFD module details; (b) SRFD module details

数据经过融合操作后,需将得到的重构特征馈送到上采样模块来实现光场图像的超分辨率。本文的上采样部分主要由像素洗牌操作完成[4-7],融合数据先通过1×1卷积将深度扩展到

3 实验结果与分析

本文使用5个公共光场数据集(EPFL[13], HCInew[14], HCIold[15], INRIA[16]和STFgantry[17])来进行训练和评估本文方法的有效性,训练集和测试集的场景个数如

表 1. 实验使用的5个公共光场数据集

Table 1. Five public light field datasets used in our experiment

|

3.1 网络各模块有效性验证

3.1.1 MBR块的有效性

为了证明MBR块中多支路连接的有效性,在深层特征提取模块、数据重构模块保持不变的基础上,将MBR块与省略支路2、支路3跳跃连接的MBR块分别作为浅层特征提取模块,进行了对比实验。实验过程中对光场图像进行4倍超分辨率重构,基于不同浅层特征提取模块的网络得到的光场超分子孔径图像的平均PSNR、SSIM值如

表 2. 基于不同浅层特征提取模块的光场图像4倍超分PSNR/SSIM值

Table 2. PSNR/SSIM values achieved by different shallow feature extraction modules for 4×SR

|

3.1.2 EADA模块的有效性

为了验证所设计用于深层特征提取的EADA模块的有效性,在浅层特征提取模块、数据重构模块保持不变的基础上,将EADA模块与ADA模块、单支路EADA模块分别作为深层特征提取模块,进行了对比实验。单支路EADA模块是EADA模块对支路2的省略。实验中仍然对光场图像进行4倍超分辨率重构,基于不同深层特征提取模块的网络得到的光场超分子孔径图像的平均PSNR、SSIM值如

表 3. 基于不同深层特征提取模块的光场图像4倍超分PSNR/SSIM值

Table 3. PSNR/SSIM values achieved by different deep feature extraction modules for 4× SR

|

3.1.3 SRFD模块的有效性

为了验证所设计用于特征融合部分的SRFD模块的有效性,在浅层特征提取模块、深层特征提取模块保持不变的基础上,将RFD模块与SRFD模块分别作为特征融合模块进行了对比实验。实验中仍然对光场图像进行4倍超分辨率重构,基于不同特征融合模块的网络得到的光场超分子孔径图像的平均PSNR、SSIM值如

表 4. 基于不同特征融合模块的光场图像4倍超分PSNR/SSIM值

Table 4. PSNR/SSIM values achieved by different feature fusion modules for 4×SR

|

3.2 网络性能分析

为了对本文所提光场超分辨率重构网络性能进行评价,本文对5个公共光场数据集的23个场景进行2倍超分和4倍超分,分别从超分后图像主观视觉效果展示、PSNR和SSIM值计算、算法复杂度分析等三个方面对本文算法进行了定性分析与定量评价,并与其它图像超分辨率重构方法进行了对比,以验证本文算法的优越性。

3.2.1 主观视觉效果对比

为了定性分析本文超分辨率重构网络的性能,将本文提出的算法与当下较为先进的两种单图像超分辨率方法(EDSR[20]和RCAN[21])和四种光场图像超分辨率方法(ResLF[8]、LFSSR[7]、LF-InterNet[4]和LF-DFnet[5])得到的超分图像进行了视觉效果对比,如

图 10. “Lego Knights”场景 4 倍超分的视觉效果对比

Fig. 10. Visual contrast of the "Lego Knights" scene with 4× SR

分析其原因,EDSR和RCAN算法仅超分光场中的单个视图,并没有使用光场的4D信息,网络超分性能最差;ResLF、LFSSR、LF-InterNet算法侧重于独立学习空间特征和角度特征,没有挖掘不同视图间的差异,限制其超分性能;LF-DFnet算法提出视差机制,充分挖掘了不同视图间的视差信息,超分性能有所提升,本文算法在挖掘不同视图间的视差信息前,对侧视图自身特征进行了强化学习,因此超分性能表现最好。

3.2.2 定量评价结果对比

定性评价受人眼视觉感知特性限制,不易客观的反映图像质量。为了进一步准确评价本文所提算法的超分辨率性能,分别计算了5个公共光场数据集中每一测试场景2倍超分和4倍超分后的PSNR值和SSIM值,并针对不同数据集取了平均值,最后计算了所有数据集的均值,不同算法的实验结果如

表 5. 不同算法对光场图像2倍超分PSNR/SSIM值

Table 5. PSNR/SSIM values achieved by different methods for 2× SR

|

表 6. 不同算法对光场图像4倍超分PSNR/SSIM值

Table 6. PSNR/SSIM values achieved by different methods for 4× SR

|

3.2.3 算法复杂度

在验证了本文所提算法对光场图像的超分效果后,进一步对算法的复杂度进行了分析,分别对比了本文算法与其它几种算法的参数量(Parameters)、每秒浮点运算次数(Flo/s),具体数据如

表 7. 不同算法(2倍超分/4倍超分)复杂度对比

Table 7. Comparisons of the number of parameters and FLOPs by different methods for 2× SR and 4× SR

|

4 结论

本文提出了一种基于角度差异强化的光场图像超分网络,以提高光场子孔径图像的空间分辨率。在浅层特征提取部分,采用了多分支残差(multi-branch residual, MBR)块来提取4D光场中的固有结构信息;在深层特征提取部分,设计了强化的角度可变形对准(enhanced angular deformable alignment, EADA)模块强化各侧视图自身特征的挖掘,使得视图间角度的差异得到更好的学习,并很好地将角度信息融合并编码到每个视图特征中;在数据重构部分,采用了结构更为简单的残差特征蒸馏(simplified residual feature distillation, SRFD)模块,使得特征融合中浅层信息和深层信息可以更直接结合。消融实验验证了本文所提网络各个模块的有效性。与其它光场超分辨率重构算法相比,本文算法在合理控制参数量的情况下,主观视觉测试和定量评价均表现出较高性能。另外,针对本文网络模型参数量较高的问题,后期将进一步简化数据重构部分的残差特征蒸馏模块,在保证超分性能的前提下进一步提高网络运算速度。

[1] Ng R, Levoy M, Brédif M, et alLight field photography with a hand-held plenoptic cameraComput Sci Tech Rep CSTR2005211111

[2] Tao M W, Hadap S, Malik J, et al. Depth from combining defocus and correspondence using light-field Cameras[C]//Proceedingsof2013IEEEInternationalConferenceonComputerVision, Sydney, 2013: 673–680. https://doi.org/10.1109/ICCV.2013.89.

[3] Levoy M, Hanrahan P. Light field rendering[C]//Proceedingsofthe23rdAnnualConferenceonComputerGraphicsandInteractiveTechniques, New York, 1996: 31–42. https://doi.org/10.1145/237170.237199.

[4] Wang Y Q, Wang L G, Yang J G, et al. Spatial-angular interaction for light field image super-resolution[C]//Proceedingsofthe16thEuropeanConferenceonComputerVision, Glasgow, 2020: 290–308. https://doi.org/10.1007/978-3-030-58592-1_18.

[8] Zhang S, Lin Y F, Sheng H. Residual networks for light field image super-resolution[C]//Proceedingsof2019IEEE/CVFConferenceonComputerVisionandPatternRecognition, Long Beach, 2019: 11046–11055. https://doi.org/10.1109/CVPR.2019.01130.

[9] Jin J, Hou J H, Chen J, et al. Light field spatial super-resolution via deep combinatorial geometry embedding and structural consistency regularization[C]//Proceedingsof2020IEEE/CVFConferenceonComputerVisionandPatternRecognition, Seattle, 2020: 2260−2269. https://doi.org/10.1109/CVPR42600.2020.00233.

[11] 赵圆圆, 施圣贤融合多尺度特征的光场图像超分辨率方法光电工程2020471220000710.12086/oee.2020.200007

[12] Liu J, Tang J, Wu G S. Residual feature distillation network for lightweight image super-resolution[C]//ProceedingsoftheEuropeanConferenceonComputerVision, Glasgow, 2020: 41–55. https://doi.org/10.1007/978-3-030-67070-2_2.

[13] Rerabek M, Ebrahimi T. New light field image dataset[C]//Proceedingsofthe8thInternationalConferenceonQualityofMultimediaExperience, Lisbon, 2016.

[14] Honauer K, Johannsen O, Kondermann D, et al. A dataset and evaluation methodology for depth estimation on 4D light fields[C]//Proceedingsofthe13thAsianConferenceonComputerVision, Cham, 2016: 19–34. https://doi.org/10.1007/978-3-319-54187-7_2.

[15] Wanner S, Meister S, Goldluecke B. Datasets and benchmarks for densely sampled 4D light fields[M]//Bronstein M, Favre J, Hormann K. Vision, ModelingandVisualization. Eurographics Association, 2013: 225–226. https://doi.org/10.2312/PE.VMV.VMV13.225-226.

[17] Vaish V, Adams A. The (new) Stanford light field archive, computer graphics laboratory, Stanford University[EB/OL]. 2008. http://lightfield.stanford.edu

[18] Kingma D P, Ba J. Adam: a method for stochastic optimization[C]//Proceedingsofthe3rdInternationalConferenceonLearningRepresentations, San Diego, 2015.

[19] He K M, Zhang X Y, Ren S Q, et al. Delving deep into rectifiers: surpassing human-level performance on ImageNet classification[C]//Proceedingsof2015InternationalConferenceonComputerVision, Santiago, 2015: 1026–1034. https://doi.org/10.1109/ICCV.2015.123.

[20] Lim B, Son S, Kim H, et al. Enhanced deep residual networks for single image super-resolution[C]//Proceedingsof2017IEEEConferenceonComputerVisionandPatternRecognitionWorkshops, Honolulu, 2017: 136−144. https://doi.org/10.1109/CVPRW.2017.151.

[21] Zhang Y L, Li K P, Li K, et al. Image super-resolution using very deep residual channel attention networks[C]//Proceedingsofthe15thEuropeanConferenceonComputerVision, Munich, 2018: 294–310. https://doi.org/10.1007/978-3-030-01234-2_18.

Article Outline

吕天琪, 武迎春, 赵贤凌. 角度差异强化的光场图像超分网络[J]. 光电工程, 2023, 50(2): 220185. Tianqi Lv, Yingchun Wu, Xianling Zhao. Light field image super-resolution network based on angular difference enhancement[J]. Opto-Electronic Engineering, 2023, 50(2): 220185.