1 引言 伪装原本是指动物用来隐藏自己或欺骗其他动物的一种方法,而伪装能力通常会影响这些动物的生存概率。随着仿生学技术的发展,伪装技术也常被人类应用于某些场合,例如现代军队所使用的迷彩。与显著目标检测(Salient Object Detection,SOD)相比,伪装目标通常与背景具有高度相似性,因此伪装目标检测(Camouflage Object Detection,COD)更加具有难度。

传统的方法主要关注图像的底层特征(如颜色、纹理、梯度等)来评估物体与背景的差异,基于三维凸度[1 ] 、灰度共生矩阵[2 ] 、Canny边缘检测器[3 ] 、光流[4 ] 等方法进行伪装目标检测。这些方法往往只考虑图像的一部分特征,难以适用于所有场景。近年来,深度学习的方法在许多领域展现出优异的性能,为一些传统方法难以处理的问题提供了新的解决方案[5 ] 。在图像领域,通过卷积神经网络(Convolution Neural Network,CNN)提取出的深度特征的表示能力要远强于图像的底层特征,因此,研究人员开始尝试用深度学习的方法来解决伪装目标分割的问题。Le等人建立了一个新的伪装图像数据集用于基准测试,并提出了一个端到端网络,其中包括一个分割分支和另一个分类分支。分类分支用于预测图像包含伪装对象的概率,随后用于增强分割分支中的分割性能[6 ] 。Fan等人提出了SINet模型,该模型包含两个模块:搜索模块定位伪装目标,识别模块精确检测伪装目标,同时建立了首个大规模伪装目标数据集[7 ] 。Mei等人在伪装目标分割任务中引入了干扰的概念,开发了一种新的干扰识别和去除的干扰挖掘方法,帮助对伪装目标的准确检测[8 ] 。Zhai等人将特征映射解耦为两个特定的任务:一个用于粗略地定位对象,另一个用于准确地预测边缘细节,并通过图迭代推理它们的高阶关系[9 ] 。Li等人提出联合训练SOD和COD任务,利用相互矛盾的信息同时提高两个任务的表现[10 ] 。

以上模型在多个伪装目标数据集上已经取得了较好的效果,但仍存在一些问题:模型的全局建模能力不足,在存在多个伪装目标且与背景高度相似时,模型容易出现漏检和误检的问题。其次,这些模型舍弃了较低层次的特征,而较深层次的特征在进行数次下采样后分辨率迅速下降,虽然减少了计算量,但同时也丢失了大量的边缘等细节信息,这也导致了模型的精度下降。最后,这些模型大多使用了极其复杂的特征融合策略,大幅提高了模型的复杂度与推理时间。

针对以上问题,本文提出了一种基于边缘增强和多级特征融合的伪装目标分割模型。首先,选择ResNet-50作为骨干网络,提取多级深度特征。其次,设计了一个边缘提取模块,选择融合细节信息丰富的两个较低层级特征,通过网络的不断学习,得到精确的边缘先验。同时,通过引入多尺度特征增强模块和跨层级特征聚合模块,分别在层内和层间增强特征表示,弥补多尺度表征能力不足的问题。之后,设计了一种简单但有效的层间注意力模块,利用相邻层的差异性,有选择地筛选出各层级间有用的信息,在保持层内语义完整的同时滤除背景噪声,再与边缘先验引导结合,输出精确的预测图。最后,为了增强网络的学习能力,本文采用加权二元交叉熵损失与加权IOU(Intersection-Over-Union)损失两部分作为损失函数,对3个不同尺度的输出预测同时进行深度监督;采用单独的加权二元交叉熵损失对边缘预测图进行监督,边缘的真值可以使用Canny边缘检测方法从标注图中得到。本文方法在4个伪装目标公开数据集CHAMELEON[11 ] 、CAMO[6 ] 、COD10K[7 ] 、NC4K[12 ] 上与先进的方法进行对比实验。实验结果表明,本文方法在所有数据集的4个常用的评价指标上均优于其他方法,同时能够满足实时性的需要,表明本文方法在伪装目标分割任务上具有优异的性能。

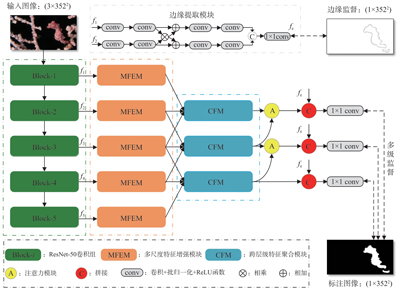

2 本文方法 如图1 所示。对于一幅输入图像I ∈ R H × W × 3 H W [13 ] ,获得不同尺度的特征f i , i ∈ { 1,2 , 3,4 , 5 }

图 1. 网络结构图Fig. 1. Network structure diagram

2.1 边缘提取模块 早期的一些相关工作[14 -15 ] 已经证实了边缘信息有助于提升计算机视觉任务的性能。在伪装目标分割任务中,由于目标与背景的高度相似性,难以清晰地辨别伪装对象与周围环境之间的边界。现有的研究表明[16 ] ,通常只有低级特征保留了大量的边缘细节信息,而在经过多个下采样操作后,细节信息会丢失。因此,本文设计了一个边缘提取模块,如图1 所示。自ResNet-50中提取出最低两层的特征f 1 ∈ R H 4 × W 4 × 64 、 f 2 ∈ R H 4 × W 4 × 256 f e

2.2 多尺度特征增强模块 伪装目标通常具有较大的尺度范围。每个单独的卷积层只能处理一种特定的尺度,为了从单个层级获取多尺度信息以表征尺度的变化,受Inception-V3[17 ] 启发,设计了一个多尺度特征融合模块(MFEM),如图2 所示。对于每个输入的特征f i ( 2 i - 1 ) × 1 1 × ( 2 i - 1 ) i ∈ { 1,2 , 3,4 } ( 2 i - 1 ) × ( 2 i - 1 ) 2 i - 1 , i ∈ { 2,3 , 4 } f i '

图 2. 多尺度特征增强模块Fig. 2. Multi-scale feature enhanced module

2.3 跨层级特征聚合模块 在跨层级特征融合的过程中,如何有效地保持层内语义的一致性及利用层间的相关性是构建伪装目标分割网络的关键。为此,本文提出了一个跨层级特征聚合模块(CFM),如图3 所示。给定一组特征f i - 1 , f i , f i + 1 , i ∈ { 2,3 , 4 } f i + 1 f i f i + 1 f i - 1 ' , f i ' , f i + 1 ' , i ∈ { 2,3 , 4 } f i f u s e , i ∈ { 2,3 , 4 } 式(5) 所示:

图 3. 跨层级特征聚合模块Fig. 3. Cross-level fusion module

f i + 1 ' = C o n v ↑ f i + 1 (1) f i ' = C o n v f i · f i + 1 ' (2) f i - 1 ' = f i - 1 · C o n v ↑ f i ' (3) f i c = C a t f i - 1 ' , C o n v ↑ C a t f i ' , f i + 1 ' (4) f i f u s e = C o n v 1 C o n v f i c (5) 其中:C o n v ↑ ( · ) C a t ( · ) C o n v 1 ( · )

2.4 注意力模块 通过简单的拼接或相加的方式融合的特征往往是复杂且低效的,大量的噪声及低置信度的信息混杂在一起会对网络的学习造成巨大的困难。为此,设计了一个简单的注意力模块,对CFM融合后的特征进一步结合并筛选,模块结构图见图4 。首先将两组相邻层级的特征f i , f i + 1 , i ∈ { 2,3 } C 降为1。即:

图 4. 层间注意力模块Fig. 4. Cross-layer attention module

f i 1 × h × w = C o n v 1 C o n v f i c × h × w (6) 其中:h 、 w c ω 1 1 × h × w 、 ω 2 1 × h × w

f i x , y ' = f i x , y · ω 1 x , y (7) f i + 1 x , y ' = f i + 1 x , y · ω 2 x , y (8) f ( x , y ) ( x , y ) ω 1 ( x , y ) + ω 2 ( x , y ) = 1 ω

p i = C o n v f i ' + f i + 1 ' (9) 采用这种注意力机制可以有效地筛选出各级特征中更有效的信息,抑制噪声,增强不同尺度特征的表示能力。需要注意的是,由于f 4 f 4

p 4 = f 4 (10) 最后,将p 2 、 p 3 、 p 4 f e P 2 、 P 3 、 P 4 P 2

2.5 损失函数 在伪装目标分割过程中,使用了加权二元交叉熵损失[18 ] (weighted binary cross entropy loss,wBCE)及加权交并比损失[18 ] (weighted intersection-over-union loss,wIOU)两部分作为损失函数。加权二元交叉熵函数的公式如式(11) 所示:

L w B C E = - ∑ i = 1 N w i · y i · l o g z i + 1 - y i · l o g 1 - z i (11) 其中:y i z i y i w i 式(12) 所示:

L w I O U = 1 - P ⋂ G P ⋃ G (12) 其中:P G

基于上述分析,使用联合损失函数对P 2 、 P 3 、 P 4 f e

L = λ 1 L e d g e + λ 2 L p r e d (13) L e d g e = L w B C E f e , E g (14) L p r e d = ∑ i ∈ { 2,3 , 4 } L w B C E p i , p g + L w I O U p i , p g (15) 其中:E g p g L w I O U λ 1 λ 2 λ 1 λ 2

3 实验与分析

3.1 数据集 我们在4个通用的伪装目标标准数据集上进行实验:CHAMELEON[11 ] 是一个小样本的伪装目标数据集,其中包含76张图像,每张图像至少有一个伪装目标;CAMO[6 ] 包含1 000张用于训练的图像和250张用于测试的图像,数据集涵盖了大量自然及人工场景下的伪装目标;COD10K[7 ] 是迄今为止最大的基准数据集,它包含5个大类和69个子类,共有3 040张训练图像和2 026张测试图像;NC4K[12 ] 是规模最大的伪装目标测试数据集,包含4 121张图像,可用来评估模型的泛化能力。仿照之前的工作[7 ] ,本文将CAMO的训练集和COD10K的训练集结合,作为完整的训练数据集(其中包含4 040张图片),并在余下的数据集上测试模型的性能。

3.2 评价指标 本文使用了4个广泛使用的评价指标:结构性度量(S α [19 ] 、E 指标(E Ø [20 ] 、带权重的F 指标(F β w [21 ] 及平均绝对误差(MAE)[22 ] 。

结构性度量(S α 式(16) 所示:

S α = α · S o P , P g + 1 - α · S r P , P g (16) 其中,S o S r [19 ] ,这里的α

E 指标(E Ø Ø F M 式(17) 所示:

E Ø = 1 w × h ∑ x = 1 w ∑ y = 1 h Ø F M x , y (17) 其中:w h

带权重的F 指标(F β w P w R w

F β w = 1 + β 2 × P w × R w β 2 × P w + R w (18) 其中,β 2 [21 ] ,β 2

平均绝对误差(MAE)用来衡量预测结果与标注图像之间的像素级差异,其被广泛应用于各类分割任务:

M A E = 1 w × h ∑ x = 1 w ∑ y = 1 h P x , y - P g x , y (19) 为了进行公平的对比,我们使用相同的代码,对不同数据集的4种评价指标进行计算。

3.3 实验细节 本文模型基于Pytorch框架构建,在NVIDIA GeForce RTX 2080TiGPU上进行所有实验。使用在ImageNet上预训练的权重文件初始化ResNet-50骨干网络的参数,其他参数由网络默认生成。在训练之前,所有训练图像及标注图像均被调整为352×352大小,并且不使用任何数据增强策略。批量大小设置为8并在训练过程中使用了Adam优化器,初始的学习率设置为1e-4,并且每30次迭代后,学习率除以10,网络共训练60轮,大约需要5.5 h。在测试过程中,测试图像同样被调整为352×352大小,随后输入网络。预测图通过双线性上采样操作缩放到原始大小以评估结果。

3.4 实验结果及对比 将本文方法与现有的11种COD方法进行比较,包括BASNet[23 ] 、EGNet[24 ] 、CPD[16 ] 、F3Net[18 ] 、PraNet[25 ] 、SINet[7 ] 、PFNet[8 ] 、C2FNet[26 ] 、SINetV2[27 ] 、LSR[12 ] 、UGTR[28 ] 。为了公平比较,我们直接使用作者在网络上开源的预测图,用相同的公式进行评估。如果缺少预测图,则使用作者提供的预训练完成的模型生成预测图。本文总结了在4个数据集上不同基线模型的定量结果。从表1 可以看出,本文方法在不同的数据集上都优于其他模型。

表 1. 不同模型在4个数据集(CHAMELEON,CAMO-test,COD10k-test,NC4K)上对4种评价指标的定量结果Table 1. Quantitative results of different models for four evaluation metrics on four dataset(CHAMELEON,CAMO-test,COD10k-test,NC4K)基线模型 CHAMELEON CAMO-test S α E Ø F β w MAE↓ S α E Ø F β w MAE↓ BASNet 0.687 0.721 0.474 0.118 0.618 0.661 0.413 0.159 EGNet 0.848 0.870 0.702 0.050 0.732 0.768 0.583 0.104 CPD 0.853 0.866 0.706 0.052 0.726 0.729 0.550 0.115 F3Net 0.848 0.917 0.744 0.047 0.711 0.780 0.564 0.109 PraNet 0.860 0.907 0.760 0.044 0.769 0.824 0.663 0.094 SINet 0.869 0.891 0.740 0.044 0.751 0.771 0.606 0.100 PFNet 0.882 0.942 0.810 0.033 0.782 0.852 0.695 0.085 C2FNet 0.888 0.946 0.828 0.032 0.820 0.864 0.752 0.066 SINetV2 0.888 0.942 0.816 0.030 0.820 0.882 0.743 0.070 LSR 0.890 0.948 0.820 0.030 0.787 0.852 0.696 0.080 UGTR 0.888 0.918 0.794 0.031 0.785 0.859 0.686 0.086 YOLOv5m-seg 0.834 0.884 0.767 0.045 0.699 0.711 0.556 0.098 YOLOv5x-seg 0.851 0.902 0.796 0.042 0.740 0.789 0.592 0.087 本文方法 0.892 0.952 0.828 0.027 0.828 0.889 0.817 0.061 基线模型 COD10K-test NC4K S α E Ø F β w MAE↓ S α E Ø F β w MAE↓ BASNet 0.634 0.678 0.365 0.105 0.695 0.785 0.546 0.095 EGNet 0.737 0.779 0.509 0.056 0.777 0.864 0.639 0.075 CPD 0.747 0.770 0.508 0.059 0.787 0.852 0.696 0.072 F3Net 0.739 0.819 0.544 0.051 0.780 0.848 0.656 0.070 PraNet 0.789 0.861 0.629 0.045 0.822 0.877 0.724 0.059 SINet 0.771 0.806 0.551 0.051 0.808 0.876 0.723 0.058 PFNet 0.800 0.868 0.660 0.040 0.839 0.892 0.745 0.053 C2FNet 0.813 0.890 0.636 0.036 0.838 0.898 0.762 0.049 SINetV2 0.815 0.887 0.680 0.037 0.840 0.907 0.770 0.048 LSR 0.804 0.889 0.673 0.037 0.840 0.907 0.770 0.048 UGTR 0.818 0.850 0.667 0.035 0.839 0.892 0.746 0.052 YOLOv5m-seg 0.715 0.732 0.527 0.048 0.753 0.780 0.634 0.066 YOLOv5x-seg 0.794 0.832 0.590 0.044 0.802 0.868 0.715 0.053 本文方法 0.822 0.890 0.673 0.034 0.850 0.908 0.775 0.044

为了进行更广泛的对比,本文使用在目标检测领域的YOLOv5模型进行分割对比实验。在训练开始前,所有图片参照官方代码库(https://github.com/ultralytics/yolov5 )的设置被重新调整为640×640大小,其他参数使用默认设置。实验选取与本文方法参数量相近的YOLOv5m-seg模型(22.67M)与性能最优的YOLOv5x-seg模型,结果见表1 。本文方法在模型大小相近的情况下性能远远领先YOLOv5m-seg模型,与YOLOv5x-seg模型相比有着巨大的优势。

图5 展示了本文方法与其他模型的视觉对比结果。可以看出,在不同的具有挑战性的场景下(第1~2行大尺寸伪装目标,第3~4行小伪装目标,第5~6行模糊边缘),本文方法都能产生优于其他模型的预测图。在目标被部分遮挡的情况下(第7行),该方法也能准确定位目标区域并产生精确的边缘细节。因此,本文方法相比于其他方法在伪装目标分割任务中具有更优秀的性能。另外,本文提供了本文方法与其他11种模型的P -R 曲线和F 曲线,如图6 所示。

图 5. 本文方法与其他方法的视觉对比Fig. 5. Vision comparison of our method with other methods

图 6. 10种不同方法在4个基准数据集上的P -R 曲线和F 曲线,本文方法为红色实线。P -R 曲线越接近右上角,F 曲线越接近坐标系上部,表示模型的性能越好。Fig. 6. P -R curves and F -measure curves of 10 different methods on four benchmark datasets. Our method is shown with a solid red line. The closer the P -R curve is to the upper right corner and the higher the F -measure curve is,the better the performance of the model is.

本文方法与其他方法在模型复杂度、参数量和实时性上也进行了对比。所有算法在相同的硬件环境下(RTX2080Ti显卡)进行实验。其中浮点运算次数(Floating Point Operations,FLOPs)可用来衡量算法复杂度,为21.26G;模型参数量(Parameters,Params)为29.47M;FPS(Frame Per Second)为44.2。为了公平比较,所有模型均使用352×352的图片计算。如表2 所示,本文方法在提升准确性的同时也保证了实时性能。

表 2. 不同模型的速度和模型复杂度分析Table 2. Speed and model complexity analysis on multiple modelsMethod 本文方法 SINet PFNet UGTR MGL-R LSR SINetV2 FLOPs/G 21.26 38.04 19.00 1 024 549.62 66.64 31.26 Params./M 29.47 48.95 49.50 48.87 63.58 50.95 24.93 FPS 44.2 56 62 18 12 56 25

3.5 消融实验 为了验证每个模块的有效性,本文设计了一系列消融实验,对边缘提取模块、多级特征增强模块(MFEM)、跨层级特征聚合模块(CFM)、注意力模块等逐步解耦,以验证其有效性,实验结果见表3 。为了验证损失函数及对应的超参数对网络性能的影响,本文对一系列不同的超参数设置进行了定量评价。

表 3. 不同模块的有效性分析Table 3. Effectiveness analysis of different modules边缘提取模块 多尺度特征增强模块 跨层级特征聚合模块 注意力模块 COD10K-test S α E Ø F β w MAE↓ 0.766 0.828 0.552 0.045 √ √ 0.803 0.857 0.639 0.040 √ √ 0.812 0.864 0.660 0.038 √ √ √ 0.812 0.868 0.652 0.038 √ √ √ 0.819 0.875 0.664 0.036 √ √ √ 0.816 0.872 0.666 0.036 √ √ √ √ 0.822 0.890 0.673 0.034

基线模型选择一个类似U-net[29 ] 结构的分割网络,编码器部分为ResNet-50网络,解码器逐级上采样并与较浅层特征结合,逐渐恢复到原尺寸。从表3 可以看出,不同的模块对模型的性能提升都有贡献:在U-net架构基础上加入多尺度特征增强模块和跨层级特征聚合模块后,模型的4个评价指标S α E Ø 、F β w S α E Ø 、F β w

图7 为逐步解耦各个子模块后的可视化效果对比。从图7 (d)可以看出,在去除了边缘提取模块后,预测结果的边界存在大量的冗余,一些较复杂的边缘结构难以被清晰地分割,说明边缘提取模块对目标边界像素的提纯至关重要。多尺度的特征更有利于定位复杂场景下的伪装物体,在分别去掉多尺度特征增强模块(图7 (e))和跨层级特征聚合模块(图7 (f))后,模型不能准确地找到目标所在的位置,出现了目标区域模糊不清、目标结构被错判和伪装区域连通性的问题。从图7 (c)和图7 (g)可以看出,注意力模块对融合后的特征进一步去噪,使网络更关注于预测目标区域,对背景区域进行抑制,目标细节更明显,置信度较低的噪声干扰被去除。

图 7. 去除不同模块的视觉比较Fig. 7. Vision comparison of removed different modules

为了分析联合损失函数各参数对网络的影响,按照不同的比例设置两部分损失函数的超参数(其中λ 1 L e d g e λ 2 L p r e d 表4 ,模型在给边缘损失较大权重时表现更好,在λ 1 = 5 、 λ 2 = 1

表 4. 两种损失函数的比重对网络性能的影响Table 4. Effect of the proportion of the two loss functions on network performanceλ 1 λ 2 COD10K-test S α E Ø F β w MAE↓ 1 1 0.813 0.887 0.660 0.036 2 1 0.820 0.890 0.669 0.034 5 1 0.822 0.890 0.673 0.034 10 1 0.825 0.884 0.670 0.035 1 2 0.807 0.878 0.662 0.035 1 5 0.800 0.871 0.654 0.037

4 结论 本文提出了一种基于边缘增强和特征融合的伪装目标分割网络。首先设计了一种边缘提取模块,有效利用低级特征,产生精确的边缘先验。其次,采用多尺度特征增强模块和跨层级特征融合模块,分别提取层内和层间的有效多尺度信息。之后,设计了一种简单有效的层间注意力模块,对充分融合的特征进行再次筛选,去除冗余的背景噪声干扰。最后,将各层预测与边缘先验结合,生成最后的预测图,并采用联合损失函数对不同尺度的预测图进行联合监督。本文方法在4个伪装目标基准数据集上进行实验,在4种不同的评价指标上都优于其他方法。在视觉对比中,本文方法分割出的预测图能够更好地识别复杂场景下的伪装物体,更好地保留了目标轮廓,细节信息更清晰。因此,本文方法对伪装目标分割有更好的效果。

李明岩, 吴川, 朱明. 基于边缘增强和特征融合的伪装目标分割[J]. 液晶与显示, 2024, 39(1): 48. Mingyan LI, Chuan WU, Ming ZHU. Camouflaged object segmentation based on edge enhancement and feature fusion[J]. Chinese Journal of Liquid Crystals and Displays, 2024, 39(1): 48.