基于点线特征结合的单目相对位姿测量方法  下载: 1410次

下载: 1410次

1 引言

视觉定位技术[1-3]是近些年迅速发展起来的一种新型技术,其在导航定位中的应用也越来越受到人们的重视。尽管现有的视觉导航定位算法[4]种类多,但在搬运型机器人[5]、智能叉车[6]等一些特殊背景下,确定高精度位姿仍面临一定挑战。

准确的点线特征检测和匹配是位姿估计技术[7]的前提,点线特征匹配精度的高低直接影响最终位姿求解结果。点特征检测和匹配较为常用的算法有SIFT(Scale-Invariant Feature Transform)[8]、SURF(Speeded Up Robust Features)[9]、ORB(Oriented FAST and Rotated BRIEF)[10]等,均可以提供较好的检测匹配效果。与点特征不同,单相机下的直线匹配[11]一直是一个难点。因为难以选取一个固定区域对线特征进行描述,极线约束[12]也不能为直线提供有效的位置约束,而且当多条直线相交时,检测的直线在交点处被分割成若干个小线段,致使端点的提取存在不稳定性。因此,现有的基于线特征的位姿估计主要应用在双目[13-14]或多目视觉中,在单目视觉[15-16]中运用较少。对于单目图像之间的直线匹配,Jia等[17]根据匹配好的点特征和LSD(Line Segment Detector)[18-19]算法检测的直线,通过构造投影不变量来进行直线匹配,该算法具有较好的匹配性能,即使在纹理少的条件下仍能较好地完成直线匹配。本文将图像中的点特征通过ORB算法实时检测和匹配,ORB特征由关键点和描述子两部分组成。其中,关键点具有尺度不变性和旋转不变性的优点;描述子采用二进制形式,可显著提高点特征的检测匹配速度。对于线特征,本文使用LSD算法和贾棋提出的算法对直线进行检测和匹配。其中,LSD检测线特征具有速度快、使用方便的优点,而且提取的直线有主方向,进行线段匹配时可排除一些误匹配。根据检测到的直线以及直线邻域的点特征,可构建直线邻域的特征数,进而计算两条直线的相似度。这样,对任意2帧图像可构建一个相似矩阵,矩阵中相似度最大的两条直线即为最终直线匹配结果。

同时,对于单相机和惯性测量单元结合的位姿估计的应用越来越普及,标定好相机与惯性测量单元后,利用惯性测量单元测量的姿态角信息可有效减少相机相对位姿估计的参数量[20-21]。由于惯性测量单元提供的偏航角精度低于俯仰角和滚转角精度,因此相机坐标系通常仅采用惯性测量单元提供的俯仰角和滚转角[20-21]。针对平面场景存在的单应性约束,Saurer等[22]提出了基于单应性的两点法,该算法可高效稳定地求解已知垂直方向的相机运动位姿。

本文借鉴贾棋和Saurer的研究思路,提出了基于点线特征结合的单目相对位姿测量方法。该方法充分利用了平面场景的有用信息,并将直线特征应用在单目相对位姿估计上,适用于自主导航[23]和增强现实[24]等领域,具有重要的理论研究意义和广泛的应用前景。

2 相机校正模型

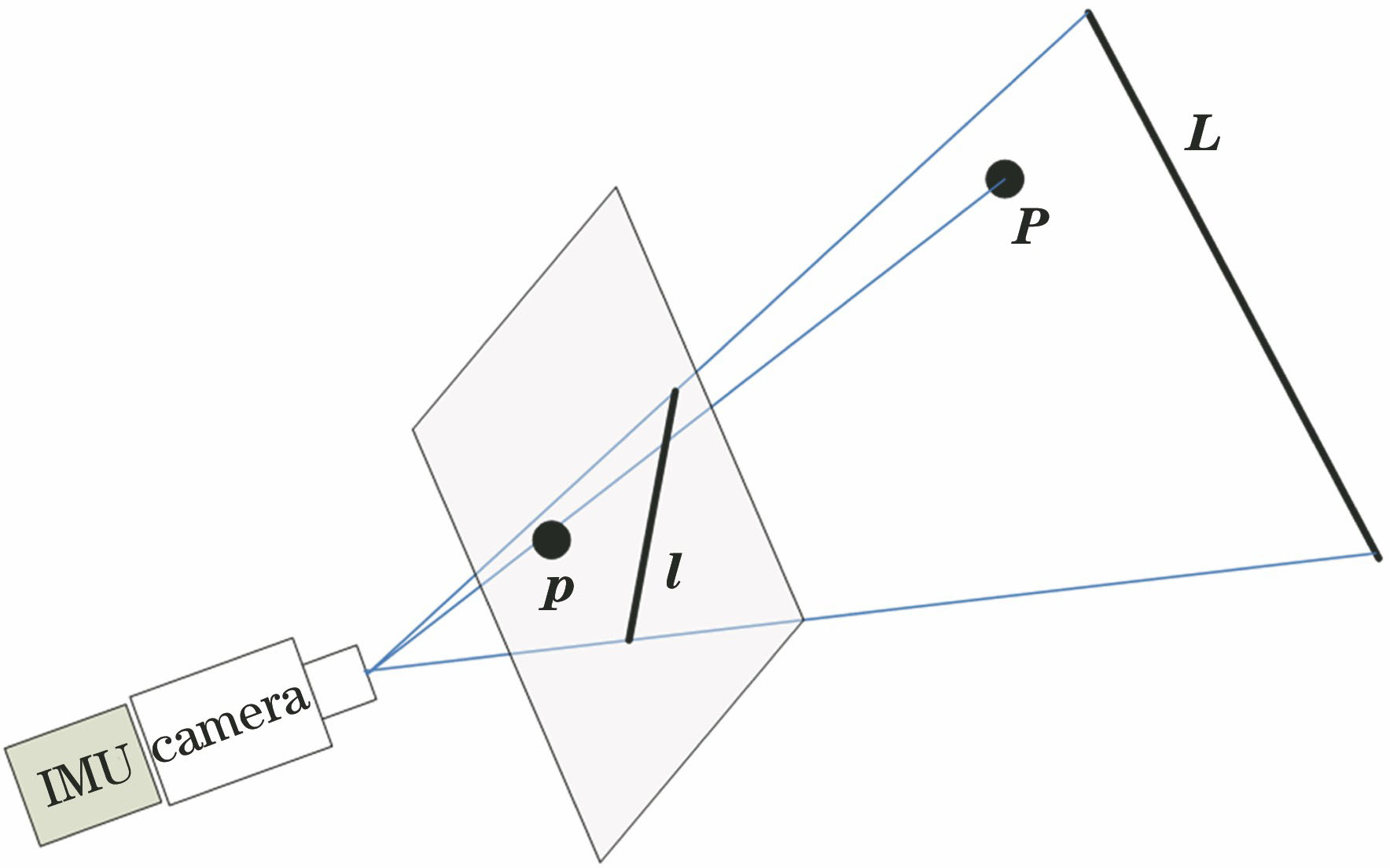

测量系统由惯性测量单元(IMU)与相机[25]构成,如

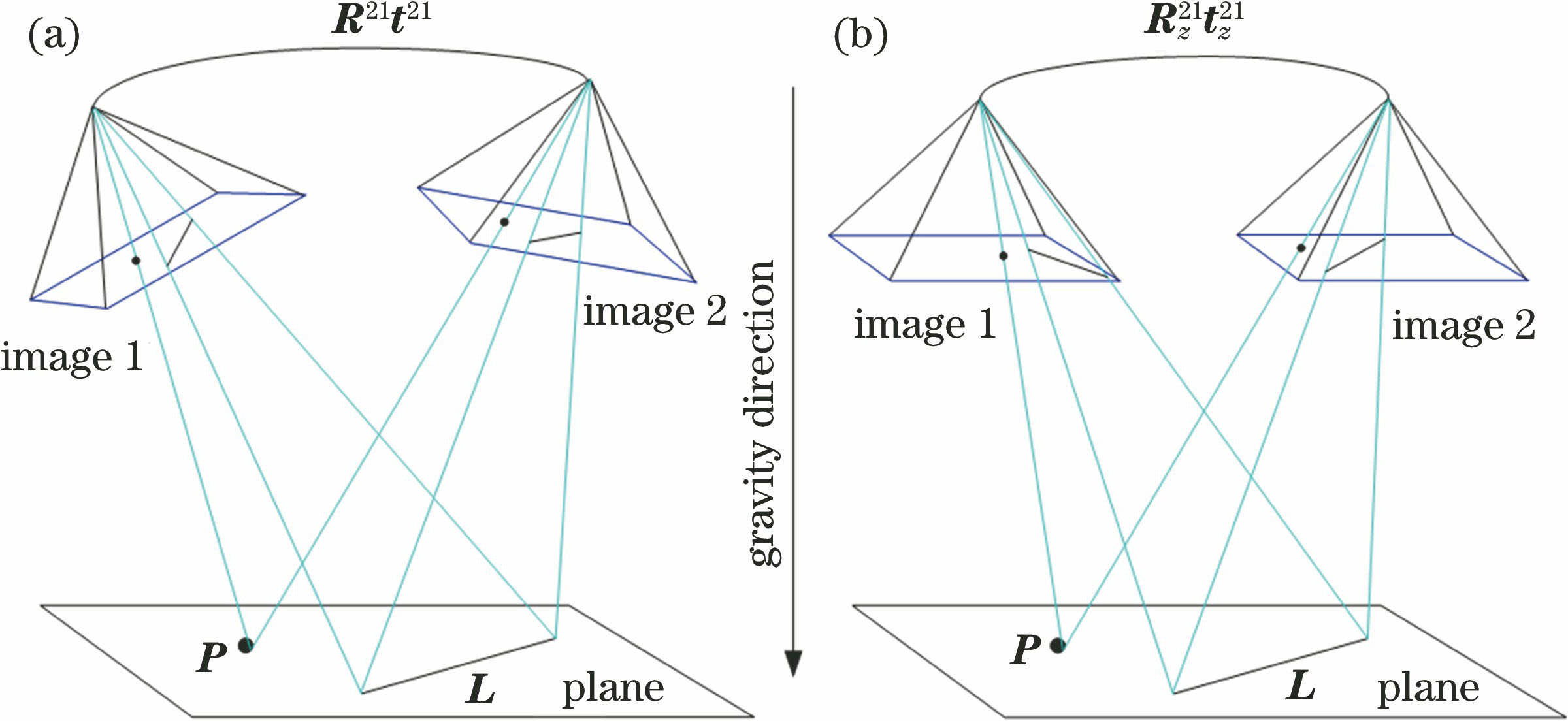

其中,惯性测量单元可实时提供准确的俯仰角和滚转角,相机可测得准确的偏航角和平移向量。利用惯性测量单元实时提供的俯仰角和滚转角信息,可将图像平面校正为正下视方向。如

图 2. 相机坐标系校正。(a)校正前;(b)校正后

Fig. 2. Camera coordinates system correction. (a) Before correction; (b) after correction

设空间中一点Pw,在第1帧相机坐标系下的坐标为Pc1,在第2帧中对应的坐标为Pc2,相机相对于世界坐标系的旋转矩阵、平移向量分别为Rwci、twci(i=1,2),则Pw和Pc1、Pc2之间的关系满足:

设惯性测量单元相对世界坐标系的旋转矩阵为Rwi=

将(2)式代入(1)式可得

将(3)式中的两个方程相减,可得到

式中:

式中:

3 基于点线特征结合的位姿估计

3.1 基于点特征的约束方程

设空间点在第i帧相机坐标系的坐标为qi=

式中:λ为尺度因子;H为单应性矩阵,则

式中:d为相机到平面的垂直距离;n为平面的法向向量,即n=[0,0,-1]T。相机坐标系和地面垂直方向对齐后,只有偏航角是未知的。设偏航角为θ,则

将(8)式代入(7)式中,可得

式中:tx、ty和tz是指矢量t在x、y和z轴3个方向的具体数值。

因此,根据H的形式,可将其表示为

(6)式两端左叉乘qj,可得

将(10)式代入(11)式,可得

整理后,可得基于点匹配的约束方程,即

3.2 基于线特征的约束方程

第i帧图像中,设线L0的直线方程为ax+by+1=0,表示成矩阵形式,即

进一步可表示为

同理,第j帧图像中,与直线L0匹配的直线L1的方程为cx+dy+1=0,可表示为

根据单应性,xi和xj满足λxj=Bxi约束。方程两端左乘以nT,可得

根据(16)式,可知(17)式的左端为0,因此右端也等于0,即

根据(15)式和(18)式,可推导出

对(19)式的两端进行变换,得

为消除尺度因子,(20)式两端左叉乘m,可得

值得注意的是,本小节的B与3.1节的H不同,这里B=KBK-1,里面含有关于内参矩阵K的变换。为此,需进一步对(20)式进行变换,即

移项,得

式中:令KTn=n',KTm=m',则可将(23)式化简成与(20)式类似的形式,即BTn'=λm'。进而可得

设n'=

3.3 基于点线特征结合的约束方程

基于点特征和线特征得到的约束方程,即可求解H。如选取1个匹配特征点和1条匹配特征线,联立方程可得

待求解问题的自由度为3,而(26)式矩阵的秩为4,因此可求解H。利用公式

进而可分解出

式中:R、t即为最终位姿求解结果。

4 实验

4.1 仿真实验

仿真实验中,相机的参数设置如下:主点为[500 pixel,500 pixel],焦距为[1000 pixel,1000 pixel]。噪声设置为[0 pixel∶0.05 pixel∶1.00 pixel],角度测量误差为[0°∶0.05°∶1.00°],每个测量点仿真计算50次。

利用算法,可求解出旋转矩阵和平移向量的测量结果。与真值对比,计算得到旋转矩阵和平移向量测量误差的平均值、中间值及测量结果的均方差。旋转矩阵和平移向量误差的计算公式为

式中:Rgt、tgt为真值;‖tgt‖、‖t‖分别为tgt和t的二范数。

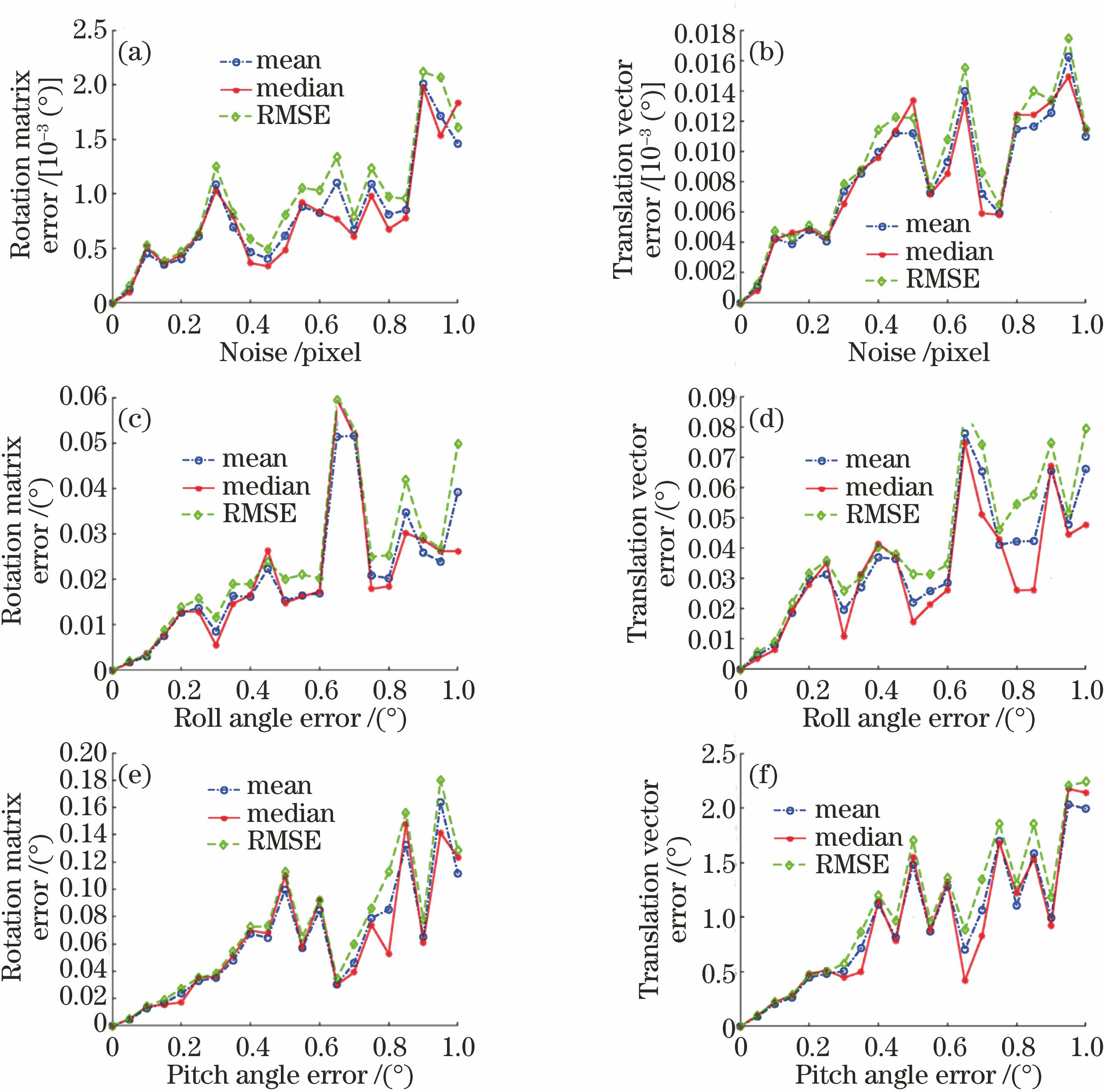

仿真结果如

图 3. 仿真实验结果。(a)(b)误差随噪声变化曲线;(c)(d)误差随滚转角测量误差变化曲线;(e)(f)误差随俯仰角测量误差变化曲线

Fig. 3. Results of simulation experiment. (a)(b) Residual value with varying noise; (c)(d) residual value with varying roll angle error; (e)(f) residual value with varying pitch angle error

4.2 实物实验

为研究点线特征结合算法在实物图像上的运行效果,实验利用Vicon[22]数据集来验证算法的可行性。具体流程如下。

4.2.1 直线匹配

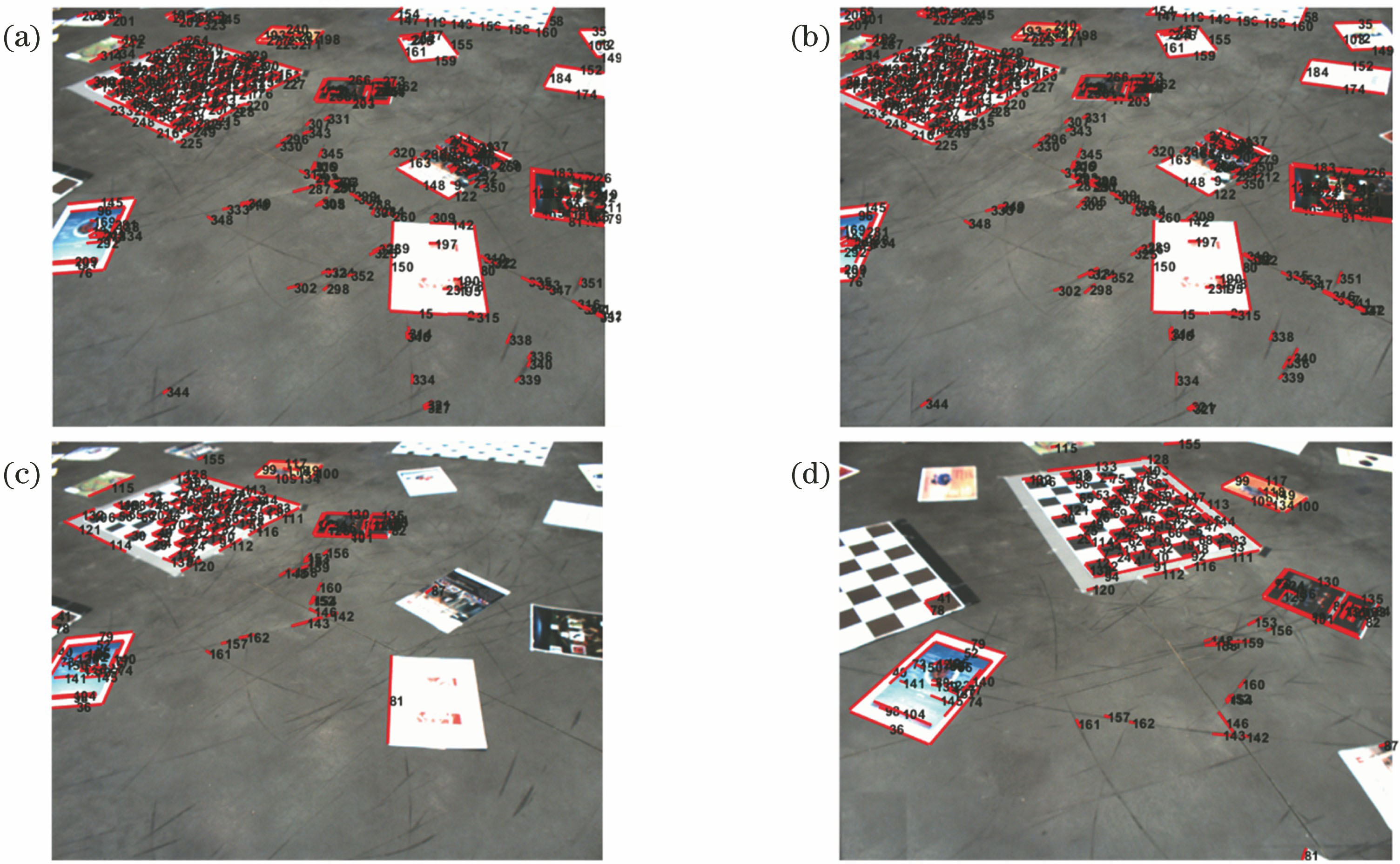

实物实验中,对Vicon数据集中的连续帧图像进行点线特征匹配。由于连续帧之间的相机运动变化不利于直观观察匹配效果,因此,选取第1帧图像分别和第5帧、第10帧图像进行匹配,结果如

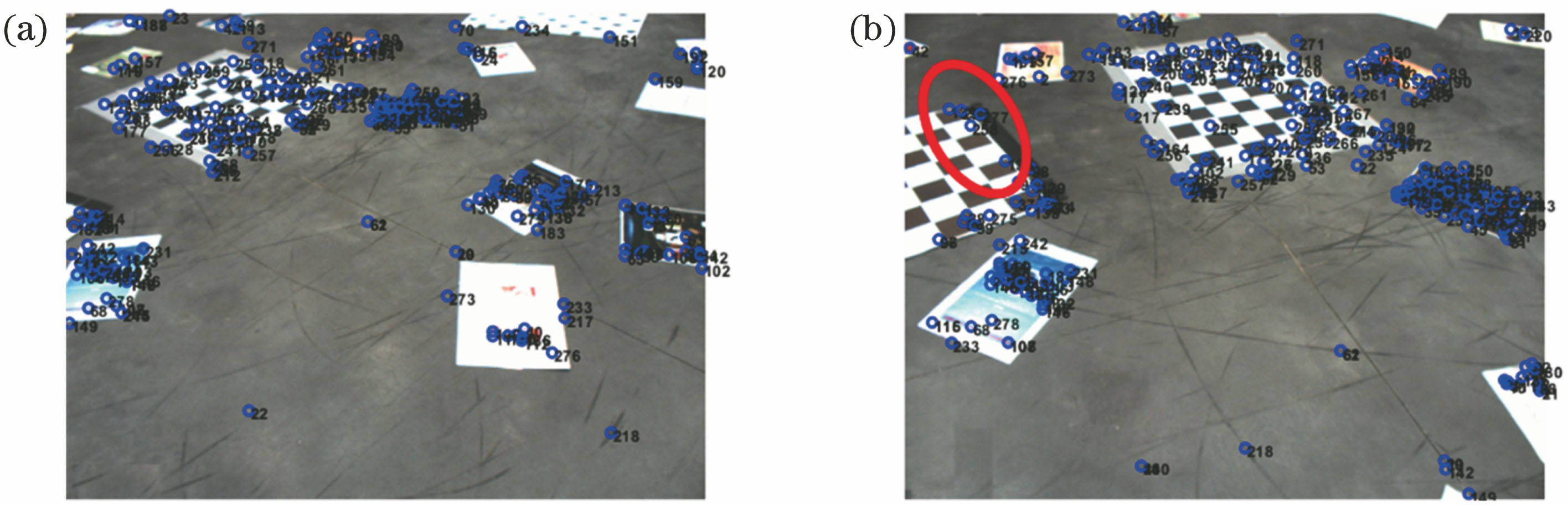

对第1帧和第10帧图像中的点特征进行检测和匹配,结果如

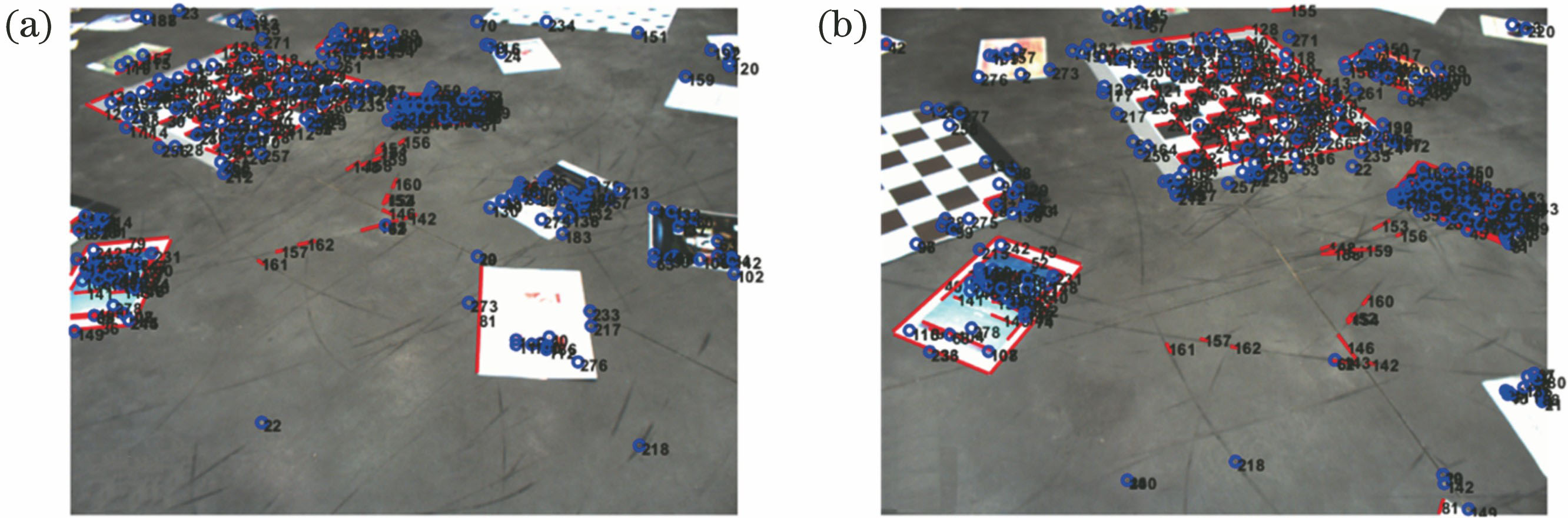

实验采用点线特征结合的方法,结果如

4.2.2 相机运动轨迹

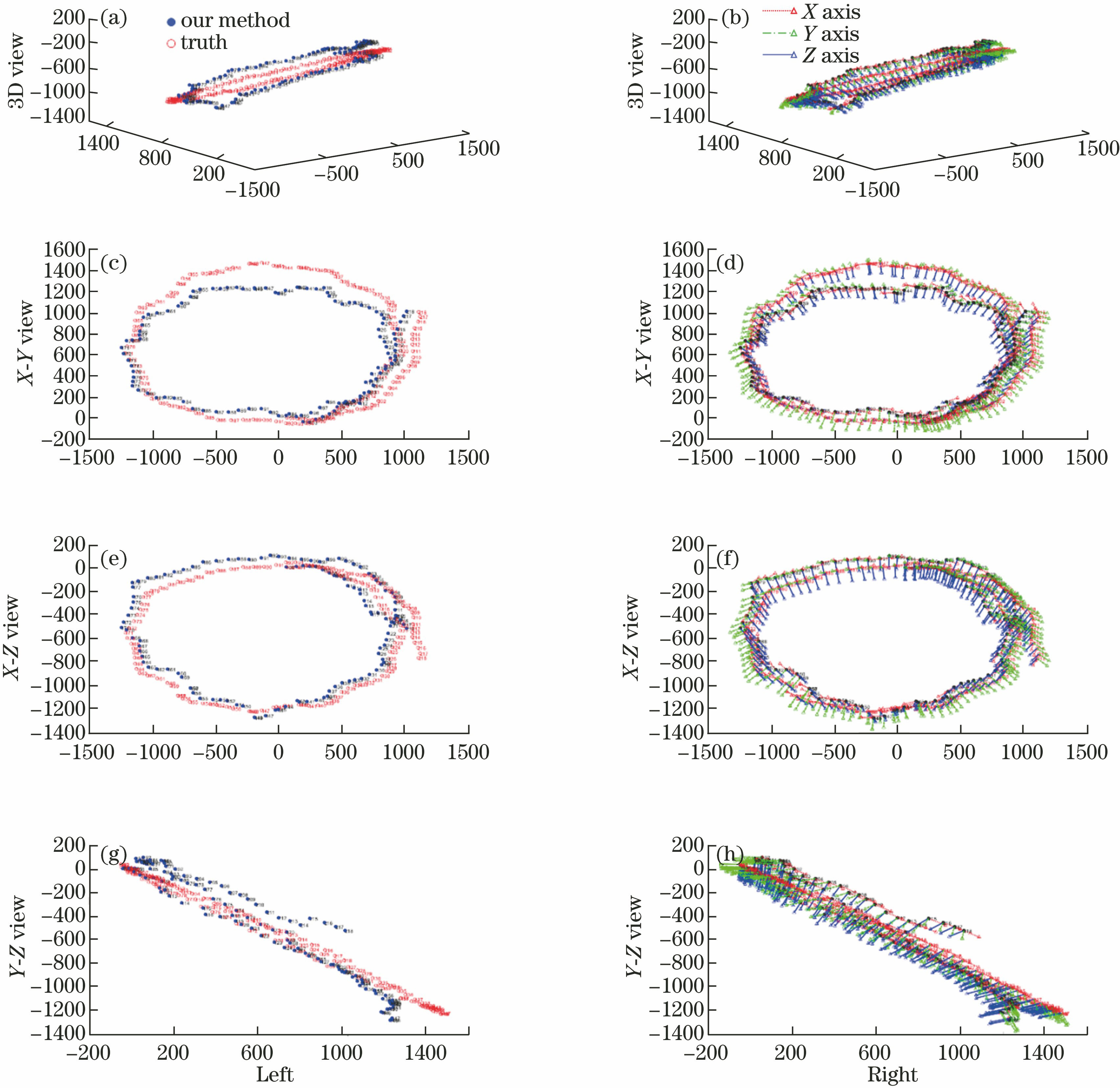

基于点线特征结合算法求解的相机运动轨迹结果如

图 4. 直线匹配结果。(a)(b)第1帧和第5帧的匹配;(c)(d)第1帧和第10帧的匹配

Fig. 4. Results of line matching. (a)(b) Matching results of 1st frame and 5th frame; (c)(d) matching results of 1st frame and 10th frame

图 5. 点特征的匹配结果。(a)第1帧;(b)第10帧

Fig. 5. Results of point matching. (a) 1st frame; (b) 10th frame

图 6. 点线特征的匹配结果。(a)第1帧;(b)第10帧

Fig. 6. Results of point-line matching. (a) 1st frame; (b) 10th frame

图 7. 相机运动轨迹。(a)(b)三维视图;(c)(d) X-Y视图;(e)(f) X-Z视图;(g)(h) Y-Z视图

Fig. 7. Track maps of camera movement. (a)(b) 3D view; (c)(d) X-Y view; (e)(f) X-Z view; (g)(h) Y-Z view

实验以数据集的第100帧为起点,画出相机运动轨迹,其形状类似于一个非规则圆形。相机运动轨迹在X轴、Y轴和Z轴的取值范围分别为[-1500 mm,1500 mm]、 [-200 mm,1600 mm]和[-1400 mm,200 mm]。比较相机运动轨迹,可验证平移向量t的准确性。在左图中,实心圆和空心圆的轨迹基本重合,说明轨迹的测量值和真值基本保持一致。

为验证旋转矩阵R的准确性,在轨迹的基础上添加相机坐标系的方向信息。在右图中,每帧相机实线轴的朝向与对应真值实线轴的朝向基本保持一致,可说明相机Z轴方向与真值基本吻合。同理,比较虚线轴和点划线轴朝向,可说明相机的X、Y轴方向也基本与真值吻合。

4.2.3 误差分析

对于平移向量的残差,由于相差一个尺度因子,所以采用平移向量之间的夹角来衡量平移向量结果的准确性。旋转矩阵和平移向量误差的计算公式等同于(29)式,误差结果如

表 1. 旋转矩阵和平移向量的残差

Table 1. Residual of rotation matrix and translation vector

| ||||||||||||||

从

5 结论

针对纹理不明显、角点少的场景,提出了基于惯性测量单元和点线特征结合的单目位姿测量算法。相比于仅依靠点特征的位姿求解方法,该算法能够充分利用场景的有效特征信息。同时,算法融合了惯性测量单元和视觉测量,仅利用1个匹配点和1条匹配线就能求解相机的运动轨迹和相机姿态,简单高效。通过仿真实验和实物实验,结果表明所提算法可有效地求解单目相对位姿。

[1] HartleyR, ZissermanA. Multiple view geometry in computer vision[M]. USA: Cambridge University Press, 2003.

[2] 沈峘, 李舜酩, 柏方超, 等. 路面车辆实时检测与跟踪的视觉方法[J]. 光学学报, 2010, 30(4): 1076-1083.

[3] 吴华, 秦世引. 基于视觉流形正则化的机器人实时定位新方法[J]. 光学学报, 2010, 30(1): 153-162.

[4] LemaireT, LacroixS. Monocular-vision based SLAM using line segments[C]∥Proceedings 2007 IEEE International Conference on Robotics and Automation, April 10-14, 2007, Roma, Italy. New York: IEEE, 2007: 2791- 2796.

[5] TamuraT, KurebayashiH, TanakaY, et al. High speed intelligent handling robot for food and pharmaceutical products[C]∥2009 IEEE Workshop on Advanced Robotics and its Social Impacts, November 23-25, 2009, Tokyo, Japan. New York: IEEE, 2009: 60- 64.

[6] Paschalidis IC, Li KY, Estanjini RM, et al. Intelligent forklift dispatching in warehouses using a sensor network[C]∥2009 17th Mediterranean Conference on Control and Automation, June 24-26, 2009, Thessaloniki, Greece. New York: IEEE, 2009: 112- 114.

[7] Ansar A, Daniilidis K. Linear pose estimation from points or lines[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2003, 25(5): 578-589.

[9] Bay H, Ess A, Tuytelaars T, et al. Speeded-up robust features (SURF)[J]. Computer Vision and Image Understanding, 2008, 110(3): 346-359.

[10] RubleeE, RabaudV, KonoligeK, et al. ORB: an efficient alternative to SIFT or SURF[C]∥Proceedings of IEEE International Conference on Computer Vision, November 6-13, 2011, Barcelona, Spain. New York: IEEE, 2011: 2564- 2571.

[11] Wang Z, Wu F, Hu Z. MSLD: a robust descriptor for line matching[J]. Pattern Recognition, 2009, 42(5): 941-953.

[12] ChumO, WernerT, MatasJ. Epipolar geometry estimation via RANSAC benefits from the oriented epipolar constraint[C]∥Proceedings of the 17th International Conference on Pattern Recognition, 2004. ICPR 2004., August 26-26, 2004, Cambridge, UK. New York: IEEE, 2004: 8206267.

[13] LoopC, Zhang ZY. Computing rectifying homographies for stereo vision[C]∥Proceedings. 1999 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (Cat. No PR00149), June 23-25, 1999, Fort Collins, CO, USA. New York: IEEE, 1999: 125- 131.

[15] 王可, 贾松敏, 李秀智, 等. 基于地面特征的移动机器人单目视觉里程计算法[J]. 光学学报, 2015, 35(5): 0515002.

[16] 何斐彦, 林嘉睿, 高扬, 等. 单目视觉与倾角仪组合优化的位姿测量系统[J]. 光学学报, 2016, 36(12): 1215002.

[17] JiaQ, Gao XK, FanX, et al. Novel coplanar line-points invariants for robust line matching across views[M] ∥Leibe B, Matas J, Sebe N, et al. Computer vision-ECCV 2016. Lecture notes in computer science. Cham: Springer, 2016, 9912: 599- 611.

[18] von Gioi R G, Jakubowicz J, Morel J M, et al. LSD: a fast line segment detector with a false detection control[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 32(4): 722-732.

[19] Zhang L, Koch R. An efficient and robust line segment matching approach based on LBD descriptor and pairwise geometric consistency[J]. Journal of Visual Communication and Image Representation, 2013, 24(7): 794-805.

[20] Guan B, Yu Q, Fraundorfer F. Minimal solutions for the rotational alignment of IMU-camera systems using homography constraints[J]. Computer vision and image understanding, 2018, 170: 79-91.

[21] FraundorferF, TanskanenP, PollefeysM. A minimal case solution to the calibrated relative pose problem for the case of two known orientation angles[M] ∥Daniilidis K, Maragos P, Paragios N. Computer vision-ECCV 2010. Lecture notes in computer science. Berlin, Heidelberg: Springer, 2010, 6314: 269- 282.

[22] Saurer O, Vasseur P, Boutteau R, et al. Homography based egomotion estimation with a common direction[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(2): 327-341.

[23] Lee GH, FaundorferF, PollefeysM. Motion estimation for self-driving cars with a generalized camera[C]∥2013 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2013, Portland, OR, USA. New York: IEEE, 2013: 2746- 2753.

[24] Azuma R, Baillot Y, Behringer R, et al. Recent advances in augmented reality[J]. IEEE Computer Graphics and Applications, 2001, 21(6): 34-47.

[25] Nützi G, Weiss S, Scaramuzza D, et al. Fusion of IMU and vision for absolute scale estimation in monocular SLAM[J]. Journal of Intelligent & Robotic Systems, 2011, 61: 287-299.

[26] Guan BL, VasseurP, DemonceauxC, et al. Visual odometry using a homography formulation with decoupled rotation and translation estimation using minimal solutions[C]∥2018 IEEE International Conference on Robotics and Automation (ICRA), May 21-25, 2018, Brisbane, QLD, Australia. New York: IEEE, 2018: 2320- 2327.

Article Outline

李涛, 关棒磊, 张家铭, 孙放, 尚洋. 基于点线特征结合的单目相对位姿测量方法[J]. 激光与光电子学进展, 2020, 57(8): 081102. Tao Li, Banglei Guan, Jiaming Zhang, Fang Sun, Yang Shang. Relative Pose Measurement Method for Monocular Cameras By Combining the Point and Line Features[J]. Laser & Optoelectronics Progress, 2020, 57(8): 081102.