基于视觉导航的输电线杆塔方位确定方法  下载: 1285次

下载: 1285次

1 引言

由于电力线基础设施长期受到自然界风、雨等的侵蚀,杆塔倾斜、绝缘子爆裂、均压环螺丝脱落等电力部件损坏的现象频繁出现,巡检人员必须对其进行周期性地检查,其中最主要的是对电力线与杆塔连接部件的局部进行巡检。随着多旋翼无人机(UAV)技术的快速发展,其在电力巡检领域有着越来越广泛的应用,极大地提高了高压输电线路的维护效率。但是UAV在电力巡检作业时,巡检人员不仅需操控UAV安全地飞行,还要操作UAV上安装的相机设备,对杆塔进行有效地拍摄。这使得巡检人员获取高质量的巡检图像的难度较大,在对一条线路多次巡检时不能保证获所取的巡检图像的质量是相同的。

杆塔具有丰富的直线特征,大多数研究者通过提取无人机航拍图像中的直线特征来检测杆塔[1-3]。Cheng等[1]使用一种基于graph-cut的图分割方法检测电力线杆塔区域,这种图分割方法适用于检测低压线路的杆塔。Han等[2]使用一种模板匹配的方法,将提取到的杆塔直线特征和预先构建好的杆塔模板库进行匹配,检测拍摄图像中的杆塔目标。该方法事先使用聚类和投影来构建杆塔的方位模板库,但是其所使用的直线段检测(LSD)方法是一种局部方法,易受到噪声的干扰,无法处理杆件交叉导致的直线段断开的情况。Cetin等[3]提出一种通过提取航拍图像中杆塔阴影区域的特征来检测杆塔的方法。由于该方法依赖于杆塔阴影,因此其实际应用中受到了较大的限制。除了直线特征之外,也有些研究者使用特征点来检测杆塔,如角点特征、ORB(Oriented Features from Accelerated Segment Test and Rotated Brief)有向旋转描述特征等。Golightly等[4]抛弃了使用线特征的检测方法,基于杆塔的角点和边缘对杆塔进行识别,但是该方法主要适用于检测小型普通低压电力线杆塔。Cerón等[5]使用基于网格的二维ORB描述符来对电力线杆塔的线性结构进行检测,将对应区域的特征输入分类器进行分类。该方法可实现对杆塔的实时检测。该方法由于使用了FAST角点特征和Brief描述子,没有对区域内部整体特征统计分析,因此该方法无法识别杆塔的方位。

近年来,随着深度学习在目标检测中的发展,有一些研究者将深度学习引入杆塔检测中来。Hui等[6]使用深度学习方法Faster RCNN(Regions with Convolutional Neural Networks)[7]对杆塔进行目标检测,并结合KCF[8](Kernel Correlation Filter)核相关滤波器目标跟踪算法对杆塔进行跟踪,实现了利用无人机对杆塔目标的自动巡检。然而,Faster RCNN方法实际处理速度慢,且无法避免杆塔检测失败的情况。因此,Zhao等[9]在Ren等[7]研究的基础上将检测过程和跟踪过程做了融合,实现了更稳健的电力线检测与跟踪。由于仍然使用Faster RCNN方法对杆塔进行检测,Zhao等的结果在处理速度和识别效果上并没有实质性提升。以上分析可以发现,现有的杆塔的检测方法仅仅实现了杆塔的全局检测或者跟踪,并没有实现对杆塔方位的分类和识别,也没有对电力线与杆塔连接处的局部进行检测。

在杆塔巡检过程中,人们感兴趣的其实主要是杆塔与导线的连接区域。在杆塔巡检中首先要确定当前待巡检的杆塔,而后操控无人机靠近要巡检的杆塔并完成对杆塔局部细节的拍摄。基于这种在全局拍摄的基础上再对局部进行特写拍摄的模式,本文根据杆塔内部不同长度、位置、方向的钢件及其之间的梯度信息提出一种由远及近的杆塔检测方法。该方法结合杆塔的HOG特征,使用多层感知机(MLP)对杆塔方位进行识别,进而对电力线和杆塔连接部件进行检测,最终实现了利用无人机由远及近对杆塔部件的自动跟踪与拍摄。

2 由远及近的杆塔检测方法

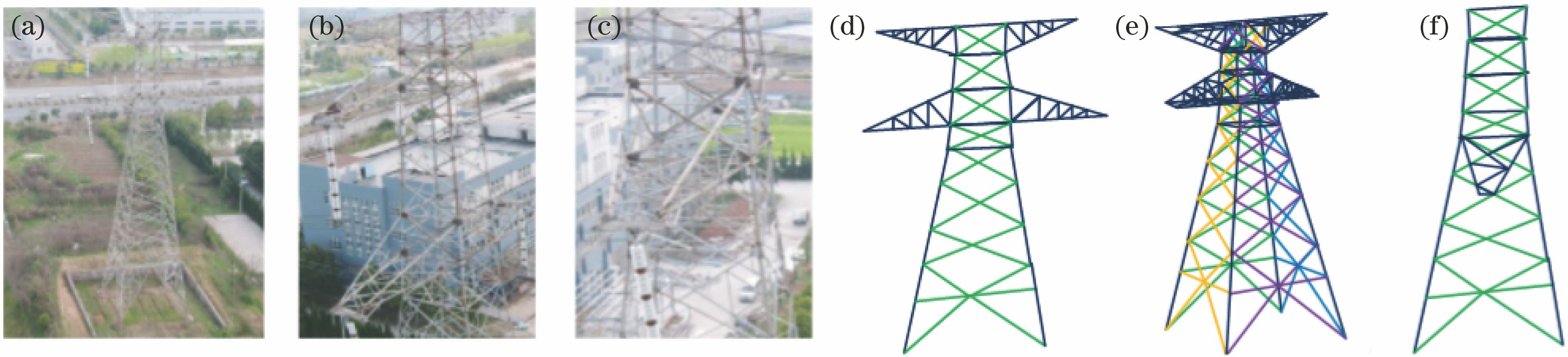

在电力线巡检任务中,无人机拍摄的杆塔图像如

图 1. 杆塔的航拍图像与示意图。(a)正视图像;(b)正侧面图像;(c)侧面图像;(d)正视示意图;(e)正侧面示意图;(f)侧面示意图

Fig. 1. Aerial images and diagrams of towers. (a) Front image; (b) front side image; (c) side image; (d) front view diagram; (e) front side view diagram; (f) side view diagram

从输电线路结构分析,其主要有两种类型的杆塔:一种是直线杆塔,另一种是耐张杆塔。两种杆塔在主体结构上是相同的,在导线与杆塔的连接方式上有所不同,如

图 2. 导线穿过直线杆塔时所形成的折线

Fig. 2. Broken lines formed when wire passing through straight tower

图 3. 耐张杆塔中引流线与导线位置的关系

Fig. 3. Location relationship between guiding lines and wires in tensile tower

从铁塔内部结构分析,每个面上的钢件呈规则性排列,在每个面上安装的钢件具有平行及相互交叉的特征。同时,不同面上的钢件会聚到塔架上时呈现出交叉“X”型结构、“K”型结构等不同的特征,如

图 4. 杆塔结构特征。(a)塔头处的交叉斜线段;(b)(c)塔身上的斜线段会聚到主框架;(d)(e)塔内交叉特征

Fig. 4. Structural characteristics of tower. (a) Cross slanted segments of tower head; (b)(c) slanted segments converged onto main frame of tower body; (d)(e) crossing characteristics in tower

综合考虑了无人机对杆塔的拍摄方式及杆塔3D镂空结构的特点,本文提出一种由远及近的杆塔检测框架。如

第1阶段,图像训练。提取对3种不同方位的杆塔图像的HOG特征,并将其输入到MLP训练神经网络模型。

第2阶段,杆塔检测。将无人机在不同方位下拍摄的杆塔图像输入到预训练好的网络模型中,检测杆塔方位。

第3阶段,局部细节巡检。调整无人机的姿态,并对杆塔局部目标(如:均压环、绝缘子等部件)进行拍摄与检测。

3 HOG特征提取与方位、区域检测

HOG特征在图像分类识别方面也有一些应用,如:文献[ 10-11]。本文基于杆塔不同方位下的结构特征,使用杆塔区域内的梯度方向直方图特征,构建相应的描述子。该方法分为训练、检测两个阶段。在训练阶段,提取不同方位下杆塔的梯度方向特征,将统计得到梯度方向特征的描述向量输入到MLP中,训练分类器模型。检测阶段分为两步。第1步,输入无人机拍摄到的杆塔图像,提取杆塔区域的HOG特征描述,并将其输入到分类器中进行分类,检测当前杆塔方位。使用基于图像的视觉伺服[12]方法,根据无人机坐标系与相机等部件坐标系之间的转换关系构建无人机动态模型,通过求解非线性优化问题来计算无人机的最佳飞行轨迹,并调整无人机的飞行姿态。第2步,使用文献[ 13]中的方法找到电力线与杆塔连接位置,对杆塔部件细节进行拍摄。

3.1 杆塔HOG特征提取

参考Dalal等[14]提出的方法,物体的局部外观和形状通常可以通过梯度的强度或者边缘的分布来描述。HOG特征是一种在计算机视觉和图像处理中进行物体检测的描述子,通过计算和统计图像局部区域梯度的方向直方图来构成特征。

以无人机悬停时采集到的RGB图像作为输入,经过图像预处理、分类检测等步骤后输出图像中的杆塔信息,即是否包含杆塔、杆塔所在位置及杆塔类型。提取杆塔区域后对图像进行预处理,将RGB图像转换为灰度图像。经过直方图均衡化后对图像进行目标增强,采用Sobel边缘提取算法提取图像边缘。这可用于计算像素点(

式中:

这些区间是互有重叠的,每一个单元格的特征会以不同的结果多次出现在最后的特征向量中,通过这种归一化的处理可得到该block描述向量,即杆塔区域特征的HOG描述符。通常使用的HOG结构大致有3种:矩形HOG、圆形HOG和中心环绕HOG。Dalal等的实验证明矩形HOG和圆形HOG的检测效果基本一致,而环绕形HOG效果相对较差[15],因此本文采用矩形HOG方式提取杆塔局部位置的HOG特征的向量描述。

3.2 多层感知机方位分类

MLP的结构如

图 9. HOG特征提取和MLP感知模型分类

Fig. 9. HOG feature extraction and MLP perception model classification

4 杆塔细节巡检

一般地,无人机将遥控信号提供的方位值

设

式中:

式中:

5 实验验证

所提算法通过QT编写的C++代码实现,并在CPU为2 GHz 四核ARM A57,内存为8 G的NVIDIA Jetson TX2上运行。搭建如

5.1 数据集准备

数据集来源于无人机高清摄像头采集的图像,季节上包含了春夏秋冬4个季节。图像原始分辨率为4096 pixel×2160 pixel,所以先将图像分辨率降低至1024 pixel×540 pixel,再从原始图像中裁剪出目标或背景区域。样本图像大小为64 pixel×128 pixel,制作成自己的数据集,最终得到1500张训练样本(包含150张背景、1350张3个部位各3类方位的杆塔图像,其中每个部位有150张图像),900张杆塔图像(每类100张图像)和100张背景图像用于训练,剩下每类50张图像用于测试,得到如

图 10. 无人机视觉感知平台及在不同方位下杆塔局部区域。(a)无人机视觉感知平台;(b1)正面塔顶;(b2)正侧面塔顶;(b3)侧面塔顶;(c1)正面塔身;(c2)正侧面塔身;(c3)侧面塔身;(d1)正面塔底;(d2)正侧面塔底;(d3)侧面塔底

Fig. 10. Visual perception platform for UAV and local areas of tower under different orientations. (a) Visual perception platform for UAV; (b1) front of tower top; (b2) front side of tower top; (b3) side of tower top; (c1) front of tower body; (c2) front side of tower body; (c3) side of tower body; (d1) front of tower bottom; (d2) front side of tower bottom; (d3) side of tower bottom

5.2 评价指标

实验室先前已经采用了Faster RCNN目标检测网络对杆塔识别和检测,本文则采用基于HOG特征的杆塔方位检测方法,并从准确率、识别速度两个维度对两种方法进行比较。准确率为目标方位类别识别正确的样本数目与该类所有样本的总数之比;识别速度为样本从输入网络到输出识别的方位结果所需要的时间。实验过程中,分别记录每一类方位识别的准确率和识别时间。

5.3 实验结果对比分析

实验使用caffe框架实现Faster RCNN卷积神经网络,使用5.1节中构建的数据集对Ren等[7]在ImageNet[19]上预训练好的模型进行微调。实验所设置的网络参数与Ren等[7]使用的参数典型值基本一致,即dropout比例为0.6,非极大值抑制(NMS)前后proposal提议区域数分别为2000和300,anchor数为9,学习率为0.001,权重衰减率为0.0005,批处理尺寸为128,最终分类输出类别为3类。MLP网络为3层,输入层为最终提取到的HOG特征,隐藏层有6个神经元,输出层有3个神经元,使用反向传播方法训练网络模型。使用5.1节中准备的数据集进行训练、测试。

如

表 1. 杆塔局部区域方位识别的准确率

Table 1. Accuracy rate of identification of local area orientation of tower

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

如

表 2. 杆塔局部区域方位识别所需时间

Table 2. Time required for identification of local area orientation of towerms

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

5.4 数据增广

对5.1节中的数据集作镜像、加高斯噪声处理,扩大样本集,使用增广后的数据集再次对Faster RCNN模型进行微调,对MLP模型进行训练。训练参数与5.4节一致。使用测试集对模型进行重新测试,结果如

由

表 3. 数据增广后杆塔局部区域方位识别的准确率

Table 3. Accuracy rate of local area orientation of tower after data augmentation

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

表 4. 数据增广后杆塔局部区域方位识别所需时间

Table 4. Time required for local area orientation of tower after data augmentationms

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

6 结论

无人机在行业领域的拍摄内容主要是野外建造的人造设施,拍摄方式需以精准路径及角度来特写人造设施。研究了一种由远及近的杆塔检测方法:1)基于杆塔地理位置信息和无人机地理位置信息建立无人机的控制规则;2)分析杆塔自身及其位置方位特点,并结合杆塔部件区域在不同方位下的不同梯度特征,构建出杆塔区域HOG特征描述符;3)使用MLP模型对HOG特征进行分类,并识别杆塔区域的方位。实验表明,在无人机执行巡检任务时,通过提取出不同方位下杆塔区域的不同HOG特征描述,可实现对杆塔的快速巡检。本文所提出的方法在检测准确率上较Faster RCNN方法最大提高了27.9%,运算时间缩短70.6%,并且具有一定的普适性。但是,对于无人机在识别杆塔局部区域方位后如何更稳健地用于视觉伺服,本文并没有很好地解决,所以,下一步研究的重点是杆塔区域方位与无人机的视觉反馈控制。

[1] ChengW, SongZ. Power pole detection based on graph cut[C]∥2008 Congress on Image and Signal Processing, May 27-30, 2008, Sanya, Hainan, China. New York: IEEE, 2008, 3: 720- 724.

[2] 韩冰, 尚方. 面向无人机输电线路巡检的电力杆塔检测框架模型[J]. 浙江电力, 2016, 35(4): 6-11.

[3] CetinB, BikdashM, McInerney M. Automated electric utility pole detection from aerial images[C]∥IEEE Southeastcon 2009, March 5-8, 2009, Atlanta, GA, USA. New York: IEEE, 2009: 44- 49.

[6] Hui XL, BianJ, Yu YJ, et al. A novel autonomous navigation approach for UAV power line inspection[C]∥2017 IEEE International Conference on Robotics and Biomimetics (ROBIO), December 5-8, 2017, Macau, China. New York: IEEE, 2017: 634- 639.

[9] Hui XL, BianJ, Zhao XG, et al. Deep-learning-based autonomous navigation approach for UAV transmission line inspection[C]∥2018 Tenth International Conference on Advanced Computational Intelligence (ICACI), March 29-31, 2018, Xiamen, China. New York: IEEE, 2018: 455- 460.

[10] 雷洁, 傅建平, 张培林. 线膛火炮内膛疵病图像分类研究[J]. 激光与光电子学进展, 2011, 48(12): 121002.

[11] 徐岩, 韦镇余. 一种改进的交通标志图像识别算法[J]. 激光与光电子学进展, 2017, 54(2): 021001.

[12] PotenaC, NardiD, PrettoA. Effective target aware visual navigation for UAVs[C]∥2017 European Conference on Mobile Robots (ECMR), September 6-8, 2017, Paris, France. New York: IEEE, 2017: 1- 7.

[13] 韩军, 张晶晶, 王滨海. 基于感知组织的输电线路结构识别方法[J]. 红外与激光工程, 2013, 42(12): 3458-3463.

[14] DalalN, TriggsB. Histograms of oriented gradients for human detection[C]∥2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR'05), June 20-25, 2005, San Diego, CA, USA. New York: IEEE, 2005: 886- 893.

[15] DalalN. Finding people in images and videos[D]. Grenoble: Institut National Polytechnique deGrenoble-INPG, 2006: 1- 8.

[16] 吴显亮, 石宗英, 钟宜生. 无人机视觉导航研究综述[J]. 系统仿真学报, 2010, 22(s1): 62-65.

[17] 王亚先. 基于电力巡检的视觉测距与视觉定位的研究[D]. 上海: 上海大学, 2017: 17- 27.

Wang YX. Research on visual ranging and visual positioning based on electric power inspection[D]. Shanghai: Shanghai University, 2017: 17- 27.

[18] 薛伟霖. 四旋翼无人机姿态控制的研究[D]. 沈阳: 沈阳工业大学, 2016: 6- 29.

Xue WL. Research of quadrotor UAV flight attitude control[D]. Shenyang: Shenyang University of Technology, 2016: 6- 29.

[19] DengJ, DongW, SocherR, et al. ImageNet: A large-scale hierarchical image database[C]∥2009 IEEE Conference on Computer Vision and Pattern Recognition, June 20-25, 2009, Miami, FL, USA. New York: IEEE, 2009: 248- 255.

Article Outline

王祖武, 韩军, 孙晓斌, 杨波. 基于视觉导航的输电线杆塔方位确定方法[J]. 激光与光电子学进展, 2019, 56(8): 081006. Zuwu Wang, Jun Han, Xiaobin Sun, Bo Yang. Methodfor Orientation Determination of Transmission Line Tower Based on Visual Navigation[J]. Laser & Optoelectronics Progress, 2019, 56(8): 081006.