基于循环生成对抗网络的大视场显微成像方法  下载: 520次

下载: 520次

In traditional optical microscopes, large field of view and high resolution cannot be achieved at the same time. Large numerical aperture objective lens is necessary to obtain high-resolution images, which will inevitably lead to the reduced imaging field of view. Similarly, a small numerical aperture objective lens should be employed to obtain a large imaging field of view, and the corresponding imaging resolution will inevitably decrease. Therefore, when the traditional optical microscope is adopted, a trade-off is needed between imaging resolution and imaging field of view, and it is impossible to obtain large field of view and high-resolution microscopic images simultaneously. With the rapid development of deep learning technology, different algorithm models are designed based on deep learning, and the corresponding pathological cell models are diagnosed in combination with the evaluation and guidance of professional doctors to yield computer-aided calculation and detection effects. Therefore, this paper proposes a method to generate matching high-resolution virtual stained images from low-resolution stained images with large field of view using cycle generative adversarial networks (Cycle-GANs), without changing the optical systems and detector devices. Only ordinary microscopes are employed to obtain staining images with large field of view, and it is unnecessary to convert the multiple objectives to obtain high-resolution images. Virtual high-resolution staining images at any position of the large field of view can be predicted through network model calculation, and the high resolution and large field of view can be realized at the same time.

In this paper, Cycle-GANs are employed to complete the experiment. Firstly, the data set preparation is carried out, and the unpaired and paired data sets of images under multiple objectives are collected respectively to constitute the training and testing parts of the network model. Secondly, a theoretical pre-experiment is conducted. The resolution of the same stained onion epidermal cell images is scaled to simulate the reduction of image resolution. The resolution of the input images is verified to have a lower limit, and the field of view of the microscope cannot be infinite in actual observation. Then, through imaging and testing the resolution testing board, the experiment of generating 25 times high-resolution virtual images from 10 times low-resolution images is carried out, which proves that Cycle-GANs networks can improve the image resolution. Finally, experiments are carried out to generate 25 times high-resolution virtual staining images corresponding to 10 times and 4 times low-resolution real staining images using stained onion epidermal cells. The corresponding values and results are obtained through subjective vision and objective evaluation indicators.

In the experiment of grading and scaling the resolution of the same stained onion epidermal cell images (Fig. 4), the fitting curves of structural similarity index (SSIM) and peak signal-to-noise ratio (PSNR) decrease with the reducing image resolution, while those of normalized root mean square error (NRMSE) increase with the decreasing image resolution (Fig. 5). With the resolution reduced by 32 times, the SSIM value lower than 0.5, and the PSNR value lower than 20, the images can no longer be correctly resolved by human eyes, which proves that the image resolution cannot be infinitely reduced. Then, in the experiment of generating 25 times high-resolution virtual images from 10 times low-resolution images on a resolution testing board (Fig. 6), low-resolution images under 10 times objective in the second row in Fig. 6 are generated by the algorithm as shown in the third row in Fig. 6. The sets of the fourth column and fifth column of the resolution testing board can be well resolved by human eyes, which shows the improvement of image resolution. Finally, in the experiment of generating 25 times high-resolution virtual stained images corresponding to 10 times low-resolution real stained images of onion epidermal cells (Fig. 7), the maximum SSIM, the maximum PSNR, and the minimum NRMSE are 0.684, 23.523 dB, and 0.131, respectively. In the experiment of generating 25 times high-resolution virtual images from 4 times low-resolution images (Fig. 8), the SSIM and PSNR can be as high as 0.597 and 22.322 dB, and the NRMSE is as low as 0.180. Under the analysis of subjective vision or objective evaluation indicators, the results of virtual stained images generated based on Cycle-GANs are close to those of real bright-field stained images under the measurement of various indicators.

Traditional optical microscopes cannot combine large field of view with high resolution. Therefore, this paper proposes a method to generate matching high-resolution virtual stained images from low-resolution stained images with large field of view by Cycle-GANs. This can transform low-resolution stained images with low-power bright field into matching high-power virtual stained high-resolution images. Experimental results show that the characteristic information, such as organelle structures in the bright-field stained images of onion epidermis cells, can be extracted effectively by Cycle-GANs. Finally, virtual cell staining is realized, and staining damage to the tissues is reduced. Additionally, the large field of view and high resolution of the traditional optical microscope can be considered at the same time by inputting low-resolution stained images with a large field of view and outputting high-resolution virtual stained images with a high similarity to high-resolution real stained images with a small field of view. Finally, the differences between the generated virtual stained images and real bright-field stained images are evaluated by subjective vision and objective evaluation indicators. The results show that the virtual stained images generated by Cycle-GANs and real stained images are highly similar under the measurement of various indicators. Therefore, this method can meet the large field of view and high resolution of traditional microscopes. When applied to real life, it can reduce the costs and the burden of doctors and is of great significance in biomedical cell research.

1 引言

在传统的光学显微镜中,大视场和高成像分辨率二者往往无法同时兼顾。若要获得高分辨率图像,则需采用大数值孔径物镜,这必然会导致成像视场的减小。同理,若想获得较大的成像视场,则需采用小数值孔径物镜,相应的成像分辨率必然会降低。因此,在使用传统光学显微镜时,必须在成像分辨率与成像视场之间进行权衡,无法同时获得视场大且分辨率高的显微图像。生物细胞作为有机体最基本的结构和单位,一直是医学和生物界研究的重要目标[1],其中对细胞结构进行采集并分析的一个重要的工具就是光学显微镜。因此,实现一次性获取大视场、高分辨率的图像在医学细胞成像领域中具有重要意义。

随着医学领域相关技术的飞速发展,对同类细胞进行检测的需求日益增大。例如,通过观察癌症患者的细胞是否发生病变来判断患者的身体状况是否良好,或是通过检测癌变细胞的数量来判断患者的康复情况。然而,在实际观测中:1)由于细胞本身具有很强的相似性,因此在大量正常细胞中观测病变细胞需要耗费大量人力和物力;2)基于长时间检测后细胞易失活死亡的特性,快速、高效率地观测细胞是否发生病变仍然是一个亟待解决的问题;3)细胞生物学的建立和发展都离不开显微技术,观测细胞最常用的工具是光学显微镜,但光学系统或图像采集系统会在一定程度上限制细胞观测,使得大视场和高分辨率的要求无法同时满足。

在实际观测的过程中,由于大多数细胞具有无色透明、体积极小的特征,故直接用普通光学显微镜进行观察时,细胞和背景反差很小,图像边缘不清晰,难以看清细胞的形态,且细胞的组成与结构不易分辨。因此,在观测前往往需要对细胞进行染色,借助颜色的反衬作用实现更清楚的观察。然而,染色剂会扰乱活体细胞正常的分裂和生命活动,破坏细胞结构,在不能满足细胞实时检测需求的同时还会造成细胞的浪费[1]。

近年来,随着计算机、人工智能和互联网的发展,医疗信息化、数字化的实现成为可能,深度学习技术在图像超分辨领域中取得了许多重大成果[2-4]。基于深度学习设计不同算法模型,结合专业医生评价与指导,诊断相应病变细胞,达到计算机辅助计算、检测的效果。鉴于此,本文提出采用循环生成对抗网络(Cycle-GANs)来对所采集的数据进行训练并测试,在不改变光学系统和探测器等设备的条件下,仅需通过普通显微镜获取大视场染色图像,不需要进行物镜倍数转换来获取高分辨率图像,通过网络模型计算即可预测出大视场中任意位置的虚拟高分辨率染色图像。实验结果显示,无论是通过主观感受评价还是通过客观评价指标衡量,在大视场、低分辨率的基础上均可得到与小视场、高分辨率的真实图像相似度极高的图像,实现了大视场与高分辨率二者的统筹兼顾。

2 算法理论与模型

2.1 基于深度学习的图像超分算法

随着人工智能的发展与信息技术的革新,机器学习在各项领域中都发挥了极其突出的作用。在许多计算机视觉任务上,计算机视觉技术都已具备了远远超过现代人的能力。机器学习被广泛应用于机器视觉、图像处理等领域中,如图像生成、图像融合、图像分割、图像去噪和图像超分辨率重建等[5-14]。基于深度学习的图像超分算法在近年来发展迅速。图像超分算法先学习高分辨率与低分辨率之间的映射关系,再利用所学的映射模型实现分辨率提升。其中,基于卷积神经网络的超分辨率重建模型(SRCNN)[15]被最早用于图像超分辨算法中。这种方法比传统方法效果更好,但是SRCNN只适用于单一尺度,同时还伴随着训练收敛速度慢、计算量大等问题,故训练速度较慢。

当网络深度训练到一定程度时,误差升高的同时梯度消失现象变得更加明显,后向传播无法将梯度反馈到前面的网络层中,前面网络参数无法更新,从而导致训练变差。因此,增强型深度超分辨率重建算法(EDSR)[2]被提出,其移除了批处理归一化层,降低了计算复杂度和算法运行占用的内存资源,但EDSR的训练速度依旧没得到很大的提升,这大大影响了图像的超分辨效率。

卷积神经网络虽然在解决图像超分辨问题上有了很大的突破,但由于其采用均方误差作为目标函数,该误差函数忽略了高频信息特征,故重建后的图像与人眼视觉观察到的图像不符。针对此问题,Ledig等[4]首次将生成对抗网络(GANs)引入图像超分辨率重建问题中,提出了基于GANs的图像超分辨率重建算法(SRGAN),该算法打破了人眼感官视觉的局限,成为了第一个将图像放大4倍且与原始图像的相似度很高的算法。然而,由于该算法的生成器网络模型中没有注意力机制,故图像特征表达能力不足,且以 LeakyReLU函数作为激活函数的激活层对不大于0的图像信息数据泛化能力不够,甚至可能出现梯度爆炸。

相较于上述图像超分辨方法,Cycle-GANs算法因其出色的迭代优化能力与快速的训练收敛速度在众多超分辨算法中脱颖而出。Cycle-GANs网络不需要一一对应的配准数据集即可实现图像风格转换,其由两个镜像GANs组成,两个网络中的生成器、判别器和循环一致性损失函数使得生成的虚拟图像与真实图像在分辨率级别上的差距缩到最小,并且能够保证生成图像与真实图像的颜色一致。

2.2 生成对抗网络

机器学习算法大致可以分为监督学习和无监督学习两类[16]。监督学习的成本高昂,所需数据必须带有标记,故无监督学习逐渐受到大众青睐,其中GANs作为一种新兴的无监督学习生成模型一经提出便备受关注。Goodfellow等[17]提出了GANs,其在计算机视觉、医学、自然语言处理和风格迁移等领域中的表现非常出色。Wang等[18]使用一种样式和结构模型(S2-GAN),生成了具有不同风格和结构的图像。Yu等[19]提出了基于补丁的GANs丢失模型(SN-PatchGAN),构建了一个快速稳定的生成式图像修复系统。Tulyakov等[20]利用视频生成的运动和内容分解模型(MoCoGAN)实现了视频生成,提高了生成结果的连续性。Koo等[21]使用深度卷积生成对抗网络模型(DCGAN)实现了对黑白照片的着色。Schlegl等[22]使用真实数据概率分布和生成数据的相似度模型(WGAN)对病变的视网膜相干断层扫描成像数据进行了检测。

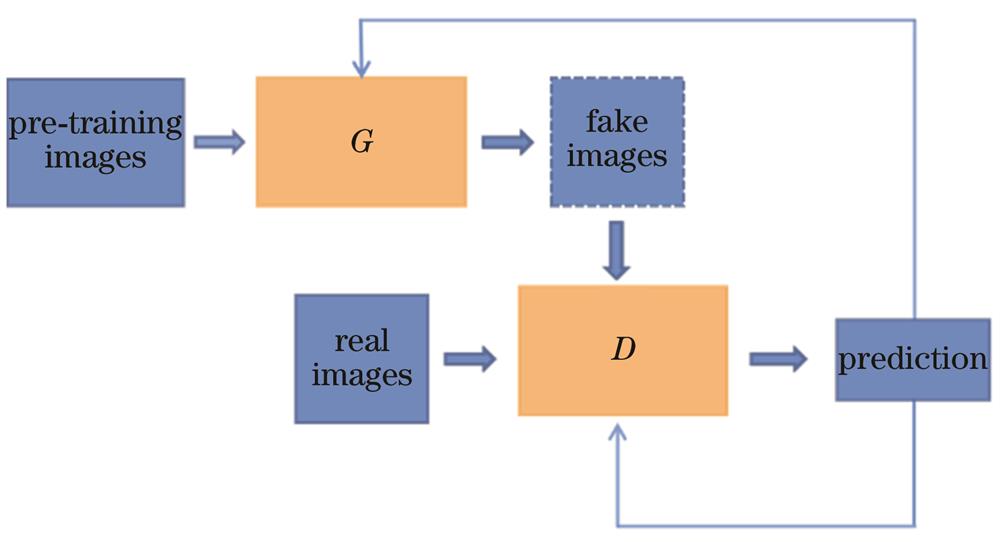

GANs是一种类似于对抗博弈游戏的训练网络,来源于博弈论中的二人零和博弈思想[23],两个神经网络以相互博弈的方式来进行学习和优化,通过数次迭代后模型达到纳什平衡状态[24]。GANs由生成器G和判别器D两个重要部分组成。生成器G主要是生成和真实图像相近似的虚拟图像,判别器D则是判别由G生成的虚拟图像和由数据集获取的真实图像。G和D通过对抗训练来实现迭代优化,不断更新相关网络参数,使得G生成的虚拟图像最大可能地接近真实图像。当判别器D每次输出的概率基本为0.5时,模型达到了纳什均衡状态。GANs的模型结构如

2.3 循环生成对抗网络

2017年,Zhu等[5]基于GANs的理论,提出了一种Cycle-GANs,其模型结构如

Cycle-GANs是无监督学习的代表,可不断学习模拟数据的分布进而生成和训练数据具有相似分布的样本。在

设从X到Y的映射为G,其对应GANs中的生成器G,G的作用是使生成的图像G(x)尽可能地相似于Y中的图像。然而,对于G所生成的图像G(x),还需通过GANs中的判别器DY来区分生成的虚拟图像G(x)与真实图像y,即X到Y的映射和判别器DY的表达式为

式中:x~P(x)和y~P(y)为原始数据分布;LGAN为判别器的损失函数;E为数学期望。

同理,设从Y到X的映射为F,Cycle-GANs模型中引入一个判别器DX来判别生成的虚拟图像F(y)与真实图像x之间的相似度。

当实验过程中数据样本容量很大时,Cycle-GANs模型设计了一种周期一致性的映射函数,很大程度上缩小了映射空间,如

该过程称为前向周期一致性。同理,Y中的图像y也应与x一致,经过周期性图像变换后应回到y,该过程称为后向周期一致性,即

因此,Cycle-GANs引入的周期一致性函数的计算公式为

式中:Lcyc为周期一致性损失函数,其主要目的是确保网络生成的伪图像F[G(x)]能够还原出符合原始数据分布x~P(x)的数据;

综上,Cycle-GANs构建了一对周期性映射函数G与F,一对判别器DY与DX,并且通过对抗损失性函数与周期一致性损失函数共同构成了周期性GANs,实现了真正意义上的无监督学习。

3 实验预处理

在对细胞进行实际观察与研究时,研究者能够利用普通光学显微镜获取大视场、低分辨率图像,但由于传统光学显微镜存在大视场与高分辨率无法兼得的特性,故若想进一步研究细胞的形态特征或组成结构,只能通过牺牲视场的方式提高图像分辨率,这在很大程度上阻碍了学者对细胞的深入研究。在医学诊断方面,该缺陷会影响医生观察病人细胞的具体状况,耗费时间精力的同时也使得细胞活性降低,影响诊断结果。

本文预测所输入预处理图片的分辨率会影响Cycle-GANs对图像分辨率的重建与复现效果,所输入预处理图片的分辨率具有一定下限,即在对图像进行实际观测时显微镜的视场不可能无限大。因此,本文在此设想的基础上完成了理论预实验,并通过主观视觉判断和客观评价指标进行分析,各项指标的数据结果证明了该设想的合理性,为后续实验提供了理论参考。

3.1 实验平台及方法

实验所有细胞样品均为洋葱内表皮细胞。将洋葱内表皮细胞制成切片,使用质量分数为1%的稀碘液对切片进行染色处理,使实验观察效果更好。将切片放置在XSP-BM-10CA光学显微镜下成像,并配合使用专业彩色CCD相机对图像进行采集。实验中所用物镜放大倍率分别为4、10、25,数值孔径(NA)分别为0.10、0.25、0.40。CCD相机为SAGA电子目镜,最高分辨率可达到2560 pixel×1922 pixel,单个像素尺寸为2.2 μm,前端镜头倍率为0.45。

实验使用Python语言,计算机配置为Windows 10,内存为64 GB,显卡为GeForce GTX 3080,显卡内存为10 GB,Pytorch版本为1.8.0,CUDA版本为11.1。图像网络模型训练参数如

表 1. 图像网络模型训练参数

Table 1. Training parameters of image network model

|

本文基于上文所采集的洋葱内表皮细胞数据集进行实验,分别针对训练集数据和测试集数据进行专业化采集。训练数据集分别在放大倍率为4、10、25的物镜下采集,得到了3组各100张明场染色图像,每组数据集之间没有一对一的对应关系,即保证了数据量的多样性与非统一性,便于计算机进行学习。测试数据集包括30组明场染色图像,其中每组均是在保证切片不发生移动的情况下,只通过转换放大倍率为4、10、25的物镜而采集到的视场固定的不同分辨率的图像。与训练集不同的是,这30组图像各组间要一一对应,为后续分析比较生成虚拟图像与真实图像间的差异做好充分准备工作,实现自动配准。

3.2 客观评价指标

在对生成的虚拟染色图像结果进行评价时,由于在不同环境下,不同的人往往会有不同的感受,故仅依靠主观评价方法不能定性地对图像进行统一分析,难以有定量的实验值作为评估标准。因此,需要引入客观评价标准对图像做出更为准确的评价。

本文引入结构相似性(SSIM)、峰值信噪比(PSNR)和归一化均方根误差(NRMSE)这三个客观评价指标来对图像进行客观评价。

SSIM引入原始图像x和生成的虚拟图像y的亮度、对比度和结构函数三个指标来度量图像相似性。用均值作为亮度的估计,标准差作为对比度的估计,协方差作为结构相似程度的度量,使得SSIM的计算结果更接近人眼观测的主观评价结果。SSIM输出的值越接近1,表明两张图像越相似。当输入的图像与真实的图像完全相同时,SSIM的值为1。SSIM的计算公式[25]为

式中:l(x,y)、c(x,y)和s(x,y)分别为两幅图像间的亮度、对比度和结构函数;μx为原始图像x的均值;μy为虚拟生成图像y的均值;

PSNR是一种使用最广泛的评价图像质量的指标,基于对应像素点间的误差,衡量最大值信号和背景噪声之间的图像质量参考值。由于许多信号都有非常宽的动态范围,故PSNR常用对数分贝单位dB来表示。PSNR值越大,表示两幅图像的相似度越高,图像失真越小。PSNR的计算公式为[26]

式中:L为图像的最大像素值;EMS为均方误差(MSE),指虚拟生成图像与真实图像之差平方的期望值,其可以评价数据的变化程度,MSE值越小,说明两幅图像间有更好的相似度。MSE的计算公式为

式中:

NRMSE是通过对均方根误差(RMSE)进行归一化处理得到的,目的是消除指标间的量纲影响,实现数据标准化。NMRSE表征两幅图像之间的误差,其值越大,两幅图像间的相似度越低,模型复现效果越差。RMSE是MSE的算术平方根,其公式为

3.3 预实验结果

为验证前文猜想,对数据集中25倍的洋葱表皮细胞进行分辨率分级缩放从而完成理论验证。

将LR图像作为输入,计算机通过算法模型运行后得到对应的虚拟图像,如

表 2. 理论验证的客观评价指标

Table 2. Objective evaluation indexes of theory verification

|

图 5. 客观评价指标与图像分辨率缩小因子的关系拟合曲线图。(a)SSIM;(b)PSNR;(c)NMRSE

Fig. 5. Fitting curve of relationship between objective evaluation index and image resolution reduction factor. (a) SSIM; (b) PSNR; (c) NMRSE

由

3.4 分辨率提升验证

已经验证了在对样本图像进行观察采集时,显微镜的视场不可能无限大这一设想,即输入预处理图片的分辨率会对Cycle-GANs所生成的虚拟图像的质量产生影响。为了更科学地评判Cycle-GANs对所输入图像分辨率提升的影响,使用分辨率板作为实验样本,通过转换不同倍数的显微物镜,根据算法结构的要求对分辨率板的不同分辨率图像进行分类采集,完成了由10倍分辨率板的低分辨率图像生成25倍虚拟高分辨率图像的实验,最终验证了基于Cycle-GANs,输入图像的分辨率会得到质的提升。

实验数据采集目标为LBTEK公司生产的型号为RTS3AB-N的分辨率板。该分辨率板是通过在钠钙玻璃上镀低反射铬膜制作而成的,包含10组(-2~+7)图案,每组元素含有三条水平线和三条竖直线,有效降低了伪分辨率的发生概率。分辨率板尺寸为76.2 mm×76.2 mm,膜层厚度为0.12 μm,线宽公差为±0.5 μm。实验所用到的显微镜系统、计算机配置和图像网络模型训练的具体参数保持不变。

先对放大倍率为4、10、25的物镜下的分辨率板图像各随机采集50张作为train部分,其中trainA部分为50张RTS3AB-N分辨率板的10倍低分辨率图像,trainB部分为50张25倍高分辨率的分辨率板图像,这些图像之间没有对应关系,构成非成对数据集。然后,采集了20组一一对应的4倍、10倍、25倍分辨率板图像作为test部分。在实际采集时,通过只转换放大倍率为4、10、25的物镜从而采集到视场固定的不同分辨率图像,因此test部分中的图像是成对的,即每一张低分辨率图像都有与之相对应的高分辨率图像。

首先,将trainA、trainB这两部分输入到算法中进行非监督式的训练学习。计算机学习分辨率板的不同分辨率图像并自动更新与迭代优化,完成了Cycle-GANs整体的训练过程。然后,将上述数据集中采集到的20组成对图像输入到模型中,计算机会根据算法在训练过程中学习到的思想生成与输入的测试集中的低分辨率图像相对应的虚拟高分辨率图像。

图 6. 由10倍分辨率板的低分辨率图像生成25倍高分辨率虚拟图像的结果

Fig. 6. Results of 25× high-resolution virtual images generated from low-resolution images of 10× resolution testing board

4 实验结果及分析

在理论验证的基础上,为了使Cycle-GANs模型更好地适配于实际光学显微镜系统,将数据集分为两组进行对照实验。首先,对在显微镜10倍大视场下采集到的图像进行随机局部性区域截取。然后,将截取后的低分辨率图像作为输入,训练由10倍低分辨率模糊图像LR转变为25倍高分辨率清晰图像HR的算法模型。最后,将输出的虚拟图像与真实的采集图像进行比较,并从主观和客观角度分别对虚拟相衬成像效果进行评价,从而验证基于深度学习生成的虚拟图像与标准明场染色显微图像之间无明显差异。由4倍模糊图像LR转变为25倍清晰图像HR的实验操作同上。测试过程中所用的不同倍率的显微图像在同一显微成像装置上采集,只是更换了显微镜物镜的倍数,待采集的细胞样本不发生相对移动,即实现了图像的自动配准。

4.1 主观评价

图像的主观评价是以人作为图像的最终视觉接收者,在一定条件下由多个观测者对待测图像质量优劣和可分辨程度进行主观判断,再对大量评分数据进行统计学处理。

从

从

4.2 客观评价

为了更客观地验证虚拟染色图像与真实明场染色图像之间无明显的差异性,选用SSIM、PSNR和NRMSE三个客观评价指标对实验结果进行客观评价。选取了测试结果中的三组细胞进行分析,

表 3. 由10倍LR生成25倍HR的客观评价指标

Table 3. Objective evaluation indexes of 25× HR generated from 10× LR

|

表 4. 由4倍LR生成25倍HR的客观评价指标

Table 4. Objective evaluation indexes of 25× HR generated from 4× LR

|

需要说明的是:当10倍LR图像转变为25倍HR图像时,其分辨率缩小因子为100/625,所以其客观评价指标的计算结果也应与理论验证部分中缩小因子在1/8~1/4的中间数值的结果相对应;当由4倍LR图像转变为25倍HR图像时,其图像分辨率缩小倍数为10000/390625,其客观评价指标的数值应略低于理论验证部分中缩小因子为1/32的结果。

5 结论

为解决传统光学显微镜大视场和高分辨率无法兼顾的问题,提出了一种利用Cycle-GANs实现由大视场、低分辨率染色图像生成与之相匹配的高分辨率虚拟染色图像的方法,实现了将低倍明场染色低分辨率图像转换为与之相匹配的高倍虚拟染色高分辨率图像。实验结果表明,运用Cycle-GANs可以将洋葱内表皮细胞明场染色图像中的细胞器组织结构等特征信息有效地提取出来,不仅实现了细胞虚拟染色,在一定程度上降低了染色剂对细胞组织的伤害,还通过输入大视场、低分辨率染色图像得到与小视场、高分辨率真实图像相似度很高的虚拟高分辨率染色图像的方法,实现了传统光学显微镜中大视场与高分辨率的统筹兼顾。最后,对生成虚拟染色图像与真实明场染色图像间的差异性进行了主观视觉评价与客观评价,二者结果均显示,基于Cycle-GANs所生成的虚拟染色图像与真实染色图像间的相似度很高。因此,通过该方法可同时满足传统显微镜的大视场与高分辨率要求。该方法运用到生活实际中时,在降低成本和节约时间的同时,减轻了医者的负担,在生物医学领域细胞研究中具有重要的应用价值。

[1] BraunbeckT, LammerE. Fish embryo toxicity assays[M]. Heidelberg: German Federal Environment Agency, 2006.

[2] LimB, SonS, KimH, et al. Enhanced deep residual networks for single image super-resolution[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition Workshops, July 21-26, 2017, Honolulu, HI, USA. New York: IEEE Press, 2017: 1132-1140.

[3] BasakH, KunduR, AgarwalA, et al. Single image super-resolution using residual channel attention network[C]//2020 IEEE 15th International Conference on Industrial and Information Systems, November 26-28, 2020, Rupnagar, India. New York: IEEE Press, 2020: 219-224.

[4] LedigC, TheisL, HuszárF, et al. Photo-realistic single image super-resolution using a generative adversarial network[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition, July 21-26, 2017, Honolulu, HI, USA. New York: IEEE Press, 2017: 105-114.

[5] ZhuJ Y, ParkT, IsolaP, et al. Unpaired image-to-image translation using cycle-consistent adversarial networks[C]//2017 IEEE International Conference on Computer Vision, October 22-29, 2017, Venice, Italy. New York: IEEE Press, 2017: 2242-2251.

[6] 唐超影, 浦世亮, 叶鹏钊, 等. 基于卷积神经网络的低照度可见光与近红外图像融合[J]. 光学学报, 2020, 40(16): 1610001.

[7] 张文秀, 朱振才, 张永合, 等. 基于残差块和注意力机制的细胞图像分割方法[J]. 光学学报, 2020, 40(17): 1710001.

[8] 朱斯琪, 王珏, 蔡玉芳. 基于改进型循环一致性生成对抗网络的低剂量CT去噪算法[J]. 光学学报, 2020, 40(22): 2210002.

[9] 李素梅, 雷国庆, 范如. 基于卷积神经网络的深度图超分辨率重建[J]. 光学学报, 2017, 37(12): 1210002.

[10] Belthangady C, Royer L A. Applications, promises, and pitfalls of deep learning for fluorescence image reconstruction[J]. Nature Methods, 2019, 16(12): 1215-1225.

[11] 王飞, 王昊, 卞耀明, 等. 深度学习在计算成像中的应用[J]. 光学学报, 2020, 40(1): 0111002.

[12] 左超, 冯世杰, 张翔宇, 等. 深度学习下的计算成像: 现状、挑战与未来[J]. 光学学报, 2020, 40(1): 0111003.

[13] Qiao C, Li D, Guo Y T, et al. Evaluation and development of deep neural networks for image super-resolution in optical microscopy[J]. Nature Methods, 2021, 18(2): 194-202.

[14] Chen J J, Sasaki H, Lai H, et al. Three-dimensional residual channel attention networks denoise and sharpen fluorescence microscopy image volumes[J]. Nature Methods, 2021, 18(6): 678-687.

[16] Pan Z Q, Yu W J, Yi X K, et al. Recent progress on generative adversarial networks (GANs): a survey[J]. IEEE Access, 2019, 7: 36322-36333.

[18] WangX L, GuptaA. Generative image modeling using style and structure adversarial networks[M]// Leibe B, Matas J, Sebe N, et al. Computer vision-ECCV 2016. Lecture notes in computer science. Cham: Springer, 2016, 9908: 318-335.

[19] YuJ H, LinZ, YangJ M, et al. Free-form image inpainting with gated convolution[C]//2019 IEEE/CVF International Conference on Computer Vision (ICCV), October 27-November 2, 2019, Seoul, Korea (South). New York: IEEE Press, 2019: 4470-4479.

[20] TulyakovS, LiuM Y, YangX D, et al. MoCoGAN: decomposing motion and content for video generation[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE Press, 2018: 1526-1535.

[22] SchleglT, SeeböckP, WaldsteinS M, et al. Unsupervised anomaly detection with generative adversarial networks to guide marker discovery[M]// Niethammer M, Styner M, Aylward S, et al. Information processing in medical imaging. Lecture notes in computer science. Cham: Springer, 2017, 10265: 146-157.

[23] Mertens J F, Zamir S. The value of two-person zero-sum repeated games with lack of information on both sides[J]. International Journal of Game Theory, 1971, 1(1): 39-64.

[24] 叶晨, 关玮. 生成式对抗网络的应用综述[J]. 同济大学学报(自然科学版), 2020, 48(4): 591-601.

Ye C, Guan W. A review of application of generative adversarial networks[J]. Journal of Tongji University (Natural Science), 2020, 48(4): 591-601.

[25] 吴洪伟. 融合频域信息的单图超分辨率重建算法研究[D]. 北京: 北京交通大学, 2021: 8-9.

WuH W. Research on single image super-resolution reconstruction algorithm fusing frequency domain information[D]. Beijing: Beijing Jiaotong University, 2021: 8-9.

[26] 刘郭琦. 基于深度学习的超分辨率图像研究[D]. 银川: 宁夏大学, 2021: 17-18.

LiuG Q. Research on super resolution image based on deep learning[D]. Yinchuan: Ningxia University, 2021: 17-18.

Article Outline

付娆, 方宇, 杨勇, 向东, 吴晓静. 基于循环生成对抗网络的大视场显微成像方法[J]. 光学学报, 2023, 43(5): 0518002. Rao Fu, Yu Fang, Yong Yang, Dong Xiang, Xiaojing Wu. Large-Field Microscopic Imaging Method Based on Cycle Generative Adversarial Networks[J]. Acta Optica Sinica, 2023, 43(5): 0518002.