基于参数化角编码的量子K-means算法

0 引言

现代信息产业的高速发展以及数据的爆炸增长, 让人们对计算力的需求远远超过以往任何一个时代。IDC DataAge 2025白皮书显示, 全球数据量总和预计到 2025 年将达到 175 ZB, 因此, 数据分析迎来了巨大的挑战。早在 1982 年, Feynman[1]提出了量子模拟的构想, 开创了量子计算这种本质上全新的计算模型。随后, Lloyd等[2] 提出了第一个量子哈密顿模拟算法, 证实了 Feynman 的构想。1985年, Deutsch[3]提出通用容错量子计算机, 描述了图灵机的量子泛化, 证明了量子理论和通用计算机的理论是相容的, 并且可能比传统计算机具有更强的计算能力。在探寻量子优势的过程中, Deutsch[4]在1989年首次提出了Deutsch算法, 很好地展示了量子计算机的并行性。之后Shor[5]在1994年提出了著名的Shor算法, 证明该算法可以在多项式时间完成大数因子分解问题。1996年, Grover[6]在经典无序搜索算法的基础上提出了Grover算法, 该算法结合了幅度放大技术, 相较于经典算法实现了平方加速。近年来, 研究人员还发现可以利用量子计算高效地完成机器学习任务, 提出了一系列量子机器学习算法, 如量子线性回归[7, 8]、量子降维算法[9-12]、量子聚类[13-18]等。

作为机器学习的主要方法之一, 聚类分析常用于对未知类别的数据进行划分, 已广泛应用在销售、医学和生物等领域。在聚类分析中, 按照一定的规则将样本数据划分成若干个簇, 并把相似的样本聚在同一个簇中, 不相似的样本分在不同簇中。在2013年, Lloyd等[19]提出了量子无监督学习, 指出由绝热算法实现的量子K-means算法可以在维数和样本数量参数上实现对经典K-means算法的指数加速。2019年, Kerenidis等[20]提出了q-means算法。与经典的K-means算法相比, 该算法提供了对数据数量的指数级加速。上述算法均需使用QRAM加载样本数据, 并且需要与数据量相当的存储空间。除此之外, QRAM 尚处于理论模型阶段[21], 在制备任意量子态方面是困难的。

本文结合角编码对数据进行加载, 基于已有样本对样本分量分别进行参数阈值设置, 执行编码数据、相似度度量、量子最小值搜索和质心迭代更新四个主要步骤。理论分析表明本文所提出算法相比于经典算法在运行时间上有平方级加速。

1 预备知识

1.1 经典K-means算法

K-means算法是一种无监督的聚类算法。给定的样本集分成K个簇, 此算法将样本集中的每一个样本依次与K个簇的质心进行距离计算, 按照距离大小确定各个样本点最近质心的簇。经典K-means算法主要分为以下四个步骤: 1) 首先选取K个(K可根据某个损失函数确定)质心, 通常是随机选取; 2) 计算余下的每一个样本点到各个质心的欧式距离, 并将其归入相互间距离最小的质心所在的簇; 3) 在所有样本点都划分完毕后, 重新计算各个簇的质心(通常是计算簇中样本点的均值), 然后迭代计算样本点到各个质心的距离, 并对所有样本点重新进行划分; 4) 重复第 2)、3) 步, 直到迭代计算后所有样本点的划分情况保持不变或小于误差, 此时K-means算法得到最优解, 将运行结果返回。

1.2 经典K-means算法相似度度量方法

经典K-means算法的关键步骤是计算待标记的样本到各个质心的距离, 并将其归入到二者间距离最小的质心所在的簇。其中, 各个簇的质心是通过计算簇中所有数据点的均值来确定的。常见的度量相似度的方式有两种, 分别是用内积计算与欧式距离计算的结果来衡量相似度。考虑两个

量子K-means算法常采用欧氏距离作为度量距离的手段。该度量方式的局部较大特征将会降低较小数值特征的作用, 甚至使其根本不起作用。为了解决欧氏距离度量特征差异大的问题, 本研究在编码数据部分利用角编码对特征执行参数化预处理, 因此, 在相似度度量方面可有效避免因局部特征的数值太大而掩盖其他较小特征的情况。

1.3 本研究所提出算法涉及的量子门操作

经典计算机处理信息的基本单元是比特, 其状态为 0 或者 1。与此相似的是, 量子计算机处理的基本单元是

式中:

量子逻辑门是作用于单个或多个量子比特以实现某个变换的酉算子操作。本研究需要用到的单量子比特逻辑门可表示为

其中

构建本研究需要用到受控交换门

最后介绍量子比较器

式中

2 量子算法描述

2.1 编码数据

数据角编码是制备量子态的重要方法, 可以有效地提高制备量子态的效率。在编码数据中, 本研究着重解决参数设置和数据加载这两个问题,

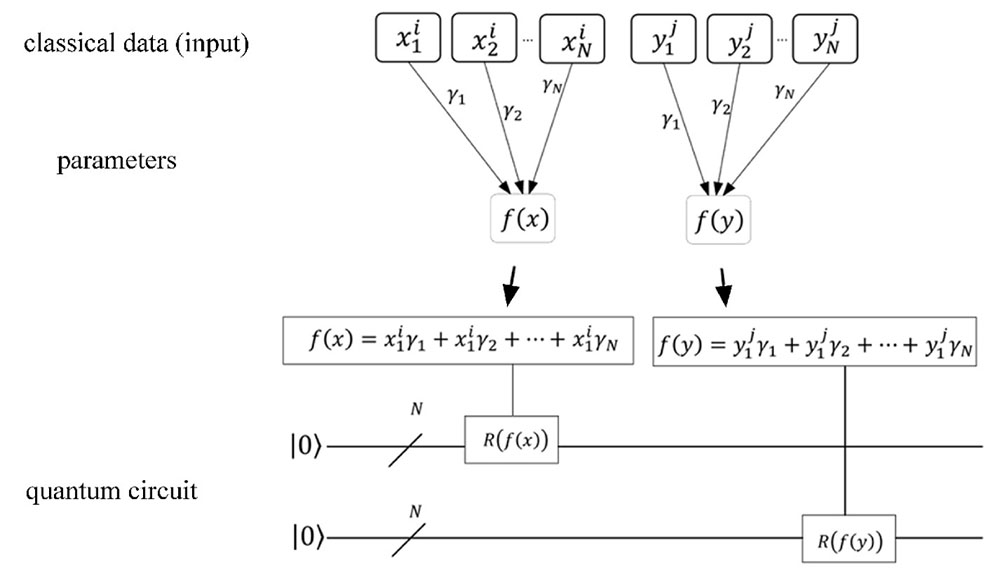

图 1. 从经典数据到量子态的量子线路图

Fig. 1. Quantum circuit diagram from classical data to quantum state

首先考虑带标签的经典数据

步骤S1: 参数值的设定与分析

针对经典数据

对 (5) 式的两个量子态作

步骤S2: 经典数据的加载

利用酉算子

同理, 用相同的方式对向量

然后, 初始化量子寄存器1、2为

上述操作后, 利用量子寄存器2控制编码算子

2.2 相似度度量

K-means算法的一个关键步骤是估计测试样本与质心之间的相似度, 着重解决测试样本与质心之间距离的问题。为计算样本之间的相似度, 本研究采用了多量子比特交换测试线路[27]。

步骤S3: 多量子比特交换测试的实现

首先初始化长度为

以3量子比特为例构建多量子比特交换测试线路, 如

推广到

表示, 其中算子下标表示量子比特数。由步骤S2可得量子态

式中算子

式中

式中

步骤S4: 多量子相位估计

该步骤利用量子相位估计来获得所有

1) 基于已定义的酉算子

2) 将控制算子

式中

3) 由文献 [28], 可以构建迭代酉算子

使得

因此, 在给定量子态

此式表示任意标签

步骤S5: 转移相位估计信息

根据(12)式保真度公式的结果

其中

2.3 量子最小值搜索

为方便起见, 将2.2节最终得到的量子态简化为

步骤S6: 量子最小值搜索算法求最小值标签

1) 随机初始化一个标签, 确定其量子寄存器1、2的大小。针对量子态

2) 利用

3) 利用Qsearch算法[33]搜索量子寄存器9是否处于

4) 根据文献[31]的结论, 当总时间复杂度小于

利用上述步骤可以得到待分配样本点所归属的簇标签。

2.4 质心迭代更新

将所有样本点分配到簇的过程会影响数据点的分布, 进而改变质心的位置, 因此, 在完成一轮迭代后需要重新考虑聚类效果。在聚类过程, 若样本点均匀分布在质心周围, 不影响质心分布的稳定性; 若样本点非均匀分布在质心周围, 则需要重新计算质心, 并对所有样本重新聚类。考虑到数据集在一轮迭代中可能改变原质心位置的情况, 就需要重新计算簇的质心。若需要对簇中样本计算新的质心, 这必然会导致质心计算的复杂度增加。为解决质心计算的问题引入了随机采样方案, 此方案利用量子的概率性输出簇中样本子集并近似代表质心, 可以降低计算质心的复杂度。

对每个簇进行随机采样之前, 记原始的簇大小为

3 性能分析

3.1 复杂度分析

在数据编码部分, 量子寄存器1、2 创建叠加态的时间复杂度为

经典K-means算法、本算法和其他量子K-means算法时间复杂度对比如

表 1. K-means算法之间的比较

Table 1. Comparison between K-means algorithms

|

3.2 数值实验

为了更加直观地判断样本的归属, 以二维样本

图 4. 二维数据点到两个质心的概率分布

Fig. 4. Probability distribution of two-dimensional data points to two centroids

由

4 结论

提出了一种无需QRAM存储的量子K-means算法。该算法利用角编码技术将经典数据转化为量子态, 并且对输入的经典数据施加不同参数, 从而解决样本不同特征尺度差异的问题。在相似度度量步骤, 使用多量子比特交换测试及量子相位估计算法, 以估计样本与质心之间的相似度信息; 在量子最小值搜索阶段, 将量子最小值搜索算法用于求解待分配样本点所归属的簇标签; 最后, 通过概率性输出样本子集近似代表质心。时间复杂度分析结果表明, 所提出算法相较于经典K-means算法实现了样本数的平方加速。还利用角编码加载了已预处理的数据, 由数值实验得出的相似度结果与经典结果一致。此外, 虽然本算法无法达到其他量子K-means算法的指数级加速效果, 但其可有效实现特征权重不同的数据集的聚类任务, 具有更广泛的适用范围。除了特征权重不同, 数据集的分布情况也是影响聚类效果的另一个主要因素。例如, 现有量子K-means算法对非凸数据集无法进行有效聚类分析。因此, 如何设计高效的量子K-means算法来解决非典型数据分布的数据集聚类问题将是下一步研究的重点。

[1] Feynman R P. Simulating physics with computers[J]. International Journal of Theoretical Physic, 1982, 21(6): 467-488.

[2] Lloyd S, Mohseni M, Rebentrost P. Quantum principal component analysis[J]. Nature Physics, 2014, 10(9): 631-633.

[3] DeutschD. Quantum theory, the Church–Turing principle and the universal quantum computer [C]. Proceedings of the Royal Society of London. A. Mathematical and Physical Sciences, 1985: 97-117.

[4] DeutschD E. Quantum computational networks [C]. Proceedings of The Royal Society of London. A. Mathematical and Physical Sciences, 1989: 73-90.

[5] ShorP W. Algorithms for quantum computation: discrete logarithms and factoring [C]. Proceedings 35th Annual Symposium on Foundations of Computer Science. Santa Fe, USA, IEEE, 1994: 124-134.

[6] GroverL K. A fast quantum mechanical algorithm for database search [C]. Proceedings of The Twenty-eighth Annual ACM Symposium on Theory of Computing, Philadelphia, USA, ACM, 1996: 212-219.

[7] Zhang D B, Xue Z Y, Zhu S L, et al. Realizing quantum linear regression with auxiliary qumodes[J]. Physical Review A, 2019, 99(1): 012331.

[8] GilyénA, SongZ, TangE. An improved quantum-inspired algorithm for linear regression [OL]. arXiv: 2009.07268, 2020, https://arxiv.org/abs/2009.07268.

[9] Sornsaeng A, Dangniam N, Palittapongarnpim P, et al. Quantum diffusion map for nonlinear dimensionality reduction[J]. Physical Review A, 2021, 104(5): 052410.

[10] Duan B J, Yuan J B, Xu J, et al. Quantum algorithm and quantum circuit for A-optimal projection: Dimensionality reduction[J]. Physical Review A, 2019, 99(3): 032311.

[11] Lin J, Bao W S, Zhang S, et al. An improved quantum principal component analysis algorithm based on the quantum singular threshold method[J]. Physics Letters A, 2019, 383(24): 2862-2868.

[12] He C, Li J Z, Liu W Q, et al. A low-complexity quantum principal component analysis algorithm[J]. IEEE Transactions on Quantum Engineering, 2022, 3: 1-13.

[13] 陈梦涵, 郭躬德, 林 崧. 基于汉明距离的量子推荐算法[J]. 量子电子学报, 2021, 38(3): 332-340.

[14] Fan D C, Song Z L, Jon S, et al. An improved quantum clustering algorithm with weighted distance based on PSO and research on the prediction of electrical power demand[J]. Journal of Intelligent & Fuzzy Systems, 2020, 38(2): 2359-2367.

[15] Yu K, Guo G D, Li J, et al. Quantum algorithms for similarity measurement based on Euclidean distance[J]. International Journal of Theoretical Physics, 2020, 59(10): 3134-3144.

[16] Gong C Q, Dong Z Y, Gani A, et al. Quantum K-means algorithm based on trusted server in quantum cloud computing[J]. Quantum Information Processing, 2021, 20(4): 1-22.

[17] Wu Z H, Song T T, Zhang Y B. Quantum K-means algorithm based on Manhattan distance[J]. Quantum Information Processing, 2022, 21(1): 19.

[18] KhanS U, AwanA J, Vall-LloseraG. K-means clustering on noisy intermediate scale quantum computers [OL]. arXiv: 1909.12183, 2019, https://arxiv.org/abs/1909.12183.

[19] LloydS, MohseniM, RebentrostP. Quantum algorithms for supervised and unsupervised machine learning [OL]. arXiv: 1307. 0411, 2013, https://arxiv.org/abs/1307.0411.

[20] KerenidisI, LandmanJ, LuongoA, et al. q-means: A quantum algorithm for unsupervised machine learning [C]. Proceedings of the 32nd Advances in Neural Information Processing Systems, Montreal, Canada, 2019: 4136–4146.

[21] 黄一鸣, 雷 航, 李晓瑜. 量子机器学习算法综述[J]. 计算机学报, 2018, 41(1): 145-163.

Huang Y M, Lei H, Li X Y. A survey on quantum machine learning[J]. Chinese Journal of Computers, 2018, 41(1): 145-163.

[22] 臧一鸣, 朱尚超, 魏战红, 等. 一种量子图像伪彩色编码方法[J]. 量子电子学报, 2022, 39(3): 343-353.

[23] WeigoldM, BarzenJ, LeymannF, et al. Expanding data encoding patterns for quantum algorithms [C]. 2021 IEEE 18th International Conference on Software Architecture Companion (ICSA-C), Stuttgart, Germany, 2021: 95-101.

[25] WilliamsC P. Explorations in Quantum Computing [M]. 2nd ed., New York: Springer, 2011: 83-91.

[26] Dang Y J, Jiang N, Hu H, et al. Image classification based on quantum K-Nearest-Neighbor algorithm[J]. Quantum Information Processing, 2018, 17(9): 239.

[27] Li P C, Guo J H, Wang B, et al. Quantum circuits for calculating the squared sum of the inner product of quantum states and its application[J]. International Journal of Quantum Information, 2019, 17(5): 1950043.

[28] Zhao J, Zhang Y H, Shao C P, et al. Building quantum neural networks based on a swap test[J]. Physical Review A, 2019, 100(1): 012334.

[29] Li P, Wang B. Quantum neural networks model based on swap test and phase estimation[J]. Neural Networks, 2020, 130: 152-164.

[30] Wang S B, Wang Z M, Li W D, et al. Quantum circuits design for evaluating transcendental functions based on a function-value binary expansion method[J]. Quantum Information Processing, 2020, 19(10): 347.

[32] Xia H Y, Li H S, Zhang H, et al. An efficient design of reversible multi-bit quantum comparator via only a single ancillary bit[J]. International Journal of Theoretical Physics, 2018, 57(12): 3727-3744.

[33] Brassard G, Høyer P, Mosca M, et al. Quantum amplitude amplification and estimation[J]. Contemporary Mathematics, 2002, 305: 53-74.

Article Outline

冯微军, 郭躬德, 林崧. 基于参数化角编码的量子K-means算法[J]. 量子电子学报, 2024, 41(1): 113. Weijun FENG, Gongde GUO, Song LIN. Quantum K-means algorithm based on parameterized angle encoding[J]. Chinese Journal of Quantum Electronics, 2024, 41(1): 113.