基于双频域特征聚合的低照度图像增强

1 引言

道路监控是智慧交通领域的重要组成部分,然而在低照度条件下的夜间场景中,摄像头采集到的图像亮度、对比度较低,且存在较多噪声颗粒,这为交通监管领域重要目标检测、识别等视觉任务带来了难度。低照度图像增强可以有效改善图像视觉效果,然而原始图像画质较低,不合理的降噪策略容易造成纹理模糊等图像退化问题,使得低照度图像增强任务具有较大的挑战性[1]。

已有低照度图像增强算法分为传统方法和基于深度学习的方法两类。传统低照度图像增强方法主要以直方图均衡化(histogram equalization,HE)和基于Retinex理论的方法为主。Li等[2]针对低画质图像难以保留细节信息的问题,提出了一种基于融合的QCFs低照度图像增强方法,将全局QCFs图像和局部对比度受限HE图像相融合来提高图像画面质量。Pan等[3]基于Retinex理论利用亮度增强函数(BEF)和自适应对比度增强(IACE)进行多尺度融合,使用高斯拉普拉斯金字塔对增强估计的光照图进行改善。李平等[4]设计了单尺度Retinex自适应增强方法,通过引导滤波对图像照度分量进行评估,再经过Gamma矫正光照图以实现自适应图像增强。

由于深度学习发展迅速,在低照度图像增强领域的应用也越来越广泛。Zhao等[5]受到Retinex理论的启发,提出了一种基于视网膜的光照注意力网络(retinex-based illumination attention network,RIANet),采用多分支结构来提取不同感受野下的光照特征,构建照明注意力块来缓解图像光照不均、对比度低等问题。Wu等[6]提出了一种基于视网膜的深度展开网络(retinex-based deep unfolding network,URetinexNet),通过隐式先验正则化模型设计迭代学习模块,循环分解图像实现噪声抑制和照度调整。Jiang等[7]针对分解得到反射图存在较多噪声的问题,提出了一种无监督分解与校正网络(unsupervised decomposition and correction network,UDCN),通过无监督噪声降噪网络(noise remove network, NRN)以HE增强图像为参照对象,在内部一致性约束、混合无参考质量感知损失函数的指导下去除阴影噪声。虽然基于Retinex理论和卷积网络通过调整分解光照分量的方式实现了低照度增强,但是基于Retinex理论和卷积神经网络的结构中,空间域的卷积堆叠操作容易损失图像结构信息,不合理的降噪策略难以区分高频信息与噪声信号,导致光照图对图像空间信息表征能力减弱,反射图在降噪过程中容易丢失纹理结构。

为解决上述问题,研究者们通过二维傅里叶变换(fast Fourier transform, FFT)将空间图像分解为不同频率、方向复平面波之和的形式,并用复数矩阵存储平面波的波动大小和平移量,利用卷积神经网络学习复平面信息分布以抑制异常峰值点,从而提高网络区分噪声信号和纹理信息的能力。Li等[8]提出了一种超高清傅里叶低照度增强网络(embedding Fourier for ultra-high- definition network,UHDFour),构建傅里叶卷积模块对振幅图和相位图进行分离处理,在傅里叶频域通过振幅图调整低照度图像亮度值,融合后的增强图像避免在增强亮度的同时放大噪声。Zhang等[9]为避免图像数据非线性映射到RGB色彩空间引入额外的噪声和伪影,提出了一种基于空间到光谱的跨尺度低照度增强网络,通过在三分支上嵌入快速傅里叶卷积块(FFC)和Transformer块,以扩大感受野范围和聚合多尺度特征。Hai等[10]提出了R2RNet网络实现低照度图像增强,利用空间信息提高图像亮度、对比度,同时通过FFT提取频域特征来保留图像细节信息。Lin等[11]为解决弱光环境下的增强过程中,容易造成过度曝光和局部模糊的问题,提出了一种基于退化特征向量引导的低照度网络,在提取到暗区和亮区上退化特征向量的基础上,设计快速傅里叶残差注意力块(FFR-DG),指导网络恢复图像细节特征。然而,频域卷积是通过引入快速傅里叶变换将RGB图像信号映射到频域向量空间并进行处理的方法,频域特征图上很小的扰动都会影响空间域全局图像的变化,容易导致低照度增强图像纹理细节模糊和空间结构信息损失。

小波变换(wavelet transform,WT)能够实现对图像全局空间信息的局部分析,通过伸缩平移运算对特征图逐步进行多尺度细化,区分高、低频率特征以避免相互之间的干扰影响,从而聚焦到任意频率特征细节处进行分析,提高网络恢复低照度图像细节方面的能力。Xu等[12]为充分利用光照信息改善图像质量,提出了一种基于光照引导的小波注意力网络(illumination guided attentive wavelet network,IGAWN),通过注意力小波变换层(attention wavelet transform layer,ADWT)对图像高、低频率进行分离,增强图像小波域的重要特征的表达并抑制冗余的噪声信号。Fan等[13]提出了一种M-Net的半小波注意力网络(half wavelet attention M-Net,HWMNet),在不同尺度的特征层上使用半小波注意力块以丰富小波域的特征,通过融合不同分辨率图像来丰富特征图的上下文信息,改善下采样造成的空间信息损失。胡聪等[14]为改善空间域卷积运算造成结构信息损失,提出了一种融合半波注意力模块的低光照图像增强算法,利用半波注意力模块获得采集小波域特征的能力,提高网络恢复图像细节特征的能力。Chen等[15]提出了一种基于注意力的广义引导网络(attention-based broad self-guided network,ABSGN),在小波域的低分辨率特征图上利用全局空间注意力块(GSA)关注上下文信息,采用多级引导密集块(MGDB)融合多尺度特征图,提高特征映射重用性,但是直接在小波域进行图像降噪任务需要网络具有较好的特征表征能力,以充分提取全局和局部的特征,导致网络运算成本的增加。

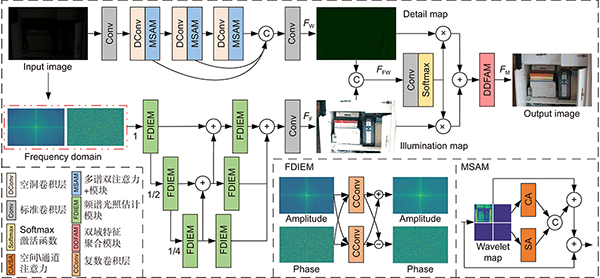

综上所述,虽然深度学习实现低照度图像增强已取得一定的效果,但在增强亮度、对比度的同时,容易放大阴影噪声,不合理的降噪策略常导致图像信息损失严重,出现不同程度的细节模糊,尤其对于画面质量较差的低照度图像,往往难以恢复丢失的纹理结构。为解决上述问题,提出一种基于双频域的特征聚合网络(dual frequency domain feature aggregation network,DF-DFANet)。首先,设计频谱光照估计模块(FDIEM),通过傅里叶域频谱特征图提取低照度图像全局特征,在频域拉升图像亮度的同时减少对噪声信号的响应。其次,提出多谱双注意力模块(MSAM),利用空间、通道注意力机制使得网络关注小波特征子图上重要特征,提高网络恢复图像细节信息的能力。最后,构建双域特征聚合模块(DDFAM)自适应学习不同像素级特征调整权重参数,并通过复数域卷积促进融合特征信息,增强图像色彩表现的自然性和纹理细节的丰富性。

2 基于双频域的特征聚合网络

为了解决低照度图像增强过程中容易出现噪声放大、纹理模糊等退化问题,提出了一种基于双频域的特征聚合网络,该网络主要由傅里叶域分支、小波域分支和双域特征聚合模块构成。其中傅里叶域分支,通过快速傅里叶变化使得浅层特征图具有全局感受野信息,由频谱光照估计模块(FDIEM)构建共轭约束条件提取丰富语义信息,逐层融合不同尺寸特征图并得到精细化的光照图;小波域分支主要由空洞卷积和多谱双注意力模块(MSAM)组成,结合通道和空间维度强化子空间特征纹理细节信息;双域特征聚合模块(DDFAM)自适应融合分支特征图,引导不同维度特征图之间相互信息互补,进一步提升融合图像颜色纹理特征的表达能力。所提DF-DFANet网络结构如

2.1 频谱光照估计模块

针对空间域卷积神经网络在低照度图像增强过程中,提升图像亮度、对比度的同时容易放大阴影噪声的问题,提出一种频谱光照估计模块(frequency domain illumination estimation module,FDIEM),首先,在傅里叶分支上低照度输入图像通过快速傅里叶变换从空域转换到频域表示,频域特征矩阵中实部表示为振幅,虚部表示为相位,则分解得到振幅图和相位图分别包含图像的亮度和噪声信息[8],对其各自进行复数卷积运算[16]可有效避免图像亮度提升对噪声放大的影响。此外,傅里叶域特征图具有覆盖全局图像的感受野[17],使得浅层网络获得包含全局上下文信息的特征图,提升网络对低照度图像的提取和表征能力。二维图像连续傅里叶变换、离散傅里叶变换和离散傅里叶逆变换计算表达式如下:

式中:x、y表示图像空间域像素点坐标,u、v表示傅里叶频域特征图点坐标,M、N表示分别图像长、宽,

其次,通过频谱光照估计模块分离频谱特征图复数矩阵的实部与虚部,获得包含颜色纹理信息的振幅图和包含语义信息的相位图。根据傅里叶变换的共轭对称性,任意一个信号序列都可由其共轭对称序列与共轭反对称序列和的形式表示,利用复数卷积层构建二维傅里叶共轭对称约束条件对,从而实现频谱光照估计模块。在经过卷积网络反向传播求导更新权重参数后,实现利用相位图的语义信息引导振幅图关注重要频率特征,并抑制无关噪声信号响应以达到图像降噪效果。频谱光照估计模块构建的共轭对称约束条件对计算表达式如下:

式中:

最后,高分辨率特征图和低分辨率特征图具有相似的振幅图,从而实现通过获取低分辨率的振幅图来调整高分辨率的亮度值,降低网络计算成本,所以将不同尺度的特征图采用逐步上采样组合的方式[18]获得亮度增强后的照度图,提高网络特征图的融合效率[19]。频谱光照估计模块如

在频谱光照估计模块中,令输入振幅矩阵和相位矩阵分别为

式中:R表示ReLU激活函数,N表示层归一化操作,C表示复数卷积层,

2.2 多谱双注意力模块

针对复杂弱光环境下难以提取低照度图像深层特征的问题,常用网络通过空间域卷积层堆叠的方式从而获得更大的感受野范围,但容易导致图像结构信息的损失。为解决此问题,提出一种多谱双注意力模块(multiple spectral attention module,MSAM),在小波域分支上,通过连续空洞卷积扩大特征图感受野范围,并引入多谱双注意力模块。该分支利用小波变换将图像投影到由尺度函数和小波函数簇构成的子空间,实现对特定信息分量的分离与观测,提高网络对细节特征的表征能力。然而对所得特征图进行简单的相加或拼接操作未曾考虑小波低频和高频特征系数分布的不同,容易造成细节信息丢失,并且在提取高频细节特征操作中容易保留阴影噪声,因此引入注意力机制可以进一步促进有用特征的频率响应,通道和空间注意力机制并联的结构设计有效缓解了不同注意力先后排列顺序造成的特征差异[20]。二维小波变换、离散小波变换和离散小波反变换计算表达式如下:

式中:

首先,堆叠多个空洞卷积提取图像结构特征并设置不同大小空洞率的卷积,在扩大特征提取范围的同时避免出现网格伪影。其次,在级联卷积层之间嵌入多谱双注意力模块,对输入图像进行分解得到低频特征和高频特征,并沿其水平、垂直和对角线方向进行重构,所得子特征图是空间域特征在小波组合频段的表示,从而提升网络对图像边缘和纹理结构的特征响应。然后,通过并行注意力机制对特征图在空间和通道维度上进行加权,强化重要目标特征的显著性区域,自适应调整不同通道特征图的权重分布。最后,利用

式中:

由于网络空间域和傅里叶域的卷积操作,容易造成图像空间信息损失,加入多谱双注意力模块实现恢复图像细节信息。首先,可逆的小波变换过程对图像特征具有分离特性,将包含低频信息、水平高频信息、垂直高频信息、对角高频信息的子空间特征图进行通道堆叠。其次,利用空间和通道注意力机制给予不同频率的特征图以相应的权重参数,增强特征图中细节信息的表达,同时抑制不同频率中的噪声信号。最后,将各个维度特征图进行通道堆叠操作,经过卷积融合操作后的特征图与输入特征图逐像素相加,增强特征重用和信息流动。多谱双注意力模块结构如

首先,在多谱双注意力模块中,令模块输入特征为

式中:

2.3 双域特征聚合模块

虽然融合不同维度的特征图可以互补相关信息,有效增强网络对特征的表达能力,但是特征图逐像素相加或相乘的融合策略难以有效利用不同特征图相关信息的空间映射关系,常导致特征融合操作图像细节增强效果不佳。为解决此问题,提出一种双域特征聚合模块(dual domain feature aggregation module,DDFAM)。由于傅里叶域和小波域的处理过程相互独立,作为该模块输入的光照图和细节图具有不同的特征分布,通过自适应计算两个特征图的权重比例关系以实现在融合过程中的软注意力机制[21],提高网络在恢复低照度图像光照和细节方面的能力。因此,首先将傅里叶域分支输出光照图和小波域分支输出细节图进行通道堆叠,并利用softmax激活函数赋予每个像素权重系数,实现特征图之间相关信息的映射。然后通过得到的权重系数对两个特征图进行逐像素相乘与相加操作,对融合特征图进行像素级细节调整。最后结合傅里叶域特征图具有全局感受野的特性[22],利用复数卷积将实数域特征图映射到复数域空间,提升网络在复数特征空间的表征能力,融合不同分支上特征图可有效增强网络对图像恢复纹理结构的能力,提高增强图像的视觉感知质量。双域特征聚合模块结构如

在双域特征聚合模块中,令傅里叶域分支和小波域分支输出特征作为模块输入特征

式中:

2.4 损失函数

损失函数使用常用的结构损失函数、感知损失函数和傅里叶损失函数,则网络总损失函数定义为三部分损失函数加权和的形式,如式(12)所示。

式中:根据经验值设置权重

结构损失函数为避免逐像素计算差异的方法造成图像模糊,通过将图像属性中的亮度、对比度和结构信息进行分离,用均值作为亮度的估计,标准差作为对比度的估计,协方差作为结构相似程度的度量,排除亮度和对比度对结构相似性的影响,提高网络对纹理结构的重建恢复能力。令

式中:

感知损失函数[24]利用欧式距离计算特征图之间的差值,通过固定VGG19网络提高对浅层颜色纹理特征和深层高级语义特征的感知能力,使得增强图像具有更好的视觉性能。令

式中:t表示VGG19预训练权重第t层,

傅里叶损失函数通过计算真实图像和预测图像的振幅图和相位图之间平均差[25],引导网络从频域角度恢复纹理特征实现对空间域特征图的补充,最小化真实图像与预测图像之间的差距,提高网络对频域特征的敏感性。令

式中:N表示图像像素点,

3 实验和结果分析

3.1 实验数据集及平台参数设置

实验平台采用Intel(R) Xeon(R) Gold 6130 处理器,128 GB内存,NVIDIA RTX 2080Ti 11 GB显卡,Ubuntu 18LTS操作系统,环境配置为CUDA10.2+Python3.6.9+Pytorch1.6。低照度图像增强对比实验数据集包括:LOL、MIT-Adobe FiveK。

LOL数据集是来自于真实场景下的500对低照度图像,通过改变采集设备的感光度和曝光值,并进行拍摄以获得低照度图像和相应的正常曝光图像。由于LOL训练数据集数量较少,为避免出现过拟合现象,对正常曝光图像进行亮度调整,得到不同亮度等级的低照度图像10000张,并对其进行反转、旋转等数据增强处理以达到扩充数据集的目的。MIT-Adobe FiveK数据集是通过调整相机传感器参数模拟模拟相机曝光过程制作,对5000张原始RGB图像调整曝光值,模拟非线性渲染过程实现不同曝光水平的图像,最终得到24330张具有不同曝光设置的8位sRGB图像。实验所用数据集组成图像拍摄场景多样化且内容丰富,图像光照条件多变,使得这些数据集在低照度实验中具有较强的泛化能力和鲁棒性。

网络训练优化器使用Adam优化器,初始学习率设置为0.0001,在训练任务完成 20 轮之后学习率衰减10倍,网络迭代次数epoch设置为200,batch size为8,patch size为256。训练过程中,按照8:2划分为训练和测试数据集,对 400×600原始图像进行随机裁剪选取256×256图像块作为网络输入。

3.2 评价指标

客观评价评价指标采用峰值信噪比(PSNR)、结构相似性(SSIM)、学习感知图像块相似度(LPIPS)。各类评价指标定义如下:

峰值信噪比(Peak signal to noise ratio,PSNR)是衡量图像含噪声程度的指标,单位为dB,如式(16)所示:

结构相似性(structural similarity,SSIM)是一种基于人眼视觉感知的图像质量评估方法,从亮度、对比度和结构三个维度来评估图像之间的相似度,如式(17)所示:

学习感知图像块相似度(Learned perceptual image patch similarity,LPIPS)是用于衡量增强图像和真实图像之间差异量,如式(18)所示:

式中:x、y分别为真实图像和增强图像,

3.3 LOL数据集实验与分析

为验证所提网络对低照度图像的增强效果,与其他对比网络进行对比实验,实验结果如

3.3.1 定性分析

由

3.3.2 定量分析

为进一步验证所提网络的有效性,在LOL测试数据集上进行对比实验,对比指标结果如

表 1. LOL真实低照度数据集测试结果

Table 1. LOL real-world dataset results

|

3.4 MIT-Adobe FiveK数据集实验与分析

为验证所提网络对不同场景的泛化性能,在MIT-Adobe FiveK数据集上进行测试实验,对比网络分别为RetinexNet[26]、Zero-DCE[27]、DSLR[28]、KinD[29]、EnGAN[30]、RUAS[31]、URetinexNet[6]、R2RNet[10]和UHDFour[8]。实验结果如

图 6. MIT-Adobe FiveK数据集增强结果对比

Fig. 6. Comparison of enhancement results of mit-adobe fivek dataset

为进一步定量评价所提网络的泛化性能,采用PSNR、SSIM、LPIPS作为衡量增强效果的评价指标,对比结果如

表 2. MIT-Adobe FiveK数据集测试结果

Table 2. MIT-Adobe FiveK dataset results

|

3.5 消融实验与性能分析

3.5.1 多谱双注意力模块的消融实验

为进一步验证多谱双注意力模块中的通道和空间注意力之间连接方式的有效性,在LOL数据集上对所提网络的DDFAM模块进行消融实验。Baseline组设置普通卷积层替换通道和空间注意力块,Serial of CA & SA组设置注意力块组合方式为串行结构,Parallel of CA & SA组设置注意力块组合方式为并行结构,实验效果如

图 7. 模块注意力结构实验效果对比

Fig. 7. Comparison of experimental effects of modular attention structure

表 3. 模块注意力结构测试对比结果

Table 3. Comparison results of module attention structure testing

|

3.5.2 网络模块消融实验

为验证所提网络各模块对低照度图像增强的有效性,在LOL低照度数据集上对各模块进行消融实验。Baseline设置一路分支为U-Net网络,另一路为标准卷积层堆叠结构,特征融合部分为逐像素相加的操作。FDIEM表示基于频谱光照估计模块的傅里叶域分支,MSAM表示嵌入多谱双注意力模块和空洞卷积的小波域分支,DDFAM表示双域特征聚合模块。实验结果如

表 4. 网络模块消融实验结果

Table 4. Experimental results of network module ablation

|

对所提网络各个模块进行消融实验,其效果图对比如

3.5.3 网络性能对比实验

为验证所提网络的性能,与对比网络在LOL低照度测试数据集上进行性能测试。低照度图像增强处理单张图像的平均时间、模型大小、浮点运算量与PSNR对比实验数据如

表 5. 不同网络的PSNR和平均处理时间、模型大小和浮点运算量对比

Table 5. Comparison of different network average processing time, model size and floating-point operations

|

3.6 真实场景增强实验

低照度图像增强在视频监控领域有着广泛的应用,对车辆管理、交通安全和车流控制都有着极大的应用价值,为了验证所提网络的实际应用效果,在现实车辆监控场景下进行实验与分析,实验结果如

图 10. 夜间低照度车辆监控图像测试结果

Fig. 10. Test results of monitoring images of low-light vehicles at night

4 结论

针对低照度图像增强中出现的边缘模糊、图像噪声等退化问题,提出一种基于双频域特征聚合的低照度增强网络。在傅里叶域分支上通过逐层融合频谱光照估计模块提取的频域特征图,扩大特征图感受野范围,结合丰富的上下文语义信息获得精细化光照图;在小波域分支上嵌入多谱双注意力模块,对小波特征图利用空间和通道注意力,提升网络关注图像高频细节特征的能力;双域特征聚合模块利用激活函数获得图像像素分配权重,实现对增强图像更精细化的调整,提高网络恢复图像颜色、纹理的能力。LOL数据集对比实验表明,所提网络PSNR达到24.3714,SSIM达到0.8937。在MIT-Adobe FiveK数据集上,PSNR、SSIM分别达到了22.7214、0.8726。此外,本文在实际应用场景进行了实验测试,增强效果稳定性良好且具有较好鲁棒性和泛化能力,但所提网络浮点运算量FLOPs较大,故降低网络计算量是下一步改进方向。

Overview: Road monitoring is an important part of the field of intelligent transportation. However, in the night scene under the condition of low illumination, the brightness and contrast of the images collected by the camera are low, and there are more noise particles, which brings difficulty to the visual tasks such as detection and recognition of important targets in the field of traffic supervision. Although deep learning has achieved certain results in the enhancement of low-light images, it is easy to amplify shadow noise while enhancing brightness and contrast. Unreasonable noise reduction strategies often lead to different degrees of detail blur in the image, especially for low-light images with poor picture quality, it is often difficult to restore the lost texture structure. To solve these problems, a dual-frequency domain based feature aggregation network (DF-DFANet) is proposed. Firstly, the spectral illumination estimation module (FDIEM) is designed to extract the global features of the image through the Fourier domain spectral feature map and reduce the response to the noise signal while pulling up the brightness of the image in the frequency domain. Secondly, a multispectral dual attention module (MSAM) is proposed, which uses the spatial and channel attention mechanism to make the network focus on the important features of the Baud sign subgraph and improves the ability of the network to recover image details. Finally, a dual-domain feature aggregation module (DDFAM) was constructed to learn the adaptive weight parameters of different pixel level features, and the complex domain convolution was used to promote the fusion of feature information, which enhanced the naturalness of image color performance and the richness of texture details. In the Fourier domain branch, the frequency domain feature map extracted by the spectral illumination estimation module is fused layer by layer, the range of the sensitivity field of the feature map is expanded, and the refined illumination map is obtained by combining rich contextual semantic information. The multi-spectral dual attention module is embedded in the branch of the wavelet domain, and the space and the channel attention are used to improve the ability of the network to pay attention to the high-frequency detail features of the image. Dual-domain feature aggregation module uses an activation function to obtain image pixel allocation weight, realizes more refined adjustment of the enhanced image, and improves the ability of the network to restore image color and texture. Comparative experiments on the LOL dataset show that the PSNR and SSIM of the proposed network reach 24.3714 and 0.8937. On the MIT-Adobe FiveK dataset, PSNR and SSIM reach 22.7214 and 0.8726, respectively. In addition, the proposed method has been tested in practical application scenarios, and the enhancement effect has good stability, robustness, and generalization ability.

[2] Li C L, Tang S Q, Yan J W, et al. Low-light image enhancement based on quasi-symmetric correction functions by fusion[J]. Symmetry, 2020, 12(9): 1561.

[3] Pan X X, Li C L, Pan Z G, et al. Low-light image enhancement method based on retinex theory by improving illumination map[J]. Appl Sci, 2022, 12(10): 5257.

[4] 李平, 梁丹, 梁冬泰, 等. 自适应图像增强的管道机器人缺陷检测方法[J]. 光电工程, 2020, 47(1): 190304.

Li P, Liang D, Liang D T, et al. Research on defect inspection method of pipeline robot based on adaptive image enhancement[J]. Opto-Electron Eng, 2020, 47(1): 190304.

[5] Zhao R N, Han Y, Zhao J. End-to-end retinex-based illumination attention low-light enhancement network for autonomous driving at night[J]. Comput Intell Neurosci, 2022, 2022: 4942420.

[7] Jiang Q P, Mao Y D, Cong R M, et al. Unsupervised decomposition and correction network for low-light image enhancement[J]. IEEE Trans Intell Transp Syst, 2022, 23(10): 19440-19455.

[8] LiC Y, GuoC L, ZhouM, et al. Embedding fourier for ultra-high-definition low-light image enhancement[C]//The Eleventh International Conference on Learning Representations, 2023.

[9] Zhang Y C, Liu H Y, Ding D D. A cross-scale framework for low-light image enhancement using spatial–spectral information[J]. Comput Electr Eng, 2023, 106: 108608.

[10] Hai J, Xuan Z, Yang R, et al. R2RNet: low-light image enhancement via real-low to real-normal network[J]. J Vis Commun Image Represent, 2023, 90: 103712.

[12] Xu J Z, Yuan M K, Yan D M, et al. Illumination guided attentive wavelet network for low-light image enhancement[J]. IEEE Trans Multimedia, 2023, 25: 6258-6271.

[14] 胡聪, 陈绪君, 吴雨锴. 融合半波注意力机制的低光照图像增强算法研究[J]. 激光杂志, 2023.

Hu C, Chen X J, Wu Y K. Research on image enhancement algorithm of low illumination image based on half wave attention mechanism[J]. Laser J, 2023.

[16] ChiL, JiangB R, MuY D. Fast Fourier convolution[C]//Proceedings of the 34th International Conference on Neural Information Processing Systems, 2020: 376.

[18] Zamir S W, Arora A, Khan S, et al. Learning enriched features for fast image restoration and enhancement[J]. IEEE Trans Pattern Anal Mach Intell, 2022, 45(2): 1934-1948.

[20] 刘光辉, 杨琦, 孟月波, 等. 一种并行混合注意力的渐进融合图像增强方法[J]. 光电工程, 2023, 50(4): 220231.

Liu G H, Yang Q, Meng Y B, et al. A progressive fusion image enhancement method with parallel hybrid attention[J]. Opto-Electron Eng, 2023, 50(4): 220231.

[23] Starovoitov V V, Eldarova E E, Iskakov K T. Comparative analysis of the SSIM index and the Pearson coefficient as a criterion for image similarity[J]. Eurasian J Math Comput Appl, 2020, 8(1): 76-90.

[24] 陶昕辰, 朱涛, 黄玉玲, 等. 基于DDR GAN的低质量图像增强算法[J]. 激光技术, 2023, 47(3): 322-328.

Tao X C, Zhu T, Huang Y L, et al. Low-quality image enhancement algorithm based on DDR GAN[J]. Laser Technol, 2023, 47(3): 322-328.

[26] WeiC, WangW J, YangW H, et al. Deep retinex decomposition for low-light enhancement[C]//British Machine Vision Conference 2018, 2018.

[28] Lim S, Kim W. DSLR: deep stacked Laplacian restorer for low-light image enhancement[J]. IEEE Trans Multimedia, 2021, 23: 4272-4284.

[30] Jiang Y F, Gong X Y, Liu D, et al. EnlightenGAN: deep light enhancement without paired supervision[J]. IEEE Trans Image Process, 2021, 30: 2340-2349.

[33] Hu Y M, He H, Xu C X, et al. Exposure: a white-box photo post-processing framework[J]. ACM Trans Graph, 2018, 37(2): 26.

[35] Li C Y, Guo C L, Loy C C. Learning to enhance low-light image via zero-reference deep curve estimation[J]. IEEE Trans Pattern Anal Mach Intell, 2022, 44(8): 4225-4238.

[36] LvF F, LuF, WuJ H, et al. MBLLEN: low-light image/video enhancement using CNNs[C]//British Machine Vision Conference 2018, 2018.

[37] Li J, Li J, Fang F, et al. Luminance-aware pyramid network for low-light image enhancement[J]. IEEE Trans Multimedia, 2020, 23: 3153-3165.

Article Outline

徐胜军, 杨华, 李明海, 刘光辉, 孟月波, 韩九强. 基于双频域特征聚合的低照度图像增强[J]. 光电工程, 2024, 50(12): 230225. Shengjun Xu, Hua Yang, Minghai Li, Guanghui Liu, Yuebo Meng, Jiuqiang Han. Low-light image enhancement based on dual-frequency domain feature aggregation[J]. Opto-Electronic Engineering, 2024, 50(12): 230225.