分离特征和协同网络下的端到端图像去雾

1 引 言

视频监控等智能设备在计算机视觉系统应用中起着重要的作用。由于雾、霾天气的存在,使得成像设备采集到的图片降质严重,不能很好地监测到目标物体,给视觉系统带来极大的不便[1-3]。因此,图像去雾有着很重要的现实意义、研究价值以及实用价值。

目前,图像去雾方法主要为基于物理模型和基于深度学习的方法。基于物理模型的方法从图像降质的本质出发,以大气散射模型为依据,通过估计大气光和透射率,逆向推导降质公式,从而得到无雾图像。He等人[4]对大量户外无雾图像统计发现:在非天空和高亮区域,其像素点的某一个颜色通道具有非常低的像素值,提出暗通道先验DCP。Zhu等人[5]通过统计有雾图像的颜色信息,提出颜色衰减先验CAP,估计出深度信息,从而得到无雾图像。Hu等人[6]观察发现大气光照不仅在不同图像中存在差异,在同幅图片的不同区域也存在差异,提出基于局部—全局联合光照调整的去雾算法,用局部光照代替全局大气光。该算法对不同雾浓度和光照条件的雾图均有良好的适应性。Yang等人[7]提出用一个分段函数来代替最小滤波器操作,有效避免了暗通道方法在边缘处透射率估计不准确的问题。基于物理模型的去雾方法发展迅速,效果显著。但存在的问题是:先验信息具有局限性,不能适用于任意场景;以DCP为例,该先验信息不适用于高亮区域。同时,手动设计特征的过程较为繁琐,不具有便利性。

为了改善传统算法的不足,基于深度学习的去雾方法迅速发展,成为图像去雾的主流方向。该类方法主要借助卷积神经网络(Convolutional Neural Network, CNN),通过构建端到端的网络架构训练所需特征。Cai等人[8]基于深层CNN搭建Dehaze-Net去雾网络来训练透射率,借助大气散射模型恢复出无雾图像,取得了不错的结果,尤其天空区域效果显著。但该网络以传统方法中的先验或假设构建,具有一定的局限性。Ren等人[9]提出的端到端门控融合去雾网络GFN通过使用白平衡、对比度增强和伽马校正等一系列操作实现最终的去雾,但网络实现过程较繁琐。Li等人[10]提出的AOD网络,通过变形大气散射模型公式,将透射率和大气光整合为一个统一参数K训练,改变了以往分别训练大气光和透射率的风格,但由于网络层数较少精度有限,并不总能达到好的去雾效果。Qin等人[11]基于不同的通道特征包含完全不同的加权信息,且不同图像像素上的雾浓度分布也不同,提出一种通道注意和像素注意机制结合的特征注意网络FFA-Net。由于该网络只是考虑了有雾图像与无雾图像之间的差值,并未从图像整体风格出发,尽管对合成图像效果良好,但在真实场景中存在细节丢失严重,去雾不彻底的问题。Wang等人[12]通过对大量有雾图像的不同颜色通道统计发现:有雾区域主要集中在Ycbcr色彩空间的亮度通道上,提出大气照明先验,搭建了AIPNet去雾网络,在一定程度上提高了图像质量,但仍存在特征提取不全面,部分复原图像伴有残雾。

基于上述传统方法以及现有网络存在的不足,本文提出了一种基于CNN的分离特征和协同网络的端到端去雾架构。首先基于大气散射模型,本文将传统的去雾模型变形为乘性干扰与加性干扰的形式,简化去雾过程,突出特征重要程度;然后用一个四层密集级联的深层多尺度网络和一个浅层多尺度网络来分别提取分离出的乘性特征MF和加性特征AF;最后结合初始输入信息以及提取到的两个特征,通过复原模块得到清晰图像。各项实验结果表明,所提网络复原图像去雾彻底,颜色保真度高,细节保持良好且无偏色现象。

2 算 法

2.1 复原模型

在图像去雾领域中,常用大气散射模型[13-15]描述雾天条件下的成像过程,如式(1)所示:

其中,和分别代表有雾图像和无雾图像,表示大气光,为透射率,反映了大气光穿透雾气的能力。

本文对大气散射模型做如下变形:

其中,将命名为乘性特征,用MF(Multiplicative Feature)表示;将命名为加性特征,用AF(Additive Feature)表示。最终的复原公式可表示为:

相比较于式(1)所示模型,本文所建立的乘性干扰加加性偏置的形式不仅可以更加简洁地反映图像退化过程,而且能够更加直观地突出各特征的重要程度,在搭建网络时更具目标性,从而保证网络训练的稳定性。由式(3)可以看出,提取乘性特征MF和加性特征AF是复原图像的关键。因此,本文网络设计的重点就是获取所需的图像特征MF和AF。

2.2 特征提取网络

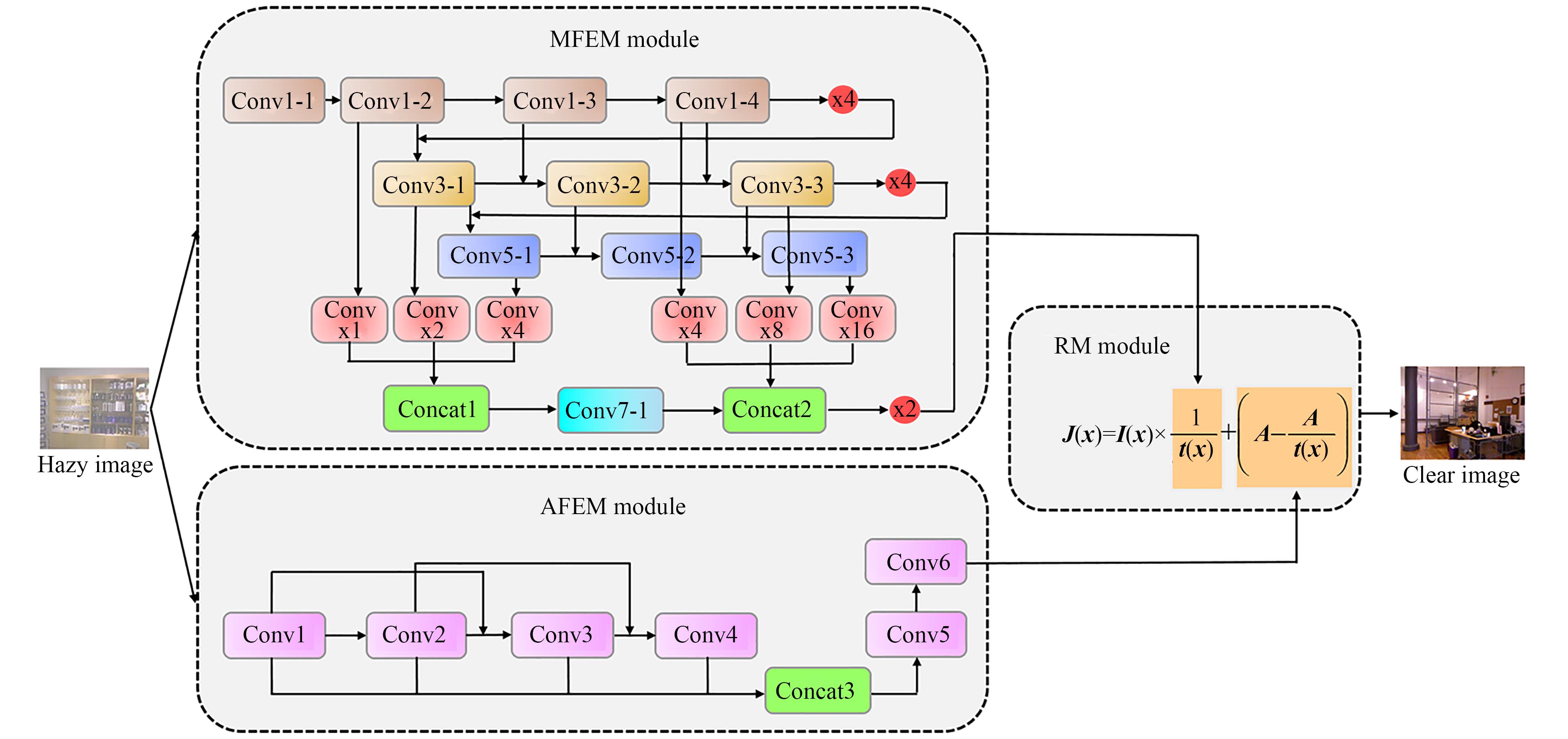

与以往大多数依赖大气散射模型,通过分别训练大气光、透射率或者将两者整合在一起训练实现去雾的操作不同。本文从大气散射模型变形公式出发,重点考虑乘性特征和加性特征的提取,设计了一个双网并行的去雾网络,网络整体架构如图1所示。

所提网络主要包括:乘性特征提取模块MFEM(Multiplicative Feature Extraction Module)、加性特征提取模块AFEM(Additive Feature Extraction Module)以及复原模块RM(Restoration Module),通过这些模块的共同作用,从而实现从有雾图像(Hazy Image)到无雾图像(Clear Image)的端到端处理。

2.2.1 乘性特征提取模块MFEM

传统的网络结构提取图像特征时通常是从单路径结构体系出发的,网络各阶段间没有通信[16-17],模型如图2(a)所示。虽然能够得到所需特征,但随着网络深度的增加,特征精度提升有限,并不能达到良好的效果。考虑到各层不同阶段之间的信息交互,本文通过将上层各阶段网络引入下层网络,进而充分利用各层网络不同深度的空间信息以及图像细节特征,获取到更加全面丰富的特征信息。各层之间的信息交互不仅实现了特征重用的目的,提升网络精度,而且可以有效减小模型部署成本[18-19],如图2(b)所示。

基于上述分析,本文MFEM模块的设计充分考虑特征重用的优点,搭建了一个四层密集级联的多尺度网络来提取图像的乘性特征。具体地,采用不同尺寸的卷积操作来获取不同感受野的图像特征;通过密集级联充分利用各层信息,补偿信息间差异,捕捉更加全面的特征;ReLu函数不仅可以克服梯度消失而且可以加快网络的训练速度,因此MFEM模块采用ReLu作为激活函数。本文将输入图片尺寸设为480×640,为保证输出图像尺寸的一致性,输出尺寸,步长,填充,输入尺寸遵循式(4)所示的规则:

其中,为输入图片尺寸,为输出图片尺寸;为填充,代表卷积核尺寸,为步长;为向下取整操作。

深度可分离卷积包括逐通道卷积(Depthwise)和逐点卷积(Pointwise)两个步骤,是两种卷积共同作用的结果。与常规卷积相比,深度可分离卷积可以在达到同等效果的同时有效降低参数量。因此,为降低网络参数量、提高网络训练效率,MFEM网络采用深度可分离卷积实现其功能。

MFEM模块各阶段内部参数如表1所示。ConvY-X中Y代表卷积核尺寸,X代表卷积编号,例如Conv1-1表示尺寸为1×1,编号为1的卷积,N表示上采样。其次,当填充时,本文采用大小为3×3,步长为2,的最大池化层对图片进行下采样操作,以减小图片尺寸。

表 1. 乘性特征提取模块MFEM各卷积核参数

Table 1. MFEM convolution kernel parameters

|

2.2.2 加性特征提取模块AFEM

在本文所提的线性复原模型中,可将加性特征AF视为偏置。与MF相比,AF对输出结果影响较小。因此,本文AFEM模块使用6个卷积层融合不同大小的滤波尺寸,捕获多感受野特征。同时,引入跳跃连接有效避免梯度消失或梯度爆炸问题,显著增强网络性能。网络内各部分参数如表2所示。为了进一步比较本文所提特征MF和AF的对复原结果的影响,进行如下实验,如图3所示。从一组有无加性特征的复原效果对比图可以看出:加性特征主要体现在图像的细节部分及颜色保真度方面,它可以有效增强图像细节信息,使图像局部特征更加明显,同时在视觉上使图像更加清晰自然。如图中红框部分所示,加性特征AF加入后地面及墙面颜色更加清晰自然且细节特征明显增多。

表 2. 加性特征提取模块AFEM各卷积核参数

Table 2. AFEM convolution kernel parameters

|

2.2.3 损失函数

为保证网络的收敛性,本文在训练网络时采用将基于预训练VGG-19网络的感知损失[20]与损失相结合的损失函数求解方法,通过最小化重建图像与真实图像之间的误差获得无雾图像。损失与感知损失分别如式(5),式(6)所示:

其中,表示真实无雾图像,表示经过所提网络得到的重建图像,,,分别表示重建图像的高度、宽度以及数目。表示真实图像特征图,表示重建图像特征图。

因此,最终的损失函数为:

其中,为权重因子,本文设置为0.01。

分别利用MFEM模块和AFEM模块得到训练好的特征AF和MF后,结合初始信息,通过复原模块,便可得到无雾图像,如图4所示。

3 实验结果与分析

为验证所提网络的有效性及合理性,本文对其在合成图像和真实图像的去雾效果分别做了定量评估,并从视觉效果和客观数据两方面与目前先进的算法作对比,使结果更具说服力。

3.1 实验设置及数据集

本文网络运行是基于Pytorch框架下实现的,在Ubuntu环境下使用V100 GPU来训练去雾网络。其中,设置初始学习率为经验值0.000 1,batchsize为32。Adam优化器的动量衰减指数分别是:,。迭代次数为30次,训练一次迭代的时间为28分钟,最终训练出的网络模型大小为1 808 kb。

本文使用合成图像数据集RESIDE(Realistic Single Image Dehazing)[21]训练网络。RESIDE从NYU2[22]深度数据集中选取图像,通过随机选择大气光()和散射设系数()来合成不同的有雾图像。其中包括ITS(Indoor Training Set)室内数据集、OTS(Outdoor Training Set)室外数据集和SOTS(Synthetic Objective Testing Set)数据集。本文选择RESIDE中的ITS数据集作为训练集,SOTS作为测试集。训练集ITS中包括1 399张清晰图像以及所对应的不同雾浓度的13 990张有雾图像;测试集SOTS中包括500张室内有雾图像和500张室外有雾图像。另外,为更好地验证所提网络的有效性和实用性,本文还选取了真实环境中色彩较为丰富的有雾图像进行测试。

在网络性能的定量评估上,本文选取了一些去雾领域具有代表性的算法作对比,包括基于物理模型的传统算法He算法、Zhu算法;基于深度学习的Cai算法、Li算法、Ren算法和Qin算法。

3.2 合成图像数据集定量评估

3.2.1 主观评价

在合成图像数据集SOTS上对网络从主观和客观两方面进行评估,随机选取其中的4幅室内图像和4幅室外图像进行效果评价,各算法去雾效果如图5~6所示。可以看出:与其他算法相比,本文算法所得结果图与原清晰图像最为相似,具体分析如下:

图 5. 室内合成雾图各算法去雾效果对比图(图像1-4)

Fig. 5. Comparison of restoration effects of various algorithms in iutdoor synthetic hazy image(Image1-4)

图 6. 室外合成雾图各算法去雾效果对比图(图像1-4)

Fig. 6. Comparison of restoration effects of various algorithms in outdoor synthetic hazy image(Image1-4)

He方法获得的图像去雾较彻底,但较其其他算法效果图而言图像整体偏暗,且由于暗通道的局限性,天空区域严重失真,如图6(b)所示。另外,边缘突变处透射率估计不准确,导致复原图像在边缘处易出现光晕和块状效应,如图6(b)中第一幅图像树叶周围存在光晕伪影;由Cai方法得到的图像颜色自然,尤其天空区域更为显著,但存在去雾不彻底和细节损失严重的问题。如图5(c)中第一幅图像墙面区域明显有雾气残留,第四幅图像前景椅子严重偏色以及图像6(c)中第一幅图像树叶过暗细节模糊;较He算法,Ren算法在天空区域的偏色问题有所改善,但部分图像存在去雾不彻底及颜色过饱和问题。如图5(d)中第四幅图像、图6(d)中第一幅图像去雾效果较差,图6(d)中第三幅图及第四幅图像中的石头护栏部分颜色过黄;Li方法得到的图像颜色保真度较好且去雾也较为彻底,但由于网络结构比较浅特征提取不是很丰富,远景区域细节恢复较差,如图6(e)中第三幅图像及第四幅图像后山的树林;Qin算法得到的无雾图像室内图像去雾效果较好,复原图像颜色自然,室外图像去雾不太彻底,但天空区域颜色自然,无明显的偏色现象,如图5(f)所示;与前面几种经典算法相比,本文算法去雾效果显著,细节保持良好,且无明显的失真、偏色等问题,去雾图像颜色自然,在室内及室外图像上均有不错的表现。

3.2.2 客观评价

客观评价指标采用深度学习中统一使用的结构相似度SSIM(Structural Similarity Index Measurement)指标和峰值信噪比PSNR(Peak Signal to Noise Ratio)指标。其中,结构相似度SSIM用来衡量两幅图像的相似程度,取值范围为[0,1],峰值信噪比PSNR用来表示一幅图像中有用信号和噪声的比值,两者都是越大越好。两指标对应的数学表达式分别如式(8),式(9)所示:

其中,和分别为图像和图像的均值,和为两幅图像的标准差,为两幅图像的协方差,和为常数。

其中,为去雾后的图像与清晰图像的最小均方误差,一般取255。

在SOTS上的客观指标如表3所示(数据为均值)。可以看出:经本文网络处理得到的图片在SSIM指标上领先其他算法,PSNR指标也优于大部分算法,取得了不错的结果,辅助验证了所提网络的有效性。

表 3. SOTS数据集评测指标

Table 3. SOTS evaluation indicators

| ||||||||||||||||||||||||||||||||||||||

3.3 真实图像数据集定量评估

3.3.1 主观评价

为了进一步证实所提网络的实用价值,本文对其在真实场景下的效果图像进行实验评估,各算法去雾效果如图7所示。可以发现:He算法对于含丰富近景的图像去雾效果良好,但由于最小滤波器使用造成透射率误估,使得复原图像在边缘处容易出现光晕,以及大气光估计不准确,导致去雾图像在含天空的远景区域严重失真,如图7(b)所示;与其他算法相比,Zhu算法和Qin算法都存在去雾不彻底,细节损失严重等问题,尤其Qin算法更加明显,如图7(c)中红框所示部分;Cai算法去雾效果显著,尤其天空区域颜色恢复自然,但部分图像去雾程度过大,导致部分像素点丢失图像变暗,如图7(d)红框中树叶部分以及船体部分所示;Ren算法效果图去雾彻底,但有明显的偏色问题特别是包含天空部分的区域,如图7(e)中图像3的树叶、图像5的前景部分以及图像2和图像6的天空区域;Li算法整体去雾效果较好,部分区域存在颜色失真现象,如图7(f)中图像4的草丘;和其它算法相比,本文算法效果图去雾彻底,细节保持良好,复原场景清晰自然。

图 7. 真实场景各算法去雾效果对比图(图像1-6)

Fig. 7. Comparison of restoration effects in real scenes(Image1-6)

3.3.2 客观评价

客观评价采用真实场景去雾领域中经常使用的无参考的图像质量评估法[23],其评价指标包括:饱和像素点个数m、可见边集合数e、平均梯度r以及运行时间t(单位:秒);其中饱和像素点个数和运行时间数值越小,算法表现越好;可见边集合数e和平均梯度r数值越大,表明算法效果越好。

各算法中各指标如表4所示(表中数据为均值)。由表可以看出:所提网络在饱和像素点个数和运行时间指标上有较好的表现,并且在可见边集合数和平均梯度两指标上具有领先优势。与其它各算法相比,所提网络在可见边集合数e上提高了28.1%,在平均梯度r上提高27.9%。

表 4. 真实场景各评价指标

Table 4. Indicators for real scenes

|

3.4 消融实验

为了进一步验证所提各模块对最终去雾结果的贡献,随机挑选数据集SOTS中的一幅图像进行如下的消融实验。主要包括:1)仅提取有雾图像的加性特征AF来复原图像;2)仅提取有雾图像的乘性特征MF来复原图像;3)加性特征AF和乘性特征MF共同作用(AF+MF)。

由图8对比图可以看出:AF图像只保留了一些全局特征,细节信息大量丢失;MF图像细节信息明显增多,但存在去雾不彻底和偏色的问题。相比之下,由AF和MF两个特征共同作用下的图像不仅保留了原图像的色彩而且细节信息明显去雾也较彻底,各图像指标如表5所示。从表5可以看出,由AF和MF两特征共同作用下得到的图像在指标SSIM和PSNR上得到了显著提升。

表 5. 在SOTS数据集上的评测指标对比

Table 5. Comparison of indicators on the SOTS

|

4 结 论

针对目前传统算法以及现有网络存在的不足,提出了一种基于CNN的分离特征和协同网络的端到端图像去雾模型。其设计从大气散射模型变形公式出发,充分考虑对图像乘性特征MF和加性特征AF的提取。通过密集级联和跨层连接有效提升网络精度,减小模型部署成本,提高网络运行效率。实验表明:所提网络去雾效果良好且图像保真度高,与其它算法相比优势明显,有效解决了当前图像去雾不彻底、颜色偏移及细节保持不佳、可见度下降等问题。但由于该网络的复原模块本质上还是依靠大气散射模型,复原出的部分图像在细节保持及天空区域的颜色保真度方面仍存在不足,提高去雾模型的准确性将是今后进一步的研究重点。

[1]

[2]

[3] WANG W, YUAN X, WU X, et al. Fast image dehazing method based on linear transformation[J]. IEEE Transactions on Multimedia, 2017, 19(6): 1142-1155.

[4] HE K, SUN J, TANG X. Single image haze removal using dark channel prior[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33(12): 2341-2353.

[5] ZHU Q, SHAO L. A fast single image haze removal algorithm using color attenuation prior[J]. IEEE Transactions on Image Processing, 2015, 24(11): 3522-3533.

[6] HU H M, ZHANG H D, ZHAO Z C, et al. Adaptive single image dehazing using joint local-global illumination adjustment[J]. IEEE Transactions on Multimedia, 2020, 22(6): 1485-1495.

[7] YANG Y, WANG Z W. Haze removal: push DCP at the edge[J]. IEEE Signal Processing Letters, 2020, 27: 1405-1409.

[8] BOLUN CAI, XIANGMIN XU, KUI JIA, et al. DehazeNet: an end-to-end system for single image haze removal[J]. IEEE Transactions on Image Processing, 2016, 25(11): 5187-5198.

[11] QIN X, WANG Z L, BAI Y C, et al. FFA-net: feature fusion attention network for single image dehazing[J]. Proceedings of the AAAI Conference on Artificial Intelligence, 2020, 34(7): 11908-11915.

[12] WANG A N, WANG W H, LIU J L, et al. AIPNet: image-to-image single image dehazing with atmospheric illumination prior[J]. IEEE Transactions on Image Processing, 2019, 28(1): 381-393.

[14] LI R D, PAN J S, HE M, et al. Task-oriented network for image dehazing[J]. IEEE Transactions on Image Processing, 2020, 29: 6523-6534.

[16] LIU R S, FAN X, HOU M J, et al. Learning aggregated transmission propagation networks for haze removal and beyond[J]. IEEE Transactions on Neural Networks and Learning Systems, 2019, 30(10): 2973-2986.

[18] LI C Y, GUO C L, GUO J C, et al. PDR-net: perception-inspired single image dehazing network with refinement[J]. IEEE Transactions on Multimedia, 2020, 22(3): 704-716.

[20] SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[J]. 3rd International Conference on Learning Representations, 2015.

[21] LI B Y, REN W Q, FU D P, et al. Benchmarking single-image dehazing and beyond[J]. IEEE Transactions on Image Processing, 2019, 28(1): 492-505.

[23]

Article Outline

杨燕, 梁小珍, 张金龙. 分离特征和协同网络下的端到端图像去雾[J]. 光学 精密工程, 2021, 29(8): 1931. Yan YANG, Xiao-zhen LIANG, Jin-long ZHANG. End-to-end image dehazing under separated features and collaborative network[J]. Optics and Precision Engineering, 2021, 29(8): 1931.