基于微振镜结构光投射器的机器人抓取  下载: 900次

下载: 900次

1 引言

随着机器人行业的发展,对视觉技术在机器人上的应用提出了很多新的要求,机器人作为人类进行生产和生活的帮手,其功能在一步一步的演进,尤其是机器人在工业上的应用。机器人视觉技术的主要功能是对物体进行匹配和定位,而对于提高自动化生产能力的工业机器人来说,如何实现快速、高精度的定位是其主要功能的体现,尤其是在德国提出工业4.0之后机器人的使用更是掀起了智能化应用的热潮。工业机器人的技术主要应用在对散乱物体的拾取和分类上,将机器人全自动拾取零件的过程称为Bin-picking[1],这样的机器人系统主要包括可编程的机械手硬件系统、具有识别和定位能力的视觉系统及可规划机械手抓取路径的软件系统。视觉系统的主要功能是从一堆散乱放置的物体中识别出需要抓取的物体并计算出物体所处的空间位置,然后规划出机器人抓取路径,从而实现对零部件的抓取分类过程。在国外机器人系统中,已大量地使用了视觉定位系统用于散乱摆放的物体抓取。如日本Fanuc公司推出的基于iRVision的Bin-picking系统(该系统采用4个相机完成三维视觉重建和目标定位功能),德国ISRA Vision公司的三维Shape Scan系统,丹麦Scape Technologies公司的Scape-Tech Discs系统及德国Sick公司的PLB-500系统。

机器人视觉定位主要是对物体的识别和定位两个步骤,传统的方法主要是基于特征和基于模型的方法。基于特征主要是在图像二维特征上采用边界、空洞、特殊形状来描述物体的特征从而实现识别的过程并分析特征在空间的位置变换关系来计算零部件的空间位置,此种方法简单易实现,但是容易受到环境光线和遮挡的影响,而且不易扩展。基于模型主要是基于三维模型,首先使用物体三维数据获取设备得到所有零部件的三维数据,然后在三维数据中识别和匹配到想要抓取的物体并计算出物体所在坐标系的空间坐标和法线信息,此种方法识别准确率高、定位精度高。但是如何快速获取高精度的三维数据是企业研发的难点,无论是基于激光三维获取[2]还是基于结构光三维数据获取的方法硬件成本都非常高,而且国内机器人公司引进国外技术的成本太高,无法实现批量装配。为了降低成本,国内研究人员在三维数据获取上采取了一些低成本的方案,例如基于视觉三维传感器RGBD的方式[3-4](如微软的Kinect、Intel的Realsense等)或是基于散斑三维重建[5]的方式。这些低成本的方案具有速度快和方便实现的优点,但是其缺点是三维数据精度低,只能满足一些大物体对精度要求不高的特殊情形,对于工业上绝大部分的要求都无法满足。而国内基于结构光高精度获取三维数据的设备也有很多,但这些设备都是基于DLP(digital light processing),即数字光处理投影仪[6],其体积大、速度慢,只能完成线下的物体三维数据获取,无法满足工业上实时快速的需求。为了满足机器人定位的快速和高精度的要求,本文提出一种基于微振镜(MEMS)结构光三维重建的机器人抓取方法。

2 微振镜结构光原理与三维重建

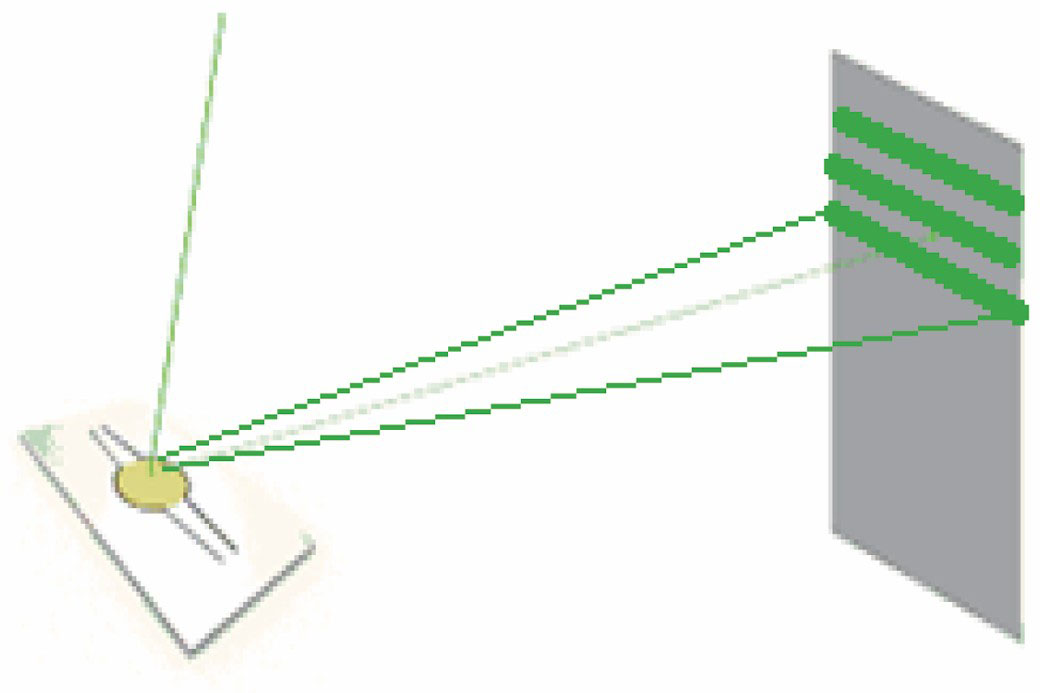

快速三维数据的获取主要是基于双目结构光设备,包括一个投影设备和两个工业相机,工作方式是通过快速地投射系列图案并使用两个已经标定好的相机来进行同步采集,最后计算出空间三维信息。其快速的特点是源于可编程的投影设备,这种投影设备是通过激光控制器使激光线来回扫描形成光栅图片并投射出去,然后利用两部工业相机同步采集图像。

快速获取到图像之后,采用基于多频外差的方法实现对物体三维信息的重建。其主要原理是通过投影设备投射一系列不同频率的光栅条纹图像到被测量物体表面,并使用双目相机来同步采集因物体表面高度调制而变形的光栅图像。然后对变形的光栅图像进行相位解包裹,计算出对应的绝对相位值,根据双目三维重建原理计算出对应的三维信息。

2.1 微振镜结构光发生器

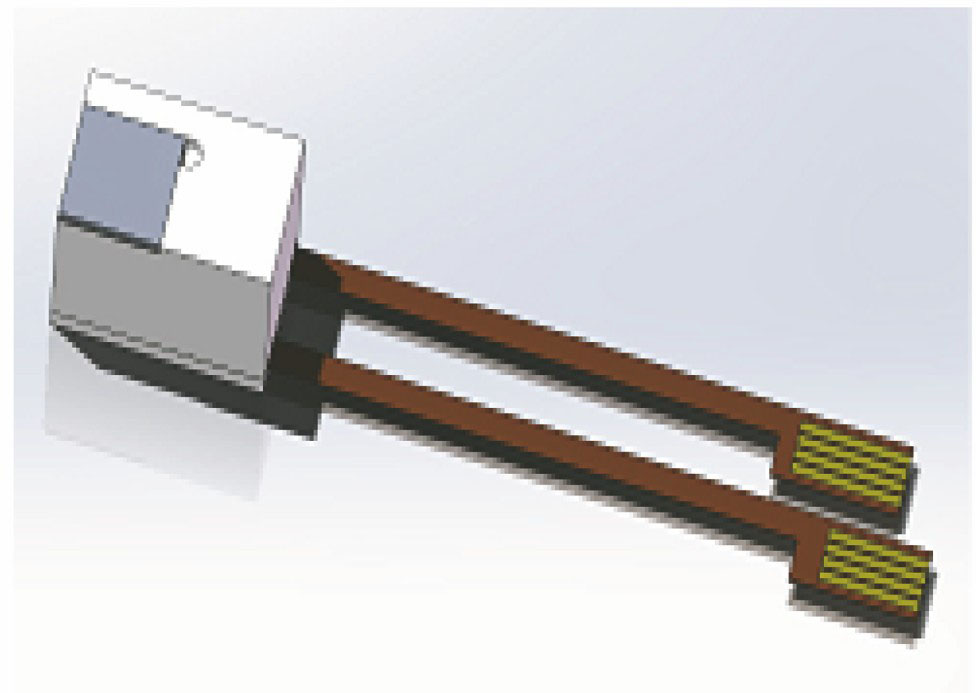

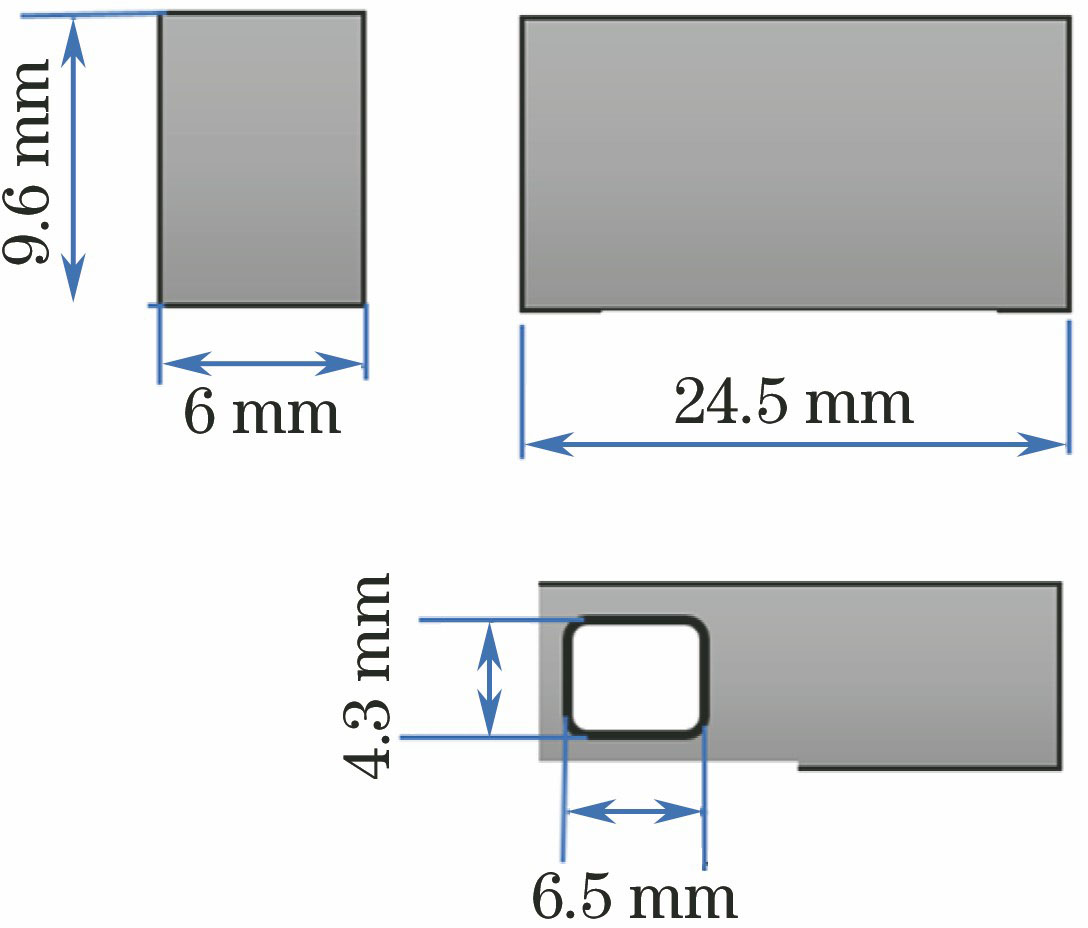

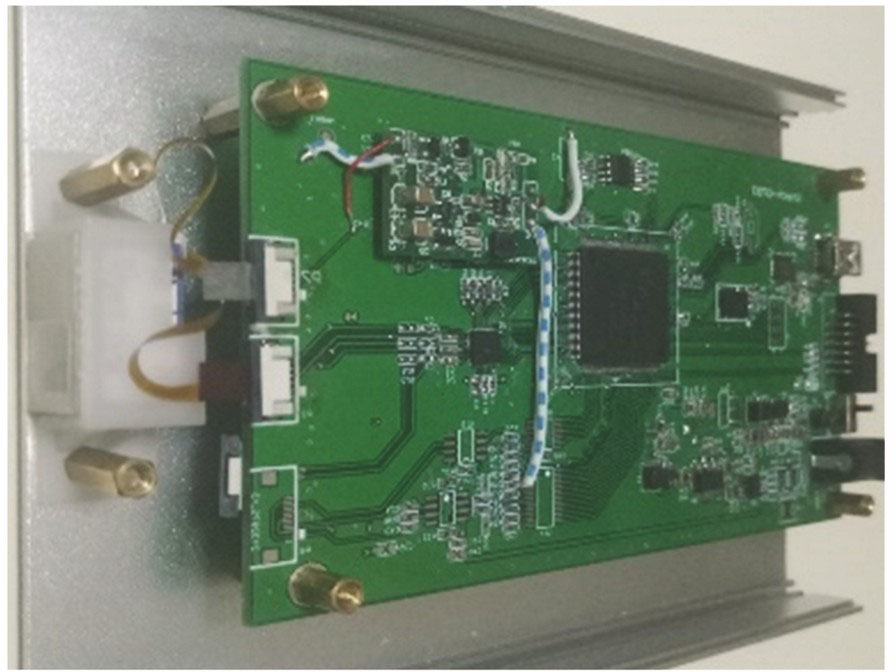

基于结构光三维重建的传统方法中光栅图像的投射采用的是DLP投影仪的方式,这种方法投射时间长,并且投影仪体积大,无法满足机器人抓取的工业需要。为了满足机器人在抓取物体过程中要求快速、精度高及体积小的特点,提出一种可编程的激光投影方式来投射结构光三维重建需要的光栅图片,其核心的激光模组如

表 1. 微振镜指标参数

Table 1. MEMS parameters

|

利用人眼的视觉暂留现象,二维微振镜[7-8]在一定的帧频下(大于25 Hz),通过李萨如扫描将激光点束投射照亮整个屏幕区域,并配合单色或三色激光的高频同步亮度调制,可以实现图像和视频的投影。这种投影系统不需要任何光学镜头,只需简单改变投影系统和屏幕的距离,不需要作任何焦距调整,即可实现不同大小的屏幕区域。此外,由于任何一个瞬间屏幕上只有一个像素点亮,激光器的功率都集中在一个像素上,不需要很大的激光器功率就可以实现较高的亮度,且不需要庞大的光源散热系统,整个投影系统集成化非常高。

点束激光器发出的激光束经过光学系统调制后变成激光线[9],并经过微振镜反射投射到被测对象上。当微振镜不扫描时,被测对象上呈现一条激光线,而当微振镜扭转扫描时在被测对象上将激光线投射成矩形光幕,如

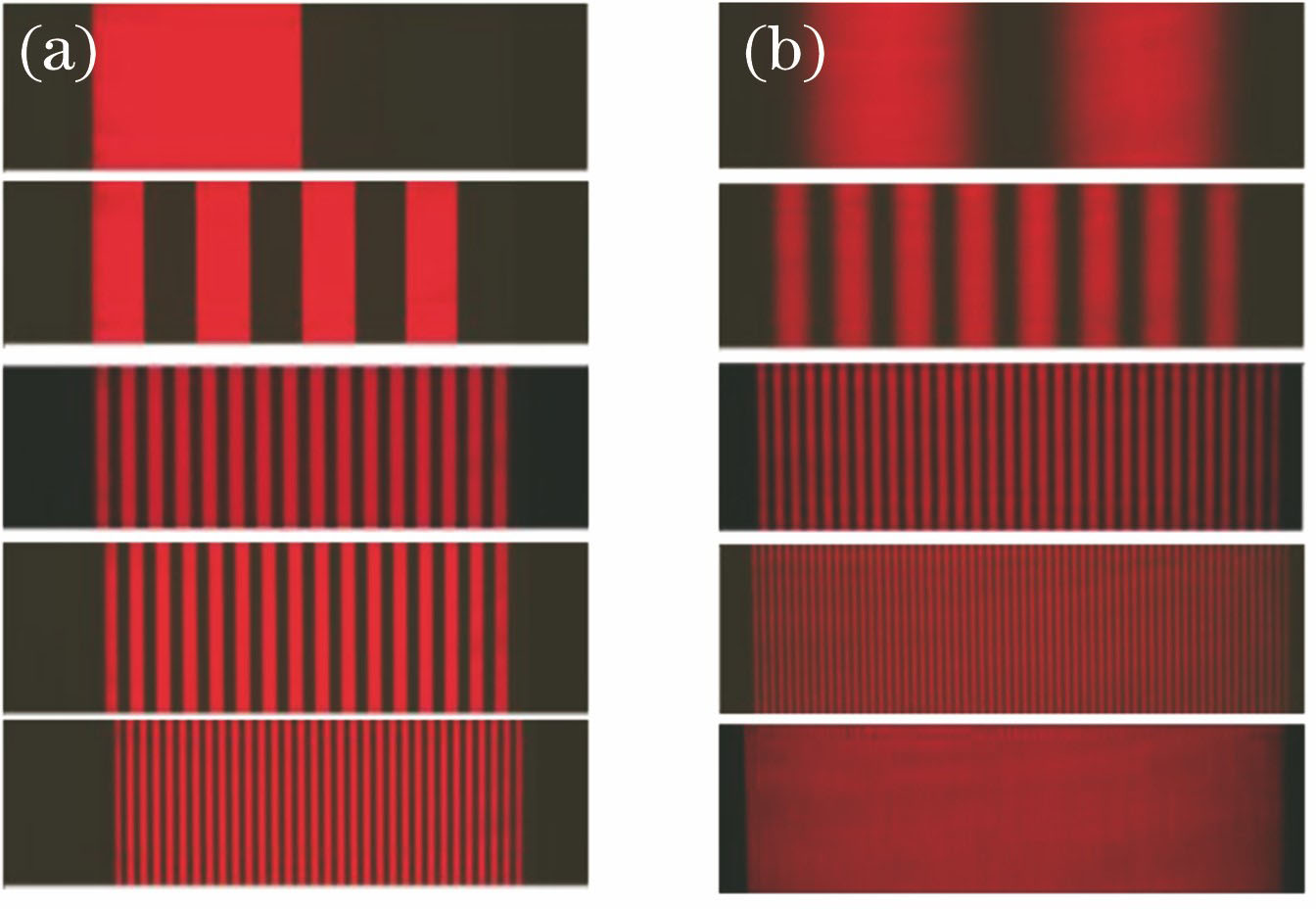

根据需求可以投射出不同类型的光栅,可以投射一定频率的方波,也可以投射一定频率的正弦波。如

基于激光束调制而成的结构光光栅投射器,具有速度快、可编程、易控制及体积小等特点,而且输出的激光功率小对人眼没有伤害,具体参数如

表 2. 激光模组参数

Table 2. Laser module parameters

| |||||||||||||||||

2.2 多频外差三维重建算法

三维重建算法使用的是基于多频外差的方法[10-11],首先使用微振镜结构光发生器投射几组不同频率的光栅图片到被测物体上,并且每个频率的光栅采用四步相移的方法分别投射4幅光栅图像。使用基于多频外差的方法的目的就是获取到图像上每个点的包裹相位[12],而使用相移方法能很好地解决这个问题。此方法最大的优点就是图像上的相位值不会受到相邻点光照强度的影响,也可以抵消被测物体表面粗糙不均匀而造成的光照不均匀的影响。

通过微振镜激光发生器将一组正弦性质的光栅投射到被测物体上,受被测物体高度调制而产生的光强函数可以表示为

式中,

式中

包裹相位计算完成之后,使用多频外差的方法对包裹相位进行展开。设每套条纹的包裹相位图为

式中,

通过使用5个不同频率的正弦波可以获得双目相机对应的展开相位图,然后根据双目立体三维重建方法对物体进行三维重建,以此获得物体的三维信息。

3 三维物体匹配与定位

获取到物体三维数据之后就可以对散乱的物体进行匹配和定位操作。机器人抓取的过程就是在一堆散乱放置的物体中识别并定位到每个物体,这个过程主要分为三个步骤:第一是获取散乱放置的物体的三维数据;第二是在获取的三维数据里面识别到被抓取的物体,由于在实际操作过程中物体的放置是随机的,而且相互有重叠,如何在随机放置的物体中快速识别到物体是关键;第三是识别到物体之后对每个识别到的物体进行定位,即获取到每个物体在机器人坐标系下的三维坐标和法线信息。

3.1 三维物体匹配

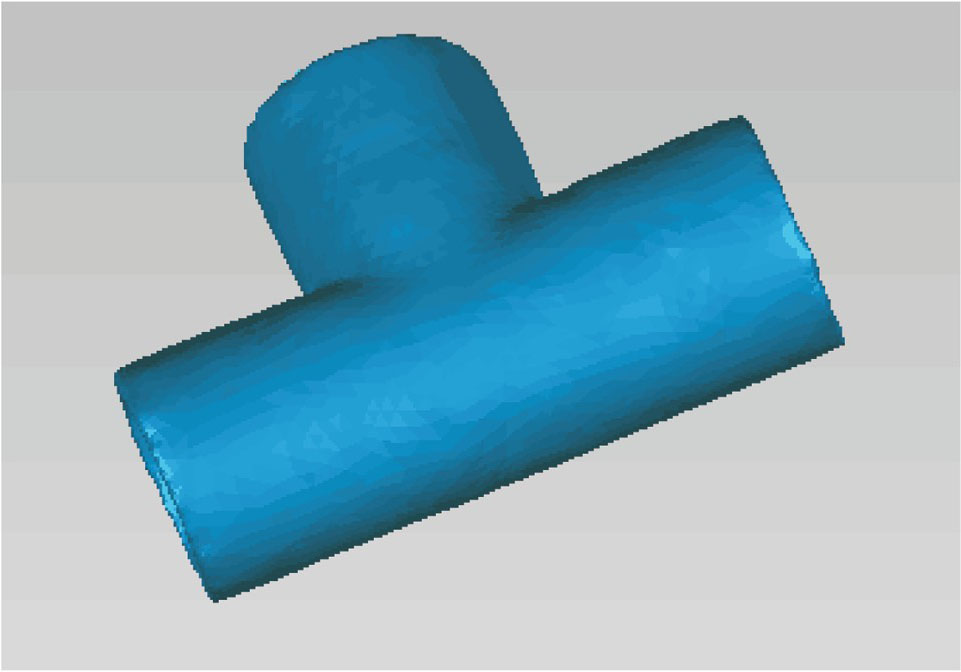

在机器人抓取过程中,三维物体的准确匹配是抓取的前提。其基本思路是在扫描的三维数据中寻找与被抓物体具有相同模式的三维数据。被抓取物体的三维模型可以事先得到,使用被抓取物体的模型在三维数据中匹配到需要抓取的物体,一次重建的三维数据中可以匹配到多个被抓的物体,这样可以把机器人视场内看到的物体尽量多的一次匹配完成,在定位物体时也可以一次完成所有被抓物体的定位。如果被抓取的物体在抓取过程中不会对其他物体产生位移影响可以一次扫描多次抓取;如果在抓取的过程中对其他物体产生了位移的影响,可以在机器人放置物体的过程中重新扫描重建,每次只抓取一个物体。此方法要求物体在获取三维数据和定位的时间内保持静止状态。

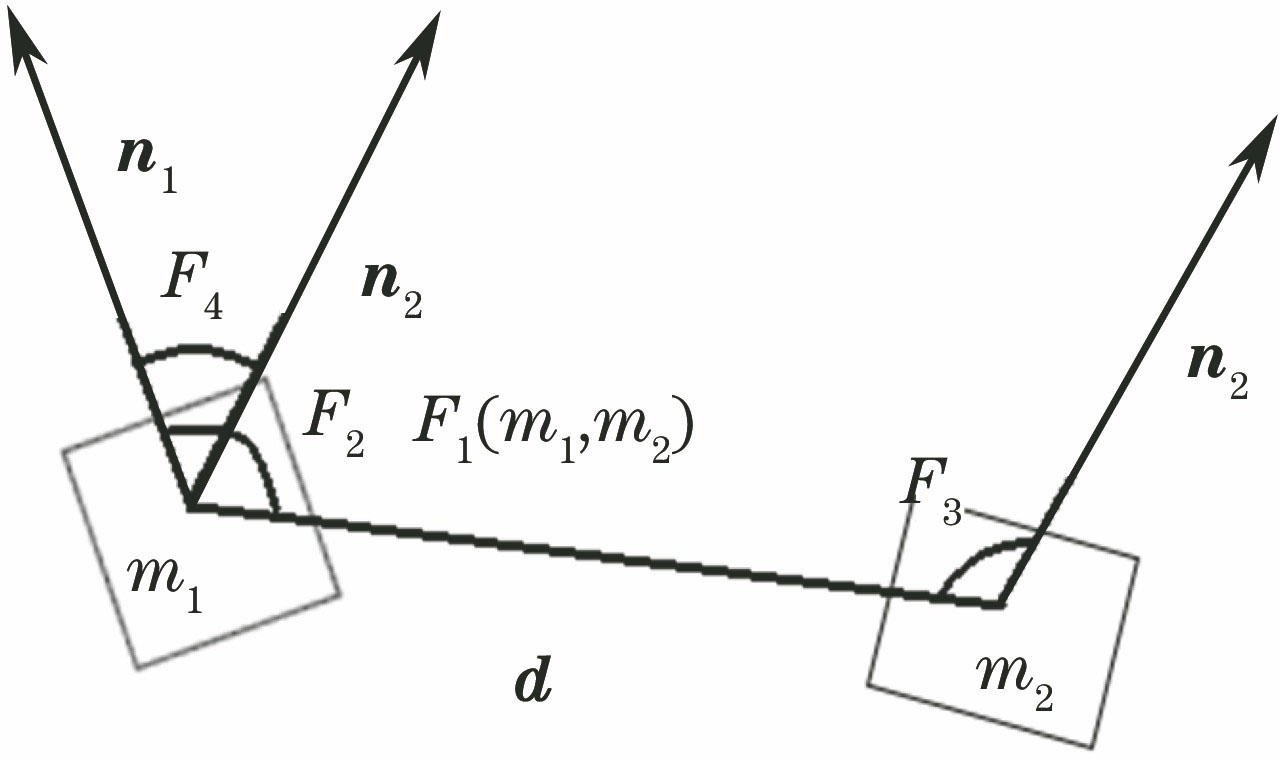

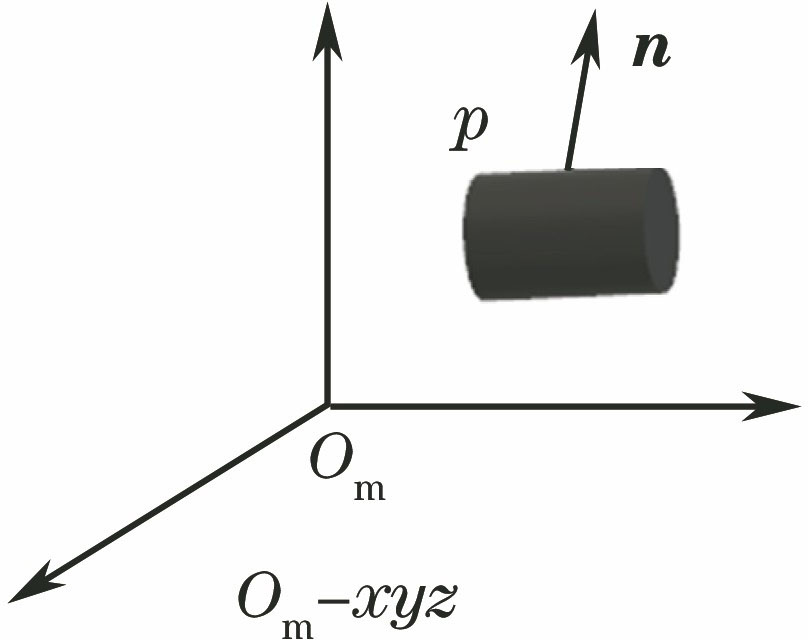

使用一种基于三维点PPF(point pair feature)[13-14]的方法实现物体的三维匹配。其核心思想就是在基础模型上和扫描得到的三维数据上建立一种描述三维特征的关系,然后使用这些特征进行匹配找到最佳的反应物体之间的旋转和位置关系[15]。设

式中∠(

可以使用PPF来描述整幅三维点云数据的特征,如

取基础模型上任意一点

式中,

式中

3.2 三维物体的定位

三维物体匹配完成之后可以得到一幅三维点云中有多个匹配成功的物体及这些物体与基础模型之间的变换关系。根据这个变换关系就可以找到点云中对应的实际物体在机器人坐标系下的位置和法线信息。

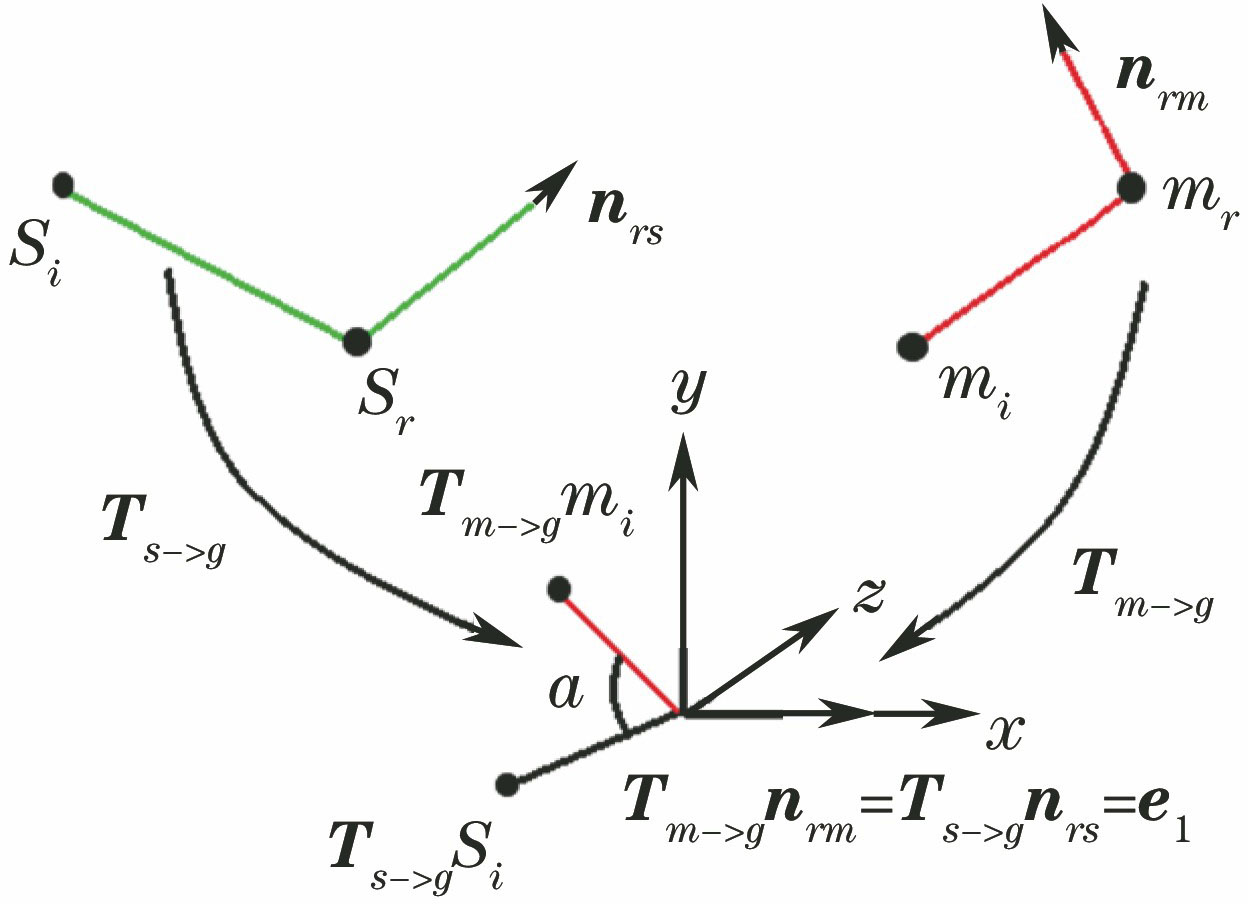

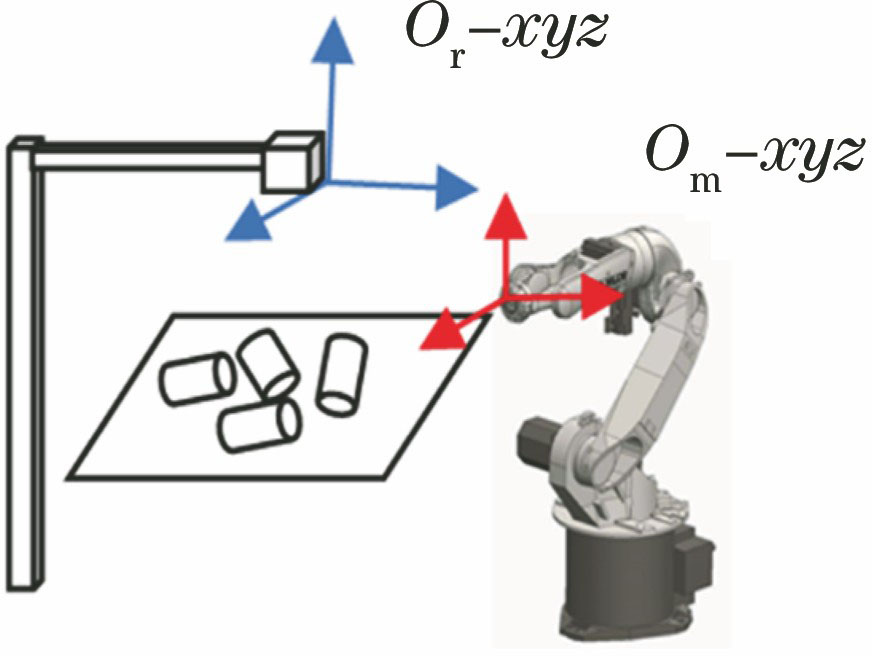

如

三维定位就是找到散乱放置的物体在相机坐标系

式中

4 实验

在基于快速结构光三维重建的机器人抓取过程中,首先需要重建出散乱摆放的系列物体的三维数据,然后使用被抓取物体的基础模型在重建的三维数据上进行匹配,通过定位到的关系确定散乱放置的物体在机器人坐标系下的位置和法线信息,最后机器人可以根据位置和法线信息来抓取某个物体。本研究的实验主要是基于快速结构光的方法,因此研究重点在三维数据的获取和定位过程。并在速度和精度上和传统的三维获取的方法进行比较。

快速结构光系统如

表 3. 系统参数

Table 3. System parameters

| ||||||||||||||||

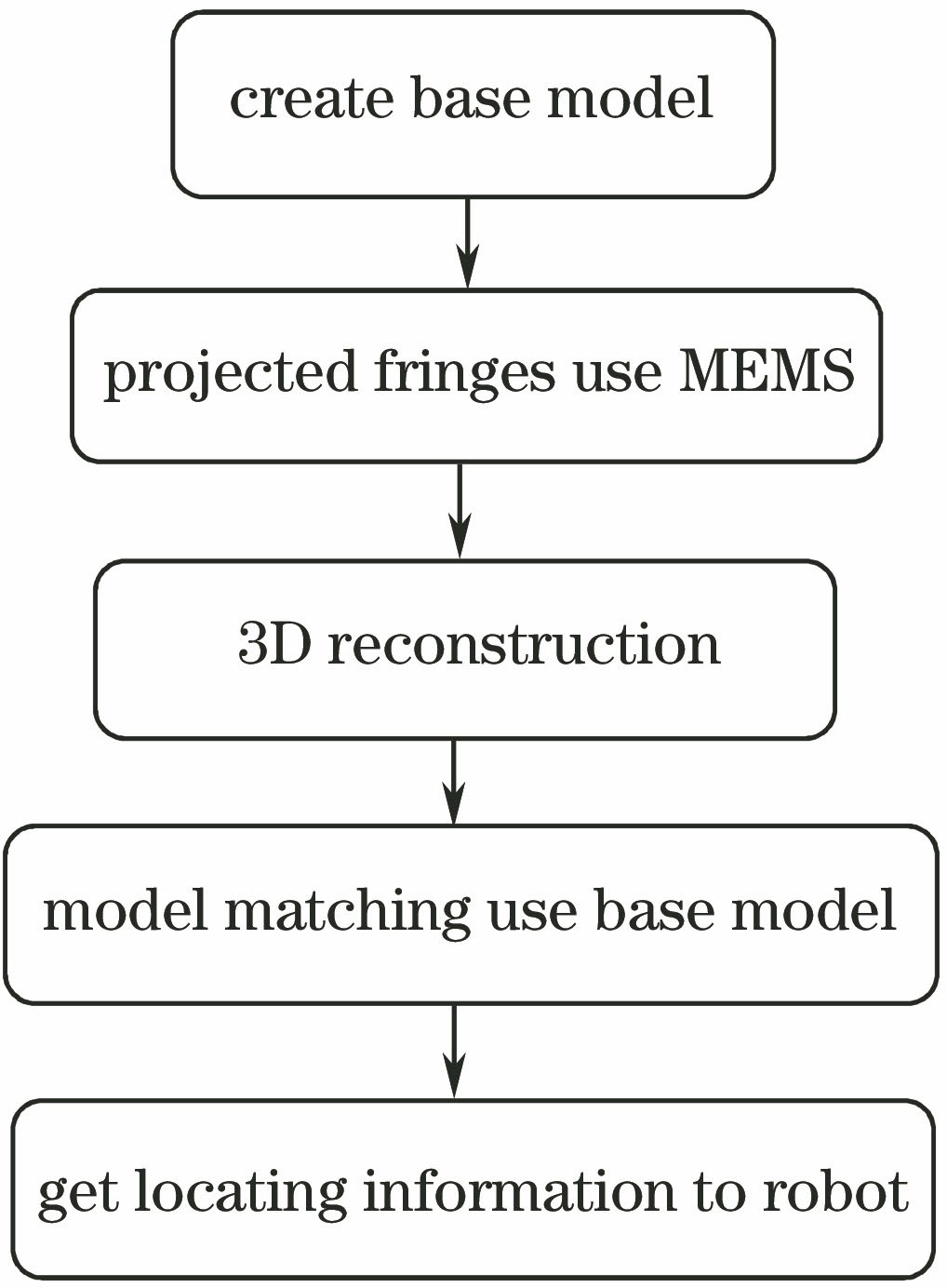

三维定位的处理过程如下,其对应的流程图如

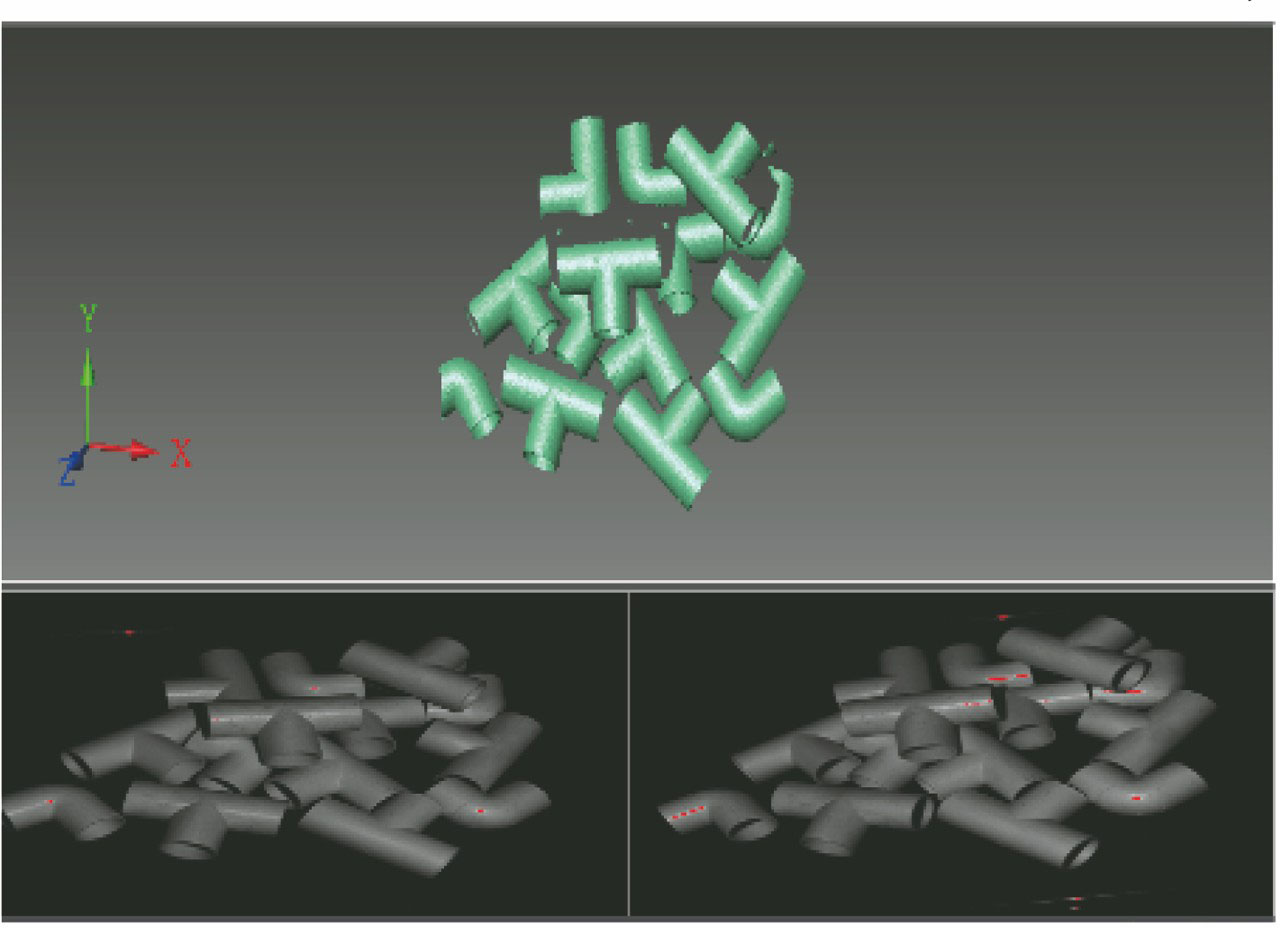

1) 载入需要抓取的物体基础模型,如

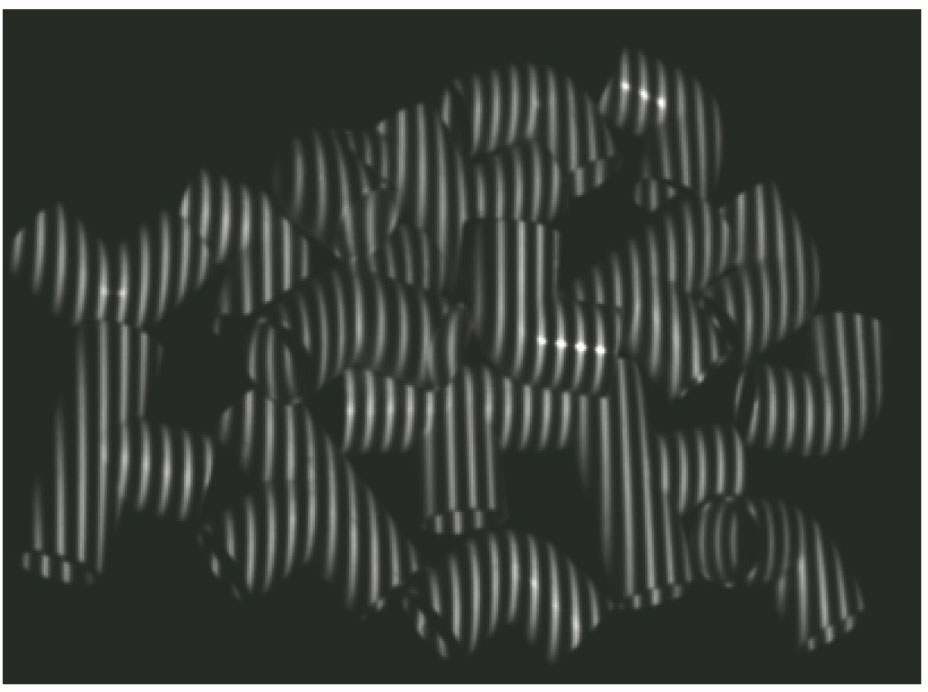

2) 使用基于振镜的双目扫描设备投射条纹,如

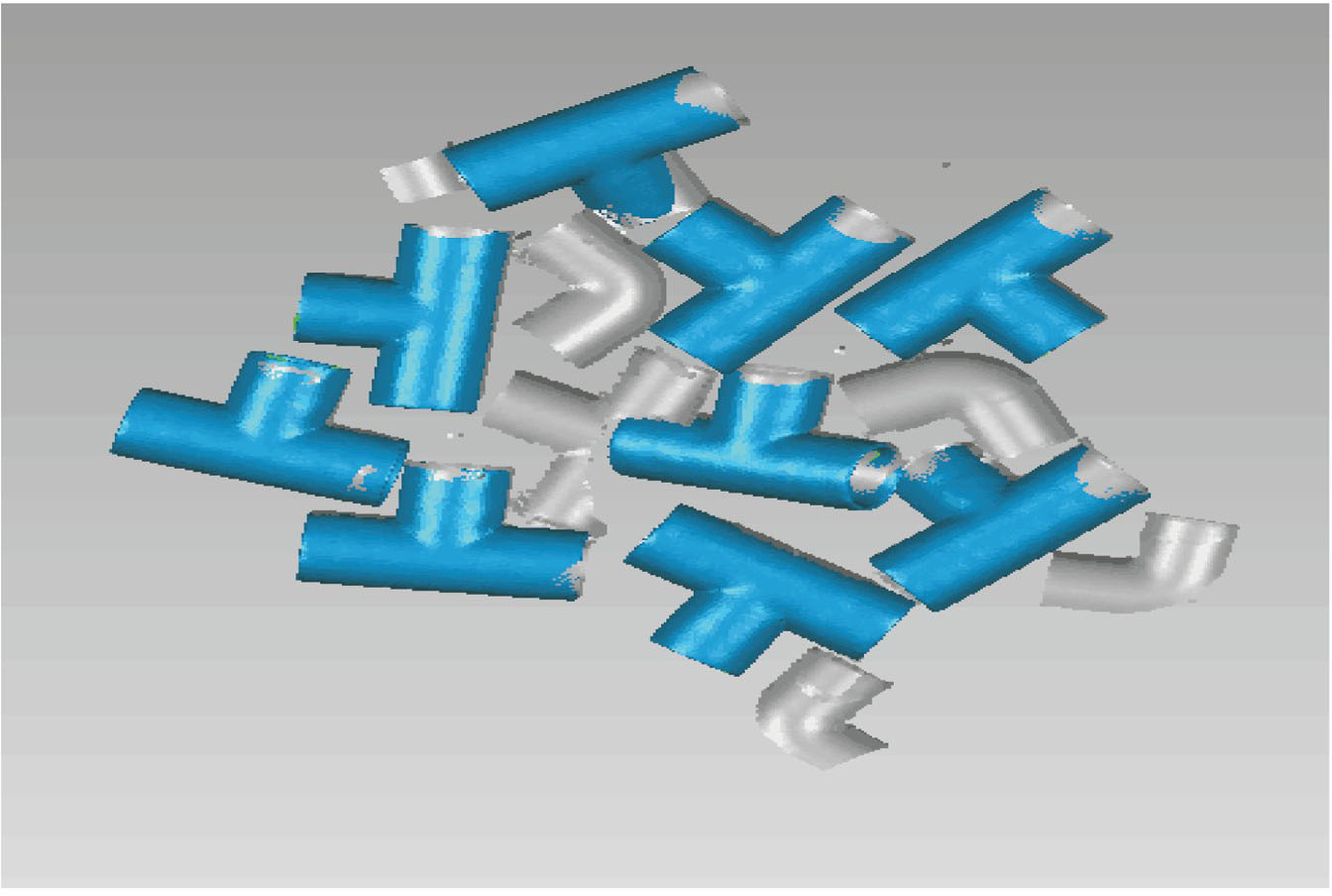

3) 使用基础模型在三维数据上进行匹配,找到所有匹配到的物体在机器人坐标系下的位置和法线信息,如

4) 将所有的定位信息传输给机器人,通过分析即可完成物体的抓取动作。

图 14. 相位主值和相位展开图。(a) 1 Hz的相位主值;(b) 4 Hz的相位主值;(c) 16 Hz的相位主值;(d) 64 Hz的相位主值; (e) 128 Hz的相位主值;(f)相位展开图

Fig. 14. Principal value maps of phase and phase unwrapping graph. (a) Phase principal value of 1 Hz; (b) phase principal value of 4 Hz; (c) phase principal value of 16 Hz; (d) phase principal value of 64 Hz; (e) phase principal value of 128 Hz; (f) phase unwrapping graph

表 4. 定位信息

Table 4. Locate information

|

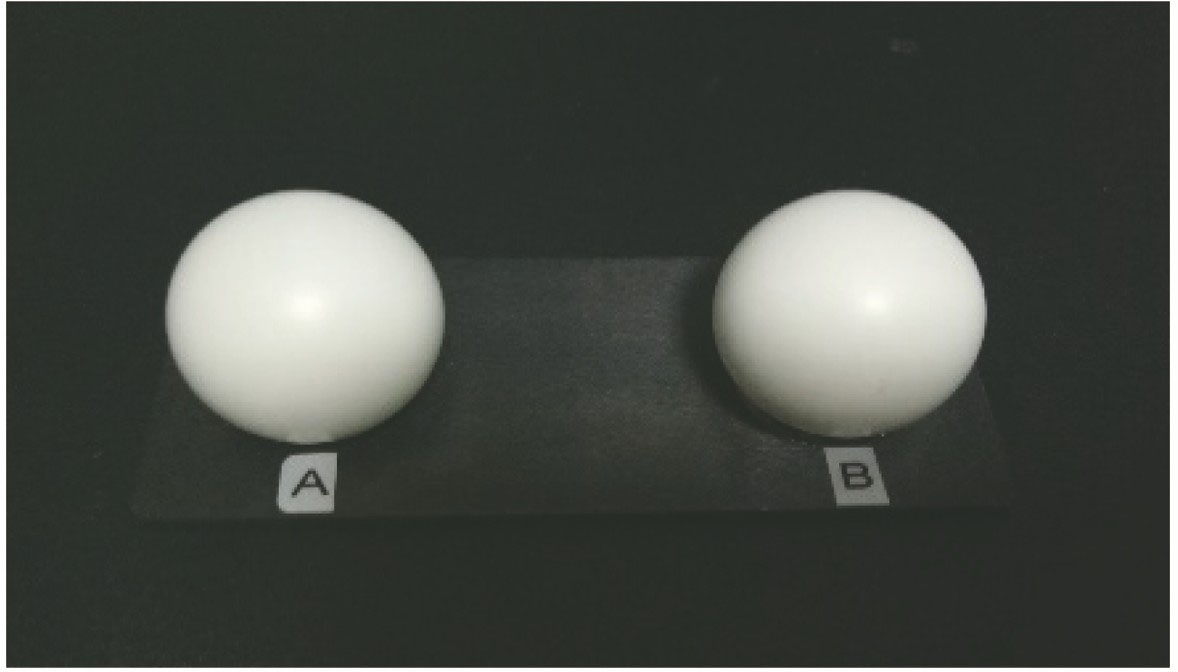

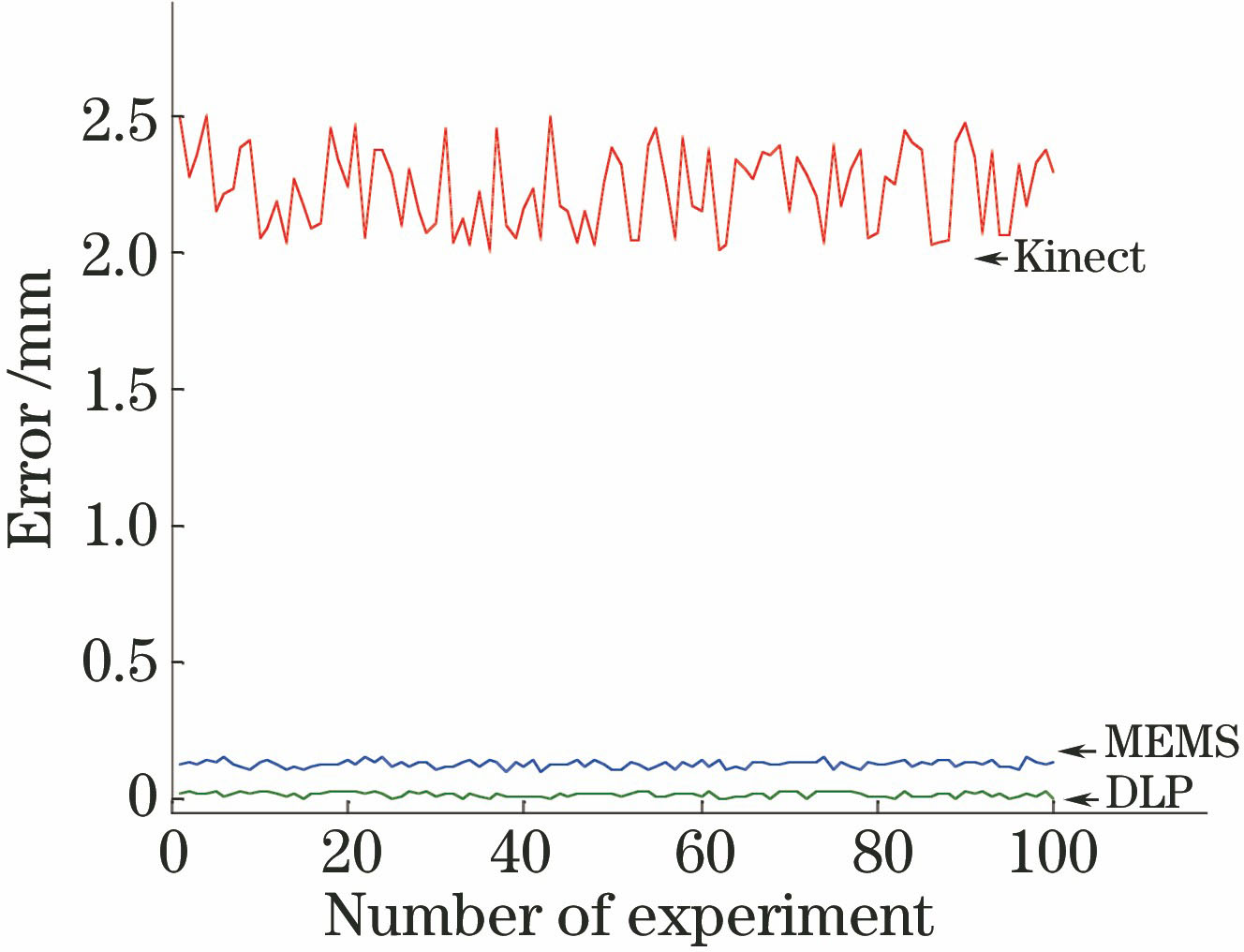

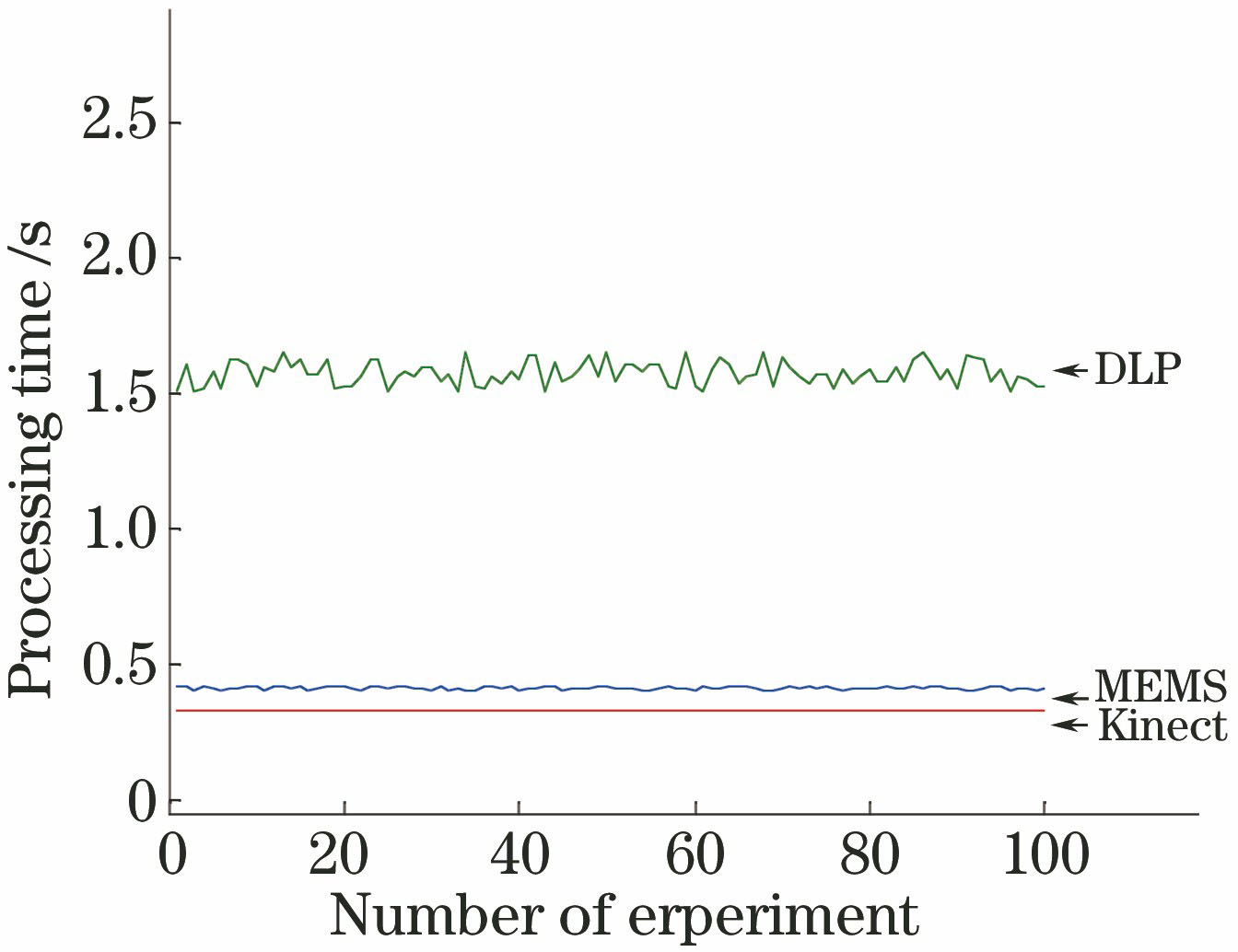

基于激光振镜结构光的机器人定位的方法可以快速地获取三维信息,并达到理想的定位精度。验证精度采用的是基于标准球的方法,如

表 5. 精度与处理时间的比较

Table 5. Comparison of accuracy and processing time

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||

5 结论

提出了一种基于微振镜结构光投射器的方式来获取物体的图像数据并采用基于双目立体视觉和多频外差的方法来对物体进行三维重建,从而快速地获取物体的三维信息;然后利用获取的三维数据通过使用PPF特征来完成三维物体的匹配和定位操作;最后找到散乱放置的物体在机器人坐标系下的三维坐标和法线信息,从而给机器人提供抓取的三维坐标和方向信息。通过实验可以看出采用基于微振镜结构光的方式可以获得与投影仪相同数量级的精度,同时拥有与Kinect方式相同的时间效率。此方法定位的精度在0.1 mm左右,处理的时间在0.4 s左右。基于微振镜的机器人定位抓取方法不仅在精度和速度上具有优势,其小型化的产品结构更有利于机器人的工业结构实现。

[1] Borowski T SW. Object detection and pose estimation of randomly organized objects for a robotic bin-picking system[D]. Blekinge: Blekinge Institute of Technology, 2012: 12- 13.

Borowski T SW. Object detection and pose estimation of randomly organized objects for a robotic bin-picking system[D]. Blekinge: Blekinge Institute of Technology, 2012: 12- 13.

[2] 陈影, 孙文磊, 黄勇, 等. 激光熔覆曲面零件再制造的机器人路径规划[J]. 中国激光, 2017, 44(5): 0502001.

陈影, 孙文磊, 黄勇, 等. 激光熔覆曲面零件再制造的机器人路径规划[J]. 中国激光, 2017, 44(5): 0502001.

[3] YuY, Song YH, Zhang YL, et al. A shadow repair approach for Kinect depth maps[M] ∥Lee K M, Matsushita Y, Rehg J M, et al. eds. Computer Vision-ACCV 2012. Berlin, Heidelberg: Springer, 2013: 615- 626.

YuY, Song YH, Zhang YL, et al. A shadow repair approach for Kinect depth maps[M] ∥Lee K M, Matsushita Y, Rehg J M, et al. eds. Computer Vision-ACCV 2012. Berlin, Heidelberg: Springer, 2013: 615- 626.

[5] 代红军, 苏显渝. 数字散斑时间序列相关三维面形测量方法[J]. 光学学报, 2001, 21(10): 1208-1213.

代红军, 苏显渝. 数字散斑时间序列相关三维面形测量方法[J]. 光学学报, 2001, 21(10): 1208-1213.

[6] 边心田, 苏显渝, 陈文静. 基于条纹投影的三维坐标测量方法[J]. 光学学报, 2010, 30(2): 416-420.

边心田, 苏显渝, 陈文静. 基于条纹投影的三维坐标测量方法[J]. 光学学报, 2010, 30(2): 416-420.

[7] Ko YC, Lee JH, Cho JW, et al. Gimbaled 2D scanning mirror with vertical combs for laser display[C]∥IEEE/LEOS International Conference on Optical MEMS and their Applications Conference, August 21-24, 2006, Big Sky, MT, USA. New York: IEEE, 2006: 104- 105.

Ko YC, Lee JH, Cho JW, et al. Gimbaled 2D scanning mirror with vertical combs for laser display[C]∥IEEE/LEOS International Conference on Optical MEMS and their Applications Conference, August 21-24, 2006, Big Sky, MT, USA. New York: IEEE, 2006: 104- 105.

[10] 陈松林, 赵吉宾, 夏仁波. 多频外差原理相位解包裹方法的改进[J]. 光学学报, 2016, 36(4): 0412004.

陈松林, 赵吉宾, 夏仁波. 多频外差原理相位解包裹方法的改进[J]. 光学学报, 2016, 36(4): 0412004.

[11] 陈玲, 邓文怡, 娄小平. 基于多频外差原理的相位解包裹方法[J]. 光学技术, 2012, 38(1): 73-78.

陈玲, 邓文怡, 娄小平. 基于多频外差原理的相位解包裹方法[J]. 光学技术, 2012, 38(1): 73-78.

[12] 章寒清. 基于多频投影条纹的物体曲面测量方法研究[D]. 长沙: 国防科技大学, 2006.

章寒清. 基于多频投影条纹的物体曲面测量方法研究[D]. 长沙: 国防科技大学, 2006.

Zhang HQ. The research based on projected various fringes for curved-surface measurement[D]. Changsha: National University of Defense Technology, 2006.

Zhang HQ. The research based on projected various fringes for curved-surface measurement[D]. Changsha: National University of Defense Technology, 2006.

[13] DrostB, UlrichM, NavabN, et al. Model globally, match locally: Efficient and robust 3D object recognition[C]∥2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, June 13-18, 2010, San Francisco, CA, USA. New York: IEEE, 2010: 998- 1005.

DrostB, UlrichM, NavabN, et al. Model globally, match locally: Efficient and robust 3D object recognition[C]∥2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, June 13-18, 2010, San Francisco, CA, USA. New York: IEEE, 2010: 998- 1005.

[14] Rusu RB, BlodowN, BeetzM. Fast point feature histograms (FPFH) for 3D registration[C]∥2009 IEEE International Conference on Robotics and Automation, May 12-17, 2009, Kobe, Japan. New York: IEEE, 2009: 3212- 3217.

Rusu RB, BlodowN, BeetzM. Fast point feature histograms (FPFH) for 3D registration[C]∥2009 IEEE International Conference on Robotics and Automation, May 12-17, 2009, Kobe, Japan. New York: IEEE, 2009: 3212- 3217.

[15] 曾繁轩, 李亮, 刁鑫鹏. 基于曲率特征的迭代最近点算法配准研究[J]. 激光与光电子学进展, 2017, 54(1): 011003.

曾繁轩, 李亮, 刁鑫鹏. 基于曲率特征的迭代最近点算法配准研究[J]. 激光与光电子学进展, 2017, 54(1): 011003.

Article Outline

黄会明, 刘桂华, 段康容. 基于微振镜结构光投射器的机器人抓取[J]. 中国激光, 2019, 46(2): 0204002. Huiming Huang, Guihua Liu, Kangrong Duan. Robot Bin-Picking Based on Micro-Electro Mechnical System Structure Light Projector[J]. Chinese Journal of Lasers, 2019, 46(2): 0204002.