融合区域匹配的快速多线结构光测量方法  下载: 536次

下载: 536次

1 引言

线结构光技术作为一种非接触式主动测量方法,具有成本低、检测效率高、适应性强等特点,被广泛应用于工业自动化中,如三维重建[1-2]、误差检测[3]及目标定位[4]。在线结构光技术中,条纹中心线提取的准确性直接影响了三维测量的精度,已有的中心线提取方法主要有极值法、灰度重心法、曲线拟合法和Hessian矩阵法等[5-7]。灰度重心法因具有速度快、稳定性好等优点近年来得到了人们的青睐,如:杨毅等[8]采用均值法和Savitzky-Golay滤波算法对灰度重心法提取的中心线进行平滑处理,减小了中心线凸起和毛刺对测量精度的影响;曾超等[9]采用灰度重心法提取的结果作为初始点,通过方向模板计算出初始点的法线方向,再将沿法线方向计算的灰度重心作为条纹的中心点,显著提高了弯曲光条的中心线提取精度;Li等[10]根据灰度重心法提取的中心点定义一个矩形区域,在矩形区域法线方向上重新计算每个中心点的坐标。基于Hessian矩阵的Steger法[11]充分考虑了激光条纹的方向和走势,提高了中心线提取的精度与稳定性,如:Xu等[12]采用Hessian矩阵计算出条纹中心初始点,利用随机采样一致性算法剔除离群点并拟合出精细的中心线;王福斌等[13]利用二次灰度重心法提取条纹中心并计算出小范围的连通域,然后利用主成分分析求解协方差矩阵的特征值和特征向量;程鑫等[14]提出一种融合极值法、Hessian矩阵法和高斯函数拟合法的中心线提取方法,在黑色胶条背景下提高了中心线提取算法的鲁棒性和精度。但这类方法较大的计算量及复杂的参数设置限制了其在工业现场的应用。

在双目线结构光系统中,立体匹配是三维重构的关键步骤,匹配精度直接影响最终的重构精度。而目前的立体匹配都依赖于激光中心线的提取,提取出左右图像的中心线后利用极线约束原理就能直接完成中心线的立体匹配,这类方法的重构精度不仅与左右图像中心线的提取精度有关,还取决于双目立体校正的精度,如:激光中心线在左右图像中存在差异(像素数目不同[15-16]、中心位置差异[17])会影响匹配精度;理论上,经立体校正后可在同一行像素中查找匹配点,但校正误差也会引起行方向产生偏差,匹配精度不高。基于区域匹配的数字图像相关(DIC)法如灰度梯度法[18-19]、曲面拟合法和反向组合法[20]的匹配精度较高,但将其用于基于灰度分布的全局匹配时计算量大,严重限制了该方法在工业实际中的应用。

针对上述问题,本文提出了一种融合区域匹配的快速多线结构光测量方法。该方法不需要考虑左右图像中心线的差异,直接以重心法提取中心线,以左图像的中心线为基准,利用DIC法在右图像中心线附近进行区域匹配,计算获得精确的匹配点,在减小DIC法区域匹配范围的同时提高了立体匹配效率,且匹配精度较高。

2 方法描述

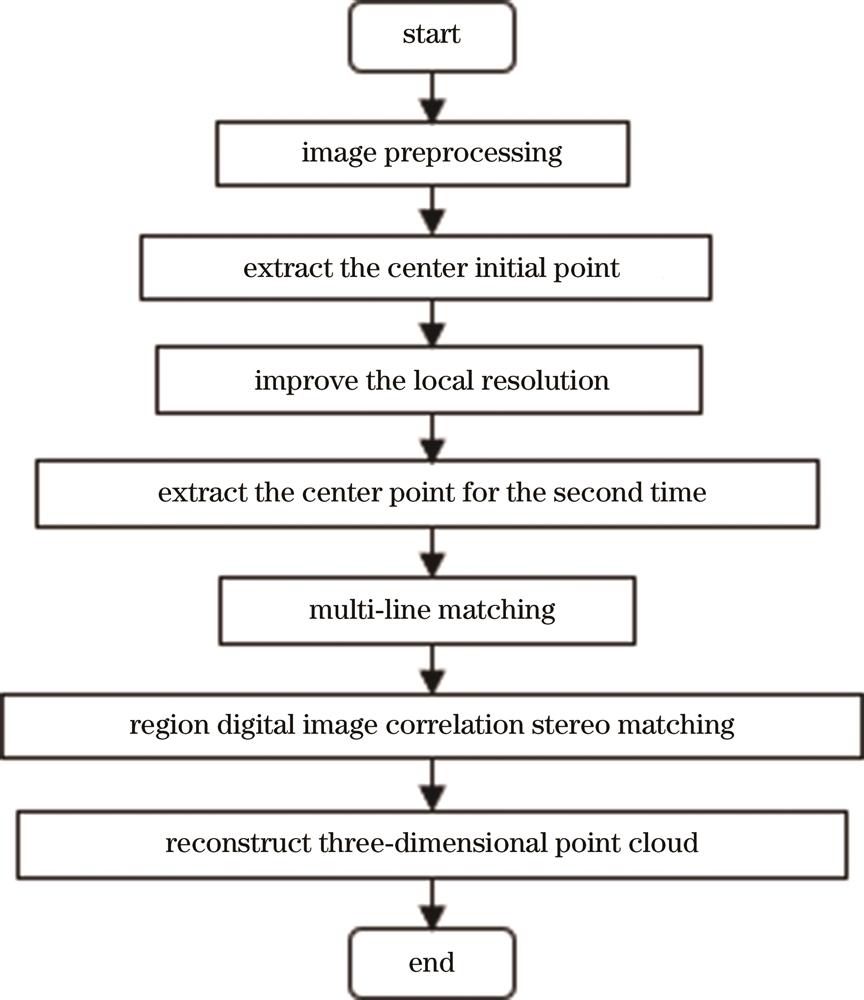

融合区域匹配的快速多线结构光测量方法主要流程如

2.1 中心初始点提取

激光条纹横截面的灰度值一般服从高斯分布,但在图像采集过程中会产生随机噪声,而双边滤波方法考虑了像素点间的距离信息和灰度信息,能保留条纹的边缘信息,有助于中心线的提取。由于测量背景复杂,图像中的非条纹区域会干扰中心线的提取,同时增加不必要的计算量。因此,根据条纹区域与背景区域的灰度值差异,设定阈值对图像进行二值化。本方法采用大津阈值法自适应计算出最佳阈值,分割出需要进行计算的条纹区域。

在条纹区域内,逐行计算灰度重心点作为条纹中心初始点。重心法的基本原理:假设某一行中像素点的坐标为

采用重心法遍历左右图像的条纹区域,可获得左右图像的所有中心初始点。

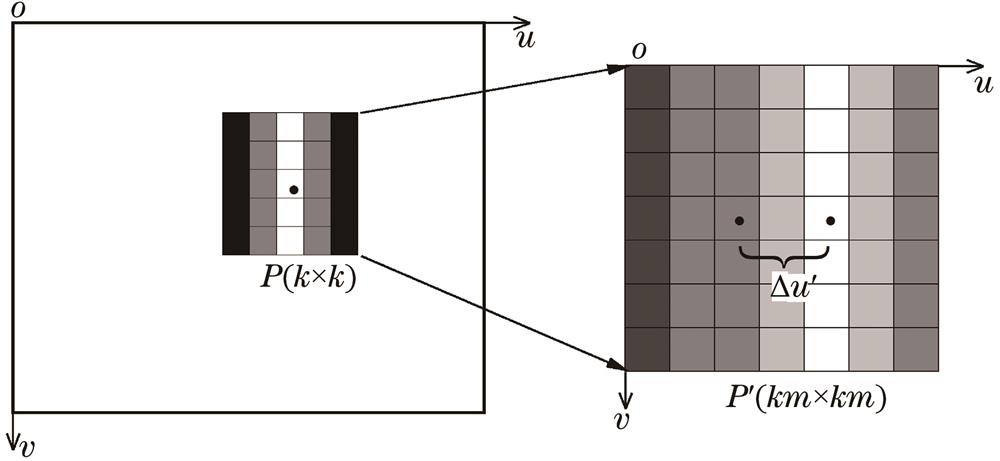

2.2 局部分辨率的提升

虽然灰度重心法的计算速度快,稳定性较好,能减少干扰引起的误差,但在不考虑条纹方向的情况下,条纹中心线提取精度较低。因此,以2.1节提取的中心点为初始点,在初始点的局部邻域内对图像分辨率进行提升,具体流程如下。

1)对于左图像和右图像中心线上的每一个点

2)受测量时环境光的影响,左图像与右图像子区内的灰度值分布不一致,且区域插值后灰度值的变化范围较小,导致后续匹配步骤中产生误差。因此,对子区域

3)采用双三次插值获得高分辨率中各像素的灰度值,此时,子区域中心不再是该行的灰度重心,需要遍历子区域

2.3 区域DIC立体匹配

在双目多线结构光系统中,中心线的立体匹配存在一对多的问题,因此基于单应性矩阵的方法解决多线激光条纹的立体匹配问题。将每条激光中心线看作是一个虚拟的光平面,每个光平面映射到左右相机像平面上的像素点形成一一对应关系,在左右相机中获得任意三个不在同一直线上的像素点,从而建立左右图像中关于该激光条纹的单应性矩阵。采用标定物通过多个中心像素点进行单应性矩阵标定,计算每条激光中心线的单应性矩阵。实际测量时,左图像的任一激光条纹中心线经过其对应的单应性变换后,将与右图中相匹配的激光中心线重合,从而快速完成左图像中各激光条纹中心线的立体匹配。完成多线条纹立体匹配后,与单线激光测量原理一样,利用极线约束原理直接计算左图像与右图像的匹配点,经过立体校正后,左图像中心线的某一点坐标

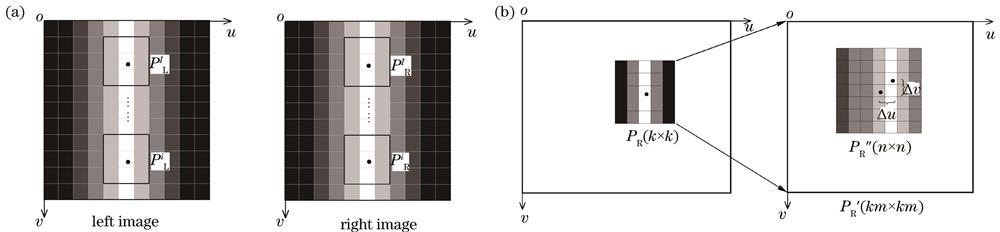

为了解决上述问题,同时考虑立体匹配的效率,提出了一种融合区域DIC立体匹配的方法。在高分辨率子区域中,以左图像提取的中心线为基准,在右图像中心线的邻近区域采用DIC方法搜索相关系数最大的像素点,并利用子区域的灰度梯度计算出亚像素位移。立体校正后的匹配精度可达到亚像素量级,因此DIC方法在右图像中的搜索范围可以限定在高分辨率子区域内。在左右图像的子区域

图 3. DIC立体匹配示意图。(a)左右图像;(b)左右图像的局部高分辨率子区域

Fig. 3. Schematic diagram of DIC stereo matching. (a) Left and right images; (b) local high-resolution sub-regions of left and right images

设

式中:

灰度变化函数

将

相关系数函数在极大值附近呈单峰性的曲面分布,相关系数函数的解即一阶导数为0的地方,可表示为

求解

式中,

结合

基于上述区域DIC立体匹配对左图像中任意一个中心点在右图像中匹配得到具有亚像素坐标的中心点,该匹配点不仅在

3 实验结果及分析

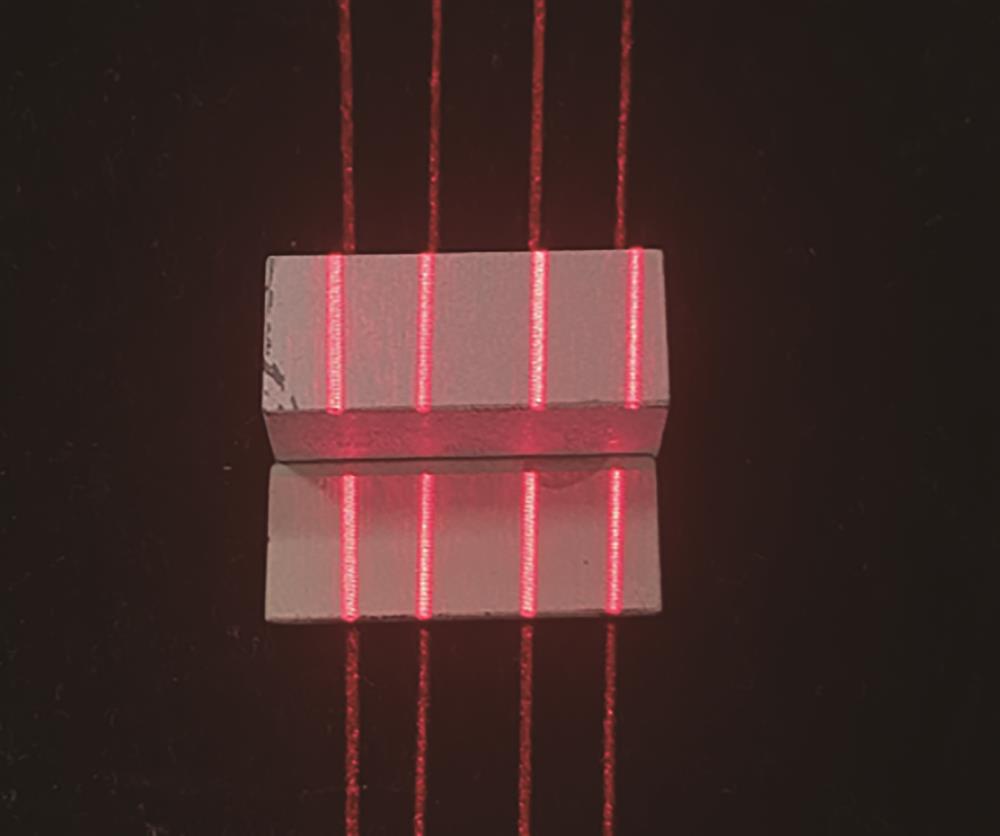

基于上述方法搭建双目视觉系统进行测量实验。实验设备:波长为650 nm的红色线激光器;分辨率为

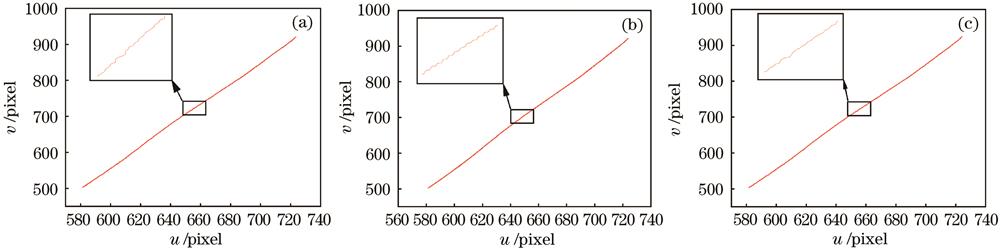

首先,对中心线提取精度进行测量分析。将激光投射到平面上,采用双目相机采集图像,分别利用传统灰度重心法、Steger法和本方法对中心线进行提取。实际测量中条纹宽度为15 pixel,因此选取尺寸为15 pixel×15 pixel的子区域,并将提升系数设置为11。传统灰度重心法、Steger法以及本方法提取的中心线如

图 4. 不同方法提取的条纹中心。(a)灰度重心法;(b)Steger法;(c)本方法

Fig. 4. Fringe centers extracted by different methods. (a) Gray centroid method; (b) Steger method; (c) our method

表 1. 不同方法的平均运行时间

Table 1. Average running time of different methods

|

表 2. 不同方法的RMSE

Table 2. RMSE of different methods

| |||||||||||||||||||||||||||||

表 3. 不同方案的RMSE

Table 3. RMSE of different schemes

|

为验证本方法的快速性,分多次对平面进行测量实验,并记录3种方法提取右图像中心线的时间各10次后取平均值,结果如

由于无法测量条纹的真正中心线,以Steger法提取的中心线为标准进行精度分析,计算传统灰度重心法与本方法提取的中心线均方根误差(RMSE),结果如

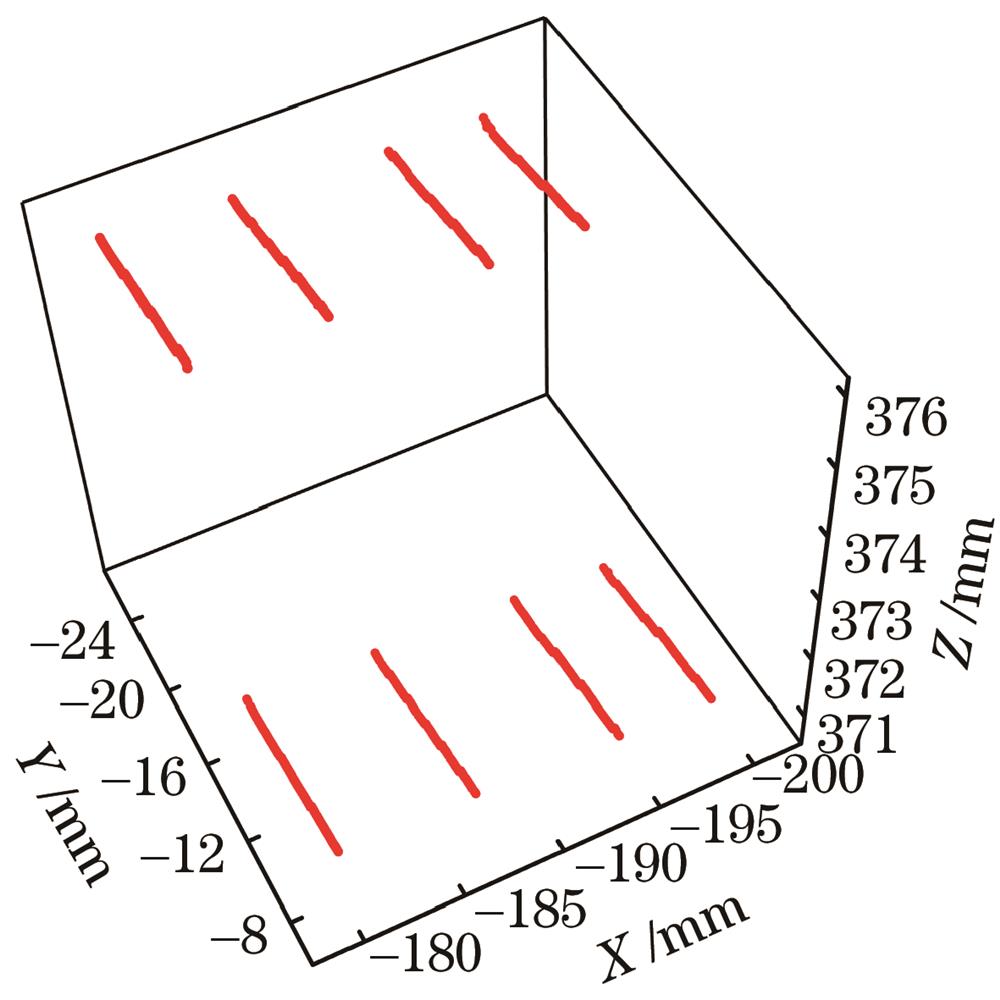

对高度为1 mm和6 mm的标准块规进行测量,以分析不同方法的三维测量精度,标准块规如

根据点云数据拟合出两个块规平面,以1 mm块规点云数据拟合的平面为基准,计算高度为6 mm块规点云数据点到该平面的距离,并用该距离减去标准高度差得到误差值。

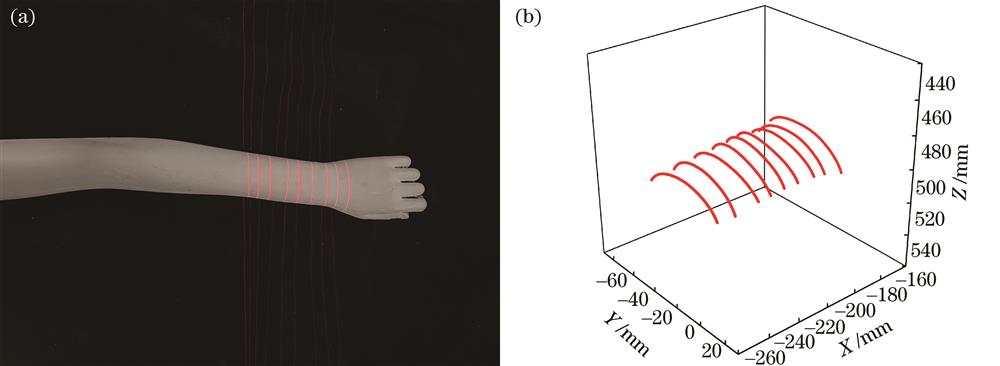

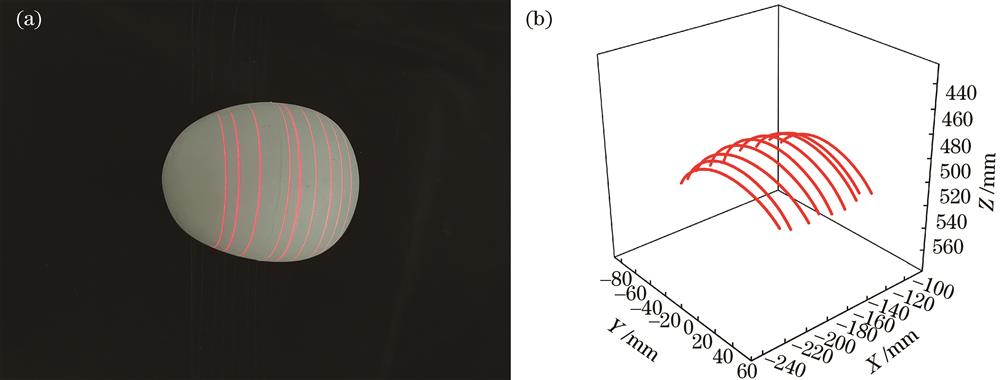

将本方法运用到机器人引导加工中,利用搭建的视觉系统对手臂模型和头部模型进行了局部三维测量。

图 7. 手臂模型的测量结果。(a)测量模型;(b)三维点云数据

Fig. 7. Measurement results of the arm model. (a) Measurement model; (b) three-dimensional point cloud data

图 8. 头部模型的测量结果。(a)测量模型;(b)三维点云数据

Fig. 8. Measurement results of the head model. (a) Measurement model; (b) three-dimensional point cloud data

4 结论

提出了一种融合区域匹配的快速多线结构光测量方法,以传统的重心法为基础,通过提升局部区域分辨率获得更高的中心线初始点,利用立体校正获得左右相机的初始匹配点,进而基于灰度梯度的DIC法进行亚像素精确匹配。将DIC法引入线结构光立体匹配中,利用线结构光的匹配关系,缩小了传统DIC法的匹配搜索范围,提高了立体匹配的效率。同时解决了立体校正误差引起的匹配精度下降问题,进一步提高了线结构光的测量精度。通过块规测量实验验证本方法的有效性,结果表明,本方法能实现快速、高精度的线结构光三维重建,测量误差小于0.05 mm,可应用于机器人引导加工、在线实时检测等工业自动化领域中。

[1] 庞兆智, 韩雷, 邵华, 等. 基于线结构光的大型螺纹在线测量与重构方法研究[J]. 工具技术, 2021, 55(3): 81-85.

Pang Z Z, Han L, Shao H, et al. On-line measurement and reconstruction of large screw thread based on line structured light[J]. Tool Engineering, 2021, 55(3): 81-85.

[2] 王雪嵩, 邵双运, 苏晓东, 等. 基于双目线结构光的承轨台测量[J]. 激光与光电子学进展, 2020, 57(21): 211202.

[3] 李东洁, 宋贺, 徐立航. 一种基于激光视觉的焊缝实时检测技术研究[J]. 激光与红外, 2019, 49(7): 818-823.

Li D J, Song H, Xu L H. A real-time welding seam detection technology based on laser vision[J]. Laser & Infrared, 2019, 49(7): 818-823.

[4] 俞隽, 李泷杲, 李根, 等. 一种基于多线结构光视觉引导的工业机器人定位方法[J]. 航空制造技术, 2020, 63(22): 84-91.

Yu J, Li S G, Li G, et al. An industrial robot positioning method based on guidance of multi-line structured light vision[J]. Aeronautical Manufacturing Technology, 2020, 63(22): 84-91.

[5] 张瑞峰, 刘畅. 分区间曲线拟合的干涉条纹中心点提取方法[J]. 激光与光电子学进展, 2021, 58(8): 0812002.

[6] He L Y, Wu S S, Wu C Y. Robust laser stripe extraction for three-dimensional reconstruction based on a cross-structured light sensor[J]. Applied Optics, 2017, 56(4): 823-832.

[7] 吴庆华, 周阳, 李子奇, 等. 双频曲线拟合线结构光条纹中心提取方法[J]. 激光与光电子学进展, 2020, 57(14): 141502.

[8] 杨毅, 闫兵, 董大伟, 等. 基于二次平滑算法的线结构光中心线提取方法[J]. 激光与光电子学进展, 2020, 57(10): 101504.

[9] 曾超, 王少军, 卢红, 等. 线结构光光条中心提取算法[J]. 中国图象图形学报, 2019, 24(10): 1772-1780.

Zeng C, Wang S J, Lu H, et al. Center extraction algorithm of line structured light stripe[J]. Journal of Image and Graphics, 2019, 24(10): 1772-1780.

[10] Li Y H, Zhou J B, Huang F S, et al. Sub-pixel extraction of laser stripe center using an improved gray-gravity method[J]. Sensors, 2017, 17(4): 814.

[11] Steger C. An unbiased detector of curvilinear structures[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1998, 20(2): 113-125.

[12] Xu G, Yuan J, Li X T, et al. Reconstruction method adopting laser plane generated from RANSAC and three dimensional reference[J]. MAPAN, 2018, 33(3): 307-319.

[13] 王福斌, 刘贺飞, 王蕊, 等. 线结构光条纹中心亚像素自适应提取算法[J]. 激光技术, 2021, 45(3): 350-356.

[14] 程鑫, 凌鹤, 李硕. 汽车焊缝密封胶条的光条中心提取算法研究[J]. 应用光学, 2019, 40(5): 823-828.

[15] 贾振元, 樊超楠, 刘巍, 等. 双目视觉测量中等匹配点的光条中心提取[J]. 光学 精密工程, 2016, 24(7): 1582-1591.

[16] 孙海卫, 毕远伟, 徐仕东. 反向重投影多线结构光立体视觉测量方法[J]. 激光杂志, 2021, 42(2): 47-51.

Sun H W, Bi Y W, Xu S D. A measurement method of multi-line structured light stereo vision based on reverse reprojection[J]. Laser Journal, 2021, 42(2): 47-51.

[17] 肖华军, 侯力, 游云霞. 一种基于图像融合的多线结构光立体视觉测量方法[J]. 四川大学学报(工程科学版), 2015, 47(3): 154-159.

Xiao H J, Hou L, You Y X. A measurement method of multi-line structured light stereo vision based on image fusion[J]. Journal of Sichuan University (Engineering Science Edition), 2015, 47(3): 154-159.

[18] 赵健. 数字散斑相关方法及其在工程测试中的应用研究[D]. 北京: 北京林业大学, 2014.

ZhaoJ. Research on digital speckle correlation method and its applications in mechanical engineering measurement[D]. Beijing: Beijing Forestry University, 2014.

[19] Zhou P, Goodson K E. Subpixel displacement and deformation gradient measurement using digital image/speckle correlation[J]. Optical Engineering, 2001, 40(8): 1613-1620.

[20] Bing P, Wu D F, Xia Y. Incremental calculation for large deformation measurement using reliability-guided digital image correlation[J]. Optics and Lasers in Engineering, 2012, 50(4): 586-592.

Article Outline

林群鸿, 张举, 江开勇, 林俊义. 融合区域匹配的快速多线结构光测量方法[J]. 激光与光电子学进展, 2023, 60(1): 0112003. Qunhong Lin, Ju Zhang, Kaiyong Jiang, Junyi Lin. Fast Multi-Line Structured Light Measurement Method Integrated with Region Matching[J]. Laser & Optoelectronics Progress, 2023, 60(1): 0112003.