面向遥感建筑物提取的轻型多尺度差异网络

1 引 言

高分辨率遥感影像是对地观测目标的重要信息载体,建筑物作为城市空间信息库的重要元素,从高分影像中精确提取的建筑物对土地覆盖分类、城市规划等领域有重要意义[1-2]。早期提取建筑物主要是人工利用目标建筑物的基础光谱、纹理等特征[3],然而不同种类的建筑物的几何与纹理信息差异很大,很难获取高精度的建筑物信息。

近年来,基于深度神经网络方法[4]凭借其强大的特征学习能力在解决各类分割任务中脱颖而出。Long等[5]提出的FCN网络,该网络通过将引入卷积层从而实现像素级的预测,但其缺乏考虑像素之间的空间关系。Badrinarayanan[6]提出编解码结构的SegNet网络,通过引入池化索引降低内存消耗。Ronnerberger[7]提出了U-Net网络,其主要通过跨层重建的思想将编码器的高级语义信息融入到解码器中,从而提升分割精度。此后,基于编解码的体系结构被逐渐应用于复杂的遥感影像分割任务[8-9]中。Ma[10]通过挖掘多尺度信息及学习全局局部特征实现充分提取不同分辨率的建筑物。Shi[11]提出在U-Net中嵌入FPN结构提高模型聚合多尺度特征信息的能力。Xu[12]通过融入胶囊卷积和空间-通道双注意力模块实现增强建筑物高阶特征的表达能力。Zhang[13]提出一种语义分割模型ResUNet,通过在U-Net模型中引入高效的残差块结构,有效解决特征信息随网络深度加深而减弱的问题,同时能简化网络的训练,促进信息的传播。Xu[14]提出一种融合分形几何特征的Resnet网络,通过引入融合分形先验的空洞空间金字塔池化模块和深度可分离卷积注意力融合机制提高分割模型的判别能力。Luo[15]提出一种ResUNet+网络,通过增强多尺度特征能力提升分割精度。Xu[16]提出一种改进ResNet的模型,通过融合多尺度的遥感建筑物特征从而提升分割精度。Lin[17]提出一种新型高效网络ESFNet,旨在以低计算成本和低内存消耗来保持轻微的精度损失。Paszke[18]提出一种高效神经网络ENet,其具有高速度低参数的特点,专门为需要低延迟操作的任务所创建。

鉴于此,尝试以ResUNet模型为基础,考虑到模型只有学习到充足的全局和局部特征信息及挖掘更多多尺度特征信息,才能充分应对形状各异的建筑物,提升分割精度。本文基于ResUNet模型,融入编解码功能差异性、多尺度膨胀感知模块及双融合机制思想设计出一种轻型多尺度差异网络LMD-Net。从而有效地解决基础模型缺乏考虑局部与全局信息的丰富关联导致建筑物提取精度不高及模型参数量大、不够轻量化等问题,实现优化基础模型的结果。

2 网络及算法

2.1 ResUNet网络模型

ResUNet[13] (Deep Residual U-Net)主要由编-解码网络和跳跃连接结构组成,该网络主要通过应用经典ResNet[19]模型中浅残差单元块搭建模型架构。该模型相比U-Net模型有以下几点不同:第一,ResUNet通过将U-Net原有的裁剪操作去除从而获得更优雅的架构;第二,ResUNet通过将特征处理单元由普通卷积单元替换成浅残差单元使得网络更能保留目标的精细信息。这种特性的网络不仅能避免普通卷积堆叠导致的信息丢失,更能促进前后向信息的传播,避免退化现象。因此其适用于基于遥感影像的目标提取任务。

2.2 轻型多尺度差异网络(LMD-Net)

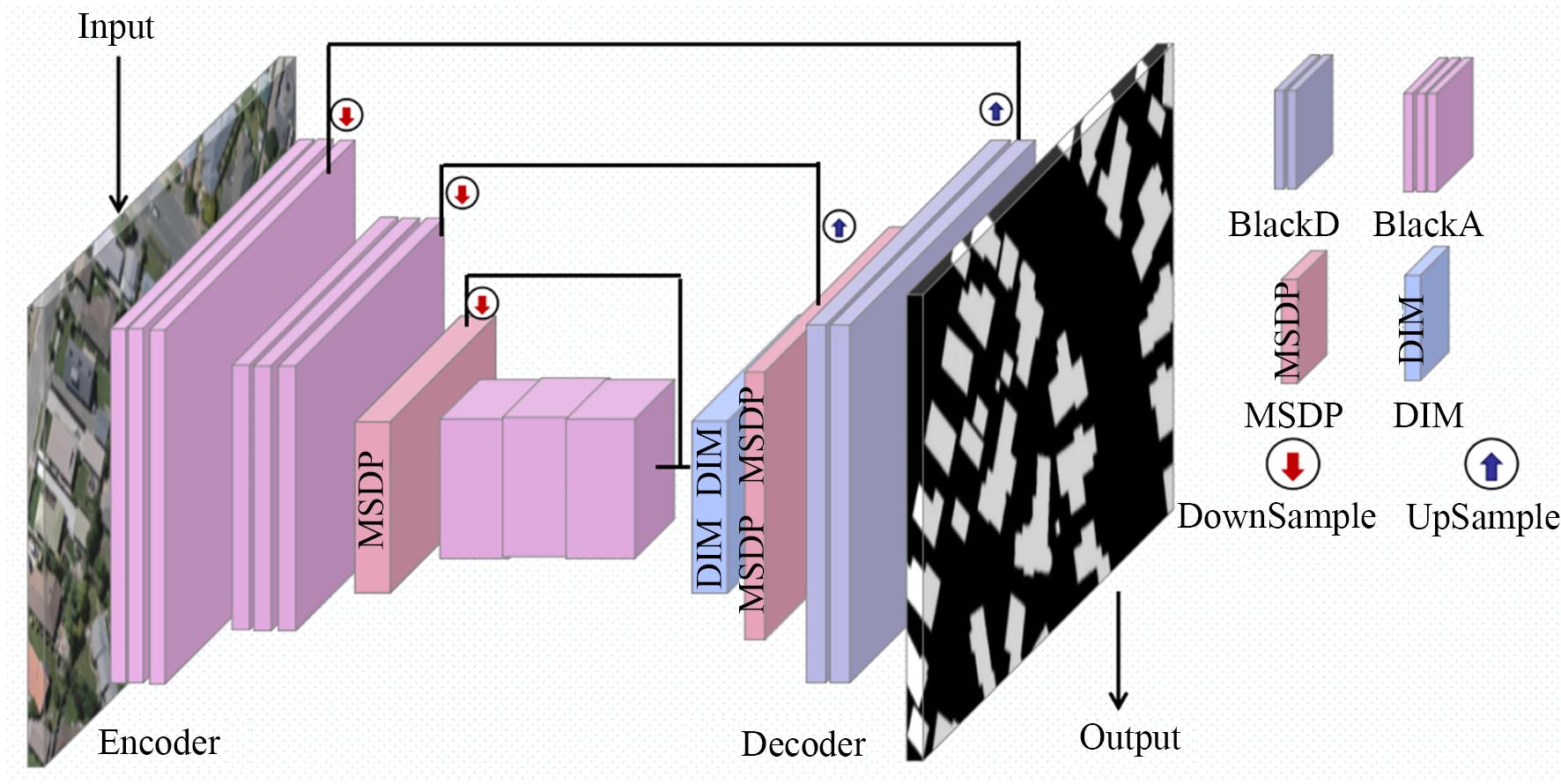

为了充分利用残差结构拟合性强的特点和多尺度融合结构增强特征表示的优越性,本文依据编解码结构的功能差异将二者结合提出轻型多尺度差异网络LMD-Net。该网络是基于编码-解码器结构的端到端建筑物提取网络模型。如图1所示,LMD-Net主要包括编码器、解码器以及跳跃连接部分。首先,依据编解码器结构的功能差异设计出一种轻型差异模型,即编码器使用BlockA,解码器使用BlockD;其次,为了使浅层表征图对位置及空间信息更敏感,深层恢复高空间高分辨率表征图的能力提升,提出在编码器第三层和解码器第二层使用多尺度膨胀感知模块,从而加剧网络对不同尺寸建筑物目标的提取能力;最后,为了进一步加深解码结构的特征通道的信息恢复能力,在模型的深跳跃连接后嵌入双融合机制,实现充分融合各尺度信息。

LMD-Net网络由四层编码器及三层解码器组成。224尺寸的输入影像经过编码器处理后得到仅有28尺寸的高级特征图,最后由三层解码器解析恢复影像空间信息。LMD-Net网络组件见表1。其展示各个组件的详细信息。

表 1. LMD-Net网络组件

Table 1. LMD-Net Network Components

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

2.3 轻型差异模型

ResUNet模型主要是通过单一的浅残差单元堆叠而成,这种方式并未考虑编码器解码器的功能差异,导致编码器不能充分发挥其特征提取的能力和解码器分类效果不佳,其次单一的堆叠网络也使得网络产生很多无用的参数。受目前轻量化系列结构[20-21]中的影响,本文引入深度可分离卷积和卷积构建一种轻型差异模型,其不仅按编解码结构的功能差异进行设计,而且缩减了很多无效参数,是最终模型轻量化的关键因素。

深度可分离卷积[22]最大的优势是可大幅度降低卷积参数。如图2所示。可将其分解为深度卷积和逐点卷积两个过程。

假设尺寸的特征图,经过个卷积操作后,得到的输出特征图。那么对于标准卷积而言,输出特征图单个像素点需个卷积核进行点乘操作,而得到大小的输出特征图所需要的计算量为:

所需的参数量为:

而对于深度可分离卷积,首先第一个过程得到输出大小为的特征图。其次第二个过程中,通过个卷积核对第一过程特征图加权组合得到输出特征图大小为。即深度可分离卷积所消耗的参数量为:

所需的计算量为:

相比普通卷积,如式(5)~式(6)所示,深度可分离卷积不仅缩减网络的参数量效果好,而且显著提升模型的训练速度,使网络更趋向于轻量化。

由上述分析知,相比普通卷积,深度可分离卷积在压缩模型参数量和计算量方面有明显的优势,而卷积所具有的调节通道维度的能力也能进一步缩减模型参数量。基于此理论,本文对比了四种特征处理单元,如图3所示,其中BlockB和BlockD是在BlockA和BlockC的基础上加入深度可分离卷积。ResUNet网络由BlockC单一堆叠而成,本文轻型差异模型的编码部分由BlockA构建,解码部分由BlockD搭建。在实验部分将详细说明四种特征处理单元的性能及轻型差异模型的形成过程。

2.4 多尺度膨胀感知模块(MSDP)

在遥感影像分割中,增强特征的表示能力是举足轻重的。伴随网络层数的不断加深,深卷积对特征的敏感程度逐渐从局部特征向全局特征的趋势发展。为了能够增强浅卷积层对定位及空间信息的敏感度及深卷积恢复空间信息的表征能力,本文基于膨胀卷积[23]的思想,提出多尺度膨胀感知模块(Multi-Scale Dilation Perception,MSDP)。

由于网络最浅层涵盖较多粗糙特征,最浅层的并行多尺度策略会加快粗糙信息的传递而减弱网络的性能,因此本文在编码器特征信息较丰富的第三层引入MSDP模块,增强编码器对定位及空间信息的提取。此外,MSDP模块虽能加剧网络融合多尺度特征信息,但沿用连续的特征恢复层更能促进网络恢复空间信息。因此本文在解码器第二层融入MSDP模块,经实验验证连续性有效。

MSDP模块的结构图如图4所示。该模块采用级联采样法,并行三级不同的空洞卷积对特征图采样,使MSDP模块能学习到来自不同感受野的图像特征,所聚合的多个尺度的语义信息能有效地增强深浅卷积的表征能力。其中,三个分支所设置的膨胀系数分别为(1,3,5),所能获得的感受野大小为(3,7,11)。并行多个大感受野分支使模型能有效捕获多尺度的上下文信息,提升对不同尺度的建筑物目标的识别能力。

膨胀卷积的主要优势是扩大感受野不消耗额外的参数量,其可视化效果如图5所示,相比标准卷积,膨胀率为2的卷积核的感知范围明显比标准卷积的更大,能表达的语义信息也越多。

实际上,采用膨胀率的卷积核大小会发生改变,其扩张后的卷积核的尺寸计算公式为:

式中,第层的卷积核大小,为膨胀率。由公式(7)进而可得第层特征图的感受野。原始影像的感受野记为1,那么第层输出特征图的感受野大小的递推公式为:

其中:为第层的步长,为层的感受野。

2.5 双融合机制

原模型的解码器仅通过密集连接融合同层编码器的特征图实现语义信息的融合,融合后的特征图仅通过单一路径提取语义特征,未能充分接收强大的特征提取编码器网络的所有有效信息。因此,本文将在解码器第一深层引入双融合机制(Dual Integration Mechanism,DIM),增强解码器的特征恢复能力。

受2.3小节中四种特征处理单元的对比实验启发,BlockA的提取能力相当高,因此将原仅通过BlockD单一路径恢复特征信息变成融合BlockA与BlockD双路径提取丰富特征信息,如图6所示,X1为同层编码器同尺寸的特征图,X2为解码器上一层特征图,首先通过跳跃连接实现第一次融合,得到56×56×512大小的特征图,其次转入双路径的特征提取路径中,得到蕴含丰富信息的两个56×56×256大小的特征图,最后通过第二次融合操作,实现增强特征恢复网络的效果,随后,上采样操作将通道数恢复到下一次所需的数值。

3 实验与分析

3.1 实验数据及实验平台

本实验采用WHU building dataset[24]开源高分遥感影像建筑物数据集,其包含8 189幅RGB遥感影像,地面空间分辨率为0.3 m,图片大小为512×512。该数据集由4 736幅训练集、2 416幅测试集和1 036幅验证集组成。本实验将数据集按照8∶1∶1比例划分,并将其裁剪为224×224。考虑到训练数据样本比较少,对训练集进行随机旋转、随机翻转、按照归一化概率选择执行色调或亮度操作扩充数据样本集。

本实验基于Pytorch框架,硬件环境为Intel(R) Core(TM) i7-7700 CPU @3.60 GHZ,内存16G, NVIDIA GeForce GTX1080(8 G显存),操作系统为Windows10。优化器Adam代替SGD训练网络,初始学习率为0.001、批次设为8、迭代次数为100。如图7所示,在训练及验证LMD-Net模型中,随着迭代次数增加,损失值逐渐降低。准确率和交并比呈平稳上升趋势。

图 7. 模型训练、验证阶段指标变化趋势图

Fig. 7. Model training and validation phase metrics change trend graph

3.2 分割性能评价指标

为了对模型的性能做定量评价,本文选用交并比(Intersection over Union, IoU)、Dice系数、准确率(Precision, Pre)和召回率(Recall, R)作为建筑物像素级语义分割的评价指标。具体计算公式如式(9)~式(12):

其中:为建筑物像素数被正确预测的数量,为将非建筑物像素被错误预测为建筑物像素数量,为非建筑物素数被正确识别的数量,为将建筑物像素预测为建筑物像素数量。

3.3 消融实验结果和分析

3.3.1 验证轻型差异模型的有效性

为了验证轻型差异模型的设计对网络整体性能及效率的影响,本文设计了四组对比实验,该实验是将编码器解码器的特征处理单元依次更换为BlockA,BlockB,BlockC和BlockD块,通过分析各项指标的数据及结合编码器和解码器的特性进而设计出本文的基础轻型差异模型。实验中使用效率评价指标Params,Flops衡量模型的时间复杂度,使用IoU衡量模型的性能。

如图8展示了在WHU数据集上六种特征处理单元的分割效率及性能。对比BlockA与BlockC,BlockA与BlockB和BlockC与BlockD可知,深度可分离卷积及1×1卷积在降低模型的参数量及计算量方面表现突出;由于编码器特征提取的质量对建筑物分类结果十分关键,而分类解码网络需要轻便快捷。分析图知,BlockA的交并比Iou最高,BlockD具有最低的参数量和计算量,因此所设计的基础轻型差异模型的编码器特征提取单元选为BlockA,解码器的特征恢复单元选用BlockD。对比BlockA+BlockD与ResUnet模型可得,轻型差异模型交并比提升了2.35%,降低约1/2的参数量,提升大约一半的速率。实现初步优化性能及效率。

图 8. 在WHU数据集上六种特征处理单元的分割效率及性能

Fig. 8. Segmentation efficiency and performance of six feature processing units on the WHU dataset

3.3.2 验证MSDP模块的有效性

为了验证在3.3.1小节中所设计的轻型差异模型中添加多尺度膨胀感知MSDP模块的有效性,如表2详细列出在WHU数据集上MSDP模块的分割精度。其中,Model表示不同模块所组合的模型,Position体现MSDP模块的放置位置,即值为0,1,2分别表示在轻型差异模型的第三层、第六层和第七层融入MSDP模块。

表 2. 在WHU数据集上MSDP的分割精度

Table 2. Segmentation accuracy of MSDP on WHU dataset

|

通过表2可以发现,在轻型差异模型中加入MSDP组合后精度得到明显提升,观察组1,2和组1,3,单向使用MSDP时,两组的Iou和Dice分别提高了0.19%,1.23%和0.35%,0.40%。对比组1,4可知,双向融入MSDP效果提升更明显,其IoU,Recall和Dice提高了0.42%,0.77%和0.3%。这说明组合MSDP模块在LMD-Net中发挥了积极作用,

能增强模型提取多尺度建筑物的能力。对比组4,5可知,沿用连续的特征恢复层能促进MSDP模块发挥作用,解码器仅第三层使用MSDP模块比解码器第二层使用MSDP模块和解码器第三层使用BlockD性能下降明显,IoU降低0.37%,Recall下降0.76%。

图9显示了在轻型差异模型中添加MSDP模块的可视化效果,G1-G4分别对应表2的四组模型,第一列为中型建筑物预测图。第二至五列为小型建筑物预测图,第五列为大型建筑物预测图。观察可知,针对不同尺度的建筑物数据集,在不同位置中所添加的MSDP模块,能不同程度地增强模型的提取性能。对比G1-G3和G4,G4能有效地改善各形状大小的建筑物出现的错检现象,但针对一些极小建筑物提取效果还是有待提升。

3.3.3 验证双融合机制的有效性

为了验证在3.3.2小节所改进的模型中添加双融合机制DIM的有效性,在WHU数据集上对该机制进行实验。如图10对比可得,添加DIM机制后,网络的性能得到进一步的提升,其中IoU及Pre提升了0.46%,0.65%。表明BIM能有效增强解码器的像素恢复能力。

3.4 模型实验结果和分析

通过对三组消融实验的分析可知,所构建的轻型差异模型、MSDP模块以及DIM机制对模型整体的性能及效率均有促进作用。本实验主要针对三种典型的语义分割网络SegNet[6],U-Net[7],ResUNet[13]和最近几年的两篇参考文献Enet[18],ESFNet[17]进行效率及性能两个方面的对比实验。

3.4.1 各模型复杂度对比实验

在效率对比实验中,主要使用的性能评估指标有Params参数量、MADDs乘法累加运算总量和Flops计算量来考核模型的时间及空间复杂度,所有对比实验的实验环境均一致。分析表3可知,U-Net网络的参数量最多,SegNet网格次之,而ResUNet因其引入残差结构等因素,虽参数量相比于U-Net网络减少一半多,但计算量却大大增加。而观察组3与组4的轻量化ESFNet及ENet网络,两组网络的参数量和计算量都极低,但依据后面实验的验证,两组轻量化网络的性能指标却损失严重,对比组5和6的LMD-Net模型与基础网络ResUNet可得,LMD-Net在各个效率指标中都优于ResUNet,不仅参数量降低2.62 M,计算量也降低12.89 G;表明LMD-Net网络实现在效率方面优化ResUNet网络。

表 3. 各模型的复杂度对比实验

Table 3. Experiments comparing complexity of each model

|

3.4.2 各模型性能评估实验

为了定量评估LMD-Net网络结构在建筑物目标提取时的有效性,实验中采用IoU,Precision,Recall和Dice指标对各模型进行精度评估。由表4可知,本文所提LMD-Net网络在基于遥感影像建筑物提取领域中表现更优,相较于对比网络ResUNet,LMD-Net网络在交并比、准确率、召回率、Dice系数上分别提高了3.23%,2.57%,1.56%,2.07%;而轻量化网络ESFnet和ENet的性能却很低,在Iou上,LMD-Net相比ESFnet模型提高了11.27%,因此并不是参数量越低性能就越好。综上表明,LMD-Net网络实现了在性能方面优化ResUNet网络,更适用于基于遥感影像的建筑物提取。

表 4. 不同网络的分割精度对比实验/%

Table 4. Comparison experiments of segmentation accuracy of different networks

|

为了能直观体现LMD-Net模型的优越性,如图11和图12所示,分别展示了六种模型在不同尺度建筑物上的可视化分割性能。

通过对比图11和图12的红框区域可知,LMD-Net网络能有效降低分割噪声,其误检率更低。由于SegNet网络结构简单,其分割预测图破碎最严重。U-Net与SegNet相比,整体效果有所提升,但对于小型建筑物仍存在背景误分。而针对轻型的ENet与ESFnet网络,ESFnet网络没有完整的建筑物边界,严重缺失边缘细节信息,ENet虽能保持良好边缘信息,但仍会将毗邻的建筑物粘连在一起。而基础模型ResUNet虽能有所提升分割性能,但小型建筑物的多检、错检及大型建筑物的漏检现象明显存在,而本文所提的LMD-Net网络,能进一步增强建筑物边缘检测能力和降低建筑物分割的错误率,但依然有提升的空间。

4 结 论

针对传统建筑物提取方法存在参数量大、计算量大以及遥感影像建筑物形状多样导致分割存在粘连现象,提出一种轻型多尺度差异网络LMD-Net网络模型,其通过编解码结构的功能差异性引入轻型差异网络,实现模型轻便化的同时增强模型语义表达能力。在此基础上,在编码器第三层和解码器第二层融入多尺度感知模块,增强模型聚合多尺度信息的能力,最后,引入双融合机制进一步增强特征恢复网络的性能。

通过在航空建筑物影像WHU数据集上实验验证,所提模型在精度指标交并比值达到87.26%,准确率达到91.76%,召回率为91.04%,Dice系数是91.38%,且参数量及计算量均大幅度得到提升,表明,LMD-Net模型相较其余模型在性能及效率两方面具有更高的可行性。

在后续研究中,在保证模型轻量化的前提下,进一步提升网络对前景像素的正确捕捉能力,从而能提取到更连续的建筑物区域和清晰的建筑物边缘部分。

[1] WANG Y, ZENG X Q, LIAO X H, et al. B-FGC-net: a building extraction network from high resolution remote sensing imagery[J]. Remote Sensing, 2022, 14(2): 269.

[2] HOSSEINPOUR H, SAMADZADEGAN F, JAVAN FD. CMGFNet: a deep cross-modal gated fusion network for building extraction from very high-resolution remote sensing images[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2022, 184: 96-115.

[3] JIN X Y, DAVIS C H. Automated building extraction from high-resolution satellite imagery in urban areas using structural, contextual, and spectral information[J]. EURASIP Journal on Advances in Signal Processing, 2005(14): 1-11.

[5] SHELHAMER E, LONG J, DARRELL T. Fully convolutional networks for semantic segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(4): 640-651.

[6] BADRINARAYANAN V, KENDALL A, CIPOLLA R. SegNet: a deep convolutional encoder-decoder architecture for image segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(12): 2481-2495.

[8]

[10] MA J J, WU L L, TANG X, et al. Building extraction of aerial images by a global and multi-scale encoder-decoder network[J]. Remote Sensing, 2020, 12(15): 2350.

[11] SHI M Y, GAO J. Research on high altitude remote sensing building segmentation based on improved u-net algorithm[J]. Instrumentation, 2021, 8(04): 47-54.

[13] ZHANG Z X, LIU Q J, WANG Y H. Road extraction by deep residual U-net[J]. IEEE Geoscience and Remote Sensing Letters, 2018, 15(5): 749-753.

[15]

[16]

[17] LIN J B, JING W P, SONG H B, et al. ESFNet: efficient network for building extraction from high-resolution aerial images[J]. IEEE Access, 2019, 7: 54285-54294.

[18]

[20]

[21] RAZA A, HUO H, FANG T. EUNet-CD: efficient UNet for change detection of very high-resolution remote sensing images[J]. IEEE Geoscience and Remote Sensing Letters, 2022, 19: 1-5.

[22] SHAHEED K, MAO A, QURESHI I, et al. Finger-vein presentation attack detection using depthwise separable convolution neural network[J]. Expert Systems with Applications, 2022, 198: 116786.

[23] WANG S H, WANG X Y, GUO X. Advanced face mask detection model using hybrid dilation convolution based method[J]. Journal of Software Engineering and Applications, 2023, 16(1): 1-19.

Article Outline

李国燕, 武海苗, 董春华, 刘毅. 面向遥感建筑物提取的轻型多尺度差异网络[J]. 光学 精密工程, 2023, 31(22): 3371. Guoyan LI, Haimiao WU, Chunhua DONG, Yi LIU. Lightweight multi-scale difference network for remote sensing building extraction[J]. Optics and Precision Engineering, 2023, 31(22): 3371.