基于双模态融合网络的目标检测算法

0 引言

目标检测是计算机视觉领域的基本任务之一,在安防监控、自动驾驶和**领域等都有重要的应用[1-2]。近年来,基于深度学习的目标检测已经成为主流,根据检测步骤的不同,算法可以分为两类:两阶段检测算法和单阶段检测算法。两阶段检测算法首先对图像提取候选框,然后基于候选区域进行修正得到检测结果,如区域卷积神经网络(Region-based Convolutional Neural Network,R-CNN)[3]、Fast-RCNN[4]和Faster-RCNN[5]等。单阶段检测算法直接对图像生成检测结果,如Single Shot Multibox Detector(SSD)[6]和You Only Look Once(YOLO)系列[7-10]等。其中,YOLOv5在检测精度和速度上具有明显的优势。此外,无锚框(Anchor-free)的检测算法近年来也逐渐兴起,如CornerNet[11]、CenterNet[12]和Fully Convolutional One-Stage(FCOS)[13]等,该类算法不用锚框,将目标检测转化为关键点的定位组合问题,摆脱了使用锚框而带来的计算量,提高检测实时性。

目前,目标检测算法主要用与检测任务相关的单模态图像作为训练数据[14-15],然而仅用单模态图像在实际的复杂场景中有时很难检测到目标。为了解决上述问题,许多研究者提出了用多模态图像作为训练数据的方法[16-17]。多模态图像,例如红外图像和可见光图像,具有互补优势。红外图像的优点是依赖目标物体产生的热源,不受照明条件的影响,但无法捕捉到目标的细节信息。可见光图像的优点是能清晰地捕捉目标的纹理特征和细节信息,但容易受到光照条件的影响。因此,基于多模态目标检测研究已成为当前的研究热点[18-23]。DEVAGUPTAPU C等[18]利用CycleGAN创建合成红外图像的策略,并利用照明感知融合框架融合可见光和红外图像,以提升红外图像中目标检测的性能;YANG L等[19]采用照明子网分配权重,联合可见光和红外图像检测行人;赵明等[20]提出了一种跨域融合网络结构,采用红外域和伪可见光域双通道的多尺度特征金字塔获取每个模态的特征图,对多尺度特征进行双模态特征融合;WANG Q等[21]设计了一种冗余信息抑制网络,能抑制跨模态冗余信息,有助于融合可见光和红外的互补信息;GENG X等[22]通过信道信息交换实现跨模态人员再识别和利用可见光红外双摄像头跟踪;周涛等[23]设计了三编码器提取多模态医学图像特征,解决单模态图像提取能力不足的问题。

对于流行的卷积神经网络,多模态图像特征融合通常有三种融合方式:早期融合、中期融合和后期融合。早期融合是指在第一个卷积层后,将多个分支特征映射融合,ZHANG Y等[24]提出一种基于注意力的多层融合网络用于多光谱行人检测;CAO Z等[25]利用多光谱通道特征融合模块,根据照明条件融合可见光和红外图像特征。中期融合是指在骨干网络提取特征后进行融合,KONIG D等[26]利用新的多光谱区域建议网络(Region Proposal Networks,RPN)来有效融合多光谱图像中的红外和可见光信息;FU L等[27]提出一种自适应空间像素级特征融合网络,可以自适应地从红外和可见光图像中提取特征进行融合。后期融合即决策级融合,执行结果的融合,WAGNER J等[28]提出两个融合架构并分析其在多光谱数据上的性能;白玉等[29]利用两种检测结果决策出最优结果,提出一种基于决策级融合的目标检测算法。但这些方法没有分别提取多模态图像的特征,且融合多模态特征时并不充分,还需要进一步提高多模态特征信息之间的互补优势。

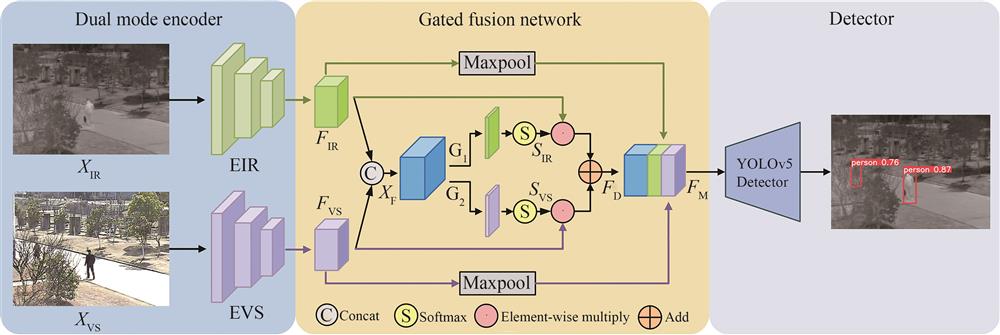

为此,本文提出一种基于双模态融合网络的目标检测算法,采用早期融合,并嵌入了一个门控融合网络,使模型能够确定两种模态图像在不同场景中对检测的贡献。首先,由于红外图像中的特征信息较少,采用设计的红外编码器中对空间信息进行编码;其次,设计了一个可见光编码器,从垂直和水平两个空间方向聚合特征,通过精确的位置信息对通道关系进行编码;最后,引入多任务学习的思想,提出门控融合网络,自适应调节权重分配,实现跨模态特征融合。并在公开数据集和自建数据集上进行验证。

1 本文算法

提出的基于双模态融合网络的目标检测算法框架如

1.1 双模态编码器

由于红外图像和可见光图像的成像差异及各自的特点,使用不同的网络来提取特征。设计的双模态编码器如

能量函数

式中,

每个神经元的权值通过

式中,将原始特征信息记为

本文算法在双模态编码器中将两个模态图像的特征信息进行融合,尽管可见光图像对比度高且能反映真实目标环境,具有丰富的图像空间及细节特征信息,但是当有遮挡或者光照不足时,就无法观察到目标。而红外图像虽然不能清晰地观察目标,但能够显示目标的位置信息及粗略的轮廓信息。最后,将EIR和EVS提取的特征

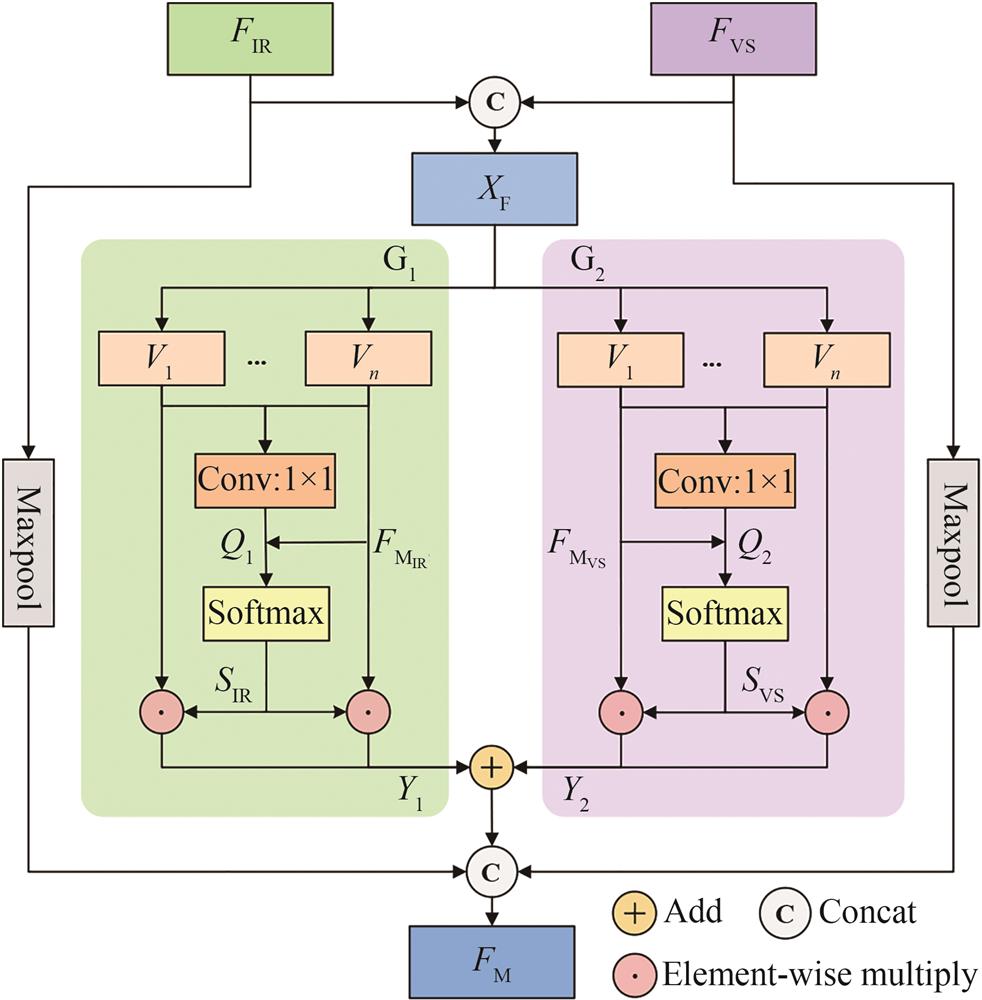

1.2 门控融合网络

借助多任务学习中的多门混合专家思想[32](Multi-gate Mixture of Experts,MMoE),提出门控融合网络,结构如

为了充分利用红外和可见光图像特征的互补性,考虑计算两种模态特征对检测的贡献,为红外特征

式中,

归一化后的权值

对红外图像和可见光图像的特征重新加权,逐像素相加得到合并的特征

2 实验结果及分析

2.1 实验条件

实验的操作系统为Ubuntu 16.04,CPU为i5-8400,GPU为NVIDIA GeForce GTX 1080Ti(显存11 GB),CUDA以及CUDNN的版本为10.0和CUDNN7.4.2。实验采用Python和PyTorch平台。训练过程中使用SGD优化器对网络参数进行迭代更新,动量参数设为0.937,BatchSize设为8,共训练150个Epoch,在加载数据时将所有图像的分辨率统一调整到640×640,再对整体网络进行端到端训练。

2.2 数据集与评价指标

用公开的KAIST行人数据集[33]和自建的GIR数据集对算法进行评估。

KAIST行人数据集共有95 328张图片,每张图片都包含红外和可见光图像两个版本,图像尺寸为640×512,包括校园、街道以及乡下等常规交通场景。由于原数据集标注较差且数据集是取自视频连续帧图片,相邻图片相差不大,故进行一定程度的数据集清洗。清洗规则为:训练集每隔2张图片取一张,并去掉所有不包含任何行人的图片,可得到7 601张训练集[34]图片,4 755张白天图片,2 846张夜晚图片。测试集每隔19张取一张,保留负样本,可得到2 252张测试集[35]图片,1 455张白天图片,797张夜晚图片。原数据集的标签中包含person、people和cyclist三个类别,当照明条件差或分辨率低时,很难区分这三类,故将标签类别仅标注为person一类。

GIR数据集是自行创建的通用目标数据集。图像来源于李成龙团队建立的RGBT210数据集[36],每张图片包含红外和可见光彩色图像两个版本,图像尺寸为630×460。从该数据集中选取5 105张图片,划分为训练图像4 084张,测试图像1 021张。对图片进行标注,确定10类目标为person、dog、car、bicycle、plant、motorcycle、umbrella、kite、toy和ball。

两种数据集每张图片均包含红外和可见光两个版本。通过对成像硬件设备捕捉的图片进行高度对齐裁剪,每个图像对是已经配准好的两张图像。对红外图像、可见光图像和两者组成的图像对分别进行训练和测试,所有类型图像共享一套标签。

实验使用的算法评价指标是平均检测精度(Average Precision,AP)、每秒帧数(Frames Per Second,FPS)、精确度(Precision,P)和召回率(Recall,R)。其中AP0.50:0.95指IoU从0.50到0.95每隔0.05计算的所有类别的AP平均值。

2.3 消融实验与定性分析

本文算法在KAIST数据集和GIR数据集上分别进行消融实验,并与基准算法的n和s两个模型进行对比,评估提出模块对检测器的贡献,以验证所提出方法的有效性。

2.3.1 KAIST数据集

在训练之前,使用k-means++聚类标签框,得到合适的预设框尺寸。常见的输入图像尺寸有416×416、512×512、608×608、640×640,考虑到输入不同尺寸的图像对可能会影响检测器性能,使用本文算法的n和s两个模型在KAIST数据集上进行实验,结果见

表 1. n模型上不同输入图像对尺寸的检测器性能

Table 1. Detector performance for different input image pairs sizes on n-model

|

表 2. s模型上不同输入图像对尺寸的检测器性能

Table 2. Detector performance for different input image pairs sizes on s-model

|

为了更好地分析编码器和门控融合网络对检测器性能的贡献,在KAIST数据集上进行消融实验,结果见

表 3. 不同模型在KAIST数据集上的消融实验结果

Table 3. Ablation experimental results of different models on the KAIST dataset

|

为更直观地比较与基准算法的检测结果,部分可视化结果如

第一行是白天场景,可见光图像光照充足,目标明显,相反,红外图像目标不明显,本文算法将可见光特征补充后能准确检测到目标且置信度分数较高。第二行在可见光图像上错检,通过与红外特征互补后,本文算法能够改善错检问题。第三行基准算法YOLOV5-s在两种图像上均未检测到小目标,而本文算法的s模型能准确地检测。第四行可见光图像光照不足,很难检测到目标,但红外图像可以解决此类场景的漏检问题,本文算法将红外特征补充后,能够准确地检测到目标。第五行是夜晚场景,此类场景下可见光图像处于劣势,相反,红外图像很有优势,因此,结合双模态图像的特征后,能够检测到目标且置信度分数比单模态图像高。

2.3.2 GIR数据集

同理使用k-means++聚类标签框设置预设框尺寸。在GIR数据集上进行消融实验,结果见

表 4. 不同模型在GIR数据集上的消融实验结果

Table 4. Ablation experimental results of different models on the GIR dataset

|

表 5. 所提算法和基准算法各类的检测精度(AP0.5%)

Table 5. The detection accuracy of the proposed algorithm and the baseline algorithm(AP0.5%)

|

为更直观地比较与基准算法的检测结果,部分可视化结果如

2.4 对比实验与定量分析

将本文算法运用于KAIST数据集和GIR数据集,并利用目标检测常用指标,如AP0.5:0.95、AP0.5等,评估所提网络。最后与近几年具有代表性的目标检测算法比较,验证本文方法的有效性。

2.4.1 KAIST数据集

表 6. 在KSIAT数据集上的对比实验结果

Table 6. Comparative experimental results on the KSIAT dataset

|

2.4.2 GIR数据集

表 7. 在GIR数据集上的对比实验结果

Table 7. Comparative experimental results on the GIR dataset

|

3 结论

本文提出了一种基于双模态融合网络的目标检测算法,有效结合了红外和可见光图像特征互补的优势,在白天或夜间条件下都能较准确地检测到目标。

算法能对同时输入的红外和可见光图像对进行目标检测,其中,由于红外图像中的特征信息较少,对红外图像采用红外编码器中的迷你残差块对空间信息进行编码,增强了目标在复杂背景中的空间信息;对可见光图像采用设计的可见光编码器从垂直和水平两个空间方向聚合特征,通过精确的位置信息对通道关系进行建模。引入多任务学习的思想,提出门控融合网络,计算不同模态的特征对检测的贡献概率,自适应调节两路特征的权重分配,实现跨模态特征融合。

该算法在KAIST和GIR数据集上的检测效果显著。在KAIST行人数据集上,与基准算法YOLOv5-n单独检测可见光图像和红外图像的结果相比,所提算法检测精度分别提升15.1%和2.8%;与基准算法YOLOv5-s相比,检测精度分别提升14.7%和3%;同时,检测速度在两个不同基准算法模型上分别达到117.6 FPS和102 FPS。在自建的GIR数据集上,所提算法的检测精度和速度也同样具有明显优势。与多个经典的双模态目标检测算法实验对比结果验证了本文的方法具有较好的检测性能,同时具有良好的实时性和鲁棒性。此外,所提算法还能对单独输入的可见光或红外图像进行目标检测,且检测性能与基准算法相比有明显提升。

[1] ZHOUY, TUZELO. Voxelnet: End-to-end learning for point cloud based 3d object detection[C]. 2018 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2018: 4490-4499.

[2] KIMS, SONGW J, KIMS H. Infrared variation optimized deep convolutional neural network for robust automatic ground target recognition[C]. 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2017: 1-8.

[3] GIRSHICKR, DONAHUEJ, DARRELLT. Rich feature hierarchies for accurate object detection and semantic segmentation[C]. 2014 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2014: 580-587.

[4] GIRSHICKR. Fast R-CNN[C]. 2015 IEEE International Conference on Computer Vision (ICCV), 2015: 1440-1448.

[5] REN S, HE K, GIRSHICK R. Faster R-CNN: towards real-time object detection with region proposal networks[J]. Advances in Neural Information Processing Systems, 2015, 28: 91-99.

[6] LIUW, ANGUELOVD, ERHAND. Ssd: single shot multibox detector[C]. 2016 European Conference on Computer Vision (ECCV), 2016: 21-37.

[7] REDMONJ, DIVVALAS, GIRSHICKR. You only look once: unified, real-time object detection[C]. 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2016: 779-788.

[8] REDMONJ, FARHADIA. YOLO9000: better, faster, stronger[C]. 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2017: 7263-7271.

[9] REDMON J, FARHADI A. Yolov3: an incremental improvement[J]. arXiv preprint, 2018.

[10] BOCHKOVSKIY A, WANG C Y, LIAO H Y M. Yolov4: optimal speed and accuracy of object detection[J]. arXiv preprint, 2020.

[11] LAWH, DENGJ. Cornernet: detecting objects as paired keypoints[C]. 2018 European Conference on Computer Vision (ECCV), 2018: 734-750.

[12] ZHOU X, WANG D, KRÄHENBÜHL P. Objects as points[J]. arXiv preprint, 2019.

[13] TIANZ, SHENC, CHENH. Fcos: fully convolutional one-stage object detection[C]. 2019 IEEE/CVF International Conference on Computer Vision (ICCV), 2019: 9627-9636.

[14] ZHAO F, WEI R, CHAO Y, et al. Infrared bird target detection based on temporal variation filtering and a gaussian heat-map perception network[J]. Applied Sciences, 2022, 12(11): 5679-5694.

[15] ZHU K, XU C, WEI Y, et al. Fast-PLDN: fast power line detection network[J]. Journal of Real-Time Image Processing, 2022, 19(1): 3-13.

[16] XU H, WANG X, MA J. DRF: Disentangled representation for visible and infrared image fusion[J]. IEEE Transactions on Instrumentation and Measurement, 2021, 70: 1-13.

[17] YAOX, ZHAOS, XUP, et al. Multi-source domain adaptation for object detection[C]. 2021 IEEE/CVF International Conference on Computer Vision (ICCV), 2021: 3273-3282.

[18] DEVAGUPTAPUC, AKOLEKARN, SHARMAMM, et al. Borrow from anywhere: pseudo multi-modal object detection in thermal imagery[C]. 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops, 2019: 1029-1038.

[19] YANG L, MA R, ZAKHOR A. Drone object detection using RGB/IR fusion[J]. arXiv preprint, 2022.

[20] 赵明, 张浩然. 一种基于跨域融合网络的红外目标检测方法[J]. 光子学报, 2021, 50(11): 1110001.

[21] WANG Q, CHI Y, SHEN T, et al. Improving RGB-infrared object detection by reducing cross-modality redundancy[J]. Remote Sensing, 2022, 14(9): 2020.

[22] GENG X, LI M, LIU W, et al. Person tracking by detection using dual visible-infrared cameras[J]. IEEE Internet of Things Journal, 2022, 9(22): 23241-23251.

[23] 周涛, 董雅丽, 刘珊, 等. 用于肺部肿瘤图像分割的跨模态多编码混合注意力U-Net[J]. 光子学报, 2022, 51(4): 0410006.

[24] ZHANG Y, YIN Z, NIE L, et al. Attention based multi-layer fusion of multispectral images for pedestrian detection[J]. IEEE Access, 2020, 8: 165071-165084.

[25] CAO Z, YANG H, ZHAO J, et al. Attention fusion for one-stage multispectral pedestrian detection[J]. Sensors, 2021, 21(12): 4184-4198.

[26] KONIGD, ADAMM, JARVERSC, et al. Fully convolutional region proposal networks for multispectral person detection[C]. 2017 IEEE Conference on Computer Vision and Pattern Recognition Workshops, 2017: 49-56.

[27] FU L, GU W, AI Y, et al. Adaptive spatial pixel-level feature fusion network for multispectral pedestrian detection[J]. Infrared Physics & Technology, 2021, 116: 103770.

[28] WAGNERJ, FISCHERV, HERMANM, et al. Multispectral pedestrian detection using deep fusion convolutional neural networks[C]. ESANN, 2016, 587: 509-514.

[29] 白玉, 侯志强, 刘晓义, 等. 基于可见光图像和红外图像决策级融合的目标检测算法[J]. 空军工程大学学报(自然科学版), 2020, 21(6): 53-59.

BAI Yu, HOU Zhiqiang, LIU Xiaoyi, et al. Target detection algorithm based on decision-level fusion of visible light image and infrared image[J]. Journal of Air Force Engineering University (Natural Science Edition), 2020, 21(6): 53-59.

[30] YANGL, ZHANGR Y, LIL. Simam: a simple, parameter-free attention module for convolutional neural networks[C]. International Conference on Machine Learning, PMLR, 2021: 11863-11874.

[31] HOUQ, ZHOUD, FENGJ. Coordinate attention for efficient mobile network design[C]. 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2021: 13713-13722.

[32] MAJ, ZHAOZ, YIX, et al. Modeling task relationships in multi-task learning with multi-gate mixture-of-experts[C]. Proceedings of the 24th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining, 2018: 1930-1939.

[33] HWANGS, PARKJ, KIMN, et al. Multispectral pedestrian detection: Benchmark dataset and baseline[C]. 2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2015: 1037-1045.

[34] LI C, SONG D, TONG R. Multispectral pedestrian detection via simultaneous detection and segmentation[J]. arXiv preprint, 2018.

[35] LIU J, ZHANG S, WANG S, et al. Multispectral deep neural networks for pedestrian detection[J]. arXiv preprint, 2016.

[36] LIC, ZHAON, LUY. Weighted sparse representation regularized graph learning for RGB-T object tracking[C]. Proceedings of the 25th ACM International Conference on Multimedia, 2017: 1856-1864.

[37] SUN Y, CAO B, ZHU P, et al. Drone-based RGB-infrared cross-modality vehicle detection via uncertainty-aware learning[J], 2021.

[38] WANG Q, CHI Y, SHEN T, et al. Improving RGB-infrared object detection by reducing cross-modality redundancy[J]. Remote Sensing, 2022, 14(9): 2020-2031.

Article Outline

孙颖, 侯志强, 杨晨, 马素刚, 范九伦. 基于双模态融合网络的目标检测算法[J]. 光子学报, 2023, 52(1): 0110002. Ying SUN, Zhiqiang HOU, Chen YANG, Sugang MA, Jiulun FAN. Object Detection Algorithm Based on Dual-modal Fusion Network[J]. ACTA PHOTONICA SINICA, 2023, 52(1): 0110002.